За последние двенадцать месяцев мошенническая деятельность на основе Deepfake в мире бизнеса пережила огромный всплеск.

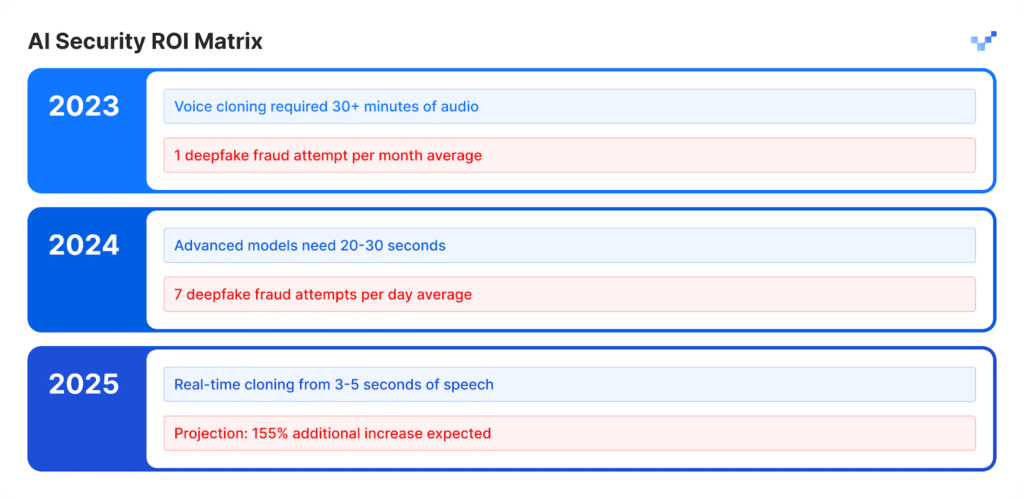

Сайт Отчет о голосовой разведке и безопасности за 2025 год от Pindrop показывает, что число голосовых атак выросло до 1300% по сравнению с предыдущим месячным показателем, поскольку теперь они происходят семь раз в день.

Исследование 1,2 миллиарда звонков клиентов, проведенное в отчете, доказывает, что это развитие представляет собой нечто большее, чем стандартный рост киберпреступности, поскольку означает полный сдвиг в методах работы мошенников.

Модель роста не показывает никаких признаков постепенного развития. Быстрые темпы этого разрушения привели к полной трансформации экономических систем, основанных на доверии.

Многочисленные статистические данные показывают все масштабы этого развивающегося кризиса.

Ресурсный центр по борьбе с кражами личных данных зафиксировал рост числа мошенничеств, выдающих себя за людей, на 148% в период с апреля 2024 года по март 2025 года.

Общая сумма убытков от мошенничества в 2024 году достигла $16,6 млрд, увеличившись на 33% по сравнению с показателями 2023 года.

Развитие технологий искусственного интеллекта превратило обман в промышленную операцию, которая ведет свою деятельность на индустриальном уровне.

Работа на руководящем уровне

Атаки на финансовые подделки затронули более 25% исполнительных систем, которые управляют финансовыми и бухгалтерскими операциями.

Число руководителей, которые прогнозируют рост числа финансовых атак deepfake в следующем году, превысило 50%.

Анатомия промышленной атаки

Клонирование голоса: От минут к мгновениям

Речевые модели ИИ продемонстрировали исключительный рост в своем развитии за последние несколько лет.

Базовое бесплатное программное обеспечение позволяет пользователям создавать синтетические голоса с помощью коротких голосовых записей, которые раньше требовали большого количества аудиоматериала и специализированных инструментов, на выполнение которых уходило несколько дней.

Искусственная речь соответствует естественному качеству человеческой речи.

Никогда больше не беспокойтесь о мошенничестве с помощью искусственного интеллекта. TruthScan Мы можем помочь вам:

- Обнаружение сгенерированного искусственного интеллекта изображения, текст, голос и видео.

- Избегайте Крупнейшее мошенничество, управляемое искусственным интеллектом.

- Защитите свои самые чувствительный активы предприятия.

Влияние по отраслям:

- В секторе страхования число атак с использованием синтетического голоса выросло на 475% за этот период времени.

- В банковской сфере зафиксирован рост мошеннических действий с использованием голоса на 149%.

- В ближайшие пять лет контактные центры понесут потенциальные убытки от мошенничества на сумму $44,5 млрд.

- Инциденты безопасности обходятся предприятиям в среднем в $600 000 за один случай.

Новое лицо мошенничества: Изощренное и отполированное

Мошенники теперь используют продвинутые атаки deepfake, которые превосходят обычные мошеннические письма, потому что их атаки имеют безупречную грамматику и появляются в подходящие моменты, выглядя при этом очень достоверно.

Эти атаки направлены на то, чтобы обойти как запрограммированные системы безопасности, так и человеческие решения.

Тематическое исследование: Близкая ошибка WPP

Преступники попытались реализовать сложную мошенническую схему, создав поддельную учетную запись WhatsApp под именем генерального директора WPP, объединив голосовой клон, имитирующий голос Марка Рида, с воспроизведением видео на YouTube с поддельной мимикой лица Марка Рида, используя при этом записанные видеоролики из открытых источников.

Злоумышленники проводили атаку через Microsoft Teams и рассылали убедительные поддельные сообщения, используя методы самозванства и тактику социальной инженерии, чтобы создать ложное ощущение срочности бизнеса.

Нападавшие достигли точки, когда им почти удалось достичь своей цели.

Обман злоумышленников не удался, потому что они внесли в свое повествование небольшие несоответствия, заставившие жертву усомниться в их рассказе.

Этот инцидент доказал, что передовые методы обмана ИИ могут обмануть даже опытных профессионалов благодаря своей реалистичности и запутанности.

Азиатско-Тихоокеанский регион: Глобальная горячая точка

Азиатско-Тихоокеанский регион стал мировым центром мошеннических действий на основе ИИ. Количество атак, связанных с ИИ, в 2024 году увеличилось на 194% по сравнению с 2023 годом.

Почему именно здесь? Быстрое внедрение цифровых платежей в сочетании с недостаточными системами защиты от мошенничества в регионе стало идеальной средой для деятельности злоумышленников.

Основные региональные данные:

- Средний финансовый ущерб от каждого инцидента составляет $600 000.

- Во всех случаях возврат похищенных средств остается ниже 5%.

- Финансовые потери от Deepfake, превышающие $1 миллион, затронули более 10% финансовых учреждений.

Этот регион является основной мишенью для мошенничества с использованием искусственного интеллекта, поскольку сотрудники работают удаленно, а инструменты синтеза голоса легко доступны.

За пределами голоса: Многовекторное мошенничество уже здесь

704% Всплеск атак с подменой лица

По данным iProov, в 2023 году количество атак с подменой лица увеличилось на 704%, а мошенничество с использованием мобильных веб-инъекций выросло на 255%.

Общее число попыток мошенничества теперь включает 42,5% попыток, сгенерированных искусственным интеллектом, которые увенчались успехом в 30% случаев.

Сообщения об инцидентах безопасности свидетельствуют о постоянном развитии угроз, которые воздействуют на различные системы.

Матрица уязвимостей предприятия

- В секторе розничной торговли в 2024 году наблюдался рост мошеннических действий на 107%, а в 2025 году, по прогнозам экспертов, число случаев мошенничества удвоится.

- Злоумышленники используют глубокие подделки, чтобы обойти системы проверки идентификационных данных, которые защищают процессы KYC.

- Системы искусственного интеллекта создают искусственные профили лиц, которым удается обмануть системы распознавания лиц.

- Злоумышленники используют синтетический контент для создания обманных юридических документов и учетных данных с помощью методов подделки документов.

Дело Брэда Питта: Психологическое мошенничество с помощью искусственного интеллекта

Французский дизайнер интерьеров стал жертвой изощренной аферы с использованием искусственного интеллекта, когда в течение нескольких месяцев перевел мошенникам почти $1 миллион.

Стратегия нападения:

- Изначально самозванец связался с жертвой, выдавая себя за мать Брэда Питта.

- Глубоко подделанные аудиозаписи и изображения, созданные искусственным интеллектом, помогли сохранить иллюзию надолго.

- Поддельные медицинские карты и документы, выглядящие как юридические, придавали схеме дополнительную достоверность.

- Мультимедийный контент в течение нескольких месяцев поддерживал правдоподобность фальшивой личности.

Человек, не являющийся новичком в технологиях, стал жертвой откровенного мошенничества.

Жертва работала как владелец бизнеса, который не знал, что взаимодействует с искусственным интеллектом.

Этот инцидент демонстрирует продвинутый уровень обмана, которого может достичь современная технология deepfake.

Пробел в обнаружении: почему большинство компаний не готовы к этому

Кризис информированности на самом верху

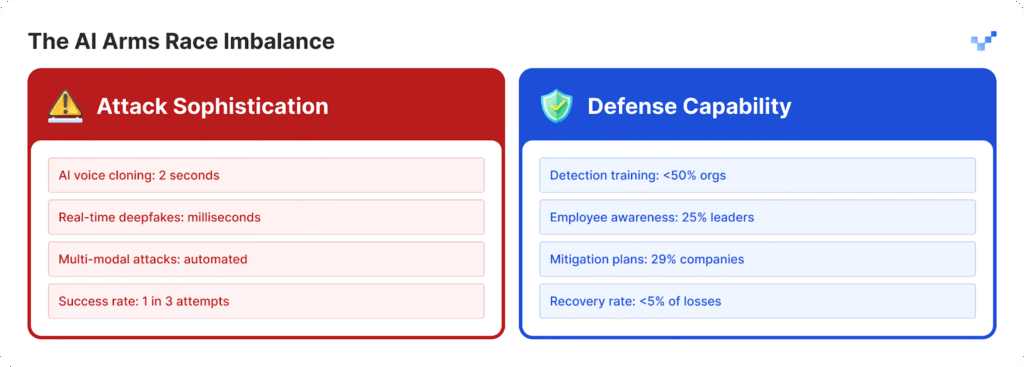

Организации пытаются защитить себя от растущего числа атак, поскольку не разработали достаточных стратегий защиты.

- Руководители 25% организаций демонстрируют ограниченное понимание работы технологии deepfake.

- Организации с трудом определяют свою способность обнаруживать deepfake-атаки, поскольку 32% из них остаются неопределенными.

- Более половины организаций не проводят для своих сотрудников обучение по вопросам угроз, основанных на искусственном интеллекте.

- Большинство организаций не имеют установленных планов или специальных протоколов для борьбы с угрозами deepfake.

Для организаций, начинающих ликвидировать этот пробел в готовности, такие инструменты, как TruthScan предлагают первый важный шаг.

Разработанный для обнаружения контента ИИ в режиме реального времени, TruthScan выявляет подозрительные визуальные, текстовые и мультимедийные объекты в различных форматах, помогая командам обнаружить синтетические манипуляции до того, как они нанесут ущерб.

Уязвимость человеческого фактора

Исследование McAfee показывает, что 70% людей не могут отличить подлинные голоса от голосовых клонов.

Проблема обостряется, потому что 40% людей ответят на голосовое сообщение, если думают, что оно принадлежит близкому человеку, которому нужна помощь.

В настоящее время наиболее опасной угрозой для безопасности предприятий является сочетание реалистичного контента, генерируемого искусственным интеллектом, с методами психологического манипулирования.

Технологический разрыв увеличивается

Проблема $40 миллиардов

По прогнозам Deloitte, к 2027 году объем мошенничества с использованием искусственного интеллекта в США достигнет $40 млрд, в то время как в 2023 году он составит $12,3 млрд.

Согласно прогнозам, ежегодные темпы роста за этот период составят 32%.

Экономическое воздействие включает в себя:

- Непосредственный финансовый ущерб наносится в результате синтетических мошеннических действий.

- Случаются кражи личных данных, а также злоупотребление персональной информацией.

- Из-за времени, необходимого для проведения судебной экспертизы, нарушается работа бизнеса.

- Предприятиям приходится платить штрафы, поскольку они не применяют надлежащих мер по защите данных.

- После того как информация о компании становится достоянием общественности, ее репутации наносится постоянный ущерб.

Контактные центры в зоне риска

К 2025 году число случаев мошенничества в розничной торговле достигнет одного из каждых 56 обращений в службу поддержки клиентов. Кризис контакт-центров будет усугубляться, поскольку мошеннические действия с использованием искусственного интеллекта будут расти в больших объемах.

Правительства начинают реагировать

В США.

- Федеральная торговая комиссия США установила новые правила, которые не позволяют пользователям использовать программы, выдающие себя за людей.

- ФБР теперь предупреждает общественность о фишинговых атаках, в которых используются технологии искусственного интеллекта.

- Несколько американских штатов приняли новые законы, направленные на регулирование технологии deepfake.

Глобально

- Закон ЕС об искусственном интеллекте требует, чтобы весь контент, созданный искусственным интеллектом, имел очевидные признаки того, что он был создан искусственным интеллектом.

- Несколько государств разработали международные соглашения, которые позволяют им применять свои законы на территории разных стран.

- Платформы ИИ должны продемонстрировать, что в их системах предусмотрены меры по предотвращению несанкционированного использования их технологий.

Возможность соблюдения требований

Организации, которые уже сегодня внедряют передовые системы обнаружения мошенничества с использованием искусственного интеллекта, займут лидирующие позиции на рынке.

Эти организации раньше других выполнят все требования, поскольку их конкуренты вынуждены тратить время на то, чтобы догнать их.

Новая парадигма безопасности

1300% Рост числа атак deepfake превратил операции по обеспечению доверия к цифровым технологиям в нечто большее, чем просто вопрос кибербезопасности.

Стратегический сдвиг:

- Современные угрозы переросли существующие системы защиты по периметру, которые уже не обеспечивают должной защиты.

- Эксперты по безопасности, потратившие годы в своей области, теперь сталкиваются с атаками deepfake, от которых они не могут защититься.

- Нынешний подход "доверяй, но проверяй" уже неэффективен, поскольку проверка должна стать постоянной оперативной процедурой.

- Необходимо развертывать системы обнаружения в режиме реального времени, поскольку ручные методы обнаружения не могут выявить угрозы до того, как они станут угрозами.

Будущее принадлежит подготовленным

Организациям необходимо сделать выбор: развернуть системы обнаружения ИИ прямо сейчас, чтобы остановить мошенничество deepfake и не допустить его прогнозируемого 155% роста в 2025 году, или рискнуть публичным раскрытием своих систем.

Организации, которые действуют сейчас, защитят свое финансовое благополучие и построят системы доверия, которые обеспечат им лидирующие позиции на будущем рынке, основанном на искусственном интеллекте.

Компании, которые первыми обнаружили угрозы ИИ и быстро внедрили решения, преуспеют в борьбе ИИ против ИИ.

Ссылки

- Пиндроп (12 июня 2025 года): "Отчет Pindrop о голосовой разведке и безопасности за 2025 год" - 1 300% всплеск мошенничества с подделками, данные анализа звонков

- Unite.AI (20 часов назад): "Deepfakes, Voice Clones Fuel 148% Surge in AI Impersonation Scams" - Статистика Identity Theft Resource Center

- Group-IB (6 августа 2025 года): "Анатомия фишинговой атаки Deepfake Voice" - Азиатско-Тихоокеанский регион 194% всплеск, данные о финансовом воздействии

- J.P. Morgan (2025): "ИИ-мошенничество, глубокие подделки, самозванство" - $16,6 млрд убытков от мошенничества, рост 33%

- Incode (20 декабря 2024 года): "Топ-5 случаев мошенничества с использованием искусственного интеллекта с 2024 года" - исследование Deloitte, подробности дела WPP

- Eftsure US (2025): "Статистика Deepfake (2025): 25 новых фактов для финансовых директоров" - Пробелы в обучении, статистика уверенности сотрудников

- Security.org (26 августа 2025 года): "2024 Deepfakes Guide and Statistics" - Статистика жертв клонирования голоса, нормативно-правовая база

- Американская ассоциация юристов (2025): "Чему нас учат мошенничества Deepfake" - пример Брэда Питта, юридические последствия

- Axios (15 марта 2025 года): "Мошенничество с использованием искусственного интеллекта для клонирования голоса: Постоянная угроза" - исследование Consumer Reports, данные ФТК о самозванстве