W ciągu ostatnich dwunastu miesięcy oszukańcze działania oparte na Deepfake w świecie biznesu doświadczyły ogromnego wzrostu.

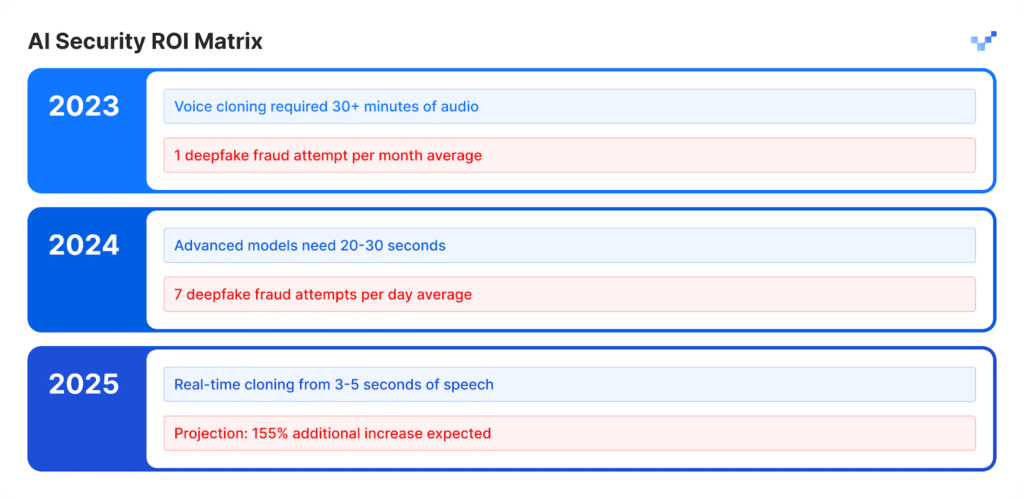

The 2025 Voice Intelligence & Security Report od Pindrop ujawnia, że ataki głosowe wzrosły do 1300% więcej niż ich poprzednie miesięczne występowanie, ponieważ obecnie występują siedem razy dziennie.

Badanie 1,2 miliarda połączeń z klientami w raporcie dowodzi, że rozwój ten stanowi coś więcej niż standardowy wzrost cyberprzestępczości, ponieważ oznacza całkowitą zmianę metod operacyjnych oszustw.

Wzorzec wzrostu nie wskazuje na podążanie ścieżką stopniowego rozwoju. Szybkie tempo tego zakłócenia doprowadziło do całkowitej transformacji systemów gospodarczych opartych na zaufaniu.

Liczne statystyki pokazują pełen zakres tego rozwijającego się kryzysu.

Identity Theft Resource Center odnotowało wzrost liczby oszustw związanych z podszywaniem się pod inne osoby o 148% w okresie od kwietnia 2024 r. do marca 2025 r.

Łączna kwota strat z tytułu oszustw w 2024 r. osiągnęła $16,6 mld, wykazując wzrost o 33% w porównaniu z danymi z 2023 r.

Postępy w technologii sztucznej inteligencji przekształciły oszustwo w operację przemysłową, która prowadzi swoją działalność na poziomie przemysłowym.

Ekspozycja na poziomie kierowniczym

Finansowe ataki typu deepfake były wymierzone w ponad 25% systemów wykonawczych, które zarządzają zarówno operacjami finansowymi, jak i księgowymi.

Liczba dyrektorów, którzy przewidują wzrost liczby ataków finansowych typu deepfake w przyszłym roku, osiągnęła ponad 50%.

Anatomia uprzemysłowionego ataku

Klonowanie głosu: Od minut do chwil

Modele mowy AI wykazały wyjątkowy wzrost w rozwoju w ciągu ostatnich kilku lat.

Podstawowe darmowe oprogramowanie umożliwia użytkownikom tworzenie syntetycznych głosów za pomocą krótkich nagrań głosowych, które wcześniej wymagały obszernego materiału audio i specjalistycznych narzędzi, których ukończenie wymagało wielu dni.

Wyjście sztucznej mowy odpowiada naturalnej jakości ludzkich wokalizacji.

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

Wpływ według branży:

- W sektorze ubezpieczeń odnotowano wzrost liczby ataków głosowych o 475% w tym okresie.

- Sektor bankowy odnotował wzrost liczby oszustw głosowych o 149%.

- Przewiduje się, że w ciągu najbliższych pięciu lat centra kontaktowe doświadczą $44,5 miliarda potencjalnych strat związanych z oszustwami.

- Incydenty związane z bezpieczeństwem kosztują firmy średnio $600,000 za każde zdarzenie.

Nowe oblicze oszustw: Wyrafinowane i dopracowane

Oszuści stosują obecnie zaawansowane ataki typu deepfake, które przewyższają podstawowe oszukańcze wiadomości e-mail, ponieważ ich ataki mają bezbłędną gramatykę i pojawiają się w odpowiednich momentach, wyglądając niezwykle autentycznie.

Ataki te mają na celu ominięcie zarówno zaprogramowanych systemów bezpieczeństwa, jak i ludzkich procesów oceny.

Studium przypadku: WPP Near Miss

Przestępcy próbowali zrealizować skomplikowany plan oszustwa poprzez utworzenie fałszywego konta WhatsApp pod CEO WPP, łącząc klon głosu, który naśladował głos Marka Reada, z odtwarzaniem wideo z YouTube w celu uzyskania fałszywej mimiki twarzy Marka Reada, jednocześnie wykorzystując nagrane filmy z domen publicznych.

Atakujący przeprowadzili swój atak za pośrednictwem Microsoft Teams i wysłali przekonujące fałszywe wiadomości za pomocą metod podszywania się i taktyk socjotechnicznych, aby stworzyć fałszywe poczucie pilności biznesowej.

Atakujący osiągnęli punkt, w którym prawie udało im się osiągnąć swój cel.

Oszustwo napastników nie powiodło się, ponieważ wprowadzili drobne niespójności w swojej narracji, które sprawiły, że ofiara zakwestionowała ich historię.

Incydent ten udowodnił, że zaawansowane techniki oszukiwania AI mogą oszukać nawet doświadczonych profesjonalistów ze względu na ich realistyczny i skomplikowany charakter.

Azja i Pacyfik: Globalny punkt zapalny

Obszar Azji i Pacyfiku stał się światowym centrum oszukańczych działań opartych na sztucznej inteligencji. Liczba ataków związanych ze sztuczną inteligencją w 2024 r. wzrosła o 194% w porównaniu z 2023 r.

Dlaczego tutaj? Szybkie wdrażanie płatności cyfrowych w połączeniu z niewystarczającymi systemami ochrony przed oszustwami w regionie sprawiło, że było to idealne środowisko do działania dla atakujących.

Kluczowe dane regionalne:

- Średnia strata finansowa z każdego incydentu wynosi $600,000.

- Odzysk skradzionych środków pozostaje poniżej 5% we wszystkich przypadkach.

- Straty finansowe związane z Deepfake przekraczające 1,7 miliona dolarów dotknęły ponad 101,6 miliona instytucji finansowych.

Region ten jest głównym celem oszustw opartych na sztucznej inteligencji, ponieważ pracownicy pracują zdalnie, a narzędzia do syntezy głosu są łatwo dostępne.

Beyond Voice: Multi-Vector Fraud is Here

Wzrost liczby ataków typu Face Swap w 704%

Według iProov liczba ataków typu "face swap" wzrosła o 704% w 2023 r., podczas gdy liczba oszustw związanych z wstrzykiwaniem danych w sieci mobilnej wzrosła o 255%.

Całkowita liczba prób oszustw obejmuje obecnie 42,5% prób wygenerowanych przez sztuczną inteligencję, które powiodły się w 30% przypadków.

Zgłoszone incydenty bezpieczeństwa wskazują na ciągły rozwój zagrożeń, które mają wpływ na różne systemy.

Matryca podatności przedsiębiorstwa na zagrożenia

- Sektor detaliczny odnotował wzrost liczby oszustw o 107% w 2024 r., a eksperci przewidują, że liczba przypadków oszustw podwoi się w 2025 r.

- Atakujący używają podróbek, aby ominąć systemy weryfikacji tożsamości, które chronią przed procesami KYC.

- Systemy sztucznej inteligencji tworzą sztuczne profile twarzy, które są w stanie oszukać systemy rozpoznawania twarzy.

- Atakujący wykorzystują syntetyczną zawartość do generowania fałszywych dokumentów prawnych i poświadczeń za pomocą metod fałszowania dokumentów.

Sprawa Brada Pitta: Oszustwo psychologiczne z wykorzystaniem sztucznej inteligencji

Francuski projektant wnętrz stał się ofiarą wyrafinowanego oszustwa z wykorzystaniem sztucznej inteligencji, kiedy to w ciągu kilku miesięcy przelał oszustom prawie $1 milionów.

Strategia ataku:

- Początkowo oszust skontaktował się z ofiarą, podając się za matkę Brada Pitta.

- Deepfake audio i obrazy generowane przez sztuczną inteligencję pomogły utrzymać iluzję w czasie.

- Fałszywa dokumentacja medyczna i dokumenty wyglądające na legalne dodawały wiarygodności temu procederowi.

- Zawartość multimedialna utrzymywała fałszywą tożsamość przez kilka miesięcy.

Osoba, która nie była nowicjuszem w dziedzinie technologii, padła ofiarą prostego oszustwa.

Ofiara działała jako właściciel firmy, który pozostawał nieświadomy, że wchodzi w interakcję ze sztuczną inteligencją.

Incydent ten pokazuje zaawansowany poziom oszustwa, jaki może osiągnąć nowoczesna technologia deepfake.

Luka w wykrywaniu: dlaczego większość firm jest nieprzygotowana

Kryzys świadomości na szczycie

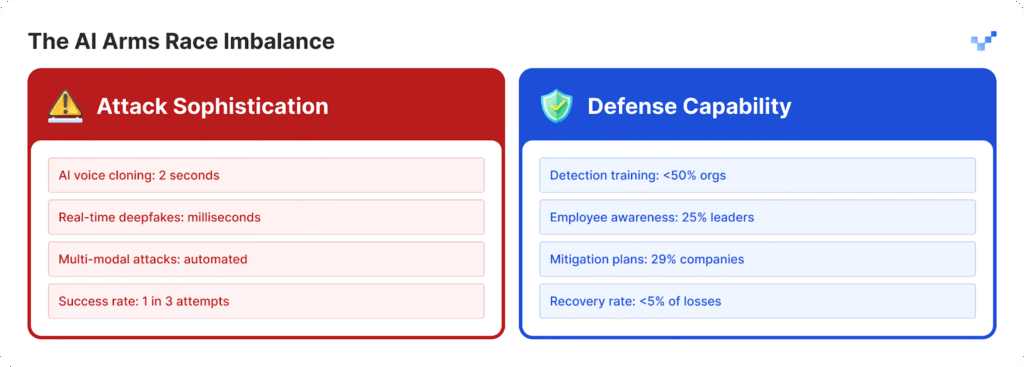

Organizacje z trudem chronią się przed nasilającymi się atakami, ponieważ nie opracowały wystarczających strategii obrony.

- Liderzy w 25% organizacji wykazują ograniczoną wiedzę na temat operacji związanych z technologią deepfake.

- Organizacje mają trudności z określeniem swojej zdolności do wykrywania ataków deepfake, ponieważ 32% z nich pozostaje niepewnych.

- Ponad połowa organizacji nie zapewnia swoim pracownikom szkoleń na temat zagrożeń opartych na sztucznej inteligencji.

- Większość organizacji nie ma ustalonych planów ani konkretnych protokołów do obsługi zagrożeń typu deepfake.

Dla organizacji zaczynających wypełniać tę lukę w gotowości, narzędzia takie jak TruthScan stanowią krytyczny pierwszy krok.

Zaprojektowany do wykrywania treści AI w czasie rzeczywistym, TruthScan oznacza podejrzane wizualizacje, tekst i media w wielu formatach - pomagając zespołom wykryć syntetyczną manipulację, zanim spowoduje szkody.

Podatność czynnika ludzkiego

Badania McAfee pokazują, że 70% osób nie odróżnia autentycznych głosów od klonów głosowych.

Problem nasila się, ponieważ 40% osób odpowiada na pocztę głosową, gdy myślą, że należy ona do kogoś, kogo kochają i kto potrzebuje pomocy.

Obecne największe zagrożenie dla bezpieczeństwa przedsiębiorstw wynika z połączenia realistycznych treści generowanych przez sztuczną inteligencję z technikami manipulacji psychologicznej.

Przepaść technologiczna powiększa się

Problem $40 miliardów

Deloitte przewiduje, że oszustwa oparte na sztucznej inteligencji osiągną w Stanach Zjednoczonych wartość $40 mld do 2027 r., podczas gdy obecne szacunki z 2023 r. wynoszą $12,3 mld.

Według prognoz roczna stopa wzrostu w tym okresie osiągnie 32%.

Wpływ ekonomiczny obejmuje:

- Bezpośrednie szkody finansowe powstają w wyniku oszustw syntetycznych.

- Zdarzają się kradzieże tożsamości i nadużycia danych osobowych.

- Operacje biznesowe doświadczają zakłóceń ze względu na czas potrzebny na dochodzenie kryminalistyczne.

- Firmy muszą płacić kary regulacyjne, ponieważ nie wdrażają odpowiednich środków ochrony danych.

- Firmy doznają trwałego uszczerbku na reputacji, gdy ich informacje stają się publicznie dostępne.

Zagrożone centra kontaktowe

Do 2025 r. liczba przypadków oszustw w handlu detalicznym osiągnie jeden na każde 56 połączeń z obsługą klienta. Kryzys w centrach kontaktowych będzie się pogłębiał, ponieważ oszukańcze działania oparte na sztucznej inteligencji będą rosły w dużych ilościach.

Rządy zaczynają reagować

W USA.

- Federalna Komisja Handlu ustanowiła nowe zasady, które uniemożliwiają użytkownikom korzystanie z oprogramowania do podszywania się pod głos.

- FBI ostrzega teraz opinię publiczną o atakach phishingowych wykorzystujących technologię sztucznej inteligencji.

- Kilka amerykańskich stanów uchwaliło nowe przepisy, które koncentrują się na regulacji technologii deepfake.

Globalnie

- Unijna ustawa o sztucznej inteligencji wymaga, aby wszystkie treści generowane przez sztuczną inteligencję wykazywały oczywiste oznaki, że zostały stworzone przez sztuczną inteligencję.

- Kilka krajów opracowało umowy międzynarodowe, które pozwalają im egzekwować swoje prawa w różnych krajach.

- Platformy AI muszą wykazać, że ich systemy mają środki zapobiegające nieautoryzowanemu wykorzystaniu ich technologii.

Możliwości w zakresie zgodności

Organizacje, które już dziś wdrożą zaawansowane systemy wykrywania oszustw AI, staną się liderami rynku.

Organizacje będą spełniać nadchodzące przepisy przed innymi, ponieważ ich konkurenci muszą poświęcić czas na nadrobienie zaległości.

Nowy paradygmat bezpieczeństwa

Wzrost liczby ataków deepfake spowodował, że cyfrowe operacje zaufania stały się czymś więcej niż tylko kwestią cyberbezpieczeństwa.

Strategiczna zmiana:

- Współczesne zagrożenia przerosły obecne systemy obrony obwodowej, które nie zapewniają już odpowiedniej ochrony.

- Eksperci ds. bezpieczeństwa, którzy spędzili lata w swojej dziedzinie, doświadczają teraz ataków typu deepfake, przed którymi nie mogą się obronić.

- Obecne podejście "ufaj, ale weryfikuj" nie jest już skuteczne, ponieważ weryfikacja musi stać się stałą procedurą operacyjną.

- Systemy wykrywania w czasie rzeczywistym muszą być wdrażane, ponieważ ręczne metody wykrywania nie są w stanie wykryć zagrożeń, zanim staną się one zagrożeniami.

Przyszłość należy do przygotowanych

Organizacje muszą dokonać wyboru między natychmiastowym wdrożeniem systemów wykrywania sztucznej inteligencji, aby powstrzymać oszustwa typu deepfake przed osiągnięciem przewidywanego wzrostu o 155% w 2025 r., a ryzykiem publicznego ujawnienia ich systemów.

Organizacje, które działają teraz, będą bronić swojej kondycji finansowej, jednocześnie budując systemy zaufania, które zapewnią im pozycję liderów na przyszłym rynku opartym na sztucznej inteligencji.

Firmy, które jako pierwsze wykryły zagrożenia związane ze sztuczną inteligencją i szybko wdrożyły rozwiązania, odniosą sukces w walce AI kontra AI.

Referencje

- Pindrop (12 czerwca 2025 r.): "Pindrop's 2025 Voice Intelligence & Security Report" - 1,300% deepfake fraud surge, dane z analizy połączeń

- Unite.AI (20 godzin temu): "Deepfakes, Voice Clones Fuel 148% Surge in AI Impersonation Scams" - Statystyki Centrum Zasobów Kradzieży Tożsamości

- Grupa-IB (6 sierpnia 2025 r.): "The Anatomy of a Deepfake Voice Phishing Attack" - wzrost w regionie Azji i Pacyfiku 194%, dane dotyczące wpływu finansowego

- J.P. Morgan (2025): "AI Scams, Deep Fakes, Impersonations" - $16,6 mld strat z tytułu oszustw, wzrost o 33%

- Incode (20 grudnia 2024 r.): "Top 5 Cases of AI Deepfake Fraud From 2024" - badanie wykonawcze Deloitte, szczegóły przypadku WPP

- Eftsure US (2025): "Deepfake statistics (2025): 25 nowych faktów dla dyrektorów finansowych" - Luki szkoleniowe, statystyki zaufania pracowników

- Security.org (26 sierpnia 2025 r.): "2024 Deepfakes Guide and Statistics" - Statystyki dotyczące ofiar klonowania głosu, krajobraz regulacyjny

- Amerykańskie Stowarzyszenie Prawników (2025): "Czego Deepfake Scams uczą nas o sztucznej inteligencji i oszustwach" - studium przypadku Brada Pitta, implikacje prawne

- Axios (15 marca 2025 r.): "Oszustwa związane z klonowaniem głosu AI: Stałe zagrożenie" - badanie Consumer Reports, dane FTC dotyczące podszywania się pod inne osoby