Deepfake-gebaseerde frauduleuze activiteiten in de zakenwereld hebben de afgelopen twaalf maanden een enorme vlucht genomen.

De 2025 Voice Intelligence & Security-rapport van Pindrop laat zien dat spraakgebaseerde aanvallen zijn gestegen tot 1300% meer dan hun vorige maandelijkse voorkomen, omdat ze nu zeven keer per dag voorkomen.

Het onderzoek van 1,2 miljard klantgesprekken in het rapport bewijst dat deze ontwikkeling meer is dan de standaardgroei van cybercriminaliteit, omdat het een complete verschuiving in de operationele fraudemethoden betekent.

Het groeipatroon wijst er niet op dat het een geleidelijk ontwikkelingspad volgt. Het snelle tempo van deze ontwrichting heeft geleid tot een volledige transformatie van op vertrouwen gebaseerde economische systemen.

Verschillende statistieken tonen de volle omvang van deze zich ontwikkelende crisis.

Het Identity Theft Resource Center registreerde een stijging van 148% in oplichting door imitaties in de periode van april 2024 tot maart 2025.

Het totale bedrag aan fraudeverliezen in 2024 bedroeg $16,6 miljard, een stijging van 33% ten opzichte van de cijfers van 2023.

Door de vooruitgang in AI-technologie is misleiding een industriële operatie geworden die zijn activiteiten op industrieel niveau uitvoert.

Executief niveau

Financiële deepfake-aanvallen zijn gericht geweest op meer dan 25% van uitvoerende systemen die zowel financiële als boekhoudkundige activiteiten beheren.

Het aantal leidinggevenden dat voorspelt dat financiële deepfake-aanvallen het komende jaar zullen toenemen, is opgelopen tot meer dan 50%.

Anatomie van een geïndustrialiseerde aanval

Stem klonen: Van minuten naar momenten

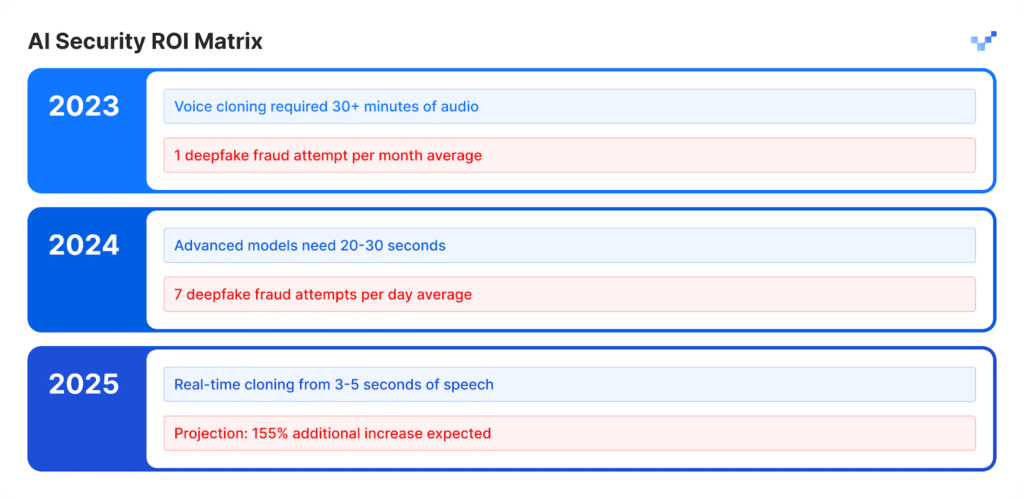

AI-spraakmodellen hebben de afgelopen jaren een uitzonderlijke groei doorgemaakt in hun ontwikkeling.

Met de gratis basissoftware kunnen gebruikers synthetische stemmen maken door middel van korte stemopnames, waarvoor vroeger uitgebreid audiomateriaal en gespecialiseerde tools nodig waren die meerdere dagen in beslag namen.

De kunstmatige spraakuitvoer komt overeen met de natuurlijke kwaliteit van menselijke vocalisaties.

Maak je nooit meer zorgen over AI-fraude. TruthScan Kan je helpen:

- AI-opgewekt detecteren afbeeldingen, tekst, spraak en video.

- Vermijd grote AI-gestuurde fraude.

- Bescherm uw meest gevoelig bedrijfsmiddelen.

Impact per sector:

- De verzekeringssector zag synthetische spraakaanvallen in deze periode stijgen met 475%.

- De banksector registreerde een stijging van 149% van frauduleuze activiteiten via spraak.

- Contactcenters zullen de komende vijf jaar naar schatting $44,5 miljard aan potentiële fraudeverliezen lijden.

- Beveiligingsincidenten kosten bedrijven gemiddeld $600.000 per gebeurtenis.

Het nieuwe gezicht van fraude: Verfijnd en gepolijst

Oplichters maken nu gebruik van geavanceerde deepfake-aanvallen die gewone oplichtingsmails overtreffen omdat hun aanvallen een foutloze grammatica hebben en op het juiste moment verschijnen terwijl ze er uiterst authentiek uitzien.

Deze aanvallen proberen zowel geprogrammeerde beveiligingssystemen als menselijke beoordelingsprocessen te omzeilen.

Casestudie: De bijna-ongelukken bij WPP

De criminelen probeerden een uitgebreid frauduleus plan uit te voeren door een nep WhatsApp-account te maken onder de naam van de CEO van WPP. Ze combineerden een stemkloon die de stem van Mark Read nabootste met het afspelen van YouTube-video's voor nepgezichtsuitdrukkingen in de naam van Mark Read, terwijl ze gebruikmaakten van opgenomen video's uit openbare domeinen.

De aanvallers voerden hun aanval uit via Microsoft Teams en stuurden overtuigende nepberichten via imitatiemethoden en social engineering-tactieken om een vals gevoel van zakelijke urgentie te creëren.

De aanvallers bereikten een punt waarop ze bijna in hun opzet slaagden.

De misleiding van de aanvallers slaagde niet omdat ze kleine inconsistenties in hun verhaal introduceerden waardoor het slachtoffer hun verhaal in twijfel trok.

Het incident bewees dat geavanceerde AI-bedrogtechnieken zelfs doorgewinterde professionals kunnen misleiden vanwege hun realistische en ingewikkelde aard.

Azië-Stille Oceaan: De mondiale hotspot

Het gebied Azië-Stille Oceaan is het wereldwijde centrum geworden voor AI-gebaseerde frauduleuze activiteiten. Het aantal AI-gerelateerde aanvallen steeg in 2024 met 194% ten opzichte van 2023.

Waarom hier? De snelle invoering van digitale betalingen in combinatie met ontoereikende fraudebeveiligingssystemen in de regio maakten het een perfecte omgeving voor aanvallers om te opereren.

Belangrijke regionale gegevens:

- Het gemiddelde financiële verlies per incident bedraagt $600.000.

- De terugvordering van gestolen geld blijft in alle gevallen onder de 5%.

- Deepfake-gerelateerde financiële verliezen van meer dan $1 miljoen troffen meer dan 10% aan financiële instellingen.

De regio vormt een belangrijk doelwit voor AI-gebaseerde fraude omdat werknemers op afstand werken en spraaksynthesetools gemakkelijk toegankelijk zijn.

Verder dan spraak: Multi-Vector Fraude is hier

Een 704%-toename in aanvallen door gezichtsswaps

Het aantal aanvallen waarbij gezichten worden verwisseld, is volgens iProov in 2023 met 704% toegenomen, terwijl fraude met injecties op mobiele websites met 255% is gegroeid.

Het totale aantal pogingen tot fraude omvat nu 42,5% door AI gegenereerde pogingen die in 30% van de gevallen slagen.

De gerapporteerde beveiligingsincidenten laten een voortdurende ontwikkeling zien van bedreigingen die invloed hebben op verschillende systemen.

De kwetsbaarhedenmatrix voor ondernemingen

- De detailhandel zag het aantal frauduleuze activiteiten in 2024 met 107% stijgen en experts voorspellen dat het aantal fraudegevallen in 2025 zal zijn verdubbeld.

- Aanvallers gebruiken deepfakes om ID-verificatiesystemen te omzeilen die beschermen tegen KYC-processen.

- Kunstmatige intelligentiesystemen produceren kunstmatige gezichtsprofielen die erin slagen gezichtsherkenningssystemen te misleiden.

- Aanvallers gebruiken synthetische inhoud om misleidende juridische documenten en referenties te genereren door middel van documentvervalsingsmethoden.

De zaak Brad Pitt: AI-gebaseerde psychologische fraude

Een Franse interieurontwerper werd het slachtoffer van een geraffineerde AI-fraude toen hij gedurende meerdere maanden bijna $1 miljoen overmaakte aan oplichters.

De aanvalsstrategie:

- De bedrieger nam aanvankelijk contact op met het slachtoffer terwijl hij zich voordeed als de moeder van Brad Pitt.

- Deepfake audio en AI-gegenereerde beelden hielpen de illusie in stand te houden.

- Valse medische dossiers en legaal uitziende documenten gaven het plan een geloofwaardig tintje.

- Multimedia-inhoud hield de valse identiteit enkele maanden geloofwaardig.

Een persoon die niet nieuw was in de technologie werd het slachtoffer van een eenvoudige zwendel.

Het slachtoffer opereerde als een bedrijfseigenaar die zich er niet van bewust was dat hij in contact stond met kunstmatige intelligentie.

Het incident toont het geavanceerde niveau van misleiding dat moderne deepfake technologie kan bereiken.

De detectiekloof: waarom de meeste bedrijven niet voorbereid zijn

Een bewustzijnscrisis aan de top

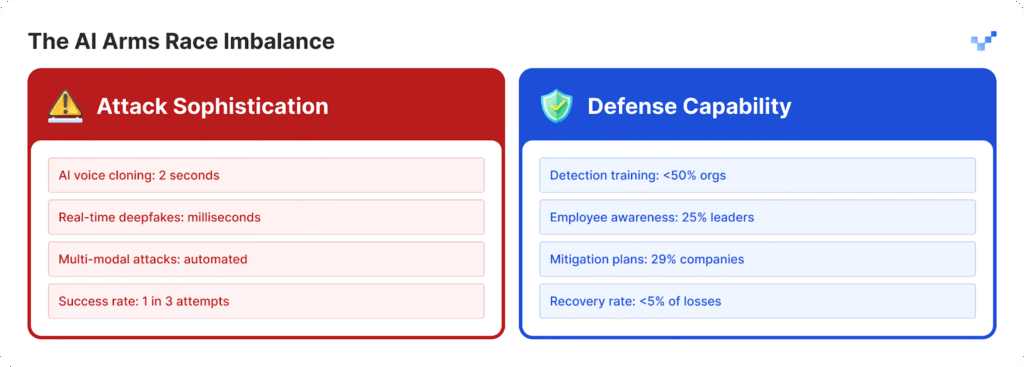

Organisaties hebben moeite zich te beschermen tegen toenemende aanvallen omdat ze onvoldoende verdedigingsstrategieën hebben ontwikkeld.

- Leiders in 25% van de organisaties hebben beperkt inzicht in de werking van deepfake technologie.

- Organisaties worstelen met het bepalen van hun vermogen om deepfake-aanvallen te detecteren omdat 32% ervan onzeker blijft.

- Meer dan de helft van de organisaties geeft hun medewerkers geen training over AI-gebaseerde bedreigingen.

- De meeste organisaties hebben geen vaste plannen of specifieke protocollen om met deepfake bedreigingen om te gaan.

Voor organisaties die het gat beginnen te dichten, zijn er hulpmiddelen zoals TruthScan bieden een cruciale eerste stap.

TruthScan is ontworpen voor realtime AI-inhouddetectie en markeert verdachte afbeeldingen, tekst en media in meerdere indelingen, zodat teams synthetische manipulatie kunnen herkennen voordat het schade veroorzaakt.

De kwetsbaarheid van de menselijke factor

Uit onderzoek van McAfee blijkt dat 70% van de mensen maakt geen onderscheid tussen authentieke stemmen en stemklonen.

Het probleem escaleert omdat 40% van de mensen een voicemail beantwoordt als ze denken dat die van iemand is van wie ze houden en die hulp nodig heeft.

De gevaarlijkste bedreiging voor de beveiliging van bedrijven komt voort uit de combinatie van door AI gegenereerde realistische inhoud met psychologische manipulatietechnieken.

De technologiekloof wordt breder

Het probleem van $40 miljard

Deloitte voorspelt dat AI-gebaseerde fraude tegen 2027 $40 miljard zal bedragen in de Verenigde Staten, terwijl de huidige schatting voor 2023 $12,3 miljard is.

De jaarlijkse groei voor deze periode zal volgens de prognoses 32% bedragen.

De economische impact omvat:

- De directe financiële schade ontstaat door synthetische fraudeactiviteiten.

- Diefstal van persoonlijke identiteiten en uitgebreid misbruik van persoonlijke informatie komen voor.

- De bedrijfsvoering wordt verstoord door de tijd die nodig is voor forensisch onderzoek.

- Bedrijven moeten boetes betalen omdat ze geen goede gegevensbeschermingsmaatregelen implementeren.

- Bedrijven lijden permanente reputatieschade nadat hun informatie openbaar is geworden.

Contactcentra in gevaar

Het aantal fraudegevallen in de detailhandel zal tegen 2025 oplopen tot één op 56 klantenservicegesprekken. De crisis in contactcentra zal verergeren omdat AI-gestuurde frauduleuze activiteiten in grote volumes zullen toenemen.

Regeringen beginnen te reageren

In de VS

- De Federal Trade Commission heeft nieuwe regels opgesteld die gebruikers verbieden om software voor stemvervalsing te gebruiken.

- De FBI waarschuwt het publiek nu voor phishingaanvallen waarbij gebruik wordt gemaakt van kunstmatige intelligentie.

- Verschillende Amerikaanse staten hebben nieuwe wetgeving aangenomen die zich richt op het reguleren van deepfake technologie.

Wereldwijd

- De EU AI Act vereist dat alle AI-gegenereerde inhoud duidelijke tekenen vertoont dat het door kunstmatige intelligentie is geproduceerd.

- Verschillende landen hebben internationale overeenkomsten gesloten om hun wetten in verschillende landen te kunnen handhaven.

- AI-platforms moeten aantonen dat hun systemen maatregelen hebben om ongeoorloofd gebruik van hun technologie te voorkomen.

De nalevingskans

Organisaties die vandaag geavanceerde AI-fraudedetectiesystemen implementeren, zullen marktleider worden.

De organisaties voldoen eerder aan toekomstige regelgeving dan anderen, omdat hun concurrenten tijd moeten besteden aan het inhalen van hun achterstand.

Een nieuw beveiligingsparadigma

De 1300% toename van 'deepfake'-aanvallen heeft digitale vertrouwensactiviteiten omgevormd tot meer dan alleen een cyberbeveiligingskwestie.

De strategische verschuiving:

- Moderne bedreigingen zijn de huidige perimeter-verdedigingssystemen, die niet langer voldoende bescherming bieden, ontgroeid.

- Beveiligingsexperts die jarenlang in hun vakgebied hebben gewerkt, krijgen nu te maken met deepfake-aanvallen waartegen ze zich niet kunnen verdedigen.

- De huidige "vertrouw maar verifieer" aanpak is niet langer effectief omdat verificatie een permanente operationele procedure moet worden.

- Er moeten realtime detectiesystemen worden ingezet omdat handmatige opsporingsmethoden bedreigingen niet kunnen detecteren voordat ze een bedreiging worden.

De toekomst is aan de voorbereiders

Organisaties moeten kiezen tussen het direct inzetten van AI-detectiesystemen om te voorkomen dat deepfake fraude de voorspelde 155% groei in 2025 bereikt of het risico lopen dat hun systemen openbaar worden gemaakt.

Organisaties die nu handelen, verdedigen hun financiële gezondheid terwijl ze vertrouwensystemen opbouwen die hun positie als leiders in de toekomstige AI-gebaseerde markt veiligstellen.

De bedrijven die AI-bedreigingen als eerste detecteren en snel oplossingen inzetten, zullen slagen in de strijd tussen AI en AI.

Referenties

- Pindrop (12 juni 2025): "Pindrop's 2025 Voice Intelligence & Security Report" - 1.300% deepfake fraude golf, gespreksanalyse gegevens

- Unite.AI (20 uur geleden): "Deepfakes, stemklonen voeden 148% toename van AI-imitatiezwendel" - Identity Theft Resource Center statistieken

- Groep-IB (6 augustus 2025): "De anatomie van een Deepfake Voice Phishing-aanval" - Azië-Pacific 194% golf, financiële impactgegevens

- J.P. Morgan (2025): "AI Scams, Deep Fakes, Impersonations" - $16,6 miljard verlies door fraude, 33% toename

- Incode (20 december 2024): "Top 5 gevallen van AI Deepfake Fraude vanaf 2024" - Deloitte executive survey, WPP case details

- Eftsure VS (2025): "Deepfake-statistieken (2025): 25 nieuwe feiten voor CFO's" - Opleidingskloven, statistieken over het vertrouwen van werknemers

- Security.org (26 augustus 2025): "2024 Deepfakes Gids en Statistieken" - Stem klonen slachtoffer statistieken, regelgevend landschap

- Amerikaanse Orde van Advocaten (2025): "Wat Deepfake Scams ons leren over AI en fraude" - Casestudie Brad Pitt, juridische implicaties

- Axios (15 maart 2025): "AI-zwendel met stemherkenning: Een hardnekkige bedreiging" - Onderzoek van Consumer Reports, FTC-gegevens over imitatie