Le attività fraudolente basate su Deepfake nel mondo degli affari hanno subito un'enorme impennata negli ultimi dodici mesi.

Il Rapporto 2025 sull'intelligenza e la sicurezza vocale di Pindrop rivela che gli attacchi basati sulla voce sono saliti a 1300% in più rispetto alla loro precedente frequenza mensile, perché ora si verificano sette volte al giorno.

La ricerca di 1,2 miliardi di chiamate di clienti effettuata nel rapporto dimostra che questo sviluppo rappresenta qualcosa di più di una normale crescita del crimine informatico, perché significa un cambiamento completo nei metodi operativi delle frodi.

Il modello di crescita non mostra alcuna indicazione di seguire un percorso di sviluppo graduale. La rapidità di questo sconvolgimento ha portato a una completa trasformazione dei sistemi economici basati sulla fiducia.

Molteplici statistiche mostrano la portata di questa crisi in via di sviluppo.

L'Identity Theft Resource Center ha registrato un aumento del 148% delle truffe di impersonificazione nel periodo compreso tra aprile 2024 e marzo 2025.

L'importo totale delle perdite dovute a frodi nel 2024 ha raggiunto $16,6 miliardi, con un aumento di 33% rispetto ai dati del 2023.

I progressi della tecnologia AI hanno trasformato l'inganno in un'operazione industriale che svolge le sue attività a livello industriale.

Esposizione a livello dirigenziale

Gli attacchi di deepfake finanziari hanno preso di mira oltre 25% di sistemi esecutivi che gestiscono operazioni finanziarie e contabili.

Il numero di dirigenti che prevedono che gli attacchi finanziari deepfake aumenteranno nel prossimo anno ha superato i 50%.

Anatomia di un attacco industrializzato

Clonazione vocale: Dai minuti ai momenti

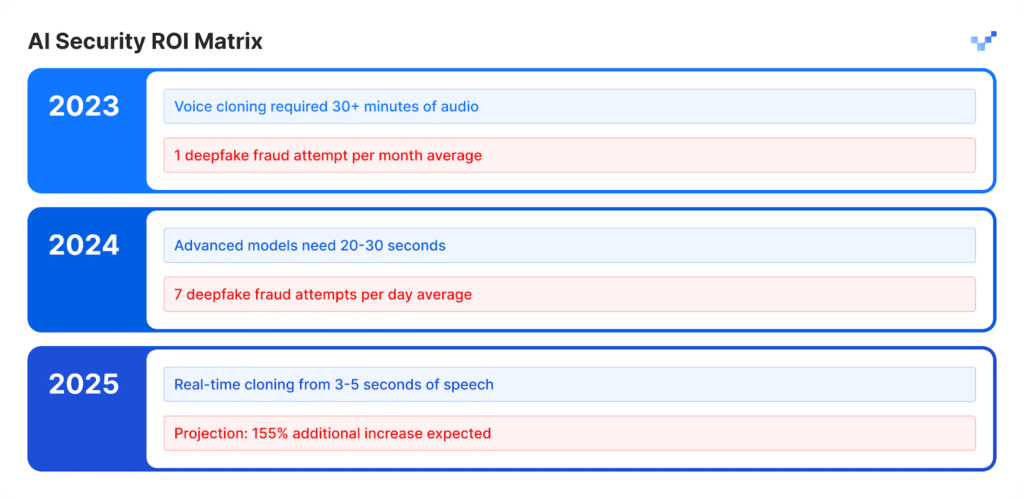

I modelli vocali di intelligenza artificiale hanno registrato una crescita eccezionale nel corso degli ultimi anni.

Il software gratuito di base consente agli utenti di creare voci sintetiche attraverso brevi registrazioni vocali, che in passato richiedevano un ampio materiale audio e strumenti specializzati che richiedevano più giorni per essere completati.

L'output vocale artificiale corrisponde alla qualità naturale delle vocalizzazioni umane.

Non preoccupatevi più delle frodi dell'IA. TruthScan Può aiutarvi:

- Rilevare l'IA generata immagini, testo, voce e video.

- Evitare frodi di grande portata guidate dall'intelligenza artificiale.

- Proteggete i vostri prodotti più sensibile beni dell'impresa.

Impatto per settore:

- Nel settore assicurativo gli attacchi vocali sintetici sono aumentati di 475% in questo periodo.

- Il settore bancario ha registrato un aumento del 149% delle attività fraudolente basate sulla voce.

- I contact center subiranno perdite potenziali di frodi per $44,5 miliardi nei prossimi cinque anni.

- Gli incidenti di sicurezza costano alle aziende in media $600.000 a evento.

Il nuovo volto della frode: Sofisticato e raffinato

I truffatori ora utilizzano attacchi deepfake avanzati che superano le e-mail di truffa di base, perché i loro attacchi hanno una grammatica impeccabile e appaiono in momenti opportuni con un aspetto estremamente autentico.

Questi attacchi sono in grado di aggirare sia i sistemi di sicurezza programmati che i processi di giudizio umano.

Caso di studio: Il quasi incidente di WPP

I criminali hanno tentato di mettere in atto un elaborato schema di frode attraverso la creazione di un falso account WhatsApp intestato al CEO di WPP, combinando un clone vocale che imitava la voce di Mark Read con la riproduzione di video di YouTube per le finte espressioni facciali del nome di Mark Read, utilizzando video registrati da domini pubblici.

Gli aggressori hanno condotto il loro attacco attraverso Microsoft Teams e hanno inviato messaggi falsi convincenti attraverso metodi di impersonificazione e tattiche di social engineering per creare un falso senso di urgenza aziendale.

Gli attaccanti hanno raggiunto un punto in cui sono quasi riusciti a raggiungere il loro obiettivo.

L'inganno degli aggressori non è riuscito perché hanno introdotto piccole incongruenze nella loro narrazione che hanno fatto sì che la vittima mettesse in dubbio la loro storia.

L'incidente ha dimostrato che le tecniche avanzate di inganno dell'IA possono ingannare anche i professionisti più esperti grazie alla loro natura realistica e intricata.

Asia-Pacifico: Il punto caldo globale

L'area Asia-Pacifico è diventata il fulcro mondiale delle attività fraudolente basate sull'IA. Il numero di attacchi legati all'IA nel 2024 è aumentato di 194% rispetto al 2023.

Perché qui? La rapida adozione dei pagamenti digitali, combinata con l'insufficienza dei sistemi di protezione dalle frodi, ha reso la regione un ambiente perfetto per l'azione degli aggressori.

Dati regionali chiave:

- La perdita finanziaria media per ogni incidente ammonta a $600.000.

- Il recupero dei fondi rubati rimane inferiore al 5% in tutti i casi.

- Le perdite finanziarie legate a Deepfake, superiori a $1 milioni, hanno interessato oltre 10% di istituzioni finanziarie.

La regione rappresenta un obiettivo importante per le frodi basate sull'intelligenza artificiale, perché i dipendenti lavorano da remoto e gli strumenti di sintesi vocale sono facilmente accessibili.

Oltre la voce: La frode multivettoriale è qui

Un'impennata di attacchi Face Swap 704%

Secondo iProov, il numero di attacchi di face swap è aumentato di 704% nel 2023, mentre le frodi di mobile web injection sono cresciute di 255%.

Il numero totale di tentativi di frode comprende ora 42,5% di tentativi generati dall'intelligenza artificiale che hanno successo in 30% dei casi.

Gli incidenti di sicurezza segnalati dimostrano un continuo sviluppo di minacce che colpiscono diversi sistemi.

La matrice di vulnerabilità aziendale

- Il settore della vendita al dettaglio ha registrato un aumento delle attività fraudolente nel 2024 e gli esperti prevedono che i casi di frode raddoppieranno nel 2025.

- Gli aggressori utilizzano i deepfake per aggirare i sistemi di verifica dell'identità che proteggono i processi KYC.

- I sistemi di intelligenza artificiale producono profili facciali artificiali che riescono a ingannare i sistemi di riconoscimento facciale.

- Gli aggressori utilizzano contenuti sintetici per generare documenti legali e credenziali ingannevoli attraverso metodi di falsificazione dei documenti.

Il caso Brad Pitt: Frode psicologica abilitata dall'intelligenza artificiale

Un designer d'interni francese è stato vittima di una sofisticata truffa di intelligenza artificiale quando ha trasferito quasi $1 milione di euro ai truffatori nel corso di diversi mesi.

La strategia di attacco:

- L'impostore ha inizialmente contattato la vittima fingendo di essere la madre di Brad Pitt.

- L'audio deepfake e le immagini generate dall'intelligenza artificiale hanno contribuito a mantenere l'illusione nel tempo.

- Cartelle cliniche false e documenti dall'aspetto legale hanno aggiunto un livello di credibilità allo schema.

- I contenuti multimediali hanno reso credibile la falsa identità per diversi mesi.

Una persona che non era nuova alla tecnologia è stata vittima di una semplice truffa.

La vittima operava come proprietario di un'azienda che non sapeva di interagire con l'intelligenza artificiale.

L'incidente dimostra il livello avanzato di inganno che la moderna tecnologia deepfake può raggiungere.

Il gap di rilevamento: perché la maggior parte delle aziende non è preparata

Una crisi di consapevolezza ai vertici

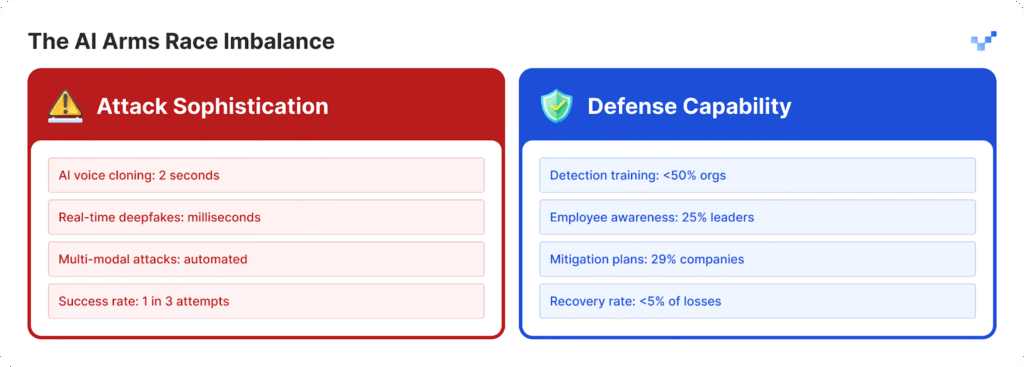

Le organizzazioni faticano a proteggersi dai crescenti attacchi perché non hanno sviluppato strategie di difesa sufficienti.

- I leader di 25% delle organizzazioni mostrano una comprensione limitata delle operazioni di deepfake technology.

- Le organizzazioni faticano a determinare la loro capacità di rilevare gli attacchi deepfake perché 32% di essi rimangono incerti.

- Più della metà delle organizzazioni non fornisce al proprio personale una formazione sulle minacce basate sull'intelligenza artificiale.

- La maggior parte delle organizzazioni non dispone di piani o protocolli specifici per gestire le minacce deepfake.

Per le organizzazioni che iniziano a colmare questo gap di preparazione, strumenti come TruthScan offrono un primo passo fondamentale.

Progettato per il rilevamento dei contenuti AI in tempo reale, TruthScan segnala immagini, testi e media sospetti in diversi formati, aiutando i team a individuare le manipolazioni sintetiche prima che causino danni.

La vulnerabilità del fattore umano

La ricerca McAfee mostra che 70% di persone non riescono a distinguere tra voci autentiche e cloni vocali.

Il problema si aggrava perché 40% di persone rispondono a un messaggio vocale quando pensano che appartenga a una persona cara che ha bisogno di aiuto.

L'attuale minaccia più pericolosa per la sicurezza aziendale emerge dalla combinazione di contenuti realistici generati dall'IA con tecniche di manipolazione psicologica.

Il divario tecnologico si sta ampliando

Il problema dei $40 miliardi di euro

Deloitte prevede che le frodi basate sull'intelligenza artificiale raggiungeranno $40 miliardi negli Stati Uniti entro il 2027, mentre la stima attuale per il 2023 è di $12,3 miliardi.

Secondo le proiezioni, il tasso di crescita annuale per questo periodo raggiungerà le 32%.

L'impatto economico comprende:

- Il danno finanziario immediato si verifica attraverso attività di frode sintetica.

- Si verificano furti di identità personali e un uso improprio delle informazioni personali.

- Le operazioni aziendali subiscono interruzioni a causa del tempo necessario per le indagini forensi.

- Le aziende devono pagare le sanzioni previste dalla normativa perché non attuano misure adeguate di protezione dei dati.

- Le aziende subiscono danni permanenti alla loro reputazione dopo che le loro informazioni vengono rese pubbliche.

Centri di contatto a rischio

Il numero di frodi nel settore retail raggiungerà una ogni 56 chiamate al servizio clienti entro il 2025. La crisi dei contact center si aggraverà perché le attività fraudolente alimentate dall'intelligenza artificiale aumenteranno ad alti volumi.

I governi iniziano a rispondere

Negli Stati Uniti

- La Federal Trade Commission ha stabilito nuove regole che impediscono agli utenti di utilizzare software di impersonificazione vocale.

- L'FBI ora avverte il pubblico degli attacchi di phishing che utilizzano la tecnologia dell'intelligenza artificiale.

- Diversi Stati americani hanno emanato una nuova legislazione incentrata sulla regolamentazione della tecnologia deepfake.

A livello globale

- La legge europea sull'intelligenza artificiale richiede che tutti i contenuti generati dall'intelligenza artificiale mostrino segni evidenti che sono stati prodotti dall'intelligenza artificiale.

- Diverse nazioni hanno sviluppato accordi internazionali che consentono loro di far rispettare le proprie leggi in diversi Paesi.

- Le piattaforme di IA devono dimostrare che i loro sistemi dispongono di misure per prevenire l'uso non autorizzato della loro tecnologia.

L'opportunità della conformità

Le organizzazioni che implementano oggi sistemi avanzati di rilevamento delle frodi tramite AI si affermeranno come leader di mercato.

Le organizzazioni si adegueranno alle nuove normative prima degli altri, perché i loro concorrenti dovranno perdere tempo per mettersi al passo.

Un nuovo paradigma di sicurezza

L'aumento degli attacchi deepfake ha trasformato le operazioni di fiducia digitale in qualcosa di più di una semplice questione di cybersecurity.

Il cambiamento strategico:

- Le minacce moderne hanno superato gli attuali sistemi di difesa perimetrale che non forniscono più una protezione adeguata.

- Gli esperti di sicurezza che hanno trascorso anni nel loro campo sperimentano attacchi deepfake da cui non possono difendersi.

- L'attuale approccio "fidati ma verifica" non è più efficace perché la verifica deve diventare una procedura operativa permanente.

- I sistemi di rilevamento in tempo reale devono essere implementati perché i metodi di rilevamento manuale non sono in grado di rilevare le minacce prima che diventino tali.

Il futuro appartiene a chi è preparato

Le organizzazioni devono scegliere se implementare subito i sistemi di rilevamento dell'intelligenza artificiale per impedire che le frodi deepfake raggiungano la crescita prevista nel 2025 o rischiare di rendere pubblici i loro sistemi.

Le organizzazioni che agiscono ora difenderanno la loro salute finanziaria e costruiranno sistemi di fiducia che garantiranno la loro posizione di leader nel futuro mercato basato sull'intelligenza artificiale.

Le aziende che hanno individuato per prime le minacce dell'IA e che hanno implementato rapidamente le soluzioni avranno successo nella battaglia tra IA e IA.

Riferimenti

- Pindrop (12 giugno 2025): "Pindrop's 2025 Voice Intelligence & Security Report" - 1.300% aumento delle frodi deepfake, dati di analisi delle chiamate

- Unite.AI (20 ore fa): "Deepfakes, cloni vocali alimentano 148% l'aumento delle truffe con imitazione dell'intelligenza artificiale" - Statistiche del Centro risorse per i furti d'identità

- Gruppo-IB (6 agosto 2025): "Anatomia di un attacco di phishing vocale Deepfake" - Impennata in Asia-Pacifico 194%, dati di impatto finanziario

- J.P. Morgan (2025): "Truffe AI, falsi profondi, imitazioni" - $16,6 miliardi di perdite per frode, 33% di aumento

- Incode (20 dicembre 2024): "Top 5 Cases of AI Deepfake Fraud From 2024" - Sondaggio esecutivo Deloitte, dettagli del caso WPP

- Eftsure US (2025): "Statistiche Deepfake (2025): 25 nuovi fatti per i CFO" - Lacune nella formazione, statistiche sulla fiducia dei dipendenti

- Security.org (26 agosto 2025): "2024 Deepfakes Guide and Statistics" - Statistiche sulle vittime della clonazione vocale, panorama normativo

- Associazione degli avvocati americani (2025): "Cosa ci insegnano le truffe Deepfake sull'intelligenza artificiale e le frodi" - Studio del caso Brad Pitt, implicazioni legali

- Axios (15 marzo 2025): "Truffe con clonazione vocale dell'intelligenza artificiale: Una minaccia persistente" - Studio di Consumer Reports, dati di impersonificazione della FTC