Les activités frauduleuses basées sur les "Deepfake" dans le monde des affaires ont connu un essor considérable au cours des douze derniers mois.

Le Rapport de Pindrop sur la sécurité et l'intelligence vocale en 2025 révèle que les attaques vocales ont augmenté de 1300% par rapport à leur fréquence mensuelle précédente, car elles se produisent désormais sept fois par jour.

L'étude de 1,2 milliard d'appels de clients réalisée dans le cadre du rapport prouve que cette évolution représente plus qu'une croissance normale de la cybercriminalité, car elle signifie un changement complet dans les méthodes opérationnelles de la fraude.

Le modèle de croissance ne montre aucune indication d'un développement progressif. Le rythme rapide de ces bouleversements a entraîné une transformation complète des systèmes économiques fondés sur la confiance.

De multiples statistiques montrent l'ampleur de cette crise en devenir.

L'Identity Theft Resource Center a enregistré une hausse de 148% des escroqueries à l'usurpation d'identité au cours de la période allant d'avril 2024 à mars 2025.

Le montant total des pertes dues à la fraude en 2024 a atteint $16,6 milliards, soit une augmentation de 33% par rapport aux chiffres de 2023.

Les progrès de la technologie de l'IA ont fait de la tromperie une opération industrielle qui mène ses activités à un niveau industriel.

Exposition au niveau exécutif

Les attaques financières de type "deepfake" ont ciblé plus de 25% de systèmes exécutifs qui gèrent les opérations financières et comptables.

Le nombre de dirigeants qui prévoient une augmentation des attaques financières de type "deepfake" au cours de l'année prochaine s'élève à plus de 50%.

Anatomie d'une attaque industrialisée

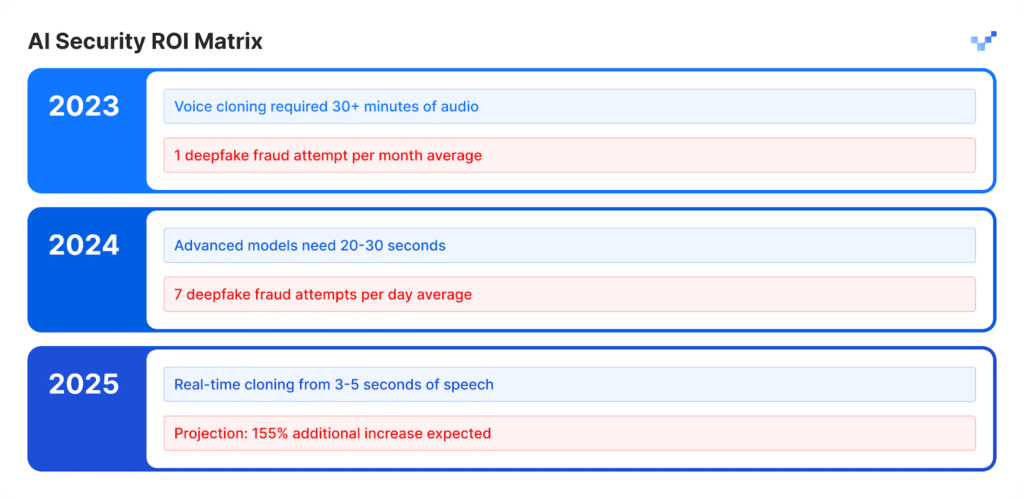

Clonage vocal : Des minutes aux instants

Les modèles vocaux d'IA ont connu une croissance exceptionnelle au cours des dernières années.

Le logiciel gratuit de base permet aux utilisateurs de créer des voix synthétiques à partir de courts enregistrements vocaux, ce qui nécessitait auparavant un matériel audio important et des outils spécialisés nécessitant plusieurs jours de travail.

La sortie de la parole artificielle correspond à la qualité naturelle des vocalisations humaines.

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

Impact par secteur d'activité:

- Le secteur des assurances a vu les attaques par voix synthétique augmenter de 475% au cours de cette période.

- Le secteur bancaire a enregistré une augmentation de 149% des activités frauduleuses basées sur la voix.

- Les centres de contact subiront des pertes potentielles de fraude estimées à $44,5 milliards d'euros au cours des cinq prochaines années.

- Les incidents de sécurité coûtent aux entreprises en moyenne $600 000 par événement.

Le nouveau visage de la fraude : Sophistiquée et raffinée

Les escrocs utilisent aujourd'hui des attaques avancées de type deepfake qui surpassent les courriels d'escroquerie de base parce que leurs attaques ont une grammaire sans faille et apparaissent à des moments opportuns tout en ayant l'air extrêmement authentiques.

Ces attaques visent à contourner à la fois les systèmes de sécurité programmés et les processus de jugement humain.

Étude de cas : L'accident évité de justesse de la WPP

Les criminels ont tenté de mettre en place un système de fraude élaboré en créant un faux compte WhatsApp sous le nom du PDG de WPP, en combinant un clone vocal imitant la voix de Mark Read et la lecture de vidéos YouTube pour de fausses expressions faciales au nom de Mark Read, tout en utilisant des vidéos enregistrées dans des domaines publics.

Les attaquants ont mené leur attaque via Microsoft Teams et ont envoyé de faux messages convaincants par le biais de méthodes d'usurpation d'identité et d'ingénierie sociale afin de créer un faux sentiment d'urgence.

Les attaquants ont atteint un point où ils ont presque réussi à atteindre leur objectif.

La tromperie des agresseurs a échoué parce qu'ils ont introduit de petites incohérences dans leur récit, ce qui a amené la victime à remettre en question leur histoire.

L'incident a prouvé que les techniques avancées de tromperie par l'IA peuvent tromper même des professionnels chevronnés en raison de leur caractère réaliste et complexe.

Asie-Pacifique : Le point chaud mondial

La région Asie-Pacifique est devenue la plaque tournante mondiale des activités frauduleuses basées sur l'IA. Le nombre d'attaques liées à l'IA en 2024 a augmenté de 194% par rapport à 2023.

Pourquoi ici ? L'adoption rapide des paiements numériques, combinée à l'insuffisance des systèmes de protection contre la fraude dans la région, en a fait un environnement idéal pour les attaquants.

Données régionales clés:

- La perte financière moyenne de chaque incident s'élève à $600.000.

- Le recouvrement des fonds volés reste inférieur à 5% dans tous les cas.

- Les pertes financières liées au Deepfake dépassant $1 million ont touché plus de 10% d'institutions financières.

La région est une cible de choix pour les fraudes basées sur l'IA car les employés travaillent à distance et les outils de synthèse vocale sont facilement accessibles.

Au-delà de la voix : La fraude multisectorielle est là

Une hausse de 704% dans les attaques par échange de visages

Selon iProov, le nombre d'attaques par échange de visages a augmenté de 704% au cours de l'année 2023, tandis que les fraudes par injection dans les sites web mobiles ont augmenté de 255%.

Le nombre total de tentatives de fraude comprend désormais 42,5% de tentatives générées par l'IA qui réussissent dans 30% des cas.

Les incidents de sécurité signalés témoignent de l'évolution constante des menaces qui pèsent sur différents systèmes.

La matrice de vulnérabilité des entreprises

- Le secteur du commerce de détail a connu une augmentation de 107% des activités frauduleuses en 2024 et les experts prévoient que les cas de fraude doubleront en 2025.

- Les attaquants utilisent des "deepfakes" pour contourner les systèmes de vérification d'identité qui protègent les processus KYC.

- Les systèmes d'intelligence artificielle produisent des profils faciaux artificiels qui parviennent à tromper les systèmes de reconnaissance faciale.

- Les attaquants utilisent du contenu synthétique pour générer des documents juridiques trompeurs et des informations d'identification par le biais de méthodes de falsification de documents.

L'affaire Brad Pitt : La fraude psychologique par l'IA

Un architecte d'intérieur français a été victime d'une escroquerie sophistiquée à l'IA en transférant près de $1 million à des escrocs pendant plusieurs mois.

La stratégie d'attaque :

- L'imposteur a d'abord contacté la victime en se faisant passer pour la mère de Brad Pitt.

- Les faux sons et les images générées par l'IA ont permis de maintenir l'illusion au fil du temps.

- De faux dossiers médicaux et des documents d'apparence légale ont ajouté une couche de crédibilité au système.

- Grâce au contenu multimédia, la fausse identité est restée crédible pendant plusieurs mois.

Une personne qui n'était pas novice en matière de technologie a été victime d'une simple escroquerie.

La victime était un chef d'entreprise qui n'avait pas conscience d'interagir avec l'intelligence artificielle.

L'incident démontre le niveau avancé de tromperie que peut atteindre la technologie moderne du "deepfake".

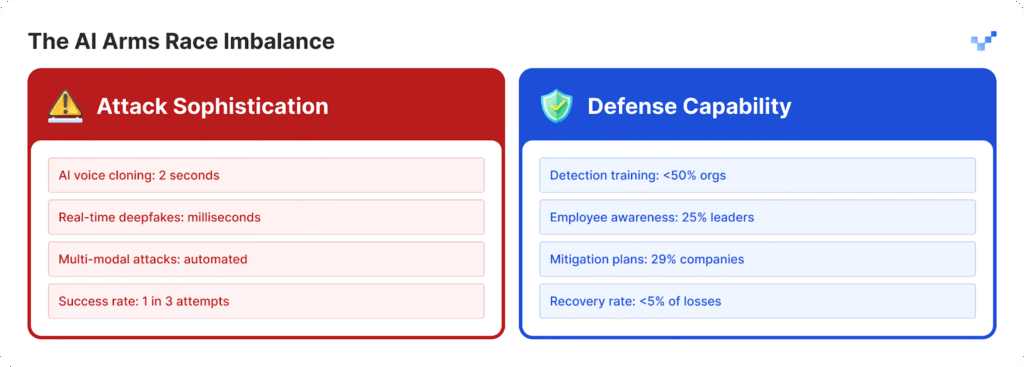

Le déficit de détection : pourquoi la plupart des entreprises ne sont pas préparées

Une crise de conscience au sommet

Les organisations ont du mal à se protéger contre les attaques croissantes parce qu'elles n'ont pas développé de stratégies de défense suffisantes.

- Les dirigeants de 25% des organisations font preuve d'une compréhension limitée des opérations liées à la technologie deepfake.

- Les organisations ont du mal à déterminer leur capacité à détecter les attaques de type "deepfake" car 32% d'entre elles restent incertaines.

- Plus de la moitié des organisations n'offrent pas à leur personnel de formation sur les menaces basées sur l'IA.

- La plupart des organisations n'ont pas de plans établis ou de protocoles spécifiques pour gérer les menaces de type "deepfake".

Pour les organisations qui commencent à combler ce déficit de préparation, des outils tels que le TruthScan constituent une première étape cruciale.

Conçu pour la détection de contenu IA en temps réel, TruthScan signale les visuels, textes et médias suspects dans de multiples formats, aidant ainsi les équipes à repérer les manipulations synthétiques avant qu'elles ne causent des dommages.

La vulnérabilité du facteur humain

L'étude de McAfee montre que 70% des personnes ne parviennent pas à faire la distinction entre les voix authentiques et les clones vocaux.

Le problème s'aggrave car 40% des personnes répondent à un message vocal lorsqu'elles pensent qu'il s'agit d'un proche qui a besoin d'aide.

La menace la plus dangereuse pour la sécurité des entreprises provient de la combinaison de contenus réalistes générés par l'IA et de techniques de manipulation psychologique.

Le fossé technologique se creuse

Le problème des $40 milliards

Deloitte prévoit que la fraude basée sur l'IA atteindra $40 milliards aux États-Unis d'ici 2027, alors que l'estimation actuelle pour 2023 s'élève à $12,3 milliards.

Le taux de croissance annuel pour cette période atteindra 32% selon les projections.

L'impact économique comprend

- Les dommages financiers immédiats sont causés par les activités de fraude synthétique.

- Le vol d'identités personnelles et l'utilisation abusive d'informations personnelles à grande échelle se produisent.

- Les opérations commerciales sont perturbées en raison du temps nécessaire à l'enquête médico-légale.

- Les entreprises doivent payer des pénalités réglementaires parce qu'elles ne mettent pas en œuvre des mesures appropriées de protection des données.

- Les entreprises subissent une atteinte permanente à leur réputation lorsque leurs informations sont rendues publiques.

Les centres de contact en danger

Le nombre de cas de fraude dans le commerce de détail atteindra un appel de service à la clientèle sur 56 d'ici 2025. La crise des centres de contact va s'aggraver car les activités frauduleuses alimentées par l'IA vont augmenter à des volumes élevés.

Les gouvernements commencent à réagir

Aux États-Unis

- La Commission fédérale du commerce a établi de nouvelles règles qui empêchent les utilisateurs de recourir à des logiciels d'usurpation d'identité vocale.

- Le FBI alerte désormais le public sur les attaques de phishing qui utilisent la technologie de l'intelligence artificielle.

- Plusieurs États américains ont adopté une nouvelle législation axée sur la réglementation de la technologie "deepfake".

Au niveau mondial

- La loi européenne sur l'IA exige que tous les contenus générés par l'IA montrent des signes évidents qu'ils ont été produits par l'intelligence artificielle.

- Plusieurs nations ont conclu des accords internationaux qui leur permettent d'appliquer leurs lois dans différents pays.

- Les plateformes d'IA doivent démontrer que leurs systèmes sont dotés de mesures visant à empêcher l'utilisation non autorisée de leur technologie.

L'opportunité de conformité

Les organisations qui mettent en œuvre dès aujourd'hui des systèmes avancés de détection des fraudes par l'IA s'imposeront comme les leaders du marché.

Les organisations respecteront les réglementations à venir avant les autres, car leurs concurrents doivent passer du temps à les rattraper.

Un nouveau paradigme de sécurité

L'augmentation 1300% des attaques de type "deepfake" a transformé les opérations de confiance numérique en quelque chose de plus qu'une simple question de cybersécurité.

Le changement stratégique :

- Les menaces modernes ont dépassé les systèmes de défense périmétrique actuels qui n'offrent plus une protection adéquate.

- Les experts en sécurité qui ont passé des années dans leur domaine subissent aujourd'hui des attaques de type "deepfake" contre lesquelles ils ne peuvent pas se défendre.

- L'approche actuelle "faire confiance mais vérifier" n'est plus efficace car la vérification doit devenir une procédure opérationnelle permanente.

- Des systèmes de détection en temps réel doivent être déployés car les méthodes de découverte manuelle ne peuvent pas détecter les menaces avant qu'elles ne deviennent des menaces.

L'avenir appartient à ceux qui sont préparés

Les organisations doivent choisir entre déployer immédiatement des systèmes de détection de l'IA pour empêcher la fraude par deepfake d'atteindre sa croissance prévue de 155% en 2025 ou risquer la divulgation publique de leurs systèmes.

Les organisations qui agissent maintenant défendront leur santé financière tout en construisant des systèmes de confiance qui leur assureront une position de leader sur le futur marché basé sur l'IA.

Les entreprises qui ont détecté les menaces liées à l'IA en premier et qui ont déployé des solutions rapidement réussiront dans la bataille entre l'IA et l'IA.

Références

- Pindrop (12 juin 2025): "Pindrop's 2025 Voice Intelligence & Security Report" - 1,300% deepfake fraud surge, call analysis data

- Unite.AI (20 heures passées): "Deepfakes, Voice Clones Fuel 148% Surge in AI Impersonation Scams" - Statistiques du centre de ressources sur le vol d'identité (Identity Theft Resource Center)

- Groupe-IB (6 août 2025): "Anatomie d'une attaque de phishing vocal Deepfake" - Asie-Pacifique 194%, données sur l'impact financier

- J.P. Morgan (2025): "AI Scams, Deep Fakes, Impersonations" - $16,6 milliards de pertes dues à la fraude, 33% d'augmentation.

- Incode (20 décembre 2024): "Top 5 Cases of AI Deepfake Fraud From 2024" - Deloitte executive survey, WPP case details (en anglais).

- Eftsure US (2025): "Statistiques Deepfake (2025) : 25 new facts for CFOs" - Lacunes en matière de formation, statistiques sur la confiance des employés

- Security.org (26 août 2025): "2024 Deepfakes Guide and Statistics" - Statistiques sur les victimes du clonage vocal, paysage réglementaire

- Association du barreau américain (2025): "Ce que les escroqueries de type Deepfake nous apprennent sur l'IA et la fraude" - Étude du cas Brad Pitt, implications juridiques

- Axios (15 mars 2025): "Les escroqueries par clonage de voix AI : Une menace persistante" - Étude de Consumer Reports, données de la FTC sur l'usurpation d'identité