Deepfake-basierte betrügerische Aktivitäten in der Geschäftswelt erlebten in den letzten zwölf Monaten einen enormen Anstieg.

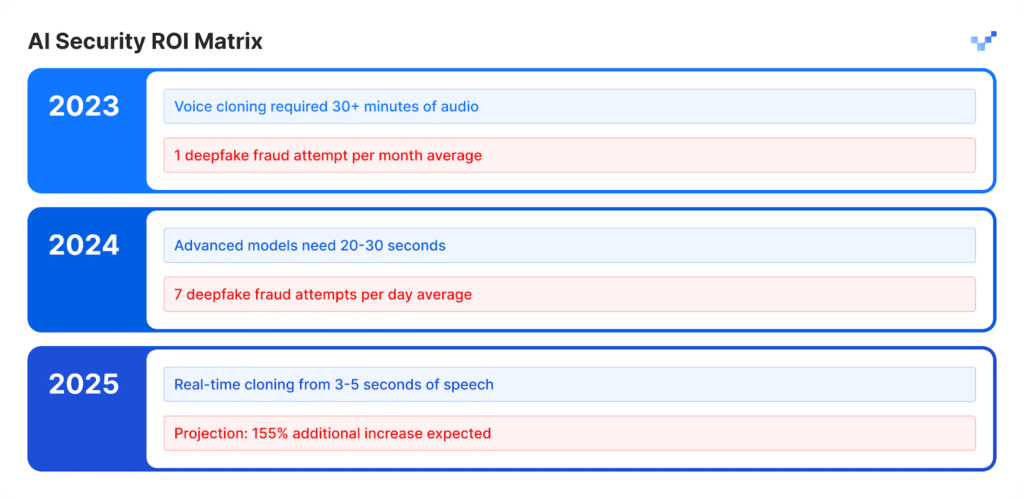

Die 2025 Voice Intelligence & Security Bericht von Pindrop zeigt, dass die Zahl der sprachbasierten Angriffe auf 1300% angestiegen ist, da sie nun sieben Mal pro Tag auftreten.

Die Untersuchung von 1,2 Milliarden Kundenanrufen durch den Bericht beweist, dass diese Entwicklung mehr als nur ein normales Wachstum der Cyberkriminalität darstellt, da sie eine vollständige Veränderung der Betrugsmethoden bedeutet.

Das Wachstumsmuster deutet nicht auf einen allmählichen Entwicklungspfad hin. Das rasante Tempo dieses Umbruchs hat zu einer vollständigen Umgestaltung der auf Vertrauen basierenden Wirtschaftssysteme geführt.

Mehrere Statistiken zeigen das ganze Ausmaß dieser sich entwickelnden Krise.

Das Identity Theft Resource Center verzeichnete im Zeitraum von April 2024 bis März 2025 einen Anstieg von 148% an Betrugsversuchen mit falschen Namen.

Der Gesamtbetrag der Betrugsverluste im Jahr 2024 erreichte $16,6 Milliarden, was einen Anstieg von 33% gegenüber den Zahlen für 2023 bedeutet.

Die Fortschritte in der KI-Technologie haben die Täuschung zu einem industriellen Betrieb gemacht, der seine Aktivitäten auf industrieller Ebene durchführt.

Exposition auf Führungsebene

Deepfake-Angriffe im Finanzbereich haben es auf mehr als 25% von Führungssystemen abgesehen, die sowohl Finanz- als auch Buchhaltungsvorgänge verwalten.

Die Zahl der Führungskräfte, die für das nächste Jahr einen Anstieg der Deepfake-Angriffe im Finanzbereich vorhersagen, hat mehr als 50% erreicht.

Anatomie eines industrialisierten Angriffs

Klonen von Stimmen: Von Minuten zu Momenten

KI-Sprachmodelle haben in den letzten Jahren ein außergewöhnliches Wachstum in ihrer Entwicklung gezeigt.

Die kostenlose Basissoftware ermöglicht es den Nutzern, synthetische Stimmen durch kurze Sprachaufnahmen zu erzeugen, für die früher umfangreiches Audiomaterial und spezielle Werkzeuge erforderlich waren, die mehrere Tage in Anspruch nahmen.

Die künstliche Sprachausgabe entspricht der natürlichen Qualität der menschlichen Vokalisation.

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

Auswirkungen nach Branchen:

- Der Versicherungssektor verzeichnete in diesem Zeitraum einen Anstieg der Angriffe auf synthetische Sprache um 475%.

- Der Bankensektor verzeichnete einen Anstieg von 149% an sprachbasierten betrügerischen Aktivitäten.

- Kontaktzentren werden in den nächsten fünf Jahren mit potenziellen Betrugsverlusten in Höhe von $44,5 Milliarden Euro rechnen müssen.

- Sicherheitsvorfälle kosten Unternehmen durchschnittlich $600.000 pro Vorfall.

Das neue Gesicht des Betrugs: Raffiniert und geschliffen

Betrüger setzen inzwischen fortgeschrittene Deepfake-Angriffe ein, die einfache Betrugs-E-Mails übertreffen, da ihre Angriffe eine einwandfreie Grammatik aufweisen, zu günstigen Zeitpunkten erscheinen und äußerst authentisch aussehen.

Diese Angriffe zielen darauf ab, sowohl programmierte Sicherheitssysteme als auch menschliche Beurteilungsprozesse zu umgehen.

Fallstudie: Der Beinahe-Unfall bei WPP

Die Kriminellen versuchten, ein ausgeklügeltes Betrugsmanöver durchzuführen, indem sie ein gefälschtes WhatsApp-Konto unter dem Namen des WPP-CEO einrichteten. Dazu kombinierten sie einen Stimmenklon, der die Stimme von Mark Read nachahmte, mit der Wiedergabe von YouTube-Videos, um die Mimik von Mark Read zu fälschen, und nutzten dabei aufgezeichnete Videos aus öffentlichen Bereichen.

Die Angreifer führten ihren Angriff über Microsoft Teams durch und versendeten überzeugende gefälschte Nachrichten mit Hilfe von Imitationsmethoden und Social-Engineering-Taktiken, um ein falsches Gefühl von geschäftlicher Dringlichkeit zu erzeugen.

Die Angreifer erreichten einen Punkt, an dem sie ihr Ziel fast erreicht hatten.

Die Täuschung der Angreifer scheiterte, weil sie kleine Ungereimtheiten in ihre Erzählung einbrachten, die das Opfer an ihrer Geschichte zweifeln ließen.

Der Vorfall bewies, dass fortschrittliche KI-Täuschungstechniken aufgrund ihrer realistischen und komplexen Natur selbst erfahrene Profis austricksen können.

Asien-Pazifik: Der globale Hotspot

Der asiatisch-pazifische Raum ist zur weltweiten Drehscheibe für KI-basierte betrügerische Aktivitäten geworden. Die Zahl der KI-bezogenen Angriffe stieg im Jahr 2024 im Vergleich zu 2023 um 194%.

Warum gerade hier? Die rasche Einführung des digitalen Zahlungsverkehrs in Kombination mit unzureichenden Betrugsschutzsystemen in der Region macht sie zu einem perfekten Umfeld für Angreifer.

Regionale Schlüsseldaten:

- Der durchschnittliche finanzielle Schaden pro Vorfall beläuft sich auf $600.000.

- Die Wiedereinziehung gestohlener Gelder liegt in allen Fällen unter 5%.

- Von den durch Deepfake verursachten finanziellen Verlusten in Höhe von mehr als $1 Mio. waren mehr als 10% der Finanzinstitute betroffen.

Die Region ist ein wichtiges Ziel für KI-basierte Betrügereien, da die Mitarbeiter aus der Ferne arbeiten und Sprachsynthesetools leicht zugänglich sind.

Jenseits der Stimme: Multi-Vektor-Betrug ist da

A 704% Anstieg der Face-Swap-Angriffe

Die Zahl der Face-Swap-Angriffe stieg laut iProov im Jahr 2023 um 704%, während der Betrug durch mobile Web-Injektionen um 255% zunahm.

Die Gesamtzahl der Betrugsversuche umfasst nun 42,5% KI-generierte Versuche, die in 30% der Fälle erfolgreich waren.

Die gemeldeten Sicherheitsvorfälle zeigen eine kontinuierliche Entwicklung von Bedrohungen, die verschiedene Systeme betreffen.

Die Schwachstellenmatrix für Unternehmen

- Der Einzelhandel verzeichnete im Jahr 2024 einen Anstieg der betrügerischen Aktivitäten um 107%, und Experten gehen davon aus, dass sich die Betrugsfälle bis 2025 verdoppeln werden.

- Angreifer verwenden Deepfakes, um ID-Verifikationssysteme zu umgehen, die vor KYC-Prozessen schützen.

- Systeme der künstlichen Intelligenz erstellen künstliche Gesichtsprofile, mit denen es gelingt, Gesichtserkennungssysteme zu täuschen.

- Angreifer verwenden synthetische Inhalte, um mit Hilfe von Dokumentenfälschungsmethoden trügerische Rechtsdokumente und Berechtigungsnachweise zu erstellen.

Der Fall Brad Pitt: KI-gestützter psychologischer Betrug

Ein französischer Innenarchitekt wurde Opfer eines ausgeklügelten KI-Betrugs, als er über mehrere Monate hinweg fast $1 Million an Betrüger überwies.

Die Angriffsstrategie:

- Der Betrüger nahm zunächst Kontakt mit dem Opfer auf und gab sich als Brad Pitts Mutter aus.

- Deepfake-Audio und KI-generierte Bilder halfen dabei, die Illusion über die Zeit aufrecht zu erhalten.

- Gefälschte Krankenakten und legal aussehende Dokumente machten die Sache noch glaubwürdiger.

- Multimediale Inhalte hielten die falsche Identität mehrere Monate lang glaubhaft.

Eine Person, der die Technik nicht fremd war, wurde Opfer eines simplen Betrugs.

Das Opfer war ein Geschäftsinhaber, der nicht wusste, dass er mit künstlicher Intelligenz interagierte.

Der Vorfall zeigt, welch fortgeschrittenes Niveau der Täuschung die moderne Deepfake-Technologie erreichen kann.

Die Aufdeckungslücke: Warum die meisten Unternehmen unvorbereitet sind

Eine Bewusstseinskrise an der Spitze

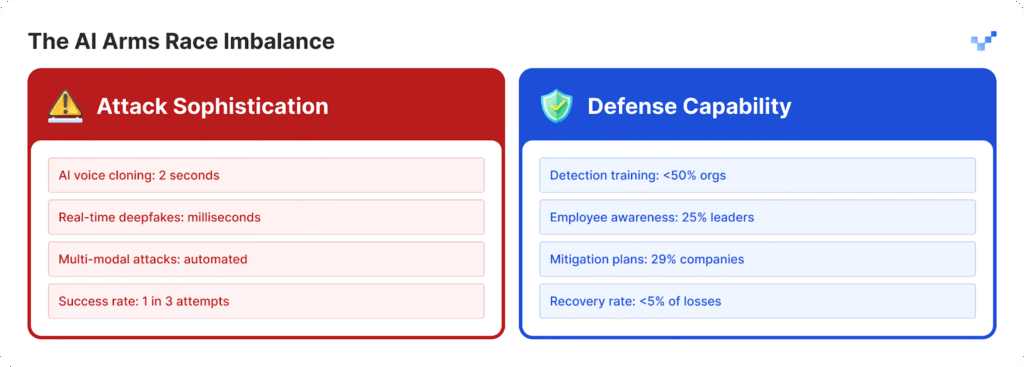

Unternehmen haben Schwierigkeiten, sich vor den zunehmenden Angriffen zu schützen, weil sie keine ausreichenden Abwehrstrategien entwickelt haben.

- Führungskräfte in 25% der Unternehmen haben nur ein begrenztes Verständnis für die Funktionsweise der Deepfake-Technologie.

- Unternehmen haben Schwierigkeiten, ihre Fähigkeit zur Erkennung von Deepfake-Angriffen zu bestimmen, da 32% von ihnen unsicher bleiben.

- Mehr als die Hälfte der Unternehmen bieten ihren Mitarbeitern keine Schulungen zu KI-basierten Bedrohungen an.

- Die meisten Unternehmen verfügen nicht über etablierte Pläne oder spezifische Protokolle für den Umgang mit Deepfake-Bedrohungen.

Für Organisationen, die damit beginnen, diese Bereitschaftslücke zu schließen, sind Tools wie TruthScan bieten einen entscheidenden ersten Schritt.

TruthScan wurde für die Erkennung von KI-Inhalten in Echtzeit entwickelt und kennzeichnet verdächtige Bilder, Texte und Medien in verschiedenen Formaten, damit Teams synthetische Manipulationen erkennen können, bevor sie Schaden anrichten.

Der menschliche Faktor - Schwachstelle

Untersuchungen von McAfee zeigen, dass 70% der Menschen können nicht zwischen echten Stimmen und Stimmklonen unterscheiden.

Das Problem eskaliert, weil 40% der Menschen auf eine Sprachnachricht antworten würden, wenn sie glauben, dass sie zu einem geliebten Menschen gehört, der Hilfe braucht.

Die derzeit gefährlichste Bedrohung für die Unternehmenssicherheit ergibt sich aus der Kombination von KI-generierten realistischen Inhalten mit psychologischen Manipulationstechniken.

Die technologische Kluft vergrößert sich

Das $40-Milliarden-Problem

Deloitte prognostiziert, dass KI-gestützter Betrug in den Vereinigten Staaten bis 2027 ein Volumen von $40 Milliarden erreichen wird, während die aktuelle Schätzung für 2023 bei $12,3 Milliarden liegt.

Die jährliche Wachstumsrate für diesen Zeitraum wird den Prognosen zufolge 32% erreichen.

Die wirtschaftlichen Auswirkungen umfassen:

- Der unmittelbare finanzielle Schaden entsteht durch synthetische Betrugsaktivitäten.

- Es kommt zum Diebstahl persönlicher Identitäten und zum erweiterten Missbrauch persönlicher Daten.

- Der Geschäftsbetrieb wird durch die Zeit, die für die forensische Untersuchung benötigt wird, gestört.

- Unternehmen müssen Strafen zahlen, weil sie keine angemessenen Datenschutzmaßnahmen ergreifen.

- Unternehmen erleiden einen dauerhaften Rufschaden, wenn ihre Informationen an die Öffentlichkeit gelangen.

Gefährdete Kontaktzentren

Die Zahl der Betrugsfälle im Einzelhandel wird bis 2025 auf einen von 56 Kundendienstanrufen ansteigen. Die Krise im Contact Center wird sich verschärfen, da KI-gestützte betrügerische Aktivitäten in großem Umfang zunehmen werden.

Die Regierungen beginnen zu reagieren

In den U.S.A.

- Die Federal Trade Commission hat neue Vorschriften erlassen, die verhindern, dass Nutzer Software zur Nachahmung von Stimmen einsetzen.

- Das FBI warnt nun die Öffentlichkeit vor Phishing-Angriffen, die sich der Technologie der künstlichen Intelligenz bedienen.

- Mehrere amerikanische Bundesstaaten haben neue Gesetze erlassen, die sich auf die Regulierung der Deepfake-Technologie konzentrieren.

Weltweit

- Das EU-KI-Gesetz schreibt vor, dass alle KI-generierten Inhalte eindeutige Anzeichen dafür aufweisen müssen, dass sie durch künstliche Intelligenz erzeugt wurden.

- Mehrere Staaten haben internationale Abkommen geschlossen, die es ihnen ermöglichen, ihre Gesetze in verschiedenen Ländern durchzusetzen.

- KI-Plattformen müssen nachweisen, dass ihre Systeme über Maßnahmen verfügen, die eine unbefugte Nutzung ihrer Technologie verhindern.

Die Chance zur Einhaltung der Vorschriften

Unternehmen, die heute fortschrittliche KI-Betrugserkennungssysteme implementieren, werden sich als Marktführer etablieren.

Die Unternehmen werden kommende Vorschriften vor anderen erfüllen, weil ihre Konkurrenten Zeit aufholen müssen.

Ein neues Sicherheitsparadigma

Die Zunahme von Deepfake-Angriffen (1300%) hat dazu geführt, dass digitale Vertrauensvorgänge nicht mehr nur eine Frage der Cybersicherheit sind.

Die Strategieverschiebung:

- Die modernen Bedrohungen sind den heutigen Perimeterschutzsystemen entwachsen, die keinen ausreichenden Schutz mehr bieten.

- Sicherheitsexperten, die jahrelang auf ihrem Gebiet gearbeitet haben, erleben nun Deepfake-Angriffe, gegen die sie sich nicht wehren können.

- Der derzeitige Ansatz "Vertrauen, aber Überprüfung" ist nicht mehr wirksam, da die Überprüfung zu einem ständigen operativen Verfahren werden muss.

- Es müssen Echtzeit-Erkennungssysteme eingesetzt werden, da manuelle Erkennungsmethoden Bedrohungen nicht erkennen können, bevor sie zu Bedrohungen werden.

Die Zukunft gehört den Vorbereiteten

Unternehmen müssen sich entscheiden, ob sie sofort KI-Erkennungssysteme einsetzen, um zu verhindern, dass der Deepfake-Betrug das für 2025 prognostizierte Wachstum von 155% erreicht, oder ob sie die Offenlegung ihrer Systeme riskieren.

Unternehmen, die jetzt handeln, schützen ihre finanzielle Gesundheit und bauen gleichzeitig Vertrauenssysteme auf, die ihre Position als Marktführer auf dem zukünftigen KI-basierten Markt sichern werden.

Die Unternehmen, die KI-Bedrohungen zuerst erkennen und schnell Lösungen bereitstellen, werden im Kampf KI gegen KI erfolgreich sein.

Referenzen

- Pindrop (Juni 12, 2025): "Pindrop's 2025 Voice Intelligence & Security Report" - 1.300% Deepfake-Betrugsanstieg, Anrufanalyse-Daten

- Unite.AI (vor 20 Stunden): "Deepfakes, Voice Clones Fuel 148% Surge in AI Impersonation Scams" - Identity Theft Resource Center Statistiken

- Gruppe-IB (6. August 2025): "Die Anatomie eines Deepfake-Voice-Phishing-Angriffs" - Asien-Pazifik 194%-Welle, Daten zu den finanziellen Auswirkungen

- J.P. Morgan (2025): "AI Scams, Deep Fakes, Impersonations" - $16,6 Milliarden Betrugsverluste, 33% Anstieg

- Incode (Dezember 20, 2024): "Top 5 Cases of AI Deepfake Fraud From 2024" - Deloitte executive survey, WPP case details

- Eftsure US (2025): "Deepfake-Statistik (2025): 25 neue Fakten für CFOs" - Ausbildungslücken, Statistiken über das Vertrauen der Mitarbeiter

- Sicherheit.org (August 26, 2025): "2024 Deepfakes Guide and Statistics" - Statistik der Opfer des Stimmenklonens, rechtliche Rahmenbedingungen

- Amerikanische Anwaltskammer (2025): "Was uns Deepfake-Betrügereien über KI und Betrug lehren" - Brad Pitt Fallstudie, rechtliche Auswirkungen

- Axios (15. März 2025): "AI-Stimmenklon-Betrug: Eine anhaltende Bedrohung" - Consumer Reports-Studie, FTC-Daten zu Imitationen