As atividades fraudulentas baseadas em deepfake no mundo dos negócios sofreram um enorme aumento nos últimos doze meses.

O Relatório de inteligência e segurança de voz 2025 da Pindrop revela que os ataques baseados em voz aumentaram para 1300% mais do que sua ocorrência mensal anterior, porque agora ocorrem sete vezes por dia.

A pesquisa de 1,2 bilhão de chamadas de clientes por meio do relatório prova que esse desenvolvimento representa mais do que o crescimento padrão do crime cibernético, pois significa uma mudança completa nos métodos operacionais de fraude.

O padrão de crescimento não mostra nenhuma indicação de seguir um caminho de desenvolvimento gradual. O ritmo acelerado dessa ruptura levou a uma transformação completa dos sistemas econômicos baseados na confiança.

Várias estatísticas mostram a extensão total dessa crise em desenvolvimento.

O Identity Theft Resource Center registrou um aumento de 148% nos golpes de falsificação de identidade durante o período de abril de 2024 a março de 2025.

O valor total das perdas por fraude em 2024 atingiu $16,6 bilhões, mostrando um aumento de 33% em relação aos números de 2023.

Os avanços da tecnologia de IA transformaram o engano em uma operação industrial que conduz suas atividades em nível industrial.

Exposição em nível executivo

Os ataques de deepfake financeiro tiveram como alvo mais de 25% de sistemas executivos que gerenciam operações financeiras e contábeis.

O número de executivos que preveem que os ataques financeiros de deepfake aumentarão no próximo ano chegou a mais de 50%.

Anatomia de um ataque industrializado

Clonagem de voz: De minutos a momentos

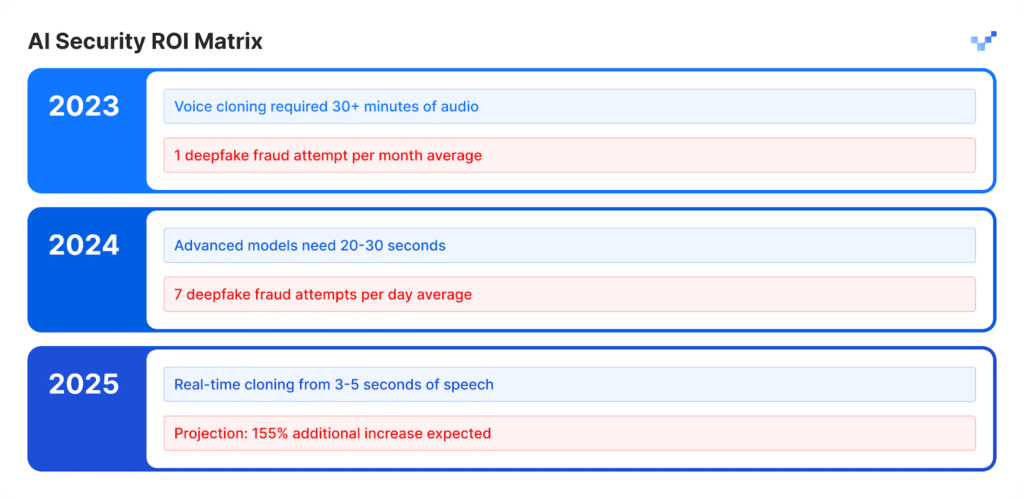

Os modelos de fala com IA apresentaram um crescimento excepcional em seu desenvolvimento nos últimos anos.

O software básico gratuito permite que os usuários criem vozes sintéticas por meio de gravações de voz curtas, o que antes exigia um extenso material de áudio e ferramentas especializadas que levavam vários dias para serem concluídas.

A saída de fala artificial corresponde à qualidade natural das vocalizações humanas.

Nunca mais se preocupe com fraudes de IA. TruthScan Pode lhe ajudar:

- Detectar IA gerada imagens, texto, voz e vídeo.

- Evitar grande fraude impulsionada por IA.

- Proteja seus mais sensível ativos da empresa.

Impacto por setor:

- O setor de seguros viu os ataques de voz sintética aumentarem em 475% durante esse período.

- O setor bancário registrou um aumento de 149% nas atividades fraudulentas baseadas em voz.

- Os contact centers sofrerão perdas projetadas de $44,5 bilhões em possíveis fraudes nos próximos cinco anos.

- Os incidentes de segurança custam às empresas uma média de $600.000 por ocorrência.

A nova face da fraude: Sofisticada e polida

Os golpistas agora empregam ataques avançados de deepfake que superam os e-mails básicos de golpes porque seus ataques têm gramática impecável e aparecem em momentos oportunos, parecendo extremamente autênticos.

Esses ataques funcionam para contornar tanto os sistemas de segurança programados quanto os processos de julgamento humano.

Estudo de caso: O quase acidente da WPP

Os criminosos tentaram executar um esquema de fraude elaborado por meio da criação de uma conta falsa no WhatsApp com o nome do CEO da WPP, combinando um clone de voz que imitava a voz de Mark Read com a reprodução de vídeos do YouTube para expressões faciais falsas com o nome de Mark Read, utilizando vídeos gravados de domínios públicos.

Os invasores conduziram o ataque por meio do Microsoft Teams e enviaram mensagens falsas convincentes por meio de métodos de personificação e táticas de engenharia social para criar um falso senso de urgência comercial.

Os atacantes chegaram a um ponto em que quase conseguiram atingir seu objetivo.

O engano dos agressores não foi bem-sucedido porque eles introduziram pequenas inconsistências em sua narrativa, o que fez com que a vítima questionasse sua história.

O incidente provou que as técnicas avançadas de fraude de IA podem enganar até mesmo profissionais experientes devido à sua natureza realista e complexa.

Ásia-Pacífico: O ponto de acesso global

A região da Ásia-Pacífico se tornou o centro mundial de atividades fraudulentas baseadas em IA. O número de ataques relacionados à IA durante 2024 aumentou em 194% em comparação com 2023.

Por que aqui? A rápida adoção de pagamentos digitais, combinada com sistemas insuficientes de proteção contra fraudes na região, tornou-a um ambiente perfeito para os invasores operarem.

Principais dados regionais:

- O prejuízo financeiro médio de cada incidente é de $600.000.

- A recuperação de fundos roubados permanece abaixo de 5% em todos os casos.

- As perdas financeiras relacionadas ao Deepfake, superiores a $1 milhão, afetaram mais de 10% de instituições financeiras.

A região é um alvo importante para fraudes baseadas em IA porque os funcionários trabalham remotamente e as ferramentas de síntese de voz são facilmente acessíveis.

Além da voz: A fraude multivetorial chegou

Um aumento de 704% em ataques de troca de face

O número de ataques de troca de rosto aumentou em 704% durante 2023, de acordo com o iProov, enquanto a fraude de injeção na Web móvel cresceu em 255%.

O número total de tentativas de fraude agora inclui 42,5% de tentativas geradas por IA, que são bem-sucedidas em 30% dos casos.

Os incidentes de segurança relatados demonstram um desenvolvimento contínuo de ameaças que afetam diferentes sistemas.

A matriz de vulnerabilidade da empresa

- O setor de varejo registrou um aumento de 107% nas atividades fraudulentas em 2024 e os especialistas preveem que os casos de fraude dobrarão em 2025.

- Os invasores usam deepfakes para contornar os sistemas de verificação de identidade que protegem contra os processos KYC.

- Os sistemas de inteligência artificial produzem perfis faciais artificiais que conseguem enganar os sistemas de reconhecimento facial.

- Os invasores usam conteúdo sintético para gerar documentos e credenciais legais enganosos por meio de métodos de falsificação de documentos.

O caso Brad Pitt: Fraude psicológica habilitada por IA

Um designer de interiores francês foi vítima de um sofisticado golpe de IA ao transferir quase $1 milhão para golpistas durante vários meses.

A estratégia de ataque:

- O impostor inicialmente entrou em contato com a vítima fingindo ser a mãe de Brad Pitt.

- O áudio deepfake e as imagens geradas por IA ajudaram a manter a ilusão ao longo do tempo.

- Registros médicos falsos e documentos de aparência legal adicionavam uma camada de credibilidade ao esquema.

- O conteúdo multimídia manteve a falsa identidade crível por vários meses.

Uma pessoa que não era novata em tecnologia foi vítima de um golpe simples.

A vítima operava como proprietário de uma empresa que não sabia que estava interagindo com inteligência artificial.

O incidente demonstra o nível avançado de fraude que a moderna tecnologia deepfake pode alcançar.

A lacuna de detecção: por que a maioria das empresas não está preparada

Uma crise de conscientização no topo

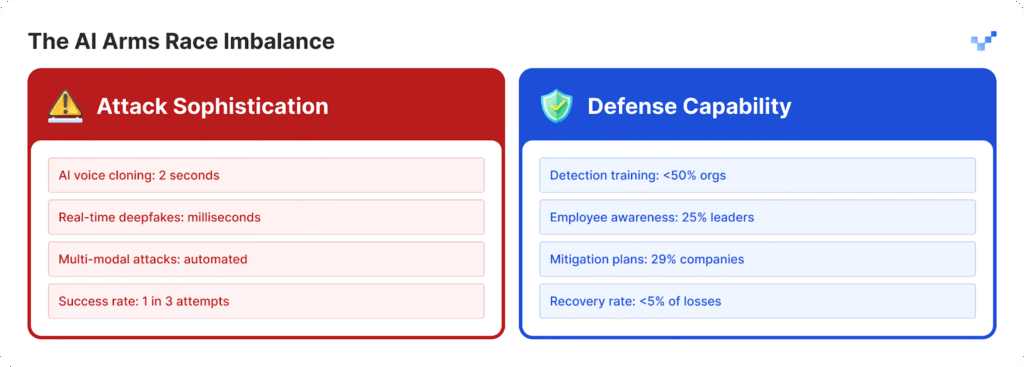

As organizações lutam para se proteger dos crescentes ataques porque não desenvolveram estratégias de defesa suficientes.

- Os líderes de 25% das organizações demonstram conhecimento limitado sobre as operações da tecnologia deepfake.

- As organizações têm dificuldade para determinar sua capacidade de detectar ataques deepfake porque 32% deles permanecem incertos.

- Mais da metade das organizações não oferece treinamento aos membros da equipe sobre ameaças baseadas em IA.

- A maioria das organizações não tem planos estabelecidos ou protocolos específicos para lidar com ameaças de deepfake.

Para as organizações que estão começando a fechar essa lacuna de prontidão, ferramentas como TruthScan oferecem um primeiro passo fundamental.

Projetado para a detecção de conteúdo de IA em tempo real, o TruthScan sinaliza visuais, textos e mídias suspeitos em vários formatos, ajudando as equipes a identificar a manipulação sintética antes que ela cause danos.

A vulnerabilidade do fator humano

A pesquisa da McAfee mostra que 70% das pessoas não conseguem distinguir entre vozes autênticas e clones de voz.

O problema se agrava porque 40% das pessoas responderiam a uma mensagem de correio de voz quando acham que ela pertence a alguém que amam e que precisa de ajuda.

A atual ameaça mais perigosa à segurança empresarial surge da combinação de conteúdo realista gerado por IA com técnicas de manipulação psicológica.

A lacuna tecnológica está aumentando

O problema de $40 bilhões

A Deloitte prevê que a fraude baseada em IA chegará a $40 bilhões nos Estados Unidos até 2027, enquanto a estimativa atual para 2023 é de $12,3 bilhões.

A taxa de crescimento anual para esse período chegará a 32%, de acordo com as projeções.

O impacto econômico inclui:

- O dano financeiro imediato ocorre por meio de atividades de fraude sintética.

- Ocorre o roubo de identidades pessoais e o uso indevido de informações pessoais.

- As operações comerciais sofrem interrupções devido ao tempo necessário para a investigação forense.

- As empresas precisam pagar penalidades regulatórias por não implementarem medidas adequadas de proteção de dados.

- As empresas sofrem danos permanentes à sua reputação depois que suas informações são disponibilizadas ao público.

Centros de contato em risco

O número de casos de fraude no varejo atingirá uma em cada 56 chamadas de atendimento ao cliente até 2025. A crise do contact center se agravará porque as atividades fraudulentas baseadas em IA aumentarão em grandes volumes.

Os governos estão começando a responder

Nos Estados Unidos.

- A Comissão Federal de Comércio estabeleceu novas regras que impedem que os usuários utilizem software de imitação de voz.

- O FBI agora alerta o público sobre ataques de phishing que usam tecnologia de inteligência artificial.

- Vários estados americanos promulgaram uma nova legislação que se concentra na regulamentação da tecnologia deepfake.

Globalmente

- A Lei de IA da UE exige que todo conteúdo gerado por IA mostre sinais óbvios de que foi produzido por inteligência artificial.

- Várias nações desenvolveram acordos internacionais que lhes permitem aplicar suas leis em diferentes países.

- As plataformas de IA devem demonstrar que seus sistemas têm medidas para evitar o uso não autorizado de sua tecnologia.

A oportunidade de conformidade

As organizações que implementarem sistemas avançados de detecção de fraude por IA hoje se estabelecerão como líderes de mercado.

As organizações atenderão às regulamentações futuras antes das outras, pois seus concorrentes precisam gastar tempo para se atualizar.

Um novo paradigma de segurança

O aumento dos ataques de deepfake transformou as operações de confiança digital em algo mais do que apenas uma questão de segurança cibernética.

A mudança estratégica:

- As ameaças modernas superaram os atuais sistemas de defesa de perímetro, que não oferecem mais a proteção adequada.

- Especialistas em segurança que passaram anos em seu campo agora sofrem ataques de deepfake contra os quais não conseguem se defender.

- A atual abordagem "confie, mas verifique" não é mais eficaz porque a verificação precisa se tornar um procedimento operacional permanente.

- Os sistemas de detecção em tempo real precisam ser implementados porque os métodos de descoberta manual não conseguem detectar ameaças antes que elas se tornem ameaças.

O futuro pertence aos que estão preparados

As organizações precisam escolher entre implantar sistemas de detecção de IA imediatamente para impedir que a fraude deepfake atinja o crescimento previsto de 155% em 2025 ou arriscar a divulgação pública de seus sistemas.

As organizações que agirem agora defenderão sua saúde financeira e, ao mesmo tempo, criarão sistemas de confiança que garantirão sua posição como líderes no futuro mercado baseado em IA.

As empresas que detectarem ameaças de IA primeiro e implementarem soluções rapidamente terão sucesso na batalha entre IA e IA.

Referências

- Pindrop (12 de junho de 2025): "Pindrop's 2025 Voice Intelligence & Security Report" - 1.300% aumento de fraudes deepfake, dados de análise de chamadas

- Unite.AI (20 horas atrás): "Deepfakes, clones de voz alimentam o aumento de 148% em golpes de imitação de IA" - Estatísticas do Identity Theft Resource Center

- Grupo-IB (6 de agosto de 2025): "The Anatomy of a Deepfake Voice Phishing Attack" (A anatomia de um ataque de phishing de voz Deepfake) - Surto de 194% na Ásia-Pacífico, dados de impacto financeiro

- J.P. Morgan (2025): "AI Scams, Deep Fakes, Impersonations" - $16,6 bilhões de perdas com fraudes, aumento de 33%

- Incode (20 de dezembro de 2024): "Top 5 Cases of AI Deepfake Fraud From 2024" - pesquisa executiva da Deloitte, detalhes do caso WPP

- Eftsure US (2025): "Estatísticas Deepfake (2025): 25 fatos novos para CFOs" - Lacunas de treinamento, estatísticas de confiança dos funcionários

- Security.org (26 de agosto de 2025): "2024 Deepfakes Guide and Statistics" - Estatísticas de vítimas de clonagem de voz, cenário regulatório

- Associação Americana de Advogados (2025): "O que os golpes de Deepfake nos ensinam sobre IA e fraude" - estudo de caso de Brad Pitt, implicações legais

- Axios (15 de março de 2025): "Golpes de clonagem de voz por IA: Uma ameaça persistente" - estudo da Consumer Reports, dados de falsificação de identidade da FTC