I juni 2025 fick en Google-anställd vad som verkade vara ett rutinsamtal från IT-supporten.

Rösten i luren lät professionell, självsäker och helt bekant.

Teknikern bad medarbetaren att godkänna en ny app i företagets Salesforce-system.

Inom loppet av några minuter hade angriparna tillgång till och stal 2,55 miljoner kundregister från Googles CRM-system.

Det som gjorde detta möjligt var användningen av deepfake audio-teknik, med AI-genererade röster som var så övertygande att de lurade en av de mest pålitliga formerna av autentisering, att känna igen en kollegas röst.

Den här incidenten, som är kopplad till gruppen ShinyHunters, visar hur angripare nu använder artificiell intelligens för att bryta sig in i företagssystem.

Salesforce, som utgör ryggraden i kundrelationshanteringen för miljontals organisationer världen över, har blivit ett av huvudmålen för en ny generation AI-drivna social engineering-attacker.

Varför Salesforce blev ett Deepfake-mål

Salesforces tillväxt har också gjort det till ett stort mål för datastöld.

Eftersom allt är centraliserat kan ett enda intrång exponera miljontals kundregister från många olika företag.

Som WithSecures chef för Threat Intelligence Tim West noterar:

Oroa dig aldrig för AI-bedrägerier igen. TruthScan Kan hjälpa dig:

- Upptäcka AI-generering bilder, text, röst och video.

- Undvik stora AI-drivna bedrägerier.

- Skydda dina mest känslig Företagets tillgångar.

"Hackinggrupper som Scattered Spider använder social engineering för att få tillgång till SaaS-miljöer. Deras attacker kan se tekniskt enkla ut, men det gör dem inte mindre farliga."

Enligt en ny undersökning från WithSecure ökade den skadliga aktiviteten i Salesforce-miljöer kraftigt under första kvartalet 2025, med en tjugofaldig ökning av antalet upptäckta fall jämfört med slutet av 2024.

Hur Deepfakes drev ett Salesforce-intrång

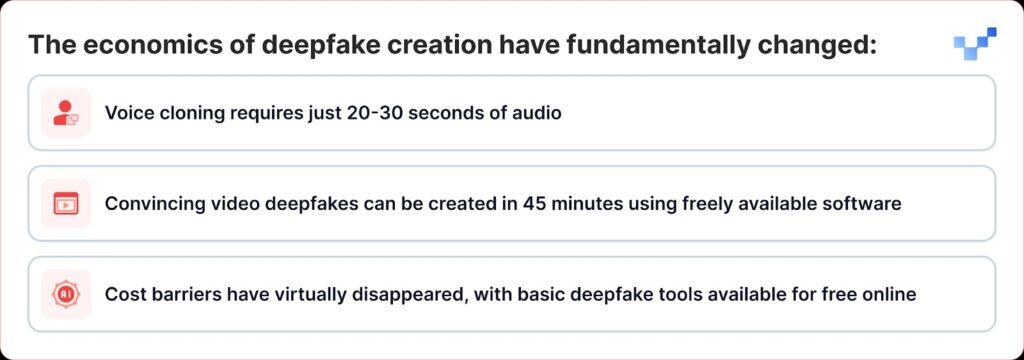

Det som gör de senaste attackerna särskilt farliga är hur deepfake-tekniken har gått från att vara ett nischverktyg till något som vem som helst kan använda som vapen.

Till skillnad från traditionella dataintrång där man bryter sig in direkt i databaser använder cyberbrottslingar nu röstbaserad social engineering, eller "vishing". Med ökningen av deepfakes och AI-röstkloning blir dessa attacker mycket svårare att upptäcka.

ShinyHunters kampanj mot Salesforce-kunder följer en effektiv spelbok som kombinerar traditionell social ingenjörskonst med banbrytande AI-bedrägeri:

Fas 1: Insamling av röstinformation

Angripare börjar med att samla in ljudprov från offentliga källor, presentationer av chefer, konferenssamtal, företagsvideor eller inlägg på sociala medier.

Med så lite som 20-30 sekunders tydligt ljud kan de skapa övertygande röstkloner.

Fas 2: Deepfake Vishing-anropet

Under ett vishing-samtal övertygar angriparen offret att gå till Salesforces anslutna appinstallationssida och godkänna en falsk version av Data Loader-appen, förklädd med något förändrat varumärke.

Med det låter offret omedvetet angriparna stjäla känslig information från Salesforce.

Sofistikeringen är anmärkningsvärd. I vissa fall använde angripare deepfake-ljud för att utge sig för att vara anställda och övertala helpdeskpersonal att godkänna obehörig åtkomst.

Detta innebär en betydande utveckling från traditionellt röstfiske, där angriparna helt enkelt låtsades vara myndighetspersoner, till AI-förstärkt imitation, där de faktiskt kan låta som specifika individer.

Fas 3: Utnyttjande av OAuth

När den skadliga applikationen har auktoriserats kringgår angriparna multifaktorautentisering helt och hållet.

När den falska appen har godkänts får angriparna långlivade OAuth-tokens, som gör det möjligt för dem att kringgå multifaktorautentisering och arbeta utan att utlösa normala säkerhetsvarningar.

Fas 4: Extrahering av tysta data

Googles Threat Intelligence Group varnade för att en hotaktör använde ett Python-verktyg för att automatisera datastöldprocessen för varje organisation som var riktad, med forskare som känner till över 700 potentiellt påverkade organisationer.

Varför vi är sårbara för AI-röster

Attackerna utnyttjar ett grundläggande mänskligt drag: vår tendens att lita på vad vi hör.

Enligt en nyligen genomförd global studie säger 70 procent av befolkningen att de inte är säkra på att de kan identifiera en riktig röst jämfört med en klonad röst.

Denna sårbarhet förvärras i företagsmiljöer där helpdeskpersonal är utbildad för att vara hjälpsam och tillmötesgående, och distansarbete har normaliserat interaktioner med enbart ljud.

Enligt CrowdStrikes Global Threat Report 2025 ökade antalet röstfiskeattacker (vishing) med 442% mellan första och andra halvåret 2024, drivet av AI-genererade nätfiske- och imitationstaktiker.

Väckarklockan för $25 miljoner

Konsekvenserna av deepfake-förstärkta attacker sträcker sig långt bortom Salesforce.

Deepfake-kuppen på $25 miljoner på ingenjörsbyrån Arup i början av 2024, där angripare använde AI för att utge sig för att vara flera chefer under ett videosamtal, visade att ingen organisation är immun mot detta hot.

Liknande attacker har också riktats mot chefer i olika branscher, bland annat ett försök att utge sig för att vara Ferraris VD Benedetto Vigna med hjälp av AI-klonade röstsamtal som imiterade hans syditalienska accent.

Dessa incidenter representerar vad säkerhetsexperter kallar "CEO fraud 2.0", attacker som går längre än att bara utge sig för att vara en annan person via e-post och som skapar ett multisensoriskt bedrägeri som kan lura även erfarna chefer.

Plattformssäkerhet kontra mänsklig sårbarhet

Salesforce har varit snabba med att betona att dessa intrång inte representerar sårbarheter i själva plattformen.

Salesforce bekräftade UNC6040:s kampanj i mars 2025 och varnade för att angripare utgav sig för att vara IT-support för att lura anställda att ge bort inloggningsuppgifter eller godkänna skadliga anslutna appar.

Företaget betonade att dessa incidenter inte involverade eller härrörde från några sårbarheter i dess plattform.

Detta visar en stor utmaning för alla SaaS-leverantörer: att ta reda på hur man stoppar attacker som spelar på mänskligt förtroende istället för tekniska brister.

Salesforce har genomfört flera försvarsåtgärder:

- Härdning av anslutna appar: Automatisk inaktivering av icke-installerade anslutna appar för nya användare

- Begränsningar av OAuth-flödet: Inaktivera anslutningar som erhållits med hjälp av vissa auktoriseringsprocesser

- Förbättrad övervakning: Förbättrad upptäckt av misstänkta mönster för auktorisering av applikationer

- Utbildning för användare: Publicera vägledning om hur man känner igen försök till social manipulering

I augusti 2025 stängde Salesforce av alla integrationer med Salesloft-teknik, inklusive Drift-appen, efter att ha upptäckt att OAuth-tokens hade stulits i relaterade attacker.

Säkerhetsexperter varnar nu för att team måste lyssna efter subtila ledtrådar, som udda pauser, bakgrundsljud eller ljudfel, som kan avslöja när en röst har genererats av AI.

Företagets svar: Bortom tekniska lösningar

Organisationer börjar inse att försvaret mot deepfake-förstärkta attacker kräver mer än tekniska lösningar; det kräver en grundläggande omprövning av förtroende- och verifieringsprocesser.

Kommunikation utan förtroende

RealityCheck från Beyond Identity ger varje deltagare en synlig, verifierad identitetsbricka som backas upp av kryptografisk enhetsautentisering och kontinuerliga riskkontroller, för närvarande tillgänglig för Zoom och Microsoft Teams.

Sådana lösningar innebär ett skifte mot "lita aldrig, verifiera alltid"-modeller för företagskommunikation.

Förbättrade utbildningsprogram

Organisationer som använder Resemble AI:s plattform för deepfake-simulering rapporterar upp till 90% färre framgångsrika attacker efter att ha implementerat plattformen, som använder hyperrealistiska simuleringar för att illustrera hur deepfake-attacker utvecklas i den verkliga världen.

Verifiering i flera kanaler

Ledande organisationer implementerar protokoll som kräver verifiering via flera kanaler för alla högriskförfrågningar, oavsett hur autentisk den ursprungliga kommunikationen verkar.

När rösten inte längre är sanningen

Deepfake-hotet mot Salesforce och andra företagssystem utgör en vändpunkt i cybersäkerhetshistorien.

För första gången kan angripare inte bara utge sig för att vara myndighetspersoner; de kan faktiskt låta som dem, se ut som dem och övertyga till och med utbildad säkerhetspersonal att vidta åtgärder som äventyrar organisationens säkerhet.

I en tid av AI-genererade bedrägerier måste förtroende förtjänas genom verifiering, inte antas genom kännedom.

Företag som förstår detta och investerar i rätt verktyg, processer och kultur kommer att ha de bästa förutsättningarna för att skydda både säkerhet och förtroende i en alltmer osäker digital värld.

I den här nya verkligheten är rösten i andra änden av linjen kanske inte den som den verkar vara.

I en tid av deepfakes är ständig vaksamhet priset för säkerhet.