Dlaczego najnowszy przełom OpenAI stał się najnowszym bólem głowy każdego członka zarządu?

Eksperyment, który złamał Internet

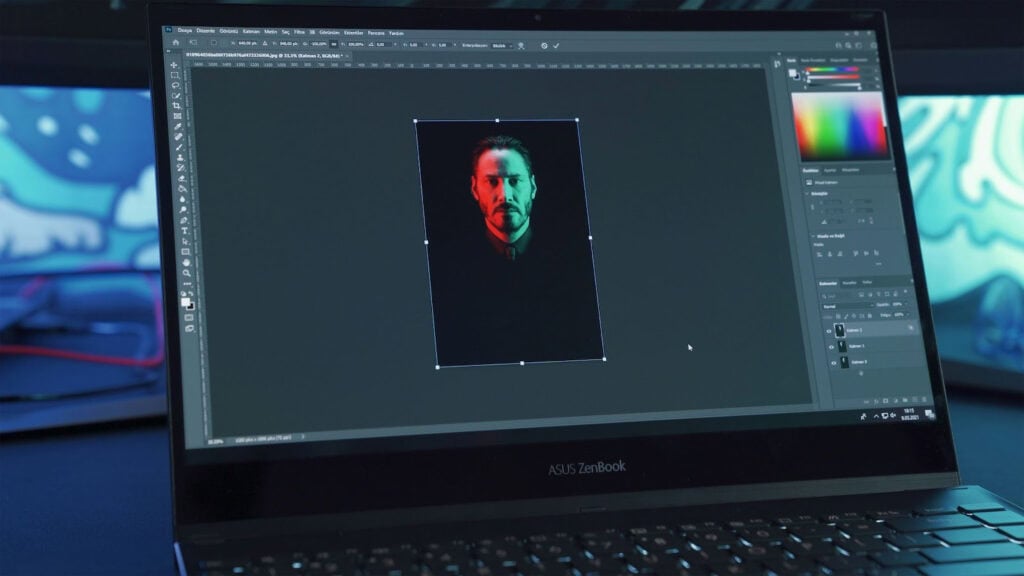

W kwietniu 2025 r. prosty eksperyment w mediach społecznościowych wstrząsnął całym światem cyberbezpieczeństwa. Użytkownicy dowiedzieli się, że GPT-4o firmy OpenAI może wygenerować realistyczne fałszywe karty Aadhaarindyjski krajowy system identyfikacji, obejmujący ponad 1,3 miliarda ludzi.

W ciągu zaledwie kilku godzin platformy mediów społecznościowych zostały zalane wygenerowanymi przez sztuczną inteligencję dokumentami tożsamości przedstawiającymi wszystkich, od zwykłych obywateli po osoby publiczne, takie jak Sam Altman i Elon Musk.

Liczby były przerażające. Od czasu premiery, GPT-4o firmy OpenAI wykonał już ponad 700 milionów obrazów.

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

To, co zaczęło się jako kreatywne eksperymentowanie z portretami w stylu Studio Ghibli, szybko przerodziło się w coś bardziej niepokojącego. Użytkownicy zaczęli udostępniać fotorealistyczne makiety rządowych kart identyfikacyjnych, wraz z kodami QR, oficjalnym formatowaniem i sfabrykowanymi danymi osobowymi, które wyglądały niepokojąco autentycznie.

Technologia stojąca za zagrożeniem: Dlaczego GPT-4o jest inny

Nowa klasa generowania obrazów przez sztuczną inteligencję

W przeciwieństwie do DALL-E, GPT-4o jest wbudowany bezpośrednio w ChatGPT. Ta zmiana daje mu nowe możliwości, ale także stwarza nowe ryzyko.

Jak przyznaje OpenAI w swojej oficjalnej dokumentacji systemowej: "Możliwości te, samodzielnie i w nowych kombinacjach, mogą potencjalnie stwarzać ryzyko w wielu obszarach, w sposób, w jaki poprzednie modele nie mogły".

Problem z dostępnością

Demokratyzacja technologii generowania obrazów stworzyła coś, co eksperci nazywają "idealną burzą" dla oszustw związanych z tożsamością.

Po pierwsze, nie są wymagane żadne umiejętności techniczne. Każdy może tworzyć fałszywe dokumenty, po prostu wpisując żądanie w języku naturalnym. Wyniki są fotorealistyczne, ściśle dopasowane do oficjalnych układów, czcionek i projektów.

W ciągu zaledwie kilku minut fałszywe dokumenty tożsamości mogą być produkowane na masową skalę. A ponieważ technologia ta działa w systemach identyfikacji różnych krajów, zagrożenie ma charakter globalny.

Obawy związane z danymi szkoleniowymi

Najbardziej niepokojąca jest kwestia źródeł danych. Użytkownicy zastanawiają się, skąd GPT-4o wziął dane treningowe do tak dokładnej replikacji dokumentów rządowych. Użytkownicy zastanawiają się, skąd model wziął dane zdjęcia Aadhaar do treningu i jak mógł tak dokładnie nauczyć się formatu.

Skala oszustw związanych ze sztuczną inteligencją: Rosnący kryzys

Aktualne statystyki malują ponury obraz

Oszustwa generowane przez sztuczną inteligencję stanowią jedno z najszybciej rosnących zagrożeń w cyberbezpieczeństwie:

- Globalny wskaźnik oszustw wzrósł z 1,10% w 2021 r. do 2,50% w 2024 r.wzrost o 127% w ciągu zaledwie trzech lat

- Sfałszowane lub zmienione dokumenty stanowią 50% wszystkich prób oszustw w 2024 roku, zgodnie z raportem Sumsub dotyczącym oszustw związanych z tożsamością

- Cyfrowe fałszerstwa wykorzystujące generatywną sztuczną inteligencję stanowią obecnie 57% wszystkich oszustw związanych z dokumentamiwzrost o 244% w porównaniu z poprzednim rokiem

- Oszustwa tożsamości związane z Deepfake wzrosły dziesięciokrotnie w 2023 r. w porównaniu do poprzedniego roku

Wpływ finansowy na różne branże

Konsekwencje gospodarcze są już poważne i coraz szybsze:

- Oszustwa z wykorzystaniem sztucznej inteligencji mogą kosztować $10,5 bln euro w 2025 r.według LexisNexis

- Oszustwa związane z syntetyczną tożsamością wzrosły o 31% Oszuści coraz częściej wykorzystują sztuczną inteligencję

- Połowa wszystkich ankietowanych firm doświadczyła oszustw związanych z treściami generowanymi przez sztuczną inteligencję. w 2024 r.

- Globalne straty spowodowane oszustwami cyfrowymi wyniosły ponad $47,8 mld euro. w 2024 r., odzwierciedlając wzrost o 15%

The Executive Blind Spot: Dlaczego przywództwo jest nieprzygotowane

Luka w świadomości

Mimo że nastąpił wzrost zagrożenia, większość kadry kierowniczej wciąż ledwo zdaje sobie z niego sprawę:

- 76% respondentów ankiety zauważyło wzrost wymogów regulacyjnych Wzywając do silniejszej weryfikacji tożsamości

- Kanały cyfrowe odpowiadają obecnie za 51% oszustwpo raz pierwszy przewyższając kanały fizyczne

- Tylko 43% organizacji finansowych korzysta z zaawansowanych metod weryfikacji Kiedy pojawiają się czerwone flagi oszustwa

- Większość organizacji nie posiada kompleksowych strategii wykrywania oszustw AI

Deficyt treningowy

Przepaść między nowymi zagrożeniami a gotowością organizacji rośnie. Większość szkoleń z zakresu bezpieczeństwa nadal nie obejmuje oszustw związanych ze sztuczną inteligencją, więc pracownicy nie są przygotowani. Nadal nie ma powszechnej wiedzy na temat deepfake'ów i obrazów AI, a procedury weryfikacji nie zostały dostosowane do dokumentacji generowanej przez AI. Wreszcie, możliwości wykrywania są nadal niewystarczające w porównaniu z technologią generowania.

Wpływ na branżę: Oblężone sektory

Najbardziej narażone branże

Na podstawie statystyk dotyczących oszustw w 2024 r., sektory o najwyższym ryzyku obejmują:

- Platformy randkowe (wskaźnik oszustw 8,9%): Oszustwa romansowe wykorzystujące fałszywe profile z dokumentami generowanymi przez sztuczną inteligencję

- Media internetowe (wskaźnik oszustw 4,27%): Obejście weryfikacji konta przy użyciu dokumentów syntetycznych

- Bankowość i ubezpieczenia (wskaźnik oszustw 3,14%): Oszustwa związane z otwieraniem kont i pożyczkami

- Kryptowaluta (88% przypadków deepfake): Obejście KYC przy użyciu tożsamości wygenerowanych przez sztuczną inteligencję

Technologiczny wyścig zbrojeń: wykrywanie kontra generowanie

Obecne możliwości wykrywania

Organizacje, które zainwestowały znaczne środki w narzędzia oparte na sztucznej inteligencji, aby walczyć z oszustwami generowanymi przez sztuczną inteligencję, zaczęły widzieć wyniki: Systemy wykrywania oszustw oparte na sztucznej inteligencji pomogły już firmom zmniejszyć liczbę przypadków oszustw o około 30%.

Badane są również inne technologie. Blockchain może zapewnić większe bezpieczeństwo danych, choć nadal wymaga szerszego przyjęcia, aby był skuteczny.

Weryfikacja biometryczna w połączeniu z analizą dokumentów tworzy bardziej niezawodną formę uwierzytelniania.

Wreszcie, wykrywanie w czasie rzeczywistym staje się potężnym zabezpieczeniem. Potwierdza, że dana osoba jest naprawdę obecna i powstrzymuje przestępców przed używaniem fałszywych statycznych obrazów podczas weryfikacji.

Luka wyrafinowania

Istnieje jednak niepokojąca rozbieżność między pewnością wykrywania a faktycznym zapobieganiem:

- Odsetek respondentów, którzy ufają firmom technologicznym w zakresie bezpieczeństwa danych biometrycznych, spadł z 29% w 2022 r. do 5% w 2024 r.

- Wiele organizacji przecenia swoje możliwości wykrywania jednocześnie nie doceniając wyrafinowania zagrożeń

- Tradycyjne środki bezpieczeństwa okazują się niewystarczające przeciwko dokumentom generowanym przez sztuczną inteligencję

- Ewolucja technologii wykrywania nie nadąża za rozwojem generacji

Reakcja regulacyjna: Krajobraz prawny

Obecne ramy prawne

Rządy na całym świecie starają się zaradzić oszustwom związanym z dokumentami generowanymi przez sztuczną inteligencję, z powolną poprawą:

- Rozporządzenie UE w sprawie eIDAS weszła w życie w maju 2024 r., wymagając silniejszej weryfikacji tożsamości cyfrowej

- Kilka krajów wzmocniło ochronę dane dotyczące opieki zdrowotnej i weryfikacja tożsamości

- Nowe przepisy wymagają przejrzystości w procesach weryfikacji tożsamości opartych na sztucznej inteligencji

- Sankcje karne Istnieją przypadki nieuczciwego wykorzystywania dokumentów wygenerowanych przez sztuczną inteligencję

Budowanie obrony wykonawczej: Kompleksowa strategia ochrony

1. Natychmiastowa ocena ryzyka

Audyt bieżących procesów weryfikacji: Sprawdź, w jaki sposób Twoja organizacja obecnie weryfikuje dokumenty tożsamości i zidentyfikuj luki w zabezpieczeniach przed oszustwami związanymi ze sztuczną inteligencją.

Identyfikacja punktów styku wysokiego ryzyka: Mapowanie wszystkich punktów, w których akceptowane są dokumenty tożsamości, onboarding, odzyskiwanie konta, transakcje o wysokiej wartości i weryfikacja zgodności.

Ocena możliwości wykrywania: Ocena, czy obecne systemy mogą identyfikować dokumenty generowane przez sztuczną inteligencję lub czy konieczne są aktualizacje.

2. Rozwiązania technologiczne

Zaawansowana analiza obrazu: Wdrożenie systemów wykrywania opartych na sztucznej inteligencji, które mogą identyfikować subtelne niespójności w dokumentach generowanych przez sztuczną inteligencję:

- Analiza tekstury: Wykrywanie nienaturalnych wzorców w tle dokumentów i zabezpieczeń

- Sprawdzanie spójności: Weryfikacja wyrównania czcionek, odstępów i oficjalnego formatowania.

- Badanie metadanych: Analiza danych dotyczących tworzenia obrazów pod kątem oznak generowania sztucznej inteligencji

- Weryfikacja w czasie rzeczywistym: Wdrożenie systemów, które mogą natychmiast przetwarzać dokumenty podczas interakcji z klientem.

Weryfikacja wieloskładnikowa: Połączenie analizy dokumentów z dodatkowymi metodami weryfikacji:

- Weryfikacja rządowej bazy danych: Powiązanie numerów dokumentów z oficjalnymi bazami danych

- Dopasowanie biometryczne: Rozpoznawanie twarzy w celu dopasowania zdjęć dokumentów do obiektów na żywo

- Analiza behawioralna: Monitorowanie wzorców zachowań użytkowników podczas procesów weryfikacji

3. Szkolenie i świadomość

Kształcenie kadry kierowniczej: Zespoły kierownicze potrzebują specjalnych szkoleń na temat ryzyka oszustw związanych z obrazami AI i konsekwencji biznesowych nieodpowiedniej weryfikacji.

Programy szkoleniowe dla pracowników: Personel pierwszej linii wymaga edukacji w zakresie:

- Techniki wykrywania wizualnego: Jak rozpoznać potencjalne dokumenty wygenerowane przez sztuczną inteligencję?

- Procedury weryfikacji: Kiedy i jak eskalować podejrzane dokumenty?

- Integracja technologii: Jak skutecznie korzystać z narzędzi do wykrywania

Bieżące aktualizacje: Regularne aktualizacje szkoleń w miarę rozwoju technik generowania AI.

4. Przeprojektowanie procesu

Protokoły weryfikacji: Wdrożenie wieloetapowej weryfikacji dla scenariuszy wysokiego ryzyka:

- Przegląd dokumentów podstawowych: Wstępna ocena przy użyciu technologii wykrywania

- Weryfikacja drugorzędna: Odsyłacz do bazy danych w celu zapewnienia autentyczności dokumentu

- Potwierdzenie trzeciorzędne: Dodatkowa weryfikacja w przypadku spraw o wysokiej wartości lub podejrzanych

Obsługa wyjątków: Jasne procedury zarządzania dokumentami, które nie przeszły weryfikacji lub wykazują oznaki generowania AI.

Rozwiązanie: Wykrywanie obrazów AI klasy korporacyjnej

Dlaczego tradycyjne podejścia zawodzą

Standardowe kontrole dokumentów zostały stworzone do wykrywania fałszerstw w starym stylu, a nie dokumentów stworzonych przez sztuczną inteligencję. Nowoczesne generowanie obrazów przez sztuczną inteligencję wymaga równie zaawansowanych możliwości wykrywania.

Obecne luki w weryfikacji obejmują:

- Błąd ludzki: Ręczni recenzenci nie są w stanie wiarygodnie zidentyfikować wyrafinowanych dokumentów generowanych przez sztuczną inteligencję.

- Ograniczona analiza techniczna: Podstawowa weryfikacja skupia się na oczywistych zmianach, pomijając subtelne wskaźniki AI.

- Ograniczenia skali: Ręczne procesy nie są w stanie poradzić sobie z liczbą prób oszustw generowanych przez sztuczną inteligencję

- Opóźnienie ewolucji: Procedury weryfikacji statycznej nie są w stanie dostosować się do szybko ewoluujących technik sztucznej inteligencji

Potrzeba specjalistycznego wykrywania sztucznej inteligencji

Organizacje poważnie myślące o ochronie przed oszustwami związanymi z obrazami AI potrzebują specjalnie zaprojektowanych systemów wykrywania:

- Analiza markerów generacji AI: Wykrywanie subtelnych artefaktów i wzorów unikalnych dla obrazów generowanych przez sztuczną inteligencję.

- Przetwarzanie w czasie rzeczywistym: Zapewnienie natychmiastowej analizy podczas przesyłania dokumentów

- Ciągłe uczenie się: Dostosowywanie się do nowych technik generowania sztucznej inteligencji w miarę ich pojawiania się.

- Możliwości integracji: Płynna współpraca z istniejącymi procesami weryfikacji

Skuteczne systemy wykrywania obrazów AI wykorzystują zaawansowane algorytmy do identyfikacji:

- Niespójności na poziomie pikseli: Subtelne wzorce wskazujące na generowanie AI

- Artefakty kompresji: Cyfrowe podpisy procesów tworzenia obrazów AI

- Anomalie statystyczne: Matematyczne wzory, które różnią się od naturalnych obrazów

- Niespójności czasowe: Oznaki manipulacji lub generowania obrazu

Podsumowanie: AI Image Fraud jest tutaj i przyspiesza

Statystyki są niezaprzeczalne: Oszustwa dokumentowe generowane przez sztuczną inteligencję ewoluowały od teoretycznego zagrożenia do obecnej rzeczywistości, powodując miliardowe straty.

Przy ponad 700 milionach obrazów wygenerowanych już przez samo GPT-4o i szybko rozwijających się możliwościach sztucznej inteligencji, organizacje stoją w obliczu rosnącego zagrożenia, któremu tradycyjne środki bezpieczeństwa nie są w stanie sprostać.

Okno na proaktywną obronę szybko się zamyka.

Technologia generowania przekonujących fałszywych dokumentów jest teraz dostępna dla każdego, kto ma dostęp do Internetu. Tymczasem wyrafinowanie dokumentów generowanych przez sztuczną inteligencję stale się poprawia, sprawiając, że ich wykrywanie staje się coraz większym wyzwaniem dla ludzkich recenzentów i podstawowych systemów weryfikacji.

Organizacje, które odmawiają dostosowania swoich procesów weryfikacji do tej nowej rzeczywistości, narażone są na wiele zagrożeń:

- Bezpośrednie straty finansowe: Od oszustw przy użyciu dokumentów generowanych przez sztuczną inteligencję

- Kary regulaminowe: Za niespełnienie zaostrzonych wymogów weryfikacyjnych

- Szkody dla reputacji: Od bycia kojarzonym z incydentami związanymi z oszustwami dotyczącymi tożsamości

- Zakłócenia operacyjne: Z dochodzenia i działań naprawczych

Nie chodzi o to, czy Twoja organizacja napotka oszustwa związane z dokumentami generowanymi przez sztuczną inteligencję; chodzi o to, czy będziesz przygotowany do ich wykrywania i zapobiegania im.

Istnieje technologia do walki z oszustwami generowanymi przez sztuczną inteligencję. Zaawansowane systemy wykrywania mogą identyfikować subtelne znaczniki, które odróżniają dokumenty wygenerowane przez sztuczną inteligencję od autentycznych. Wdrożenie wymaga jednak natychmiastowych działań, ponieważ zagrożenie ewoluuje każdego dnia.

Firmy muszą teraz zainwestować w kompleksowe funkcje wykrywania obrazów AI lub ryzykować, że staną się kolejną ofiarą w najszybciej rozwijającej się kategorii oszustw naszych czasów.

Dla kadry kierowniczej gotowej chronić swoje organizacje przed oszustwami związanymi z obrazami AI, zaawansowana technologia wykrywania jest dostępna już dziś. Dowiedz się, jak wykrywanie obrazów AI klasy korporacyjnej może zabezpieczyć Twoje procesy weryfikacji na stronie truthscan.com/ai-image-detector.

Referencje

- Outlook Money. "ChatGPT może generować fałszywe karty Aadhaar i PAN: Oto, co musisz wiedzieć". Outlook Money, 5 kwietnia 2025 r. https://www.outlookmoney.com/news/chatgpt-can-generate-fake-aadhaar-pan-cards-heres-what-you-need-to-know

- Business Today. "Fałszywy Aadhaar, PAN z ChatGPT: Jak zidentyfikować prawdziwe rządowe dowody tożsamości; sprawdź kroki". Business Today, 5 kwietnia 2025 r. https://www.businesstoday.in/personal-finance/news/story/fake-aadhaar-pan-with-chatgpt-how-to-identify-real-government-id-proofs-check-steps-470849-2025-04-05

- Business Standard. "ChatGPT może generować fałszywe karty Aadhaar i PAN: Jak je zweryfikować". Business Standard, 7 kwietnia 2025 r. https://www.business-standard.com/finance/personal-finance/chatgpt-can-generate-fake-aadhaar-pan-cards-how-to-verify-them-125040700728_1.html

- OneIndia News. "Czy ChatGPT może tworzyć karty Aadhaar i PAN? Internauci bombardują media społecznościowe fałszywymi dowodami osobistymi". OneIndia News, 4 kwietnia 2025 r. https://www.oneindia.com/india/can-chatgpt-create-aadhaar-cards-pan-cards-netizens-bombard-social-media-with-fake-id-cards-4114335.html

- Technologia Business Today. "Fałszywe karty Aadhaar budzą obawy, ponieważ narzędzie wizerunkowe ChatGPT osiąga 700 milionów kreacji". Business Today, 4 kwietnia 2025 r. https://www.businesstoday.in/technology/news/story/fake-aadhaar-cards-spark-concern-as-chatgpts-image-tool-hits-700-million-creations-470750-2025-04-04

- MoneyLife. "Ostrzeżenie o oszustwach: sztuczna inteligencja tworzy autentycznie wyglądające" fałszywe "karty Aadhaar i PAN"! MoneyLife. https://www.moneylife.in/article/fraud-alert-ais-creating-genuinelooking-fake-aadhaar-pan-cards/76873.html

- Rynek analizy danych. "ChatGPT wywołuje obawy o oszustwa związane z identyfikacją: Czy naprawdę może generować fałszywe karty Aadhaar i PAN?" Rynek analizy danych. https://www.datainsightsmarket.com/news/article/chatgpt-can-generate-fake-aadhaar-pan-cards-13557

- Angel One. "ChatGPT może generować fałszywe karty Aadhaar i PAN: Jak je zweryfikować". Angel One, 8 kwietnia 2025 r. https://www.angelone.in/news/chatgpt-can-generate-fake-aadhaar-and-pan-cards-how-to-verify-them

- Aktualizacja danych biometrycznych. "Social buzzuje z paszportami i dowodami osobistymi generowanymi przez ChatGPT". Aktualizacja danych biometrycznych, 11 kwietnia 2025 r. https://www.biometricupdate.com/202504/social-buzzes-with-chatgpt-generated-passports-and-id-cards

- Munsif Daily. "Narzędzie obrazu ChatGPT używane do generowania kart Aadhaar i PAN, obawy dotyczące prywatności i nadużyć". Munsif Daily, 4 kwietnia 2025 r. https://munsifdaily.com/chatgpts-image-tool-used-to-generate-aadhaar-and-pan-cards/

- Snappt. "Trendy w weryfikacji tożsamości w 2025 r. i perspektywy na przyszłość". Snappt, 4 sierpnia 2025 r. https://snappt.com/blog/id-verification-trends/

- Snappt. "Statystyki dotyczące oszustw związanych z tożsamością w 2025 r.". Snappt20 listopada 2024 r. https://snappt.com/blog/identity-fraud-statistics/

- Sumsub. "Trendy dotyczące oszustw w 2025 roku: Od oszustw opartych na sztucznej inteligencji po kradzież tożsamości i demokratyzację oszustw". Sumsub. https://sumsub.com/blog/fraud-trends-sumsub-fraud-report/

- Sumsub. "Statystyki kradzieży tożsamości i oszustw w 2024 r.". Sumsub. https://sumsub.com/fraud-report-2024/

- arXiv. "Wykrywanie oszustw tożsamości opartych na sztucznej inteligencji: Przegląd systematyczny". arXiv, 16 stycznia 2025 r. https://arxiv.org/html/2501.09239v1

- Zaufanie. "Trendy w weryfikacji tożsamości w 2025 roku i później". Zaufanie, 5 sierpnia 2025 r. https://www.entrust.com/blog/2025/02/identity-verification-trends-in-2025-and-beyond

- Incode. "Ujawniono 5 najważniejszych przypadków oszustw AI Deepfake od 2024 roku". Blog Incode20 grudnia 2024 r. https://incode.com/blog/top-5-cases-of-ai-deepfake-fraud-from-2024-exposed/

- Mitek Systems. "Przewidywania dotyczące oszustw w 2025 roku: Spostrzeżenia na temat pojawiających się zagrożeń związanych z oszustwami". Mitek Systems, 12 grudnia 2024 r. https://www.miteksystems.com/blog/2025-fraud-predictions-industry-innovators

- KYC Hub. "7 najważniejszych trendów w zakresie weryfikacji tożsamości w 2025 roku". KYC Hub30 grudnia 2024 r. https://www.kychub.com/blog/identity-verification-trends/