W czerwcu 2025 r. pracownik Google otrzymał, jak się wydawało, rutynowy telefon od działu wsparcia IT.

Głos na linii brzmiał profesjonalnie, pewnie i całkowicie znajomo.

Technik poprosił pracownika o zatwierdzenie nowej aplikacji w firmowym systemie Salesforce.

W ciągu kilku minut atakujący uzyskali dostęp i ukradli 2,55 miliona rekordów klientów z CRM Google.

Było to możliwe dzięki zastosowaniu technologii deepfake audio, w której głosy generowane przez sztuczną inteligencję były tak przekonujące, że oszukiwały jedną z najbardziej zaufanych form uwierzytelniania, rozpoznając głos współpracownika.

Incydent ten, powiązany z grupą ShinyHunters, pokazuje, w jaki sposób atakujący wykorzystują obecnie sztuczną inteligencję do włamywania się do systemów firmowych.

Jako podstawa zarządzania relacjami z klientami dla milionów organizacji na całym świecie, Salesforce stał się jednym z głównych celów nowej generacji ataków socjotechnicznych opartych na sztucznej inteligencji.

Dlaczego Salesforce stał się celem Deepfake?

Rozwój Salesforce sprawił również, że stał się on dużym celem kradzieży danych.

Ponieważ wszystko jest scentralizowane, pojedyncze naruszenie może ujawnić miliony rekordów klientów z wielu różnych firm.

Jak zauważa Tim West, szef działu Threat Intelligence w WithSecure:

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

"Grupy hakerskie, takie jak Scattered Spider, wykorzystują socjotechnikę, aby uzyskać dostęp do środowisk SaaS. Ich ataki mogą wyglądać na technicznie proste, ale to nie czyni ich mniej niebezpiecznymi".

Według nowych badań WithSecure, złośliwa aktywność w środowiskach Salesforce gwałtownie wzrosła w pierwszym kwartale 2025 roku, z dwudziestokrotnym wzrostem wykryć w porównaniu do końca 2024 roku.

Jak podróbki napędzały włamanie do Salesforce

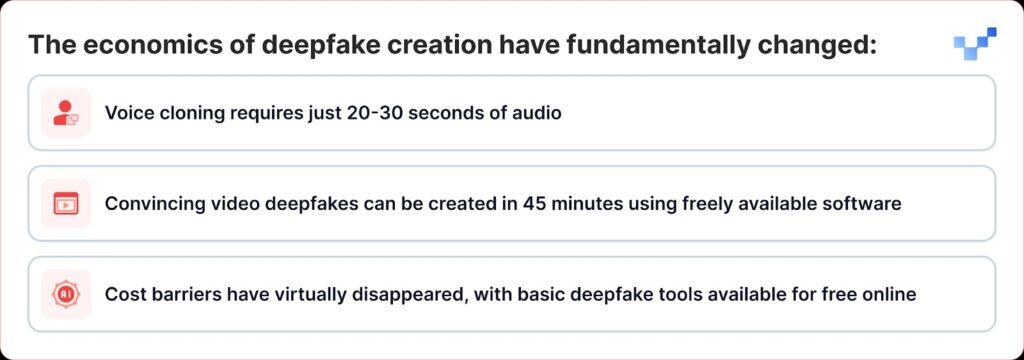

To, co sprawia, że ostatnie ataki są szczególnie niebezpieczne, to fakt, że technologia deepfake zmieniła się z niszowego narzędzia w coś, co każdy może wykorzystać jako broń.

W przeciwieństwie do tradycyjnych naruszeń danych, które włamują się bezpośrednio do baz danych, cyberprzestępcy wykorzystują obecnie inżynierię społeczną opartą na głosie lub "vishing". Wraz z pojawieniem się deepfake'ów i klonowania głosu za pomocą sztucznej inteligencji, ataki te stają się coraz trudniejsze do wykrycia.

Kampania ShinyHunters skierowana przeciwko klientom Salesforce opiera się na skutecznym podręczniku, który łączy tradycyjną inżynierię społeczną z najnowocześniejszym oszustwem AI:

Faza 1: Zbieranie informacji głosowych

Atakujący zaczynają od zbierania próbek audio ze źródeł publicznych, prezentacji kierownictwa, połączeń konferencyjnych, filmów firmowych lub postów w mediach społecznościowych.

Dzięki zaledwie 20-30 sekundom czystego dźwięku mogą tworzyć przekonujące klony głosowe.

Faza 2: Deepfake Vishing Call

Podczas połączenia vishingowego atakujący przekonuje ofiarę do przejścia na stronę konfiguracji połączonej aplikacji Salesforce i zatwierdzenia fałszywej wersji aplikacji Data Loader, zamaskowanej nieco zmienionym brandingiem.

W ten sposób ofiara nieświadomie pozwala atakującym wykraść poufne dane z Salesforce.

Wyrafinowanie jest niezwykłe. W niektórych przypadkach atakujący wykorzystywali deepfake audio do podszywania się pod pracowników i nakłaniania personelu pomocy technicznej do autoryzacji nieuczciwego dostępu.

Stanowi to znaczącą ewolucję od tradycyjnego phishingu głosowego, w którym atakujący po prostu udawali autorytety, do podszywania się wzmocnionego sztuczną inteligencją, w którym mogą faktycznie brzmieć jak określone osoby.

Faza 3: Wykorzystanie OAuth

Po autoryzacji złośliwej aplikacji atakujący całkowicie omijają uwierzytelnianie wieloskładnikowe.

Po zatwierdzeniu fałszywej aplikacji atakujący uzyskują długotrwałe tokeny OAuth, które pozwalają im ominąć uwierzytelnianie wieloskładnikowe i działać bez uruchamiania normalnych alertów bezpieczeństwa.

Faza 4: Cicha ekstrakcja danych

Google's Threat Intelligence Group ostrzegła, że aktor wykorzystał narzędzie Python do zautomatyzowania procesu kradzieży danych dla każdej organizacji, która była celem ataku, a badacze wiedzą o ponad 700 potencjalnie dotkniętych organizacjach.

Dlaczego jesteśmy podatni na głosy AI?

Sukces tych ataków wykorzystuje podstawową ludzką cechę: naszą tendencję do ufania temu, co słyszymy.

Według jednego z ostatnich globalnych badań, 70 procent ludzi twierdzi, że nie są pewni, czy są w stanie zidentyfikować prawdziwy, czy sklonowany głos.

Podatność ta jest potęgowana w środowiskach korporacyjnych, w których personel pomocy technicznej jest szkolony, aby być pomocnym i przychylnym, a praca zdalna znormalizowała interakcje wyłącznie audio.

Według raportu CrowdStrike 2025 Global Threat Report, między pierwszą a drugą połową 2024 r. nastąpił wzrost liczby ataków phishingu głosowego (vishingu) o 442%, napędzany przez taktyki phishingu i podszywania się generowane przez sztuczną inteligencję.

$25 Million Wake-Up Call

Konsekwencje ataków deepfake wykraczają daleko poza Salesforce.

Deepfake heist o wartości $25 milionów w firmie inżynieryjnej Arup na początku 2024 roku, w którym atakujący wykorzystali sztuczną inteligencję do podszywania się pod wielu dyrektorów podczas rozmowy wideo, pokazał, że żadna organizacja nie jest odporna na to zagrożenie.

Podobne ataki były również wymierzone w kadrę kierowniczą w różnych branżach, w tym próba podszycia się pod dyrektora generalnego Ferrari Benedetto Vignę przy użyciu sklonowanych przez sztuczną inteligencję połączeń głosowych, które naśladowały jego południowowłoski akcent.

Incydenty te reprezentują to, co eksperci ds. bezpieczeństwa nazywają "oszustwami CEO 2.0", atakami, które wykraczają poza zwykłe podszywanie się pod e-maile, tworząc wielozmysłowe oszustwa, które mogą oszukać nawet doświadczonych menedżerów.

Bezpieczeństwo platformy a podatność człowieka na zagrożenia

Salesforce szybko podkreślił, że naruszenia te nie stanowią luk w zabezpieczeniach samej platformy.

Salesforce potwierdził kampanię UNC6040 w marcu 2025 roku, ostrzegając, że atakujący podszywali się pod dział wsparcia IT, aby nakłonić pracowników do przekazania danych uwierzytelniających lub zatwierdzenia złośliwych połączonych aplikacji.

Firma podkreśliła, że incydenty te nie wiązały się ani nie wynikały z żadnych luk w jej platformie.

Pokazuje to główne wyzwanie dla wszystkich dostawców SaaS: zastanowienie się, jak powstrzymać ataki, które wykorzystują ludzkie zaufanie zamiast błędów technicznych.

Salesforce wdrożył kilka środków obronnych:

- Zabezpieczenie połączonych aplikacji: Automatyczne wyłączanie niezainstalowanych połączonych aplikacji dla nowych użytkowników.

- Ograniczenia przepływu OAuth: Wyłączenie połączeń uzyskanych przy użyciu określonych procesów autoryzacji

- Ulepszone monitorowanie: Ulepszone wykrywanie podejrzanych wzorców autoryzacji aplikacji

- Edukacja użytkowników: Publikowanie wskazówek dotyczących rozpoznawania prób inżynierii społecznej

W sierpniu 2025 r. Salesforce zamknął wszystkie integracje z technologiami Salesloft, w tym z aplikacją Drift, po stwierdzeniu, że tokeny OAuth zostały skradzione w powiązanych atakach.

Eksperci ds. bezpieczeństwa ostrzegają teraz, że zespoły muszą słuchać subtelnych wskazówek, takich jak dziwne pauzy, szumy w tle lub usterki audio, które mogą ujawnić, że głos został wygenerowany przez sztuczną inteligencję.

Odpowiedź przedsiębiorstwa: Więcej niż rozwiązania technologiczne

Organizacje zaczynają zdawać sobie sprawę, że obrona przed atakami deepfake wymaga czegoś więcej niż tylko rozwiązań technologicznych; wymaga to fundamentalnego przemyślenia procesów zaufania i weryfikacji.

Komunikacja oparta na zerowym zaufaniu

RealityCheck by Beyond Identity zapewnia każdemu uczestnikowi widoczny, zweryfikowany identyfikator tożsamości, który jest wspierany przez kryptograficzne uwierzytelnianie urządzeń i ciągłe kontrole ryzyka, obecnie dostępne dla Zoom i Microsoft Teams.

Takie rozwiązania stanowią przejście w kierunku modeli "nigdy nie ufaj, zawsze weryfikuj" dla komunikacji korporacyjnej.

Ulepszone programy szkoleniowe

Organizacje korzystające z platformy symulacyjnej deepfake firmy Resemble AI zgłaszają nawet 90% zmniejszenie liczby udanych ataków po wdrożeniu platformy, która wykorzystuje hiperrealistyczne symulacje, aby zilustrować, jak ataki deepfake rozwijają się w prawdziwym świecie.

Weryfikacja wielokanałowa

Wiodące organizacje wdrażają protokoły, które wymagają weryfikacji za pośrednictwem wielu kanałów w przypadku wszelkich żądań wysokiego ryzyka, niezależnie od tego, jak autentyczna wydaje się początkowa komunikacja.

Kiedy głos nie jest już prawdą

Zagrożenie deepfake dla Salesforce i innych systemów korporacyjnych stanowi punkt zwrotny w historii cyberbezpieczeństwa.

Po raz pierwszy atakujący mogą nie tylko podszywać się pod autorytety, ale także brzmieć jak one, wyglądać jak one i przekonać nawet wyszkolonych specjalistów ds. bezpieczeństwa do podjęcia działań zagrażających bezpieczeństwu organizacji.

W erze oszustw generowanych przez sztuczną inteligencję zaufanie musi być zdobywane poprzez weryfikację, a nie zakładane przez znajomość.

Firmy, które to zrozumieją i zainwestują w odpowiednie narzędzia, procesy i kulturę, będą w najlepszej pozycji, aby chronić zarówno bezpieczeństwo, jak i zaufanie w coraz bardziej niepewnym cyfrowym świecie.

W tej nowej rzeczywistości głos po drugiej stronie linii może nie być tym, kim się wydaje.

W erze deepfake'ów stała czujność jest ceną bezpieczeństwa.