In juni 2025 kreeg een Google-medewerker een op het eerste gezicht routine telefoontje van IT-ondersteuning.

De stem aan de lijn klonk professioneel, zelfverzekerd en volledig vertrouwd.

De technicus vroeg de medewerker om een nieuwe app goed te keuren in het Salesforce-systeem van het bedrijf.

Binnen enkele minuten hadden de aanvallers toegang en stalen ze 2,55 miljoen klantgegevens uit het CRM van Google.

Wat dit mogelijk maakte was het gebruik van deepfake audiotechnologie, met AI-gegenereerde stemmen die zo overtuigend waren dat ze een van de meest vertrouwde vormen van authenticatie, het herkennen van de stem van een collega, voor de gek hielden.

Dit incident, dat te maken heeft met de groep ShinyHunters, laat zien hoe aanvallers nu kunstmatige intelligentie gebruiken om in te breken in bedrijfssystemen.

Als de ruggengraat van klantrelatiebeheer voor miljoenen organisaties wereldwijd, is Salesforce een van de belangrijkste doelwitten geworden voor een nieuwe generatie AI-gestuurde social engineering-aanvallen.

Waarom Salesforce een Deepfake-doelwit is geworden

De groei van Salesforce heeft het bedrijf ook tot een groot doelwit voor gegevensdiefstal gemaakt.

Omdat alles gecentraliseerd is, kan één inbreuk miljoenen klantgegevens van veel verschillende bedrijven blootleggen.

Zoals WithSecure's hoofd van Threat Intelligence Tim West opmerkt:

Maak je nooit meer zorgen over AI-fraude. TruthScan Kan je helpen:

- AI-opgewekt detecteren afbeeldingen, tekst, spraak en video.

- Vermijd grote AI-gestuurde fraude.

- Bescherm uw meest gevoelig bedrijfsmiddelen.

"Hackinggroepen zoals Scattered Spider zetten social engineering in om toegang te krijgen tot SaaS-omgevingen. Hun aanvallen zien er technisch misschien eenvoudig uit, maar dat maakt ze niet minder gevaarlijk."

Volgens nieuw onderzoek van WithSecure is kwaadaardige activiteit binnen Salesforce-omgevingen sterk toegenomen in het eerste kwartaal van 2025, met een vertwintigvoudiging van het aantal detecties ten opzichte van eind 2024.

Hoe Deepfakes een Salesforce-inbraak voedden

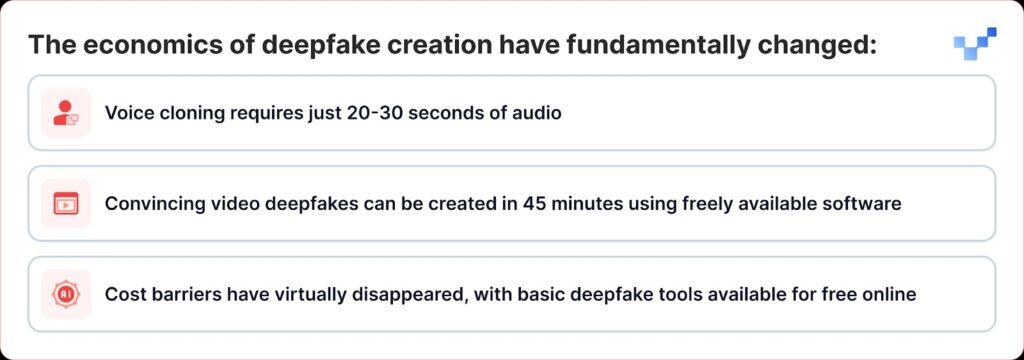

Wat recente aanvallen extra gevaarlijk maakt, is hoe deepfake technologie is veranderd van een niche-tool naar iets dat iedereen als wapen kan gebruiken.

In tegenstelling tot traditionele datalekken waarbij direct wordt ingebroken in databases, maken cybercriminelen nu gebruik van spraakgebaseerde social engineering, of "vishing". Met de opkomst van deepfakes en AI-stemkloon worden deze aanvallen veel moeilijker te herkennen.

De ShinyHunters-campagne tegen Salesforce-klanten volgt een effectief draaiboek dat traditionele social engineering combineert met geavanceerde AI-bedrog:

Fase 1: Steminformatie verzamelen

Aanvallers beginnen met het verzamelen van audiomonsters van openbare bronnen, presentaties van directieleden, conferentiegesprekken, bedrijfsvideo's of posts op sociale media.

Met slechts 20-30 seconden duidelijke audio kunnen ze overtuigende stemklonen maken.

Fase 2: De Deepfake Vishing-oproep

Tijdens een vishing-gesprek overtuigt de aanvaller het slachtoffer om naar de instellingenpagina van de verbonden app van Salesforce te gaan en een nepversie van de Data Loader-app goed te keuren, vermomd met een licht gewijzigde branding.

Daarmee laat het slachtoffer de aanvallers onbewust gevoelige gegevens uit Salesforce stelen.

De geavanceerdheid is opmerkelijk. In sommige gevallen gebruikten aanvallers deepfake audio om zich voor te doen als werknemers en helpdeskmedewerkers over te halen om malafide toegang te autoriseren.

Dit is een belangrijke evolutie van traditionele voice phishing, waarbij aanvallers zich voordeden als autoriteitsfiguren, naar AI-gestuurde imitatie, waarbij ze daadwerkelijk kunnen klinken als specifieke personen.

Fase 3: OAuth-exploitatie

Zodra de kwaadaardige toepassing is geautoriseerd, omzeilen aanvallers de multifactorauthenticatie volledig.

Nadat de nep-app is goedgekeurd, verkrijgen aanvallers OAuth-tokens met een lange levensduur, waarmee ze multifactorauthenticatie kunnen omzeilen en kunnen werken zonder normale beveiligingswaarschuwingen af te geven.

Fase 4: Stille gegevensextractie

De Threat Intelligence Group van Google waarschuwde dat een bedreigende actor een Python-tool gebruikte om het proces van gegevensdiefstal te automatiseren voor elke organisatie die het doelwit was. Onderzoekers zijn zich bewust van meer dan 700 mogelijk getroffen organisaties.

Waarom we kwetsbaar zijn voor AI-stemmen

Het succes van deze aanvallen maakt gebruik van een fundamentele menselijke eigenschap: onze neiging om te vertrouwen wat we horen.

Volgens een recent wereldwijd onderzoek zegt 70 procent van de mensen dat ze er niet zeker van zijn dat ze een echte stem kunnen onderscheiden van een gekloonde stem.

Deze kwetsbaarheid wordt nog vergroot in bedrijfsomgevingen waar helpdeskmedewerkers getraind zijn om behulpzaam en meegaand te zijn en waar werken op afstand interacties met alleen audio heeft genormaliseerd.

Volgens CrowdStrike's 2025 Global Threat Report was er een toename van 442% in voice phishing (vishing) aanvallen tussen de eerste en tweede helft van 2024, gedreven door AI-gegenereerde phishing en imitatie tactieken.

De $25 Miljoen Wake-Up Call

De implicaties van deepfake-aanvallen reiken veel verder dan Salesforce.

De $25 miljoen deepfake heist bij ingenieursbureau Arup begin 2024, waarbij aanvallers AI gebruikten om zich tijdens een videogesprek voor te doen als meerdere leidinggevenden, liet zien dat geen enkele organisatie immuun is voor deze dreiging.

Soortgelijke aanvallen waren ook gericht op leidinggevenden in verschillende sectoren, waaronder een poging om Ferrari CEO Benedetto Vigna na te doen door middel van AI-gekloonde spraakoproepen die zijn Zuid-Italiaanse accent nabootsten.

Deze incidenten vertegenwoordigen wat beveiligingsexperts "CEO-fraude 2.0" noemen, aanvallen die verder gaan dan eenvoudige e-mailimitatie en die multi-zintuiglijke misleidingen creëren die zelfs ervaren leidinggevenden voor de gek kunnen houden.

Platformbeveiliging versus menselijke kwetsbaarheid

Salesforce heeft snel benadrukt dat deze inbreuken geen kwetsbaarheden in hun platform zelf zijn.

Salesforce erkende de campagne van UNC6040 in maart 2025 en waarschuwde dat aanvallers zich voordeden als IT-ondersteuning om werknemers te verleiden tot het geven van referenties of het goedkeuren van kwaadaardige verbonden apps.

Het bedrijf benadrukte dat deze incidenten niet te maken hadden met kwetsbaarheden in zijn platform en daar ook niet uit voortkwamen.

Dit laat een grote uitdaging zien voor alle SaaS-aanbieders: uitvinden hoe je aanvallen kunt stoppen die spelen op menselijk vertrouwen in plaats van technische gebreken.

Salesforce heeft verschillende verdedigingsmaatregelen geïmplementeerd:

- Aangesloten apps hardenen: Niet-geïnstalleerde connected apps automatisch uitschakelen voor nieuwe gebruikers

- OAuth stroombeperkingen: Uitschakelen van verbindingen die zijn verkregen met behulp van bepaalde autorisatieprocessen

- Verbeterde bewaking: Verbeterde detectie van verdachte autorisatiepatronen voor applicaties

- Gebruikerseducatie: Richtlijnen publiceren over het herkennen van pogingen tot social engineering

In augustus 2025 sloot Salesforce alle integraties met Salesloft-technologieën af, inclusief de Drift-app, nadat was ontdekt dat OAuth-tokens waren gestolen bij gerelateerde aanvallen.

Beveiligingsexperts waarschuwen nu dat teams moeten luisteren naar subtiele aanwijzingen, zoals vreemde pauzes, achtergrondgeluiden of audioglitches, die kunnen verraden wanneer een stem door AI is gegenereerd.

Het antwoord van de onderneming: Verder dan technologische oplossingen

Organisaties beginnen in te zien dat verdediging tegen deepfake-aanvallen meer vereist dan technologische oplossingen; het vereist een fundamentele heroverweging van vertrouwens- en verificatieprocessen.

Nul-vertrouwen communicatie

RealityCheck van Beyond Identity geeft elke deelnemer een zichtbare, geverifieerde identiteitsbadge die wordt ondersteund door cryptografische apparaatverificatie en continue risicocontroles, momenteel beschikbaar voor Zoom en Microsoft Teams.

Dergelijke oplossingen betekenen een verschuiving naar "nooit vertrouwen, altijd verifiëren"-modellen voor bedrijfscommunicatie.

Verbeterde trainingsprogramma's

Organisaties die het deepfake simulatieplatform van Resemble AI gebruiken, melden tot 90% minder succesvolle aanvallen na implementatie van het platform, dat hyperrealistische simulaties gebruikt om te illustreren hoe deepfake-aanvallen zich in de echte wereld ontvouwen.

Verificatie via meerdere kanalen

Toonaangevende organisaties implementeren protocollen die verificatie via meerdere kanalen vereisen voor alle verzoeken met een hoog risico, ongeacht hoe authentiek de eerste communicatie lijkt.

Wanneer stem niet langer waarheid is

De deepfake-dreiging voor Salesforce en andere bedrijfssystemen vormt een keerpunt in de cyberbeveiligingsgeschiedenis.

Voor het eerst kunnen aanvallers zich niet alleen voordoen als autoriteitsfiguren, maar kunnen ze ook echt klinken als hen, eruitzien als hen en zelfs getrainde beveiligingsprofessionals overtuigen om acties te ondernemen die de beveiliging van de organisatie in gevaar brengen.

In een tijdperk van door AI gegenereerd bedrog moet vertrouwen worden verdiend door verificatie, niet verondersteld door vertrouwdheid.

Bedrijven die dit begrijpen en investeren in de juiste tools, processen en cultuur zullen zich in de beste positie bevinden om zowel veiligheid als vertrouwen te beschermen in een steeds onzekerder wordende digitale wereld.

In deze nieuwe realiteit is de stem aan de andere kant van de lijn misschien niet wie hij lijkt.

In het tijdperk van deepfakes is constante waakzaamheid de prijs voor veiligheid.