I juni 2025 mottok en Google-ansatt det som så ut til å være en rutinesamtale fra IT-support.

Stemmen i røret hørtes profesjonell, selvsikker og fullstendig kjent ut.

Teknikeren ba den ansatte om å godkjenne en ny app i selskapets Salesforce-system.

I løpet av få minutter hadde angriperne tilgang til og stjal 2,55 millioner kundeoppføringer fra Googles CRM-system.

Det som gjorde dette mulig, var bruken av deepfake-lydteknologi, med AI-genererte stemmer som var så overbevisende at de lurte en av de mest pålitelige formene for autentisering, nemlig å gjenkjenne stemmen til en kollega.

Denne hendelsen, som er knyttet til ShinyHunters-gruppen, viser hvordan angripere nå bruker kunstig intelligens til å bryte seg inn i bedriftssystemer.

Salesforce, som er ryggraden i kunderelasjonsstyringen for millioner av organisasjoner over hele verden, har blitt et av hovedmålene for en ny generasjon AI-drevne sosialtekniske angrep.

Hvorfor Salesforce ble et Deepfake-mål

Salesforce' vekst har også gjort selskapet til et stort mål for datatyveri.

Siden alt er sentralisert, kan et enkelt sikkerhetsbrudd eksponere millioner av kundeopplysninger fra mange forskjellige selskaper.

Som Tim West, leder for Threat Intelligence i WithSecure, bemerker:

Aldri bekymre deg for AI-svindel igjen. TruthScan Kan hjelpe deg:

- Oppdage AI generert bilder, tekst, tale og video.

- Unngå stor AI-drevet svindel.

- Beskytt dine mest følsom virksomhetens eiendeler.

"Hackergrupper som Scattered Spider bruker sosial manipulering for å få tilgang til SaaS-miljøer. Angrepene deres kan se teknisk enkle ut, men det gjør dem ikke mindre farlige."

Ifølge en ny WithSecure-undersøkelse økte den ondsinnede aktiviteten i Salesforce-miljøer kraftig i første kvartal 2025, med en tyvedobling i antall oppdagelser sammenlignet med slutten av 2024.

Hvordan Deepfakes drev et Salesforce-brudd

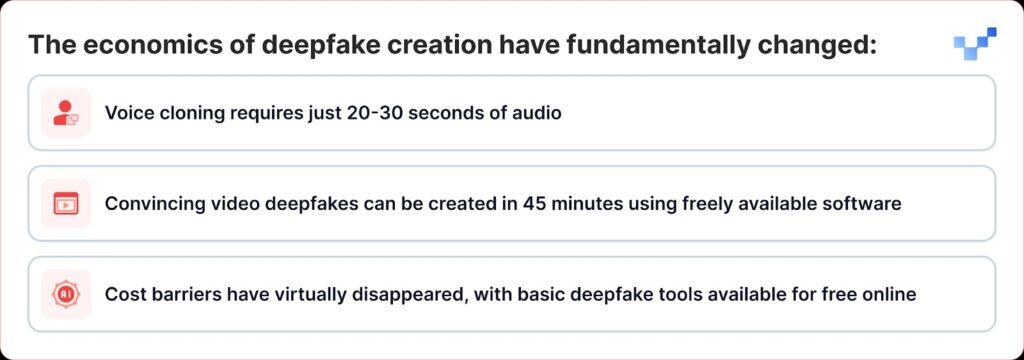

Det som gjør de siste angrepene spesielt farlige, er hvordan deepfake-teknologien har gått fra å være et nisjeverktøy til å bli et våpen som hvem som helst kan bruke.

I motsetning til tradisjonelle datainnbrudd som bryter seg direkte inn i databaser, bruker nettkriminelle nå stemmebasert sosial manipulering, eller "vishing". Med fremveksten av deepfakes og AI-stemmekloning blir disse angrepene mye vanskeligere å oppdage.

ShinyHunters-kampanjen mot Salesforce-kunder følger en effektiv dreiebok som kombinerer tradisjonell sosial manipulering med banebrytende AI-bedrag:

Fase 1: Innsamling av stemmeinformasjon

Angriperne begynner med å høste lydprøver fra offentlige kilder, lederpresentasjoner, konferansesamtaler, bedriftsvideoer eller innlegg i sosiale medier.

Med så lite som 20-30 sekunder med klar lyd kan de skape overbevisende stemmekloner.

Fase 2: Deepfake Vishing-anropet

Under en vishing-samtale overbeviser angriperen offeret om å gå til Salesforces tilkoblede appoppsettside og godkjenne en falsk versjon av Data Loader-appen, forkledd med litt endret merkevarebygging.

Dermed lar offeret angriperne ubevisst stjele sensitive data fra Salesforce.

Raffinementet er bemerkelsesverdig. I noen tilfeller brukte angriperne deepfake-lyd for å utgi seg for å være ansatte og overtale helpdesk-ansatte til å autorisere useriøs tilgang.

Dette representerer en betydelig utvikling fra tradisjonell phishing med stemmen, der angriperne bare utga seg for å være autoritetspersoner, til AI-forbedret imitasjon, der de faktisk kan høres ut som bestemte personer.

Fase 3: Utnyttelse av OAuth

Når den ondsinnede applikasjonen er autorisert, kan angriperne omgå flerfaktorautentisering helt og holdent.

Etter at den falske appen er godkjent, får angriperne tak i langlivede OAuth-tokens, som gjør at de kan omgå flerfaktorautentisering og operere uten å utløse normale sikkerhetsvarsler.

Fase 4: Stille datauttrekk

Googles Threat Intelligence Group advarte om at en trusselaktør brukte et Python-verktøy til å automatisere datatyveriprosessen for hver organisasjon som ble angrepet, og forskerne var klar over at over 700 organisasjoner potensielt var berørt.

Hvorfor vi er sårbare for AI-stemmer

Disse angrepene utnytter et grunnleggende menneskelig trekk: vår tendens til å stole på det vi hører.

Ifølge en nylig gjennomført global studie sier 70 prosent av befolkningen at de ikke er sikre på at de kan identifisere en ekte stemme kontra en klonet stemme.

Denne sårbarheten forsterkes i bedriftsmiljøer der helpdesk-ansatte er opplært til å være hjelpsomme og imøtekommende, og der fjernarbeid har normalisert interaksjoner som kun foregår via lyd.

Ifølge CrowdStrikes 2025 Global Threat Report var det en økning på 442% i antall stemmefiskeangrep (vishing) mellom første og andre halvdel av 2024, drevet av AI-generert phishing og etterligningstaktikker.

Vekkeroppringningen på $25 millioner

Konsekvensene av deepfake-forbedrede angrep strekker seg langt utover Salesforce.

Deepfake-kuppet på $25 millioner hos ingeniørfirmaet Arup i begynnelsen av 2024, der angriperne brukte kunstig intelligens til å utgi seg for å være flere ledere i en videosamtale, viste at ingen organisasjoner er immune mot denne trusselen.

Lignende angrep har også vært rettet mot ledere i ulike bransjer, blant annet et forsøk på å utgi seg for å være Ferraris administrerende direktør Benedetto Vigna ved hjelp av AI-klonede taleanrop som etterlignet hans søritalienske aksent.

Disse hendelsene representerer det sikkerhetseksperter kaller "CEO fraud 2.0", angrep som går lenger enn bare å utgi seg for å være en e-post, og som skaper multisensoriske bedrag som kan lure selv erfarne ledere.

Plattformsikkerhet vs. menneskelig sårbarhet

Salesforce har vært raske med å understreke at disse bruddene ikke representerer sårbarheter i selve plattformen.

Salesforce erkjente UNC6040s kampanje i mars 2025, og advarte om at angripere utga seg for å være IT-support for å lure ansatte til å gi bort legitimasjon eller godkjenne ondsinnede tilkoblede apper.

Selskapet understreket at disse hendelsene ikke involverte eller hadde sin opprinnelse i sårbarheter i plattformen.

Dette viser en stor utfordring for alle SaaS-leverandører: å finne ut hvordan man kan stoppe angrep som spiller på menneskelig tillit i stedet for tekniske feil.

Salesforce har iverksatt flere defensive tiltak:

- Herding av tilkoblede apper: Automatisk deaktivering av ikke-installerte tilkoblede apper for nye brukere

- Begrensninger i OAuth-flyten: Deaktivering av tilkoblinger oppnådd ved hjelp av visse autorisasjonsprosesser

- Forbedret overvåking: Forbedret oppdagelse av mistenkelige autorisasjonsmønstre for applikasjoner

- Brukeropplæring: Publisering av veiledning om hvordan man gjenkjenner forsøk på sosial manipulering

I august 2025 stengte Salesforce alle integrasjoner med Salesloft-teknologier, inkludert Drift-appen, etter å ha oppdaget at OAuth-tokens hadde blitt stjålet i relaterte angrep.

Sikkerhetseksperter advarer nå om at teamene må lytte etter subtile ledetråder, som merkelige pauser, bakgrunnsstøy eller lydfeil, som kan avsløre når en stemme har blitt generert av AI.

Virksomhetens respons: Utover teknologiske løsninger

Organisasjoner begynner å innse at forsvaret mot deepfake-forbedrede angrep krever mer enn teknologiske løsninger; det krever en grunnleggende revurdering av tillits- og verifiseringsprosesser.

Null tillit til kommunikasjon

RealityCheck fra Beyond Identity gir alle deltakere et synlig, verifisert identitetsmerke som støttes av kryptografisk enhetsautentisering og kontinuerlige risikokontroller, som for øyeblikket er tilgjengelig for Zoom og Microsoft Teams.

Slike løsninger representerer et skifte i retning av "aldri stole på, alltid verifisere"-modeller for bedriftskommunikasjon.

Forbedrede opplæringsprogrammer

Organisasjoner som bruker Resemble AIs deepfake-simuleringsplattform, rapporterer om opptil 90% færre vellykkede angrep etter implementering av plattformen, som bruker hyperrealistiske simuleringer for å illustrere hvordan deepfake-angrep utspiller seg i den virkelige verden.

Verifisering av flere kanaler

Ledende organisasjoner implementerer protokoller som krever verifisering gjennom flere kanaler for alle høyrisikoforespørsler, uansett hvor autentisk den opprinnelige kommunikasjonen ser ut til å være.

Når stemmen ikke lenger er sannhet

Deepfake-trusselen mot Salesforce og andre bedriftssystemer representerer et vendepunkt i cybersikkerhetshistorien.

For første gang kan angripere ikke bare utgi seg for å være autoritetspersoner; de kan faktisk høres ut som dem, se ut som dem og overbevise selv utdannede sikkerhetseksperter om å foreta handlinger som setter organisasjonens sikkerhet i fare.

I en tid med AI-generert bedrag må tillit oppnås gjennom verifisering, ikke antas gjennom kjennskap.

Bedrifter som forstår dette og investerer i de riktige verktøyene, prosessene og kulturen, vil være i den beste posisjonen for å beskytte både sikkerhet og tillit i en stadig mer usikker digital verden.

I denne nye virkeligheten er det ikke sikkert at stemmen i den andre enden av linjen er den den gir seg ut for å være.

I en tid med deepfakes er konstant årvåkenhet prisen for sikkerhet.