Nel giugno del 2025, un dipendente di Google ha ricevuto quella che sembrava essere una chiamata di routine dall'assistenza IT.

La voce al telefono sembrava professionale, sicura e del tutto familiare.

Il tecnico ha chiesto al dipendente di approvare una nuova applicazione nel sistema Salesforce dell'azienda.

In pochi minuti, gli aggressori hanno avuto accesso e hanno rubato 2,55 milioni di record di clienti dal CRM di Google.

A renderlo possibile è stato l'uso della tecnologia deepfake audio, con voci generate dall'intelligenza artificiale così convincenti da ingannare una delle forme di autenticazione più affidabili, il riconoscimento della voce di un collega.

Questo incidente, legato al gruppo ShinyHunters, mostra come gli aggressori stiano utilizzando l'intelligenza artificiale per penetrare nei sistemi aziendali.

Essendo la spina dorsale della gestione delle relazioni con i clienti per milioni di organizzazioni in tutto il mondo, Salesforce è diventato uno dei principali obiettivi di una nuova generazione di attacchi di social engineering basati sull'intelligenza artificiale.

Perché Salesforce è diventata un bersaglio di Deepfake

La crescita di Salesforce l'ha anche trasformata in un grande obiettivo per il furto di dati.

Poiché tutto è centralizzato, una singola violazione può esporre milioni di dati di clienti di molte aziende diverse.

Come osserva Tim West, responsabile dell'intelligence sulle minacce di WithSecure:

Non preoccupatevi più delle frodi dell'IA. TruthScan Può aiutarvi:

- Rilevare l'IA generata immagini, testo, voce e video.

- Evitare frodi di grande portata guidate dall'intelligenza artificiale.

- Proteggete i vostri prodotti più sensibile beni dell'impresa.

"Gruppi di hacker come Scattered Spider utilizzano il social engineering per accedere agli ambienti SaaS. I loro attacchi possono sembrare tecnicamente semplici, ma questo non li rende meno pericolosi".

Secondo una nuova ricerca di WithSecure, l'attività dannosa all'interno degli ambienti Salesforce è aumentata notevolmente nel primo trimestre del 2025, con un aumento di venti volte dei rilevamenti rispetto alla fine del 2024.

Come i deepfakes hanno alimentato la violazione di Salesforce

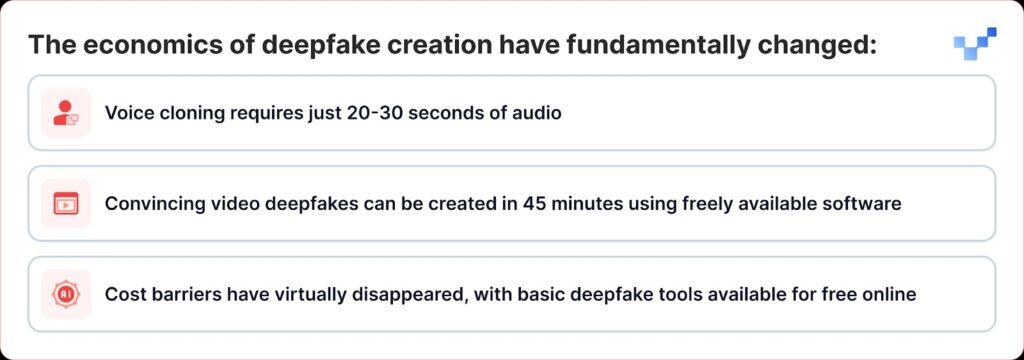

Ciò che rende particolarmente pericolosi i recenti attacchi è il modo in cui la tecnologia deepfake si è trasformata da uno strumento di nicchia a qualcosa che chiunque può usare come arma.

A differenza delle tradizionali violazioni di dati che penetrano direttamente nei database, i criminali informatici utilizzano ora il social engineering basato sulla voce, o "vishing". Con l'aumento dei deepfakes e della clonazione vocale AI, questi attacchi stanno diventando molto più difficili da individuare.

La campagna di ShinyHunters contro i clienti Salesforce segue un efficace schema di gioco che combina l'ingegneria sociale tradizionale con l'inganno dell'IA all'avanguardia:

Fase 1: raccolta di informazioni vocali

Gli aggressori iniziano raccogliendo campioni audio da fonti pubbliche, presentazioni di dirigenti, conference call, video aziendali o post sui social media.

Con appena 20-30 secondi di audio chiaro, possono creare cloni vocali convincenti.

Fase 2: la chiamata di vishing di Deepfake

Durante una chiamata di vishing, l'aggressore convince la vittima ad accedere alla pagina di configurazione delle app connesse di Salesforce e ad approvare una versione falsa dell'app Data Loader, camuffata con un marchio leggermente alterato.

In questo modo, la vittima permette inconsapevolmente agli aggressori di rubare dati sensibili da Salesforce.

Il livello di sofisticazione è notevole. In alcuni casi, gli aggressori hanno utilizzato l'audio deepfake per impersonare i dipendenti e convincere il personale dell'help desk ad autorizzare l'accesso illecito.

Questo rappresenta un'evoluzione significativa dal phishing vocale tradizionale, in cui gli aggressori fingevano semplicemente di essere figure autoritarie, all'impersonificazione potenziata dall'intelligenza artificiale, in cui possono effettivamente parlare come individui specifici.

Fase 3: Sfruttamento di OAuth

Una volta autorizzata l'applicazione dannosa, gli aggressori aggirano completamente l'autenticazione a più fattori.

Dopo l'approvazione dell'app fasulla, gli aggressori ottengono token OAuth a lunga durata, che consentono loro di bypassare l'autenticazione a più fattori e di operare senza attivare i normali avvisi di sicurezza.

Fase 4: Estrazione silenziosa dei dati

Il Threat Intelligence Group di Google ha avvertito che un attore delle minacce ha utilizzato uno strumento Python per automatizzare il processo di furto dei dati per ogni organizzazione presa di mira; i ricercatori sono a conoscenza di oltre 700 organizzazioni potenzialmente colpite.

Perché siamo vulnerabili alle voci dell'intelligenza artificiale

Il successo di questi attacchi sfrutta un tratto umano fondamentale: la nostra tendenza a fidarci di ciò che sentiamo dire.

Secondo un recente studio globale, il 70% delle persone dichiara di non essere sicuro di poter identificare una voce reale da una clonata.

Questa vulnerabilità è aggravata negli ambienti aziendali dove il personale dell'help desk è addestrato a essere disponibile e accomodante e il lavoro in remoto ha normalizzato le interazioni solo audio.

Secondo il Global Threat Report 2025 di CrowdStrike, tra la prima e la seconda metà del 2024 si è registrato un aumento di 442% degli attacchi di phishing vocale (vishing), guidati da tattiche di phishing e impersonificazione generate dall'intelligenza artificiale.

Il campanello d'allarme di $25 milioni di euro

Le implicazioni degli attacchi deepfake si estendono ben oltre Salesforce.

Il furto con deepfake da $25 milioni di euro ai danni della società di ingegneria Arup all'inizio del 2024, in cui gli aggressori hanno utilizzato l'intelligenza artificiale per impersonare diversi dirigenti durante una videochiamata, ha dimostrato che nessuna organizzazione è immune da questa minaccia.

Attacchi simili hanno preso di mira anche dirigenti di diversi settori, tra cui il tentativo di impersonare l'amministratore delegato della Ferrari Benedetto Vigna utilizzando chiamate vocali clonate dall'intelligenza artificiale che imitavano il suo accento italiano meridionale.

Questi incidenti rappresentano ciò che gli esperti di sicurezza chiamano "frode del CEO 2.0", attacchi che vanno oltre la semplice impersonificazione dell'e-mail per creare inganni multisensoriali che possono ingannare anche dirigenti esperti.

Sicurezza della piattaforma e vulnerabilità umana

Salesforce si è affrettata a sottolineare che queste violazioni non rappresentano vulnerabilità della piattaforma stessa.

Salesforce ha riconosciuto la campagna di UNC6040 nel marzo 2025, avvertendo che gli aggressori impersonavano il supporto IT per ingannare i dipendenti e indurli a fornire credenziali o ad approvare applicazioni collegate dannose.

L'azienda ha sottolineato che questi incidenti non hanno coinvolto o avuto origine da alcuna vulnerabilità della sua piattaforma.

Questo dimostra una sfida importante per tutti i fornitori di SaaS: capire come fermare gli attacchi che giocano sulla fiducia umana invece che sui difetti tecnici.

Salesforce ha implementato diverse misure difensive:

- Protezione delle app connesse: Disabilitazione automatica delle app connesse non installate per i nuovi utenti

- Limitazioni del flusso OAuth: Disabilitazione delle connessioni ottenute con determinati processi di autorizzazione

- Monitoraggio migliorato: Rilevamento migliorato dei modelli di autorizzazione delle applicazioni sospette

- Formazione degli utenti: Pubblicare una guida per riconoscere i tentativi di social engineering

Nell'agosto 2025, Salesforce ha chiuso tutte le integrazioni con le tecnologie Salesloft, compresa l'app Drift, dopo aver scoperto che i token OAuth erano stati rubati in attacchi correlati.

Gli esperti di sicurezza avvertono ora che i team devono ascoltare i sottili indizi, come strane pause, rumori di fondo o difetti audio, che possono rivelare quando una voce è stata generata dall'IA.

La risposta aziendale: Oltre le soluzioni tecnologiche

Le organizzazioni stanno iniziando a riconoscere che per difendersi dagli attacchi deepfake-enhanced non bastano le soluzioni tecnologiche, ma occorre un ripensamento fondamentale dei processi di fiducia e verifica.

Comunicazione a fiducia zero

RealityCheck di Beyond Identity fornisce a ogni partecipante un badge di identità visibile e verificato, supportato da un'autenticazione crittografica dei dispositivi e da controlli continui dei rischi, attualmente disponibile per Zoom e Microsoft Teams.

Queste soluzioni rappresentano un cambiamento verso i modelli "mai fidarsi, sempre verificare" per la comunicazione aziendale.

Programmi di formazione avanzati

Le organizzazioni che utilizzano la piattaforma di simulazione deepfake di Resemble AI riportano una riduzione fino a 90% degli attacchi riusciti dopo l'implementazione della piattaforma, che utilizza simulazioni iperrealistiche per illustrare come si svolgono gli attacchi deepfake nel mondo reale.

Verifica multicanale

Le organizzazioni leader stanno implementando protocolli che richiedono la verifica attraverso più canali per qualsiasi richiesta ad alto rischio, indipendentemente dall'autenticità della comunicazione iniziale.

Quando la voce non è più verità

La minaccia deepfake a Salesforce e ad altri sistemi aziendali rappresenta un punto di inflessione nella storia della cybersicurezza.

Per la prima volta, gli aggressori non si limitano a impersonare figure autoritarie, ma sono in grado di parlare come loro, di assomigliare a loro e di convincere persino professionisti della sicurezza addestrati a intraprendere azioni che compromettono la sicurezza dell'organizzazione.

In un'epoca di inganni generati dall'Intelligenza Artificiale, la fiducia deve essere guadagnata attraverso la verifica, e non presunta attraverso la familiarità.

Le aziende che comprendono questo aspetto e investono negli strumenti, nei processi e nella cultura giusti saranno nella posizione migliore per proteggere sia la sicurezza che la fiducia in un mondo digitale sempre più incerto.

In questa nuova realtà, la voce all'altro capo del filo potrebbe non essere quella che sembra.

Nell'era dei deepfakes, la costante vigilanza è il prezzo della sicurezza.