En juin 2025, un employé de Google a reçu ce qui semblait être un appel de routine de l'assistance informatique.

La voix au bout du fil semblait professionnelle, confiante et tout à fait familière.

Le technicien a demandé à l'employé d'approuver une nouvelle application dans le système Salesforce de l'entreprise.

En quelques minutes, les attaquants ont eu accès à 2,55 millions d'enregistrements de clients du CRM de Google et les ont volés.

Cela a été rendu possible par l'utilisation d'une technologie de "deepfake audio", avec des voix générées par l'IA si convaincantes qu'elles ont trompé l'une des formes d'authentification les plus fiables, à savoir la reconnaissance de la voix d'un collègue.

Cet incident, lié au groupe ShinyHunters, montre comment les attaquants utilisent désormais l'intelligence artificielle pour s'introduire dans les systèmes des entreprises.

En tant qu'épine dorsale de la gestion de la relation client pour des millions d'organisations dans le monde, Salesforce est devenu l'une des principales cibles d'une nouvelle génération d'attaques d'ingénierie sociale basées sur l'IA.

Pourquoi Salesforce est devenu la cible d'un Deepfake

La croissance de Salesforce en a également fait une cible de choix pour le vol de données.

Comme tout est centralisé, une seule violation peut exposer des millions de dossiers de clients provenant de nombreuses entreprises différentes.

Comme le fait remarquer Tim West, responsable de la veille sur les menaces chez WithSecure :

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

"Des groupes de pirates comme Scattered Spider utilisent l'ingénierie sociale pour accéder aux environnements SaaS. Leurs attaques peuvent sembler techniquement simples, mais cela ne les rend pas moins dangereuses."

Selon une nouvelle étude de WithSecure, les activités malveillantes au sein des environnements Salesforce ont fortement augmenté au cours du premier trimestre 2025, avec une multiplication par vingt des détections par rapport à la fin de l'année 2024.

Comment les Deepfakes ont alimenté une brèche dans Salesforce

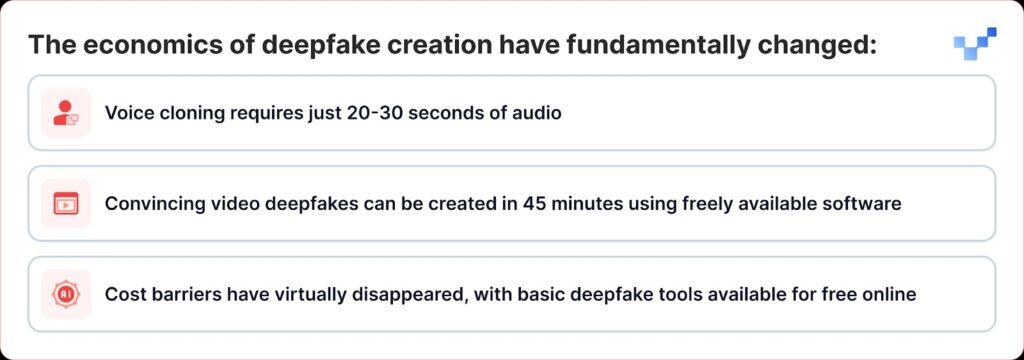

Ce qui rend les attaques récentes particulièrement dangereuses, c'est la façon dont la technologie deepfake est passée d'un outil de niche à quelque chose que tout le monde peut utiliser comme une arme.

Contrairement aux violations de données traditionnelles qui s'introduisent directement dans les bases de données, les cybercriminels utilisent désormais l'ingénierie sociale basée sur la voix, ou "vishing". Avec l'essor des deepfakes et du clonage vocal par l'IA, ces attaques sont de plus en plus difficiles à repérer.

La campagne de ShinyHunters contre les clients de Salesforce suit une stratégie efficace qui associe l'ingénierie sociale traditionnelle à la tromperie de l'IA de pointe :

Phase 1 : Collecte de renseignements vocaux

Les attaquants commencent par récolter des échantillons audio à partir de sources publiques, de présentations de cadres, de conférences téléphoniques, de vidéos d'entreprise ou de messages sur les médias sociaux.

Avec seulement 20 à 30 secondes de son clair, ils peuvent créer des clones de voix convaincants.

Phase 2 : L'appel d'hameçonnage Deepfake

Lors d'un appel de vishing, l'attaquant convainc la victime de se rendre sur la page de configuration de l'application connectée de Salesforce et d'approuver une fausse version de l'application Data Loader, déguisée avec une image de marque légèrement modifiée.

Ainsi, la victime laisse sans le savoir les attaquants voler des données sensibles dans Salesforce.

La sophistication est remarquable. Dans certains cas, les attaquants ont utilisé de faux sons pour se faire passer pour des employés et persuader le personnel du service d'assistance d'autoriser un accès non autorisé.

Il s'agit d'une évolution significative par rapport à l'hameçonnage vocal traditionnel, où les attaquants se faisaient simplement passer pour des figures d'autorité, et à l'usurpation d'identité améliorée par l'IA, où ils peuvent réellement ressembler à des personnes spécifiques.

Phase 3 : Exploitation d'OAuth

Une fois l'application malveillante autorisée, les attaquants contournent entièrement l'authentification multifactorielle.

Une fois la fausse application approuvée, les attaquants obtiennent des jetons OAuth à longue durée de vie, qui leur permettent de contourner l'authentification multifactorielle et d'agir sans déclencher les alertes de sécurité habituelles.

Phase 4 : Extraction de données silencieuses

Le Threat Intelligence Group de Google a averti qu'un acteur de la menace a utilisé un outil Python pour automatiser le processus de vol de données pour chaque organisation ciblée, les chercheurs ayant connaissance de plus de 700 organisations potentiellement touchées.

Pourquoi nous sommes vulnérables aux voix de l'IA

Le succès de ces attaques exploite un trait humain fondamental : notre tendance à faire confiance à ce que nous entendons.

Selon une étude mondiale récente, 70 % des personnes déclarent ne pas être sûres de pouvoir distinguer une voix réelle d'une voix clonée.

Cette vulnérabilité est aggravée dans les entreprises où le personnel du service d'assistance est formé pour être serviable et accommodant, et où le travail à distance a normalisé les interactions audio uniquement.

Selon le 2025 Global Threat Report de CrowdStrike, les attaques par hameçonnage vocal (vishing) ont augmenté de 442% entre le premier et le second semestre 2024, sous l'effet de tactiques d'hameçonnage et d'usurpation d'identité générées par l'IA.

Le réveil du million $25

Les implications des attaques par "deepfake" vont bien au-delà de Salesforce.

Le vol de $25 millions d'euros à la société d'ingénierie Arup au début de 2024, où les attaquants ont utilisé l'IA pour se faire passer pour plusieurs cadres lors d'un appel vidéo, a montré qu'aucune organisation n'est à l'abri de cette menace.

Des attaques similaires ont également visé des dirigeants de différents secteurs, notamment une tentative d'usurpation de l'identité du PDG de Ferrari, Benedetto Vigna, au moyen d'appels vocaux clonés par l'IA qui imitaient son accent du sud de l'Italie.

Ces incidents représentent ce que les experts en sécurité appellent la "fraude au PDG 2.0", des attaques qui vont au-delà de la simple usurpation d'identité par courriel pour créer des tromperies multisensorielles qui peuvent tromper même des cadres expérimentés.

Sécurité des plateformes et vulnérabilité humaine

Salesforce s'est empressé de souligner que ces brèches ne représentaient pas des vulnérabilités dans sa plateforme elle-même.

Salesforce a reconnu la campagne d'UNC6040 en mars 2025, avertissant que les attaquants se faisaient passer pour le service d'assistance informatique afin d'inciter les employés à donner des informations d'identification ou à approuver des applications connectées malveillantes.

L'entreprise a souligné que ces incidents n'impliquaient pas de vulnérabilités dans sa plateforme et n'en étaient pas à l'origine.

Il s'agit là d'un défi majeur pour tous les fournisseurs de SaaS : trouver le moyen d'arrêter les attaques qui jouent sur la confiance humaine plutôt que sur les failles techniques.

Salesforce a mis en place plusieurs mesures de défense :

- Durcissement des applications connectées : Désactivation automatique des applications connectées non installées pour les nouveaux utilisateurs

- Restrictions du flux OAuth : Désactivation des connexions obtenues à l'aide de certains processus d'autorisation

- Surveillance améliorée : Détection améliorée des modèles d'autorisation d'application suspects

- Éducation des utilisateurs : Publication de conseils pour reconnaître les tentatives d'ingénierie sociale

En août 2025, Salesforce a fermé toutes les intégrations avec les technologies Salesloft, y compris l'application Drift, après avoir découvert que des jetons OAuth avaient été volés lors d'attaques connexes.

Les experts en sécurité préviennent désormais que les équipes doivent être à l'écoute d'indices subtils, tels que des pauses bizarres, des bruits de fond ou des problèmes audio, qui peuvent révéler qu'une voix a été générée par l'IA.

La réponse de l'entreprise : Au-delà des solutions technologiques

Les organisations commencent à reconnaître que la défense contre les attaques de type "deepfake" nécessite plus que des solutions technologiques ; elle exige de repenser fondamentalement les processus de confiance et de vérification.

Communication sans confiance

RealityCheck de Beyond Identity donne à chaque participant un badge d'identité visible et vérifié, soutenu par une authentification cryptographique des appareils et des vérifications continues des risques, actuellement disponible pour Zoom et Microsoft Teams.

Ces solutions représentent une évolution vers des modèles de communication d'entreprise fondés sur le principe "ne jamais faire confiance, toujours vérifier".

Programmes de formation améliorés

Les organisations qui utilisent la plateforme de simulation de deepfake de Resemble AI signalent une réduction de 90% des attaques réussies après avoir mis en œuvre la plateforme, qui utilise des simulations hyperréalistes pour illustrer comment les attaques de deepfake se déroulent dans le monde réel.

Vérification multicanal

Les organisations de premier plan mettent en œuvre des protocoles qui exigent une vérification par le biais de plusieurs canaux pour toute demande à haut risque, quelle que soit l'authenticité apparente de la communication initiale.

Quand la voix n'est plus la vérité

La menace que représente le deepfake pour Salesforce et d'autres systèmes d'entreprise constitue un point d'inflexion dans l'histoire de la cybersécurité.

Pour la première fois, les attaquants ne peuvent pas se contenter d'usurper l'identité d'une autorité ; ils peuvent en fait parler comme elle, lui ressembler et convaincre même des professionnels de la sécurité bien formés de prendre des mesures qui compromettent la sécurité de l'organisation.

À l'ère de la tromperie générée par l'IA, la confiance doit être gagnée par la vérification, et non présumée par la familiarité.

Les entreprises qui comprennent cela et qui investissent dans les outils, les processus et la culture appropriés seront les mieux placées pour protéger la sécurité et la confiance dans un monde numérique de plus en plus incertain.

Dans cette nouvelle réalité, la voix à l'autre bout du fil n'est peut-être pas celle que l'on croit.

À l'ère des "deepfakes", la vigilance constante est le prix de la sécurité.