Im Juni 2025 erhielt ein Google-Mitarbeiter einen scheinbar routinemäßigen Anruf vom IT-Support.

Die Stimme in der Leitung klang professionell, selbstbewusst und völlig vertraut.

Der Techniker bat den Mitarbeiter, eine neue App im Salesforce-System des Unternehmens zu genehmigen.

Innerhalb weniger Minuten hatten die Angreifer Zugriff und stahlen 2,55 Millionen Kundendatensätze aus dem CRM-System von Google.

Möglich wurde dies durch den Einsatz von Deepfake-Audio-Technologie, bei der KI-generierte Stimmen so überzeugend sind, dass sie eine der vertrauenswürdigsten Formen der Authentifizierung, nämlich die Erkennung der Stimme eines Kollegen, überlisten.

Dieser Vorfall, der mit der Gruppe ShinyHunters in Verbindung gebracht wird, zeigt, wie Angreifer jetzt künstliche Intelligenz nutzen, um in Unternehmenssysteme einzudringen.

Als Rückgrat des Kundenbeziehungsmanagements für Millionen von Unternehmen weltweit ist Salesforce zu einem der Hauptziele für eine neue Generation von KI-gestützten Social-Engineering-Angriffen geworden.

Warum Salesforce ein Deepfake-Ziel geworden ist

Das Wachstum von Salesforce hat das Unternehmen auch zu einem großen Ziel für Datendiebstahl gemacht.

Da alles zentralisiert ist, kann ein einziger Verstoß Millionen von Kundendaten von vielen verschiedenen Unternehmen offenlegen.

Tim West, Leiter der Abteilung Threat Intelligence bei WithSecure, merkt an:

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

"Hackergruppen wie Scattered Spider nutzen Social Engineering, um sich Zugang zu SaaS-Umgebungen zu verschaffen. Ihre Angriffe mögen technisch einfach aussehen, aber das macht sie nicht weniger gefährlich."

Laut einer neuen Studie von WithSecure haben die bösartigen Aktivitäten in Salesforce-Umgebungen im ersten Quartal 2025 stark zugenommen, mit einer zwanzigfachen Zunahme der Entdeckungen im Vergleich zu Ende 2024.

Wie Deepfakes zu einem Salesforce-Einbruch führten

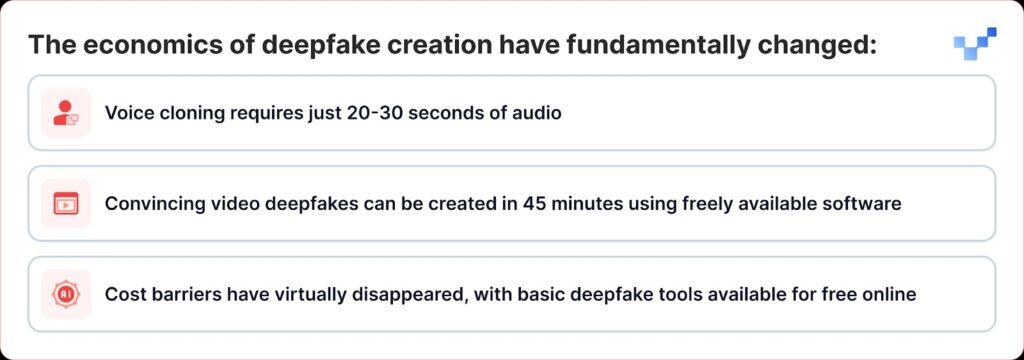

Was die jüngsten Angriffe besonders gefährlich macht, ist die Tatsache, dass sich die Deepfake-Technologie von einem Nischenwerkzeug zu etwas entwickelt hat, das jeder als Waffe einsetzen kann.

Im Gegensatz zu herkömmlichen Datenschutzverletzungen, bei denen direkt in Datenbanken eingebrochen wird, verwenden Cyberkriminelle jetzt sprachbasiertes Social Engineering oder "Vishing". Mit dem Aufkommen von Deepfakes und KI-Stimmenklonen werden diese Angriffe immer schwieriger zu erkennen.

Die ShinyHunters-Kampagne gegen Salesforce-Kunden folgt einem effektiven Playbook, das traditionelles Social Engineering mit modernster KI-Täuschung kombiniert:

Phase 1: Sammlung von Sprachinformationen

Die Angreifer beginnen damit, Audio-Samples aus öffentlichen Quellen, Präsentationen von Führungskräften, Telefonkonferenzen, Unternehmensvideos oder Posts in sozialen Medien zu sammeln.

Mit nur 20-30 Sekunden klarer Audioaufnahmen können sie überzeugende Stimmenklone erstellen.

Phase 2: Der Deepfake-Vishing-Anruf

Während eines Vishing-Anrufs bringt der Angreifer das Opfer dazu, die Einrichtungsseite für verbundene Apps von Salesforce aufzurufen und eine gefälschte Version der Data Loader-App zu genehmigen, die mit einem leicht veränderten Branding getarnt ist.

Damit lässt das Opfer die Angreifer unwissentlich sensible Daten aus Salesforce stehlen.

Die Raffinesse ist bemerkenswert. In einigen Fällen nutzten die Angreifer Deepfake-Audio, um sich als Mitarbeiter auszugeben und Helpdesk-Mitarbeiter dazu zu bringen, den unberechtigten Zugriff zu genehmigen.

Dies stellt eine bedeutende Entwicklung vom traditionellen Voice-Phishing dar, bei dem sich die Angreifer einfach als Autoritätspersonen ausgaben, hin zur KI-gestützten Imitation, bei der sie sich tatsächlich wie bestimmte Personen anhören können.

Phase 3: OAuth-Ausnutzung

Sobald die bösartige Anwendung autorisiert ist, umgehen Angreifer die Multi-Faktor-Authentifizierung vollständig.

Nachdem die gefälschte App genehmigt wurde, erhalten die Angreifer langlebige OAuth-Tokens, die es ihnen ermöglichen, die Multi-Faktor-Authentifizierung zu umgehen und ohne normale Sicherheitswarnungen zu arbeiten.

Phase 4: Stille Datenextraktion

Die Threat Intelligence Group von Google warnte, dass ein Bedrohungsakteur ein Python-Tool benutzte, um den Datendiebstahl für jedes betroffene Unternehmen zu automatisieren. Die Forscher wissen von über 700 potenziell betroffenen Unternehmen.

Warum wir anfällig für KI-Stimmen sind

Der Erfolg dieser Angriffe nutzt eine grundlegende menschliche Eigenschaft aus: unsere Neigung, dem zu vertrauen, was wir hören.

Laut einer aktuellen weltweiten Studie sind 70 Prozent der Menschen nicht sicher, ob sie eine echte Stimme von einer geklonten unterscheiden können.

Diese Schwachstelle wird in Unternehmensumgebungen noch verstärkt, in denen Helpdesk-Mitarbeiter darauf geschult sind, hilfsbereit und zuvorkommend zu sein, und in denen die Arbeit an entfernten Standorten reine Audio-Interaktionen normalisiert hat.

Laut dem CrowdStrike Global Threat Report 2025 gab es zwischen dem ersten und dem zweiten Halbjahr 2024 einen Anstieg der Voice-Phishing-Angriffe (Vishing) um 442%, angetrieben durch KI-generierte Phishing- und Impersonationstaktiken.

Der $25 Millionen Weckruf

Die Auswirkungen von Deepfake-Angriffen gehen weit über Salesforce hinaus.

Der $25 Millionen Deepfake-Diebstahl beim Ingenieurbüro Arup Anfang 2024, bei dem Angreifer KI nutzten, um sich bei einem Videoanruf als mehrere Führungskräfte auszugeben, zeigte, dass kein Unternehmen gegen diese Bedrohung immun ist.

Ähnliche Angriffe zielten auch auf Führungskräfte in verschiedenen Branchen ab, darunter der Versuch, sich als Ferrari-CEO Benedetto Vigna auszugeben, indem KI-geklonte Sprachanrufe verwendet wurden, die seinen süditalienischen Akzent imitierten.

Diese Vorfälle stellen das dar, was Sicherheitsexperten als "CEO-Betrug 2.0" bezeichnen, d. h. Angriffe, die über eine einfache E-Mail-Identität hinausgehen und zu einer multisensorischen Täuschung führen, die selbst erfahrene Führungskräfte täuschen kann.

Plattformsicherheit vs. menschliche Schwachstelle

Salesforce hat schnell betont, dass es sich bei diesen Sicherheitsverletzungen nicht um Schwachstellen in seiner Plattform selbst handelt.

Salesforce bestätigte die UNC6040-Kampagne im März 2025 und warnte davor, dass Angreifer sich als IT-Support ausgaben, um Mitarbeiter dazu zu bringen, Anmeldedaten weiterzugeben oder bösartige verbundene Anwendungen zu genehmigen.

Das Unternehmen betonte, dass diese Vorfälle keine Schwachstellen in seiner Plattform betrafen oder darauf zurückzuführen waren.

Dies zeigt, dass alle SaaS-Anbieter vor einer großen Herausforderung stehen: Sie müssen herausfinden, wie sie Angriffe abwehren können, die auf menschliches Vertrauen und nicht auf technische Schwächen setzen.

Salesforce hat mehrere Abwehrmaßnahmen ergriffen:

- Abhärtung verbundener Anwendungen: Automatisches Deaktivieren nicht installierter verbundener Apps für neue Benutzer

- OAuth Flussbeschränkungen: Deaktivierung von Verbindungen, die über bestimmte Autorisierungsprozesse hergestellt wurden

- Verbessertes Monitoring: Verbesserte Erkennung von verdächtigen Anwendungsautorisierungsmustern

- Aufklärung der Benutzer: Veröffentlichung von Anleitungen zur Erkennung von Social Engineering-Versuchen

Im August 2025 schloss Salesforce alle Integrationen mit Salesloft-Technologien, einschließlich der Drift-App, nachdem festgestellt worden war, dass OAuth-Tokens bei entsprechenden Angriffen gestohlen worden waren.

Sicherheitsexperten warnen nun, dass Teams auf subtile Hinweise achten müssen, wie z. B. seltsame Pausen, Hintergrundgeräusche oder Audiostörungen, die verraten können, ob eine Stimme von einer KI erzeugt wurde.

Die Antwort des Unternehmens: Mehr als technologische Lösungen

Unternehmen erkennen allmählich, dass die Abwehr von Deepfake-Angriffen mehr als nur technologische Lösungen erfordert, sondern auch ein grundlegendes Überdenken der Vertrauens- und Verifizierungsprozesse.

Null-Vertrauens-Kommunikation

RealityCheck von Beyond Identity verleiht jedem Teilnehmer einen sichtbaren, verifizierten Identitätsausweis, der durch kryptografische Geräteauthentifizierung und kontinuierliche Risikoprüfungen gestützt wird und derzeit für Zoom und Microsoft Teams verfügbar ist.

Solche Lösungen stehen für eine Verlagerung hin zu "never trust, always verify"-Modellen für die Unternehmenskommunikation.

Verbesserte Schulungsprogramme

Unternehmen, die die Deepfake-Simulationsplattform von Resemble AI nutzen, berichten von einem Rückgang der erfolgreichen Angriffe um bis zu 90% nach der Implementierung der Plattform, die hyperrealistische Simulationen nutzt, um zu veranschaulichen, wie Deepfake-Angriffe in der realen Welt ablaufen.

Mehrkanalige Verifizierung

Führende Unternehmen führen Protokolle ein, die bei allen risikoreichen Anfragen eine Überprüfung über mehrere Kanäle vorschreiben, unabhängig davon, wie authentisch die ursprüngliche Kommunikation erscheint.

Wenn die Stimme nicht mehr die Wahrheit ist

Die Deepfake-Bedrohung für Salesforce und andere Unternehmenssysteme stellt einen Wendepunkt in der Geschichte der Cybersicherheit dar.

Zum ersten Mal können sich Angreifer nicht nur als Autoritätspersonen ausgeben, sondern sich auch so anhören, so aussehen und sogar geschulte Sicherheitsexperten zu Handlungen überreden, die die Sicherheit eines Unternehmens gefährden.

In einem Zeitalter der KI-generierten Täuschung muss Vertrauen durch Verifizierung verdient werden, nicht durch Vertrautheit vorausgesetzt werden.

Unternehmen, die dies verstehen und in die richtigen Tools, Prozesse und die richtige Kultur investieren, werden in einer zunehmend unsicheren digitalen Welt am besten in der Lage sein, sowohl Sicherheit als auch Vertrauen zu schützen.

In dieser neuen Realität ist die Stimme am anderen Ende der Leitung vielleicht nicht die, die sie zu sein scheint.

Im Zeitalter der Deepfakes ist ständige Wachsamkeit der Preis für Sicherheit.