I juni 2025 modtog en Google-medarbejder, hvad der så ud til at være et rutineopkald fra IT-support.

Stemmen i røret lød professionel, selvsikker og fuldstændig velkendt.

Teknikeren bad medarbejderen om at godkende en ny app i virksomhedens Salesforce-system.

I løbet af få minutter havde angriberne adgang til og stjal 2,55 millioner kundeoplysninger fra Googles CRM-system.

Det, der gjorde det muligt, var brugen af deepfake-lydteknologi med AI-genererede stemmer, der var så overbevisende, at de snød en af de mest pålidelige former for autentificering, nemlig genkendelse af en kollegas stemme.

Denne hændelse, der er knyttet til ShinyHunters-gruppen, viser, hvordan angribere nu bruger kunstig intelligens til at bryde ind i virksomhedssystemer.

Som rygraden i kunderelationsstyringen for millioner af organisationer verden over er Salesforce blevet et af hovedmålene for en ny generation af AI-drevne social engineering-angreb.

Hvorfor Salesforce blev et Deepfake-mål

Salesforces vækst har også gjort det til et stort mål for datatyveri.

Da alt er centraliseret, kan et enkelt brud afsløre millioner af kundeoplysninger fra mange forskellige virksomheder.

Som WithSecures leder af Threat Intelligence Tim West bemærker:

Du skal aldrig bekymre dig om AI-svindel igen. TruthScan Kan hjælpe dig:

- Opdag AI-generering billeder, tekst, stemme og video.

- Undgå at stor AI-drevet svindel.

- Beskyt dine mest følsom virksomhedsaktiver.

"Hackergrupper som Scattered Spider bruger social engineering til at få adgang til SaaS-miljøer. Deres angreb ser måske teknisk enkle ud, men det gør dem ikke mindre farlige."

Ifølge en ny WithSecure-undersøgelse steg den ondsindede aktivitet i Salesforce-miljøer kraftigt i første kvartal af 2025 med en tyvefoldig stigning i antallet af opdagelser sammenlignet med slutningen af 2024.

Hvordan deepfakes gav næring til et Salesforce-brud

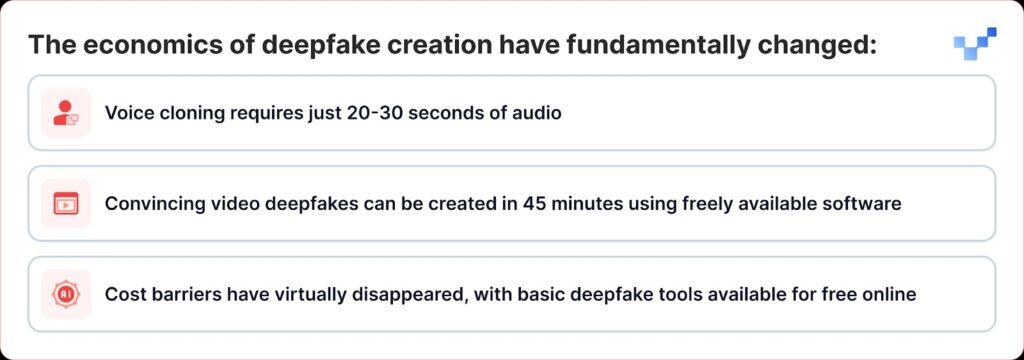

Det, der gør de seneste angreb særligt farlige, er, at deepfake-teknologien er gået fra at være et nicheværktøj til noget, alle kan bruge som våben.

I modsætning til traditionelle databrud, der bryder direkte ind i databaser, bruger cyberkriminelle nu stemmebaseret social engineering eller "vishing". Med fremkomsten af deepfakes og AI-stemmekloning bliver disse angreb meget sværere at spotte.

ShinyHunters-kampagnen mod Salesforce-kunder følger en effektiv drejebog, der kombinerer traditionel social engineering med avanceret AI-bedrag:

Fase 1: Indsamling af stemmeoplysninger

Angriberne begynder med at høste lydprøver fra offentlige kilder, ledelsespræsentationer, konferenceopkald, virksomhedsvideoer eller indlæg på sociale medier.

Med så lidt som 20-30 sekunders klar lyd kan de skabe overbevisende stemmekloner.

Fase 2: Deepfake Vishing-opkaldet

Under et vishing-opkald overbeviser angriberen offeret om at gå til Salesforces opsætningsside for forbundne apps og godkende en falsk version af Data Loader-appen, forklædt med lidt ændret branding.

Dermed lader offeret ubevidst angriberne stjæle følsomme data fra Salesforce.

Raffinementet er bemærkelsesværdigt. I nogle tilfælde brugte angriberne deepfake-lyd til at udgive sig for at være medarbejdere og overtale helpdesk-personalet til at give tilladelse til useriøs adgang.

Dette repræsenterer en betydelig udvikling fra traditionel stemmephishing, hvor angriberne blot udgav sig for at være autoritetspersoner, til AI-forbedret efterligning, hvor de faktisk kan lyde som specifikke personer.

Fase 3: Udnyttelse af OAuth

Når den ondsindede applikation er godkendt, kan angriberne helt omgå multifaktorautentificering.

Når den falske app er godkendt, får angriberne langtidsholdbare OAuth-tokens, som giver dem mulighed for at omgå multifaktorautentificering og operere uden at udløse normale sikkerhedsadvarsler.

Fase 4: Stille dataudtræk

Googles Threat Intelligence Group advarede om, at en trusselsaktør brugte et Python-værktøj til at automatisere datatyveriprocessen for hver organisation, der blev ramt, og forskerne havde kendskab til over 700 potentielt påvirkede organisationer.

Hvorfor vi er sårbare over for AI-stemmer

Succesen med disse angreb udnytter et grundlæggende menneskeligt træk: vores tendens til at stole på, hvad vi hører.

Ifølge en nylig global undersøgelse siger 70 procent af befolkningen, at de ikke er sikre på, at de kan identificere en ægte stemme i forhold til en klonet stemme.

Denne sårbarhed forstærkes i virksomhedsmiljøer, hvor helpdeskmedarbejdere er uddannet til at være hjælpsomme og imødekommende, og fjernarbejde har normaliseret interaktioner, der kun foregår med lyd.

Ifølge CrowdStrikes 2025 Global Threat Report var der en stigning på 442% i voice phishing-angreb (vishing) mellem første og andet halvår af 2024, drevet af AI-genererede phishing- og efterligningstaktikker.

Vækkeuret på $25 millioner kroner

Konsekvenserne af deepfake-forstærkede angreb rækker langt ud over Salesforce.

Deepfake-kuppet på $25 millioner hos ingeniørfirmaet Arup i begyndelsen af 2024, hvor angribere brugte AI til at udgive sig for at være flere ledere under et videoopkald, viste, at ingen organisationer er immune over for denne trussel.

Lignende angreb har også været rettet mod ledere i forskellige brancher, herunder et forsøg på at udgive sig for at være Ferraris CEO Benedetto Vigna ved hjælp af AI-klonede stemmeopkald, der efterlignede hans syditalienske accent.

Disse hændelser repræsenterer det, som sikkerhedseksperter kalder "CEO fraud 2.0", angreb, der går ud over simpel e-mailudgivelse for at skabe multisensoriske bedrag, der kan narre selv erfarne ledere.

Platformssikkerhed vs. menneskelig sårbarhed

Salesforce har været hurtige til at understrege, at disse brud ikke repræsenterer sårbarheder i selve deres platform.

Salesforce anerkendte UNC6040's kampagne i marts 2025 og advarede om, at angribere udgav sig for at være IT-support for at narre medarbejdere til at give legitimationsoplysninger væk eller godkende ondsindede forbundne apps.

Virksomheden understregede, at disse hændelser ikke involverede eller stammede fra nogen sårbarheder i dens platform.

Dette viser en stor udfordring for alle SaaS-udbydere: at finde ud af, hvordan man stopper angreb, der spiller på menneskelig tillid i stedet for tekniske fejl.

Salesforce har implementeret flere defensive foranstaltninger:

- Hærdning af forbundne apps: Automatisk deaktivering af ikke-installerede forbundne apps for nye brugere

- Begrænsning af OAuth-flow: Deaktivering af forbindelser opnået ved hjælp af visse godkendelsesprocesser

- Forbedret overvågning: Forbedret opdagelse af mistænkelige autorisationsmønstre for applikationer

- Uddannelse af brugere: Udgivelse af vejledning i at genkende forsøg på social engineering

I august 2025 lukkede Salesforce ned for alle integrationer med Salesloft-teknologier, herunder Drift-appen, efter at have konstateret, at OAuth-tokens var blevet stjålet i relaterede angreb.

Sikkerhedseksperter advarer nu om, at teams skal lytte efter subtile spor, som mærkelige pauser, baggrundsstøj eller lydfejl, der kan afsløre, hvornår en stemme er genereret af AI.

Virksomhedens svar: Ud over teknologiske løsninger

Organisationer er begyndt at indse, at forsvaret mod deepfake-forstærkede angreb kræver mere end teknologiske løsninger; det kræver en grundlæggende nytænkning af tillids- og verifikationsprocesser.

Kommunikation uden tillid

RealityCheck fra Beyond Identity giver alle deltagere et synligt, verificeret identitetsbadge, der understøttes af kryptografisk enhedsgodkendelse og løbende risikotjek, som i øjeblikket er tilgængeligt for Zoom og Microsoft Teams.

Sådanne løsninger repræsenterer et skift i retning af "never trust, always verify"-modeller for virksomhedskommunikation.

Forbedrede træningsprogrammer

Organisationer, der bruger Resemble AI's deepfake-simuleringsplatform, rapporterer om en reduktion på op til 90% i vellykkede angreb efter implementering af platformen, som bruger hyperrealistiske simuleringer til at illustrere, hvordan deepfake-angreb udfolder sig i den virkelige verden.

Verifikation af flere kanaler

Førende organisationer implementerer protokoller, der kræver verifikation gennem flere kanaler for alle højrisikoanmodninger, uanset hvor autentisk den oprindelige kommunikation ser ud.

Når stemmen ikke længere er sandhed

Deepfake-truslen mod Salesforce og andre virksomhedssystemer repræsenterer et vendepunkt i cybersikkerhedens historie.

For første gang kan angribere ikke bare udgive sig for at være myndighedspersoner; de kan faktisk lyde som dem, se ud som dem og overbevise selv uddannede sikkerhedsfolk om at foretage handlinger, der kompromitterer organisationens sikkerhed.

I en tid med AI-genereret bedrag skal tillid opnås gennem verifikation, ikke antages gennem fortrolighed.

Virksomheder, der forstår dette og investerer i de rigtige værktøjer, processer og kultur, vil være i den bedste position til at beskytte både sikkerhed og tillid i en stadig mere usikker digital verden.

I denne nye virkelighed er stemmen i den anden ende af røret måske ikke den, den giver sig ud for at være.

I en tid med deepfakes er konstant årvågenhed prisen for sikkerhed.