Em junho de 2025, um funcionário do Google recebeu o que parecia ser uma ligação de rotina do suporte de TI.

A voz na linha parecia profissional, confiante e completamente familiar.

O técnico pediu ao funcionário que aprovasse um novo aplicativo no sistema Salesforce da empresa.

Em poucos minutos, os invasores tiveram acesso e roubaram 2,55 milhões de registros de clientes do CRM do Google.

O que tornou isso possível foi o uso da tecnologia de áudio deepfake, com vozes geradas por IA tão convincentes que enganaram uma das formas mais confiáveis de autenticação, o reconhecimento da voz de um colega.

Esse incidente, vinculado ao grupo ShinyHunters, mostra como os invasores estão usando a inteligência artificial para invadir os sistemas das empresas.

Como a espinha dorsal do gerenciamento de relacionamento com o cliente para milhões de organizações em todo o mundo, o Salesforce se tornou um dos principais alvos de uma nova geração de ataques de engenharia social com tecnologia de IA.

Por que a Salesforce se tornou um alvo de Deepfake

O crescimento da Salesforce também a transformou em um grande alvo para o roubo de dados.

Como tudo é centralizado, uma única violação pode expor milhões de registros de clientes de muitas empresas diferentes.

Como observa Tim West, chefe de inteligência contra ameaças da WithSecure:

Nunca mais se preocupe com fraudes de IA. TruthScan Pode lhe ajudar:

- Detectar IA gerada imagens, texto, voz e vídeo.

- Evitar grande fraude impulsionada por IA.

- Proteja seus mais sensível ativos da empresa.

"Grupos de hackers como o Scattered Spider utilizam engenharia social para obter acesso a ambientes SaaS. Seus ataques podem parecer tecnicamente simples, mas isso não os torna menos perigosos."

De acordo com a nova pesquisa da WithSecure, a atividade mal-intencionada dentro dos ambientes do Salesforce aumentou acentuadamente no primeiro trimestre de 2025, com um aumento de vinte vezes nas detecções em comparação com o final de 2024.

Como os Deepfakes alimentaram uma violação da Salesforce

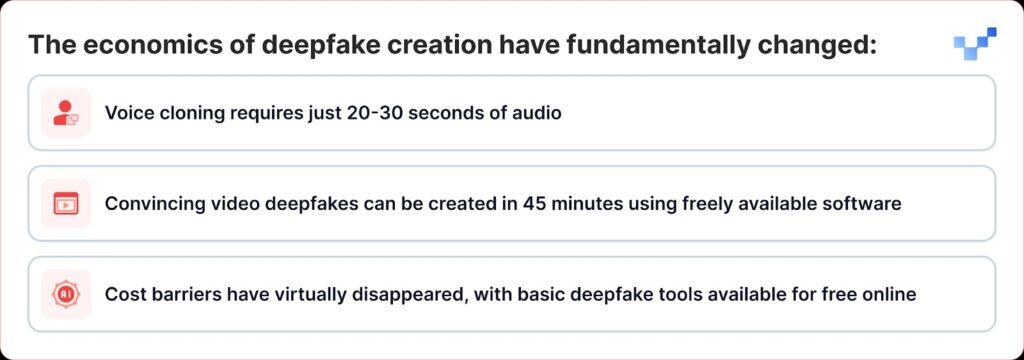

O que torna os ataques recentes especialmente perigosos é o fato de a tecnologia deepfake ter mudado de uma ferramenta de nicho para algo que qualquer pessoa pode usar como arma.

Ao contrário das violações de dados tradicionais que invadem diretamente os bancos de dados, os criminosos cibernéticos agora estão usando engenharia social baseada em voz, ou "vishing". Com o aumento de deepfakes e clonagem de voz por IA, esses ataques estão se tornando muito mais difíceis de detectar.

A campanha da ShinyHunters contra os clientes da Salesforce segue um manual eficaz que combina a engenharia social tradicional com o engano de IA de ponta:

Fase 1: coleta de inteligência de voz

Os invasores começam coletando amostras de áudio de fontes públicas, apresentações de executivos, chamadas em conferência, vídeos da empresa ou publicações em mídias sociais.

Com apenas 20 a 30 segundos de áudio nítido, eles podem criar clones de voz convincentes.

Fase 2: a chamada de vishing do Deepfake

Durante uma chamada de vishing, o invasor convence a vítima a acessar a página de configuração do aplicativo conectado do Salesforce e aprovar uma versão falsa do aplicativo Data Loader, disfarçada com uma marca ligeiramente alterada.

Com isso, a vítima, sem saber, permite que os invasores roubem dados confidenciais do Salesforce.

A sofisticação é notável. Em alguns casos, os invasores usaram áudio deepfake para se fazer passar por funcionários e persuadir a equipe de help desk a autorizar o acesso indevido.

Isso representa uma evolução significativa do phishing de voz tradicional, em que os invasores simplesmente fingiam ser figuras de autoridade, para a personificação aprimorada por IA, em que eles podem realmente soar como indivíduos específicos.

Fase 3: Exploração do OAuth

Quando o aplicativo malicioso é autorizado, os invasores ignoram totalmente a autenticação multifator.

Depois que o aplicativo falso é aprovado, os invasores obtêm tokens OAuth de longa duração, o que lhes permite ignorar a autenticação multifator e operar sem disparar os alertas de segurança normais.

Fase 4: Extração de dados silenciosos

O Grupo de Inteligência contra Ameaças do Google alertou que um agente de ameaças usou uma ferramenta Python para automatizar o processo de roubo de dados para cada organização visada, com pesquisadores cientes de mais de 700 organizações potencialmente afetadas.

Por que somos vulneráveis às vozes da IA

O sucesso desses ataques explora uma característica humana fundamental: nossa tendência de confiar no que ouvimos.

De acordo com um estudo global recente, 70% das pessoas dizem não ter certeza de que podem identificar uma voz real em comparação com uma voz clonada.

Essa vulnerabilidade é agravada em ambientes corporativos em que a equipe de help desk é treinada para ser prestativa e complacente, e o trabalho remoto normalizou as interações somente por áudio.

De acordo com o Relatório de Ameaças Globais de 2025 da CrowdStrike, houve um aumento de 442% nos ataques de phishing de voz (vishing) entre o primeiro e o segundo semestre de 2024, impulsionado por táticas de phishing e personificação geradas por IA.

O alerta de $25 milhões

As implicações dos ataques aprimorados por deepfake vão muito além da Salesforce.

O roubo de $25 milhões de deepfake na empresa de engenharia Arup no início de 2024, em que os invasores usaram IA para se passar por vários executivos em uma chamada de vídeo, demonstrou que nenhuma organização está imune a essa ameaça.

Ataques semelhantes também tiveram como alvo executivos de diferentes setores, incluindo uma tentativa de se passar pelo CEO da Ferrari, Benedetto Vigna, usando chamadas de voz clonadas por IA que imitavam seu sotaque do sul da Itália.

Esses incidentes representam o que os especialistas em segurança chamam de "fraude de CEO 2.0", ataques que vão além da simples personificação de e-mail para criar enganos multissensoriais que podem enganar até mesmo executivos experientes.

Segurança da plataforma vs. vulnerabilidade humana

A Salesforce foi rápida em enfatizar que essas violações não representam vulnerabilidades em sua plataforma em si.

A Salesforce reconheceu a campanha do UNC6040 em março de 2025, alertando que os invasores estavam se passando pelo suporte de TI para enganar os funcionários e fazê-los fornecer credenciais ou aprovar aplicativos conectados maliciosos.

A empresa enfatizou que esses incidentes não envolveram ou se originaram de nenhuma vulnerabilidade em sua plataforma.

Isso mostra um grande desafio para todos os provedores de SaaS: descobrir como impedir ataques que se baseiam na confiança humana em vez de falhas técnicas.

A Salesforce implementou várias medidas defensivas:

- Fortalecimento de aplicativos conectados: Desativação automática de aplicativos conectados não instalados para novos usuários

- Restrições de fluxo OAuth: Desativação de conexões obtidas usando determinados processos de autorização

- Monitoramento aprimorado: Detecção aprimorada de padrões suspeitos de autorização de aplicativos

- Educação do usuário: Publicação de orientações sobre o reconhecimento de tentativas de engenharia social

Em agosto de 2025, a Salesforce fechou todas as integrações com as tecnologias da Salesloft, incluindo o aplicativo Drift, depois de descobrir que os tokens OAuth haviam sido roubados em ataques relacionados.

Os especialistas em segurança agora alertam que as equipes precisam ouvir pistas sutis, como pausas estranhas, ruído de fundo ou falhas de áudio, que podem revelar quando uma voz foi gerada por IA.

A resposta da empresa: Além das soluções tecnológicas

As organizações estão começando a reconhecer que a defesa contra ataques aprimorados por deepfake exige mais do que soluções tecnológicas; exige uma reformulação fundamental dos processos de confiança e verificação.

Comunicação de confiança zero

O RealityCheck da Beyond Identity oferece a cada participante um crachá de identidade visível e verificado, apoiado por autenticação de dispositivo criptográfico e verificações contínuas de risco, atualmente disponível para o Zoom e o Microsoft Teams.

Essas soluções representam uma mudança em direção aos modelos "nunca confie, sempre verifique" para a comunicação empresarial.

Programas de treinamento aprimorados

As organizações que usam a plataforma de simulação de deepfake da Resemble AI relatam uma redução de até 90% nos ataques bem-sucedidos após a implementação da plataforma, que utiliza simulações hiper-realistas para ilustrar como os ataques de deepfake se desenvolvem no mundo real.

Verificação multicanal

As principais organizações estão implementando protocolos que exigem verificação por meio de vários canais para todas as solicitações de alto risco, independentemente da autenticidade da comunicação inicial.

Quando a voz não é mais a verdade

A ameaça de deepfake ao Salesforce e a outros sistemas corporativos representa um ponto de inflexão na história da segurança cibernética.

Pela primeira vez, os invasores não podem apenas se passar por figuras de autoridade; eles podem realmente se parecer com elas e convencer até mesmo profissionais de segurança treinados a tomar medidas que comprometam a segurança organizacional.

Em uma era de enganos gerados por IA, a confiança precisa ser conquistada por meio de verificação, e não presumida por meio da familiaridade.

As empresas que entenderem isso e investirem nas ferramentas, nos processos e na cultura certos estarão na melhor posição para proteger a segurança e a confiança em um mundo digital cada vez mais incerto.

Nessa nova realidade, a voz do outro lado da linha pode não ser quem parece ser.

Na era dos deepfakes, a vigilância constante é o preço da segurança.