Страхове шахрайство вступає в нову еру завдяки штучному інтелекту. Як досвідчені шахрайські угруповання, так і шахраї-одинаки використовують інструменти штучного інтелекту для створення фальшивих заяв, синтетичних ідентифікаційних даних, підроблених доказів і дуже переконливих шахрайських схем з видачею себе за іншу особу. У цьому аналітичному документі розглядаються останні тенденції 2025 року у сфері страхового шахрайства з використанням штучного інтелекту - від згенерованих штучним інтелектом заяв і документів до фальшивих голосових шахрайств - та окреслюються шляхи реагування страховиків на них. Ми представляємо останні дані, реальні кейси та стратегічні ідеї для андеррайтерів, розслідувачів шахрайства, команд кібербезпеки, менеджерів з врегулювання збитків та керівників вищої ланки, які повинні розуміти цей швидкозмінний ландшафт загроз.

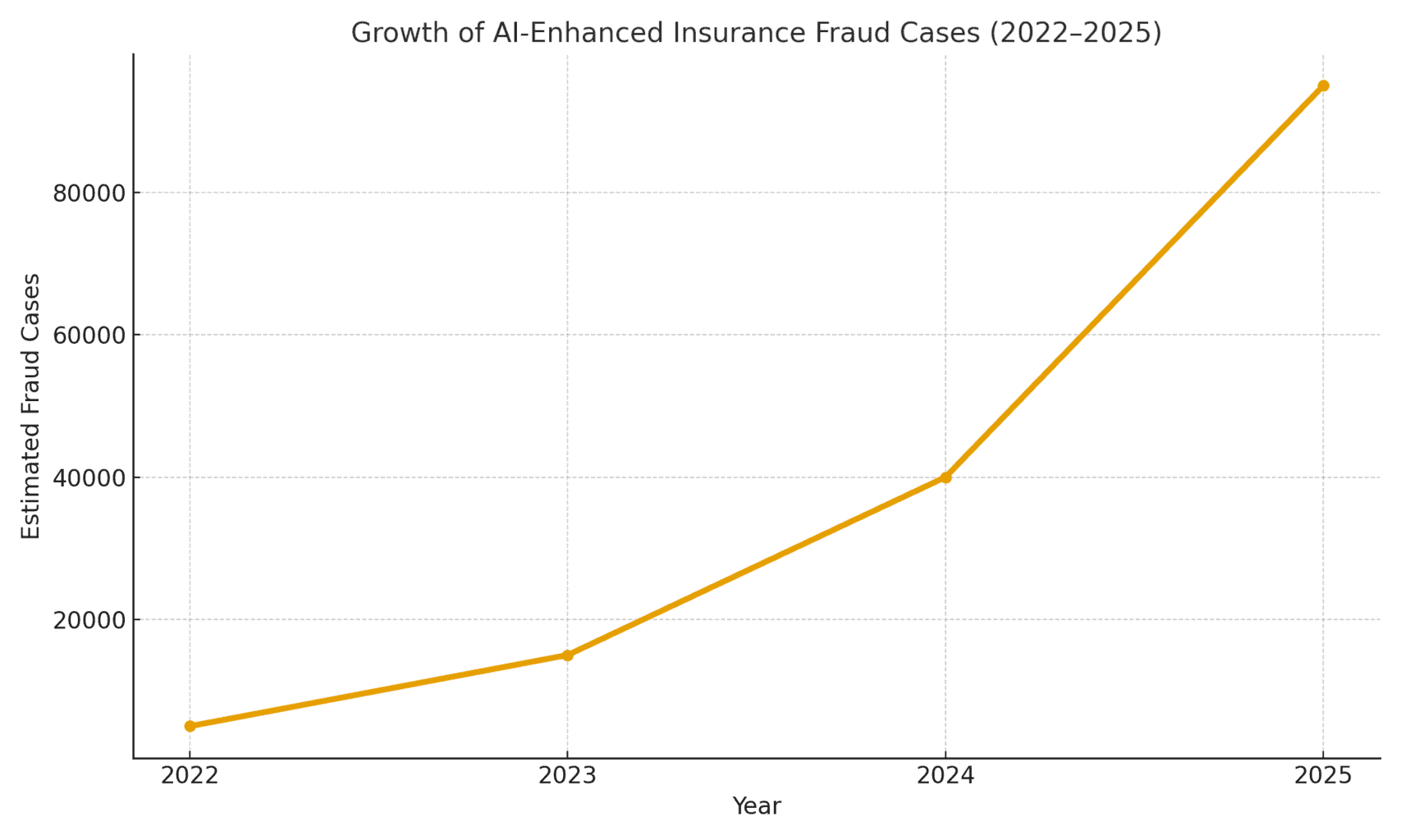

Масштаб загрози: Шахрайство за допомогою штучного інтелекту стрімко зростає. Звіт судово-бухгалтерської експертизи за 2025 рік показав, що На шахрайство, кероване штучним інтелектом, зараз припадає понад половина всіх випадків цифрового фінансового шахрайства[1]. Зокрема, у страхуванні фірма Pindrop, що займається безпекою голосових даних, спостерігала 475% Збільшення кількості атак шахрайства з використанням синтетичного голосу на страхові компанії у 2024 роціщо призвело до зростання загальної кількості спроб страхового шахрайства на 19% у порівнянні з минулим роком[2]. Страховики стикаються з приблизно Вразливість до шахрайства у 20 разів вища, ніж у банківчастково через значну залежність від документів, зображень та голосових підтверджень у заявах[3]. На рисунку 1 нижче показано стрімке зростання кількості випадків страхового шахрайства з використанням штучного інтелекту в період з 2022 по 2025 рік, оскільки численні галузеві звіти свідчать про потрійне або чотиризначне зростання відсотка виявлених випадків шахрайства з використанням штучного інтелекту в порівнянні з попереднім роком.

Рисунок 1: Стрімке зростання кількості випадків страхового шахрайства з використанням штучного інтелекту (індексоване зростання 2022-2025 рр.). Галузеві дані свідчать про експоненціальне зростання кількості контенту, створеного штучним інтелектом, у шахрайських заявах, особливо з 2023 року.[4][2]

Заяви, створені штучним інтелектом, і фейкові докази

Однією з найпоширеніших тенденцій є використання генеративного ШІ для створення повністю сфабриковані страхові випадки. За допомогою сучасних генераторів тексту зі штучним інтелектом шахраї можуть писати реалістичні описи інцидентів, медичні звіти або заяви в поліцію одним натисканням кнопки. Ці описи, написані штучним інтелектом, часто читаються як відшліфовані та правдоподібні, що ускладнює виявлення невідповідностей. Наприклад, шахраї використовують ChatGPT для створення детальних описів аварій або звітів про травми, які звучать професійно і переконливо - завдання, яке колись вимагало значних зусиль і письменницьких навичок.

Більше занепокоєння викликає те, що злочинці тепер поєднують ці фейкові наративи з Підтверджувальні докази, згенеровані штучним інтелектом. Моделі генерації зображень (наприклад, Midjourney або DALL-E) та інструменти редагування можуть створювати фотореалістичні фотографії пошкоджень і травм. Згідно з галузевими звітами, деякі водії почали надання зображень, згенерованих штучним інтелектом, для перебільшення пошкоджень транспортних засобів у страхових випадках[5]. Генеративний ШІ може створити фотографію розбитої машини або затопленого будинку, яких насправді ніколи не існувало. Ці зображення є часто більш реалістичні, ніж ті, яких можна було досягти за допомогою старих технік фотошопу.[6]через що їх важко виявити неозброєним оком. У квітні 2025 року Zurich Insurance відзначила зростання кількості претензій з підроблені рахунки-фактури, сфабриковані кошториси на ремонт та цифрові фотографіївключаючи випадки, коли на зображення врятованих автомобілів штучним інтелектом були нанесені реєстраційні номери транспортних засобів[7][8]. Такі фейкові докази в поєднанні з добре продуманою формою заявки, написаною ШІ, можуть прослизнути повз ручну перевірку.

Яскравий випадок у Великій Британії, коли шахраї взяли фотографія фургона торговця з соцмережі та використання ШІ для додавання тріснутого бампераа потім подає його разом із фальшивим рахунком за ремонт на 1000 фунтів стерлінгів як частину фальшивої заяви про аварію[9]. Шахрайство було розкрито лише тоді, коли слідчі помітили те саме фото фургона (до пошкоджень) на сторінці власника у Facebook[10]. Це ілюструє ширше явище: страховики повідомляють про 300% стрибок у редагуванні "неглибокої підробки" зображень (прості цифрові маніпуляції для додавання пошкоджень або зміни деталей) лише за один рік (2021-2022 проти 2022-2023).[4]. У 2024 році Allianz UK попередила, що цифрові спотворення фотографій і підроблені документи мають "всі ознаки того, що стануть останнім великим шахрайством, яке вразило галузь".[4]. Керівник відділу з боротьби з шахрайством у Цюріху також зауважив, що те, що раніше вимагало інсценування фізичної автомобільної аварії, тепер можна зробити повністю за допомогою комп'ютера - шахраї можуть "створити шахрайську заяву з-за клавіатури і отримати значні суми" за допомогою фальшивих фотографій і звітів про повну втрату[11][12]. Цей зсув не лише збільшує кількість фальшивих заяв, але й знижує вхідний бар'єр для потенційних шахраїв.

Більше ніколи не турбуйтеся про шахрайство зі штучним інтелектом. TruthScan Може допомогти тобі:

- Виявлення згенерованого ШІ зображення, текст, голос і відео.

- Уникайте велике шахрайство, кероване штучним інтелектом.

- Захистіть своє найдорожче чутливий активи підприємства.

За межами автомобілів, майнові та страхові виплати за шкоду, заподіяну здоров'ю спостерігають за роздуванням збитків за допомогою ШІ. З'являються повідомлення про підроблені фотографії для туристичного страхування (наприклад, "пошкодження" багажу або інсценовані сцени крадіжки) і згенеровані штучним інтелектом квитанції на дорогі товари, які ніколи не були придбані. Позови про відшкодування шкоди життю та здоров'ю теж не застраховані - шахраї створили фальшиві медичні рахунки та свідоцтва про смерть за допомогою підроблювачів документів зі штучним інтелектом. Насправді, Цюріх відзначив, що технологія глибокого підроблення використовується для створення повністю фіктивні інженерні оцінки та медичні висновки у пакетах заяв[11]. Ці документи, створені штучним інтелектом, часто з реалістичними логотипами та підписами, неможливо відрізнити від справжніх паперів. Для страховиків життя виникають нові проблеми, пов'язані з тим, що шахрайство з некрологами та свідоцтвами про смертьЗлочинці можуть використовувати ШІ для створення фальшивих некрологів або листів від лікарів, які підтверджують смерть людини, яка насправді все ще жива (або взагалі ніколи не існувала, про що мова піде далі).

Синтетичні страхувальники та ідентичності

Мабуть, найбільш підступним розвитком подій є шахрайство з синтетичними ідентифікаційними даними у страхуванні. Шахрайство з синтетичними ідентифікаційними даними передбачає створення фіктивної особи або організації шляхом поєднання реальних даних (викрадені номери соціального страхування, адреси тощо) зі сфабрикованими деталями (вигадані імена, фальшиві документи, що посвідчують особу). Досягнення в галузі штучного інтелекту дозволили тривіально легко генерувати реалістичні особисті профілі - з фотографіями та посвідченнями особи - для людей, яких не існує[13][14]. Тепер шахраї можуть алгоритмічно створити повністю фальшивого клієнта, придбати поліс на його ім'я, а згодом подати заяву на виплату страхового відшкодування на цю фальшиву особу.

У секторі страхування життя схеми синтетичної ідентичності мають злетіла до небес.. Галузеві дослідження 2025 року оцінюють витрати на шахрайство з синтетичними ідентифікаційними даними понад $30 мільярдів щорічнона які припадає до 80-85% від усіх випадків шахрайства з персональними даними у фінансових послугах[15][16]. Особливо сильно постраждали страховики життя: відомо, що шахраї оформити поліси страхування життя на підставну особу, а потім "вбити" цю особу на папері, щоб отримати страхову виплату в разі смерті[17]. Наприклад, шахрай може створити синтетичного клієнта "Джон Доу", сплачувати внески протягом року, а потім подати заяву з підробленим свідоцтвом про смерть і некрологом про передчасну смерть Джона Доу. Оскільки особистість була ретельно сформована (кредитна історія, публічні записи тощо), заява про смерть може виглядати легітимною - до тих пір, поки не буде знайдено тіло або справжніх родичів. На той час, коли шахрайство виявляється, зловмисники вже давно втекли з виплатою.

Синтетичні схеми ідентичності також страждають медичне страхування та автострахування. Злочинні угруповання створюють "франкенштейнівські" особистості шляхом використання номерів соціального страхування дітей або людей похилого віку (які не мають кредитної історії) у поєднанні зі згенерованими штучним інтелектом іменами та водійськими посвідченнями[15]. Потім вони купують медичні або автополіси на цих підставних осіб, а незабаром після цього подають великі позови. Один з варіантів - створення синдикатів фіктивні підприємства (підставні компанії) - наприклад, фіктивна компанія-перевізник - і придбання для неї комерційної страховки, щоб потім заявити про інсценовані аварії або травми фантомних працівників[18][19]. Оскільки бізнес існує лише на папері (зі згенерованими штучним інтелектом реєстраційними та податковими номерами), це Синтетичне шахрайство "на основі суб'єктів господарювання" часто не виявляється до моменту виплати страхового відшкодування[18][20].

Чому синтетичні ідентичності такі ефективні? По-перше, вони часто проходять через автоматизовані перевірки ідентичності. Кредитні бюро та системи KYC можуть виявити ніяких червоних прапорців тому що ідентифікатор містить деякі реальні, дійсні дані (наприклад, справжній SSN з чистим записом)[21]. Тим часом, фотографії профілю та скани посвідчень особи, створені штучним інтелектом, можуть виглядати абсолютно автентично - сучасний ШІ може створити людське обличчя, яке навіть просунуті системи розпізнавання облич можуть сприйняти як справжнє. Результат: більшість автоматизованих систем визнають ці профілі легітимними і шахрайство виявляється (якщо взагалі виявляється) лише після великих втрат[22].

Реальний вплив: RGA повідомляє, що шахрайство із синтетичними ідентифікаційними даними у страхуванні життя зараз коштує галузі близько $30B на рік і зросла майже на 400% з 2020 року[15][16]. За оцінками Федеральної торгової комісії США, на синтетичні ідентифікатори припадає переважна більшість випадків шахрайства з особистими даними[16]. Ці втрати в кінцевому підсумку б'ють по гаманцях чесних страхувальників - кожна сім'я платить додатково \$700 премій щороку через збільшення навантаження на страховиків через шахрайство.[15]. Страховики реагують на це, посилюючи перевірку під час реєстрації та розгляду заяв: впроваджуючи перевірки баз даних на наявність зв'язку між особами, моніторинг декількох полісів за однією адресою і навіть проводячи тести "на живучість" (селфі-відео перевірки, щоб переконатися, що заявник є реальною людиною, а не просто зображенням штучного інтелекту).[23][24]. Але, як ми побачимо, шахраї протистоять ШІ в іншій сфері: фальшиві голоси та відео.

Фальшиві голоси та відеозаписи

Згенеровані штучним інтелектом аудіо- та відеопідробки додають страховому шахрайству нового тривожного виміру. У 2023 та 2024 роках було зафіксовано кілька випадків, коли злочинці використовували клонування голосу видавати себе за людей по телефону - тактика, яка спочатку використовувалася при пограбуваннях банків (як, наприклад, сумнозвісний фальшивий телефонний дзвінок генерального директора, який вкрав $35 мільйонів доларів у 2020 році), але тепер поширилася і на страхування. Шахраї клонують голоси страхувальників, лікарів або аварійних комісарів і використовують їх у шахрайських схемах із застосуванням соціальної інженерії. Аналіз Піндропа до 2024 року попереджає, що "Глибокі підробки, технологія синтетичного голосу та шахрайство, кероване штучним інтелектом, змінюють ландшафт шахрайства"з фальсифікацією голосу масштабування з безпрецедентною швидкістю[25]. Вони виявили, що страхові колл-центри бомбардували закордонні зловмисники, які використовували голосові підробки: наприклад, надходили дзвінки з викраденим SSN та особистими даними реального страхувальника, і якщо агент відповідав, то голос абонента, клонований штучним інтелектом, може обдурити агента через автентифікацію на основі знань і вимагати шахрайську виплату[26]. У випадку з одним страховиком на західному узбережжі зловмисники неодноразово використовували цей метод, намагаючись заволодіти рахунками та перенаправляти виплати, використовуючи той факт, що перевірка ідентифікатора кол-центру покладалася на голос та особисту інформацію, яку можна підробити.[26].

Імітація голосу також використовувалася на стороні споживачів: Шахраї дзвонили жертвам аварій або вигодонабувачам, в той час як видають себе за представників страхової компаніївикористовуючи голоси штучного інтелекту, які звучать як офіційні, щоб виманити конфіденційну інформацію або навіть платежі. І навпаки, шахрай може видавати себе за клієнта на гарячій лінії, щоб подати претензію по телефону, використовуючи фальшивий голос, який відповідає статі/віку клієнтатаким чином оминаючи голосові та біометричні перевірки. Нещодавня статистика шахрайства є протверезливою: експерти галузі прогнозують, що 162% Зростання кількості підроблених шахрайських атак на страховиків у наступному році[27]і Піндроп записав 475% сплеск синтетичних голосових атак у 2024 році як згадувалося раніше[2]. Ці атаки швидко випереджають більш традиційні вектори кібершахрайства.

Крім телефонних дзвінків, глибокі фейки на основі відео з'являються в процесі врегулювання збитків. Багато страховиків запровадили віртуальні перевірки страхових випадків та відеоконференції (прискорені пандемією) для перевірки збитків або дистанційного опитування заявників. Зараз шахраї використання аватарок зі штучним інтелектом і фейкових відео, щоб обдурити ці перевірки. Були повідомлення про те, що заявники використовували Аватарки зі штучним інтелектом для відеодзвінків у прямому ефірі з пристосуванцями, щоб замаскуватися під когось іншого або приховати ознаки невідповідності[28]. Наприклад, шахрайське угруповання може використовувати глибоку підробку "живе" відео з нібито заявником, який демонструє свої збитки на смартфоніколи насправді людина в кадрі - це синтезована штучним інтелектом композиція або найнятий актор з фільтрами, що змінюють обличчя. Одним із спекулятивних, але правдоподібних сценаріїв є використання глибокої підробки покійний людина: При шахрайстві з ануїтетом або страхуванням життя член сім'ї може використати підроблене відео нещодавно померлої людини під час рутинного дзвінка для підтвердження факту життя, щоб продовжити отримувати виплати.[29]. Хоча ще не було жодного гучного випадку такого роду, страховики готуються до нього. Регулятори також беруть до уваги - у США та Європі тривають дискусії щодо класифікації глибоких підробок як крадіжки особистих даних та оновлення керівних принципів перевірки доказів у страхуванні[30].

Виявити глибоку підробку відео та аудіо дуже складно без технічних інструментів. Люди не навчені розпізнавати тонкі проблеми з синхронізацією губ або акустичні дивацтва. Однак у деяких випадках були тривожні сигнали: наприклад, неприродне миготіння або збої на відео, або фонові звукові артефакти під час дзвінка, які насторожили слідчих. Але в цілому, шахрайство з підробленими страховими полісами все ще перебуває на ранніх стадіяха судове переслідування залишається рідкісним явищем - станом на 2023 рік юридичні визначення були нечіткими, а довести, що відео було згенероване штучним інтелектом, було складно без експертного аналізу.[31]. Це дає шахраям відчуття безкарності. Гонка озброєнь триває: страховики тепер звертаються до криміналістичний ШІ для боротьби зі штучним інтелектомрозгортає алгоритми глибокого виявлення фейків, щоб ретельно перевіряти підозрілі відео кадр за кадром на наявність ознак маніпуляцій.[24]. Постачальники голосової біометрії випускають детектори підроблених голосів, які аналізують спектральні патерни і голосову каденцію на предмет автентичності[32]. Ми обговоримо ці захисні технології в наступному розділі.

Фішинг та шахрайство з використанням штучного інтелекту

Не все шахрайство з використанням штучного інтелекту відбувається через відділ претензій; деякі цілі клієнти та співробітники через соціальну інженерію. Фішингові листи та тексти, створені штучним інтелектом стали головною загрозою у сфері страхування. У цих схемах шахраї використовують чат-боти зі штучним інтелектом та інструменти перекладу для створення переконливих шахрайських повідомлень. Наприклад, злочинці можуть імітувати брендинг і стиль написання страхової компанії для масової фішингової розсилки страхувальникам, повідомляючи їм, що "необхідно вжити термінових заходів, щоб запобігти скасуванню поліса", і перенаправляючи їх на фальшивий веб-сайт. На відміну від незграбних шахрайських листів минулого, ШІ забезпечує бездоганну граматику і навіть персоналізаціющо робить їх більш правдоподібними. Ми бачили, як штучний інтелект використовується для пошуку в соціальних мережах деталей, які вплітаються в фішинг-повідомлення, наприклад, посилання на нещодавню покупку автомобіля в підробленому повідомленні про автострахування.

Інший вектор - це Видавання себе за агентів або керівників за допомогою ШІ. Були випадки, коли шахраї клонували голос власника страхового агентства і залишали клієнтам голосові повідомлення з проханням повідомити банківську інформацію - фактично, це була голосова фішингова атака. Так само внутрішнє шахрайство може бути наслідком імітації ШІ: фінансовий відділ одного страховика ледь не став жертвою, коли шахраї надіслали фальшиве аудіоповідомлення. нібито від генерального директора надання дозволу на переказ коштів (варіант "шахрайства з боку керівника", який зараз покривається деякими полісами страхування від електронних злочинів)[33]). За даними Liberty Specialty Markets, у 2023 році такі шахрайства з використанням штучного інтелекту зросли на 17% у порівнянні з попереднім роком[33]і, як очікується, продовжить зростати.

Споживачі також стають мішенню для шахрайства з використанням синтетичних медіа пов'язані зі страхуванням. Коаліція проти страхового шахрайства відзначає випадки, коли самозванці видають себе за страхових аджастерів, зв'язуються з потерпілими в аваріях, стверджуючи, що вони обробляють їхні заяви, а потім з вимогою негайної оплати або надання конфіденційних даних[23]. Нічого не підозрюючи, клієнти, з полегшенням почувши голос нібито представника, можуть погодитися, особливо якщо абонент знав деталі їхньої аварії (які ШІ міг отримати через хакерські атаки або з відкритих джерел). Поінформованість громадськості про цю тактику є низькою, тому експерти із запобігання шахрайству закликають страховиків інформувати страхувальників про перевірку особи абонентів та електронної пошти[23][34]. Так само, як банки попереджають клієнтів про фішинг, страховики в 2025 році починають включати в свою комунікацію попередження про шахрайство.

Спільною рисою цих схем зі штучним інтелектом є використання легкодоступних наборів "шахрайство як послуга"[35]. У темному інтернеті злочинці можуть купити або підписатися на інструменти, які надають заздалегідь виготовлені фальшиві голоси, шаблони документів, генератори фішингових електронних листів і багато іншого. Така демократизація інструментів ШІ означає, що навіть малокваліфіковані шахраї можуть здійснювати складні шахрайські атаки[35]. Для страхових компаній це означає потік більш переконливих спроб шахрайства, що надходять з усіх боків - претензії, обслуговування клієнтів, електронна пошта, навіть соціальні мережі. Це підкреслює необхідність багатосторонньої стратегії захисту, що поєднує технології, людську пильність і міжгалузеву співпрацю.

Виявлення та захист: Реакція на основі штучного інтелекту

Боротьба з шахрайством, керованим штучним інтелектом, вимагає Захист, керований штучним інтелектом. Страховики все частіше звертаються до передових технологій виявлення та оновлених процесів, щоб протистояти цьому натиску. По суті, страховики повинні впроваджувати контрольні точки автентифікації контенту протягом усього життєвого циклу страхування - від андеррайтингу до врегулювання збитків і взаємодії з клієнтами - для виявлення підробок із застосуванням ШІ. На рисунку 2 представлено розбивку основних видів шахрайства з використанням штучного інтелекту та їхню поширеність, а в наступних розділах детально описано, як виявити та запобігти кожному з них.

Рисунок 2: Види страхового шахрайства з використанням ШІ у 2025 році (оціночна частка за схемами). Фальшиві зображення (підроблені фотографії пошкоджень) і синтетичні ідентичності є одними з найбільших категорій, за ними йдуть підроблені ШІ документи (наприклад, квитанції, сертифікати) і шахрайство з підробленими аудіо- та відеоматеріалами.

1. Інструменти для виявлення вмісту зі штучним інтелектом: Нові служби виявлення ШІ можуть аналізувати текст, зображення, аудіо та відео, щоб визначити, чи були вони згенеровані машиною або підроблені. Наприклад, страховики можуть використовувати такі рішення, як Детектори тексту та зображень зі штучним інтелектом від TruthScan які використовують точний ШІ 99%+ для позначення написаних ШІ документів або підроблених фотографій[36]. Страхова компанія може інтегрувати ці детектори у свою систему заяв: коли подається заява та докази, текстовий опис може бути автоматично відсканований на наявність мовних шаблонів, згенерованих ШІ, а будь-які завантажені зображення можуть бути відскановані на наявність ознак CGI або редагування. Інструменти корпоративного рівня можуть ідентифікувати згенерований ШІ текст у документах, електронних листах і повідомленнях з точністю 99%[36]і аналогічно виявляти зображення, створені штучним інтелектом або піддані маніпуляціям, щоб забезпечити автентичність візуального контенту[36]. Це означає, що фальшивий опис аварії, створений ChatGPT, або сфальсифікована фотографія пошкоджень в дорозі будуть позначені для ручної перевірки до того, як заявка буде оброблена. Страховики у 2025 році все частіше використовуватимуть таку автентифікацію контенту за допомогою штучного інтелекту, 83% фахівців з протидії шахрайству планують впровадити генеративне виявлення ШІ до 2025 рокузгідно з опитуванням ACFE, порівняно з 18%, що використовується сьогодні.[37][38].

2. Верифікація особи та біометричні перевірки: Для боротьби з синтетичними ідентифікаціями страховики також вдосконалюють протоколи KYC за допомогою штучного інтелекту. Сервіси підтвердження особи можуть здійснювати перехресну перевірку даних заявника за кількома базами даних і використовувати розпізнавання обличчя з тестами на реальність. Наприклад, вимога зробити коротке відео-селфі під час реєстрації (і зіставлення обличчя з наданим ідентифікатором) може запобігти використанню багатьох синтетичних ідентифікаторів. Ще більш високотехнологічні компанії, такі як TruthScan, пропонують експертизу зображень, яка може розміщувати згенеровані штучним інтелектом фотографії профілю, аватарки та синтетичні зображення персонажів - їх ШІ-детектор зображень - це навчені розпізнавати обличчя, створені такими генераторами, як StyleGAN або ThisPersonDoesNotExist[39]. Використовуючи такі інструменти, страховик може виявити, чи не є селфі заявника на страхування життя реальною людиною. З боку голосу, голосова біометрична автентифікація для дзвінків у службу підтримки можуть допомогти; сучасні детектори голосового ШІ здатні ідентифікувати синтетичні голоси та спроби клонування голосу в режимі реального часу[40]. Наприклад, TruthScan's Розпізнавання голосу за допомогою штучного інтелекту система використовує акустичний аналіз для розпізнавати голоси, згенеровані штучним інтелектом, і аудіопідробки до того, як вони обдурять співробітників колл-центру[40]. Ці рішення діють як брандмауер - якщо хтось телефонує від імені Джона Доу і його голос не збігається з автентичним голосом Джона Доу (або відповідає відомим характеристикам глибокої підробки), дзвінок може бути позначений або вимагати подальшого підтвердження особи. Багатофакторна автентифікація (підтвердження електронною поштою/СМС, одноразові паролі тощо) додає додаткові перешкоди, які необхідно подолати для імітаторів.

3. Експертиза підроблених відео та зображень: Коли справа доходить до відеодоказів, страховики починають впроваджувати спеціалізований криміналістичний аналіз. Сучасне програмне забезпечення може аналізувати метадані відео, послідовність кадрів і рівень помилок, щоб виявити глибокі підробки. Деякі інструменти досліджують відображення, тіні та фізіологічні ознаки (наприклад, пульс у горлі людини на відео), щоб переконатися, що відео є справжнім. Експертиза метаданих також є цінним: вивчення метаданих файлів і слідів генерації в зображеннях або PDF-файлах може виявити, чи було щось створено інструментом штучного інтелекту.[41]. Страховики повинні вимагати оригінальні фотофайли (які містять метадані), а не просто скріншоти або роздруковані копії, наприклад. Команда Цюріхського банку по боротьбі з шахрайством досягла успіху у виявленні підроблених зображень автомобілів, помітивши аномалії в метаданих зображень і проаналізувавши рівень помилок.[41]. Детектори шахрайства по електронній пошті також може сканувати вхідні повідомлення на наявність ознак фішингового контенту, написаного штучним інтелектом, або відомих шкідливих підписів.[42]. Багато страховиків тепер використовують симуляції фішингу та приклади шахрайства, створені штучним інтелектом, під час навчання співробітників, щоб підвищити їхню обізнаність.

4. Зміни процесів та навчання персоналу: Технології самі по собі не є срібною кулею. Удосконалення процесу Наприклад, частіші випадкові вибіркові особисті перевірки високовартісних страхових випадків або вимога фізичної документації в певних випадках. Деякі страховики відклали повністю автоматизовану наскрізну обробку страхових випадків, повернувшись до розгляду заяв з високими показниками за моделлю ризиків шахрайства зі штучним інтелектом. З людського боку, навчання має вирішальне значення. Слідчі та страхові агенти, які займаються розслідуванням шахрайства, навчаються розпізнавати червоні прапорці ШІ: наприклад, численні заяви з однаковими формулюваннями ("стиль" ChatGPT), зображення, яким бракує справжньої випадковості (наприклад, повторювані патерни в тому, що повинно бути органічним ушкодженням), або голоси, які звучать майже правильно, але мають роботизовану каденцію. Страховики також навчають клієнтів: розсилають попередження про шахрайські схеми і радять, як перевірити особу страхового представника (наприклад, надають відомий номер зворотного дзвінка).

5. Спільні зусилля: Співпраця в масштабах всієї індустрії посилюється. У Великій Британії Бюро страхового шахрайства та Асоціація британських страховиків сформували робочі групи з питань шахрайства зі штучним інтелектом, а урядова Хартія по боротьбі зі страховим шахрайством (2024) сприяє обміну даними та спільним ініціативам[43]. У всьому світі страховики співпрацюють з фірмами, що займаються кібербезпекою, та стартапами у сфері штучного інтелекту. Зокрема, з'являються нові страхові продукти: Liberty Mutual запустив страхування від електронних злочинів для МСП, яке спеціально покриває шахрайство з підробленими документами та шахрайство з боку керівників[44][33]підкреслюючи, що цей ризик є цілком реальним. Це також означає, що страховики можуть виявитися як жертвами, так і запобіжниками шахрайства зі штучним інтелектом, виплачуючи компенсації, якщо шахрайство не буде виявлено, а також пропонуючи покриття для інших, хто постраждав від таких атак.

Інтеграцію технології виявлення в робочі процеси можна уявити як багатоточковий захист у життєвому циклі заяв. Як показано в Малюнок 3страховики можуть додавати етапи перевірки ШІ на застосування політики (для перевірки синтетичних ідентифікаційних даних за допомогою документів, що посвідчують особу, та селфі-перевірок), за адресою подання претензії (для автоматичного аналізу завантажених документів, фотографій або аудіо для генерації ШІ), під час розгляд/розслідування претензій (для проведення глибокої криміналістичної експертизи підозрілих доказів і перевірки будь-яких голосових взаємодій), а також безпосередньо перед виплата (остаточна автентифікація особи, щоб переконатися, що одержувач виплати є законним). Виявляючи шахрайство на ранніх стадіях - в ідеалі, під час прийому на роботу або першого повідомлення про збиток - страховики заощаджують витрати на розслідування та уникають неправомірних виплат.

Рисунок 3: Інтеграція точок виявлення ШІ в життєвий цикл страхування. Під час реєстрації полісу ШІ-перевірка ідентичності перевіряє наявність синтетичних або фальшивих ідентифікаційних даних. Коли подається заява на відшкодування, автоматичні детектори сканують текст заяви, документи та зображення на предмет вмісту, згенерованого штучним інтелектом. Під час розгляду заяви спеціалізовані інструменти глибокого аналізу підробок і голосу перевіряють будь-які аудіо- та відеодокази. Перед виплатою біометрична верифікація підтверджує особу бенефіціара. Такий багаторівневий підхід допомагає перехоплювати шахрайство на кількох етапах.

Страховикам не обов'язково створювати всі ці можливості власними силами - багато хто звертається до корпоративних рішень, таких як TruthScan's AI Detection Suiteякий пропонує ряд інструментів, що можуть бути інтегровані через API в системи страховиків. Наприклад, Послуга TruthScan з розпізнавання зображень на основі штучного інтелекту та виявлення підробок можна використовувати для перевірки автентичності зображень і відео з точністю понад 99%[45]. Їх ШІ-детектор тексту позначає текст, написаний штучним інтелектом, у претензіях або електронних листах[36]в той час як ШІ-детектор голосу забезпечує виявлення клонування голосу та верифікацію диктора, щоб зупинити телефонних шахраїв[40]. Існують навіть нішеві інструменти, такі як Детектор підроблених квитанцій миттєво аналізувати інвойси/чеки на наявність ознак підробки або згенерованих штучним інтелектом шрифтів/макетів[46] - надзвичайно корисний, враховуючи поширеність фальшивих рахунків за ремонт у страхових випадках. Використовуючи комбінацію цих інструментів, страховик може значно підвищити рівень виявлення шахрайства. Один зі страховиків зі списку Fortune 500 повідомив про виявлення 97% спроб глибокого підроблення у 2024 році, використовуючи багаторівневий підхід до перевірки ШІ (текст, зображення, голос) і тим самим уникнувши збитків у розмірі \$20M[47][48].

Висновок

Штучний інтелект трансформує поле битви зі страховим шахрайством у глобальному масштабі. Шахраї впроваджують інновації за допомогою генеративного ШІ, щоб створювати більш переконливі, ніж будь-коли, фальшивки - від повністю сфабрикованих людей і нещасних випадків до пародий, які можуть обдурити навіть досвідчених професіоналів. Дані за 2024-2025 роки свідчать про тривожне зростання кількості таких схем з використанням штучного інтелекту, але вони також підкреслюють, що страховики, які інвестують у виявлення та запобігання шахрайству, можуть бути на крок попереду. Поєднуючи передова технологія виявлення ШІ - як-от криміналістика зображень, автентифікація голосу та аналіз тексту - завдяки оновленим робочим процесам та освіті галузь може зменшити ризики, не жертвуючи при цьому ефективністю, яку приносять цифрові процеси.

По суті, це технологічна гонка озброєнь[49]. Як зазначив один експерт із запобігання шахрайству, "У цій новій реальності пильність - це премія, яку треба платити"[50]. Страхові компанії повинні розвивати культуру пильності та використовувати найкращі доступні інструменти для збереження довіри до процесу врегулювання збитків. Це означає перевірку правдивості документів, голосів і зображень з тією ж ретельністю, з якою андеррайтери оцінюють ризики. Це також означає співпрацю в галузі для обміну інформацією про нові тактики шахрайства зі застосуванням ШІ та спільну розробку стандартів (наприклад, стандартні вимоги до метаданих для поданих медіа або галузеві чорні списки відомих фальшивих ідентифікаторів).

2025 рік - переломний момент: страховики, які проактивно адаптуватися до шахрайства, керованого штучним інтелектом захистять своїх клієнтів і баланси, тоді як ті, хто повільно реагує, можуть стати жертвами шахрайства, що привертає увагу преси. Обнадійливою новиною є те, що технологія протидії шахрайству вже існує і швидко розвивається - той самий штучний інтелект, який допомагає шахраям, може допомогти страховикам. Впроваджуючи такі рішення, як мультимодальний пакет виявлення ШІ TruthScan для заяв і перевірки особи, страховики можуть значно знизити рівень успішності спроб шахрайства з використанням штучного інтелекту.[51][52]. Таким чином вони не лише запобігають втратам, але й надсилають чіткий сигнал потенційним шахраям: якими б розумними не були інструменти, шахрайство буде розкрито.

Таким чином, страхове шахрайство, кероване штучним інтелектом, є серйозним викликом, але на нього можна відповісти настільки ж розумним захистом. Завдяки пильності, крос-функціональній стратегії та правильним технологічним партнерам страхова індустрія може продовжувати дотримуватися фундаментальної обіцянки, що лежить в основі її бізнесу, - виплачувати лише законні страхові відшкодування, і робити це швидко та безпечно у світі, що стає все більш цифровим.

Посилання:

- Асоціація британських страховиків - Асоціація британських страховиків Статистика шахрайства 2023[53][54]

- Allianz & Zurich про сплеск позовів від AI-"дрібних фейків" The Guardian, 2024[4][11]

- Facia.ai - "Страхове шахрайство: Як штучний інтелект переписує правила". Жовтень 2025[55][56]

- Коаліція проти страхового шахрайства Синтетичне шахрайство в страхуванні (Quantexa), Грудень 2024[21][17]

- RGA - "Нова межа боротьби з шахрайством: синтетичні ідентичності". Червень 2025 року[15][16]

- Pindrop - Звіт про голосове шахрайство, через FierceHealthcare, червень 2025[2][3]

- Обертання чисел - "Найкращі схеми фінансового шахрайства 2025". Жовтень 2025[1][57]

- TruthScan - AI Detection Platform (огляд послуг), 2025[51][52]

- TruthScan - Сторінка продукту AI Image Detector, 2025[45][39]

- TruthScan - Сторінка продукту AI Voice Detector, 2025[40]

- TruthScan - Сторінка продукту Детектор фальшивих чеків, 2025[46]

- Спеціалізовані ринки Liberty - Прес-реліз щодо страхування від підробок та кібер-шахрайства, Березень 2025[33]

- Facia.ai - Блог: Страховий захист від шахрайства - гонка озброєнь, 2025[24][32]

- Страховий бізнес у Великобританії - "Зображення, згенеровані штучним інтелектом, використовуються для шахрайства з автомобілями". Квітень 2025[7][58]

- The Guardian - "Підроблені фото пошкоджень автомобіля сигналізують страховикам" Травень 2024[9][12]

[1] [35] [57] Схеми фінансового шахрайства 2025: Загрози та червоні прапорці штучного інтелекту

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Страхове шахрайство зросло на 19% через голосові атаки у 2024 році

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Шахраї редагують фотографії автомобілів, щоб додати фальшиві пошкодження в страховій афері у Великобританії | Страхова галузь | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Зображення, згенеровані штучним інтелектом, тепер використовуються для шахрайства в автострахуванні - звіт | Страховий бізнес Великобританія

[13] [14] [15] [16] Нова межа боротьби з шахрайством: синтетичні ідентичності та гонка озброєнь зі штучним інтелектом | RGA

[17] [18] [19] [20] [21] [22] JIFA: Синтетичне шахрайство: Оскільки синтетичне шахрайство вже присутнє в їх екосистемі, страховики повинні думати як банки - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Страхове шахрайство: Як штучний інтелект переписує правила страхових відшкодувань

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Тиха загроза: Чому страхове шахрайство переходить на телефонну лінію

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] Страхування від електронних злочинів для МСП націлене на шахрайство керівників, глибокі підробки - LSM | Страховий бізнес Великобританія

[36] [42] [51] TruthScan - виявлення та захист контенту за допомогою штучного інтелекту на підприємстві

[37] Дослідження: 8 з 10 борців із шахрайством планують впровадити генеративний ШІ до 2025 року

[38] Висновки зі Звіту про порівняльний аналіз технологій протидії шахрайству за 2024 рік

[39] [45] Детектор зображень зі штучним інтелектом | Виявлення фальшивих та маніпулятивних фотографій - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] АІ-детектор голосу для виявлення підробок і клонування голосу | TruthScan

https://truthscan.com/ai-voice-detector

[46] Детектор підроблених чеків TruthScan | Перевірка автентичності чеків

https://truthscan.com/fake-receipt-detector

[47] Страхова компанія Fortune 500 виявила 97% підробок і зупинила синтетичні ...