Вичерпний посібник з розуміння, виявлення та запобігання голосовому шахрайству з використанням штучного інтелекту на підприємстві

Мільйонний голосовий дзвінок $25, якого ніколи не було

У лютому 2024 року фінансовий працівник багатонаціональної компанії в Гонконзі отримала відеодзвінок від свого фінансового директора.

Голос на іншому кінці дроту був безпомилковим; кожна інтонація, кожна пауза і навіть легкий акцент були миттєво впізнані.

Він терміново попросив її обробити 15 банківських переказів на загальну суму $25 мільйонів, щоб завершити конфіденційне придбання.

Більше ніколи не турбуйтеся про шахрайство зі штучним інтелектом. TruthScan Може допомогти тобі:

- Виявлення згенерованого ШІ зображення, текст, голос і відео.

- Уникайте велике шахрайство, кероване штучним інтелектом.

- Захистіть своє найдорожче чутливий активи підприємства.

Фінансовий директор ніколи не робив цього дзвінка. Він був повністю згенерований штучним інтелектом.

Це не поодинокий випадок. Фінансові установи спостерігають різке зростання кількості фейкових шахрайств.

За останні три роки кількість випадків підскочила на 2137%, і зараз на ШІ припадає 42,5% всіх спроб шахрайства в секторі.

Навіть незважаючи на сплеск голосового шахрайства з використанням ШІ, більше половини керівників компаній визнають, що їхні працівники не навчені виявляти фейкові атаки та реагувати на них; майже 80% компаній не мають формальних протоколів для реагування на такі інциденти.

Як працює клонування голосу зі штучним інтелектом і чому воно становить загрозу

Сучасний ШІ-синтез голосу потребує напрочуд мало даних. Лише кілька секунд аудіо можуть клонувати голос з точністю до 85%.

Процес зводиться до трьох основних етапів:

- Збір даних: Шахраї збирають зразки голосу з відкритих джерел, таких як конференц-дзвінки, інтерв'ю в подкастах, кліпи в соціальних мережах або навіть відеопости в LinkedIn.

- Тренування моделей: ШІ аналізує голосові характеристики, такі як висота, тон, акцент, темп і особливості дихання.

- Покоління: Система створює синтетичну мову, достатньо переконливу, щоб обдурити навіть близьких колег.

Проблема доступності

Що робить цю загрозу ще більш небезпечною, так це її демократизація. Шахраям більше не потрібні ресурси голлівудського рівня.

Все, що потрібно, - це доступне програмне забезпечення для клонування голосу з короткого ролика в соціальних мережах; інструменти з відкритим вихідним кодом і хмарні сервіси штучного інтелекту зробили клонування голосу доступним для будь-кого з базовими технічними навичками.

Чому керівники є головними мішенями для шахраїв

Керівники стикаються з небезпечним поєднанням факторів ризику.

Завдяки їхній публічній присутності в соціальних мережах зразки голосу легко знайти, а їхній авторитет часто спонукає співробітників швидко реагувати на термінові запити.

В середньому кожен четвертий керівник має обмежене розуміння технології глибокого підроблення.

Поточна статистика малює тривожну картину

В одному з них 2024 Опитування Deloitte25,9% керівників заявили, що їхні організації зіткнулися принаймні з одним інцидентом глибокого підроблення фінансових або бухгалтерських даних за останній рік, і половина респондентів вважає, що кількість таких атак зростатиме протягом наступних 12 місяців.

Найбільше занепокоєння викликає те, що лише 52% організацій впевнені, що можуть виявити глибоку підробку свого керівника.

Як розпізнати голосове шахрайство зі штучним інтелектом

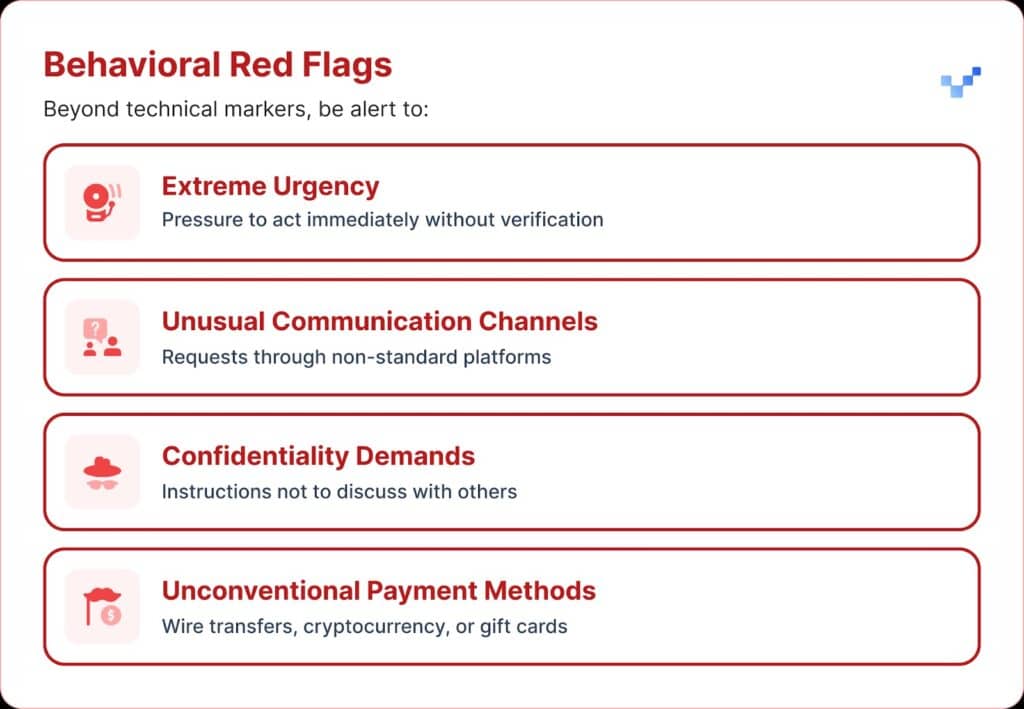

Коли ви отримуєте підозріле голосове повідомлення, є кілька попереджувальних знаків, на які слід звернути увагу.

Голосові шахраї зі штучним інтелектом часто звучать монотонно або пласко. Ви також можете помітити незвичний темп, дивні паузи або неприродний ритм.

Звук також може мати слабке електронне гудіння або відлуння, особливо під час тривалих дзвінків.

І в багатьох випадках голос повторює обмежені фрази, які виглядають як написані за сценарієм або відрепетирувані.

Фінансовий вплив і скільки це насправді коштує

Більшість організацій втратили в середньому близько $450 000, але у секторі фінансових послуг збитки перевищили $603 000.

А в найважчих випадках 1 з 10 організацій повідомила про збитки в розмірі понад 1ТП7Т1 млн.

Ця тенденція швидко зростає. Попереднє дослідження 2022 року показало, що середній фінансовий тягар шахрайства з використанням персональних даних становив близько $230 000, що майже вдвічі менше за нинішній показник.

Прогнозовані майбутні збитки

За даними Центру фінансових послуг Deloitte, втрати від шахрайства зі сторони ШІ в США можуть зрости з 1 трлн 7 трлн 12,3 млрд доларів у 2023 році до 1 трлн 7 трлн 40 млрд доларів до 2027 року. Це приблизно 321% зростання щороку.

Регіональна вразливість

У Північній Америці на 1740% збільшилася кількість випадків шахрайства з використанням глибоких підробок.

Таке значне регіональне зростання свідчить про те, що Північна Америка може бути основною мішенню для шахраїв, які займаються підробками, ймовірно, через її велику цифрову економіку та широке використання онлайн-сервісів.

Стратегічні підходи до захисту виконавчої влади

1. Впровадження протоколів верифікації

Одним із способів посилення захисту є використання системи "безпечних слів" - заздалегідь узгоджених фраз для автентифікації, якими користуються ключові співробітники.

Шахрай, який використовує клонування голосу ШІ, не знатиме правильних відповідей на питання особистої верифікації.

Ще одним запобіжником є багатоканальна перевірка.

Будь-який незвичний фінансовий запит слід підтверджувати через окремий канал зв'язку, ніколи не покладаючись лише на початковий спосіб контакту.

Компанії також повинні встановити чіткі правила ескалації, з періодами очікування та етапами затвердження для великих фінансових операцій, незалежно від того, хто їх запитує.

2. Пам'ятайте про цифрову експозицію

Ще один рівень захисту полягає в обмеженні кількості аудіо- та відеоматеріалів керівників, доступних в Інтернеті. Чим більше зразків можуть зібрати шахраї, тим переконливішими стають їхні клони.

Це також допомагає встановити чіткі правила для керівників у соціальних мережах, особливо щодо розміщення відео з чистим звуком.

А коли йдеться про конференції, організаціям слід пам'ятати про записані розмови чи інтерв'ю, які містять довгі відрізки голосових зразків.

3. Впроваджуйте технічні рішення

Саме тут передові технології виявлення ШІ стають критично важливими.

Організаціям потрібна голосова автентифікація корпоративного рівня та глибоке виявлення підробок можливості, які надають:

- Аналіз у реальному часі: Виявляйте синтетичні голоси під час спілкування в реальному часі

- Історична перевірка: Аналізуйте записані дзвінки та повідомлення на автентичність

- Інтеграційні можливості: Безперешкодна робота з існуючими комунікаційними платформами

- Високі показники точності: Мінімізуйте кількість хибних спрацьовувань під час виявлення складних підробок

4. Комплексні навчальні програми

Команди керівників потребують цілеспрямованого навчання щодо голосових загроз ШІ та процедур перевірки.

Не менш важливим є підвищення обізнаності працівників.

Кожен, незалежно від ролі, має бути здатним виявляти потенційні глибокі фейки та запобігати проникненню кіберзагроз в організацію.

Регулярні симуляційні вправи можуть посилити цю готовність, використовуючи імітацію спроб голосового шахрайства для тестування та вдосконалення процедур реагування.

Передові рішення для розпізнавання голосу зі штучним інтелектом

Традиційні засоби захисту були створені для мережевих загроз, а не для імітації людини за допомогою штучного інтелекту.

Основні причини, через які стандартні засоби кібербезпеки не можуть протидіяти голосовій соціальній інженерії:

- Немає сигнатур шкідливих програм: Голосові виклики не спрацьовують на традиційні системи безпеки

- Людський фактор довіри: Люди природно довіряють тому, що чують, особливо знайомим голосам

- Прогалини в технологіях виявлення: Незважаючи на збільшення кількості спроб шахрайства за допомогою штучного інтелекту, включаючи глибокі підробки, лише 22% фінансових установ впровадили інструменти для запобігання шахрайству на основі штучного інтелекту.

Потреба в спеціалізованому розпізнаванні голосу

Сучасне голосове шахрайство вимагає сучасних засобів виявлення.

Корпоративний рівень Системи розпізнавання голосу зі штучним інтелектом Можеш:

- Аналіз вокальних біомаркерів: Виявляйте тонкі невідповідності в синтетичному мовленні

- Обробка в реальному часі: Негайно сповіщайте про підозрілі дзвінки

- Безперервне навчання: Адаптуйтеся до нових технологій синтезу голосу

- Інтеграція готова: Робота з існуючою комунікаційною інфраструктурою

Організаціям, які серйозно ставляться до захисту від голосового шахрайства, необхідно інвестувати в спеціально створену технологію виявлення ШІ, яка може відповідати складності загроз, з якими вони стикаються.

Голосове шахрайство вже тут, і воно зростає

У першому кварталі 2025 року фейкове шахрайство та крадіжка персональних даних спричинили понад 1 трлн. 7 трлн. 200 млн. збитків.

Голосовий фішинг з використанням ШІ-клонів підскочив на 442%, і понад 400 компаній щодня потерпають від шахрайства з підробленими генеральними або фінансовими директорами.

Хоча 56% компаній стверджують, що відчувають себе дуже впевнено у виявленні глибоких підробок, лише 6% насправді уникли фінансових втрат від них.

Важливо не те, чи стане ваша організація мішенню, а те, чи готові ви до цього.

Голосове шахрайство змінює обличчя кібербезпеки. Традиційні засоби захисту не можуть впоратися з імітацією за допомогою штучного інтелекту.

Щоб залишатися захищеними, організаціям потрібні кращі інструменти виявлення, ефективні навчальні програми та чіткі процедури перевірки.

Технології для боротьби з шахраями вже існують. Питання лише в тому, чи скористаєтесь ви нею до першого інциденту з голосовим шахрайством, чи після.