Вступ: Нова ера атак, керованих штучним інтелектом

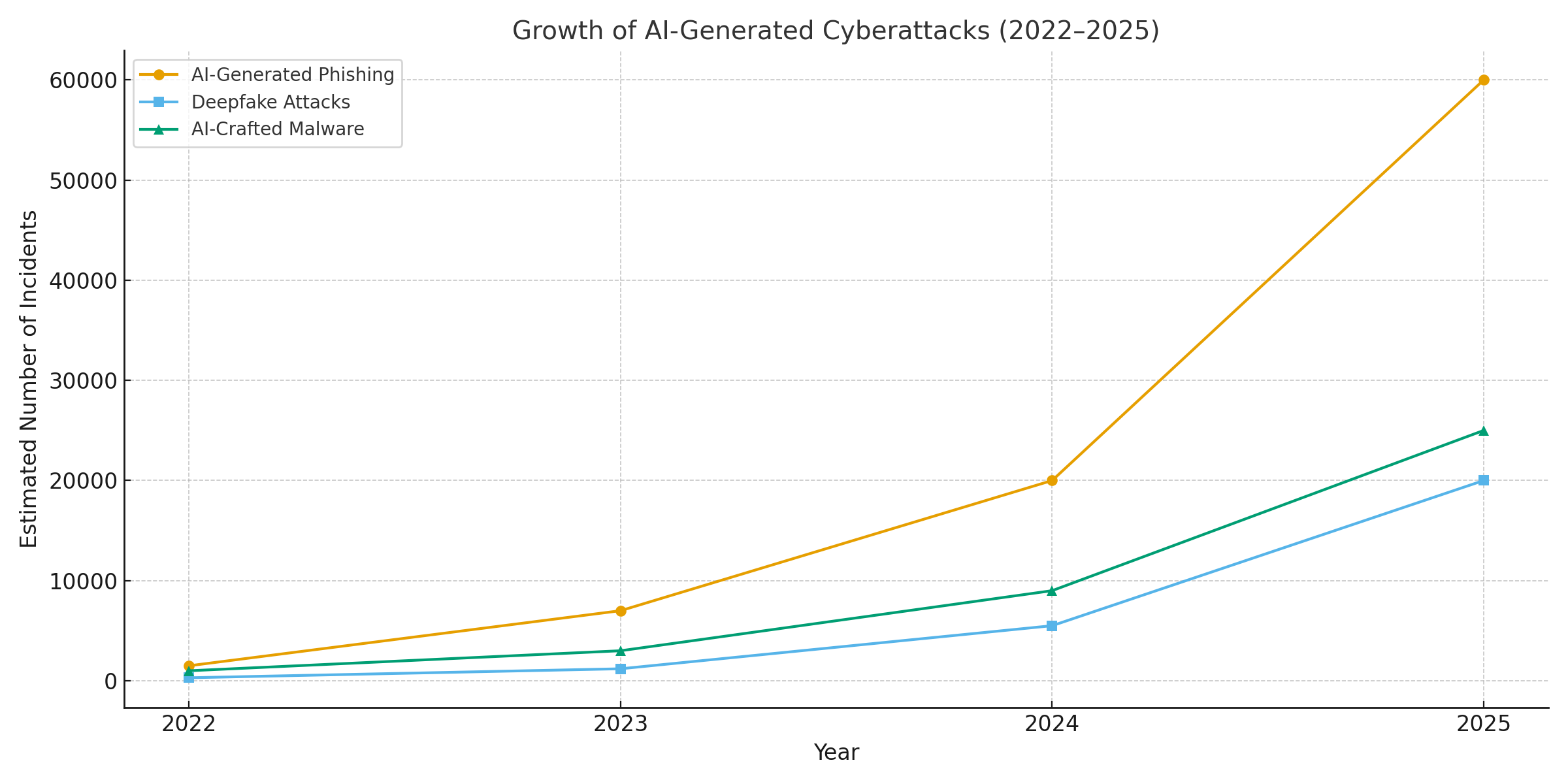

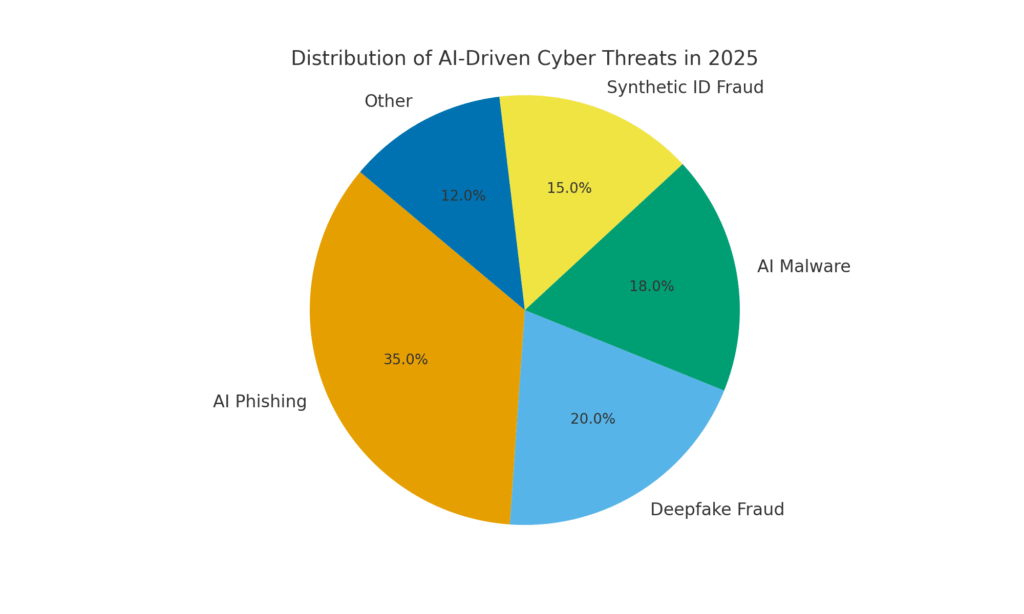

2025 рік став переломним для кібербезпеки. Генеративний ШІ прискорив кібератаки, дозволивши зловмисникам запускати більше часті, реалістичні та масштабовані кампаній, ніж будь-коли раніше. Фактично, за минулий рік, за оцінками, близько 16% зареєстрованих кіберінцидентів пов'язані з використанням зловмисниками інструментів штучного інтелекту (наприклад, моделі генерації зображень і мови) для посилення соціальної інженерії[1]. Від надзвичайно переконливих фішингових листів до підроблених аудіо- та відеофайлів - зловмисники використовують ШІ на озброєнні в усіх секторах. Більшість фахівців з безпеки зараз пов'язують Сплеск кібератак на генеративний ШІщо дає зловмисникам швидші та розумніші способи експлуатувати жертв[2]. Генеративний ШІ ефективно знижує планку навичок для кіберзлочинності, одночасно підвищуючи її ефективність.

Чому це викликає занепокоєння? ШІ може миттєво створювати відшліфований, контекстно-залежний контент, який обдурює навіть підготовлених користувачів. Він може імітувати голоси та обличчя з точністю, що лякає, і навіть генерувати шкідливий код, який видозмінюється, щоб уникнути виявлення. Як наслідок, кібератаки стало важче виявляти і легше здійснювати. Про це свідчать результати дослідження Всесвітній економічний форум попереджає, що 72% організацій зіткнулися з підвищеними кібер-ризиками - особливо соціальною інженерією та шахрайством - через зростаючі можливості генеративного ШІ.[3]. Реальні інциденти підтверджують це: На початку 2024 року злочинці використовували згенеровану штучним інтелектом фальшивий відеодзвінок видати себе за фінансового директора компанії та обманом змусити працівника перейти на іншу роботу $25.6 млн шахраям[4]. А в іншому випадку північнокорейські хакери використовували Згенеровані ШІ фальшиві документи, що посвідчують особу для обходу перевірок безпеки в захисній фішинговій кампанії[5]. Ці приклади підкреслюють ставки - генеративний ШІ розширює можливості шахраїв, які обходять як людський, так і технічний контроль.

Однак ШІ також є частиною рішення. Просунуті інструменти виявлення (наприклад, TruthScan) використовують ШІ проти ШІ - аналіз контенту на наявність тонких ознак машинного генерування. У цьому документі ми розглянемо головні кіберзагрози 2025 року, пов'язані зі штучним інтелектом, і те, як організації можуть пом'якшити їхні наслідки. За матеріалами Фішинг, що генерується штучним інтелектом до глибоке шахрайство з боку генерального директора, Шкідливе програмне забезпечення, створене штучним інтелектом, синтетичні ідентичностіта багато іншого, ми дослідимо, як генеративний ШІ змінює форму атак. Ми також обговоримо конкретні заходи захисту, зокрема Виявлення вмісту зі штучним інтелектомтехнології глибокої криміналістики підробок та перевірки особистих даних, які можуть допомогти командам безпеки відновити свою перевагу. Мета полягає в тому, щоб висвітлити, як підприємства, MSSP, CISO і фахівці з розслідування шахрайства можуть інтегрувати інструменти виявлення ШІ у свій стек кібербезпеки щоб протистояти цій хвилі загроз, керованих штучним інтелектом.

Більше ніколи не турбуйтеся про шахрайство зі штучним інтелектом. TruthScan Може допомогти тобі:

- Виявлення згенерованого ШІ зображення, текст, голос і відео.

- Уникайте велике шахрайство, кероване штучним інтелектом.

- Захистіть своє найдорожче чутливий активи підприємства.

Фішинг та BEC на основі штучного інтелекту: шахрайство в безпрецедентних масштабах

Одним з найяскравіших впливів генеративного ШІ є боротьба з фішингом та компрометація ділової електронної пошти (BEC) схеми. Мовні моделі зі штучним інтелектом за лічені секунди можуть створювати вільні, контекстуально адаптовані електронні листи, усуваючи кричущі граматичні помилки та незграбні фрази, які колись видавали фішинг-атаку. Результат - потік дуже переконливих шахрайських листів і текстів. До квітня 2025 року, більше половини спаму (51%) було створено штучним інтелектом (ШІ)порівняно з практично нульовим показником за два роки до цього[6]. Ще більш тривожним є те, що дослідники виявили, що близько 14% листів з атаками на БЕК були згенеровані штучним інтелектом до 2025 року[7] - Очікується, що ця цифра зростатиме, оскільки злочинці використовують такі інструменти, як ChatGPT. За оцінками деяких досліджень понад 80% фішингових листів тепер можуть створюватися за допомогою штучного інтелекту[8].

Кількість цих штучно створених приманок стрімко зросла. Аналіз безпеки показує, що фішингові атаки, пов'язані з генеративним ШІ, зросли на 1,265% за короткий проміжок часу[9]. За один період кількість повідомлень про фішингові інциденти різко зросла 466% за один кварталзначною мірою через автоматизовані фішингові набори та ботів, які розсилають кастомізовані приманки[9][10]. Чому такий стрибок? Тому що ШІ дозволяє зловмисникам масштаб їхню діяльність. Один злочинець може використовувати чат-бот зі штучним інтелектом, щоб генерувати тисячі персоналізованих шахрайських електронних листів, націлених на різних співробітників або клієнтів, і все це за час, який раніше витрачався на створення одного. Ця масова автоматизація змусила ФБР попередити, що втрати BEC (які вже становили $2,7 мільярда доларів у 2022 році) будуть тільки прискорюватися, оскільки ШІ "загрожує збільшити ці втрати ще більше"[11][12].

Мало того, що фішингових листів стало більше, вони також ефективніше. Жертви обманюються частіше завдяки відшліфованій мові та контекстуальним деталям, які може врахувати штучний інтелект. У лабораторних тестах фішингові листи, написані штучним інтелектом, досягали 54% Коефіцієнт кліків - набагато вище ~12% для традиційних спроб фішингу[13]. Ці повідомлення читаються як справжній стиль CEO або посилаються на реальні події компанії, що послаблює пильність одержувачів. Зловмисники навіть використовують штучний інтелект для A/B-тестування різних фраз і повторюють найуспішніші гачки[14]. І на відміну від людей, ШІ не робить помилок і не втомлюється - він може видавати нескінченну кількість варіантів, поки один з них не прослизне повз фільтри і не обдурить когось.

Приклад: У середині 2025 року в Україні з'явиться Reuters розслідування показало, як шахраї з Південно-Східної Азії використовували ChatGPT для автоматизації шахрайських комунікацій[15]. Вони масово створювали переконливі банківські електронні листи та тексти для обслуговування клієнтів, значно збільшуючи охоплення своїх схем. Європейська поліція також повідомила, що фішингові набори на основі ШІ продаються в темному інтернеті за ціною менше $20, що дозволяє малокваліфікованим акторам запускати складні кампанії.[16][17]. Бар'єр для входу для БЕК та фішингу практично зник.

Захисні заходи - Зупинка фішингових атак зі штучним інтелектом: Зважаючи на цю атаку, організації повинні зміцнити свої канали електронної пошти та обміну повідомленнями. Саме тут Виявлення вмісту зі штучним інтелектом може допомогти. Такі інструменти, як ШІ-детектор тексту від TruthScan та спеціалізовані сканери електронної пошти може аналізувати вхідні повідомлення на наявність статистичних маркерів ШІ-генерованого тексту. Наприклад, у програмі TruthScan - детектор електронного шахрайства використовує аналіз природної мови для позначення листів, які, ймовірно, походять від штучного інтелекту, навіть якщо вони виглядають легітимно[18]. Ці детектори досліджують такі речі, як ідеально відшліфована граматика, складність речень і стилістичні патерни, незвичні для письменників-людей. За допомогою сканування в реальному часіПідозрілі електронні листи можна помістити в карантин або позначити для перевірки, перш ніж вони потраплять до користувачів. Команди корпоративної безпеки починають розгортати такі фільтри зі штучним інтелектом на поштових шлюзах і платформах обміну повідомленнями. На практиці це додає новий рівень захисту на додаток до традиційних спам-фільтрів, який чітко налаштований на виявлення контенту, написаного штучним інтелектом. Починаючи з 2025 року, провідні підприємства інтегрують такі рішення, як TruthScan через API, у свої захищені шлюзи електронної пошти та хмарні пакети для спільної роботи, створюючи автоматизовану контрольну точку для Фішинг, що генерується штучним інтелектом зміст.

Глибока фальсифікація голосу та відео: Шахрайство за принципом "окозамилювання"

Можливо, найбільш вісцеральною загрозою, пов'язаною зі штучним інтелектом, у 2025 році буде зростання фальшиві голосові та відео-атаки. Використовуючи моделі штучного інтелекту, злочинці можуть клонувати голос людини за кількома секундами аудіозапису або створювати реалістичне відео з обличчям людини за кількома фотографіями. Ці глибокі підробки використовуються для шахрайства з видаванням себе за інших людей - від шахрайства з генеральними директорами ("фальшиві дзвінки генерального директора") до фальшивих відеоконференцій тощо. Нещодавній галузевий звіт показав 47% організацій зазнали глибоких фейкових атак щось на кшталт[19]. І це не просто теорія: численні крадіжки у 2023-2025 роках довели, що глибокі фейки можуть перемогти найкращий спосіб перевірки автентичності - наші власні очі та вуха.

Один із сумнозвісних випадків стосувався міжнародного банківського переказу $25 мільйонів після того, як співробітник був обманутий підробленою відеоконференцією. Зловмисники використовували штучний інтелект, щоб синтезувати подобу фінансового директора компанії під час дзвінка в Zoom, з її голосом і манерами, і доручили співробітнику перевести кошти[4][20]. В іншому випадку в Австралії місцева влада втратили $2.3 мільйона коли шахраї підробляли голос і відео міських чиновників, щоб схвалити шахрайські платежі[21]. І що особливо тривожно, злочинці використовують голоси, клоновані штучним інтелектом, у "шахрайстві з бабусями та дідусями" - дзвонять літнім людям і видають себе за їхніх родичів, які потрапили в біду. Про це йдеться у дослідженні ФБР і FinCEN наприкінці 2024 року випустили попередження про сплеск шахрайства з використанням "Глибоко фейкові" медіа, створені штучним інтелектомвключаючи фальшивих агентів з обслуговування клієнтів та синтетичні ідентифікаційні дані для обходу перевірок KYC[22].

Частота злочинів на основі глибоких фейків стрімко зростає. Станом на кінець 2024 року один з аналізів показав кожні п'ять хвилин відбувалося нове шахрайство з глибоким підробленням в середньому[23]. Лише в першому кварталі 2025 року кількість повідомлень про інциденти з глибокими фейками підскочила на 19% порівняно з всі 2024 року[24][25]. Наразі на частку "глибоких фейків" припадає приблизно 6.5% всіх шахрайських атак, a 2,137% збільшення з 2022 року[26][27]. Необхідна технологія стала легкодоступною - часто для цього потрібно лише 30 секунд аудіо для клонування голосу або менше години зразків відеозаписів, щоб переконливо змоделювати обличчя людини[20]. Коротше кажучи, ніколи ще не було так просто "підробити" особистість довіреної особи і обманом змушують жертв передавати гроші або інформацію.

Оборонні заходи - аутентифікація реальності: Щоб протистояти глибоким фейковим загрозам, організації звертаються до передових виявлення синтетичних носіїв інструменти. Наприклад, Детектор голосу зі штучним інтелектом TruthScan і Детектор підробок TruthScan використовувати ШІ для аналізу аудіо- та відеоматеріалів на предмет маніпуляцій. Ці системи виконують покадровий аналіз і аналіз форми сигналу, щоб виявити такі артефакти, як неприродні рухи обличчя, проблеми з синхронізацією губ або спектральні нерівномірності звуку, які видають ШІ-генерований кліп. У тестах алгоритми TruthScan показали такі результати 99%+ точність ідентифікації голосів, згенерованих штучним інтелектом і виявляв маніпуляції з відеокадрами в режимі реального часу[28][29]. Насправді, дослідники з Genians Security Center нещодавно використовували криміналістику зображень TruthScan для аналізу підробленої ідентифікаційної картки, яку використовували північнокорейські хакери - детектор підроблених зображень TruthScan позначив документ як неавтентичний з 98% впевненістьзапобігаючи спробі фішингу зі списом[5][30].

Для практичного захисту підприємства розгортають ці засоби виявлення в ключових точках. Верифікація голосу додається до робочих процесів кол-центрів - наприклад, коли "клієнт" просить про великий переказ по телефону, аудіо можна пропустити через детектор підробки голосу, щоб переконатися, що це дійсно він (а не імітатор ШІ). Аналогічно, платформи для відеоконференцій може інтегрувати сканування відеопотоків учасників у режимі реального часу, щоб виявити будь-які синтетичні обличчя. Наприклад, пакет TruthScan для виявлення підробок пропонує аналіз відеодзвінків у реальному часі та автентифікація обличчя які можуть підключатися до Zoom або WebEx через API[31][29]. Це означає, що якщо хтось намагається приєднатися до наради, використовуючи створене штучним інтелектом відео з вашим генеральним директором, система може позначити "можливу глибоку підробку" ще до того, як буде завдано шкоди. Крім того, важливі транзакції тепер часто включають етап перевірки (позасмугової або багатофакторної), який може використовувати автентифікацію контенту - наприклад, вимагати короткого усного підтвердження, яке потім перевіряється голосовим детектором ШІ на справжність. Використовуючи ці інструменти, компанії створюють мережу безпеки: навіть якщо співробітники Дивіться. або чути щось правдоподібне, прихована експертиза ШІ поставить під сумнів його реальність. У пронизаному ШІ ландшафті загроз "Не довіряй - перевіряй" стає мантрою для будь-якого голосового чи відеозв'язку, що стосується грошей або конфіденційного доступу.

Шкідливе програмне забезпечення зі штучним інтелектом та заплутаний код: Еволюція загроз у коді

Вплив штучного інтелекту не обмежується соціальною інженерією - він також змінює правила гри в розробці шкідливого програмного забезпечення та коду для ухилення від атак. У 2025 році група розвідки загроз Google виявила перші штами шкідливого програмного забезпечення з використанням ШІ під час страти, щоб змінити їхню поведінку[32][33]. Один з прикладів, який отримав назву PROMPTFLUXбув шкідливим скриптом, який фактично звертався до API штучного інтелекту (модель Gemini від Google), щоб переписувати власний код на льотустворюючи нові завуальовані варіанти для уникнення антивірусного виявлення[34][35]. Ця еволюція ШІ "точно вчасно" знаменує собою стрибок до автономного, поліморфного шкідливого програмного забезпечення. Ще один зразок, ПРОМЫШЛЕННОСТЬвикористовував помічника з кодування ШІ для генерації однорядкових команд Windows для крадіжки даних, по суті, передаючи частину своєї логіки на аутсорсинг двигуну ШІ в режимі реального часу.[36][37]. Ці інновації вказують на майбутнє, в якому шкідливе програмне забезпечення може безперервно видозмінюватися - подібно до того, як це робить людина-рукописний тестувальник - для того, щоб обійти захист.

Навіть без ШІ на льоту зловмисники використовують його під час розробки для створення більш потужного шкідливого коду. Генеративний ШІ може створювати шкідливе програмне забезпечення, яке сильно затуманенийщо містить шари заплутаної логіки, які перешкоджають зворотному інжинірингу. Згідно зі звітами розвідки загроз, понад 70% великих порушень у 2025 році були пов'язані з тією чи іншою формою поліморфного шкідливого програмного забезпечення який змінює свій підпис або поведінку, щоб уникнути виявлення[38]. Крім того, 76% фішингових кампаній тепер використовують поліморфні тактики, такі як динамічні URL-адреси або корисне навантаження, переписане штучним інтелектом[38]. Інструменти на кшталт темних інтернет-пропозицій WormGPT і ШахрайствоGPT (необмежені клони ChatGPT) дозволяють навіть неспеціалістам генерувати шкідливі програми-дропери, клавіатурні шпигуни або програми-вимагачі, просто описавши те, що вони хочуть[39]. Результатом є велика кількість нових варіантів шкідливого програмного забезпечення. Наприклад, у 2024 році викрадач інформації під назвою BlackMamba з'ясувалося, що це було повністю згенерований штучним інтелектомвикористовуючи ChatGPT для написання коду сегментами - при кожному виконанні створювався дещо інший двійковий файл, що збивало з пантелику традиційні антивіруси, засновані на сигнатурах[38]. Дослідники безпеки також продемонстрували згенеровані ШІ поліморфні докази концепцій, які можуть обійти багато засобів захисту кінцевих точок[40].

Крім того, зловмисники використовують ШІ для точного налаштування своїх доставка шкідливого програмного забезпечення. ШІ може розумно створювати фішингові електронні листи (як ми вже обговорювали), які містять посилання на шкідливе програмне забезпечення. Він також може допомогти в розробці експлойтів - наприклад, використовувати ШІ для пошуку нових вразливостей або оптимізації командного коду. Як повідомляється, національні держави використовують передові моделі ШІ, щоб допомогти у виявленні експлойтів нульового дня і розробці спеціального шкідливого програмного забезпечення для цілей[41]. Усі ці тенденції означають, що шкідливе програмне забезпечення у 2025 році буде більш прихованим та адаптивним. Воно часто "Спільно створені" зі штучним інтелектомщо ускладнює його виявлення за допомогою звичайних правил.

Захисні заходи - ШІ проти ШІ в захисті від шкідливого програмного забезпечення: Захист від шкідливих програм, створених штучним інтелектом, вимагає поєднання розширеного виявлення та аналізу з використанням штучного інтелекту на стороні захисту. Багато організацій розширюють свої захист кінцевих точок і EDR (Endpoint Detection & Response) з AI/ML моделями, які шукають поведінкові патерни коду, згенерованого штучним інтелектом. Наприклад, раптові трансформації коду на хості або незвичні шаблони викликів API можуть вказувати на те, що PROMPTFLUX регенерує сам себе. Аналогічно, моніторинг мережі може виявити такі аномалії, як звернення шкідливого програмного забезпечення до сервісів ШІ (що не є "нормальним" для користувацьких додатків). Постачальники навчають детектори на основі ML на сім'ї шкідливого програмного забезпечення з підтримкою ШІ, виявлених до цього часу, покращуючи розпізнавання цих нових загроз.

Одне з рішень, що з'являється, полягає в наступному інтегроване сканування контенту зі штучним інтелектом у конвеєри розробника та збірки. Це означає використання детекторів на основі ШІ для аналізу скриптів, збірок програмного забезпечення або навіть змін конфігурації на наявність шкідливого контенту або контенту, створеного ШІ. Наприклад, Детектор правди в реальному часі TruthScan можна використовувати не лише для аналізу тексту - його мультимодальний аналіз може виявити підозрілий код або конфігураційні файли, розпізнаючи, чи були вони згенеровані машинним способом із застосуванням шаблонів обфускації.[42][43]. Команди розробників і MSSP починають сканувати скрипти інфраструктури як коду, журнали PowerShell та інші артефакти на наявність ознак сегментів, написаних штучним інтелектом, які можуть вказувати на руку зловмисника. Хоча ця сфера тільки зароджується, вона є багатообіцяючою: в одному випадку команда безпеки використовувала детектор ШІ, щоб зловити заплутаний файл фішингового набору, який "відчувався" як створений штучним інтелектом і дійсно був частиною атаки[44]. Код файлу був надто складним і багатослівним (ознаки генерації ШІ), а перевірка вмісту підтвердила високу ймовірність того, що він не був написаний людиною[40].

Нарешті, надзвичайно важливим є обмін розвідданими про загрози, пов'язані зі штучним інтелектом. Коли Google GTIG публікує детальну інформацію про шкідливе програмне забезпечення на основі Prompt або коли дослідники повідомляють про нові методи ухилення від ШІ, організації повинні враховувати їх у своїх технологіях виявлення. Поведінкова аналітика - пошук дій, таких як процес, що породжує скрипт, який переписує код цього ж процесу - може виявити аномалії, які демонструє шкідливе програмне забезпечення з підтримкою штучного інтелекту. Коротше кажучи, захисники повинні боротися з вогнем вогнем: розгортати Інструменти безпеки на основі штучного інтелекту які можуть адаптуватися так само швидко, як і шкідливе програмне забезпечення, кероване штучним інтелектом. Це включає в себе все - від антивірусів зі штучним інтелектом до аналітики поведінки користувачів, яка може визначити, коли обліковий запис або система починає діяти "не зовсім по-людськи". Використовуючи ШІ для захисту, команди безпеки можуть протистояти перевагам швидкості та масштабу, які ШІ надає зловмисникам.

Синтетичні ідентичності та шахрайські схеми зі штучним інтелектом

Перехід від шкідливого програмного забезпечення до світу шахрайства: шахрайство з синтетичними ідентифікаційними даними стрімко зросла завдяки генеративному ШІ. Шахрайство з використанням синтетичних ідентифікаційних даних передбачає створення фіктивних осіб шляхом поєднання реальних і фальшивих даних (наприклад, справжній SSN + фальшиве ім'я та документи). Ці "франкенштейнівські" особистості потім використовуються для відкриття банківських рахунків, отримання кредитів або проходження KYC-перевірок, що в кінцевому підсумку призводить до несплати кредитів або відмивання грошей. Це вже був один з найбільш швидкозростаючих видів шахрайства, а штучний інтелект підлив масла у вогонь. Збитки від шахрайства з синтетичними ідентифікаторами перетнув $35 мільярдів у 2023 році[45]і до початку 2025 року деякі оцінки вказували на те, що майже 25% усіх збитків від банківського шахрайства були зумовлені синтетичними ідентичностями[46]. Аналітики Experian виявили, що понад 80% випадків шахрайства з новими акаунтами на певних ринках тепер пов'язані з синтетичними ідентифікаторами[19] - приголомшлива статистика, яка підкреслює, наскільки поширеним стало це шахрайство.

Генеративний ШІ посилює синтетичне шахрайство кількома способами. По-перше, штучний інтелект робить тривіальним створення "документи заводчика" та цифрові сліди, необхідні для продажу фальшивої особистості. У минулому шахрай міг відфотошопити посвідчення особи або вручну створити фальшиві рахунки за комунальні послуги. Зараз існують інструменти для створення автентичні на вигляд фотографії профілю, посвідчення особи, паспорти, банківські виписки, навіть профілі в соціальних мережах використання ШІ-генераторів зображень і мовних моделей[47][48]. Наприклад, за допомогою ШІ можна створити реалістичний знімок голови неіснуючої людини (запобігаючи легкому пошуку за зворотним зображенням) і згенерувати відповідне фальшиве водійське посвідчення з цією фотографією. ШІ також може імітувати "ознаки життя" особистості - наприклад, створювати записи про синтетичних батьків, адреси або пости в соціальних мережах щоб доповнити передісторію.[49]. У Бостонському ФРС відзначили, що Gen AI може навіть виробляти глибоко підроблені аудіо та відео підставної особи - Наприклад, синтетичний користувач може "з'явитися" на відео з селфі-верифікації, з унікальним обличчям і голосом, згенерованим штучним інтелектом.[50].

По-друге, ШІ допомагає шахраям розширювати масштаби їхні операції. Замість того, щоб підробляти одну або дві особи за раз, вони можуть програмно генерувати сотні або тисячі повних пакетів ідентифікаційних даних і масово заповнювати заявки на нові облікові записи[51][52]. Деякі сервіси темного Інтернету фактично пропонують "Синтетичні ідентичності як послуга"використовуючи автоматизацію для створення верифікованих акаунтів на продаж. Наприклад, під час програм допомоги під час пандемії COVID-19 злочинці використовували ботів з ідентифікаційними даними, згенерованими штучним інтелектом, щоб масово подавати заявки на кредити та пільги, переповнюючи систему фальшивими заявниками. За прогнозами Juniper Research, глобальні витрати на шахрайство з цифровими ідентифікаційними даними (що підживлюється такою тактикою) становитимуть зростання 153% до 2030 року порівняно з 2025 роком[53].

Захисні заходи - перевірка особистості у світі штучного інтелекту: Традиційні методи підтвердження особи борються з підробками, створеними штучним інтелектом. Щоб адаптуватися, організації впроваджують багаторівнева перевірка ідентичності та поведінки підсилений штучним інтелектом. Ключовий рівень просунутий експертиза документів та зображень. Наприклад, Детектор зображень зі штучним інтелектом TruthScan і Детектор підроблених документів надають можливість аналізувати завантажені ідентифікаційні дані, селфі або документи на наявність ознак синтезу або фальсифікації. Ці інструменти досліджують артефакти на рівні пікселів, невідповідності в освітленні та метаданих, щоб визначити, чи є зображення згенерованим штучним інтелектом, чи ним маніпулювали. Вони можуть вловлювати тонкі підказки - наприклад, ідентичні фонові візерунки на фотографіях, згенерованих GAN, або шрифти та інтервали на посвідченні особи, які не відповідають жодному відомому урядовому шаблону. Впроваджуючи такі детектори під час реєстрації, банки можуть автоматично позначати водійські права або селфі заявника, якщо вони, ймовірно, згенеровані штучним інтелектом (наприклад, система TruthScan позначила б фальшивий військовий квиток, який використовувався у справі про фішинг APT Kimsuky).[5]). Згідно з прес-релізом TruthScan, їхня платформа використовується фінансовими установами для перевірки автентичності документів у великих масштабах, виявляючи глибокі підробки з надзвичайно високою точністю[54].

Інший рівень - це поведінкова аналітика та перехресні перевірки. Справжні особистості мають глибину - роки історії, публічні записи, активність у соціальних мережах тощо. Ідентичності, створені штучним інтелектом, незалежно від того, наскільки вони відшліфовані, часто не мають такого глибокого коріння. Зараз банки і кредитори використовують ШІ для перехресної кореляції даних заявки з публічними і приватними даними: Чи показують номер телефону та електронну пошту цієї людини історію використання? Чи має сенс геолокація пристрою або IP-адреси? Чи вводять вони дані у форми по-людськи, чи копіюють (як це роблять боти)? Моделі штучного інтелекту можна навчити відрізняти справжню поведінку клієнтів від синтетичних шаблонів. Федеральна резервна система зазначила, що "Синтетичні ідентичності є поверхневими, і ШІ це бачить" - Верифікація на основі штучного інтелекту може швидко шукати цифровий слід ідентичності та сигналізувати, якщо його не знайдено або знайдено дуже мало[55]. На практиці сервіси перевірки особи тепер використовують штучний інтелект, який перевіряє, чи збігається селфі користувача з минулими фотографіями (щоб виявити підміну облич), і навіть підказує користувачам рандомізовані дії (наприклад, певні пози або фрази) під час перевірки реальності, що ускладнює правильну реакцію для глибоких фейків.[56][57].

Нарешті, постійний моніторинг Аналіз поведінки акаунта після реєстрації допомагає виявити синтетичні акаунти, які вислизнули з-під контролю. Оскільки ці акаунти не прив'язані до реальних осіб, їхні патерни використання часто виділяються (наприклад, здійснення транзакцій в потрібний час для отримання кредиту, а потім виведення його на максимум). Моніторинг шахрайства на основі штучного інтелекту (наприклад, платформи Sift або Feedzai) може виявити аномалії у використанні акаунтів, позначивши потенційну синтетику для перевірки. Підсумовуючи, боротьба з шахрайством з використанням ШІ вимагає Підтвердження особи за допомогою ШІ - поєднуючи експертизу документів, біометричні перевірки, кореляцію даних і поведінковий аналіз. Хороша новина полягає в тому, що ті самі досягнення в галузі штучного інтелекту, які уможливлюють шахрайство, також використовуються для його виявлення. TruthScan, наприклад, пропонує набір для перевірки особистих даних яка інтегрує аналіз тексту, зображень і голосу для перевірки нових користувачів. Використовуючи ці інструменти, один великий банк помітив значне зниження кількості успішних відкриттів синтетичних рахунків, хоча середні показники по галузі зростали. Гонка озброєнь триває, але захисники вчаться розпізнавати слабкі "цифрові ознаки" синтетики, незалежно від того, як добре ШІ намагається замести сліди.

Інтеграція виявлення штучного інтелекту в стек безпеки

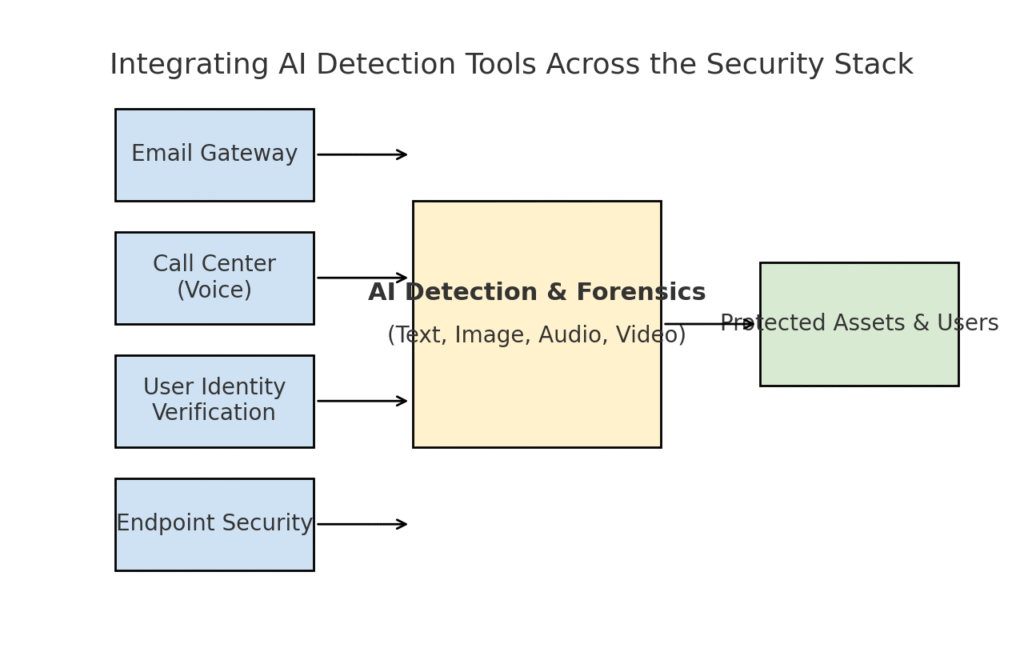

Ми дослідили кілька окремих сфер загроз - фішинг, глибокі підробки, шкідливе програмне забезпечення, синтетичне шахрайство - і всі вони підсилені штучним інтелектом. Зрозуміло, що немає єдиного інструменту або одноразового рішення не вирішить проблему. Натомість підприємствам потрібна комплексна стратегія, щоб впроваджуйте виявлення та верифікацію на основі ШІ на кожному рівні їхнього стеку кібербезпеки. Підхід повинен відображати поверхню атаки, охоплюючи електронну пошту, Інтернет, голос, документи, ідентифікаційні дані тощо. На діаграмі нижче показано, як організації можуть інтегрувати інструменти виявлення ШІ від TruthScan (і подібні рішення) на всіх рівнях корпоративної безпеки:

Інтеграція інструментів виявлення ШІ на різних рівнях стека безпеки - від поштових шлюзів і кол-центрів до верифікації користувачів і захисту кінцевих точок. Виявлення контенту зі штучним інтелектом (в центрі) аналізує текст, зображення, аудіо та відео в режимі реального часу, передаючи його в точки застосування, які захищають активи та користувачів.

У цій моделі, мультимодальні АІ-датчики діють як центральний мозок який взаємодіє з різними засобами контролю безпеки:

- Шлюзи електронної пошти: Вхідні листи проходять через детектор тексту/шахрайства зі штучним інтелектом, перш ніж потрапити до вхідних. Це пов'язано з захистом від фішингу, який ми обговорювали - наприклад, з використанням Детектор електронного шахрайства TruthScan через API вашого email-провайдера, щоб автоматично відправляти в карантин підозрілі листи, згенеровані штучним інтелектом[18]. Його також можна застосовувати до платформ обміну повідомленнями (чат-додатки, SMS-шлюзи) для сканування контенту на наявність фішингу або шахрайських шаблонів.

- Колл-центри та голосові системи: Телефонні та VOIP-канали захищені завдяки інтеграції глибокого розпізнавання підробок голосу. Наприклад, лінія підтримки клієнтів банку може використовувати Детектор голосу зі штучним інтелектом TruthScan аналізувати аудіозаписи вхідних дзвінків у режимі реального часу та попереджати, якщо голос абонента є синтетичним або не відповідає відомому профілю[58][59]. Це допомагає запобігти успішним атакам вішингу та імітації голосу (наприклад, фальшивим дзвінкам від керівника).

- Процеси перевірки особи користувача: Під час створення облікового запису або ризикованих дій користувача (скидання пароля, банківські перекази) вмикається перевірка особи на основі ШІ. Завантажене фото посвідчення особи перевіряється інструментом криміналістики зображень (наприклад, перевіряється, чи не згенероване воно штучним інтелектом, чи не є фотографією фотографії), а селфі або відеодзвінок перевіряється детектором глибоких підробок. TruthScan's Детектор підробок можна використовувати для автентифікації обличчя, щоб переконатися, що людина на камері справжня і відповідає ідентифікатору[60][61]. Поведінкові сигнали (каденція набору тексту, узгодженість роботи пристрою) також можна подавати в моделі ШІ для виявлення ботів або синтетичних ідентичностей.

- Кінцеві точки та мережа: Агенти безпеки кінцевих точок і проксі-сервери можуть включати аналіз вмісту файлів і скриптів за допомогою ШІ. Наприклад, якщо EDR кінцевої точки бачить, що виконується новий скрипт або EXE-файл, він може надіслати текстовий вміст файлу на детектор ШІ, щоб перевірити, чи схожий він на відоме шкідливе програмне забезпечення, створене ШІ, або має ознаки прихованого ШІ-коду. Аналогічно, системи DLP (запобігання втраті даних) можуть використовувати виявлення ШІ-тексту для позначення конфіденційного тексту, згенерованого ШІ (що може вказувати на те, що інсайдер використовує ШІ для створення повідомлень про витік даних або фальсифікацію звітів). TruthScan's Детектор реального часу призначений для підключення до таких робочих процесів, пропонуючи аналіз контенту в реальному часі на різних платформах з автоматизованими опціями реагування[42][62] (наприклад, автоматичне блокування файлу або повідомлення, якщо його ідентифіковано як згенероване ШІ шкідливе програмне забезпечення або дезінформацію).

У "The ключова перевага цього комплексного підходу є швидкість і послідовність. Атаки ШІ відбуваються швидко - фішингові електронні листи, фальшиві голоси і синтетичні дані можуть вражати багато каналів одночасно. Оснастивши всі ці канали засобами виявлення ШІ, організація отримує видимість у реальному часі та глибокий захист. Одна команда описала це як створення "імунної системи ШІ" для свого підприємства: щоразу, коли щось передається (електронний лист, завантаження документа, голосовий дзвінок тощо), імунна система ШІ "винюхує" його на наявність сторонніх (згенерованих ШІ) підписів і нейтралізує його, якщо виявляє зловмисність.

Корпоративний пакет TruthScan є прикладом цього, оскільки він пропонує уніфікована платформа охоплює виявлення ШІ тексту, зображень, аудіо та відео, яке можна розгортати модульно або в цілому[63][64]. Багато компаній починають із впровадження однієї-двох функцій (скажімо, розпізнавання тексту в електронній пошті та розпізнавання зображень в онбордінгу), а потім розширюють їх, коли бачать їхню цінність. Важливо, що інтеграцію зроблено зручною для розробників - TruthScan та подібні сервіси надають API та SDK, щоб команди безпеки могли підключити виявлення до існуючих систем без масштабного реінжинірингу. Незалежно від того, чи це SIEM, поштовий шлюз, спеціальний банківський додаток або CRM-система, виявлення може працювати за лаштунками і надсилати сповіщення або автоматичні дії. Наприклад, велика платформа соціальних мереж інтегрувала API модерації контенту, щоб автоматично видаляти підроблені відео за лічені хвилини після завантаження[65][66]запобігаючи поширенню дезінформації, створеної штучним інтелектом.

Висновок: Залишатися на крок попереду

Стрімке поширення загроз, керованих штучним інтелектом, у 2025 році поставило організації перед новими викликами. Зловмисники знайшли способи масштабно експлуатувати людську довіру, видаючи себе за інші особи, автоматизуючи соціальну інженерію, обходячи захист за допомогою адаптивного коду та створюючи цілу фальшиву реальність. Це лякаюча перспектива для захисників, але не безнадійна. Так само, як злочинці використовують ШІ, так само і ми можемо залучити ШІ на бік безпеки. Поява Виявлення контенту зі штучним інтелектом, експертиза глибоких підробок і синтетичні сканери ідентичностей дає нам потужну протидію цим новим загрозам. Розгортаючи ці інструменти та інтегруючи їх на всіх рівнях За допомогою новітніх технологій захисту підприємства можуть значно знизити ризик пропуску атак з використанням штучного інтелекту. Перші користувачі вже запобігли багатомільйонним спробам шахрайства, спіймавши глибокі підробки на гарячому[26]або запобігали фішинговим атакам, фільтруючи електронні листи, створені штучним інтелектом.

Окрім технологій, організаціям слід розвивати культуру "довіряй, але перевіряй". Співробітники повинні усвідомлювати, що в епоху штучного інтелекту бачити (або чути) не завжди означає вірити - здоровий скептицизм у поєднанні з перевіркою робочих процесів може зупинити багато прийомів соціальної інженерії. Навчання та обізнаність у поєднанні з автоматизовані інструменти перевірки, такі як TruthScanутворюють потужний захист. У певному сенсі ми повинні підняти планку автентифікації та перевірки інформації. Цифрові комунікації та документи більше не можна сприймати за чисту монету; їхнє походження потрібно перевіряти, або машинним способом, або за допомогою процесу.

У міру того, як ми рухаємося вперед, слід очікувати, що зловмисники будуть і далі вдосконалювати свою тактику ШІ, але також слід очікувати і подальших інновацій в області захисного ШІ. Динаміка "кішки-мишки" збережеться. Успіх захисників залежатиме від гнучкість та обмін інформацією. Ті, хто швидко впроваджує нові дані про загрози (наприклад, нові методи виявлення глибоких підробок або оновлені сигнатури моделей ШІ), випередять зловмисників, які використовують новітні інструменти ШІ. Співпраця між промисловістю, науковими колами та урядом також матиме життєво важливе значення в цій боротьбі, про що свідчать попередження та рамки, що з'являються в таких установах, як NIST's AI Risk Management Framework, а також міжбанківська співпраця у сфері виявлення шахрайства за допомогою ШІ.

Насамкінець, індустрія кібербезпеки перебуває в розпалі зміни парадигми, зумовленої штучним інтелектом. Загрози відрізняються від тих, що були десять років тому, але ми зустрічаємо їх з настільки ж безпрецедентним захистом. Завдяки поєднанню передових технологій виявлення та надійної стратегії безпеки ми може пом'якшити ризики генеративного ШІ і навіть перетворити його на нашу перевагу. Такі інструменти, як набір для виявлення ШІ від TruthScan, дають нам змогу відновити довіру у світі з нульовою довірою - щоб переконатися, що людина на іншому кінці дроту реальна, що документ у нашій поштовій скриньці справжній, а код, який працює в нашій мережі, не був підроблений зловмисним ШІ. Інвестуючи в ці можливості зараз, організації не тільки захистять себе від сьогоднішніх атак з використанням ШІ, але й підвищать стійкість до нових загроз завтрашнього дня. Підсумок очевидний: ШІ може посилювати кібератаки, але при правильному підході він також може посилити наш захист.

Джерела: Відповідні дані та приклади були взяті зі звітів аналітиків та експертів про загрози 2025 року, зокрема зі звіту Майєра Брауна "Тенденції кіберінцидентів" (Mayer Brown's Cyber Incident Trends)[1][67]Огляд загроз 2025 року від Fortinet[2][19]Дослідження Barracuda щодо атак ШІ на електронну пошту[6][7]звіт Google GTIG про загрози штучного інтелекту[34]Бостонський федеральний резерв про синтетичне шахрайство[45][50]а також опубліковані кейси та прес-релізи TruthScan[30][26]серед інших. Вони ілюструють масштаби загроз, спричинених штучним інтелектом, та ефективність контрзаходів, орієнтованих на штучний інтелект, у реальних сценаріях. Вивчаючи такі розвіддані та впроваджуючи найсучасніші інструменти, ми можемо з упевненістю орієнтуватися в епоху кіберризиків, що посилюються штучним інтелектом.

[1] [67] Тенденції кіберінцидентів 2025 року, що потрібно знати вашому бізнесу | Інсайти | Mayer Brown

[2] [3] [19] Найкраща статистика з кібербезпеки: Факти, статистика та порушення за 2025 рік

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Шахрайство, кероване штучним інтелектом, у фінансових послугах: Останні тенденції та рішення | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan виявив північнокорейську фейкову атаку на чиновників оборонного відомства - Bryan County Magazine

[6] [7] [14] Половина спаму у вашій поштовій скриньці генерується штучним інтелектом - його використання в просунутих атаках знаходиться на ранній стадії | Блог Barracuda Networks

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Індекс цифрової довіри за 2 квартал 2025 року: Дані про шахрайство зі штучним інтелектом та аналітика | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Загрози кібербезпеці ШІ 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Новітні дані про загрози | TruthScan

[18] [63] [64] TruthScan - виявлення та захист контенту за допомогою штучного інтелекту на підприємстві

[23] [46] [56] [57] Deepfakes і депозити: Як боротися з шахрайством за допомогою генеративного АІ

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Підроблені атаки та фішинг зі штучним інтелектом: статистика за 2025 рік

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] АІ-детектор голосу для виявлення підробок і клонування голосу | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - виявлення фейкових відео та відео зі штучним інтелектом - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Досягнення у використанні інструментів штучного інтелекту суб'єктами загроз | Блог Google Cloud

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Хакери заплутали шкідливе програмне забезпечення за допомогою багатослівного коду зі штучним інтелектом

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Виявлення ШІ в реальному часі - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Оператори EvilAI використовують код, згенерований ШІ, і підроблені додатки для далеких ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Gen AI посилює загрозу шахрайства з синтетичними ідентифікаційними даними - Федеральний резервний банк Бостона

[53] Шахрайство з синтетичними ідентифікаційними даними 2025: Стратегії виявлення та запобігання з використанням штучного інтелекту