Inledning: En ny era av AI-drivna angrepp

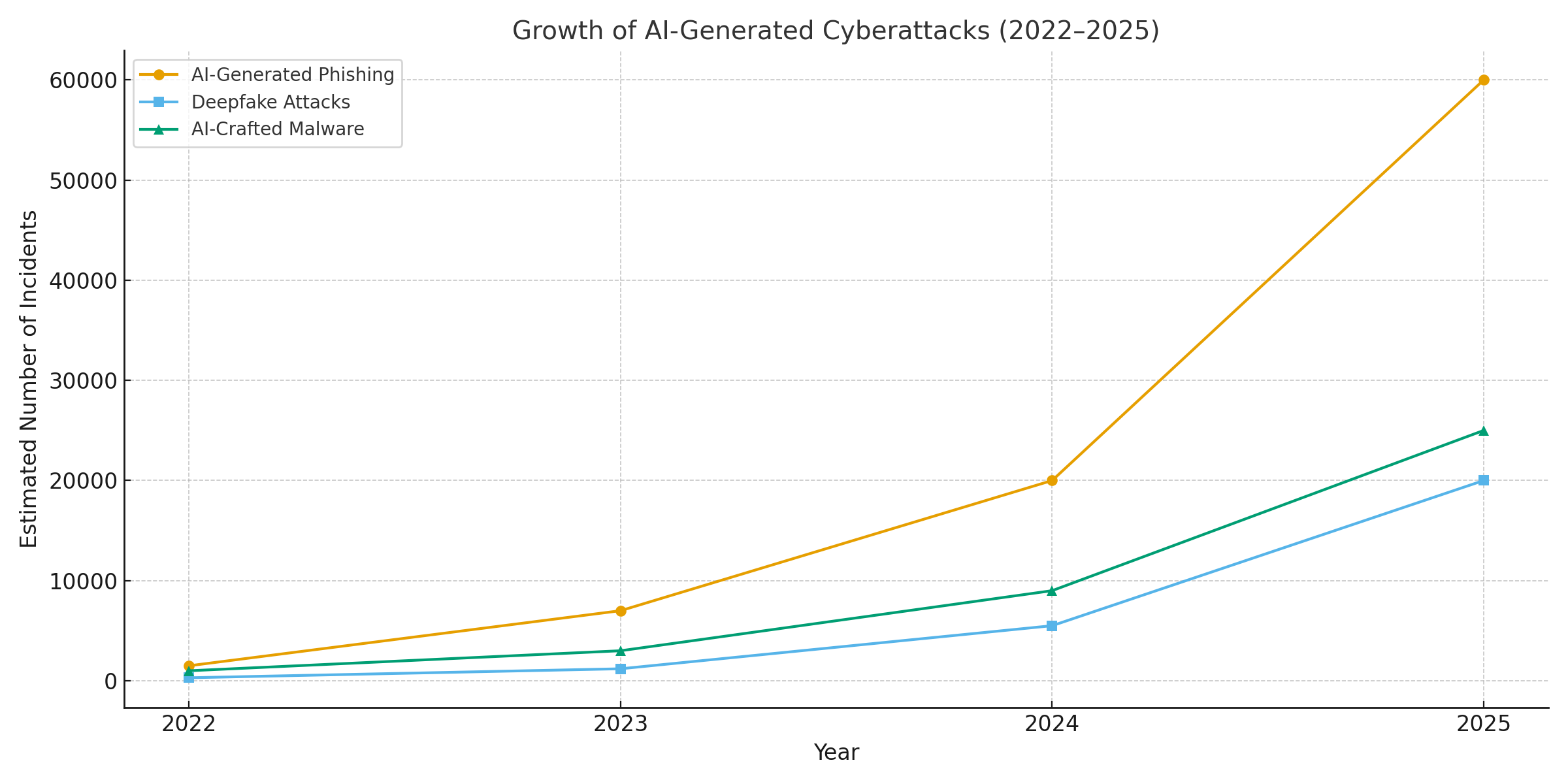

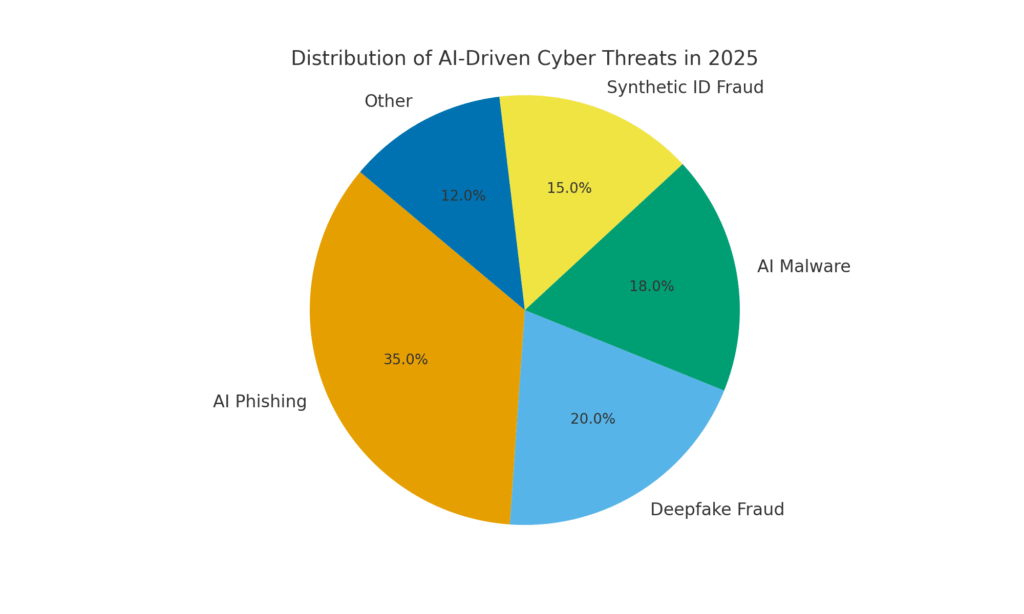

År 2025 har inneburit en vändpunkt för cybersäkerheten. Generativ AI har ökat cyberattackernas kraft och gjort det möjligt för hotaktörer att lansera mer frekventa, realistiska och skalbara kampanjer än någonsin tidigare. Faktum är att under det senaste året har uppskattningsvis 16% av de rapporterade cyberincidenterna involverade angripare som använde AI-verktyg (t.ex. modeller för bild- och språkgenerering) för att förbättra social ingenjörskonst[1]. Från extremt övertygande phishing-mejl till deepfake audio/video-bedrägerier - illvilliga aktörer använder AI som vapen inom alla sektorer. En majoritet av säkerhetsexperter tillskriver nu ökning av cyberattacker till generativ AI, vilket ger dåliga aktörer snabbare och smartare sätt att utnyttja offer[2]. Generativ AI sänker effektivt kunskapskraven för cyberbrottslighet samtidigt som den ökar dess styrka.

Varför är detta så oroande? AI kan omedelbart producera polerat, kontextmedvetet innehåll som lurar även utbildade användare. Den kan imitera röster och ansikten med skrämmande precision och till och med generera skadlig kod som förändras för att undgå upptäckt. Som ett resultat av detta har cyberattacker blivit svårare att upptäcka och lättare att utföra. Den Världsekonomiskt forum varnar för att 72% av organisationerna har sett ökade cyberrisker - särskilt social ingenjörskonst och bedrägerier - på grund av generativ AI:s växande kapacitet[3]. Händelser i den verkliga världen bekräftar detta: I början av 2024 använde brottslingar en AI-genererad deepfake videosamtal att utge sig för att vara ett företags finansdirektör och lura en anställd att överföra $25,6 miljoner euro till bedragarna[4]. Och i ett annat fall använde nordkoreanska hackare AI-genererade falska ID-handlingar för att kringgå säkerhetskontroller i en phishing-kampanj för försvar[5]. Dessa exempel belyser vad som står på spel - generativ AI möjliggör bedrägerier som kringgår både mänskliga och tekniska kontroller.

Men AI är också en del av lösningen. Avancerade detekteringsverktyg (som de från TruthScan) använder AI mot AI - analys av innehåll för att hitta subtila tecken på maskinell generering. I det här whitepaperet undersöker vi de främsta AI-drivna cyberhoten 2025 och hur organisationer kan motverka dem. Från AI-genererad nätfiske till deepfake VD-bedrägeri, AI-skapad skadlig kod, syntetiska identiteteroch mer, kommer vi att utforska hur generativ AI omformar attacker. Vi kommer också att diskutera konkreta försvarsåtgärder, inklusive AI-detektering av innehåll, deepfake-forensics och teknik för identitetsverifiering som kan hjälpa säkerhetsteam att återfå övertaget. Målet är att belysa hur företag, MSSP:er, CISO:er och bedrägeriutredare kan integrera AI-detekteringsverktyg i hela sin cybersäkerhetsstack för att motverka denna våg av AI-drivna hot.

Oroa dig aldrig för AI-bedrägerier igen. TruthScan Kan hjälpa dig:

- Upptäcka AI-generering bilder, text, röst och video.

- Undvik stora AI-drivna bedrägerier.

- Skydda dina mest känslig Företagets tillgångar.

AI-genererad nätfiske och BEC: Bedrägerier i aldrig tidigare skådad skala

En av de tydligaste effekterna av generativ AI har varit på nätfiske och Kompromittering av företags e-post (BEC) system. AI-språkmodeller kan skriva flytande, kontextuellt skräddarsydda e-postmeddelanden på några sekunder - vilket eliminerar de avslöjande grammatikfel och besvärliga formuleringar som en gång avslöjade phishing. Resultatet är en flod av mycket övertygande bluffmejl och sms. I april 2025, över hälften av skräppostmeddelandena (51%) skrevs av AI, upp från nästan noll två år tidigare[6]. Ännu mer alarmerande var att forskarna fann att cirka 14% av e-postmeddelandena om BEC-attacker var AI-genererade senast 2025[7] - en siffra som förväntas stiga i takt med att brottslingar tar till sig verktyg som ChatGPT. Vissa studier uppskattar över 80% av phishing-mejl kan nu få hjälp av AI med att skapa dem[8].

Volymen av dessa AI-genererade lockbeten har exploderat. Säkerhetsanalyser visar att nätfiskeattacker kopplade till generativ AI ökade med 1,265% på kort tid[9]. Under en period ökade antalet rapporter om nätfiskeincidenter 466% under ett enda kvartaltill stor del på grund av automatiserade phishing-kit och robotar som pumpar ut anpassade beten[9][10]. Varför en sådan spik? Eftersom AI låter angripare skala deras verksamhet på ett dramatiskt sätt. En enda brottsling kan använda en AI-chattbot för att generera tusentals av personliga bluffmejl riktade till olika anställda eller kunder, allt på den tid det brukade ta att skapa ett. Denna massautomatisering fick FBI att varna för att BEC-förluster (som redan var $2,7 miljarder 2022) bara kommer att accelerera eftersom AI "hotar att driva dessa förluster ännu högre"[11][12].

Det finns inte bara fler phishing-meddelanden, de är också mer effektiv. Offren luras i högre grad av det polerade språket och de kontextuella detaljer som AI kan införliva. I labbtester uppnådde AI-skrivna phishing-e-postmeddelanden en 54% klickfrekvens - långt över ~12% för traditionella phishing-försök[13]. Dessa meddelanden läses som en äkta VD-stil eller hänvisar till verkliga företagshändelser, vilket sänker mottagarnas vaksamhet. Angriparna använder till och med AI för att A/B-testa olika formuleringar och upprepa de mest framgångsrika krokarna[14]. Och till skillnad från människor gör AI inte stavfel eller blir trött - det kan spy ut oändliga varianter tills en slinker förbi filter och lurar någon.

Ett exempel på det: I mitten av 2025 kommer en Reuters utredning avslöjade hur sydostasiatiska bedragare utnyttjade ChatGPT för att automatisera bedrägerikommunikation[15]. De genererade övertygande bankmejl och kundtjänsttexter en masse, vilket kraftigt ökade räckvidden för deras system. Europeisk polis rapporterade på liknande sätt att AI-drivna nätfiskekit såldes på den mörka webben för under $20, vilket gjorde det möjligt för lågutbildade aktörer att starta sofistikerade kampanjer[16][17]. Inträdeshindret för BEC och phishing har i princip försvunnit.

Defensiva åtgärder - Stoppa AI Phish: Med tanke på anstormningen måste organisationerna stärka sina e-post- och meddelandekanaler. Det är här AI-detektering av innehåll kan hjälpa dig. Verktyg som TruthScans AI-textdetektor och specialiserade e-postskannrar kan analysera inkommande meddelanden med avseende på statistiska markörer för AI-genererad text. Till exempel kan TruthScan Detektor för e-postbedrägerier använder analys av naturligt språk för att flagga e-postmeddelanden som sannolikt härrör från en AI, även om de ser legitima ut[18]. Dessa detektorer undersöker saker som perfekt polerad grammatik, meningskomplexitet och stilometriska mönster som är ovanliga för mänskliga skribenter. Med Skanning i realtidkan misstänkta e-postmeddelanden sättas i karantän eller flaggas för granskning innan de når användarna. Företagens säkerhetsteam börjar använda sådana AI-drivna filter i e-postgateways och meddelandeplattformar. I praktiken lägger detta till ett nytt försvarslager ovanpå traditionella skräppostfilter - ett som uttryckligen är inställt på att fånga upp AI-skrivet innehåll. Från och med 2025 integrerar ledande företag lösningar som TruthScan via API i sina säkra e-postgateways och molnbaserade samarbetssviter, vilket skapar en automatiserad kontrollpunkt för AI-genererad nätfiske innehåll.

Deepfake röst- och videoimitation: Bedrägeriet "att se är att luras"

Det kanske mest påtagliga AI-drivna hotet under 2025 är ökningen av deepfake röst- och videoattacker. Med hjälp av AI-modeller kan brottslingar klona en persons röst från bara några sekunders ljud, eller generera en realistisk video av någons ansikte från en handfull foton. Dessa "deepfakes" används som vapen i bedrägerier med höga insatser - från VD-bedrägerier ("fake CEO"-samtal) till falska videokonferenser och mycket mer. En nyligen publicerad branschrapport avslöjade 47% av organisationerna har upplevt deepfake-attacker av något slag[19]. Och det är inte bara teoretiskt: flera stölder under 2023-2025 har visat att deepfakes kan besegra den ultimata autentiseringen - våra egna ögon och öron.

Ett ökänt fall gällde en internationell banköverföring av $25 miljoner efter att en anställd blivit lurad av en deepfake-videokonferens. Angriparna använde AI för att syntetisera likheten med företagets finansdirektör i ett Zoom-samtal, komplett med hennes röst och manér, och instruerade den anställde att överföra pengar[4][20]. I en annan händelse i Australien har en lokal myndighet förlust $2,3 miljoner kronor när bedragare fejkade både röst och video från stadstjänstemän för att godkänna bedrägliga betalningar[21]. Och oroväckande nog använder brottslingar AI-klonade röster i "farföräldrabedrägerier" - de ringer äldre och utger sig för att vara deras släktingar i nöd. De FBI och FinCEN utfärdade varningar i slutet av 2024 om en ökning av bedrägerier med hjälp av AI-genererade "deepfake"-medier, inklusive falska kundtjänstmedarbetare och syntetiska identiteter för att kringgå KYC-verifieringar[22].

Frekvensen av deepfake-baserade brott ökar snabbt. I slutet av 2024 visade en analys att ett nytt deepfake-bedrägeri inträffade var femte minut i genomsnitt[23]. Bara under Q1 2025 ökade antalet rapporterade deepfake-incidenter med 19% jämfört med alla av 2024[24][25]. Deepfakes står nu för uppskattningsvis 6,5% av alla bedrägeriattacker, a 2.137%-ökning sedan 2022[26][27]. Den teknik som krävs har blivit lättillgänglig - ofta krävs det så lite som 30 sekunder av ljud för att klona en röst, eller under en timmes provfilmning för att modellera en persons ansikte på ett övertygande sätt[20]. Kort sagt, det har aldrig varit enklare att "fejka" en betrodd persons identitet och lura offren att lämna över pengar eller information.

Försvarsåtgärder - Autentisering av verkligheten: För att motverka deepfake-hot vänder sig organisationer till avancerade Detektering av syntetiska medier verktyg. Till exempel, TruthScans AI-röstdetektor och TruthScan Deepfake-detektor använder AI för att analysera ljud och video efter tecken på manipulation. Dessa system utför analys av bildruta för bildruta och vågform för att upptäcka artefakter som onaturliga ansiktsrörelser, läppsynkroniseringsproblem eller spektrala oregelbundenheter i ljudet som avslöjar ett AI-genererat klipp. I tester uppnådde TruthScans algoritmer 99%+ noggrannhet vid identifiering av AI-genererade röster och upptäckte manipulerade videobilder i realtid[28][29]. Faktum är att forskare vid Genians Security Center nyligen använde TruthScans bildforensik för att analysera ett falskt ID-kort som användes av nordkoreanska hackare - TruthScans deepfake-bilddetektor flaggade dokumentet som oäkta med 98% förtroende, avvärja spear-phishing-försöket[5][30].

För att kunna försvara sig i praktiken använder företagen dessa detekteringsfunktioner vid viktiga knutpunkter. Röstverifiering läggs till i callcenters arbetsflöden - t.ex. när en "kund" begär en stor överföring via telefon kan ljudet köras genom en deepfake-detektor för att säkerställa att det verkligen är de själva (och inte en AI-imitation). På samma sätt, plattformar för videokonferenser kan integrera live deepfake-skanning av deltagarnas videoströmmar för att fånga upp eventuella syntetiska ansikten. TruthScans svit för deepfake-detektering erbjuder till exempel analys av videosamtal i realtid och ansiktsautentisering som kan anslutas till Zoom eller WebEx via API[31][29]. Det innebär att om någon försöker delta i ett möte med hjälp av en AI-skapad video av er VD kan systemet flagga för "möjlig deepfake" innan någon skada har skett. Dessutom innehåller viktiga transaktioner nu ofta ett verifieringssteg (utanför bandet eller med flera faktorer) som kan utnyttja innehållsautentisering - t.ex. genom att kräva en kort muntlig bekräftelse som sedan kontrolleras av en AI-röstdetektor för äkthet. Genom att kombinera dessa verktyg skapar företagen ett skyddsnät: även om medarbetarna se eller höra något trovärdigt, kommer en AI-forensiker bakom kulisserna att ifrågasätta dess verklighet. I ett hotlandskap som genomsyras av AI, "Lita inte på - verifiera" blir mantrat för all röst- eller videokommunikation som rör pengar eller känslig åtkomst.

AI-framställd skadlig kod och fördunklad kod: Utvecklande hot i koden

AI:s inflytande är inte begränsat till social ingenjörskonst - det förändrar också spelet när det gäller utveckling av skadlig kod och undvikande attackkod. År 2025 avslöjade Googles Threat Intelligence Group den första stammar av skadlig kod med hjälp av AI under utförande för att ändra deras beteende[32][33]. Ett exempel, kallat PROMPTFLUXvar ett skadligt skript som faktiskt ringde till ett AI API (Googles Gemini-modell) för att skriva om sin egen kod i farten, producerar nya fördunklade varianter för att undvika antivirusdetektering[34][35]. Denna "just-in-time"-utveckling av AI innebär ett steg mot autonom, polymorf skadlig kod. Ett annat exempel, PROMPTSTEAL, använde en AI-kodningsassistent för att generera enradiga Windows-kommandon för datastöld, vilket i huvudsak outsourcade delar av sin logik till en AI-motor i realtid[36][37]. Dessa innovationer pekar mot en framtid där skadlig programvara kontinuerligt kan förändra sig själv - ungefär som en mänsklig pen-tester skulle göra - för att besegra försvar.

Även utan direkt AI använder angripare AI under utvecklingen för att skapa mer potent skadlig kod. Generativ AI kan producera skadlig kod som är mycket fördunkladsom innehåller lager av förvirrande logik som försvårar reverse engineering. Enligt rapporter från hotintelligens, över 70% av de större intrången 2025 involverade någon form av polymorf skadlig kod som ändrar sin signatur eller sitt beteende för att undvika upptäckt[38]. Därutöver, 76% av phishing-kampanjer använder nu polymorf taktik som dynamiska webbadresser eller AI-omskrivna nyttolaster[38]. Verktyg som den mörka webbens erbjudanden WormGPT och BedrägeriGPT (obegränsade kloner av ChatGPT) gör det möjligt för även icke-experter att generera droppers för skadlig kod, keyloggers eller ransomware-kod genom att helt enkelt beskriva vad de vill ha[39]. Resultatet är ett överflöd av nya varianter av skadlig kod. Till exempel, år 2024 en info-stjälare som heter BlackMamba framkom att det var helt AI-genereradoch använde ChatGPT för att skriva sin kod i segment - varje exekvering producerade en något annorlunda binär, vilket förvirrade traditionella signaturbaserade antivirusprogram[38]. Säkerhetsforskare demonstrerade också AI-genererade polymorfa proof-of-concepts som kunde undvika många endpoint-skydd[40].

Dessutom utnyttjar angripare AI för att finjustera sina metoder och leverans av skadlig kod. AI kan på ett intelligent sätt skripta phishing-mejl (som vi diskuterat) med länkar till skadlig kod. Det kan också hjälpa till med utvecklingen av exploateringar - t.ex. genom att använda AI för att hitta nya sårbarheter eller optimera skalkod. Nationalstatliga aktörer har enligt uppgift använt avancerade AI-modeller för att upptäcka nolldagsexploateringar och utveckla skräddarsydd skadlig kod för mål[41]. Alla dessa trender innebär att skadlig kod 2025 är mer dold och mer anpassningsbar. Den är ofta "samskapad" med AIvilket gör det svårare att upptäcka med hjälp av konventionella regler.

Defensiva åtgärder - AI vs. AI i försvar mot skadlig programvara: För att försvara sig mot AI-skapad skadlig kod krävs en kombination av avancerad upptäckt och AI-driven analys på den defensiva sidan. Många organisationer utökar sina Endpoint-skydd och EDR (Endpoint Detection & Response) med AI/ML-modeller som letar efter beteendemönster i AI-genererad kod. Till exempel kan plötsliga kodtransformationer på värddatorn eller ovanliga API-anropsmönster indikera något som PROMPTFLUX som regenererar sig själv. På samma sätt kan nätverksövervakning fånga upp avvikelser som skadlig kod som når ut till AI-tjänster (vilket inte är "normalt" för användarapplikationer). Leverantörerna tränar ML-baserade detektorer på familjer av AI-assisterad skadlig kod som hittills identifierats, vilket förbättrar igenkänningen av dessa nya hot.

En lösning som håller på att växa fram är integrerad AI-innehållsskanning i pipelines för utvecklare och byggprojekt. Detta innebär att AI-drivna detektorer används för att analysera skript, programvarubyggen eller till och med konfigurationsändringar för skadligt eller AI-genererat innehåll. Ett exempel, TruthScans realtidsdetektor kan användas för mer än bara text - dess multimodala analys kan potentiellt flagga misstänkt kod eller konfigurationsfiler genom att känna igen om de har genererats maskinellt med fördunklingsmönster[42][43]. Utvecklingsteam och MSSP:er börjar skanna infrastruktur-som-kod-skript, PowerShell-loggar och andra artefakter efter tecken på AI-skrivna segment som kan tyda på en angripares hand. Även om detta är ett begynnande område, visar det löfte: i ett fall använde ett säkerhetsteam en AI-detektor för att fånga en fördunklad phishing kit-fil som "kändes" AI-genererad och faktiskt var en del av en attack[44]. Filens kod var överdrivet komplex och mångordig (kännetecken för AI-generering), och en AI-innehållsskanning bekräftade en hög sannolikhet för att den inte var mänskligt skriven[40].

Slutligen är det avgörande att dela hotinformation med fokus på AI-hot. När Google GTIG publicerar detaljer om Prompt-baserad skadlig kod eller när forskare rapporterar nya AI-undvikande tekniker, bör organisationer mata in dessa i sin detektionsteknik. Beteendeanalys - som letar efter åtgärder som en process som skapar ett skript som skriver om samma process kod - kan fånga upp avvikelser som AI-assisterad skadlig kod uppvisar. Kort sagt, försvarare måste bekämpa eld med eld: distribuera AI-drivna säkerhetsverktyg som kan anpassa sig lika snabbt som den AI-drivna skadliga programvaran gör. Detta inkluderar allt från AI-förbättrat antivirus till analys av användarbeteenden som kan identifiera när ett konto eller system börjar bete sig "inte riktigt mänskligt". Genom att anamma AI för försvar kan säkerhetsteamen motverka de hastighets- och skalfördelar som AI ger angriparna.

Syntetiska identiteter och AI-drivna bedrägerier

Från skadlig kod till bedrägerier: Bedrägeri med syntetisk identitet har exploderat med hjälp av generativ AI. Syntetiska identitetsbedrägerier innebär att man skapar fiktiva personer genom att kombinera riktiga och falska uppgifter (t.ex. riktiga SSN + falska namn och dokument). Dessa "Frankenstein"-identiteter används sedan för att öppna bankkonton, ansöka om kredit eller klara kundkännedomskontroller - vilket i slutändan leder till obetalda lån eller penningtvätt. Det var redan en av de snabbast växande bedrägerityperna, och AI har nu hällt bränsle på elden. Förluster från bedrägerier med syntetiskt ID passerade $35 miljarder år 2023[45]och i början av 2025 tyder vissa beräkningar på nästan 25% av alla förluster till följd av bankbedrägerier berodde på syntetiska identiteter[46]. Experians analytiker fann att över 80% av bedrägerier med nya konton på vissa marknader är nu kopplad till syntetiska ID[19] - en häpnadsväckande statistik som understryker hur utbrett detta bedrägeri har blivit.

Generativ AI förstärker syntetiska bedrägerier på flera olika sätt. För det första gör AI det trivialt att producera "uppfödardokument" och digitala fotavtryck som behövs för att sälja en falsk identitet. Förr i tiden kunde en bedragare Photoshopa ett ID eller manuellt skapa falska elräkningar. Nu finns det verktyg för att generera autentiska profilbilder, ID-handlingar, pass, kontoutdrag och till och med profiler på sociala medier med hjälp av AI-bildgeneratorer och språkmodeller[47][48]. Man kan t.ex. använda en AI för att skapa en realistisk bild av huvudet på en person som inte finns (vilket förhindrar enkla sökningar med omvända bilder) och skapa ett matchande falskt körkort med den bilden. AI kan också simulera "livstecken" för en identitet - t.ex. skapa register över syntetiska föräldrar, adresser eller inlägg på sociala medier för att ge kött på benen åt en bakgrundshistoria[49]. Boston Fed noterade att Gen AI till och med kan producera deepfake ljud och video av en falsk person - En syntetisk användare kan till exempel "dyka upp" i en verifieringsvideo med selfie, komplett med unikt ansikte och röst, allt AI-genererat[50].

För det andra hjälper AI bedragare skala upp deras verksamhet. Istället för att förfalska en eller två identiteter åt gången kan de programmatiskt generera hundratals eller tusentals kompletta identitetspaket och automatiskt fylla i nya kontoansökningar en masse[51][52]. Vissa tjänster på den mörka webben erbjuder effektivt "Syntetiska identiteter som en tjänst", som använder automatisering för att producera verifierade konton till försäljning. Under hjälpprogrammen för covid-19-pandemin använde brottslingar till exempel botar med AI-genererade identiteter för att massansöka om lån och förmåner, vilket överväldigade systemet med falska sökande. Juniper Research beräknar att den globala kostnaden för digitala identitetsbedrägerier (som drivs av denna taktik) kommer att öka 153% till 2030 jämfört med 2025[53].

Defensiva åtgärder - verifiering av identitet i en AI-värld: Traditionella metoder för identitetskontroll har svårt att stå emot AI-skapade förfalskningar. För att anpassa sig antar organisationer identitets- och beteendeverifiering i flera lager förstärkt av AI. Ett viktigt lager är avancerad kriminalteknik för dokument och bilder. Till exempel, TruthScans AI-bilddetektor och Detektor för falska dokument ger möjlighet att analysera uppladdade ID-handlingar, selfies eller dokument för tecken på syntetisering eller manipulering. Dessa verktyg undersöker artefakter på pixelnivå, inkonsekvenser i belysning och metadata för att avgöra om en bild är AI-genererad eller manipulerad. De kan fånga subtila ledtrådar - som identiska bakgrundsmönster från GAN-genererade foton, eller teckensnitt och avstånd på ett ID som inte matchar någon känd regeringsmall. Genom att använda sådana detektorer vid onboarding kan banker automatiskt flagga en sökandes körkort eller selfie om den sannolikt är AI-genererad (till exempel skulle TruthScans system ha flaggat det falska militära ID som användes i Kimsuky APT-phishingfallet[5]). Enligt ett pressmeddelande från TruthScan har deras plattform använts av finansinstitut för att validera dokumentäkthet i stor skala och identifiera deepfakes med extremt hög noggrannhet[54].

Ett annat lager är beteendeanalys och korsreferenskontroller. Riktiga identiteter har djup - år av historia, offentliga register, aktivitet på sociala medier osv. AI-genererade identiteter, oavsett hur polerade de är, saknar ofta dessa djupa rötter. Banker och långivare använder nu AI för att korskorrelera ansökningsdata med offentliga och egna data: Visar den här personens telefonnummer och e-post en användningshistorik? Är enhetens eller IP:ns geolokalisering meningsfull? Skriver de in data i formulär på ett mänskligt sätt, eller kopierar de (som robotar gör)? AI-modeller kan tränas för att skilja äkta kundbeteende från syntetiska mönster. Federal Reserve noterade följande "syntetiska identiteter är ytliga, och AI kan se det" - AI-baserad verifiering kan snabbt söka efter det digitala fotavtrycket för en identitet och slå larm om inget eller mycket lite hittas[55]. I praktiken använder tjänster för identitetsverifiering nu AI som kontrollerar om en användares selfie matchar tidigare foton (för att upptäcka ansiktsbyten) och till och med uppmanar användare med slumpmässiga åtgärder (som specifika poser eller fraser) under liveness-kontroller, vilket gör det svårare för deepfakes att svara korrekt[56][57].

Äntligen, kontinuerlig övervakning av kontobeteende efter ombordstigning hjälper till att fånga upp syntetiska konton som slinker igenom. Eftersom dessa konton inte är knutna till en verklig persona sticker deras användningsmönster ofta ut (t.ex. att göra perfekt tajmade transaktioner för att bygga kredit och sedan maxa ut). AI-driven bedrägeriövervakning (som Sifts eller Feedzais plattformar) kan identifiera avvikelser i hur konton används och flagga för potentiella syntetiska konton för granskning. Sammanfattningsvis kräver kampen mot AI-aktiverade identitetsbedrägerier AI-baserad identitetsverifiering - som kombinerar kriminalteknik för dokument, biometriska kontroller, datakorrelation och beteendeanalys. Den goda nyheten är att samma AI-framsteg som möjliggör bedrägerier också används för att upptäcka dem. TruthScan, till exempel, erbjuder en svit för identitetsverifiering som integrerar text-, bild- och röstanalys för att kontrollera nya användare. Genom att utnyttja dessa verktyg kunde en stor bank notera en betydande minskning av antalet framgångsrika syntetiska kontoöppningar, trots att branschgenomsnittet ökade. Kapprustningen fortsätter, men försvararna lär sig att upptäcka de svaga "digitala tecknen" på en syntetisk användare, oavsett hur väl AI försöker dölja sina spår.

Integrering av AI-detektering i hela säkerhetslösningen

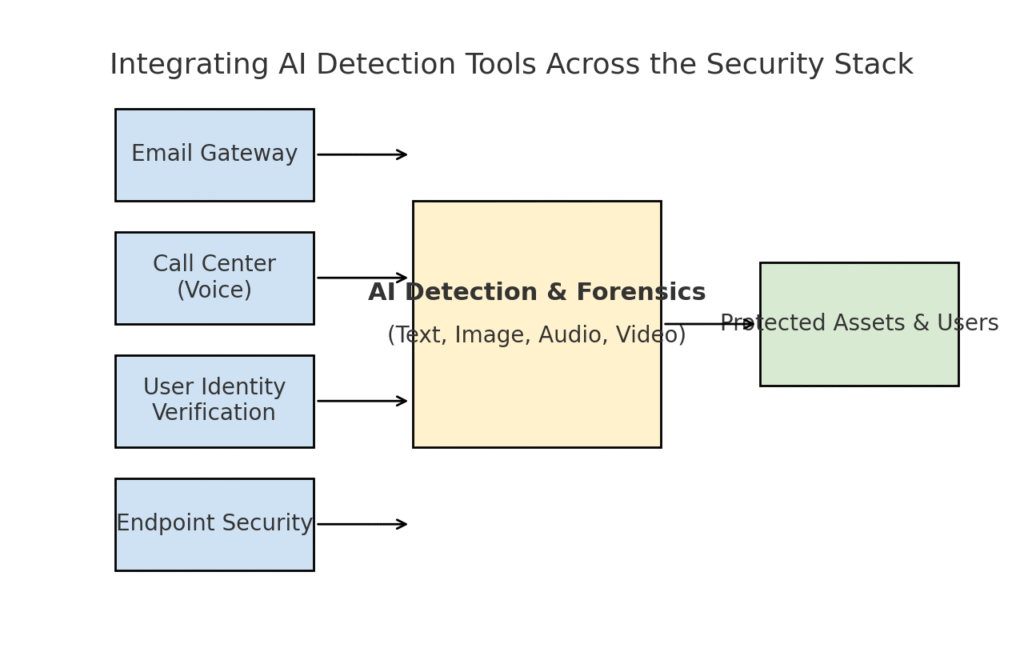

Vi har utforskat flera olika hotområden - nätfiske, deepfakes, skadlig kod, syntetiska bedrägerier - som alla förstärks av AI. Det är tydligt att inget enskilt verktyg eller någon engångslösning kommer att lösa utmaningen. Istället behöver företagen en heltäckande strategi för att inbyggd AI-driven detektering och verifiering i varje lager av deras cybersäkerhetsstrategi. Tillvägagångssättet måste spegla attackytan och täcka e-post, webb, röst, dokument, identitet och mer. Diagrammet nedan illustrerar hur organisationer kan integrera TruthScans AI-detekteringsverktyg (och liknande lösningar) i företagets gemensamma säkerhetslager:

Integrering av AI-detekteringsverktyg i flera lager av säkerhetsstacken - från e-postgateways och callcenter till användarverifiering och endpointskydd. AI-innehållsdetektering (center) analyserar text, bilder, ljud och video i realtid och matas in i verkställighetspunkter som skyddar tillgångar och användare.

I den här modellen, multimodala AI-detektorer fungerar som en central hjärna som har gränssnitt mot olika säkerhetskontroller:

- E-postgateways: Inkommande e-postmeddelanden passerar genom en AI-text/bluffdetektor innan de når inkorgen. Detta knyter an till det phishing-försvar vi diskuterade - t.ex. att använda TruthScans detektor för e-postbedrägerier via API hos din e-postleverantör för att automatiskt sätta misstänkta AI-genererade e-postmeddelanden i karantän[18]. Det kan också tillämpas på meddelandeplattformar (chattappar, SMS-gateways) för att skanna innehåll efter phishing- eller bedrägerimönster.

- Callcenter och röstsystem: Telefon- och VOIP-kanaler säkras genom att integrera deepfake-detektering av röst. Till exempel kan en banks kundsupportlinje använda TruthScans AI-röstdetektor analysera inkommande samtalsljud i realtid och varna om en uppringares röstavtryck är syntetiskt eller inte stämmer överens med den kända profilen[58][59]. Detta bidrar till att förhindra att vishing och röstimitationsattacker (som falska VD-samtal) lyckas.

- Processer för verifiering av användaridentitet: När ett konto skapas eller när användare vidtar åtgärder med hög risk (lösenordsåterställning, banköverföringar) sätts AI-driven identitetsverifiering in. Ett uppladdat foto-ID granskas av ett bildforensikverktyg (t.ex. kontroll av om det är AI-genererat eller ett foto av ett foto), och en selfie eller ett videosamtal granskas av en deepfake-detektor. TruthScan's Deepfake-detektor kan här användas för att utföra ansiktsautentisering - för att säkerställa att personen på kameran är verklig och matchar ID[60][61]. Beteendesignaler (hur ofta man skriver, enhetens konsistens) kan också matas in i AI-modeller för att upptäcka robotar eller syntetiska identiteter.

- Endpoints och nätverk: Endpoint security agents och proxyservrar kan integrera AI-innehållsanalys för filer och skript. Om en endpoint EDR till exempel ser att ett nytt skript eller EXE körs kan den skicka filens textinnehåll till en AI-detektor för att kontrollera om det liknar känd AI-genererad skadlig kod eller uppvisar drag av fördunklad AI-kod. På samma sätt kan DLP-system (system för förebyggande av dataförlust) använda AI-textdetektering för att flagga känslig text som genererats av AI (vilket kan tyda på att en insider använder AI för att utarbeta meddelanden om datautfiltrering eller förfalska rapporter). TruthScans Realtidsdetektor är utformad för att ansluta till sådana arbetsflöden och erbjuder liveanalys av innehåll på olika plattformar med automatiserade svarsalternativ[42][62] (t.ex. automatisk blockering av en fil eller ett meddelande om det identifieras som AI-genererad skadlig kod eller desinformation).

Den viktig fördel av denna integrerade strategi är hastighet och konsistens. AI-attacker sker snabbt - phishing-mejl, falska röster och syntetiska data kan nå många kanaler samtidigt. Genom att förse alla dessa kanaler med AI-detektering får en organisation synlighet i realtid och ett djupgående försvar. Ett team beskrev det som att de skapade ett "AI-immunsystem" för sitt företag: när något kommuniceras (oavsett om det är ett e-postmeddelande, en dokumentuppladdning, ett röstsamtal etc.) "sniffar" AI-immunsystemet det efter främmande (AI-genererade) signaturer och neutraliserar det om det visar sig vara skadligt.

TruthScans företagssvit exemplifierar detta, eftersom den erbjuder en enhetlig plattform AI-detektering av text, bild, ljud och video som kan distribueras modulärt eller som en helhet[63][64]. Många företag börjar med att implementera en eller två funktioner (t.ex. textdetektering i e-post och bilddetektering i onboarding) och utökar sedan med andra när de ser värdet. Integrationen görs dessutom utvecklarvänlig - TruthScan och liknande tjänster tillhandahåller API:er och SDK:er så att säkerhetsteam kan koppla in detektering i befintliga system utan omfattande omkonstruktion. Oavsett om det är en SIEM, en e-postgateway, en anpassad bankapp eller ett CRM-system kan detekteringen köras bakom kulisserna och mata varningar eller automatiserade åtgärder. Till exempel integrerade en stor plattform för sociala medier API:er för innehållsmoderering för att automatiskt ta bort deepfake-videor inom några minuter efter uppladdning[65][66]och förhindra spridning av AI-genererad felaktig information.

Slutsats: Att ligga steget före kurvan

Den snabba spridningen av AI-drivna hot under 2025 har utmanat organisationer på nya sätt. Angripare har hittat sätt att utnyttja människors förtroende i stor skala - genom att imitera röster och identiteter, automatisera social ingenjörskonst, undvika försvar genom adaptiv kod och skapa helt falska verkligheter. Det är ett skrämmande perspektiv för försvarare, men inte hopplöst. Precis som brottslingar utnyttjar AI, kan vi också få AI på säkerhetssidan. Framväxten av AI-detektering av innehåll, deepfake-forensics och skannrar för syntetiska identiteter ger oss kraftfulla motmedel mot dessa nya hot. Genom att använda dessa verktyg och integrera dem i alla lager Genom att bygga upp ett försvar kan företag dramatiskt minska risken för att AI-drivna attacker slinker igenom. Tidiga användare har redan avvärjt bedrägeriförsök på flera miljoner dollar genom att ta deepfakes på bar gärning[26]eller förhindrat phishing-katastrofer genom att filtrera bort AI-skapade e-postmeddelanden.

Utöver tekniken bör organisationer odla en kultur av "lita på men verifiera". Medarbetarna bör vara medvetna om att i AI-eran är det inte alltid så att man tror på det man ser (eller hör) - en sund skepsis i kombination med verifieringsarbetsflöden kan stoppa många socialtekniska knep. Utbildning och medvetenhet i kombination med Automatiserade verifieringsverktyg som TruthScanbildar ett formidabelt försvar. På sätt och vis måste vi höja ribban för autentisering och validering av information. Digital kommunikation och digitala dokument kan inte längre tas för vad de är, utan deras ursprung måste kontrolleras, antingen maskinellt eller genom en process.

När vi går vidare kan vi förvänta oss att angriparna ytterligare förfinar sin AI-taktik - men vi kan också förvänta oss fortsatt innovation inom defensiv AI. Katt-och-råtta-dynamiken kommer att bestå. Framgång för försvarare kommer att hänga på smidighet och delning av information. De som snabbt införlivar ny hotinformation (t.ex. nya tekniker för att upptäcka deepfake eller uppdaterade signaturer för AI-modeller) kommer att ligga steget före angripare som utnyttjar de senaste AI-verktygen. Samarbeten mellan industrin, den akademiska världen och myndigheter kommer också att vara avgörande i den här kampen, vilket framgår av de varningar och ramverk som kommer från myndigheter som NIST:s AI Risk Management Framework och samarbeten mellan banker om AI-detektering av bedrägerier.

Avslutningsvis är cybersäkerhetsindustrin mitt uppe i ett AI-drivet paradigmskifte. Hoten är helt annorlunda än för tio år sedan, men vi möter dem med lika oöverträffade försvar. Med en kombination av avancerad detekteringsteknik och robusta säkerhetsstrategier kan vi kan minska riskerna med generativ AI och till och med vända dem till vår fördel. Verktyg som TruthScans AI-detekteringssvit gör det möjligt för oss att återskapa förtroende i en värld utan förtroende - för att säkerställa att personen i andra änden av linjen är verklig, att dokumentet i vår inkorg är autentiskt och att koden som körs i vårt nätverk inte har manipulerats av en skadlig AI. Genom att investera i dessa funktioner nu kommer organisationer inte bara att skydda sig mot dagens AI-aktiverade attacker utan också bygga motståndskraft mot morgondagens hot. Slutsatsen är tydlig: AI kanske ökar cyberattackerna, men med rätt tillvägagångssätt kan det också öka vårt försvar.

Källor: Relevanta uppgifter och exempel har hämtats från 2025 hotrapporter och experter, inklusive Mayer Browns Cyber Incident Trends[1][67], Fortinet's 2025 hot roundup[2][19], Barracuda-forskning om AI-e-postattacker[6][7], Google GTIG:s rapport om AI-hot[34], Boston Federal Reserve insikter om syntetiska bedrägerier[45][50]och TruthScans publicerade fallstudier och pressmeddelanden[30][26]bland andra. Dessa illustrerar omfattningen av AI-drivna hot och effektiviteten hos AI-fokuserade motåtgärder i verkliga scenarier. Genom att dra lärdom av sådan intelligens och använda avancerade verktyg kan vi med tillförsikt navigera i en tid av AI-förstärkta cyberrisker.

[1] [67] 2025 Cyberincidenttrender Vad ditt företag behöver veta | Insikter | Mayer Brown

[2] [3] [19] Bästa statistiken om cybersäkerhet: Fakta, statistik och intrång för 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] AI-drivet bedrägeri inom finansiella tjänster: Aktuella trender och lösningar | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan upptäcker nordkoreansk Deepfake-attack mot försvarstjänstemän - Bryan County Magazine

[6] [7] [14] Hälften av skräpposten i din inkorg genereras av AI - dess användning i avancerade attacker är i ett tidigare skede | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Q2 2025 Digital Trust Index: Data och insikter om AI-bedrägerier | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] AI Cybersecurity Hot 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Senaste hotinformationen | TruthScan

[18] [63] [64] TruthScan - AI-detektering och innehållssäkerhet för företag

[23] [46] [56] [57] Deepfakes och insättningar: Hur man bekämpar generativa AI-bedrägerier

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake-attacker och AI-genererad nätfiske: Statistik 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI-röstdetektor för deepfakes och röstkloning | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifiera falska och AI-videor - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI-hotspårare: Framsteg i hotaktörers användning av AI-verktyg | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackare fördunklade skadlig kod med mångordig AI-kod

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] AI-detektering i realtid - TruthScan

https://truthscan.com/real-time-ai-detector

[44] EvilAI-operatörer använder AI-genererad kod och falska appar för långt ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Gen AI ökar hotet från bedrägerier med syntetiska identiteter - Federal Reserve Bank of Boston

[53] Syntetiska identitetsbedrägerier 2025: Strategier för AI-detektering och förebyggande