En omfattande guide för att förstå, upptäcka och förhindra bedrägerier med AI-röst i företaget

Röstsamtalet på $25 miljoner som aldrig ägde rum

I februari 2024 fick en finansanställd på ett multinationellt företag i Hongkong ett videosamtal från sin finanschef.

Rösten i andra änden var omisskännlig; varje tonfall, varje paus och till och med den lilla accenten kändes omedelbart igen.

Han bad henne att snabbt behandla 15 banköverföringar på totalt $25 miljoner för att slutföra ett konfidentiellt förvärv.

Oroa dig aldrig för AI-bedrägerier igen. TruthScan Kan hjälpa dig:

- Upptäcka AI-generering bilder, text, röst och video.

- Undvik stora AI-drivna bedrägerier.

- Skydda dina mest känslig Företagets tillgångar.

CFO:n ringde aldrig det samtalet. Det var helt AI-genererat.

Detta var inte ett isolerat fall. Finansiella institutioner ser en brant ökning av deepfake-bedrägerier.

Under de senaste tre åren har antalet fall ökat med 2.137%, och AI står nu för 42,5% av alla bedrägeriförsök i sektorn.

Trots den kraftiga ökningen av AI-baserade röstbedrägerier medger mer än hälften av företagsledarna att deras anställda inte har utbildats för att upptäcka eller reagera på deepfake-attacker; nästan 80% av företagen har inga formella protokoll på plats för att hantera dessa incidenter.

Hur AI-röstkloning fungerar och varför det är ett hot

Modern AI-röstsyntes behöver förvånansvärt lite data. Bara några sekunders ljud kan klona en röst med upp till 85% noggrannhet.

Processen består av tre huvudsakliga steg:

- Datainsamling: Bedragare samlar röstprover från offentliga källor som konferenssamtal, podcastintervjuer, klipp från sociala medier eller till och med LinkedIn-videoinlägg.

- Modellutbildning: AI analyserar röstens egenskaper som tonhöjd, tonläge, accent, tempo och andningsmönster.

- Generation: Systemet skapar syntetiskt tal som är tillräckligt övertygande för att lura även nära kollegor.

Tillgänglighetsproblemet

Det som gör detta hot ännu farligare är dess demokratisering. Bedragare behöver inte längre resurser på Hollywood-nivå.

Allt som krävs är en tillgänglig programvara för att klona en röst från ett kort klipp på sociala medier; verktyg med öppen källkod och molnbaserade AI-tjänster har gjort röstkloning tillgänglig för alla med grundläggande tekniska färdigheter.

Varför chefer är de främsta måltavlorna för bedrägerier

Ledande befattningshavare står inför en farlig blandning av riskfaktorer.

Deras offentliga exponering via sociala medier gör att röstprover är lätta att hitta, och deras auktoritet får ofta anställda att agera snabbt på brådskande förfrågningar.

I genomsnitt har en av fyra chefer en begränsad förståelse för deepfake-teknik.

Aktuell statistik ger en oroande bild

I en 2024 Deloitte-undersökning, 25,9% av cheferna sade att deras organisationer hade utsatts för minst en deepfake-incident riktad mot finansiella data eller redovisningsdata under det senaste året, och hälften av alla tillfrågade trodde att sådana attacker skulle öka under de kommande 12 månaderna.

Mest oroande: endast 52% av organisationerna känner sig säkra på att de skulle kunna upptäcka en deepfake av sin VD.

Hur man upptäcker bedrägerier med AI-röst

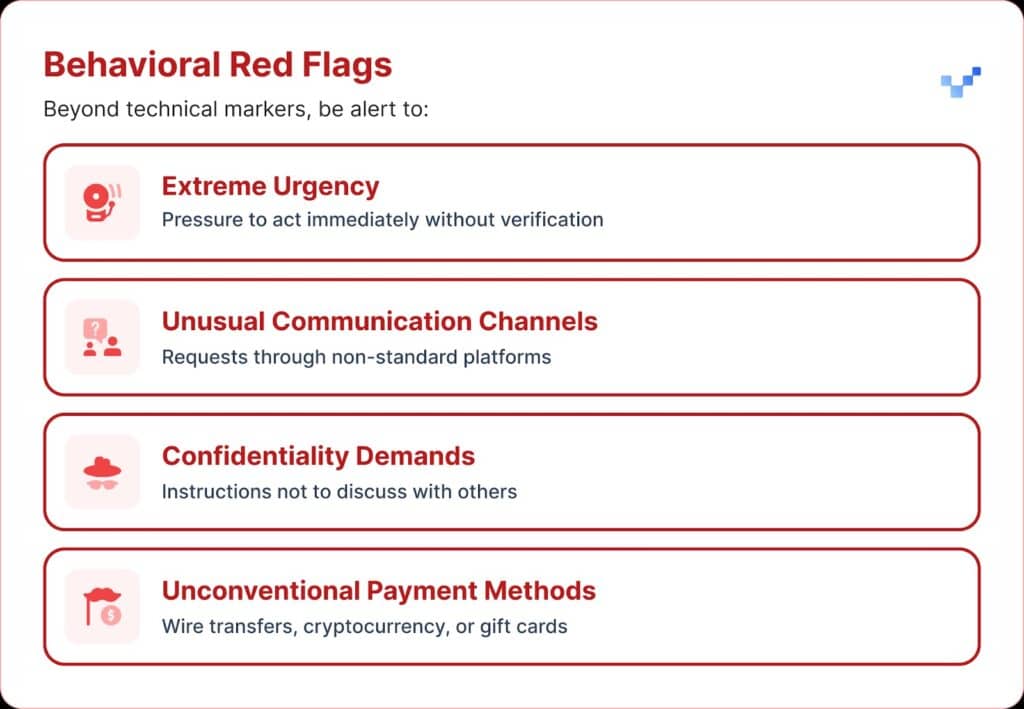

När du får ett misstänkt röstmeddelande finns det några varningssignaler att hålla utkik efter.

AI-röstbedrägerier låter ofta monotona eller platta. Du kanske också märker ett ovanligt tempo, med konstiga pauser eller en onaturlig rytm.

Ljudet kan också innehålla svagt elektroniskt surrande eller eko, särskilt under längre samtal.

Och i många fall upprepar rösten begränsade fraser som ser ut att vara skrivna eller inövade.

Finansiell påverkan och vad det verkligen kostar

De flesta organisationer förlorade i genomsnitt cirka $450.000, men inom sektorn för finansiella tjänster steg förlusterna till över $603.000.

Och i de allvarligaste fallen rapporterade 1 av 10 organisationer förluster på mer än $1 miljon.

Denna trend har vuxit snabbt. Tidigare forskning från 2022 visade att den genomsnittliga ekonomiska bördan av identitetsbedrägerier var cirka $230.000, nästan hälften av den nuvarande siffran.

Beräknade framtida förluster

Enligt Deloittes Center for Financial Services kan de pengar som går förlorade på grund av AI-bedrägerier i USA öka från $12,3 miljarder 2023 till $40 miljarder 2027. Det är ungefär 32% tillväxt varje år.

Regional sårbarhet

Nordamerika upplevde en ökning av deepfake-bedrägerier med 1740%.

Denna betydande regionala ökning tyder på att Nordamerika kan vara ett primärt mål för deepfake-bedrägerier, sannolikt på grund av dess stora digitala ekonomi och utbredda användning av onlinetjänster.

Strategiska tillvägagångssätt för skydd av chefer

1. Implementera verifieringsprotokoll

Ett sätt att stärka försvaret är att använda ett system med "säkra ord", dvs. på förhand överenskomna autentiseringsfraser som delas med nyckelpersoner.

En bedragare som använder AI-röstkloning kommer inte att veta rätt svar på personliga verifieringsfrågor.

En annan säkerhetsåtgärd är verifiering i flera kanaler.

Alla ovanliga ekonomiska förfrågningar ska bekräftas via en separat kommunikationskanal och aldrig enbart genom den ursprungliga kontaktmetoden.

Företagen bör också sätta upp tydliga regler för eskalering, med väntetider och godkännandesteg för stora finansiella transaktioner, oavsett vem som begär dem.

2. Tänk på den digitala exponeringen

Ett annat lager av skydd kommer från att begränsa hur mycket verkställande ljud och video som finns tillgängligt online. Ju fler prover bedragare kan samla in, desto mer övertygande blir deras kloner.

Det är också bra att fastställa tydliga riktlinjer för sociala medier för chefer, särskilt när det gäller att publicera videor med rent ljud.

Och när det gäller konferenser bör organisationer vara uppmärksamma på inspelade föredrag eller intervjuer som ger bort långa sträckor av röstprov.

3. Implementera tekniska lösningar

Det är här som avancerad AI-detekteringsteknik blir avgörande.

Organisationer behöver företagsklassad röstautentisering och deepfake-detektering kapacitet som ger:

- Analys i realtid: Upptäcka syntetiska röster under live-kommunikation

- Historisk verifiering: Analysera inspelade samtal och meddelanden för äkthet

- Integrationskapacitet: Fungerar sömlöst med befintliga kommunikationsplattformar

- Hög noggrannhet: Minimera antalet falska positiva resultat samtidigt som sofistikerade förfalskningar fångas upp

4. Omfattande utbildningsprogram

Ledningsgrupper behöver riktad utbildning om hot från AI-röster och verifieringsprocedurer.

Lika viktigt är det att öka medarbetarnas medvetenhet.

Alla, oavsett roll, bör vara utrustade för att kunna upptäcka potentiella deepfakes och förhindra att cyberhot kommer in i organisationen.

Regelbundna simuleringsövningar kan stärka denna beredskap genom att använda falska röstbedrägeriförsök för att testa och förfina svarsprocedurerna.

Avancerade AI-lösningar för röstdetektering

Traditionella försvar byggdes för nätverksbaserade hot, inte för AI-drivna mänskliga imitationer.

De främsta anledningarna till att vanliga cybersäkerhetsverktyg inte kan hantera röstbaserad social ingenjörskonst:

- Ingen signatur för skadlig kod: Röstsamtal utlöser inte traditionella säkerhetssystem

- Den mänskliga förtroendefaktorn: Människor litar naturligt på vad de hör, särskilt när det gäller bekanta röster

- Upptäckt av tekniska luckor: Trots ökningen av AI-drivna bedrägeriförsök, inklusive deepfakes, har endast 22% av finansinstituten implementerat AI-baserade verktyg för att förebygga bedrägerier

Behovet av specialiserad röstdetektering

Moderna röstbedrägerier kräver moderna detekteringsfunktioner.

Företagsklassad AI-system för röstdetektering kan:

- Analysera biomarkörer för röst: Upptäcka subtila inkonsekvenser i syntetiskt tal

- Realtidsbearbetning: Ge omedelbara varningar vid misstänkta samtal

- Kontinuerligt lärande: Anpassa till nya tekniker för röstsyntes

- Redo för integration: Arbeta med befintlig kommunikationsinfrastruktur

Organisationer som verkligen vill skydda sig mot röstbedrägerier måste investera i specialbyggd AI-detekteringsteknik som kan matcha de sofistikerade hoten de står inför.

Röstbedrägerier är här nu, och det eskalerar

Under första kvartalet 2025 orsakade deepfake-bedrägerier och identitetsstölder över $200 miljoner i förluster.

Röstphishing med AI-kloner hoppade 442%, och mer än 400 företag om dagen drabbas av deepfake CEO- eller CFO-bedrägerier.

Medan 56% av företagen säger att de känner sig mycket säkra på att upptäcka deepfakes, är det bara 6% som faktiskt har undvikit att drabbas av ekonomiska förluster på grund av dem.

Det viktiga är inte om din organisation kommer att utsättas för angrepp, utan om du är redo för det.

Röstbedrägerier håller på att förändra cybersäkerheten. Traditionella försvar kan inte hålla jämna steg med AI-drivna imitationer.

För att hålla sig skyddade behöver organisationerna bättre detekteringsverktyg, starka utbildningsprogram och tydliga verifieringsrutiner.

Tekniken för att slå tillbaka finns redan här. Den verkliga frågan är om du kommer att använda den före eller efter din första incident med röstbedrägerier.