Inledning

Artificiell intelligens förändrar det finansiella bedrägerilandskapet på ett sätt som aldrig tidigare skådats. I början av 2024 använde bedragare AI-genererade deepfakes för att utge sig för att vara chefer i ett videosamtal och lurade en anställd i Hongkong att överföra $25 miljoner till bedragarna[1][2]. Händelser som denna visar hur generativ AI gör det möjligt för brottslingar att skapa mycket övertygande bedrägerier som riktar sig mot banker och deras kunder. Tillsynsmyndigheter slår larm: det amerikanska finansdepartementets FinCEN utfärdade i slutet av 2024 en varning om ökande bedrägerier med hjälp av AI-genererade "deepfake"-medier, inklusive falska identitetshandlingar för att kringgå bankverifieringar[3][4]. Detta whitepaper undersöker de senaste Trender för AI-bedrägerier inom finansiella tjänster och diskuterar hur institutioner kan stärka sina försvar. Vi undersöker hur bedragare använder generativ AI som vapen - från deepfake-imitationer till syntetiska identiteter - och beskriver teknik och strategier (inklusive avancerade detekteringsverktyg som TruthScan) som bedrägeriteam och chefer kan använda för att motverka detta föränderliga hot.

Viktiga AI-bedrägeritrender inom finansiella tjänster

AI och maskininlärning utnyttjas av dåliga aktörer för att genomföra bedrägerier i större skala och på ett mer sofistikerat sätt. Anmärkningsvärt AI-driven bedrägeritaktik som påverkar banker, fintech-företag och försäkringsbolag inkluderar:

- Bedrägerier med Deepfake-imitation: Brottslingar använder AI-genererad video och ljud för att i realtid utge sig för att vara betrodda personer (VD:ar, kunder etc.). Exempelvis har verklighetstrogna deepfake-röster använts i vishing-attacker (voice phishing) för att godkänna bedrägliga banköverföringar, och AI-skapade videor har lurat anställda att godkänna falska transaktioner[1][5]. Dessa syntetiska medier gör det svårt att veta om du verkligen talar med den person du tror att du är, vilket möjliggör värdefulla rån som $25M deepfake-fallet ovan. Deepfakes håller på att bli prisvärd och enkel att producerasom kräver så lite som 20-30 sekunders ljud för att klona en röst, eller mindre än en timme för att generera en till synes autentisk video[6].

- AI-förstärkt nätfiske och BEC: Generativ AI sätter turbo på social ingenjörskonst som phishing-mejl och Kompromittering av företags e-post (BEC). AI-chattbottar kan skriva mycket personliga bluffmejl på ett perfekt affärsspråk, härma en vd:s skrivstil eller skapa övertygande falska leverantörsfakturor i stor skala. Faktum är att underjordiska verktyg som BedrägeriGPT och WormGPT (ofiltrerade versioner av ChatGPT) har dykt upp för att hjälpa cyberbrottslingar att automatisera phishing och skapande av skadlig kod[7][8]. Det innebär att en potentiell bedragare med minimala färdigheter enkelt kan generera sofistikerade nätfiskekampanjer eller skadlig kod. Med AI kan en enda brottsling skicka ut tusentals skräddarsydda bluffmejl eller textmeddelanden, vilket avsevärt ökar räckvidden för traditionella bedrägeriförsök. FBI:s Internet Crime Center har redan observerat över $2,7 miljarder kronor förlorade på grund av BEC-bedrägerier 2022, och generativ AI hotar att öka dessa förluster ännu mer under de kommande åren[9][10].

- Syntetiska identiteter och dokumentbedrägeri: Generativ AI driver på en boom av bedrägerier med syntetiska identiteter, en av de snabbast växande typerna av ekonomisk brottslighet[11][12]. Bedragare kombinerar riktiga och falska personuppgifter för att skapa "Frankenstein"-identiteter och använder sedan AI för att ta fram realistiska styrkande handlingar - från falska pass och kontoutdrag till lönespecifikationer[7]. AI-bildgeneratorer och redigeringsverktyg kan förfalska ID-handlingar och foton som ser äkta ut som klarar en tillfällig inspektion. Även livskontroller eller selfieverifieringar kan potentiellt utmanövreras med AI-manipulerade bilder eller video. Genom att automatisera skapandet av tusentals falska identiteter (var och en med AI-genererade profilbilder, sociala medier etc.) kan brottslingar öppna bankkonton eller ansöka om lån i massor och tvätta pengar eller inte betala sina krediter. Förlusterna från bedrägerier med syntetiska identiteter uppskattades till cirka $35 miljarder år 2023[13]och generativ AI påskyndar bara denna trend genom att göra falska identiteter billigare och svårare att upptäcka.

- Automatiserat bedrägeri och undandragande: AI skapar inte bara falskt innehåll, utan hjälper också bedragare maximera framgången för sina program. Avancerade robotar kan snabbt testa stulna kreditkortsuppgifter på e-handelssajter och använda ML för att undvika upptäckt. AI kan hjälpa brottslingar att identifiera de svagaste länkarna i en organisations säkerhet eller till och med syntetisera röstsvar för att besegra telefonbaserad identitetsverifiering. En liten industri på den mörka webben säljer nu AI-verktyg för "bedrägeri som tjänst" för så lite som $20[14]. Denna demokratisering av AI-kapacitet innebär att även kriminella på låg nivå kan genomföra mycket sofistikerade bedrägeriattacker. Kapprustningen sträcker sig till att undvika upptäckt - bedragare använder AI för att undersöka bankernas system för bedrägeribekämpning och förfinar sin metod tills de hittar en metod som slinker igenom filtren[15]. Kort sagt, AI gör det möjligt att genomföra bedrägerier i en omfattning och med en effektivitet som aldrig tidigare skådatsoch utmanar det konventionella försvaret.

Dessa AI-baserade taktiker är redan sprider sig i en alarmerande takt. Traditionella bedrägerier som checkförfalskning och nätfiske har förekommit i åratal, men AI ökar deras volym och realism. Uppgifterna berättar en tydlig historia: AI-bedrägerier är översvämning.

Oroa dig aldrig för AI-bedrägerier igen. TruthScan Kan hjälpa dig:

- Upptäcka AI-generering bilder, text, röst och video.

- Undvik stora AI-drivna bedrägerier.

- Skydda dina mest känslig Företagets tillgångar.

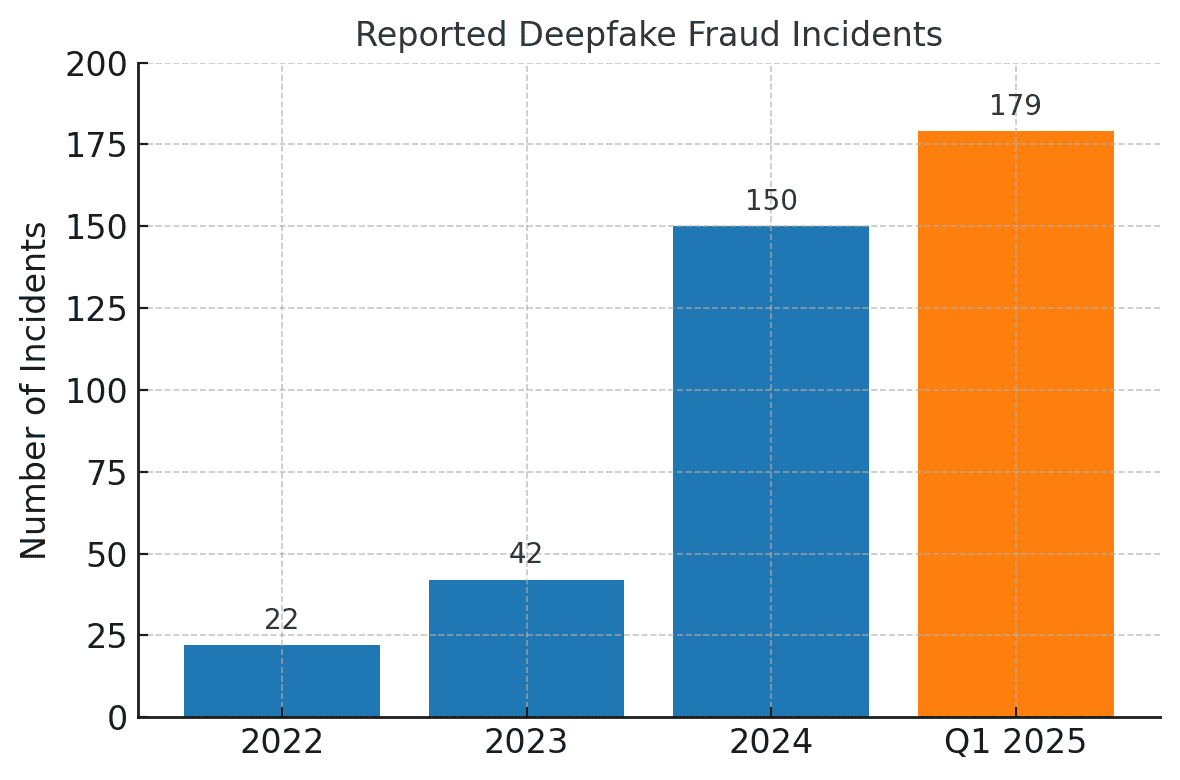

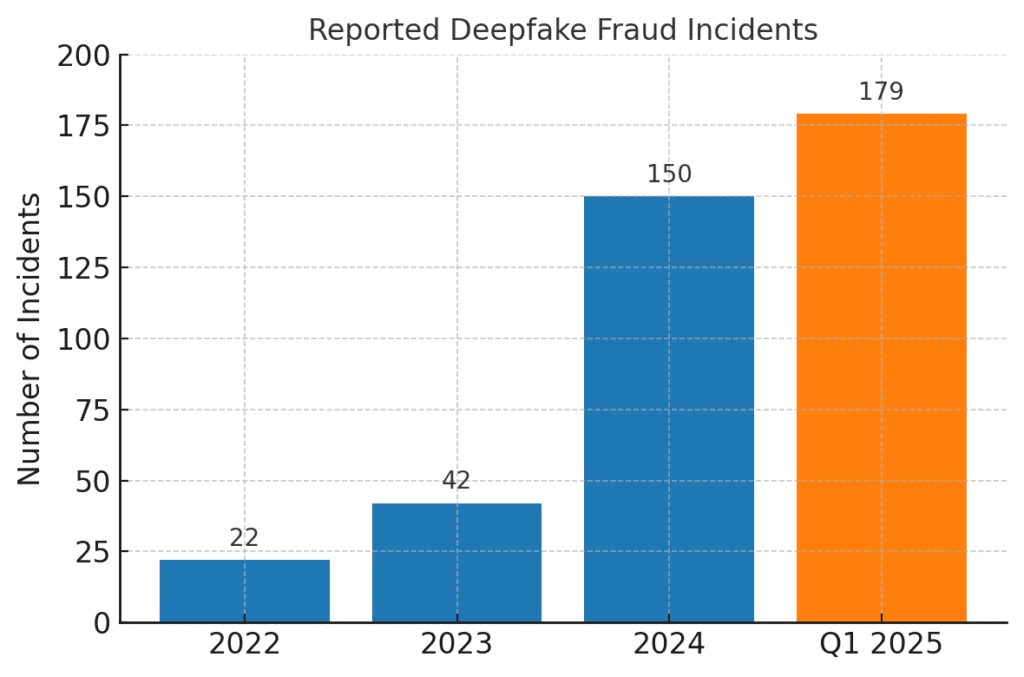

Deepfake-relaterade bedrägerier har skjutit i höjden. År 2022 registrerades endast 22 fall av deepfake-bedrägerier, men 2023 var det 42 och 2024 exploderade incidenterna till 150. Bara under det första kvartalet 2025, 179 incidenter med deepfake-bedrägerier rapporterades - vilket överstiger den totala siffran för hela 2024[16][17].

Nya branschanalyser bekräftar dessa trender. En rapport noterade en 700% ökning av antalet deepfake-incidenter med inriktning på fintech-företag 2023[18]. Ännu mer häpnadsväckande är att Nordamerika såg en 1,740% Ökning av antalet fall av deepfake-bedrägerier mellan 2022 och 2023[19]. Finansiella brottslingar använder dessa verktyg snabbt eftersom de fungerar - många banker och offer är ännu inte beredda att upptäcka AI-genererade bedrägerier.

Effekter och utmaningar för finansinstitut

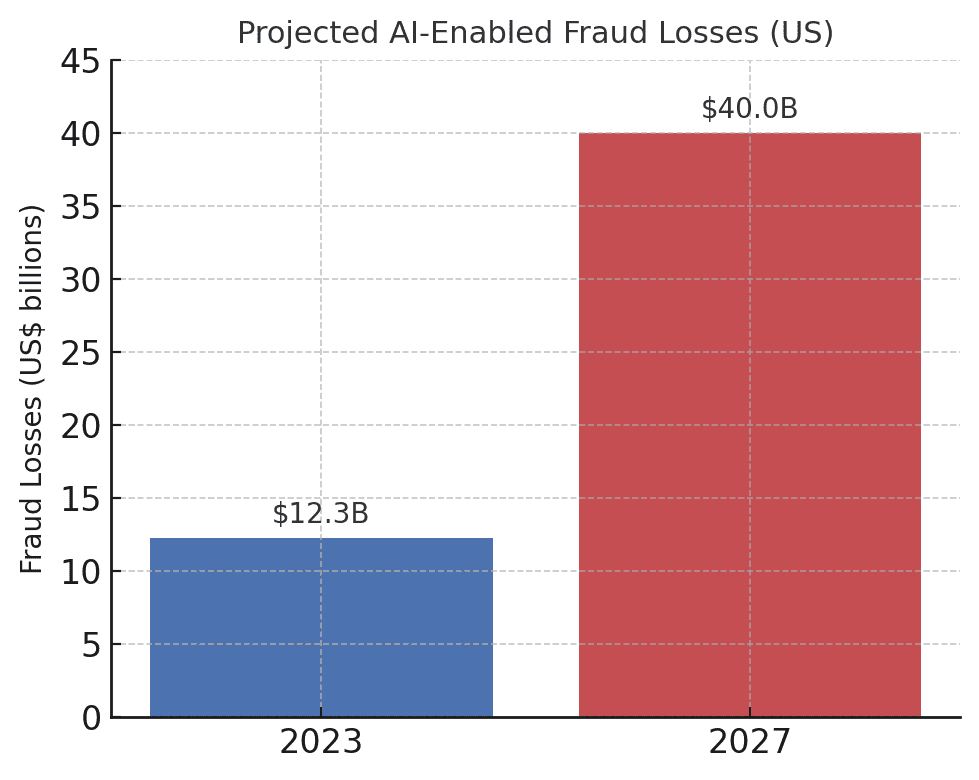

Ökningen av AI-drivna bedrägerier utgör betydande påverkan på finansinstituten, deras kunder och det finansiella systemet i stort. Den mest omedelbara effekten är monetära förluster. Branschprognoser förutspår att 2027, Bedrägeriförluster som möjliggörs av generativ AI kan uppgå till $40 miljarder i USA, upp från $12,3 miljarder år 2023[20]. Denna mer än trefaldiga ökning (a 32% CAGR) återspeglar hur snabbt bedrägeririsken ökar i dollar räknat.

Förväntade förluster från AI-baserade bedrägerier ökar dramatiskt. Deloitte uppskattar att förlusterna för finansiella bedrägerier i USA kopplade till generativ AI kommer att stiga från $12,3 miljarder år 2023 till $40 miljarder år 2027[20].

Utöver de faktiska förlusterna tillkommer ryktes- och förtroendekostnader. Konsumenterna förväntar sig att deras banker ska skydda dem - men bedrägerier med hjälp av AI undergräver förtroendet för digitala kanaler. Om en kund till exempel faller offer för ett övertygande deepfake-bedrägeri (som ett falskt videosamtal med en bankman) kan kunden anklaga banken för bristande säkerhet. Allmänhetens förtroende i röstverifiering, e-post och till och med videokonferenser kan urholkas om "det du ser/hör" inte längre kan antas vara verkligt[21]. Enligt undersökningar anser 85% av finansproffs i USA / Storbritannien att deepfake-bedrägerier är ett "existentiellt" hot mot deras organisations säkerhet[22]. Mer än hälften av företagen på dessa marknader rapporterar att de har utsatts för en deepfake-driven bluff, och alarmerande nog 43% av dem som attacken riktades mot medgav att attacken lyckades i att lura dem[23]. Varje lyckad incident orsakar inte bara ekonomisk skada utan undergräver också kundernas förtroende för institutionen.

Finansiella företag brottas också med utmaningar för verksamhet och efterlevnad från AI-bedrägerier. Antibedrägeriteamen står inför en kraftig ökning av varningar och incidenter, vilket tär på utredningsresurserna. Befintliga modeller för att upptäcka bedrägerier (varav många bygger på regler eller äldre maskininlärningstekniker) kan ha svårt att känna igen AI-syntetiserat innehåll som ser legitimt ut. Faktum är att toppmoderna deepfake-detekteringssystem som utvecklats i laboratorier ser sin noggrannhet sjunka med nästan 50% när de konfronteras med verklighetstrogna deepfakes i det vilda[24]. Mänsklig personal klarar sig inte mycket bättre - studier visar att människor bara kan upptäcka högkvalitativa deepfake-videor runt 55%-60% av tiden, knappt bättre än chans[25]. Detta tyder på att bankerna utan nya verktyg kommer att missa en stor del av de AI-drivna bedrägeriförsöken.

Det finns också en regleringsdimension. Tillsynsmyndigheter och brottsbekämpande myndigheter är mycket medvetna om riskerna (vilket framgår av FinCEN:s varning) och de förväntar sig att finansinstituten anpassar sig. Bankerna kan komma att ställas inför tuffare riktlinjer för kundverifiering och bedrägerirapportering i AI-eran. Om en bankanställd till exempel blir lurad av en deepfake att godkänna en överföring på $10 miljoner kan tillsynsmyndigheterna komma att granska bankens kontroller och due diligence-processer. Den Lag om banksekretess omfattar nu uttryckligen rapportering av misstänkt cyberbrottslighet och deepfake-relaterad verksamhet[26][4]vilket innebär att bankerna måste utbilda personalen i att känna igen och rapportera AI-genererade bedrägeriindikatorer i rapporter om misstänkt aktivitet (SAR). Att inte hålla jämna steg med AI-förbättrade bedrägeritekniker kan leda till överträdelser av regelefterlevnad eller juridiskt ansvar om kunder eller motparter hävdar att banken inte gjorde tillräckligt för att förhindra förutsebara AI-aktiverade bedrägerier.

Den kanske största utmaningen är asymmetriska karaktären hos detta nya hot. Generativ AI sänker kraftigt kostnaden och kompetensbarriären för angripare, samtidigt som volymen och realismen i attackerna ökar exponentiellt. Ett enda viralt deepfake-rykte eller ett övertygande röstklonsamtal kan omintetgöra investeringar i autentisering som uppgår till miljontals dollar. Samtidigt måste försvararna verifiera äktheten i varje transaktion och interaktion, vilket är en mycket svårare uppgift. Det är verkligen en kapprustning: AI ger bedragare en självuppdaterande verktygslåda för att kringgå säkerheten, vilket kräver att bankerna ständigt uppdaterar sina försvar också[15][27]. Många finansinstitut medger att de inte är tillräckligt förberedda - över 80% av företagen saknar en formell beredskapsplan för deepfake-attackeroch mer än hälften har inte gett någon utbildning till anställda om riskerna med deepfake[28][29]. Denna beredskapsklyfta innebär att organisationerna för närvarande är sårbara, men den visar också var det behövs åtgärder.

En anmärkningsvärd och nedslående siffra kommer från en nyligen publicerad branschrapport: 42,5% av bedrägeriförsöken inom finanssektorn involverar nu någon form av AI[30]. Med andra ord har nästan hälften av de bedrägeriattacker som bankerna utsätts för en AI-komponent - oavsett om det handlar om ett AI-genererat dokument, en syntetiserad röst eller ett maskingenererat phishingmeddelande. Den här statistiken understryker att AI inte är ett hypotetiskt framtida hot; det är redan här och tvingar finansinstituten att anpassa sig eller drabbas av allt större förluster.

Försvar mot AI-baserade bedrägerier: Strategier och lösningar

För att hantera AI-drivna bedrägerier krävs en utveckling av strategierna för bedrägeribekämpning. Traditionella metoder (som manuell verifiering eller statiska regelmotorer) är ingen match för formskiftande AI-bedrägerier. Istället måste bankerna anamma technology (like making sure they have a Secure SSL Certificate), training, and teamwork för att vända utvecklingen. Nedan redogör vi för viktiga strategier och nya lösningar:

- Utnyttja AI för att bekämpa AI (avancerade detekteringsverktyg): Finansiella institutioner vänder sig i allt högre grad till AI-drivna detekteringslösningar för att identifiera AI-genererat innehåll och avvikelser. I grund och botten måste du bekämpa eld med eld. Nya företagsverktyg som t.ex. TruthScan erbjuder multimodal AI-detektering av text, bilder, röst och video för att hjälpa till att autentisera innehåll i realtid[31]. Banker kan t.ex. använda AI-textdetektorer för att skanna inkommande kommunikation (e-post, chattmeddelanden) efter tecken på AI-genererat språk som kan tyda på ett phishing-meddelande eller en falsk kundförfrågan. TruthScans AI-textdetekteringssystem kan identifiera AI-skrivet innehåll från modeller som GPT-4 med 99%+ noggrannhetoch till och med peka ut vilka meningar som sannolikt är AI-genererade[32][33]. På samma sätt kan AI-verktyg för bildforensik verifiera dokument och bilder; en AI-bilddetektor kan flagga för om ett inlämnat körkort eller en elräkning har skapats eller manipulerats digitalt genom att jämföra det med kända mönster av AI-genererade bilder[34]. För ljudhot börjar bankerna använda röst djupa falska detektorer - lösningar som analyserar samtalsljud för att hitta akustiska fingeravtryck av syntetiskt tal. TruthScans AI Voice Detector, till exempel, lyssnar efter tydliga tecken på röstkloning och kan verifiera talarens äkthet för att förhindra samtal från bedragare[35]. Genom att integrera dessa detektorer via API i sina arbetsflöden kan finansinstitut automatiskt söka efter AI-innehåll i bakgrunden av transaktioner och interaktioner. Detta ger ett ytterligare försvarslager som fungerar i maskinhastighet och fångar upp det som mänskliga ögon/öron kan missa.

- Implementera multifaktor- och out-of-band-verifiering: Eftersom AI gör det svårare att lita på röster eller bilder bör bankerna förlita sig mer på verifieringsmetoder som AI inte enkelt kan förfalska. Detta inkluderar multifaktorautentisering (MFA) med hjälp av säkra kanaler. Om en begäran om banköverföring till exempel kommer via e-post eller videosamtal ska en andra faktor krävas, till exempel ett engångslösenord som skickas till den begärandes kända mobila enhet eller en återuppringning på ett betrott telefonnummer som finns i arkivet. Vissa banker lägger till "liveness"-kontroller för högrisk-transaktioner - till exempel genom att be en kund att ta en selfie i realtid med en specifik gest eller ett specifikt ord, vilket är svårare för en deepfake-video att replikera. Biometriska autentiserare kan förbättras med åtgärder mot förfalskning (t.ex. skanning för 3D-ansiktsdjup eller övervakning av de subtila ögonrörelser som deepfakes ofta misslyckas med att efterlikna).[27]). Nyckeln är att undvika enskilda felkällor. Även om en AI deepfake kan lura en kanal (t.ex. röstverifiering), kan en samordnad kontroll utanför bandet eller ett biometriskt test ge den utmaning som krävs för att avslöja bedrägeriet. Principer om nolltolerans bör tillämpas: Behandla alla oönskade eller oväntade instruktioner (även från en "känd" chef eller kund) som misstänkta tills de har verifierats genom en oberoende kanal.

- Utbildning av medarbetare och medvetenhet om bedrägerier: Enbart teknik är ingen patentlösning - särskilt eftersom bedragare kommer att rikta in sig på den svagaste länken, vilket ofta är mänskligt förtroende. Finansiella institutioner bör investera i regelbunden utbildning för bedrägeriförebyggande team och frontpersonal om AI-baserade bedrägerier. Anställda måste lära sig att känna igen röda flaggor för deepfakes och social ingenjörskonst. Detta kan inkludera utbildning om subtila avvikelser (t.ex. problem med läppsynkronisering i ett videosamtal, eller ljud som innehåller onaturlig intonation eller för lite bakgrundsljud - potentiella tecken på en syntetisk röst). Uppmuntra en kultur av verifieringMedarbetarna ska känna sig bemyndigade att avbryta en misstänkt transaktion eller begäran och verifiera den på egen hand, även om den verkar komma från VD. Fallet med Försök till röstförfalskning av Ferraris VD är lärorikt - en chef avslöjade bara bedrägeriet genom att ställa en personlig fråga som bedragaren inte kunde besvara[36]. Simulerade phishing/deepfake-övningar kan också vara användbara. På samma sätt som företag genomför phishing-simuleringar för att utbilda personalen kan de simulera ett falskt röstmeddelande eller ett falskt videomöte och se om de anställda upptäcker det. Detta bygger upp ett muskelminne för att motstå verkliga attacker. Med tanke på att mer än 50% av företagen har inga protokoll för deepfake-respons och lite utbildning på plats[29]att införa sådana program är en lågt hängande frukt för att förbättra motståndskraften.

- Analys av bedrägerier och upptäckt av avvikelser: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier ljud AI-genererade eller alltför formelartade (i kombination med AI-textdetektering som nämndes tidigare). Banker som JPMorgan har börjat använda stora språkmodeller på sin interna kommunikation för att upptäcka fraser eller sammanhang som kan tyda på ett försök till social ingenjörskonst[37]. Betalningsnätverk som Mastercard skannar stora datamängder (miljarder transaktioner) med AI för att identifiera bedrägliga transaktioner som traditionella regler skulle missa[38]. Det vi kan ta med oss är att defensiv AI måste vara lika innovativ som offensiv AI. Företag bör överväga att utveckla eller köpa AI-modeller specifikt för att upptäcka deepfake-innehåll, syntetiska identiteter och generativa attackmönster. Avgörande är att dessa modeller kontinuerligt omskolas med de senaste exemplen på AI-bedrägerier (en metod som kallas onlineinlärning eller federerad inlärning) så att de håller jämna steg med brottslingarnas snabbt föränderliga taktik[39][40].

- Samarbete och informationsutbyte: För att bekämpa bedrägerier med hjälp av AI krävs samarbete både inom och mellan institutioner. Ensidiga insatser är mindre effektiva mot ett hot som överskrider organisationsgränserna. Bedrägeribekämpningsteam, cybersäkerhetsteam och IT måste arbeta hand i hand - till exempel kan säkerhetsteam använda deepfake-detektering i videokonferensverktyg, medan bedrägeriteam integrerar innehållsskanningar i transaktionsövervakning. På en bredare nivå bör bankerna delta i branschgrupper som Financial Services Information Sharing and Analysis Center (FS-ISAC) för att utbyta information om nya AI-bedrägerier.[41]. Om en bank upptäcker en ny deepfake-attackvektor kan den genom att dela med sig av sina insikter hjälpa andra att täppa till luckan innan de drabbas. Gemensamma övningar eller "red team"-simuleringar med scenarier som involverar AI (t.ex. ett deepfake-bedrägeri eller AI-genererad ID-verifiering) kan genomföras genom branschkonsortier eller med stöd från tillsynsmyndigheter. Tillsynsmyndigheterna själva fokuserar på AI-risker, så det är klokt att samarbeta med dem proaktivt. Genom att bidra till standarder och riktlinjer för AI-användning kan bankerna hjälpa till att forma ett säkrare ekosystem. I slutändan, eftersom ett hot mot en bank är ett hot mot alla i detta utrymme[42]En kollektiv försvarsstrategi kommer att stärka allas förmåga att upptäcka och avskräcka från AI-förstärkta bedrägerier.

- Åtgärder för kundutbildning och förtroende: Slutligen bör finansinstituten inte förbise betydelsen av kundmedvetenhet. Eftersom deepfakes och AI-bedrägerier riktar sig till allmänheten (t.ex. falska röster i mor- och farföräldrabedrägerier eller falska chattar med "teknisk support" som genereras av AI) kan bankerna hjälpa till att utbilda kunderna om dessa faror. Många banker skickar redan varningar om nätfiske; de kan utöka dessa till att nämna AI-röstkloning och deepfake-videor och ge tips om hur man verifierar förfrågningar. Vissa progressiva organisationer skickar push-meddelanden eller varningar i sina appar om ett känt bedrägeri cirkulerar (t.ex. "Akta dig: bedragare kan använda röstkloner av familjemedlemmar som ber om pengar")[43]. Även om utbildning inte direkt förhindrar attacker kan den minska andelen lyckade attacker och förstärka bilden av att banken är en partner i säkerhetsfrågor. Banker som investerar i avancerad bedrägeribekämpning bör dessutom lyfta fram detta för kunderna som en Differentiator - Om kunderna till exempel får veta att alla videosamtal eller dokument som skickas in skannas av AI för att kontrollera äktheten (utan att känsliga metoder avslöjas) kan det försäkra kunderna om att banken använder alla tillgängliga verktyg för att skydda dem. Att bevara det digitala förtroendet kommer att vara avgörande för att bankerna fullt ut ska kunna utnyttja AI:s fördelar inom tjänstesektorn, så transparens och kundfokuserade skyddsåtgärder är en del av ett holistiskt försvar.

Rollen för AI-tjänster för innehållsdetektering

En hörnsten i verktygslådan för bedrägeribekämpning i AI-eran är användningen av Tjänster för AI-detektering av innehåll. Dessa tjänster är specialiserade på att upptäcka "fingeravtryck" av AI-genererat innehåll som kan slinka förbi mänskliga granskare. TruthScan är en sådan leverantör som erbjuder en företagsklassad Suite för AI-detektering som spänner över flera olika innehållstyper. Finansiella institutioner kan integrera dessa verktyg för att automatiskt söka efter förfalskningar och bedrägeriindikatorer:

- Verifiering av dokument och bilder: TruthScans plattform gör det möjligt för banker att testa finansiella dokument för AI-genererade bedrägerier i realtid[44]. Det innebär att när ett nytt konto öppnas eller en låneansökan kommer in med foto-ID och lönespecifikation kan systemet omedelbart analysera dessa bilder för tecken på syntetisk generering eller manipulering. Med över 99% målprecision[45]AI Image Detector kan fånga upp falska ID-bilder eller manipulerade PDF-filer som en människa skulle kunna godkänna på förhand. Den här typen av kontroll av dokumentens äkthet är avgörande för att stoppa bedrägerier med syntetiska identiteter innan konton ens öppnas.

- Transaktionsövervakning i realtid: Genom att distribuera API-integrationer kan TruthScan koppla upp sig mot bankernas transaktionshantering och flagga för avvikelser i i realtid. Om en instruktion kommer via e-post som verkar misstänkt kan Email Scam Detector analysera innehållet i meddelandet och upptäcka om det troligen har skrivits av en AI-modell som försöker förfalska en leverantör eller chef[46]. På samma sätt kan AI-detektor i realtid kan övervaka livekommunikation (t.ex. chattar eller samarbetsplattformar) för att ge omedelbara varningar om t.ex. ett falskt videoflöde från en bedragare upptäcks under ett möte med höga insatser[47][48]. Kontinuerlig övervakning med omedelbara varningar och automatiserade svar bidrar till att krympa det fönster där bedrägerier kan ske utan att upptäckas.

- Deepfake-försvar för röst och video: För callcenters och kundansvariga kan införlivandet av TruthScans AI-röstdetektor lägger till ett extra lager av säkerhet. Om en bedragare ringer in och utger sig för att vara en kund med hjälp av en röstklon kan systemet analysera samtalsljudet och flagga om det innehåller AI-syntetiserade element (t.ex. saknade naturliga mikropauser eller artefakter i ljudvågorna).[35]. På videofronten är Deepfake-detektor använder datorseendealgoritmer på videobilder för att hitta inkonsekvenser - som onaturliga ansiktsrörelser, konstig belysning eller felaktig läppsynk - som avslöjar en förfalskning[49][50]. Genom att verifiera integriteten hos röster och ansikten i viktiga interaktioner kan bankerna hindra bedragare från att försöka lura sina anställda. Dessa verktyg fungerar som en högteknologisk lögndetektor för digitalt innehåll och verkar osynligt i bakgrunden.

Det är värt att notera att användning av sådan detekteringsteknik inte är någon universallösning, utan den bör kalibreras och anpassas till institutionens arbetsflöden. Falska positiva resultat måste hanteras (till exempel kan en AI-textdetektor flagga mallbaserad legitim kommunikation som misstänkt tills den lär sig skillnaden). Men när de integreras på rätt sätt förbättrar dessa verktyg markant en organisations förmåga att upptäcka bedrägligt innehåll innan det orsakar skada. De genererar också verifieringskedjor och analytiska rapporter som är användbara för efterlevnad och för att kontinuerligt förbättra bedrägerimodellerna.

Avgörande för hur effektiva AI-detekteringsverktyg är beror på ständiga uppdateringar. Precis som antivirusprogram kräver nya signaturer för nya virus, behöver AI-detektorer omskolas till de senaste deepfake-teknikerna och AI-modellerna. Leverantörer som TruthScan uppdaterar sina algoritmer för att hantera nya generativa modeller och undvikande taktiker, vilket bibehåller hög noggrannhet även när AI utvecklas[51]. Detta avlastar de interna teamen och säkerställer att bankerna inte utkämpar gårdagens krig medan brottslingarna går vidare till nya AI-trick.

Slutsats

Finansbranschen står vid ett vägskäl i kampen mot bedrägerier. Å ena sidan anammar brottslingar snabbt generativ AI för att lansera bedrägerier som är mer övertygande och utbredda än någonsin. Å andra sidan har banker och bedrägeribekämpare en växande arsenal av AI-drivna försvar till sitt förfogande. De institutioner som kommer att trivas är de som känna igen den nya hotbilden och reagera med samma uppfinningsrikedom. Detta innebär att investera i avancerad detekteringsförmåga, integrera verifieringsprocesser i flera lager, utbilda både personal och kunder samt främja en kultur av vaksamhet och anpassning.

AI-baserade bedrägerier är ett mål som rör sig snabbt - deepfake-bedrägeriet som lurar ett företag idag kan motverkas av nya detektionstekniker imorgon, bara för att bedragarna ändrar sina metoder nästa vecka. En strategi för bedrägeribekämpning som är "branschstandard" 2025 är därför en strategi som betonar flexibilitet och kontinuerlig förbättring. Finansiella organisationer bör behandla sina bedrägeriförsvarssystem som levande, lärande enheter som utvecklas i takt med kriminella taktiker. Att utnyttja partnerskap med teknikleverantörer är en smart genväg för att bygga upp dessa funktioner. Till exempel kan samarbete med specialiserade företag som TruthScan (som erbjuder lösningar som är skräddarsydda för bank- och finanssektorn) påskynda en institutions förmåga att förhindra AI-baserade bedrägerier och samtidigt upprätthålla regelefterlevnad och kundförtroende[52].

I slutändan handlar skyddet mot AI-drivna bedrägerier inte bara om teknik - det handlar om att bevara de grundläggande förtroende som ligger till grund för finanssektorn. Kunderna måste kunna lita på att deras bank kan skilja en riktig transaktion från en falsk, en riktig kund från en AI-imitatör. Genom att använda avancerade AI-detekteringsverktyg, förstärka verifieringsprotokollen och ligga steget före nya hot kan finansföretagen upprätthålla detta förtroende. Vägen framåt kommer utan tvekan att innehålla fler bedrägeriförsök från motståndare, men med beredskap och rätt investeringar kan bankerna säkerställa att AI blir mer av en tillgång än ett hot inom bedrägeribekämpning. Det är ett mål som är möjligt att uppnå: samma AI-teknik som hotar att störa kan utnyttjas för att skydda integriteten i vårt finansiella system. Nu är det dags för bedrägeribekämpningsteam och chefer på C-nivå att agera beslutsamt, använda avancerade lösningar och strategier för att överlista bedragarna och säkra framtiden för digital finansiering.

Källor: Nya branschrapporter, regleringsvarningar och tekniska vitböcker har refererats till genomgående (Deloitte[20][18], Världsekonomiskt forum[19][24], USA:s finansdepartement FinCEN[3][4], Federal Reserve[13], Keepnet Labs[16][30](bland andra) för att tillhandahålla data och exempel. Alla data och exempel citeras in-line så att läsarna kan utforska dem vidare.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking och risk för AI-bedrägerier | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Det är viktigt att upptäcka farlig AI i deepfake-eran | World Economic Forum

[3] [4] [26] FinCEN utfärdar varning om bedrägerier med Deepfake Media riktade mot finansinstitut | FinCEN.gov

[7] [8] FraudGPT och GenAI: Hur kommer bedragare att använda AI härnäst? | Alloy

[11] Bedrägeri med syntetisk identitet: Hur AI ändrar spelreglerna - Federal Reserve Bank of Boston

[12] [13] Generativ artificiell intelligens ökar hoten från syntetiska identitetsbedrägerier

[16] [17] [22] [23] [28] [29] [30] Deepfake Statistik & Trender 2025 | Nyckeldata & Insikter - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - AI-detektering och innehållssäkerhet för företag

[32] [33] [51] AI-detektor: AI-textdetektering i företagsklass - TruthScan

[44] [45] [52] AI-bedrägeridetektering för banker | CRO-lösningar | TruthScan

[49] [50] Deepfake Detector - Identifiera falska och AI-videor - TruthScan