Försäkringsbedrägerier är på väg in i en ny era som drivs av artificiell intelligens. Sofistikerade bedrägeriringar och ensamma bedragare utnyttjar generativa AI-verktyg för att producera falska anspråk, syntetiska identiteter, djupt förfalskade bevis och mycket övertygande bedrägerier genom imitation. Detta whitepaper undersöker de senaste 2025-trenderna inom AI-drivna försäkringsbedrägerier - från AI-genererade anspråk och dokument till deepfake röstbedrägerier - och beskriver hur försäkringsgivare kan svara. Vi presenterar aktuella data, verkliga fall och strategiska insikter för försäkringsgivare, bedrägeriutredare, cybersäkerhetsteam, skadereglerare och C-suite-ledare som behöver förstå detta snabbt föränderliga hotlandskap.

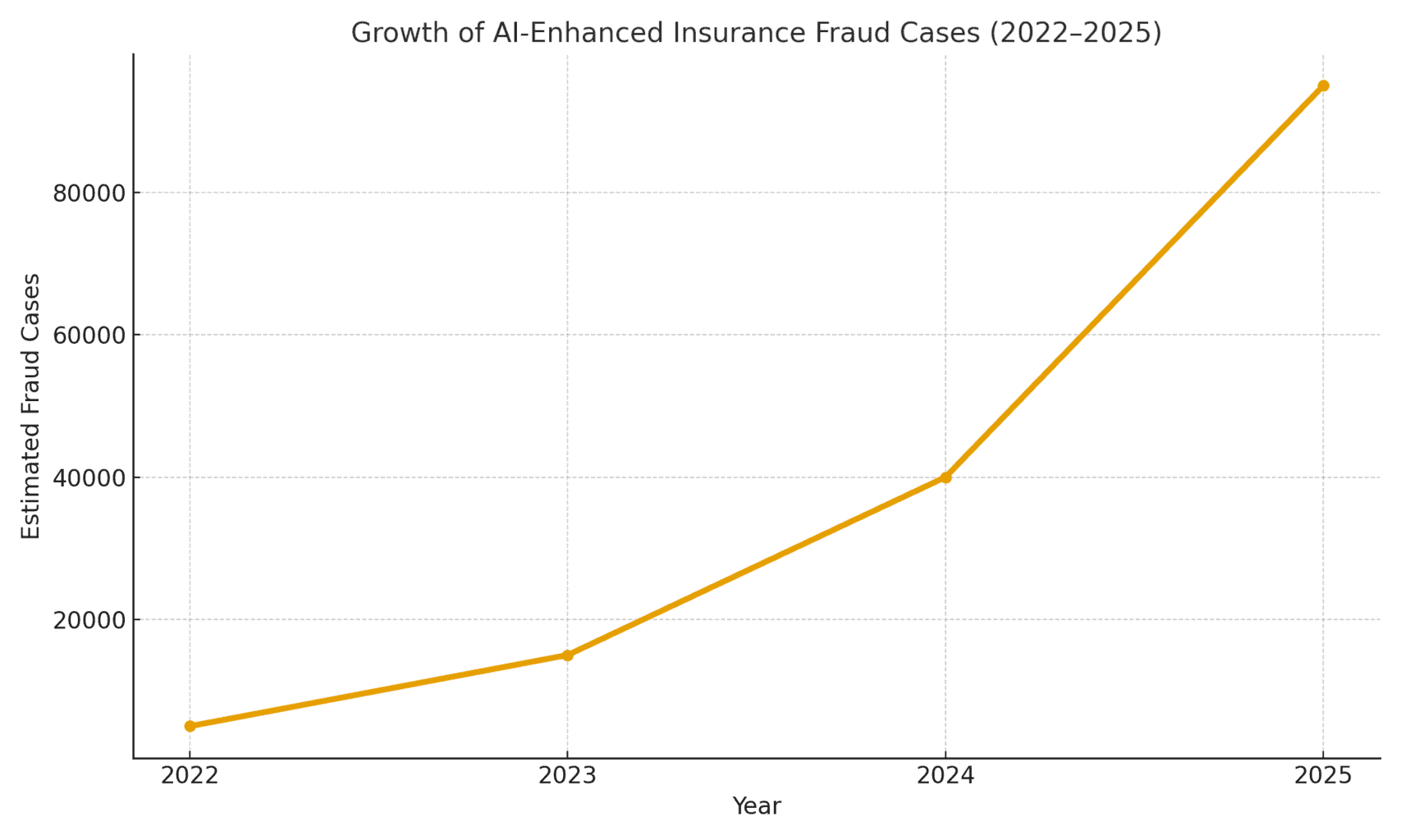

Omfattningen av hotet: Bedrägerier som möjliggörs av AI ökar kraftigt. En rapport från 2025 om kriminalteknisk redovisning visade att AI-drivna bedrägerier står nu för över hälften av alla digitala finansiella bedrägerier[1]. När det gäller försäkringar observerade röstsäkerhetsföretaget Pindrop en 475% ökning av bedrägerier med syntetiska röster mot försäkringsbolag under 2024vilket bidrog till en ökning med 19% jämfört med föregående år av de totala försöken till försäkringsbedrägerier[2]. Försäkringsbolagen står inför ungefär 20 gånger högre bedrägeriexponering än bankerdelvis på grund av att man i stor utsträckning förlitar sig på dokument, bilder och röstverifieringar i samband med krav[3]. Figur 1 nedan illustrerar den explosiva ökningen av AI-förstärkta försäkringsbedrägerier från 2022 till 2025, eftersom flera branschrapporter har visat på tre- eller fyrsiffriga procentuella ökningar från år till år i upptäckt AI-inblandning i bedrägerier.

Figur 1: Snabb ökning av AI-förstärkta fall av försäkringsbedrägerier (indexerad tillväxt 2022-2025). Branschdata indikerar exponentiella ökningar av AI-genererat innehåll som hittas i bedrägliga anspråk, särskilt sedan 2023.[4][2]

AI-genererade påståenden och falska bevis

En av de mest utbredda trenderna är användningen av generativ AI för att skapa helt fabricerade försäkringsanspråk. Med avancerade AI-textgeneratorer kan bedragare skriva realistiska incidentbeskrivningar, läkarrapporter eller polisutlåtanden med ett klick på en knapp. Dessa AI-skrivna berättelser framstår ofta som polerade och trovärdiga, vilket gör det svårare för skadereglerare att upptäcka inkonsekvenser. Bedragare har till exempel använt ChatGPT för att skriva detaljerade olycksbeskrivningar eller skaderapporter som låter professionella och övertygande - en uppgift som en gång i tiden krävde betydande ansträngning och skrivkunnighet.

Mer oroande är att brottslingar nu parar ihop dessa falska berättelser med AI-genererad stödjande bevisning. Bildgenereringsmodeller (som Midjourney eller DALL-E) och redigeringsverktyg kan producera fotorealistiska bilder av skador och personskador. Enligt branschrapporter har vissa förare börjat AI-genererade bilder används för att överdriva fordonsskador i samband med bilskador[5]. Generativ AI kan skapa en bild av ett bilvrak eller ett översvämmat hem som egentligen aldrig har existerat. Dessa bilder är ofta mer realistiska än vad äldre Photoshop-tekniker kunde åstadkomma[6]vilket gör dem svåra att upptäcka med blotta ögat. I april 2025 noterade Zurich Insurance en ökning av antalet skador med manipulerade fakturor, fabricerade reparationsberäkningar och digitalt ändrade foton, inklusive fall där fordonsregistreringsnummer AI-infördes på bilder av skrotade bilar[7][8]. Sådana falska bevis kan, i kombination med en väl utformad AI-skriven ansökningsblankett, slinka förbi manuella granskningar.

Ett slående fall i Storbritannien handlade om bedragare som tog en foto i sociala medier av en hantverkarbil och användning av AI för att lägga till en sprucken stötfångareoch skickade sedan in den tillsammans med en falsk reparationsfaktura på 1.000 pund som en del av en falsk kraschanmälan[9]. Bedrägeriet avslöjades först när utredarna märkte att samma skåpbilsfoto (före skadan) på ägarens Facebook-sida[10]. Detta illustrerar ett bredare fenomen: försäkringsbolagen rapporterar en 300% hopp i "shallowfake" bildredigeringar (enkla digitala manipulationer för att lägga till skador eller ändra detaljer) på bara ett år (2021-2022 jämfört med 2022-2023)[4]. Allianz UK varnade 2024 för att digitala fotodistorsioner och falska dokument hade "alla tecken på att bli den senaste stora bluffen som drabbade branschen"[4]. Zurichs chef för skadereglering konstaterade likaledes att det som tidigare krävde att man iscensatte en fysisk bilolycka kan nu göras helt bakom en dator - bedragare kan "skapa ett bedrägligt anspråk bakom tangentbordet och få ut betydande summor" med falska foton och rapporter om totalförlust[11][12]. Denna förändring ökar inte bara volymen av falska krav utan sänker också inträdesbarriären för potentiella bedragare.

Oroa dig aldrig för AI-bedrägerier igen. TruthScan Kan hjälpa dig:

- Upptäcka AI-generering bilder, text, röst och video.

- Undvik stora AI-drivna bedrägerier.

- Skydda dina mest känslig Företagets tillgångar.

Bortom bilar, Skador på egendom och skadegörelse ser AI-assisterad inflation av förluster. Det finns rapporter om falska foton för reseförsäkringar (t.ex. "skadat" bagage eller iscensatta stöldscener) och AI-genererade kvitton för dyra varor som aldrig har köpts. Liv- och sjukvårdsförsäkringar är inte heller immuna - bedragare har skapat falska sjukvårdsräkningar och dödsattester med hjälp av AI-dokumentförfalskare. Faktum är att Zurich noterade att deepfake-teknik användes för att skapa helt fiktiva ingenjörsutlåtanden och medicinska rapporter i skadepaket[11]. Dessa AI-genererade dokument, som ofta är försedda med realistiska logotyper och signaturer, kan vara omöjliga att skilja från äkta pappersarbete. Ett växande problem för livförsäkringsbolagen är bedrägeri med dödsannonser och dödsattester: brottslingar kan använda AI för att producera falska dödsannonser eller läkarbrev för att stödja en dödsansökan för någon som faktiskt fortfarande lever (eller som aldrig har existerat alls, vilket diskuteras nedan).

Syntetiska försäkringstagare och identiteter

Den kanske mest försåtliga utvecklingen är Bedrägeri med syntetisk identitet inom försäkring. Bedrägeri med syntetisk identitet innebär att man skapar en fiktiv person eller enhet genom att kombinera verkliga uppgifter (stulna personnummer, adresser etc.) med påhittade detaljer (falska namn, falska ID-handlingar). Framsteg inom AI har gjort det trivialt enkelt att generera realistiska personliga profiler - inklusive foton och ID - för personer som inte existerar[13][14]. Bedragare kan nu algoritmiskt skapa en helt falsk kund, köpa en försäkring i dennes namn och senare lägga fram krav eller försäkringsförmåner för den falska identiteten.

Inom livförsäkringssektorn har system med syntetisk identitet sköt i höjden. Branschforskning 2025 uppskattar kostnaderna för syntetiska identitetsbedrägerier över $30 miljarder kronor årligenoch står för så mycket som 80-85% av alla fall av identitetsbedrägerier inom finansiella tjänster[15][16]. Livförsäkringsbolagen har drabbats särskilt hårt: skurkar har varit kända för att teckna livförsäkringar för en fiktiv person och sedan "döda" den personen på papperet för att få ut dödsfallsersättningen[17]. En bedragare kan till exempel skapa en syntetisk kund "John Doe", betala premier i ett år och sedan skicka in ett krav med ett falskt dödsintyg och en dödsruna för John Does för tidiga bortgång. Eftersom identiteten byggdes upp noggrant (kredithistorik, offentliga register etc.) kan dödsfallsansökan verka legitim - tills ingen verklig kropp eller verkliga släktingar kan hittas. När bedrägeriet väl upptäcks har förövarna sedan länge försvunnit med utbetalningen.

Syntetiska identitetsbedrägerier plågar också sjukförsäkring och bilförsäkring. Kriminella nätverk skapar "Frankenstein" identiteter genom att använda barns eller äldres personnummer (som inte har någon kredithistorik) i kombination med AI-genererade namn och körkort[15]. Därefter köpa sjukförsäkringar eller bilförsäkringar för dessa falska individer och kort därefter lämna in stora krav. En variant är syndikat som sätter upp falska företag (skalbolag) - till exempel ett falskt lastbilsföretag - och köper en företagsförsäkring för det, bara för att senare kräva ersättning för iscensatta olyckor eller falska anställdas skador[18][19]. Eftersom företaget bara existerar på papper (med AI-genererade företagsregistreringar och skatte-ID), är detta "Entitetsbaserat" syntetiskt bedrägeri avslöjas ofta inte förrän efter att ersättningarna har betalats ut[18][20].

Varför är syntetiska identiteter så effektiva? För det första går de ofta igenom automatiserade identitetsverifieringskontroller. Kreditbyråer och KYC-system kan hitta inga röda flaggor eftersom identiteten innehåller några riktiga, giltiga uppgifter (t.ex. ett riktigt SSN med ett rent register)[21]. Samtidigt kan AI-genererade profilbilder och ID-skanningar se helt autentiska ut - dagens AI kan producera ett mänskligt ansikte som till och med avancerad ansiktsigenkänning kan acceptera som äkta. Resultatet av detta: de flesta automatiserade system känner igen dessa profiler som legitima och bedrägerierna upptäcks först (om ens alls) efter stora förluster[22].

Påverkan i den verkliga världen: RGA rapporterar att bedrägeri med syntetisk identitet inom livförsäkring kostar nu branschen cirka $30B per år och har vuxit med nästan 400% sedan 2020[15][16]. U.S. Federal Trade Commission uppskattar att syntetiska ID:n utgör den stora majoriteten av identitetsbedrägerierna[16]. Dessa förluster drabbar i slutändan ärliga försäkringstagares plånböcker - varje familj betalar uppskattningsvis \$700 extra i premier varje år på grund av den bredare bedrägeribördan på försäkringsbolagen[15]. Försäkringsbolagen svarar med att förstärka verifieringen vid onboarding och anspråk: implementera databaskontroller för identitetskoppling, övervakning av flera försäkringar på samma adress och till och med köra "liveness"-tester (selfie-videokontroller för att säkerställa att en sökande är en riktig person, inte bara en AI-bild)[23][24]. Men som vi kommer att se kontrar bedragarna med AI på nästa arena: deepfake-röster och -videor.

Deepfake-röster och videopåståenden

AI-genererad ljud och video deepfakes tillföra en alarmerande ny dimension till försäkringsbedrägerier. Under 2023 och 2024 inträffade flera incidenter där brottslingar använde kloning av röst för att efterlikna individer över telefon - en taktik som ursprungligen sågs i bankkupper (som det ökända deepfake CEO-telefonsamtalet som stal $35 miljoner 2020) men som nu sprider sig till försäkringar. Bedragare klonar rösterna från försäkringstagare, läkare eller skadereglerare och använder dem i socialtekniska bedrägerier. Pindrops analys från 2024 varnade för att "deepfakes, syntetisk röstteknik och AI-drivna bedrägerier omformar bedrägerilandskapet", med röstbedrägeri skalning i en aldrig tidigare skådad takt[25]. De fann att försäkringscentraler bombarderades av utländska dåliga aktörer som använde röst deepfakes: till exempel skulle samtal komma in med en riktig försäkringstagares stulna SSN och personuppgifter, och om en agent svarade, skulle Uppringarens AI-klonade röst kan lura handläggaren genom kunskapsbaserad autentisering och begära en bedräglig utbetalning[26]. I ett försäkringsbolag på västkusten använde angripare upprepade gånger denna metod för att försöka ta över konton och omdirigera utbetalningar, och utnyttjade det faktum att ID-verifiering av callcenter förlitade sig på röst och personlig information som kan förfalskas[26].

Röstimitation har också använts på konsumentsidan: Bedragare har ringt olycksoffer eller förmånstagare medan utger sig för att vara försäkringsrepresentanterDe använder AI-röster för att låta officiella och lura till sig känslig information eller till och med betalningar. Omvänt kan en bedragare utge sig för att vara en kund på en hotline för skadeärenden för att göra en skadeanmälan via telefon med hjälp av en deepfake-röst som matchar kundens kön/ålderoch på så sätt kringgå röstbiometriska kontroller. Den senaste tidens bedrägeristatistik är nedslående: branschexperter räknar med en 162% Ökning av bedrägerier med deepfake mot försäkringsbolag under det kommande året[27]och Pindrop registrerade ett 475% ökning av attacker med syntetisk röst 2024 som tidigare nämnts[2]. Dessa attacker går snabbt förbi mer traditionella cyberbedrägerier.

Utöver telefonsamtal, videobaserade deepfakes framträder i skadeprocessen. Många försäkringsbolag har infört virtuella skadeinspektioner och videokonferenser (vilket påskyndades av pandemin) för att verifiera förluster eller intervjua ersättningssökande på distans. Nu är bedragarna utnyttja AI-avatarer och djupt förfalskade videor för att lura dessa verifieringar. Det har förekommit rapporter om att sökande har använt AI-genererade avatarer i live videosamtal med justeringsmän, för att maskera sig som någon annan eller för att dölja tecken på inkonsekvens[28]. Till exempel kan en bedrägeriring använda en deepfake "live"-video av en förmodad kärande som visar sina skador via smartphonenär personen på kameran i själva verket är en AI-syntetiserad komposit eller en inhyrd skådespelare som bär ansiktsändrande filter. Ett spekulativt men troligt scenario är att använda en deepfake av en avliden person: I ett livränte- eller livförsäkringsbedrägeri kan en familjemedlem använda en deepfake-video av den nyligen avlidne under ett rutinmässigt livbevissamtal för att fortsätta få utbetalningar[29]. Även om inget högprofilerat fall av denna karaktär har offentliggjorts ännu, är försäkringsbolagen beredda på det. Tillsynsmyndigheterna noterar också - diskussioner pågår i USA och Europa om att klassificera deepfakes som identitetsstöld och uppdatera riktlinjerna för bevisprövning inom försäkringsbranschen[30].

Det är mycket svårt att upptäcka falska videor och ljud utan tekniska verktyg. Mänskliga skadereglerare är inte utbildade för att urskilja subtila problem med läppsynk eller akustiska konstigheter. Det har dock funnits varningssignaler i vissa fall: till exempel onaturliga blinkningar eller ansiktsglitchar på video, eller bakgrundsljudartefakter i ett samtal som tipsade utredarna. Övergripande dock, deepfake försäkringsbedrägeri är fortfarande i ett tidigt skedeoch åtal är fortfarande sällsynt - 2023 var de juridiska definitionerna oklara och det var svårt att bevisa att en video var AI-genererad utan expertanalys[31]. Detta ger bedragarna en känsla av straffrihet. Kapprustningen är igång: försäkringsbolagen vänder sig nu till kriminalteknisk AI för att bekämpa AI, som använder algoritmer för deepfake-detektering för att granska misstänkta videor bildruta för bildruta efter tecken på manipulation[24]. Leverantörer av röstbiometri lanserar detektorer för djupa falska röster som analyserar spektrala mönster och röstkadens för äkthet[32]. Vi kommer att diskutera dessa defensiva tekniker i ett senare avsnitt.

AI-förstärkt nätfiske och bedrägerier med falska identiteter

Inte alla AI-baserade bedrägerier kommer via skadeavdelningen; vissa mål är kunder och medarbetare via social ingenjörskonst. Phishing-mejl och -texter skapade av AI har blivit ett stort hot inom försäkringsområdet. I dessa system använder bedragarna AI-chattbottar och översättningsverktyg för att skapa mycket övertygande bedrägerikommunikation. Till exempel kan brottslingar imitera ett försäkringsbolags varumärke och skrivstil för att skicka ut massbrev till försäkringstagare med phishing-meddelanden, där de säger att "brådskande åtgärder krävs för att förhindra att försäkringen sägs upp" och hänvisar dem till en falsk webbplats. Till skillnad från tidigare tiders klumpiga bluffmejl, AI säkerställer oklanderlig grammatik och till och med personaliseringvilket gör dem mycket mer trovärdiga. Vi har sett AI användas för att skrapa sociala medier efter detaljer som vävs in i spear-phishing-meddelanden, till exempel att hänvisa till ett nyligen genomfört bilköp i ett falskt meddelande om bilförsäkring.

En annan vektor är AI-stödd imitation av agenter eller chefer. Det har förekommit fall där bedragare har klonat rösten hos en ägare till en försäkringsbyrå och lämnat röstmeddelanden till kunder där de ber om uppdateringar av bankinformation - i praktiken en röstfiskeattack. På samma sätt kan interna bedrägerier härröra från AI-imitation: ett försäkringsbolags finansavdelning blev nästan offer när bedragare skickade ett deepfake-ljudmeddelande enligt uppgift från VD godkänna en överföring av pengar (en variant av "CEO-bedrägeri" som nu täcks av vissa e-brottsförsäkringar)[33]). Dessa typer av AI-drivna bedrägerier med efterliknande steg 17% 2023 enligt Liberty Specialty Markets[33]och förväntas fortsätta att stiga.

Konsumenterna utsätts också för bedrägerier via syntetiska medier kopplade till försäkringar. Coalition Against Insurance Fraud noterar exempel på bedragare som utger sig för att vara försäkringsjusterare, kontaktar olycksoffer och påstår att de hanterar deras anspråk och sedan kräver omedelbar betalning eller känsliga uppgifter[23]. Misstänksamma kunder, som är lättade över att höra från en förmodad representant, kan följa uppmaningen, särskilt om den som ringer känner till detaljer om deras olycka (som AI kan få fram genom hackning eller offentliga källor). Allmänhetens medvetenhet om denna taktik är låg; därför uppmanar experter på bedrägeriförebyggande åtgärder försäkringsbolagen att utbilda försäkringstagare om att verifiera identiteten hos personer som ringer och skickar e-post[23][34]. Precis som bankerna varnar sina kunder för nätfiske börjar försäkringsbolagen 2025 att inkludera varningar för deepfake-bedrägerier i sin kommunikation.

En röd tråd i dessa AI-förstärkta system är användningen av lättillgängliga "fraud-as-a-service"-paket[35]. På den mörka webben kan brottslingar köpa eller prenumerera på verktyg som tillhandahåller färdiga deepfake-röster, falska dokumentmallar, generatorer för phishing-e-post med mera. Denna demokratisering av AI-verktyg innebär även lågutbildade bedragare kan genomföra sofistikerade bedrägeriattacker[35]. För försäkringsbolagen innebär detta en flodvåg av mer övertygande bedrägeriförsök från alla håll - skadeanmälan, kundtjänst, e-post och till och med sociala medier. Det understryker behovet av en mångsidig försvarsstrategi som kombinerar teknik, mänsklig vaksamhet och branschöverskridande samarbete.

Upptäckt och försvar: Ett AI-drivet svar

För att bekämpa AI-drivna bedrägerier krävs AI-drivet försvar. Försäkringsbolagen vänder sig i allt högre grad till avancerad detekteringsteknik och omarbetade processer för att motverka angreppet. I grund och botten måste försäkringsgivarna bädda in kontrollpunkter för innehållsautentisering genom hela försäkringslivscykeln - från underwriting till skadeanmälningar och kundinteraktioner - för att upptäcka AI-förfalskningar. Figur 2 visar en uppdelning av de viktigaste bedrägerityperna som möjliggörs av AI och deras utbredning, och i följande avsnitt beskrivs hur man kan upptäcka och förhindra dem.

Figur 2: Olika typer av AI-förstärkta försäkringsbedrägerier 2025 (uppskattad andel per system). Falska bilder (manipulerade foton av skador) och syntetiska identiteter är bland de största kategorierna, följt av AI-förfalskade dokument (t.ex. kvitton, certifikat) och deepfake audio/video-bedrägerier.

1. Verktyg för AI-detektering av innehåll: Nya AI-detekteringstjänster kan analysera text, bilder, ljud och video för att avgöra om de är maskingenererade eller manipulerade. Försäkringsbolag kan till exempel utnyttja lösningar som TruthScans AI-text- och bilddetektorer som använder 99%+ exakt AI för att flagga AI-skrivna dokument eller manipulerade foton[36]. Ett försäkringsbolag skulle kunna integrera dessa detektorer i sitt system för skadeanmälningar: när en skadeanmälan och dess bevis lämnas in kan textbeskrivningen automatiskt skannas efter AI-genererade språkmönster, och alla uppladdade bilder kan skannas efter tecken på CGI eller redigering. Verktyg i företagsklass kan identifiera AI-genererad text i dokument, e-postmeddelanden och kommunikation med 99%-noggrannhet[36], och på samma sätt upptäcka AI-genererade eller manipulerade bilder för att säkerställa att det visuella innehållet är äkta[36]. Detta innebär att en falsk olycksberättelse som producerats av ChatGPT eller ett falskt skadefoto under resan skulle flaggas för manuell granskning innan anspråket behandlas. Försäkringsgivare 2025 antar i allt högre grad sådan AI-innehållsautentisering - i själva verket, 83% av yrkesverksamma inom bedrägeribekämpning planerar att integrera generativ AI-detektering 2025enligt en undersökning från ACFE, en ökning från endast 18% som använder det idag[37][38].

2. Identitetsverifiering och biometriska kontroller: För att hantera syntetiska identiteter förbättrar försäkringsbolagen också KYC-protokollen med AI. Tjänster för identitetsvalidering kan korsverifiera uppgifter om sökande mot flera databaser och använda ansiktsigenkänning med livstest. Om man till exempel kräver en kort videoselfie under onboarding (och använder ansiktsmatchning till det ID som tillhandahålls) kan man förhindra många syntetiska ID. Ännu mer högteknologiska företag som TruthScan erbjuder bildforensiska metoder som kan upptäcka AI-genererade profilbilder, avatarer och syntetiska personbilder - deras AI-bilddetektor är utbildad för att identifiera ansikten som skapats av generatorer som StyleGAN eller ThisPersonDoesNotExist[39]. Genom att använda sådana verktyg kan ett försäkringsbolag upptäcka om en selfie från en livförsäkringssökande inte är en riktig människa. På röstsidan, röstbiometrisk autentisering för kundtjänstsamtal kan vara till hjälp; moderna röst-AI-detektorer kan identifiera syntetiska röster och försök till röstkloning i realtid[40]. Till exempel har TruthScan's AI-röstdetektering systemet använder akustisk analys för att känna igen AI-genererade röster och ljudförfalskningar innan de lurar callcenterpersonal[40]. Dessa lösningar fungerar som en brandvägg - om någon ringer och utger sig för att vara John Doe och deras röstavtryck inte matchar John Does autentiska röst (eller matchar kända deepfake-egenskaper), kan samtalet flaggas eller ytterligare identitetsbevis krävas. Flerfaktorsautentisering (e-post/SMS-bekräftelse, engångslösenord etc.) gör det ännu svårare för imitatörer att ta sig förbi.

3. Deepfake Video & Image Forensics: När det gäller videobevis börjar försäkringsbolagen implementera specialiserad kriminalteknisk analys. Avancerad programvara kan analysera videometadata, ramkonsistens och felnivåer för att upptäcka deepfakes. Vissa verktyg undersöker reflektioner, skuggor och fysiologiska signaler (som puls i en persons hals på video) för att säkerställa att en video är äkta. Rättsmedicinska metoder för metadata är också värdefullt: genom att undersöka filmetadata och genereringsavtryck i bilder eller PDF-filer kan man avslöja om något sannolikt har producerats av ett AI-verktyg[41]. Försäkringsbolagen bör t.ex. kräva originalbildfiler (som innehåller metadata) i stället för bara skärmdumpar eller utskrivna kopior. Zurichs bedrägeriteam noterade framgångar med att fånga falska bilbilder genom att märka avvikelser i bildens metadata och felnivåanalys[41]. Detektorer för e-postbedrägerier kan också skanna inkommande kommunikation efter tecken på AI-skrivet phishing-innehåll eller kända skadliga signaturer[42]. Många försäkringsbolag kör nu phishing-simuleringar och AI-skrivna bedrägeriexempel i personalutbildningen för att öka medvetenheten.

4. Processförändringar och utbildning av personal: Teknik i sig är ingen universallösning. Förbättringar av processer görs, till exempel mer frekventa slumpmässiga personliga stickprovskontroller för anspråk med högt värde eller krav på fysisk dokumentation i vissa fall. Vissa försäkringsbolag har försenat helautomatiserad direkthantering av anspråk och återinför mänsklig granskning av anspråk som får höga poäng i en riskmodell för AI-bedrägerier. På den mänskliga sidan är utbildning avgörande. Bedrägeriutredare och skadereglerare utbildas för att känna igen varningssignaler från AI: t.ex. flera anspråk med identiska formuleringar (ChatGPT-stil), bilder som saknar verklig slumpmässighet (t.ex. upprepade mönster i vad som borde vara organiska skador) eller röster som låter nästan rätt men har robotkadens. Försäkringsbolagen utbildar också kunderna: de skickar ut bedrägerivarningar om deepfake-system och ger råd om hur man verifierar en försäkringsrepresentants identitet (till exempel genom att ange ett känt återuppringningsnummer).

5. Samarbetsinsatser: Samarbetet inom hela branschen intensifieras. I Storbritannien har Insurance Fraud Bureau och Association of British Insurers bildat arbetsgrupper om AI-bedrägerier, och regeringens Stadga om försäkringsbedrägerier (2024) främjar datadelning och gemensamma initiativ[43]. Globalt samarbetar försäkringsbolag med cybersäkerhetsföretag och nystartade AI-bolag. Framför allt dyker det upp nya försäkringsprodukter: Liberty Mutual lanserade en e-brottsförsäkring för små och medelstora företag som specifikt täcker deepfake-bedrägerier och VD-bedrägerier[44][33]vilket understryker att denna risk är mycket verklig. Det innebär också att försäkringsbolagen kan komma att bli både offer för och lösare av AI-bedrägerier - de kan betala ut pengar för ett deepfake-bedrägeri om det inte upptäcks, men de kan också erbjuda skydd för andra som drabbas av sådana attacker.

Integrationen av detektionsteknik i arbetsflödena kan visualiseras som ett flerpunktsförsvar i kravlivscykeln. Som visas i Bild 3kan försäkringsbolagen införa AI-verifieringssteg vid policytillämpning (för att kontrollera syntetiska identiteter via ID-handlingar och selfies), på inlämning av krav (för att automatiskt analysera uppladdade dokument, foton eller ljud för AI-generering), under granskning/utredning av anspråk (för att utföra deepfake-forensisk analys på misstänkta bevis och verifiera eventuella röstinteraktioner), och precis före utbetalning (en slutlig identitetsverifiering för att säkerställa att betalningsmottagaren är legitim). Genom att upptäcka bedrägerier tidigt - helst redan vid onboarding eller första skadeanmälan - sparar försäkringsbolagen utredningskostnader och undviker felaktiga utbetalningar.

Figur 3: Integration av AI-detekteringspunkter i försäkringens livscykel. Vid tecknandet av en försäkring kontrollerar AI-baserad identitetsvalidering om det finns syntetiska eller falska identiteter. När en skadeanmälan skickas in skannar automatiska detektorer skadeanmälans text, dokument och bilder efter AI-genererat innehåll. Vid granskning av anspråk verifierar specialiserade verktyg för deepfake- och röstanalys alla ljud- och videobevis. Före utbetalning bekräftas förmånstagarens identitet genom biometrisk identitetsverifiering. Detta flerskiktade tillvägagångssätt hjälper till att upptäcka bedrägerier i flera steg.

Försäkringsbolagen behöver inte bygga upp alla dessa funktioner internt - många vänder sig till företagslösningar som TruthScans AI-detekteringssvitsom erbjuder en rad olika verktyg som kan API-integreras i försäkringsbolagens system. Till exempel, TruthScans tjänst för AI-bild- och Deepfake-detektering kan användas för att verifiera äktheten hos bilder och videor med över 99% noggrannhet[45]. Deras AI-textdetektor flaggar för AI-skriven text i krav eller e-postmeddelanden[36]medan AI-röstdetektor Avkänning av röstkloning och högtalarverifiering för att stoppa telefonbedragare[40]. Det finns till och med nischverktyg som en Detektor för falska kvitton för att omedelbart analysera fakturor/kvitton för tecken på manipulering eller AI-genererade teckensnitt/layouter[46] - extremt användbart med tanke på förekomsten av falska reparationsräkningar i skadeanmälningar. Genom att använda en kombination av dessa verktyg kan ett försäkringsbolag drastiskt förbättra sin förmåga att upptäcka bedrägerier. En Fortune 500-försäkringsgivare rapporterade att de fångat 97% av deepfake-försök år 2024 genom att använda en AI-screeningmetod i flera lager (text, bild, röst) och därigenom undvika förluster på uppskattningsvis \$20M[47][48].

Slutsats

AI håller på att förändra slagfältet för försäkringsbedrägerier på global nivå. Bedragare använder generativ AI för att skapa lögner som är mer övertygande än någonsin - från helt påhittade personer och olyckor till imitationer som kan lura även erfarna yrkesmän. Uppgifterna från 2024-2025 visar en alarmerande tillväxt i dessa AI-drivna system, men de visar också att försäkringsgivare som investerar i upptäckt och förebyggande åtgärder kan ligga steget före. Genom att kombinera banbrytande AI-detekteringsteknik - som bildforensik, röstautentisering och textanalys - med uppdaterade arbetsflöden och utbildning kan branschen minska riskerna utan att ge avkall på den effektivitet som digitala processer medför.

I grund och botten handlar det om en teknisk kapprustning[49]. Som en expert på bedrägeribekämpning noterade, "I denna nya verklighet är vaksamhet den premie som måste betalas"[50]. Försäkringsbolagen måste främja en vaksamhetskultur och utnyttja de bästa tillgängliga verktygen för att bevara förtroendet för skadeprocessen. Det innebär att verifiera sanningshalten i dokument, röster och bilder med samma noggrannhet som försäkringsgivare använder för att bedöma risk. Det innebär också att samarbeta inom branschen för att dela information om nya AI-bedrägerier och gemensamt utveckla standarder (t.ex. standardiserade metadatakrav för inlämnade medier eller branschens svarta listor över kända falska identiteter).

2025 är en brytpunkt: de försäkringsbolag som proaktivt anpassa sig till AI-drivna bedrägerier kommer att skydda sina kunder och balansräkningar, medan de som reagerar långsamt kan bli måltavlor för bedrägerier som skapar rubriker. Den uppmuntrande nyheten är att tekniken för att slå tillbaka finns och snabbt mognar - samma AI som ger bedragare möjlighet att göra det kan ge försäkringsgivare möjlighet att göra det. Genom att implementera lösningar som TruthScans multimodala AI-detekteringssvit för anspråk och identitetsverifiering kan försäkringsgivare dramatiskt minska framgångsgraden för AI-genererade bedrägeriförsök[51][52]. På så sätt förhindrar de inte bara förluster utan sänder också ett tydligt budskap till potentiella bedragare: det spelar ingen roll hur smarta verktygen är, bedrägerier kommer att avslöjas.

Sammanfattningsvis är AI-drivna försäkringsbedrägerier en formidabel utmaning, men en utmaning som kan mötas med ett lika intelligent försvar. Med vaksamhet, en tvärfunktionell strategi och rätt teknikpartner kan försäkringsbranschen fortsätta att upprätthålla det grundläggande löfte som är kärnan i dess verksamhet - att endast betala ut legitima ersättningar, och att göra det snabbt och säkert i en alltmer digital värld.

Referenser:

- Föreningen för brittiska försäkringsbolag - Statistik över bedrägerier 2023[53][54]

- Allianz & Zurich om AI-"ytliga falska" anspråksökningar The Guardian, 2024[4][11]

- Facia.ai - "Deepfake försäkringsbedrägeri: Hur AI skriver om reglerna," Oktober 2025[55][56]

- Koalition mot försäkringsbedrägerier - Syntetiska bedrägerier inom försäkringsbranschen (Quantexa), Dec 2024[21][17]

- RGA - "Bedrägeribekämpningens nya gräns: Syntetiska identiteter" Juni 2025[15][16]

- Pindrop - Rapport om röstbedrägerier, via FierceHealthcare, juni 2025[2][3]

- Vridande siffror - "De största finansiella bedrägerierna 2025" Oktober 2025[1][57]

- TruthScan - AI Detection Platform (översikt över tjänster), 2025[51][52]

- TruthScan - Produktsida för AI Image Detector, 2025[45][39]

- TruthScan - Produktsida för AI Voice Detector, 2025[40]

- TruthScan - Produktsida för detektor för falska kvitton, 2025[46]

- Liberty Specialiserade marknader - Pressmeddelande från Deepfake/Cyber Fraud Insurance, mars 2025[33]

- Facia.ai - Blogg: Kapprustning för att förebygga försäkringsbedrägerier, 2025[24][32]

- Försäkringsverksamhet Storbritannien - "AI-genererade bilder används för motorbedrägerier" april 2025[7][58]

- The Guardian - "Falska bilder på bilskador skrämmer försäkringsbolagen" Maj 2024[9][12]

[1] [35] [57] 2025 System för finansiella bedrägerier: AI-hot och varningssignaler

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Försäkringsbedrägerier ökade med 19% från röstattacker under 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Bedragare redigerar fordonsfoton för att lägga till falska skador i försäkringsbedrägeri i Storbritannien | Försäkringsbranschen | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] AI-genererade bilder används nu för trafikförsäkringsbedrägerier - rapport | Insurance Business UK

[13] [14] [15] [16] Fraud Fight's New Frontier: Syntetiska identiteter och en AI-vapenkapplöpning | RGA

[17] [18] [19] [20] [21] [22] JIFA: Syntetiskt bedrägeri: Med syntetiska bedrägerier redan i deras ekosystem måste försäkringsbolagen tänka mer som banker - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Deepfake försäkringsbedrägeri: Hur AI skriver om reglerna för försäkringsanspråk

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Det tysta hotet: Varför försäkringsbedrägerier flyttar till telefonlinjen

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] E-brottsförsäkring för små och medelstora företag inriktad på VD-bedrägerier och deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - AI-detektering och innehållssäkerhet för företag

[37] Studie: 8 av 10 bedrägeribekämpare förväntar sig att använda generativ AI år 2025

[38] Insikter från 2024 års benchmarkingrapport om bedrägeribekämpningsteknik

[39] [45] AI-bilddetektor - upptäcka falska och manipulerade foton - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI-röstdetektor för deepfakes och röstkloning | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Detektor för falska kvitton | Verifiera kvittots äkthet

https://truthscan.com/fake-receipt-detector

[47] Fortune 500-försäkringsgivaren upptäcker 97% av Deepfakes och stoppar syntetiska ...