Inledning

Generativ AI håller på att revolutionera sjukvården - och inte alltid till det bättre. Under 2025 har bedrägerier inom sjukvården ökat mer digitala och sofistikerade, drivna av dataintrång, automatisering och generativ AI[1]. Brottslingar utnyttjar AI-verktyg för att skapa falska patientidentiteter, syntetiska försäkringsanspråk, AI-genererade medicinska dokument, förfalskade recept och till och med deepfaked interaktioner mellan läkare och patient. Dessa högteknologiska bedrägerier når nya höjder och hotar försäkringsbolagens ekonomi och patientsäkerheten över hela världen. Utmaningen är enorm: bedrägerier inom sjukvården kostar redan tiotals miljarder årligen, och ökningen av AI är intensifierar både omfattningen och komplexiteten av bedrägerier[2][3]. Detta whitepaper ger en detaljerad titt på de senaste AI-drivna bedrägeritrenderna inom sjukvården, verkliga fall från 2025 och strategier - från AI-innehållsdetektorer till identitetsverifiering - för att bekämpa detta föränderliga hot.

Ökningen av AI-baserade bedrägerier inom hälso- och sjukvården

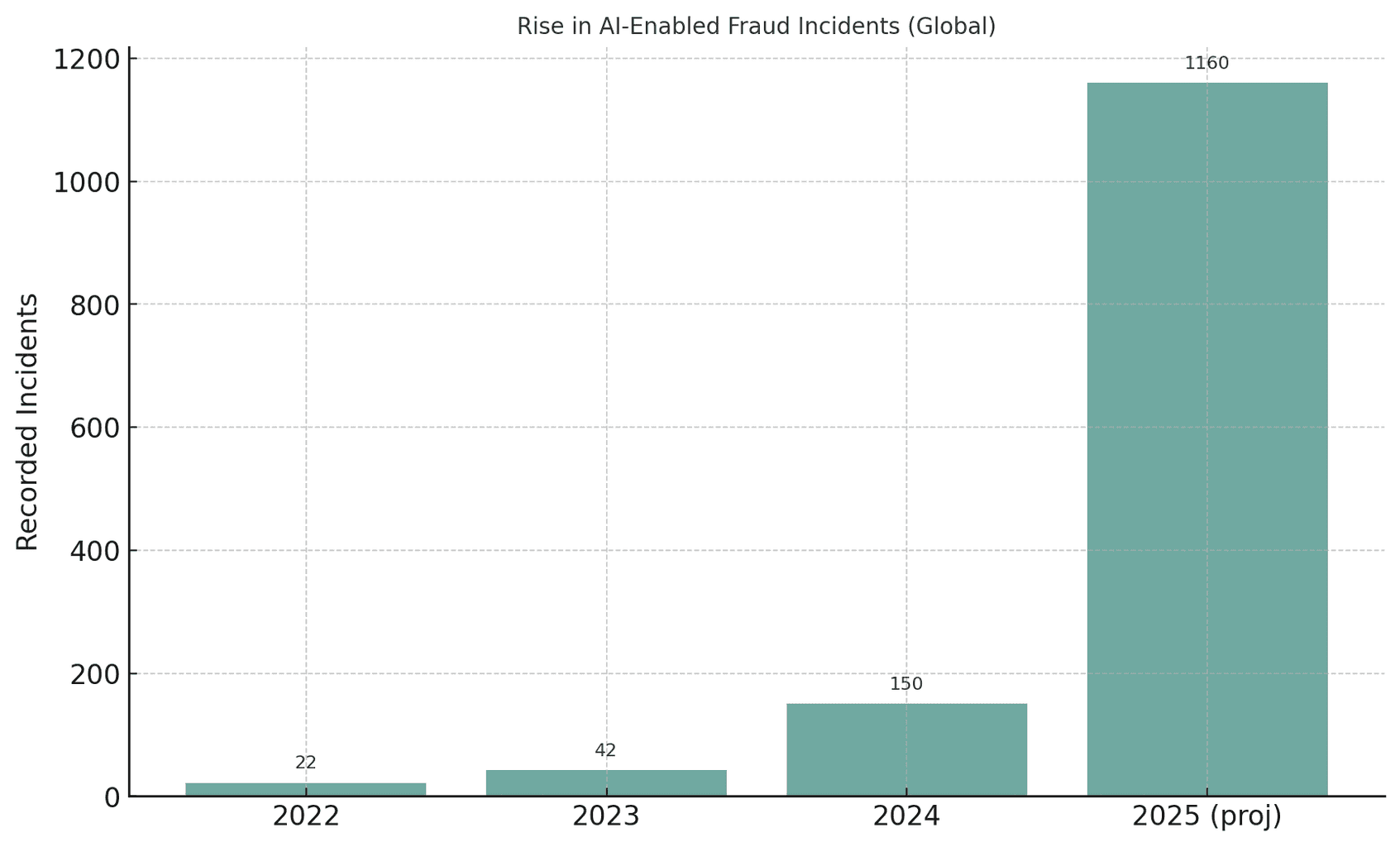

Den globala hälso- och sjukvårdssektorn genomgår en oöverträffad ökning av AI-drivna bedrägeriförsök. När generativ AI blir tillgänglig kan bedragare automatisera det som tidigare var manuella bedrägerier och producera övertygande falska identiteter, dokument och till och med röster eller videor i stor skala. Till exempel noterade myndigheterna att bedrägeriförsök med deepfake-media ökade med 3 000% under 2023 ensam[4][5]. Deepfake-relaterade incidenter nästan fördubblades från 22 under 2022 till 42 under 2023, och exploderade sedan till 150 incidenter under 2024; häpnadsväckande nog inträffade 179 deepfake-bedrägerier under första kvartalet 2025 - vilket redan överstiger totalen för 2024[6][7]. Denna trend tyder på en skenande tillväxt i AI-drivna bedrägerieroch analytiker förutspår att generativ AI kan driva bedrägeriförlusterna från $12,3 miljarder år 2023 till $40 miljarder år 2027 (32% CAGR)[8].

Bild: Den explosiva tillväxten av bedrägerier med hjälp av AI under de senaste åren. Upptäckta fall av deepfake eller AI-assisterade bedrägerier har ökat dramatiskt från 2022 till 2025, vilket illustrerar hur generativa AI-verktyg har ökat bedrägeriförsöken[4][7].

Oroa dig aldrig för AI-bedrägerier igen. TruthScan Kan hjälpa dig:

- Upptäcka AI-generering bilder, text, röst och video.

- Undvik stora AI-drivna bedrägerier.

- Skydda dina mest känslig Företagets tillgångar.

Hälso- och sjukvården är särskilt sårbar för denna AI-drivna brottsvåg. Sektorns enorma, fragmenterade ekosystem - som spänner över sjukhus, kliniker, försäkringsbolag, apotek och telehälsoplattformar - erbjuder tusentals attackpunkter[9][10]. Traditionella bedrägerier (t.ex. falska försäkringskort eller stulna patient-ID) har utvecklats till systemisk exploatering använda AI[10][11]. I ett amerikanskt tillslag 2025 åtalade justitiedepartementet 324 svarande i upplägg som totalt uppgick till $14,6 miljarder i falska fordringar - det största bedrägerifallet inom sjukvården någonsin[12][13]. Många bedrägerier involverade telemedicinska konsultationer och bedrägerier med genetiska tester, och en ny DOJ Data Fusion Center för bedrägerier inom hälso- och sjukvården använde AI-analys för att proaktivt upptäcka mönster[14][15]. Det är uppenbart att AI är ett tveeggat svärd: det hjälper utredare att upptäcka bedrägerier, men också gör det möjligt för brottslingar att begå bedrägerier i en aldrig tidigare skådad omfattning och sofistikering[11][2].

Vanliga AI-drivna bedrägeritekniker inom hälso- och sjukvården (2025)

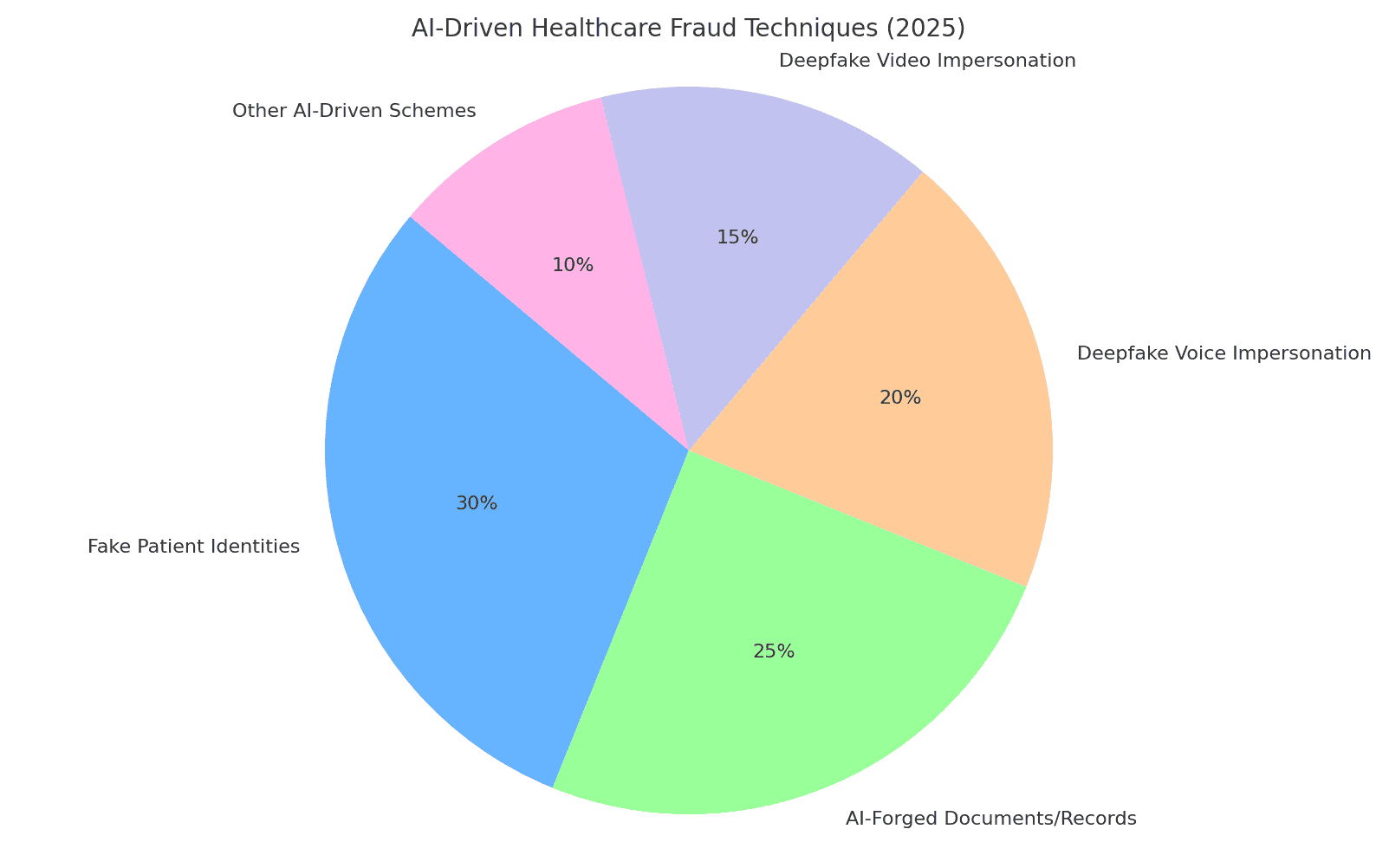

Bedragare 2025 har en verktygslåda med AI-aktiverade taktiker för att lura sjukvårdssystem och försäkringsbolag. De viktigaste metoderna är att förfalska identiteter och dokument, generera falska medicinska data och utge sig för att vara betrodd personal via deepfakes. Nedan går vi igenom de vanligaste AI-drivna bedrägeriteknikerna och hur de används mot sjukvårdsorganisationer:

Bild: Fördelning av de viktigaste AI-drivna teknikerna för bedrägerier inom vården 2025. Falska patientidentiteter och AI-förfalskade dokument (t.ex. medicinska journaler, krav) utgör en stor andel av bedrägerierna, medan deepfake röst och videoimitationer är ett snabbt växande hot. "Andra AI-drivna system" inkluderar AI-skapade phishing-mejl, robotar som attackerar patientportaler och liknande exploateringar (uppskattade procentandelar baserade på branschrapporter[8][16]).

Syntetiska patientidentiteter

Falska patientidentiteter - ofta skapade med hjälp av AI - är en grundläggande bedrägeritaktik. Istället för att stjäla en persons identitet kombinerar brottslingar verkliga data från flera personer med påhittade detaljer för att skapa syntetiska identiteter som passerar som nya patienter[17][18]. Generativ AI påskyndar detta genom att producera realistiska personliga register. AI kan till exempel generera trovärdiga ID, profiler, till och med familjehistorik ("syntetiska föräldrar") för en falsk patient[19][20]. Dessa fantompatienter används sedan för att öppna konton, teckna försäkringar eller fakturera för tjänster som aldrig inträffade. Under covid-19-pandemin använde bedragare syntetiska ID-handlingar för att få tillgång till akuta sjukvårdsförmåner; nu använder de dem för att lämna in falska försäkringsanspråk eller få recept, som vet att en väl utformad identitet kan undgå upptäckt[21][22]. Enligt U.S. Federal Reserve uppgick förlusterna från bedrägerier med syntetiska identiteter till $35 miljarder år 2023 och fortsätter att stiga[23]. Konsekvenserna för sjukvården är allvarliga: bedragare kan använda ett barns stulna personnummer för att skapa en falsk patient med perfekt kreditvärdighet, eller blanda stulna patientuppgifter för att kringgå försäkringsbolagens verifiering[17][24]. Varje syntetisk patient som förs in i systemet undergräver dataintegriteten och kan leda till felaktiga utbetalningar eller till och med kliniska fel om den falska identiteten blandas med riktiga medicinska journaler.

AI-genererade medicinska dokument och försäkringsanspråk

Generativ AI används nu för att skapa medicinska dokument, journaler och hela försäkringsanspråk. Språkmodeller kan producera autentiska läkaranteckningar, epikriser, labbresultat eller fakturor fyllda med medicinsk jargong - allt skräddarsytt för att stödja ett bedrägligt krav. Faktum är att branschobservatörer rapporterar om en 89% ökning av AI-genererade medicinska dokument som lämnas in, jämfört med tidigare år[25][26]. Bedragare utnyttjar dessa falska journaler för att motivera dyra ingrepp eller mediciner som aldrig har tillhandahållits, eller för att blåsa upp ersättningskoder. Till exempel kan en AI generera en falsk diagnostisk bildrapport eller laboratorieresultat för att styrka ett högkostnadsanspråk för onkologiska läkemedel. Försäkringsgivare och hälso- och sjukvårdssystem står inför en flod av sådana syntetiskt pappersarbetevilket gör det svårare att skilja legitima krav från förfalskningar. I Storbritannien noterar försäkringsbolagen en snabbt ökande användning av deepfakes och manipulerade dokument vid bedrägerier, ofta i till synes rutinmässiga krav av lågt värde för att undvika granskning[27]. Inte ens kliniskt bildspråk är immunt - det finns bevis för att Bedragare använder generativ AI för att efterlikna medicinska bilder som röntgenstrålar eller skanningar[3]. Konsekvenserna går utöver ekonomisk förlust: om förfalskade medicinska journaler hamnar i patientjournaler kan de leda till feldiagnoser eller felaktig behandling. Så är det, AI-skrivna hälsodokument utgör en allvarlig integritets- och säkerhetsrisk.

Förfalskade recept och apoteksbedrägerier

Förskrivningsbedrägerier har gått in i den digitala tidsåldern med AI. Förfalskade recept - som tidigare gjordes med stulna receptblock eller rudimentär redigering - kan nu genereras automatiskt med realistiska detaljer och läkarsignaturer. AI-bildgeneratorer eller mallar gör det trivialt att skapa utskrifter av e-recept som ser äkta ut eller apoteksbeställningar. Mer försåtligt är att brottslingar använder kloning av röst för att utge sig för att vara läkare i samtal med farmaceuter. I en rapporterad trend hackade bedragare sig in i medicinska journaler för att stjäla läkares DEA-registreringsnummer och använde sedan dessa uppgifter för att skicka elektroniska recept för kontrollerade ämnen[28]. Det har förekommit fall av Förfalskningar av AI-röst används för att godkänna påfyllning - en apotekare får ett samtal som låter exakt som en känd läkare som bekräftar ett recept, men det är i själva verket en AI-genererad röst. Som ett resultat kan kontrollerade läkemedel (som opioider eller stimulantia) erhållas olagligt och avledas. Förfalskade receptbedrägerier orsakar inte bara ekonomiska förluster för försäkringsbolag och apotek; de utgör också en fara för patienterna, som kan få felaktiga mediciner i sina journaler. Om en bedragare till exempel utger sig för att vara en patient för att få opioidrecept, kan Patientjournalen kan uppdateras med läkemedel som patienten aldrig har tagit, vilket kan leda till farliga interaktioner eller att patienten flaggas som läkemedelssökande.[29]. Denna blandning av cyberbrottslighet och AI-exploatering har lett till varningar från tillsynsmyndigheter. Sjukvårdsorganisationer måste nu verifiera att varje recept - särskilt högriskläkemedel - är legitimt och verkligen kommer från den auktoriserade leverantörenInte en deepfake eller ett dataintrång.

Deepfake-imitationer av läkare och patienter

Den kanske mest uppseendeväckande utvecklingen är användningen av deepfakes för att utge sig för att vara vårdpersonal eller patienter. Inom telemedicin och kundtjänst använder bedragare AI-genererad video och ljud för att lura personerna på andra sidan. Till exempel har brottslingar skapat deepfake-videor av patienter för telehälsokonsultationer, lura läkare att tillhandahålla "behandling" eller remisser som sedan faktureras till försäkringar[30][31]. Omvänt kan en bedragare deepfake en läkares likhet - med hjälp av en ansedd läkares ansikte och röst - i ett videosamtal för att övertyga en patient om att betala för en bedräglig tjänst eller lämna ut personlig information. IT-experter inom sjukvården varnar för att telehälsa har blivit en mogen måltavla: man kan boka ett virtuellt möte med en falsk patientidentitet och sedan låta en AI-avatar stå med på video för att få recept eller medicinsk rådgivning under falska förespeglingar[31][32]. Utöver telemedicin mättar deepfakes sociala medier i form av "Läkar"-videor som marknadsför mirakelkurer. År 2024 observerade experter att deepfaked videor av kända läkare "tog verkligen fart," riktar sig till äldre målgrupper med falska hälsotips och bluffprodukter[33][34]. Betrodda TV-läkare i Storbritannien och Frankrike fick sina liknelser klonade för att stödja falska diabeteskurer och blodtryckstillskott[35][36]. Upp till hälften av tittarna kunde inte se att dessa deepfake medicinska videor var falska[37]. Denna erosion av sanningen har påtagliga kostnader: patienter kan följa skadliga råd från en falsk läkarvideo, eller bedragare kan fakturera försäkringsbolag för konsultationer som aldrig ägt rum förutom som en deepfake-inspelning. Allt som allt, AI-driven imitation undergräver det grundläggande förtroendet för interaktioner inom hälso- och sjukvården - om man inte kan lita på att personen på skärmen eller i telefonen är den han eller hon utger sig för att vara, är hela systemet i fara.

Effekt och skala: 2025 Bedrägerier i siffror

AI-drivna bedrägerier är inte längre en marginell fråga - de utgör nu ett stort ekonomiskt avbräck och säkerhetshot i globala hälso- och sjukvårdssystem. Följande färska statistik och fall illustrerar hur omfattning av problemet:

- Årliga förluster: Bedrägerier inom sjukvården kostar USA uppskattningsvis $68 miljarder eller mer varje år[25], ungefär 3-10% av alla hälsoutgifter[38]. Globalt sett kan bedrägerier konsumera cirka 6% av utgifterna för hälso- och sjukvård[39] - en häpnadsväckande siffra med tanke på att världens sjukvårdskostnader uppgår till biljoner dollar. Dessa förluster leder i slutändan till högre premier, ökade sjukhuskostnader och minskade resurser för patientvård.

- Ökning av bedrägerier 2023-2025: Tillkomsten av generativ AI har lett till en explosion av bedrägeriförsök. Deepfake-relaterade bedrägeriincidenter ökade tiodubblas från 2022 till 2023[4]. År 2024 hoppade rapporterade deepfake-incidenter till 150 (en ökning med 257%)[40]och 2025 är på väg att vida överträffa detta (580 incidenter under bara första halvåret 2025, nästan 4× det totala antalet för 2024)[7]. Bedrägeriexperter noterar att 46% har stött på syntetiskt ID-bedrägeri, 37% röstförfalskningar och 29% videoförfalskningar i sina utredningar[8] - vilket visar hur vanliga dessa AI-tekniker har blivit.

- Rekordstora nedtagningar: De brottsbekämpande myndigheterna svarar med större tillslag. I juni 2025 tillkännagav det amerikanska justitiedepartementet historiens största uppgörelse om bedrägeri inom sjukvården, åtalade 324 personer och avslöjade $14,6 miljarder i bedrägliga fordringar[1][13]. Det handlade bland annat om bedrägerier med telehälsokonsulter, bedrägerier med genetiska tester och bedrägerier med varaktig medicinsk utrustning i stor skala[13]. Som en del av denna ansträngning, Medicare avbröt $4 miljarder i väntande utbetalningar anses vara misstänkt[41]och förhindra dessa förluster. Ett hörnstensfall ("Operation Gold Rush") avslöjade en internationell liga som använde stulna identiteter för att registrera $10,6 miljarder i falska ersättningar för medicinsk utrustning[42] - ett bevis på hur långt brottslingar kan gå när de är beväpnade med intrångsdata och automatisering.

- Försäkringsgivarens påverkan: Försäkringsbolag över hela världen ser en ökning av AI-relaterade bedrägerier. I Storbritannien rapporterar försäkringsbolagen att deepfakes används i allt större utsträckning i skadeärenden (ofta "low touch"-skador för att undvika upptäckt)[27]. Ett ledande återförsäkringsbolag varnar för att förfalskade medicinska journaler och falska hälsotillstånd undergräver försäkringstekniken och kan driva upp förlusterna inom liv- och sjukförsäkring[43]. En analys från Deloitte 2024 förutspådde att 2027, generativa AI-baserade bedrägerier kan stå för $40 miljarder i årliga förluster i USA. (upp från $12,3 miljarder år 2023)[8]. Denna utveckling innebär ett betydande avbräck för försäkringsbolagens resultat om inte kraftfulla motåtgärder vidtas.

- Patientoffer: Patienter och allmänhet förlorar också pengar på dessa bedrägerier. Särskilt äldre vuxna har utsatts för bedrägerier med AI-röst ("barnbarn i nöd"-samtal) och deepfake-hälsobedrägerier. År 2023 rapporterade seniorer i USA $3,4 miljarder kronor i förluster till följd av bedrägerier, en ökning med 11% från föregående år[44][45] - en del av detta drivs av AI-förstärkta system. Och utöver den monetära kostnaden finns det en mänsklig kostnad: bedrägliga medicinska råd och falska behandlingar som marknadsförs via AI kan leda till fysisk skada eller förlorat förtroende för legitim sjukvårdsrådgivning.

Sammantaget har 2025 klargjort att AI sätter turbo på traditionella sjukvårdsbedrägerier. Det som tidigare var mindre, opportunistiska upplägg har skalats upp till industrialiserade verksamheter som sträcker sig över kontinenter. Kombinationen av stora datamängder (ofta från intrång) och AI-generering innebär att bedrägerier kan genomföras med skrämmande snabbhet och trovärdighet. De globala förlusterna uppgår till tiotals miljarder och ökaroch alla intressenter - från sjukhus och försäkringsbolag till patienter - är i riskzonen. I nästa avsnitt diskuteras hur branschen kan slå tillbaka med hjälp av lika avancerad teknik och lika avancerade strategier.

Försvar mot AI-drivna bedrägerier: Strategier och lösningar

För att bekämpa AI-baserade bedrägerier inom sjukvården krävs en arsenal av lika avancerade försvar. Sjukvårdschefer, cybersäkerhetsteam, compliance officers och försäkringsbolag måste samordna sig för att införa åtgärder för bedrägeribekämpning vid varje sårbar punkt - från patientens introduktion till utbetalning av ersättning. Nedan beskrivs viktiga strategier och tekniska lösningar för att motverka AI-drivna bedrägerier:

- Verktyg för AI-detektering av innehåll: Precis som brottslingar använder AI för att fabricera innehåll kan organisationer använda AI för att upptäcka det. Avancerad Detektorer för AI-skrivet innehåll (t.ex. TruthScans svit) analyserar text, bilder, ljud och video för att identifiera tecken på AI-generering. Till exempel tillämpar TruthScans plattform maskininlärning för att upptäcka de statistiska mönster och språkliga egenheter som tyder på AI-genererad text med över 99% noggrannhet[46][47]. Dessa verktyg kan integreras i skaderegleringssystem eller elektroniska patientjournaler för att automatiskt flagga misstänkta dokument - t.ex. en medicinsk rapport som sannolikt har skrivits av ChatGPT - för manuell granskning. På samma sätt kan AI-bildforensik upptäcka manipulerade medicinska skanningar eller falska ID-handlingar, och algoritmer för deepfake-detektering kan analysera videor för tecken på syntes (artefakter i pixlar, udda timing av ansiktsrörelser etc.)[48][49]. Genom att använda multimodala AI-detektorer kan vårdorganisationer sålla bort en stor del av det AI-smidda innehållet i realtid innan det orsakar skada.

- Verifiering av medicinska journaler och dokument: Vårdgivare vänder sig till specialiserade lösningar för att verifiera äktheten hos register och skadedokument. Detta inkluderar hashning och digital signering av legitima poster, samt användning av databaser med kända dokumentmallar för att jämföra med inskickade dokument. AI-drivna verifieringstjänster (till exempel TruthScans Autentisering av medicinska dokument lösning) kan omedelbart analysera ett dokuments innehåll och metadata för att avgöra om det har genererats eller ändrats maskinellt[50][51]. De tittar på inkonsekvenser som en människa skulle kunna missa - till exempel subtila formateringsavvikelser eller metadata som indikerar att en bild är AI-producerad. Övervakning av patientjournaler och försäkringsanspråk i realtid för avvikelser är också viktigt[52]. Genom att kontinuerligt skanna nya poster (laboratorieresultat, läkaranteckningar, bilagor till krav) kan dessa system fånga upp falska uppgifter före de leder till bedrägliga utbetalningar eller kliniska fel. Vissa försäkringsbolag har infört regler som innebär att all dokumentation som identifieras som AI-genererad automatiskt dras in för bedrägeriutredning. Målet är att säkerställa att varje journal eller anspråk som kommer in i arbetsflödet är tillförlitligt och oförändrat.

- Identitetssäkring och validering: Att stärka identitetsverifieringen är avgörande i en tid av syntetiska ID:n. Hälso- och sjukvårdsenheter bör genomdriva rigorösa identitetsbevis för nya patienter, leverantörer och säljare. Detta kan innebära multifaktorautentisering, biometriska kontroller (som ansiktsigenkänning eller fingeravtryck vid registrering) och användning av tjänster för identitetsverifiering som utnyttjar AI för att upptäcka falska ID-handlingar eller personuppgifter som inte stämmer överens. Ansiktsigenkänning kan till exempel kombineras med liveness-tester för att förhindra att ett AI-genererat ansikte via ett foto passerar som en riktig patient. På baksidan kan algoritmer korsverifiera en patients uppgifter (adress, telefon, e-post, närvaro på sociala medier) för att upptäcka "tunna" identiteter som saknar en normal historik - ett känt kännetecken för syntetiska ID:n[53]. Finansinstitut har använt sådana AI-drivna bakgrundskontroller med stor effekt[54]och sjukvården kan göra samma sak: t.ex. flagga en ny Medicare-ansökan om de inte har något digitalt fotavtryck före i år. Validering av leverantörsidentiteter är lika viktigt - att se till att läkaren på en telehälsovideo är licensierad och faktiskt är den de påstår, kanske genom att utfärda digitala certifikat eller vattenmärkta videoflöden som är svåra för deepfakes att efterlikna. På apotek bör personalen dubbelkolla ovanliga receptförfrågningar via direktsamtal till leverantörer och använda kodfraser eller verifieringsfrågor för att besegra potentiella AI-röstbedrägerier.

- Integrerad bedrägeriupptäckt i arbetsflöden: För att verkligen skydda systemet kan bedrägeribekämpning inte vara ett fristående steg - det måste vävs in i varje arbetsflöde i en hälsoorganisation.

I praktiken innebär detta att sjukhus och försäkringsbolag använder API-integrationer för att anropa tjänster som upptäcker bedrägerier vid kritiska tidpunkter. Till exempel, när en leverantör skickar in ett anspråk med bifogade dokument, kan en AI-tjänst automatiskt utvärdera dessa bilagor för äkthet på några sekunder. Om ett telehälsomöte initieras kan plattformen köra passiv röstanalys i bakgrunden för att säkerställa att den som ringer inte använder en syntetiserad röst. Kontinuerlig övervakning är också avgörande: moderna bedrägeriplattformar erbjuder instrumentpaneler som spårar bedrägerisignaler i hela organisationen (misslyckade valideringar, frekvent flaggning av en viss kliniks anspråk etc.) för att identifiera mönster, till exempel en organiserad bedrägeriring som arbetar med flera anspråk. Genom att behandla bedrägerier inom sjukvården mer som cyberhot - med Övervakning dygnet runt, upptäckt av avvikelser och snabb incidenthantering - organisationer kan fånga upp problem innan de sprider sig[55].

- AI för bedrägerianalys och mönsterigenkänning: Mängden vårddata är så stor att AI är oumbärligt när det gäller att hitta bedrägerimönster som människor missar. Modeller för maskininlärning kan tränas på historiska bedrägerifall för att upptäcka nya (till exempel genom att klustra anspråk som har liknande ovanliga ICD-koder eller identifiera när en läkares fakturering avviker kraftigt från andra läkares). Försäkringsbolagen använder redan prediktiv analys för att poängsätta anspråk för bedrägeririsk i realtid. Nya tekniker som grafneurala nätverk kan kartlägga relationer mellan patienter, leverantörer, diagnoser och anspråk för att upptäcka osannolika kopplingar (t.ex. att samma serienummer används i anspråk från olika stater). TruthScans svit för försäkringsbedrägerier omfattar till exempel mönsterigenkänning av fordringar och prediktiv modellering för att upptäcka organiserade bedrägeriringar och atypiska mönster innan förlusterna ackumuleras[56][57]. DOJ Fusion Center 2025 exemplifierade detta tillvägagångssätt - aggregering av data över Medicare och privata försäkringsbolag för att proaktivt hitta kluster av misstänkt aktivitet[58]. Sjukvårdsorganisationer bör likaså dela data och AI-modeller i konsortier för att bredda de bedrägerisignaler som var och en kan upptäcka. Ju mer data (inom integritetsgränserna) som matar dessa modeller, desto bättre blir de på att urskilja normalt kontra bedrägligt beteende.

- Utbildning av personal och processtyrning: Tekniken är avgörande, men mänsklig medvetenhet är fortfarande ett kraftfullt försvar. Sjukvårdspersonal och administratörer bör utbildas om AI-aktiverad bedrägeritaktik - till exempel att veta att en perfekt skrivet e-postmeddelande från en VD kan vara AI-authoriserad nätfiskeeller att de ska verifiera videosamtalares identitet om något verkar "fel" (konstiga ögonrörelser eller ljudfördröjning kan tyda på en deepfake). Regelbundna övningar och tips (liknande utbildning i phishing) kan genomföras för nya hot som deepfake-telefonbedrägerier. Enkla processkontroller lägger till lager av säkerhet: kräva återuppringning eller sekundär verifiering för stora eller ovanliga betalningsförfrågningar, använda kända säkra kommunikationskanaler för känslig information och upprätthålla en incidentresponsplan specifikt för misstänkt AI-medierat bedrägeri. Det är viktigt att organisationer odlar en kultur där medarbetarna känner sig bemyndigade att ifrågasätta avvikelseräven om det är en "läkare" på video som ber om en udda förfrågan. Många deepfake-bedrägerier lyckas genom att utnyttja förtroende och auktoritet; en vaksam arbetsstyrka som känner till dessa trick kan stoppa incidenter tidigt. Som en expert noterade kan det bli lika rutinmässigt att konfrontera deepfakes som att upptäcka phishing-mejl - en standarddel av cybersäkerhetshygienen[32][59].

- Utnyttja specialiserade tjänster: Med tanke på den snabba utvecklingen av AI-hot samarbetar många vårdorganisationer med specialiserade leverantörer av bedrägeribekämpning. Tjänster som TruthScan för hälso- och sjukvård erbjuder helhetslösningar som är skräddarsydda för medicinska användningsområden, inklusive: realtidsövervakning av integriteten i elektroniska patientjournaler (EMR), verifiering av patientdokument mot AI-manipulation, deepfake-detektering för telehälsa och rapportering om efterlevnad (t.ex. verifieringskedjor som bevisar tillbörlig aktsamhet vid bedrägeridetektering för tillsynsmyndigheter)[60][51]. Sådana plattformar tillhandahåller ofta API-integration för sömlös anpassning till befintliga system och är byggda för att uppfylla hälso- och sjukvårdsbestämmelser (HIPAA, GDPR)[61][62]. Genom att använda verktyg i företagsklass kan även mindre kliniker eller regionala försäkringsbolag få tillgång till avancerade AI-detekteringsfunktioner utan att behöva utveckla dem internt. Dessutom bör försäkringsgivare och leverantörer hålla utkik efter uppdateringar av regelverk och branschstandarder - till exempel nya lagar mot deepfake-bedrägerier (vissa jurisdiktioner förbjuder nu uttryckligen medicinska deepfakes, och USA utvidgar stadgarna för identitetsstöld till att omfatta AI-imitation[63]). Genom att anpassa sig till sådana standarder och använda de senaste verktygen kan man inte bara minska bedrägeriförlusterna utan också visa upp en stark säkerhetsposition för partners, revisorer och patienter.

Slutsatser och utsikter

År 2025 har visat sig vara ett år då Anden är ute ur flaskan - generativ AI och automatisering är nu sammanflätade med bedrägerier inom vården. Framöver kommer bedragarna sannolikt att fortsätta att förnya sig: vi kan få se AI-modeller som lär sig att härma specifika läkares skrivstilar eller deepfakes som reagerar i realtid på utmanande frågor. Kampen kommer att vara en pågående kapprustning. Hälso- och sjukvårdsbranschen svarar dock med samma kraft och investerar i AI-drivna försvar och stramare säkerhetsarbetsflöden. Genom att kombinera Avancerad detekteringsteknik, rigorösa verifieringsprocesser, branschöverskridande datadelning och vaksamma medarbetarekan sjukvårdsorganisationer avsevärt minska hotet från bedrägerier som underlättas av AI.

Det här är inte bara en IT-fråga - det är en fråga om styrning och förtroende. Styrelser och chefer inom sjukvården måste erkänna AI-bedrägerier som en strategisk risk för ekonomin och patienternas förtroende, vilket kräver regelbunden uppmärksamhet och resurser. Compliance-teamen bör uppdatera riskbedömningarna för bedrägerier så att de omfattar AI-aspekter, och försäkringsbolagen bör kanske ompröva sina försäkringsantaganden när de vet att en viss andel av anspråken kan vara AI-assisterade bedrägerier. Å andra sidan kommer ett etiskt utnyttjande av AI inom sjukvården (för kliniskt beslutsstöd, effektiv fakturering etc.) att fortsätta att ge stora fördelar - så länge det finns starka skyddsåtgärder för att förhindra missbruk.

Sammanfattningsvis, generativ AI har förändrat bedrägeribranschen inom sjukvården, men med medvetenhet och avancerade motåtgärder behöver det inte överväldiga systemet. De organisationer som kommer att lyckas är de som håller sig informerade om nya hot, anpassar sig snabbt med AI-drivna försvar och främjar en kultur av "verifiering och tillit" snarare än "tillit som standard". På så sätt kan sjukvården på ett säkert sätt utnyttja AI:s positiva sidor och samtidigt neutralisera dess missbruk, vilket skyddar både resultatet och patienternas välbefinnande i den digitala tidsåldern.

Källor: Nya branschrapporter och fall som nämns ovan, inklusive Pymnts (juli 2025)[2][3], Swiss Re Institute (juni 2025)[27], Federal Reserve Bank of Boston (april 2025)[19], BMJ (2024)[37]och TruthScan-lösningsbeskrivningar (2025)[51][64]bland andra. Alla uppgifter och citat återspeglar de senast tillgängliga 2024-2025, vilket illustrerar det aktuella läget för AI-drivna bedrägerier inom sjukvården och svaren för att bekämpa dem.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] DOJ krediterar AI-verktyg i historiskt tillslag mot sjukvårdsbedrägerier

[4] [5] [6] [7] [16] [40] [44] [45] Deepfake Statistik & Trender 2025 | Nyckeldata & Insikter - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes och kunskapens kris | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] Gen AI ökar hotet från bedrägerier med syntetiska identiteter - Federal Reserve Bank of Boston

[25] [26] [56] [57] [62] [64] AI-bedrägeridetektering inom sjuk- och livförsäkring | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Hur deepfakes, desinformation och AI förstärker försäkringsbedrägerier | Swiss Re

[28] DEA varnar för elektronisk receptbedrägeri - Pharmacy Practice News

[29] [39] Cybersäkerhet och bedrägerier inom sjukvården: En djupdykning i dagens största risker och försvar | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] Det föränderliga hotet från Deepfake-bedrägerier inom telemedicin, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Experter varnar för bedragare som använder "deepfakes" av kända läkare på sociala medier

[35] [36] [37] Betrodda TV-läkare "deepfakade" för att marknadsföra hälsobedrägerier på sociala medier - BMJ Group

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] aktuellt forskningsläge Ajit Appari och M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - AI-detektering och innehållssäkerhet för företag

[50] [51] [52] [60] [61] AI-detektering av bedrägerier med medicinska journaler | CRO-lösningar för hälso- och sjukvård | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Hur farliga är Deepfakes och andra AI-drivna bedrägerier?