Введение

Искусственный интеллект беспрецедентно меняет ландшафт финансового мошенничества. В начале 2024 года мошенники использовали сгенерированные искусственным интеллектом глубокие подделки, чтобы выдать себя за руководителей компаний во время видеозвонка, обманув сотрудника из Гонконга и заставив его перевести $25 млн. мошенникам[1][2]. Подобные инциденты демонстрируют, как генеративный ИИ позволяет преступникам создавать весьма убедительные аферы, направленные на банки и их клиентов. Регуляторы бьют тревогу: FinCEN при Минфине США в конце 2024 года выпустил предупреждение о росте мошенничества с использованием сгенерированных ИИ "глубоких подделок", включая поддельные документы, удостоверяющие личность, чтобы обойти банковские проверки.[3][4]. В этом документе рассматриваются новейшие Тенденции развития мошенничества с использованием искусственного интеллекта в сфере финансовых услуг и обсуждается, как учреждения могут усилить свою защиту. Мы исследуем, как мошенники используют генеративный искусственный интеллект - от глубоких подделок до синтетических личностей, - и описываем технологии и стратегии (включая передовые инструменты обнаружения, такие как TruthScan), которые команды мошенников и руководители могут использовать для противодействия этой эволюционирующей угрозе.

Основные тенденции в области мошенничества с использованием искусственного интеллекта в сфере финансовых услуг

ИИ и машинное обучение используются злоумышленниками для более масштабного и изощренного мошенничества. Примечательные Тактика мошенничества с использованием искусственного интеллекта В число факторов, влияющих на банки, финтех и страховщиков, входят:

- Мошенничество с выдачей себя за Deepfake: Преступники используют Видео и аудио, созданные искусственным интеллектом чтобы выдавать себя за доверенных лиц (руководителей компаний, клиентов и т. д.) в режиме реального времени. Например, реалистичные голоса deepfake использовались в атаках vishing (голосовой фишинг) для авторизации мошеннических электронных переводов, а видеоролики, созданные искусственным интеллектом, обманывали сотрудников, заставляя их одобрять фиктивные транзакции.[1][5]. Благодаря таким синтетическим носителям информации сложно определить, действительно ли вы говорите с человеком, за которого себя выдаете, что позволяет совершать кражи ценных вещей, как в случае с подделкой $25M, о котором шла речь выше. Глубокие подделки становятся доступные и простые в производствеДля клонирования голоса требуется всего 20-30 секунд аудиозаписи, а для создания, казалось бы, аутентичного видео - менее часа.[6].

- Фишинг и BEC с использованием искусственного интеллекта: Генеративный искусственный интеллект ускоряет развитие схем социальной инженерии, таких как фишинговые письма и компрометация деловой электронной почты (BEC). Чат-боты с искусственным интеллектом могут составлять высоко персонализированные мошеннические электронные письма на идеальном деловом языке, имитируя стиль письма генерального директора или создавая убедительные поддельные счета-фактуры поставщиков. Фактически, такие подпольные инструменты, как FraudGPT и WormGPT (нефильтрованные версии ChatGPT) появились, чтобы помочь киберпреступникам автоматизировать фишинг и создание вредоносных программ.[7][8]. Это означает, что потенциальный мошенник с минимальными навыками может с легкостью генерировать отточенные фишинговые кампании или вредоносный код. С помощью искусственного интеллекта один преступник может рассылать тысячи специально разработанных мошеннических писем или текстовых сообщений, что значительно увеличивает масштабы традиционных попыток мошенничества. Центр ФБР по борьбе с интернет-преступностью уже заметил более $2,7 млрд. в 2022 году, а генеративный искусственный интеллект угрожает увеличить эти потери в ближайшие годы[9][10].

- Синтетические личности и мошенничество с документами: Генеративный искусственный интеллект стимулирует бум синтетического мошенничества с идентификацией личностиодин из самых быстрорастущих видов финансовых преступлений.[11][12]. Мошенники объединяют реальные и поддельные персональные данные, создавая личности "франкенштейнов", а затем используют искусственный интеллект для подготовить реалистичные подтверждающие документы - от поддельных паспортов и банковских выписок до платежных ведомостей[7]. Генераторы и инструменты редактирования изображений AI могут подделывать подлинные удостоверения личности и фотографии которые проходят при случайном осмотре. Даже проверка на "живость" или верификация selfie могут быть потенциально побеждены с помощью изображений или видео, подделанных ИИ. Автоматизировав создание тысяч поддельных личностей (каждая из которых имеет сгенерированные ИИ фотографии профиля, социальные сети и т. д.), преступники могут массово открывать банковские счета или обращаться за кредитами, отмывать деньги или не платить по кредитам. Убытки от мошенничества с использованием синтетических идентификационных данных оцениваются примерно в $35 миллиардов в 2023 году[13]И генеративный ИИ только ускоряет эту тенденцию, делая поддельные личности дешевле и сложнее для обнаружения.

- Автоматизированное мошенничество и уклонение: Помимо создания поддельного контента, искусственный интеллект помогает мошенникам максимизировать успех своих планов. Усовершенствованные боты могут быстро проверить данные украденной кредитной карты на сайтах электронной коммерции, используя искусственный интеллект, чтобы избежать триггеров обнаружения. ИИ может помочь преступникам выявить слабые звенья в системе безопасности организации или даже синтезировать голосовые ответы, чтобы избежать проверки личности по телефону. В настоящее время в темной паутине продаются инструменты искусственного интеллекта "мошенничество как услуга" по цене от $20.[14]. Такая демократизация возможностей ИИ означает, что даже преступники низкого уровня могут совершать весьма изощренные мошеннические атаки. Гонка вооружений распространяется и на уклонение от обнаружения - мошенники используют ИИ, чтобы прощупать банковские системы защиты от мошенничества и совершенствовать свой подход, пока не найдут метод, который проскользнет через фильтры.[15]. Одним словом, искусственный интеллект позволяет проводить мошенничество с невиданными ранее масштабами и эффективностьюЭто бросает вызов традиционной обороне.

Эти тактические приемы с использованием искусственного интеллекта уже Размножаются с ужасающей скоростью. Традиционные схемы мошенничества, такие как подделка чеков или фишинг, существуют уже много лет, но ИИ увеличивает их объем и реалистичность. Данные говорят об очевидном: ИИ-мошенничество - это сургут.

Никогда больше не беспокойтесь о мошенничестве с помощью искусственного интеллекта. TruthScan Мы можем помочь вам:

- Обнаружение сгенерированного искусственного интеллекта изображения, текст, голос и видео.

- Избегайте Крупнейшее мошенничество, управляемое искусственным интеллектом.

- Защитите свои самые чувствительный активы предприятия.

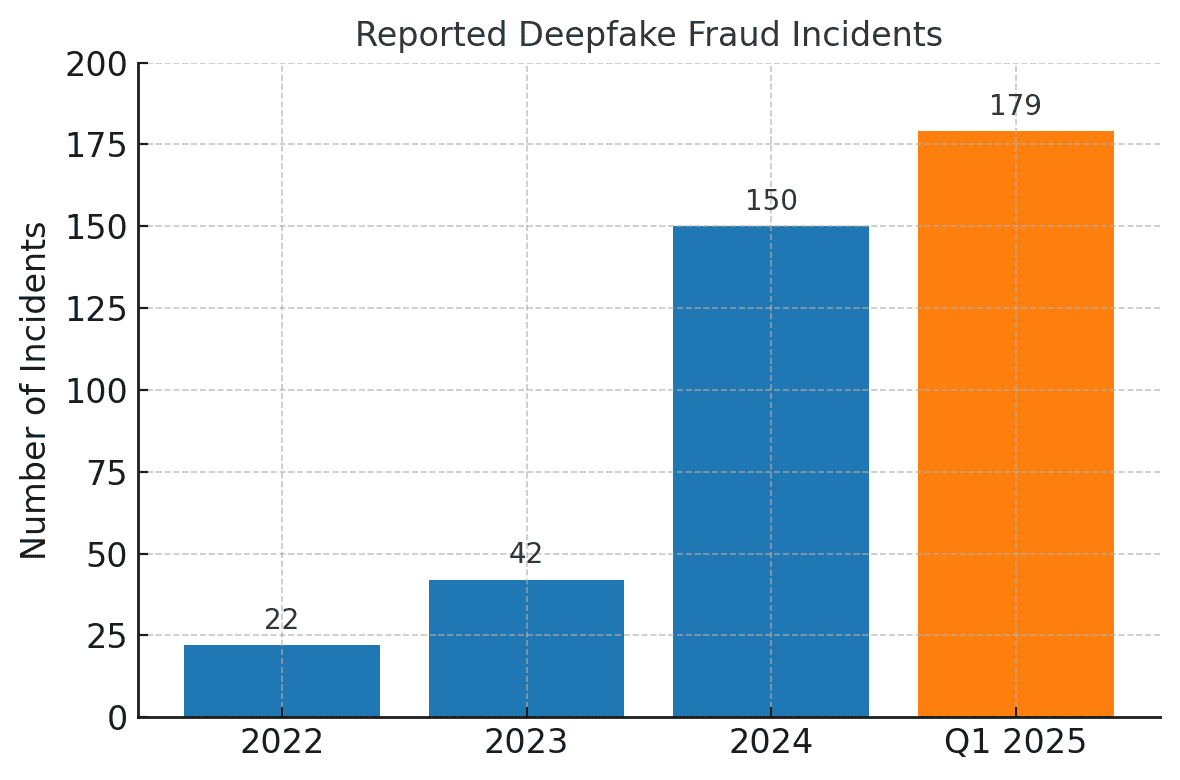

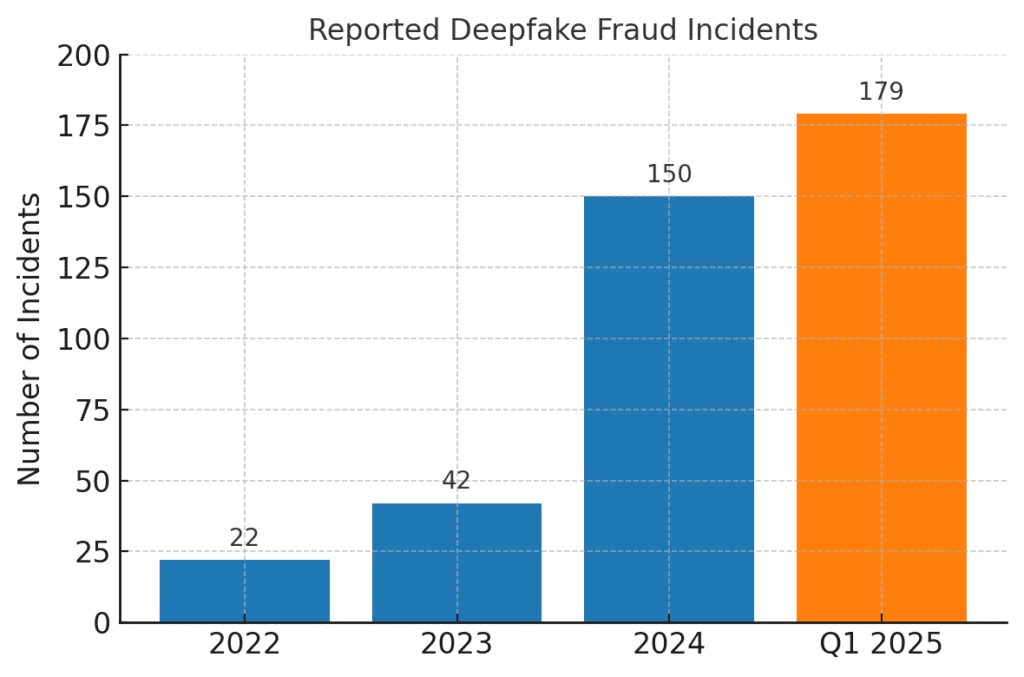

Число случаев мошенничества, связанных с deepfake, резко возросло. Если в 2022 году было зафиксировано всего 22 случая мошенничества с использованием фальшивок, то в 2023 году их стало 42, а к 2024 году число инцидентов выросло до 150. Только за первый квартал 2025 года, 179 случаев мошенничества с использованием deepfake было зарегистрировано - больше, чем за весь 2024 год.[16][17].

Последние отраслевые анализы подтверждают эти тенденции. В одном из отчетов отмечается 700% Увеличение числа инцидентов с подделками ориентированных на финтех-компании в 2023 году[18]. Еще более ошеломляющим является тот факт, что в Северной Америке произошло 1,740% Всплеск числа случаев мошенничества с глубокими подделками между 2022 и 2023 гг.[19]. Финансовые преступники быстро осваивают эти инструменты, потому что они работают - многие банки и жертвы еще не готовы обнаружить обман, созданный искусственным интеллектом.

Последствия и проблемы для финансовых учреждений

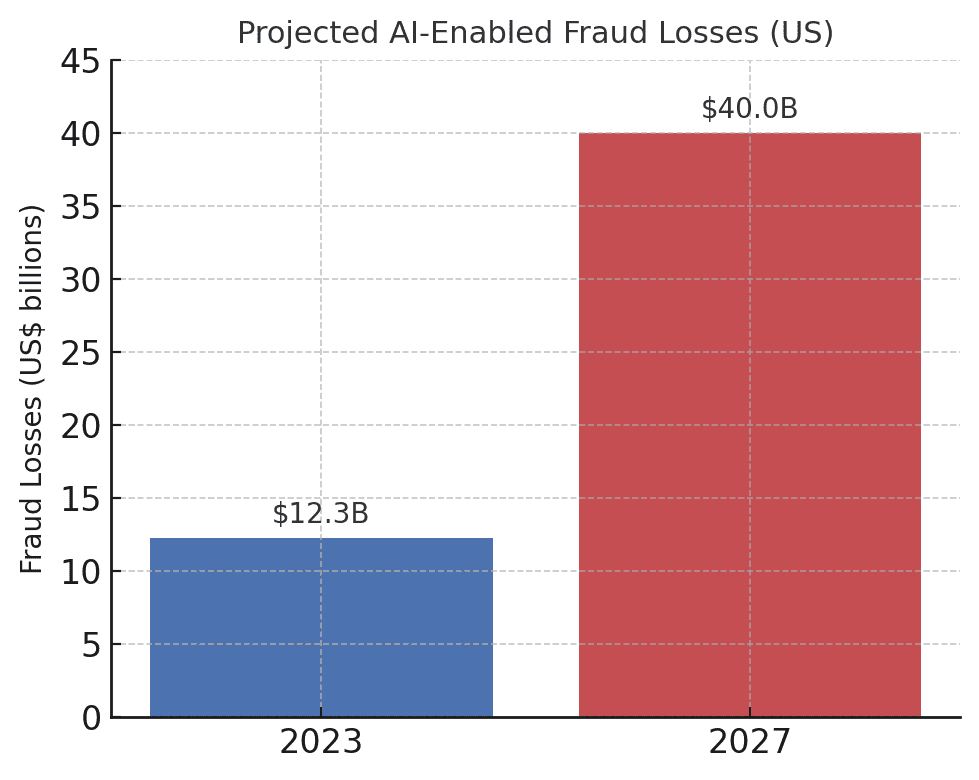

Рост мошенничества, управляемого искусственным интеллектом, представляет собой значительные воздействия на финансовые учреждения, их клиентов и всю финансовую систему. Самое непосредственное воздействие - это денежные потери. Согласно отраслевым прогнозам, к 2027 г, Убытки от мошенничества благодаря генеративному ИИ могут достичь $40 миллиардов в СШАпо сравнению с $12,3 млрд в 2023 году.[20]. Это более чем трехкратное увеличение (a 32% CAGR) отражает, насколько быстро растет риск мошенничества в долларовом выражении.

Прогнозируемые потери от мошенничества с использованием ИИ резко возрастают. По оценкам Deloitte, потери от финансового мошенничества, связанного с генеративным ИИ, в США вырастут с $12,3 млрд в 2023 году до $40 млрд к 2027 году[20].

Помимо потерь, связанных с сырьем, существуют репутационные и трастовые расходы. Потребители ожидают, что их банки будут их защищать, но мошенничество с использованием искусственного интеллекта подрывает доверие к цифровым каналам. Например, если клиент становится жертвой убедительного мошенничества deepfake (например, поддельного видеозвонка банкира), он может обвинить банк в недостаточной безопасности. Общественное доверие в голосовом подтверждении, электронных письмах и даже видеоконференциях может свестись на нет, если "увиденное/услышанное" больше не будет считаться реальным[21]. Согласно опросам, 85% финансовых специалистов в США/Великобритании рассматривают мошенничество с подделками как "экзистенциальную" угрозу безопасности своей организации.[22]. Более половины компаний на этих рынках сообщают, что стали жертвами мошенничества, основанного на фальшивках, и, что вызывает тревогу 43% из тех, на кого была направлена атака, признали, что она удалась одурачить их[23]. Каждый успешный инцидент не только наносит финансовый ущерб, но и подрывает доверие клиентов к учреждению.

Финансовые компании также борются с операционные проблемы и проблемы соблюдения нормативных требований от мошенничества с использованием искусственного интеллекта. Команды по борьбе с мошенничеством сталкиваются с резким увеличением количества предупреждений и инцидентов, что приводит к ограничению ресурсов расследования. Существующие модели обнаружения мошенничества (многие из которых основаны на правилах или старых методах машинного обучения) могут с трудом распознавать контент, синтезированный ИИ, который выглядит легитимным. Так, точность современных систем глубокого обнаружения подделок, разработанных в лабораториях, падает почти на 50% при столкновении с настоящие фальшивки в дикой природе[24]. С человеческим персоналом дела обстоят не лучше - исследования показали, что люди могут распознать только высококачественные видеоролики deepfake. 55%-60% времени...едва ли лучше, чем шанс.[25]. Это говорит о том, что без новых инструментов банки будут пропускать значительную часть попыток мошенничества, управляемых искусственным интеллектом.

Также есть нормативное измерение. Регуляторы и правоохранительные органы прекрасно осознают риски (о чем свидетельствует предупреждение FinCEN) и ожидают от финансовых учреждений адаптации. В эпоху ИИ банки могут столкнуться с ужесточением требований по проверке клиентов и информированию о мошенничестве. Например, если сотрудник банка будет обманут с помощью deepfake и одобрит перевод на сумму $10 миллионов, регуляторы могут тщательно проверить контроль и процессы должной осмотрительности банка. Сайт Закон о банковской тайне теперь в явном виде включает сообщение о подозрениях в киберпреступности и деятельности, связанной с "глубокими подделками[26][4]Это означает, что банки должны обучить персонал распознавать и сообщать о признаках мошенничества, генерируемых искусственным интеллектом, в отчетах о подозрительной деятельности (SAR). Неспособность идти в ногу с методами мошенничества с использованием искусственного интеллекта может привести к нарушению нормативных требований или юридической ответственности, если клиенты или контрагенты будут утверждать, что банк не сделал достаточно для предотвращения предсказуемых мошенничеств с использованием искусственного интеллекта.

Возможно, самой большой проблемой является асимметричный характер этой новой угрозы. Генеративный ИИ значительно снижает стоимость и квалификационный барьер для злоумышленников, при этом экспоненциально увеличивая объем и реалистичность атак. Один вирусный слух deepfake или убедительный голосовой клон-звонок могут уничтожить миллионы долларов инвестиций в аутентификацию. В то же время защитники должны проверять подлинность каждой транзакции и каждого взаимодействия, что является гораздо более сложной задачей. Это настоящая гонка вооружений: ИИ дает мошенникам самообновляющийся набор инструментов для обхода защиты, что требует от банков постоянно обновлять свои средства защиты.[15][27]. Многие финансовые учреждения признают, что они недостаточно подготовлены. Более 80% компаний не имеют официального плана реагирования на атаки deepfakeи более половины не проводили обучение сотрудников по рискам deepfake.[28][29]. Этот пробел в готовности означает, что организации в настоящее время уязвимы, но он также показывает, где необходимо принять меры.

Примечательный и отрезвляющий показатель содержится в недавнем отраслевом отчете: 42,5% попыток мошенничества в финансовом секторе теперь в той или иной форме связаны с искусственным интеллектом[30]. Другими словами, почти половина мошеннических атак, с которыми сталкиваются банки, имеет компонент ИИ - будь то сгенерированный ИИ документ, синтезированный голос или сгенерированное машиной фишинговое сообщение. Эта статистика подчеркивает, что ИИ - это не гипотетическая угроза будущего; он уже здесь, заставляя финансовые учреждения адаптироваться или сталкиваться с растущими убытками.

Защита от мошенничества с использованием искусственного интеллекта: Стратегии и решения

Противостояние мошенничеству, управляемому искусственным интеллектом, требует эволюции стратегий предотвращения мошенничества. Традиционные подходы (такие как ручная проверка или статичные системы правил) не подходят для борьбы с мошенничеством с использованием искусственного интеллекта. Вместо этого банки должны принять на вооружение технология (например, убедиться, что у них есть Безопасный SSL-сертификат), Обучение, тренировки и работа в команде чтобы переломить ситуацию. Ниже мы приводим основные стратегии и новые решения:

- Использование ИИ для борьбы с ИИ (усовершенствованные средства обнаружения): Финансовые учреждения все чаще обращаются к Решения для обнаружения на основе искусственного интеллекта для выявления контента, созданного ИИ, и аномалий. По сути, вам нужно бороться с огнем с помощью огня. Новые корпоративные инструменты, такие как TruthScan Мультимодальное обнаружение искусственного интеллекта в тексте, изображениях, голосе и видео для проверки подлинности контента в режиме реального времени.[31]. Например, банки могут использовать детекторы текстов ИИ для сканирования входящих сообщений (электронных писем, сообщений в чате) на наличие признаков сгенерированного ИИ языка, который может указывать на фишинговое письмо или поддельный запрос клиента. Система обнаружения ИИ-текста TruthScan может идентифицировать написанный ИИ контент по таким моделям, как GPT-4 с 99%+ точностьдаже определить, какие предложения, скорее всего, сгенерированы искусственным интеллектом[32][33]. Аналогичным образом, инструменты искусственного интеллекта для экспертизы изображений могут проверять документы и изображения. Детектор изображений AI может определить, что предоставленные водительские права или счет за коммунальные услуги были созданы в цифровом виде или подверглись манипуляциям, сравнив их с известными образцами изображений, сгенерированных ИИ[34]. Для борьбы с аудиоугрозами банки начинают использовать детекторы фальшивых голосов - решения, которые анализируют аудиозаписи звонков на предмет наличия акустических отпечатков синтетической речи. ИИ-детектор голоса TruthScan, например, прослушивает сигнальные признаки клонирования голоса и может проверка подлинности оратора для предотвращения звонков самозванцев[35]. Интегрировав эти детекторы через API в свои рабочие процессы, финансовые учреждения могут автоматически проверять содержимое ИИ на фоне транзакций и взаимодействий. Это обеспечивает дополнительный уровень защиты, который работает с машинной скоростью, улавливая то, что могут пропустить человеческие глаза/уши.

- Реализация многофакторной и внеполосной верификации: Поскольку ИИ становится все труднее доверять голосам или изображениям, банкам следует больше полагаться на методы проверки, которые ИИ не сможет легко подделать. К ним относится многофакторная аутентификация (MFA) по защищенным каналам. Например, если запрос на банковский перевод поступает по электронной почте или видеозвонку, необходимо ввести второй фактор, такой как одноразовый код, отправленный на известное мобильное устройство заявителя, или обратный звонок на доверенный номер телефона, находящийся в базе данных. Некоторые банки добавляют проверку "живости" для транзакций с высоким уровнем риска - например, просят клиента сделать живое селфи с определенным жестом или словом, которое сложнее воспроизвести с помощью deepfake-видео. Биометрические аутентификаторы могут быть дополнены средствами защиты от подделки (например, сканированием глубины 3D-лица или отслеживанием тонких движений глаз, которые подделкам часто не удается имитировать).[27]). Главное - избежать единых точек отказа. Даже если искусственный интеллект может обмануть один канал (например, голосовую верификацию), скоординированная внеполосная проверка или биометрический тест могут обеспечить необходимый вызов, чтобы выявить мошенничество. Принципы нулевого доверия следует применять: относитесь к любым незапрошенным или неожиданным инструкциям (даже от "известного" руководителя или клиента) как к подозрительным до тех пор, пока они не будут проверены по независимому каналу.

- Обучение сотрудников и повышение осведомленности о мошенничестве: Сами по себе технологии не являются серебряной пулей - особенно если учесть, что мошенники выбирают самое слабое звено, которым часто является человеческое доверие. Финансовые учреждения должны вкладывать средства в регулярное обучение команд по предотвращению мошенничества и сотрудников, работающих на передовой, по вопросам мошенничества с использованием искусственного интеллекта. Сотрудники должны научиться распознавать красные флажки глубоких подделок и социальной инженерии. Это может включать в себя обучение по тонким аномалиям (например, проблемы с синхронизацией губ при видеозвонке или аудио, содержащее неестественные интонации или слишком мало фонового шума - потенциальные признаки синтетического голоса). Поощряйте культуру проверкаСотрудники должны чувствовать себя вправе приостановить подозрительную операцию или запрос и проверить их самостоятельно, даже если они, как кажется, исходят от генерального директора. Случай с Попытка подмены голоса генерального директора Ferrari Показательно, что руководитель раскрыл уловку, задав личный вопрос, на который самозванец не смог ответить.[36]. Имитация фишинга/глубокой подделки также может быть полезна. Подобно тому, как компании проводят симуляцию фишинга для обучения персонала, они могут смоделировать глубокую подделку голосовой почты или фальшивую видеовстречу и посмотреть, обнаружат ли ее сотрудники. Это развивает мышечную память для противостояния реальным атакам. Учитывая, что Более 50% компаний не имеют протоколов реагирования на deepfake и слабо обучены[29]Поэтому введение таких программ - это "низко висящий плод" для повышения устойчивости.

- Аналитика мошенничества и обнаружение аномалий: Банкам следует продолжать использовать ИИ в оборонительных целях, совершенствуя аналитику по борьбе с мошенничеством. Современные системы обнаружения мошенничества Используют модели машинного обучения, которые анализируют транзакции в режиме реального времени и выявляют аномалии или модели повышенного риска. Эти модели необходимо обновлять, чтобы они включали сигналы, указывающие на мошенничество, управляемое ИИ. Например, модель машинного обучения может быть обучена выявлять метаданные или поведенческие модели, связанные с захватом аккаунта ботами (например, невероятно быстрое заполнение формы или идеально последовательный ввод текста, свидетельствующий об использовании автоматизированного скрипта). Языковые модели можно использовать для анализа содержимого сообщений и выявления того, что электронное письмо от поставщика звуки, созданные искусственным интеллектом или чрезмерно шаблонных (в сочетании с упомянутым ранее распознаванием текста с помощью искусственного интеллекта). Такие банки, как JPMorgan, начали использовать большие языковые модели в своих внутренних коммуникациях, чтобы выявить фразы или контексты, которые могут указывать на попытку социальной инженерии.[37]. Платежные сети, такие как Mastercard, сканируют огромные массивы данных (миллиарды транзакций) с помощью искусственного интеллекта, чтобы выявить мошеннические операции, которые традиционные правила могли бы пропустить.[38]. Вывод таков. оборонительный ИИ должны быть такими же инновационными, как и наступательный ИИ. Компаниям следует рассмотреть возможность разработки или приобретения моделей ИИ, специально предназначенных для обнаружения глубоко подделанного контента, синтетических личностей и генерируемых моделей атак. Очень важно, чтобы эти модели постоянно обучались на последних примерах мошенничества с помощью ИИ (такая практика называется онлайн-обучением или федеративным обучением), чтобы они не отставали от быстро меняющихся тактик преступников.[39][40].

- Сотрудничество и обмен информацией: Борьба с мошенничеством с использованием искусственного интеллекта потребует сотрудничества как внутри организации, так и между организациями. Изолированные усилия менее эффективны в борьбе с угрозой, которая выходит за пределы организационных границ. Группы по предотвращению мошенничества, группы кибербезопасности и ИТ-отделы Например, службы безопасности могут внедрить систему обнаружения подделок в инструменты для видеоконференций, а службы мошенничества - интегрировать сканирование контента в систему мониторинга транзакций. На более широком уровне банкам следует участвовать в отраслевых группах, таких как Центр обмена информацией и анализа финансовых услуг (FS-ISAC), чтобы обмениваться информацией о новых схемах мошенничества с использованием искусственного интеллекта.[41]. Если один банк обнаружит новый вектор атаки deepfake, обмен информацией может помочь другим закрыть брешь до того, как они окажутся под ударом. Совместные учения или симуляции "красной команды" со сценариями, в которых задействован ИИ (например, мошенничество с глубокой подделкой исполнительных органов или созданный ИИ обход проверки идентификационных данных), могут проводиться через отраслевые консорциумы или при поддержке регуляторов. Регуляторы сами уделяют внимание рискам, связанным с ИИ, поэтому целесообразно взаимодействовать с ними на упреждающей основе. Внося свой вклад в разработку стандартов и рекомендаций по использованию ИИ, банки могут способствовать формированию более безопасной экосистемы. В конечном итоге, поскольку Угроза одному банку - угроза всем в этом пространстве[42]Коллективный подход к защите укрепит способность каждого обнаруживать и предотвращать мошенничество с использованием искусственного интеллекта.

- Обучение клиентов и меры доверия: Наконец, финансовые учреждения не должны упускать из виду роль информированности клиентов. Поскольку мошенничества с использованием искусственного интеллекта и deepfakes нацелены на широкую публику (например, фальшивые голоса в мошенничествах с бабушками и дедушками или фиктивные чаты "техподдержки", созданные искусственным интеллектом), банки могут помочь просветить клиентов об этих опасностях. Многие банки уже рассылают предупреждения о фишинге; они могут расширить их, упомянув клонирование голоса ИИ и видеоролики с глубокими подделками, и дать советы о том, как проверять запросы. Некоторые прогрессивные организации рассылают push-уведомления или предупреждения в своих приложениях о распространении известного мошенничества (например, "Осторожно: мошенники могут использовать голосовые клоны членов семьи, требуя деньги")[43]. Непосредственно предотвратить атаки невозможно, но обучение может снизить процент успешных атак и подтвердить, что банк является партнером в сфере безопасности. Более того, банки, инвестирующие в передовые методы предотвращения мошенничества, должны подчеркивать это клиентам в качестве дифференциатор - Например, информирование клиентов о том, что все видеозвонки или предоставленные документы проверяются искусственным интеллектом на подлинность (без разглашения секретных методов), может убедить их в том, что банк использует все доступные инструменты для их защиты. Сохранение цифрового доверия будет иметь решающее значение для банков, чтобы в полной мере использовать преимущества ИИ в сфере услуг, поэтому прозрачность и ориентированные на клиента меры защиты являются частью комплексной защиты.

Роль услуг по обнаружению контента с помощью искусственного интеллекта

Краеугольным камнем в наборе инструментов для борьбы с мошенничеством в эпоху ИИ является использование Услуги по обнаружению контента с помощью искусственного интеллекта. Эти службы специализируются на выявлении "отпечатков пальцев" контента, созданного искусственным интеллектом, которые могут ускользнуть от человеческих рецензентов. TruthScan - один из таких поставщиков, предлагающий корпоративный уровень Пакет обнаружения искусственного интеллекта охватывает множество типов контента. Финансовые учреждения могут интегрировать эти инструменты для автоматической проверки на наличие подделки и признаков мошенничества:

- Проверка документов и изображений: Платформа TruthScan позволяет банкам проверка финансовых документов на предмет мошенничества, генерируемого искусственным интеллектом, в режиме реального времени[44]. Это означает, что при открытии нового счета или получении заявки на кредит с фотографией удостоверения личности и квитанции об оплате труда система может мгновенно проанализировать эти изображения на предмет признаков синтетической генерации или фальсификации. С точностью до цели более 99%[45]ИИ-детектор изображений может распознать поддельные изображения удостоверений личности или поддельные PDF-файлы, которые человек может принять за чистую монету. Этот вид проверка подлинности документов Это очень важно для предотвращения мошенничества с использованием синтетических идентификационных данных еще до открытия счетов.

- Мониторинг транзакций в режиме реального времени: Развернув API-интеграцию, TruthScan может подключаться к банковской обработке транзакций и выявлять аномалии в реальное время. Если по электронной почте приходит подозрительное сообщение, Email Scam Detector может проанализировать его содержимое и определить, что оно, скорее всего, было написано моделью искусственного интеллекта, пытающейся подделать поставщика или руководителя.[46]. Аналогичным образом Детектор искусственного интеллекта в реальном времени может отслеживать живые коммуникации (например, чаты или платформы для совместной работы), чтобы мгновенно оповещать, если, например, во время совещания с высокой ставкой будет обнаружен самозваный видеопоток deepfake[47][48]. Постоянный мониторинг с мгновенным оповещением и автоматической реакцией помогает сократить окно, в котором мошенничество может остаться незамеченным.

- Защита от подделки голоса и видео: Для центров обработки вызовов и менеджеров по работе с клиентами использование TruthScan Детектор голоса ИИ добавляет дополнительный уровень безопасности. Если мошенник звонит, выдавая себя за клиента, используя голосовой клон, система может проанализировать аудиозапись звонка и определить, содержит ли она элементы, синтезированные искусственным интеллектом (например, отсутствующие естественные микропаузы или артефакты в звуковых волнах).[35]. Что касается видео, то Детектор подделок Применяет алгоритмы компьютерного зрения к видеокадрам, чтобы выявить несоответствия - неестественные движения лица, странное освещение или несовпадение губ - которые свидетельствуют о подделке[49][50]. Проверяя целостность голосов и лиц при ключевых взаимодействиях, банки могут предотвратить попытки самозванцев обмануть их сотрудников. Эти инструменты действуют как высокотехнологичный детектор лжи для цифрового контента, незаметно работая в фоновом режиме.

Стоит отметить, что развертывание такой технологии обнаружения - это не панацея от всех бед; она должна быть откалибрована и настроена на рабочие процессы учреждения. Необходимо бороться с ложными срабатываниями (например, ИИ-детектор текста может считать подозрительными легитимные сообщения, основанные на шаблонах, пока не поймет разницу). Однако при правильной интеграции эти инструменты заметно повышают способность организации Выявляйте мошеннический контент до того, как он нанесет ущерб. Кроме того, они генерируют аудиторские следы и аналитические отчеты, которые полезны для соблюдения нормативных требований и постоянного совершенствования моделей мошенничества.

Эффективность средств обнаружения ИИ зависит, прежде всего, от постоянные обновления. Подобно тому, как антивирусное программное обеспечение требует новых сигнатур для новых вирусов, детекторы ИИ нуждаются в переобучении новейшим техникам deepfake и моделям ИИ. Такие поставщики, как TruthScan, обновляют свои алгоритмы для работы с новыми генеративными моделями и тактиками уклонения, поддерживая высокую точность даже по мере развития ИИ.[51]. Это снимает нагрузку с собственных команд и позволяет банкам не вести вчерашнюю войну, в то время как преступники переходят к новым трюкам с использованием искусственного интеллекта.

Заключение

Сфера финансовых услуг стоит на перепутье в борьбе с мошенничеством. С одной стороны, преступники стремительно осваивают генеративный ИИ, чтобы запустить мошенничество, более убедительное и масштабное, чем когда-либо. С другой стороны, банки и борцы с мошенничеством имеют в своем распоряжении все более широкий арсенал средств защиты, основанных на ИИ. Процветать будут те учреждения, которые распознавать новый ландшафт угроз и реагировать на них с не меньшей изобретательностью. Это означает инвестирование в передовые возможности обнаружения, интеграцию многоуровневых процессов проверки, обучение персонала и клиентов, а также формирование культуры бдительности и адаптации.

Мошенничество с использованием искусственного интеллекта - быстро движущаяся цель: мошенничеству deepfake, одурачившему компанию сегодня, завтра могут противостоять новые методы обнаружения, а на следующей неделе мошенники изменят свои методы. Таким образом, в 2025 году стратегия предотвращения мошенничества, соответствующая отраслевым стандартам, должна быть ориентирована на гибкость и постоянное совершенствование. Финансовые организации должны относиться к своим системам защиты от мошенничества как к живые, обучающиеся существа которые развиваются параллельно с тактикой преступников. Использование партнерских отношений с поставщиками технологий - разумный путь к созданию таких возможностей. Например, сотрудничество со специализированными компаниями, такими как TruthScan (которая предлагает решения, разработанные специально для банковской и финансовой сферы), может ускорить процесс создания возможностей для Предотвращение мошенничества с помощью искусственного интеллекта при соблюдении нормативных требований и сохранении доверия клиентов[52].

В конечном счете, защита от мошенничества, управляемого искусственным интеллектом, заключается не только в технологиях, но и в сохранении фундаментальных доверие которая лежит в основе финансов. Клиенты должны быть уверены, что их банк сможет отличить реальную транзакцию от подделки, реального клиента от самозванца с искусственным интеллектом. Развертывая передовые средства обнаружения ИИ, укрепляя протоколы проверки и опережая возникающие угрозы, компании, предоставляющие финансовые услуги, могут поддерживать это доверие. Несомненно, в будущем недоброжелатели будут предпринимать все больше попыток мошенничества, но благодаря готовности и правильным инвестициям банки смогут гарантировать, что ИИ становится скорее активом, чем угрозой в сфере предотвращения мошенничества. Это вполне достижимая цель: те же технологии ИИ, которые угрожают разрушением, могут быть использованы для защиты целостности нашей финансовой системы. Настало время для команд по предотвращению мошенничества и руководителей высшего звена действовать решительно, Использование передовых решений и стратегий, чтобы перехитрить мошенников и обеспечить будущее цифровых финансов.

Источники: В тексте использованы ссылки на последние отраслевые отчеты, предупреждения регулирующих органов и технологические документы (Deloitte[20][18]Всемирный экономический форум[19][24]Казначейство США FinCEN[3][4]Федеральная резервная система США[13], Keepnet Labs[16][30], среди прочих), чтобы предоставить данные и примеры. Все данные и примеры приводятся в тексте, чтобы читатели могли продолжить изучение.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking и риск мошенничества с помощью искусственного интеллекта | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Обнаружение опасного ИИ необходимо в эпоху глубоких подделок | Всемирный экономический форум

[3] [4] [26] FinCEN выпустил предупреждение о мошеннических схемах с использованием поддельных СМИ, нацеленных на финансовые учреждения | FinCEN.gov

[7] [8] FraudGPT и GenAI: как мошенники будут использовать искусственный интеллект дальше? | Сплав

[11] Синтетическое мошенничество с использованием личных данных: Как искусственный интеллект меняет игру - Федеральный резервный банк Бостона

[12] [13] Генеративный искусственный интеллект увеличивает угрозы мошенничества с использованием синтетических идентификационных данных

[16] [17] [22] [23] [28] [29] [30] Статистика и тенденции Deepfake 2025 | Ключевые данные и выводы - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - корпоративный искусственный интеллект для обнаружения и защиты контента

[32] [33] [51] Детектор искусственного интеллекта: ИИ-обнаружение текста корпоративного уровня - TruthScan

[44] [45] [52] Обнаружение мошенничества с помощью искусственного интеллекта | Решения CRO | TruthScan

[49] [50] Детектор фальшивок - выявление поддельных и искусственных видео - TruthScan