Страховое мошенничество вступает в новую эру, опирающуюся на искусственный интеллект. Сложные мошеннические группы и мошенники-одиночки используют генеративные инструменты искусственного интеллекта для создания фальшивых претензий, синтетических личностей, глубоко подделанных доказательств и очень убедительных мошенничеств с выдачей себя за других. В этом обзоре рассматриваются последние 2025 тенденций в страховом мошенничестве с использованием ИИ - от сгенерированных ИИ претензий и документов до мошенничества с глубокой подделкой голоса - и описывается, как страховщики могут реагировать. Мы приводим последние данные, реальные примеры и стратегические соображения для андеррайтеров, следователей по делам о мошенничестве, команд кибербезопасности, менеджеров по урегулированию убытков и руководителей высшего звена, которым необходимо понимать этот быстро меняющийся ландшафт угроз.

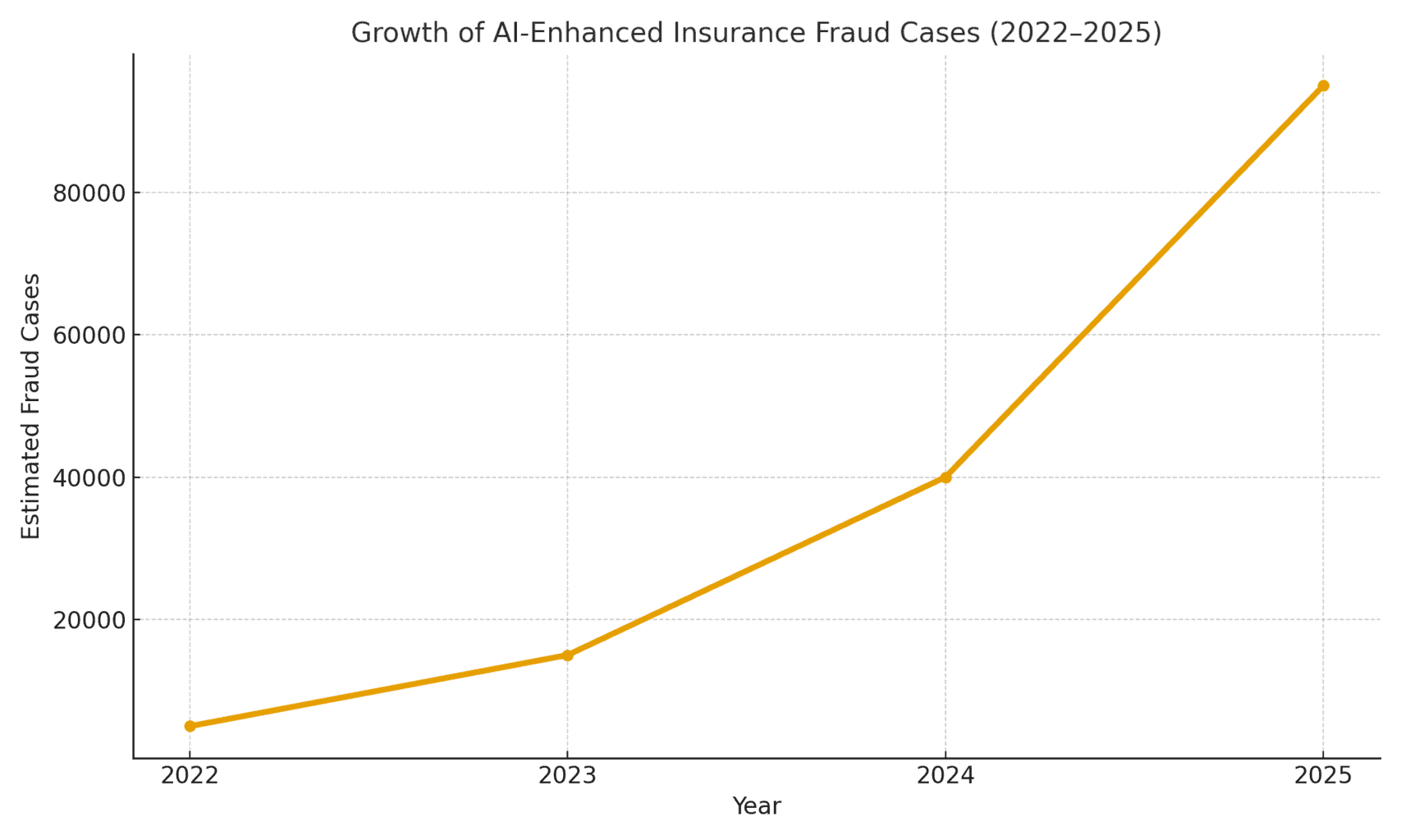

Масштаб угрозы: Мошенничество с использованием искусственного интеллекта набирает обороты. В отчете о судебно-бухгалтерской экспертизе за 2025 год было обнаружено, что На мошенников, управляемых искусственным интеллектом, теперь приходится более половины всех цифровых финансовых махинаций[1]. В частности, компания Pindrop, занимающаяся вопросами безопасности голосовой связи, заметила, что 4751TP6В 2024 году увеличится количество атак на страховые компании, связанных с мошенничеством с использованием синтетических голосовчто способствовало увеличению общего числа попыток страхового мошенничества на 19% по сравнению с прошлым годом.[2]. Страховщикам грозит примерно Подверженность мошенничеству в 20 раз выше, чем у банковотчасти из-за того, что при рассмотрении претензий широко используются документы, изображения и голосовые верификации[3]. На рисунке 1 ниже показан взрывной рост числа случаев страхового мошенничества с использованием ИИ в период с 2022 по 2025 год, поскольку многочисленные отраслевые отчеты свидетельствуют о трех- или четырехзначном процентном росте по сравнению с предыдущим годом выявленных случаев участия ИИ в мошенничестве.

Рисунок 1. Стремительный рост числа случаев страхового мошенничества с использованием ИИ (индексированный рост 2022-2025 гг.). Отраслевые данные свидетельствуют об экспоненциальном росте количества контента, созданного ИИ, в мошеннических заявлениях, особенно начиная с 2023 года.[4][2]

Утверждения, сгенерированные искусственным интеллектом, и фальшивые доказательства

Одна из наиболее распространенных тенденций - использование генеративного ИИ для создания полностью сфабрикованные страховые случаи. С помощью продвинутых генераторов текстов с искусственным интеллектом мошенники могут одним нажатием кнопки составить реалистичные описания происшествий, медицинские заключения или заявления в полицию. Такие написанные искусственным интеллектом изложения часто выглядят отточенными и правдоподобными, что затрудняет наладчикам выявление несоответствий. Например, мошенники используют ChatGPT для составления подробных описаний происшествий или отчетов о травмах, которые звучат профессионально и убедительно - задача, которая раньше требовала значительных усилий и писательского мастерства.

Еще более тревожным является то, что преступники теперь объединяют эти фальшивые нарративы с Подтверждающие доказательства, созданные искусственным интеллектом. Модели генерации изображений (например, Midjourney или DALL-E) и инструменты редактирования могут создавать фотореалистичные фотографии повреждений и травм. По сообщениям специалистов, некоторые водители начали представление изображений, сгенерированных искусственным интеллектом, для преувеличения ущерба, нанесенного автомобилю, в автомобильных исках[5]. Генеративный искусственный интеллект может создать фотографию разбитого автомобиля или затопленного дома, которых на самом деле никогда не существовало. Эти изображения часто более реалистичные, чем те, которых можно было достичь с помощью старых методов Photoshop[6]Поэтому их трудно обнаружить невооруженным глазом. В апреле 2025 года страховая компания Zurich Insurance отметила рост числа претензий с подделанные счета-фактуры, сфабрикованные сметы на ремонт и измененные в цифровом формате фотографиивключая случаи, когда Регистрационные номера автомобилей были вставлены искусственным интеллектом на снимки утилизированных машин[7][8]. Такие поддельные доказательства в сочетании с хорошо продуманной ИИ формой заявления могут проскользнуть мимо ручной проверки.

В Великобритании произошел поразительный случай, когда мошенники взяли фото фургона торговца в социальных сетях и использование искусственного интеллекта для добавления треснувшего бампераа затем представил его вместе с поддельным счетом за ремонт на 1000 фунтов стерлингов в качестве части ложного заявления о дорожно-транспортном происшествии.[9]. Афера была раскрыта только тогда, когда следователи заметили тот же фотография фургона (до повреждения) на странице владельца в Facebook[10]. Это иллюстрирует более широкое явление: страховщики сообщают о 300% скачок в редактировании изображений "неглубокой подделки" (простые цифровые манипуляции для добавления повреждений или изменения деталей) всего за один год (2021-2022 против 2022-2023)[4]. В 2024 году компания Allianz UK предупредила, что цифровые искажения фотографий и поддельные документы имеют "все признаки того, чтобы стать последним крупным мошенничеством, поразившим индустрию".[4]. Руководитель отдела по борьбе с мошенничеством компании Zurich также отметил, что То, что раньше требовало инсценировки автомобильной аварии, теперь можно сделать за компьютером. - Мошенники могут "создать мошенническое заявление, сидя за клавиатурой, и получить значительные суммы" с помощью поддельных фотографий и отчетов о полной потере имущества[11][12]. Этот сдвиг не только увеличивает объем фальшивых заявлений, но и снижает барьер для потенциальных мошенников.

Никогда больше не беспокойтесь о мошенничестве с помощью искусственного интеллекта. TruthScan Мы можем помочь вам:

- Обнаружение сгенерированного искусственного интеллекта изображения, текст, голос и видео.

- Избегайте Крупнейшее мошенничество, управляемое искусственным интеллектом.

- Защитите свои самые чувствительный активы предприятия.

Не только автомобили, Имущественные претензии и претензии в связи с несчастными случаями наблюдают за раздуванием убытков с помощью искусственного интеллекта. Есть сообщения о поддельных фотографиях для туристической страховки (например, "повреждение" багажа или инсценированные сцены кражи) и генерируемых ИИ чеках на дорогие товары, которые никогда не покупались. Претензии к жизни и здоровью Не обошлось и без мошенничества - мошенники создают фиктивные медицинские счета и свидетельства о смерти с использованием искусственного интеллекта для подделки документов. Так, в Цюрихе отметили, что технология deepfake используется для создания полностью фиктивные инженерные экспертизы и медицинские заключения в пакетах претензий[11]. Эти сгенерированные искусственным интеллектом документы, часто дополненные реалистичными логотипами и подписями, могут быть неотличимы от настоящих бумаг. Страховщиков жизни все чаще беспокоит следующее Подделка некрологов и свидетельств о смертиПреступники могут использовать искусственный интеллект для создания поддельных некрологов или писем врачей, чтобы подтвердить заявление о смерти человека, который на самом деле еще жив (или вообще никогда не существовал, о чем пойдет речь далее).

Синтетические страхователи и личности

Возможно, самым коварным событием является мошенничество с использованием синтетических данных в страховании. Синтетическое мошенничество с идентификацией личности предполагает создание фиктивного лица или организации путем комбинирования реальных данных (украденные номера социального страхования, адреса и т. д.) с вымышленными деталями (поддельные имена, поддельные документы, удостоверяющие личность). Достижения в области искусственного интеллекта позволили с легкостью генерировать реалистичные личные профили - включая фотографии и идентификаторы - для несуществующих людей[13][14]. Мошенники теперь могут алгоритмически создать абсолютно поддельного клиента, приобрести полис на его имя и впоследствии предъявлять претензии или выплаты по полису на эту поддельную личность.

В секторе страхования жизни используются схемы синтетической идентификации. взлетел. Согласно отраслевым исследованиям, в 2025 году расходы на синтетическое мошенничество с использованием личных данных составят более $30 миллиардов в годна долю которых приходится до 80-85% всех случаев мошенничества с использованием личных данных в сфере финансовых услуг[15][16]. Особенно сильно пострадали страховщики жизни: мошенники известны тем, что оформлять полисы страхования жизни на вымышленное лицо, а затем "убивать" его на бумаге, чтобы получить страховое возмещение в случае смерти[17]. Например, мошенник может создать искусственного клиента "Джон Доу", платить страховые взносы в течение года, а затем подать заявление с поддельным свидетельством о смерти и некрологом о безвременной кончине Джона Доу. Поскольку личность была тщательно установлена (кредитная история, публичные записи и т. д.), заявление о смерти может выглядеть законным - до тех пор, пока не будет найдено настоящее тело или реальные родственники. К тому времени, когда мошенничество обнаруживается, преступники уже давно ушли с выплатами.

Синтетические схемы идентификации также являются проблемой. медицинское страхование и автострахование. Преступные группировки создают личности "Франкенштейнов" путем использование номеров социального страхования детей или пожилых людей (которые не имеют кредитной истории) в сочетании с именами и водительскими правами, сгенерированными искусственным интеллектом[15]. Затем они покупают медицинские или автомобильные полисы для этих подставных лиц, а вскоре после этого подают крупные иски.. Один из вариантов - синдикаты, создающие фиктивные предприятия (подставные компании) - например, фиктивная автотранспортная компания - и приобретение для нее коммерческой страховки, чтобы впоследствии предъявить претензии по инсценированным авариям или травмам фиктивных сотрудников[18][19]. Поскольку бизнес существует только на бумаге (с генерируемыми ИИ регистрационными документами и налоговыми идентификаторами), это Синтетическое мошенничество "на основе сущностей" часто раскрывается только после выплаты страхового возмещения[18][20].

Почему синтетические личности так эффективны? Во-первых, они часто проходят через автоматические проверки подлинности. Кредитные бюро и системы KYC могут обнаружить никаких красных флажков потому что личность содержит некоторые реальные, достоверные данные (например, настоящий SSN с чистым послужным списком)[21]. Между тем, созданные ИИ фотографии профиля и сканы удостоверений личности могут выглядеть абсолютно подлинными - современный ИИ может создать человеческое лицо, которое даже продвинутая система распознавания лиц может принять за настоящее. Результат: большинство автоматизированных систем распознают эти профили как легитимные а мошенничество обнаруживается (если вообще обнаруживается) только после крупных потерь.[22].

Воздействие в реальном мире: RGA сообщает, что Синтетическое мошенничество с идентификацией личности в страховании жизни обходится отрасли примерно в $30B в год и выросла почти на 400% с 2020 года.[15][16]. По оценкам Федеральной торговой комиссии США, синтетические идентификаторы составляют подавляющее большинство случаев мошенничества с личными данными.[16]. Эти потери в конечном итоге бьют по кошелькам честных страхователей - каждая семья ежегодно платит \$700 дополнительных страховых взносов в связи с увеличением нагрузки на страховщиков из-за мошенничества.[15]. Страховщики реагируют на это, усиливая проверку при оформлении страхового полиса и претензий: внедряют проверку базы данных на предмет связи личности, отслеживают наличие нескольких полисов по одному и тому же адресу и даже проводят тесты на "живость" (проверка видеозаписи selfie, чтобы убедиться, что заявитель - реальный человек, а не просто изображение, созданное искусственным интеллектом).[23][24]. Но, как мы увидим, мошенники противостоят искусственному интеллекту на следующей арене: глубоко подделанные голоса и видео.

Голоса и видеозаписи Deepfake

Созданный искусственным интеллектом аудио- и видеоподделки добавляют новое тревожное измерение страховому мошенничеству. В 2023 и 2024 годах было зафиксировано несколько случаев, когда преступники использовали клонирование голоса выдавать себя за людей по телефону - тактика, которая первоначально применялась при ограблении банков (например, печально известный телефонный звонок генерального директора deepfake, в результате которого в 2020 году было похищено $35 миллионов), а теперь распространяется и на страхование. Мошенники клонируют голоса страхователей, врачей или специалистов по урегулированию убытков и используют их в аферах, связанных с социальной инженерией. В анализе Pindrop за 2024 год говорится, что "Глубокие подделки, технологии синтетического голоса и мошенничество, управляемое искусственным интеллектом, меняют ландшафт мошенничества"с голосовым мошенничеством беспрецедентное масштабирование[25]. Они обнаружили, что колл-центры страховых компаний подвергаются атаке зарубежных злоумышленников, использующих подделки голоса: например, поступали звонки с украденными SSN и личными данными настоящего страхователя, и если агент отвечал, то ИИ-клонированный голос звонящего может обмануть агента с помощью аутентификации на основе знаний и запросить мошенническую выплату[26]. В случае с одной из страховых компаний Западного побережья злоумышленники неоднократно использовали этот метод для захвата счетов и перенаправления выплат, используя тот факт, что проверка идентификационных данных в колл-центре проводилась с использованием голоса и личной информации, которую можно подделать.[26].

Голосовое самозванство использовалось и на стороне потребителей: Мошенники звонили жертвам несчастных случаев или бенефициарам, в то время как выдают себя за страховых представителейИИ-голос может звучать официально, чтобы выманить конфиденциальную информацию или даже платежи. И наоборот, мошенник может выдавать себя за клиента на горячей линии по урегулированию претензий, чтобы подавать претензии по телефону, используя фальшивый голос, соответствующий полу/возрасту клиентатаким образом, обходя голосовые биометрические проверки. Последние статистические данные о мошенничестве отрезвляют: эксперты отрасли прогнозируют, что 162% Рост числа мошеннических атак на страховщиков с использованием технологии deepfake в следующем году[27]а Пиндроп записал 475% всплеск атак с использованием синтетического голоса в 2024 году как уже говорилось ранее[2]. Эти атаки быстро опережают более традиционные векторы кибермошенничества.

Не только телефонные звонки, глубокие подделки на основе видео В процессе рассмотрения претензий появляются новые технологии. Многие страховщики перешли на виртуальные проверки претензий и видеоконференции (ускоренные пандемией), чтобы проверять убытки или удаленно опрашивать заявителей. Теперь мошенники Использование аватаров ИИ и поддельных видеороликов для обмана этих проверок. Поступали сообщения о том, что заявители использовали Созданные искусственным интеллектом аватары на видеозвонках в реальном времени с наладчиками, чтобы замаскироваться под кого-то другого или скрыть признаки несоответствия[28]. Например, мошенническая группа может использовать глубокую подделку "живое" видео, на котором предполагаемый истец демонстрирует свои повреждения с помощью смартфонакогда на самом деле человек на камере - это синтезированный искусственным интеллектом композит или наемный актер, на которого наложены фильтры, изменяющие лицо. Один из спекулятивных, но правдоподобных сценариев - использование глубокой подделки умерший человек: При мошенничестве с аннуитетами или страхованием жизни член семьи может использовать фальшивое видео с недавно умершим во время обычного звонка для подтверждения жизни, чтобы продолжать получать выплаты.[29]. Несмотря на то, что пока не было обнародовано ни одного громкого случая такого рода, страховщики готовятся к этому. Регулирующие органы также принимают к сведению - В США и Европе ведутся дискуссии о классификации глубоких подделок как кражи личных данных и обновлении руководства по проверке доказательств в страховании[30].

Обнаружить глубоко поддельные видео и аудио очень сложно без технических средств. Наладчики не обучены различать тонкие проблемы с синхронизацией губ или акустические странности. Тем не менее, в некоторых случаях были обнаружены тревожные сигналы: например, неестественное моргание или глюки на лице на видео, или фоновые звуковые артефакты во время звонка, которые насторожили следователей. Однако в целом, Мошенничество с поддельными страховками все еще находится на ранних стадияхПо состоянию на 2023 год юридические определения оставались неясными, а доказать, что видео было сгенерировано искусственным интеллектом, было сложно без экспертного анализа.[31]. Это дает мошенникам ощущение безнаказанности. Гонка вооружений продолжается: страховщики теперь обращаются к Криминалистический ИИ для борьбы с ИИиспользование алгоритмов глубокого обнаружения подделок для покадровой проверки подозрительных видео на наличие признаков манипуляции[24]. Производители голосовой биометрии выпускают детекторы фальшивого голоса, которые анализируют спектральный рисунок и голосовой ритм на предмет подлинности.[32]. Мы рассмотрим эти защитные технологии в следующем разделе.

Фишинг и мошенничество с использованием искусственного интеллекта

Не все мошенничества с использованием искусственного интеллекта проходят через отдел претензий; некоторые цели - это клиенты и сотрудники с помощью социальной инженерии. Фишинговые письма и тексты, созданные искусственным интеллектом стали серьезной угрозой в сфере страхования. В этих схемах мошенники используют чат-боты с искусственным интеллектом и инструменты перевода для создания очень убедительных мошеннических сообщений. Например, преступники могут выдавать себя за бренд страховой компании и стиль письма, чтобы разослать страхователям массовые фишинговые письма, в которых сообщается, что "необходимо срочно принять меры, чтобы предотвратить аннулирование полиса", и направить их на поддельный веб-сайт. В отличие от неуклюжих мошеннических писем прошлого, ИИ обеспечивает безупречную грамматику и даже персонализациючто делает их гораздо более правдоподобными. Мы видели, как искусственный интеллект использовался для поиска информации в социальных сетях, которая вплеталась в фишинговые сообщения, например, упоминание о недавней покупке автомобиля в поддельном уведомлении об автостраховании.

Другим вектором является ИИ выдает себя за агентов или руководителей. Известны случаи, когда мошенники клонировали голос владельца страхового агентства и оставляли клиентам голосовые сообщения с просьбой обновить банковскую информацию - фактически голосовая фишинговая атака. Аналогичным образом, внутреннее мошенничество может быть связано с выдачей себя за ИИ: финансовый отдел одной страховой компании едва не стал жертвой мошенников, отправивших глубоко подделанное аудиосообщение якобы от генерального директора разрешение на перевод средств (вариант "мошенничества генерального директора", который теперь покрывается некоторыми полисами страхования от электронных преступлений).[33]). По данным Liberty Specialty Markets, в 2023 году число подобных мошенничеств, связанных с выдачей себя за людей, управляемых искусственным интеллектом, увеличится на 17%.[33]и, как ожидается, будет продолжать расти.

Потребители также становятся жертвами мошенничества с использованием синтетических средств массовой информации связанные со страхованием. Коалиция против страхового мошенничества отмечает случаи, когда самозванцы, выдающие себя за страховых агентов, связываются с жертвами аварий, утверждая, что занимаются их претензиями, а затем требование немедленной оплаты или предоставления конфиденциальных данных[23]. Ничего не подозревающие клиенты, обрадованные звонком от якобы представителя, могут подчиниться, особенно если звонивший знал подробности их аварии (которые ИИ мог получить из хакерских или открытых источников). Общественность мало осведомлена об этой тактике, поэтому эксперты по предотвращению мошенничества призывают страховщиков информировать страхователей о проверке личности звонящих и электронных писем[23][34]. Подобно тому, как банки предупреждают клиентов о фишинге, страховщики в 2025 году начинают включать в свои сообщения предупреждения о мошенничестве deepfake.

Одна из общих черт этих схем с применением искусственного интеллекта - использование легкодоступных наборов "мошенничество как услуга".[35]. В темной паутине преступники могут купить или подписаться на инструменты, которые предоставляют готовые голоса deepfake, шаблоны поддельных документов, генераторы фишинговых писем и многое другое. Такая демократизация инструментов ИИ означает, что Даже низкоквалифицированные мошенники могут совершать сложные мошеннические атаки[35]. Для страховых компаний это означает шквал более убедительных попыток мошенничества, поступающих со всех сторон - из отдела урегулирования убытков, службы поддержки клиентов, электронной почты и даже социальных сетей. Это подчеркивает необходимость многосторонней стратегии защиты, сочетающей технологии, бдительность людей и межотраслевое сотрудничество.

Обнаружение и защита: Ответ на основе искусственного интеллекта

Борьба с мошенничеством, управляемым искусственным интеллектом, требует Оборона, управляемая искусственным интеллектом. Чтобы противостоять этому натиску, страховщики все чаще прибегают к передовым технологиям обнаружения и обновленным процессам. По сути, страховщики должны внедрить контрольные точки аутентификации содержимого На протяжении всего жизненного цикла страхования - от андеррайтинга до претензий и взаимодействия с клиентом - выявлять фальсификации с помощью ИИ. На рисунке 2 представлены основные виды мошенничества, которые позволяет совершать ИИ, и их распространенность, а в следующих разделах подробно описаны способы обнаружения и предотвращения каждого из них.

Рисунок 2. Виды страхового мошенничества с использованием ИИ в 2025 году (расчетная доля по схемам). Поддельные изображения (подделанные фотографии ущерба) и синтетические личности являются самыми крупными категориями, за ними следуют подделанные ИИ документы (например, квитанции, сертификаты) и глубоко подделанные аудио/видео мошенничества.

1. Инструменты обнаружения контента ИИ: Новые сервисы обнаружения ИИ могут анализировать текст, изображения, аудио- и видеоматериалы, чтобы определить, были ли они созданы машиной или подверглись манипуляциям. Например, страховщики могут использовать такие решения, как ИИ-детекторы текста и изображений TruthScan которые используют 99%+ точный искусственный интеллект для выявления написанных искусственным интеллектом документов или поддельных фотографий[36]. Страховая компания может интегрировать эти детекторы в свою систему рассмотрения претензий: при подаче претензии и ее доказательств текстовое описание может быть автоматически просканировано на наличие языковых шаблонов, сгенерированных ИИ, а загруженные изображения могут быть просканированы на наличие признаков CGI или редактирования. Инструменты корпоративного уровня могут Идентифицируйте текст, созданный искусственным интеллектом, в документах, электронных письмах и сообщениях с точностью 99%[36], и аналогично обнаружение изображений, сгенерированных искусственным интеллектом или подвергшихся манипуляциям, для обеспечения подлинности визуального контента[36]. Это означает, что фальшивый рассказ о ДТП, созданный ChatGPT, или поддельная фотография повреждений в середине пути будут отмечены для ручной проверки перед обработкой претензии. Страховщики в 2025 году все чаще используют такую проверку подлинности контента с помощью искусственного интеллекта, 83% специалистов по борьбе с мошенничеством планируют внедрить генеративный искусственный интеллект к 2025 годуСогласно опросу ACFE, сегодня ее используют всего 18%.[37][38].

2. Верификация личности и биометрические проверки: Для борьбы с синтетическими личностями страховщики также совершенствуют протоколы KYC с помощью искусственного интеллекта. Сервисы проверки личности могут проводить перекрестную проверку данных заявителя по нескольким базам данных и использовать распознавание лиц с тестами на "живость". Например, требование сделать короткое видео selfie во время регистрации (и использование сопоставления лица с предоставленным идентификатором) может предотвратить многие синтетические идентификаторы. Еще более высокотехнологичные компании, такие как TruthScan, предлагают криминалистическую экспертизу изображений, которая позволяет обнаружить сгенерированные ИИ фотографии профиля, аватары и синтетические образы личности - Их детектор изображений с искусственным интеллектом обучен распознавать лица, созданные генераторами типа StyleGAN или ThisPersonDoesNotExist[39]. Используя такие инструменты, страховщик может определить, не является ли selfie заявителя на страхование жизни настоящим человеком. На стороне голоса, голосовая биометрическая аутентификация для звонков в службу поддержки клиентов; современные детекторы голосового ИИ способны идентифицировать синтетические голоса и попытки клонирования голоса в режиме реального времени[40]. Например, TruthScan's Распознавание голоса с помощью искусственного интеллекта Система использует акустический анализ для распознавать сгенерированные ИИ голоса и аудиоподделки до того, как они обманут персонал центра обработки вызовов[40]. Эти решения действуют как брандмауэр - если кто-то звонит, выдавая себя за Джона Доу, и его голосовой отпечаток не совпадает с подлинным голосом Джона Доу (или соответствует известным характеристикам deepfake), звонок может быть отмечен или потребовано дополнительное подтверждение личности. Многофакторная аутентификация (подтверждение по электронной почте/SMS, одноразовые коды и т. д.) создает дополнительные препятствия для самозванцев.

3. Deepfake Video & Image Forensics: Когда речь заходит о видеодоказательствах, страховщики начинают применять специализированный криминалистический анализ. Современное программное обеспечение может анализировать метаданные видео, последовательность кадров и уровень ошибок для выявления глубоких подделок. Некоторые инструменты изучают отражения, тени и физиологические признаки (например, пульс в горле человека на видео), чтобы убедиться в подлинности видео. Криминалистическая экспертиза метаданных Также ценно: изучение метаданных файлов и следов генерации в изображениях или PDF-файлах может показать, что что-то, скорее всего, было создано с помощью инструмента искусственного интеллекта.[41]. Страховщики должны требовать оригинальные файлы фотографий (содержащие метаданные), а не просто скриншоты или распечатанные копии, например. Команда мошенников Zurich отметила успех в выявлении поддельных изображений автомобилей, заметив аномалии в метаданных изображения и проанализировав уровень ошибок[41]. Детекторы мошенничества по электронной почте Кроме того, можно проверять входящие сообщения на наличие признаков фишинга, написанного искусственным интеллектом, или известных вредоносных сигнатур.[42]. Многие страховщики теперь используют симуляторы фишинга и примеры мошенничества, разработанные искусственным интеллектом, в процессе обучения сотрудников, чтобы повысить их осведомленность.

4. Изменение процессов и обучение персонала: Одни только технологии - это не серебряная пуля. Усовершенствования процесса В настоящее время принимаются такие меры, как более частые выборочные личные проверки претензий, имеющих высокую стоимость, или требование предъявления документов в определенных случаях. Некоторые страховщики отложили полностью автоматизированную сквозную обработку претензий, вновь прибегая к человеческому анализу претензий, получивших высокие оценки по модели риска мошенничества, разработанной искусственным интеллектом. С человеческой стороны решающее значение имеет обучение. Следователи по делам о мошенничестве и специалисты по урегулированию претензий обучаются распознавать "тревожные сигналы" ИИ: например, несколько претензий с использованием одинаковых формулировок ("стиль" ChatGPT), изображения, лишенные подлинной случайности (например, повторяющиеся узоры на том, что должно быть органическим повреждением), или голоса, которые звучат так. почти правильно, но с роботизированным ритмом. Страховщики также ведут разъяснительную работу с клиентами: рассылают предупреждения о мошенничестве, рассказывая о схемах deepfake, и советуют, как проверить личность страхового представителя (например, предоставить известный номер обратного звонка).

5. Совместные усилия: Сотрудничество в масштабах отрасли расширяется. В Великобритании Бюро по борьбе со страховым мошенничеством и Ассоциация британских страховщиков создали рабочие группы по мошенничеству с использованием искусственного интеллекта, а правительство Устав страхового мошенничества (2024) способствует обмену данными и совместным инициативам[43]. Во всем мире страховщики сотрудничают с компаниями, занимающимися кибербезопасностью, и стартапами в области искусственного интеллекта. Примечательно, что появляются новые страховые продукты: Liberty Mutual запустила Страхование от электронных преступлений для малых и средних предприятий, которое специально покрывает мошенничество с глубокими подделками и обман руководителей компаний[44][33], подчеркивая, что этот риск вполне реален. Это также означает, что страховщики могут оказаться как жертвами, так и исполнителями мошенничества с использованием искусственного интеллекта - выплачивая деньги за мошенничество deepfake, если оно не было обнаружено, но при этом предлагая страховое покрытие для других людей, пострадавших от таких атак.

Интеграцию технологии обнаружения в рабочие процессы можно представить как многоточечную защиту в жизненном цикле претензий. Как показано на рисунке Рисунок 3Страховщики могут вводить этапы проверки ИИ в применение политики (для проверки синтетических личностей по документам и селфи), на подача претензий (для автоматического анализа загруженных документов, фотографий или аудиозаписей с целью создания искусственного интеллекта), во время рассмотрение претензий/расследование (для проведения глубокой экспертизы подозрительных улик и проверки любых голосовых взаимодействий), а также непосредственно перед выплата (окончательная проверка подлинности личности, чтобы убедиться в легитимности получателя платежа). Выявляя мошенничество на ранних стадиях - в идеале при регистрации или первом уведомлении об убытке, - страховщики экономят расходы на проведение расследований и избегают неправомерных выплат.

Рисунок 3. Интеграция точек обнаружения ИИ в жизненный цикл страхования. При оформлении полиса проверка личности на основе ИИ проверяет наличие синтетических или поддельных данных. При подаче претензии автоматические детекторы сканируют текст претензии, документы и изображения на наличие сгенерированного ИИ контента. Во время рассмотрения претензий специализированные инструменты глубокого анализа подделок и голоса проверяют любые аудио/видео доказательства. Перед выплатой биометрическая проверка личности подтверждает личность бенефициара. Такой многоуровневый подход помогает пресекать мошенничество на разных этапах.

Страховщикам не обязательно создавать все эти возможности собственными силами - многие обращаются к таким корпоративным решениям, как Пакет TruthScan для обнаружения искусственного интеллекта, которая предлагает ряд инструментов, которые могут быть интегрированы по API в системы страховщиков. Например, Сервис TruthScan по обнаружению изображений и подделок с помощью искусственного интеллекта может использоваться для проверки подлинности изображений и видео с точностью более 99%[45]. Их ИИ-детектор текста Отмечает написанный искусственным интеллектом текст в претензиях или электронных письмах[36], в то время как Детектор голоса ИИ Обнаружение клонирования голоса и проверка динамиков для защиты от телефонных самозванцев[40]. Существуют даже нишевые инструменты, такие как Детектор фальшивых квитанций мгновенный анализ счетов/квитанций на предмет признаков фальсификации или шрифтов/макетов, сгенерированных искусственным интеллектом[46] - чрезвычайно полезно, учитывая распространенность поддельных счетов за ремонт в претензиях. Используя комбинацию этих инструментов, страховщик может значительно повысить процент выявления мошенничества. Один страховщик из списка Fortune 500 сообщил о том, что улавливает 97% попыток глубокой подделки в 2024 году, используя многоуровневый подход к проверке с помощью ИИ (текст, изображение, голос) и тем самым избежав убытков на сумму \$20 млн.[47][48].

Заключение

ИИ трансформирует поле боя страхового мошенничества в глобальном масштабе. Мошенники используют генеративный ИИ для создания более убедительных фальшивок, чем когда-либо, - от полностью сфабрикованных людей и несчастных случаев до пародий, способных обмануть даже опытных профессионалов. Данные за 2024-2025 годы свидетельствуют о тревожном росте этих схем с использованием ИИ, но также подчеркивают, что страховщики, которые инвестируют в обнаружение и предотвращение, могут быть на шаг впереди. Сочетая Передовая технология обнаружения искусственного интеллекта - Например, экспертиза изображений, аутентификация голоса и анализ текста - с помощью обновленных рабочих процессов и обучения отрасль может снизить риски, не жертвуя эффективностью, которую приносят цифровые процессы.

По своей сути это гонка технологических вооружений.[49]. Как отметил один из экспертов по предотвращению мошенничества, "В этой новой реальности бдительность - это премия, которую нужно платить".[50]. Страховые компании должны формировать культуру бдительности и использовать лучшие доступные инструменты для сохранения доверия к процессу рассмотрения претензий. Это означает проверку достоверности документов, голосов и изображений с той же тщательностью, с которой страховщики оценивают риски. Это также означает сотрудничество в рамках всей отрасли для обмена информацией о возникающих тактиках мошенничества с использованием ИИ и совместной разработки стандартов (например, стандартных требований к метаданным для предоставляемых носителей или отраслевых черных списков известных поддельных личностей).

2025 год - это переломный момент: страховщики, которые проактивно адаптироваться к мошенничеству с помощью искусственного интеллекта защитят своих клиентов и балансы, а те, кто не спешит реагировать, могут оказаться мишенью для афер с громкими заголовками. Обнадеживающей новостью является то, что технология для борьбы с мошенниками существует и быстро развивается - тот же ИИ, который дает мошенникам возможности, может дать возможность страховщикам. Внедряя такие решения, как мультимодальный комплекс TruthScan для обнаружения ИИ при рассмотрении претензий и проверке личности, страховщики могут значительно снизить процент успешных попыток мошенничества, генерируемых ИИ.[51][52]. Тем самым они не только предотвращают убытки, но и дают понять потенциальным мошенникам: какими бы хитроумными ни были их инструменты, мошенничество будет раскрыто.

В общем, страховое мошенничество с помощью искусственного интеллекта - это грозный вызов, но на него можно ответить не менее умной защитой. Благодаря бдительности, межфункциональной стратегии и правильным технологическим партнерам страховая отрасль сможет продолжать выполнять фундаментальное обещание, лежащее в основе ее бизнеса, - выплачивать только законные страховые возмещения, причем делать это быстро и безопасно во все более цифровом мире.

Ссылки:

- Ассоциация британских страховщиков - Статистика мошенничества 2023[53][54]

- Allianz и Zurich о всплеске претензий, вызванных искусственным интеллектом - "мелкие подделки" The Guardian, 2024 год[4][11]

- Facia.ai - "Страховое мошенничество Deepfake: Как искусственный интеллект переписывает правила". Октябрь 2025 г.[55][56]

- Коалиция против страхового мошенничества - Синтетическое мошенничество в страховании (Quantexa), Декабрь 2024 г.[21][17]

- RGA - "Новый рубеж борьбы с мошенничеством: синтетические личности". Июнь 2025 года[15][16]

- Пиндроп - Отчет о голосовом мошенничестве, через FierceHealthcare, Jun 2025[2][3]

- Поворот чисел - "Лучшие схемы финансового мошенничества 2025 года". Октябрь 2025 г.[1][57]

- TruthScan - Платформа AI Detection (обзор услуг), 2025[51][52]

- TruthScan - Страница продукта AI Image Detector, 2025[45][39]

- TruthScan - Страница продукта AI Voice Detector, 2025[40]

- TruthScan - Страница продукта Детектор фальшивых квитанций, 2025[46]

- Liberty Specialty Markets - Пресс-релиз компании Deepfake/Cyber Fraud Insurance, Март 2025 г.[33]

- Facia.ai - Блог: Гонка вооружений по предотвращению страхового мошенничества, 2025[24][32]

- Страховой бизнес Великобритании - "Сгенерированные искусственным интеллектом изображения используются для мошенничества с автомобилями". Апр 2025[7][58]

- The Guardian - "Поддельные фотографии повреждений автомобилей настораживают страховщиков". Май 2024 г.[9][12]

[1] [35] [57] 2025 Схемы финансового мошенничества: Угрозы и красные флажки искусственного интеллекта

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] В 2024 году объем страхового мошенничества от голосовых атак увеличится на 19%

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Мошенники редактируют фотографии автомобилей, добавляя фальшивые повреждения в страховых аферах в Великобритании | Страховая индустрия | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Изображения, сгенерированные искусственным интеллектом, теперь используются для мошенничества в сфере автострахования - отчет | Insurance Business UK

[13] [14] [15] [16] Новый рубеж борьбы с мошенничеством: синтетические личности и гонка вооружений ИИ | RGA

[17] [18] [19] [20] [21] [22] JIFA: Синтетическое мошенничество: Поскольку синтетическое мошенничество уже присутствует в их экосистеме, страховщикам нужно думать больше, как банкам - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Страховое мошенничество Deepfake: Как искусственный интеллект переписывает правила страховых претензий

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Тихая угроза: Почему страховое мошенничество переходит на телефонную линию

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] Страхование от электронных преступлений для МСП нацелено на мошенничество руководителей, глубокие подделки - LSM | Страховой бизнес Великобритании

[36] [42] [51] TruthScan - корпоративный искусственный интеллект для обнаружения и защиты контента

[37] Исследование: 8 из 10 борцов с мошенничеством рассчитывают внедрить генеративный ИИ к 2025 году

[38] Основные сведения из отчета о бенчмаркинге технологий борьбы с мошенничеством за 2024 год

[39] [45] ИИ-детектор изображений | Выявление поддельных и манипулированных фотографий - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] ИИ-детектор голоса для глубоких подделок и клонирования голоса | TruthScan

https://truthscan.com/ai-voice-detector

[46] Детектор поддельных квитанций TruthScan | Проверка подлинности квитанций

https://truthscan.com/fake-receipt-detector

[47] Страховщик из списка Fortune 500 обнаруживает 97% подделок и прекращает синтетическую ...