Исчерпывающее руководство по пониманию, обнаружению и предотвращению голосового мошенничества с использованием ИИ на предприятиях

Голосовой звонок на $25 миллионов, который так и не состоялся

В феврале 2024 года финансовый работник транснациональной компании в Гонконге получил видеозвонок от своего финансового директора.

Голос на другом конце был безошибочным: все интонации, все паузы и даже легкий акцент были мгновенно узнаваемы.

Он срочно попросил ее обработать 15 электронных переводов на общую сумму $25 миллионов для завершения конфиденциального приобретения.

Никогда больше не беспокойтесь о мошенничестве с помощью искусственного интеллекта. TruthScan Мы можем помочь вам:

- Обнаружение сгенерированного искусственного интеллекта изображения, текст, голос и видео.

- Избегайте Крупнейшее мошенничество, управляемое искусственным интеллектом.

- Защитите свои самые чувствительный активы предприятия.

Финансовый директор никогда не делал этого звонка. Он был полностью сгенерирован искусственным интеллектом.

Это не единичный случай. Финансовые учреждения отмечают резкий рост мошенничества с использованием фальшивок.

За последние три года количество таких случаев увеличилось на 2137%, а искусственный интеллект сейчас составляет 42,5% от всех попыток мошенничества в секторе.

Даже несмотря на всплеск мошенничества с использованием искусственного интеллекта, более половины руководителей компаний признают, что их сотрудники не прошли обучение по выявлению и реагированию на атаки deepfake; почти 80% компаний не имеют официальных протоколов для обработки таких инцидентов.

Как работает искусственный интеллект для клонирования голоса и почему он представляет угрозу

Современному искусственному интеллекту для синтеза голоса требуется удивительно мало данных. Всего несколько секунд аудиозаписи могут клонировать голос с точностью до 85%.

Процесс сводится к трем основным этапам:

- Сбор данных: Мошенники берут образцы голоса из открытых источников, таких как конференц-связь, интервью в подкасте, ролики в социальных сетях или даже видеопосты в LinkedIn.

- Обучение модели: ИИ анализирует такие характеристики вокала, как высота тона, тембр, акцент, темп и характер дыхания.

- Поколение: Система создает синтетическую речь, достаточно убедительную, чтобы одурачить даже близких коллег.

Проблема доступности

Что делает эту угрозу еще более опасной, так это ее демократизация. Мошенникам больше не нужны ресурсы голливудского уровня.

Все, что требуется, - это доступное программное обеспечение для клонирования голоса из короткого ролика в социальных сетях; инструменты с открытым исходным кодом и облачные сервисы искусственного интеллекта сделали клонирование голоса доступным для всех, кто обладает базовыми техническими навыками.

Почему руководители являются мишенью для мошенничества

Руководители сталкиваются с опасным сочетанием факторов риска.

Благодаря публичной известности в социальных сетях образцы голоса легко найти, а их авторитет часто заставляет сотрудников быстро реагировать на срочные запросы.

В среднем каждый четвертый руководитель имеет ограниченное представление о технологии deepfake.

Текущая статистика рисует тревожную картину

В Исследование Deloitte 2024 года25,9% руководителей заявили, что за последний год их организации сталкивались хотя бы с одним инцидентом deepfake, направленным на финансовые или бухгалтерские данные, а половина всех респондентов считают, что в ближайшие 12 месяцев число таких атак возрастет.

Самое интересное: только 52% организаций уверены, что смогут распознать глубокую подделку своего генерального директора.

Как распознать мошенников с искусственным интеллектом

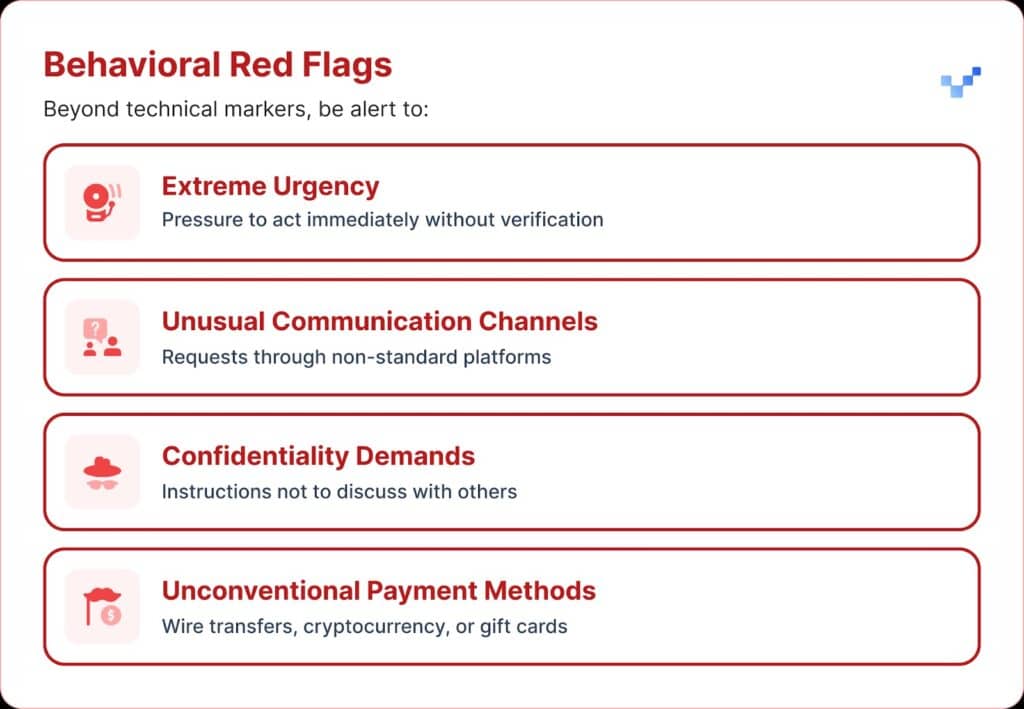

Если вы получили подозрительное голосовое сообщение, есть несколько предупреждающих признаков, на которые следует обратить внимание.

Голос мошенников с искусственным интеллектом часто звучит монотонно или плоско. Вы также можете заметить необычный темп речи, со странными паузами или неестественным ритмом.

Звук также может сопровождаться слабым электронным жужжанием или эхом, особенно во время длительных разговоров.

Во многих случаях голос повторяет ограниченные фразы, которые выглядят как заготовленные или отрепетированные.

Финансовые последствия и реальные затраты

Большинство организаций потеряли в среднем около $450 000, но в секторе финансовых услуг потери превысили $603 000.

А в самых тяжелых случаях каждая десятая организация сообщала об убытках, превышающих $1 миллион.

Эта тенденция быстро развивается. Более раннее исследование, проведенное в 2022 году, показало, что среднее финансовое бремя, связанное с мошенничеством с использованием личных данных, составляло около $230 000, что почти вдвое меньше нынешнего показателя.

Прогнозируемые будущие убытки

По данным Центра финансовых услуг компании Deloitte, объем средств, потерянных в результате мошенничества с использованием искусственного интеллекта, в США может вырасти с $12,3 млрд в 2023 году до $40 млрд к 2027 году. Это примерно 32% роста в год.

Региональная уязвимость

В Северной Америке на 1740% увеличилось количество мошенничеств с глубокими подделками.

Такой значительный региональный рост позволяет предположить, что Северная Америка может стать основной целью мошенников, занимающихся подделками, скорее всего, из-за большой цифровой экономики и широкого использования онлайн-сервисов.

Стратегические подходы к защите руководителей

1. Внедрить протоколы верификации

Один из способов усиления защиты - использование системы "безопасных слов", заранее согласованных фраз для аутентификации, которые передаются ключевым сотрудникам.

Мошенник, использующий искусственный интеллект для клонирования голоса, не будет знать правильных ответов на вопросы о проверке личности.

Еще одна мера предосторожности - многоканальная проверка.

Любой необычный финансовый запрос следует подтверждать через отдельный канал связи, никогда не полагаясь только на первоначальный способ связи.

Компаниям также следует установить четкие правила эскалации, предусматривающие периоды ожидания и этапы утверждения крупных финансовых операций, независимо от того, кто их запрашивает.

2. Не забывайте о цифровой экспозиции

Еще один уровень защиты - ограничение доступа к исполнительным аудио- и видеоматериалам в Интернете. Чем больше образцов могут собрать мошенники, тем более убедительными становятся их клоны.

Также полезно установить для руководителей четкие правила работы в социальных сетях, особенно в отношении размещения видеороликов с чистым звуком.

А когда речь идет о конференциях, организациям следует помнить о том, что записанные выступления или интервью могут содержать длинные фрагменты голосов.

3. Развертывание технических решений

Именно здесь передовые технологии обнаружения ИИ приобретают решающее значение.

Организациям нужна голосовая аутентификация корпоративного уровня и обнаружение подделок возможности, которые обеспечивают:

- Анализ в режиме реального времени: Обнаружение синтетических голосов во время общения в реальном времени

- Историческая верификация: Анализируйте записанные звонки и сообщения на предмет подлинности

- Возможности интеграции: Легко сочетаются с существующими коммуникационными платформами

- Высокие показатели точности: Минимизация ложных срабатываний при выявлении сложных подделок

4. Комплексные программы обучения

Руководителям необходимо пройти целевое обучение по вопросам угроз, связанных с голосом ИИ, и процедурам проверки.

Не менее важно повысить осведомленность сотрудников.

Каждый человек, занимающий любую должность, должен быть готов выявлять потенциальные подделки и предотвращать проникновение киберугроз в организацию.

Регулярные симуляционные учения могут укрепить эту готовность, используя имитацию попыток голосового мошенничества для проверки и отработки процедур реагирования.

Передовые решения для обнаружения голоса с помощью искусственного интеллекта

Традиционные средства защиты были созданы для сетевых угроз, а не для человеческой имперсонации с помощью ИИ.

Основные причины, по которым стандартные средства кибербезопасности не могут справиться с социальной инженерией на основе голоса:

- Нет сигнатуры вредоносного ПО: Голосовые звонки не вызывают срабатывания традиционных систем безопасности

- Фактор человеческого доверия: Люди, естественно, доверяют тому, что слышат, особенно знакомым голосам.

- Пробелы в технологиях обнаружения: Несмотря на рост числа попыток мошенничества с использованием искусственного интеллекта, включая глубокие подделки, только 22% финансовых учреждений внедрили средства предотвращения мошенничества на основе искусственного интеллекта

Необходимость в специализированном распознавании голоса

Современное голосовое мошенничество требует современных средств обнаружения.

Корпоративный класс Системы распознавания голоса с искусственным интеллектом может:

- Анализ вокальных биомаркеров: Обнаружение тонких несоответствий в синтетической речи

- Обработка в реальном времени: Обеспечьте немедленное оповещение при подозрительных звонках

- Непрерывное обучение: Адаптация к новым технологиям синтеза голоса

- Готовность к интеграции: Работа с существующей инфраструктурой связи

Организациям, серьезно относящимся к защите от голосового мошенничества, необходимо инвестировать в специально разработанную технологию обнаружения ИИ, способную соответствовать сложности угроз, с которыми они сталкиваются.

Голосовое мошенничество уже здесь, и его масштабы растут

В первом квартале 2025 года мошенничество deepfake и кража личных данных принесли более $200 миллионов убытков.

Голосовой фишинг с помощью клонов искусственного интеллекта вырос на 442%, а более 400 компаний в день подвергаются мошенничеству с поддельными генеральными директорами или финансовыми директорами.

Хотя 56% предприятий заявили, что чувствуют себя очень уверенно при обнаружении подделок, только 6% действительно избежали финансовых потерь от них.

Важно не то, станет ли ваша организация мишенью, а то, готовы ли вы к этому.

Голосовое мошенничество меняет лицо кибербезопасности. Традиционные средства защиты не в состоянии справиться с самозванством на основе искусственного интеллекта.

Чтобы оставаться защищенными, организациям нужны более совершенные средства обнаружения, эффективные программы обучения и четкие процедуры проверки.

Технологии для борьбы с мошенничеством уже существуют. Вопрос в том, воспользуетесь ли вы ею до первого случая голосового мошенничества или после.