Введение: Новая эра атак, управляемых искусственным интеллектом

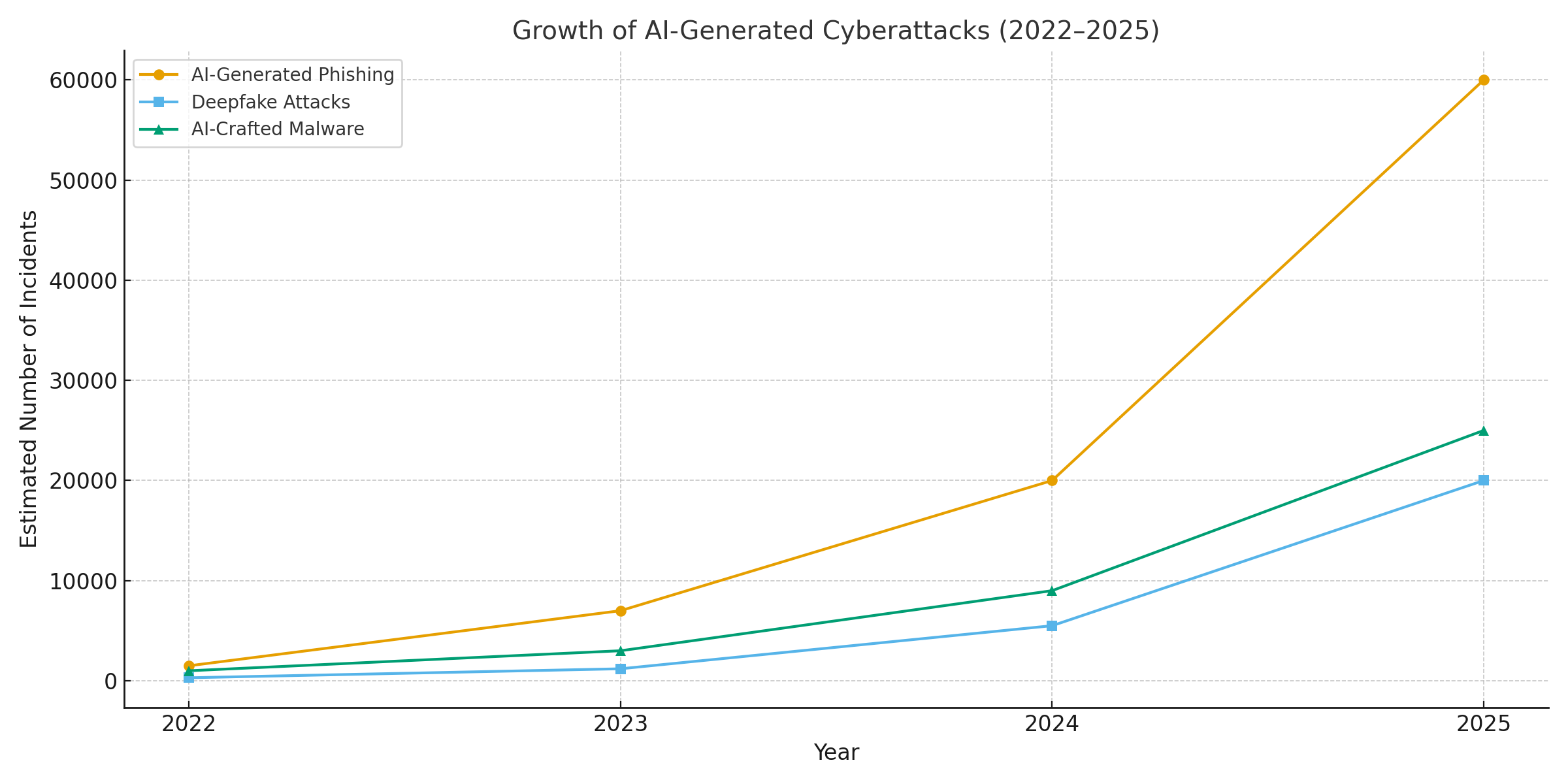

2025 год стал переломным моментом в кибербезопасности. Генеративный искусственный интеллект усовершенствовал кибератаки, позволив субъектам угроз запускать все больше частые, реалистичные и масштабируемые кампаний, чем когда-либо прежде. Фактически, за последний год по оценкам В 16% зарегистрированных киберинцидентов злоумышленники использовали инструменты искусственного интеллекта (например, модели генерации изображений и языков) для улучшения социальной инженерии[1]. От сверхубедительных фишинговых писем до глубоко подделанных аудио- и видеомошенников - злоумышленники используют ИИ во всех отраслях. Большинство специалистов по безопасности теперь приписывают Всплеск кибератак связан с генеративным искусственным интеллектомЭто позволяет злоумышленникам быстрее и умнее использовать жертв в своих целях.[2]. Генеративный ИИ эффективно снижает планку навыков для киберпреступников, одновременно увеличивая их возможности.

Почему это так важно? ИИ может мгновенно создавать отточенный, учитывающий контекст контент, который обманывает даже подготовленных пользователей. Он может с пугающей точностью выдавать себя за людей и лица и даже генерировать вредоносный код, который изменяет форму, чтобы избежать обнаружения. В результате кибератаки стало сложнее обнаружить и проще осуществить. Сайт Всемирный экономический форум предупреждает, что 72% организаций столкнулись с ростом киберрисков - особенно социальной инженерии и мошенничества - из-за растущих возможностей генеративного ИИ.[3]. Реальные случаи подтверждают это: В начале 2024 года преступники использовали сгенерированный ИИ глубокая подделка видеозвонка чтобы выдать себя за финансового директора компании и обманом заставить сотрудника перевести $25,6 млн. мошенникам[4]. А в другом случае северокорейские хакеры использовали Поддельные удостоверения личности, созданные искусственным интеллектом для обхода проверок безопасности в ходе защитной фишинговой кампании[5]. Эти примеры свидетельствуют о том, что генеративный искусственный интеллект позволяет мошенникам обходить как человеческий, так и технический контроль.

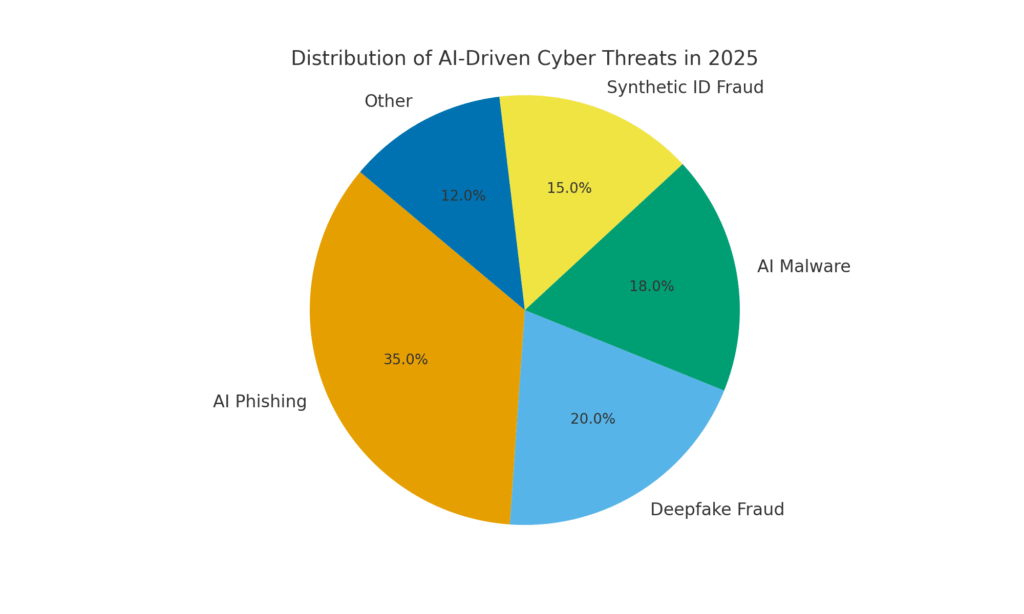

Однако искусственный интеллект также является частью решения. Передовые инструменты обнаружения (например, инструменты TruthScan) используют искусственный интеллект. против ИИ - анализ контента на предмет обнаружения тонких признаков машинного производства. В этом документе мы рассмотрим основные киберугрозы 2025 года, основанные на искусственном интеллекте, и способы их нейтрализации. С сайта Фишинг, созданный искусственным интеллектом на deepfake CEO мошенничество, Вредоносные программы, созданные искусственным интеллектом, синтетические личностиМы рассмотрим, как генеративный ИИ меняет структуру атак. Мы также обсудим конкретные меры защиты, в том числе Обнаружение контента с помощью искусственного интеллектаТехнологии deepfake forensics, deepfake forensics и identity verification могут помочь службам безопасности восстановить преимущество. Цель - рассказать о том, как предприятия, MSSP, CISO и следователи по делам о мошенничестве могут интегрировать средства обнаружения ИИ в свой стек кибербезопасности чтобы противостоять этой волне угроз, основанных на искусственном интеллекте.

Никогда больше не беспокойтесь о мошенничестве с помощью искусственного интеллекта. TruthScan Мы можем помочь вам:

- Обнаружение сгенерированного искусственного интеллекта изображения, текст, голос и видео.

- Избегайте Крупнейшее мошенничество, управляемое искусственным интеллектом.

- Защитите свои самые чувствительный активы предприятия.

Фишинг и BEC, генерируемые искусственным интеллектом: мошенничество беспрецедентного масштаба

Одно из самых заметных воздействий генеративного ИИ было оказано на фишинг и компрометация деловой электронной почты (BEC) схемы. Языковые модели ИИ могут составлять беглые, контекстуально адаптированные электронные письма за считанные секунды, устраняя бросающиеся в глаза грамматические ошибки и неловкие формулировки, которые раньше выдавали фишинг. В результате мы получаем поток очень убедительных мошеннических писем и текстов. К апрелю 2025 года, Более половины спамерских писем (51%) были написаны искусственным интеллектомПо сравнению с практически нулевым показателем за два года до этого[6]. Что еще более тревожно, исследователи обнаружили, что около 14% писем с атаками BEC были сгенерированы искусственным интеллектом к 2025 году[7] - и эта цифра, как ожидается, будет расти по мере того, как преступники будут осваивать такие инструменты, как ChatGPT. По оценкам некоторых исследований через 80% фишинговых писем теперь может помогать искусственный интеллект[8].

Объем этих сгенерированных ИИ приманок резко возрос. Согласно анализу безопасности, число фишинговых атак, связанных с генеративным ИИ, выросло на 1,265% за короткий промежуток времени[9]. За один период количество сообщений о фишинговых инцидентах подскочило 466% в одном кварталев значительной степени благодаря автоматизированным фишинговым наборам и ботам, создающим индивидуальные приманки.[9][10]. Почему такой всплеск? Потому что искусственный интеллект позволяет злоумышленникам шкала их деятельности значительно возрастает. Один преступник может использовать чатбота с искусственным интеллектом для создания тыс. персонализированных мошеннических писем, направленных на разных сотрудников или клиентов, и все это за то время, которое раньше уходило на составление одного. Такая массовая автоматизация привела к тому, что ФБР предупредило, что потери от BEC (которые уже составили $2,7 млрд в 2022 году) будут только расти, поскольку искусственный интеллект "угрожает сделать эти потери еще выше".[11][12].

Фишинговых писем стало не только больше, но и более эффективный. Жертвы чаще всего оказываются обманутыми благодаря отточенному языку и контекстуальным деталям, которые может включить ИИ. В лабораторных тестах фишинговые письма, написанные ИИ, достигли 54% коэффициент кликабельности - намного выше, чем ~12% для традиционных попыток фишинга.[13]. Такие сообщения выглядят как подлинный стиль генерального директора или ссылаются на реальные события компании, что снижает бдительность получателей. Злоумышленники даже используют искусственный интеллект для A/B-тестирования различных фраз и итерации наиболее удачных крючков.[14]. И в отличие от людей, ИИ не делает опечаток и не устает - он может бесконечно повторять варианты, пока один не проскочит через фильтры и не обманет кого-то.

Пример из практики: В середине 2025 г. Reuters Расследование показало, как мошенники из Юго-Восточной Азии использовали ChatGPT для автоматизации мошеннических коммуникаций[15]. Они массово генерировали убедительные банковские электронные письма и тексты для службы поддержки клиентов, что значительно увеличивало охват их схем. Европейская полиция также сообщила о продаже в темной паутине наборов для фишинга, управляемых искусственным интеллектом, по цене менее $20, что позволяет низкоквалифицированным игрокам запускать сложные кампании.[16][17]. Барьер для проникновения BEC и фишинга практически испарился.

Защитные меры - остановка ИИ-фишинга: В условиях такого натиска организациям необходимо укреплять свою электронную почту и каналы обмена сообщениями. Именно здесь Обнаружение контента с помощью искусственного интеллекта может помочь. Такие инструменты, как ИИ-детектор текста TruthScan и специализированный сканеры электронной почты может анализировать входящие сообщения на предмет статистических признаков текста, созданного искусственным интеллектом. Например. Детектор мошенничества по электронной почте TruthScan Использует анализ естественного языка для выявления писем, которые, вероятно, были отправлены искусственным интеллектом, даже если они выглядят законными.[18]. Эти детекторы изучают такие вещи, как идеально отточенная грамматика, сложность предложений и стилистические особенности, нехарактерные для писателей-людей. С помощью сканирование в режиме реального времениПодозрительные письма могут быть помещены в карантин или отмечены для проверки до того, как они попадут к пользователям. Корпоративные службы безопасности начинают внедрять такие фильтры на основе искусственного интеллекта на почтовых шлюзах и платформах обмена сообщениями. На практике это добавляет новый уровень защиты поверх традиционных спам-фильтров - тот, который явно настроен на отлов контента, написанного ИИ. К 2025 году ведущие предприятия интегрируют такие решения, как TruthScan, через API в свои защищенные почтовые шлюзы и облачные комплексы для совместной работы, создавая автоматическую точку проверки для Фишинг, созданный искусственным интеллектом содержание.

Deepfake Voice & Video Impersonation: Мошенничество "Видение обманчиво"

Пожалуй, самой серьезной угрозой, связанной с ИИ, в 2025 году станет появление глубокие поддельные атаки на голос и видео. Используя модели искусственного интеллекта, преступники могут клонировать голос человека на основе всего нескольких секунд аудиозаписи или создавать реалистичное видео с чьим-то лицом на основе нескольких фотографий. Эти глубокие подделки используются для мошенничества с выдачей себя за человека - от мошенничества с генеральными директорами (звонки фальшивым генеральным директорам) до фиктивных видеоконференций и не только. Недавний отраслевой отчет показал. 47% организаций сталкивались с атаками deepfake что-то вроде[19]. И это не просто теория: многочисленные кражи в 2023-2025 годах доказали, что фальшивки могут победить самую надежную проверку подлинности - наши собственные глаза и уши.

Один из печально известных случаев связан с международным банковским переводом $25 млн. после того, как сотрудник был обманут с помощью поддельной видеоконференции. Злоумышленники использовали искусственный интеллект, чтобы синтезировать подобие финансового директора компании во время звонка через Zoom, включая ее голос и манеры, и проинструктировать сотрудника о необходимости перевести средства.[4][20]. В другом случае, произошедшем в Австралии, местное правительство потерял $2,3 миллиона когда мошенники подделали голос и видео городских чиновников, чтобы те одобрили мошеннические платежи[21]. И что тревожно, преступники используют клонированные ИИ голоса в "мошенничестве с бабушками и дедушками" - звонят пожилым людям и выдают себя за их родственников, попавших в беду. Сайт ФБР и FinCEN В конце 2024 года появились предупреждения о всплеске мошенничества с использованием Созданные искусственным интеллектом "глубоко поддельные" медиавключая подставных агентов по обслуживанию клиентов и синтетические личности для обхода проверок KYC.[22].

Частота преступлений на основе deepfake быстро растет. К концу 2024 года, согласно одному из аналитических исследований. каждые пять минут происходило новое мошенничество с подделками. в среднем[23]. Только в первом квартале 2025 года количество зарегистрированных инцидентов с подделками выросло на 19% по сравнению с все 2024 год[24][25]. На долю подделок сейчас приходится примерно 6,5% всех мошеннических атак, a 2,137% увеличение с 2022 года[26][27]. Необходимые технологии стали легкодоступными - зачастую для этого требуется всего лишь 30 секунд аудио для клонирования голоса, или не более часа видеозаписей для убедительного моделирования лица человека[20]. Одним словом, еще никогда не было так просто "подделывать" личность доверенного лица и обманом заставляют жертв передавать деньги или информацию.

Защитные меры - аутентификация реальности: Чтобы противостоять угрозам deepfake, организации используют передовые технологии. обнаружение синтетических носителей инструменты. Например, ИИ-детектор голоса TruthScan и Детектор глубоких подделок TruthScan используют искусственный интеллект для анализа аудио и видео на предмет признаков манипуляции. Эти системы выполняют покадровый анализ и анализ формы волны, чтобы обнаружить такие артефакты, как неестественные движения лица, проблемы с синхронизацией губ или неравномерность спектра звука, которые выдают клип, созданный искусственным интеллектом. В ходе испытаний алгоритмы TruthScan достигли следующих результатов 99%+ точность идентификации голосов, созданных искусственным интеллектом и обнаруживать манипулируемые видеокадры в режиме реального времени[28][29]. Так, исследователи из Genians Security Center недавно использовали криминалистическую экспертизу изображений TruthScan для анализа поддельного удостоверения личности, используемого северокорейскими хакерами, - детектор изображений TruthScan отметил документ как неподлинный с 98% довериеПресечение попытки фишинга с помощью копья[5][30].

Для практической защиты предприятия устанавливают эти средства обнаружения в ключевых точках. Проверка голоса добавляется в рабочие процессы колл-центров - например, когда "клиент" запрашивает по телефону крупный перевод, аудиозапись может быть пропущена через детектор глубокой подделки голоса, чтобы убедиться, что это действительно он (а не имитатор ИИ). Аналогично, платформы для видеоконференций можно интегрировать глубокое сканирование видеопотоков участников в режиме реального времени, чтобы выявить любые искусственные лица. Пакет TruthScan для обнаружения глубоких подделок, например, предлагает Анализ видеозвонков в режиме реального времени и аутентификация по лицу которые могут подключаться к Zoom или WebEx через API[31][29]. Это означает, что если кто-то попытается присоединиться к встрече, используя созданное ИИ видео с вашим генеральным директором, система сможет отметить "возможную глубокую подделку" до того, как будет нанесен ущерб. Кроме того, важные транзакции теперь часто включают этап проверки (внеполосный или многофакторный), который может использовать аутентификацию контента - например, требовать краткого речевого подтверждения, которое затем проверяется голосовым детектором ИИ на подлинность. Используя эти инструменты, компании создают систему безопасности: даже если сотрудники см. или слышать Если что-то кажется правдоподобным, закулисная экспертиза ИИ поставит под сомнение его реальность. В условиях пронизанного ИИ ландшафта угроз, "Не доверяйте - проверяйте". становится мантрой для любой голосовой или видеосвязи, связанной с деньгами или конфиденциальным доступом.

Вредоносные программы, созданные искусственным интеллектом, и обфусцированный код: Эволюционирующие угрозы в коде

Влияние искусственного интеллекта не ограничивается социальной инженерией - он также меняет игру в области разработки вредоносного ПО и кода для атак-уклонений. В 2025 году группа Threat Intelligence Group компании Google обнаружила первые штаммы вредоносных программ с использованием искусственного интеллекта во время казнь, чтобы изменить свое поведение[32][33]. Один из примеров, получивший название PROMPTFLUXЭто был вредоносный скрипт, который обращался к API искусственного интеллекта (модель Gemini от Google), чтобы переписывать собственный код на летусоздание новых обфусцированных вариантов для обхода антивирусного обнаружения[34][35]. Такая эволюция ИИ "точно в срок" знаменует собой скачок к автономным, полиморфным вредоносным программам. Еще один пример, PROMPTSTEALиспользовали помощника по кодированию с искусственным интеллектом для создания однострочных команд Windows для кражи данных, по сути, передавая части своей логики механизму искусственного интеллекта в режиме реального времени[36][37]. Эти инновации указывают на будущее, в котором вредоносное ПО сможет постоянно модифицировать себя - подобно тому, как это делает человек-испытатель - для поражения защитных систем.

Даже в отсутствие искусственного интеллекта злоумышленники используют его в процессе разработки для создания более мощного вредоносного кода. Генеративный ИИ может создавать вредоносные программы, которые очень запутанныйВ них содержатся слои запутанной логики, затрудняющие обратную разработку. По данным разведки угроз, Более 70% крупных взломов в 2025 году были связаны с полиморфным вредоносным ПО той или иной формы изменяет свою сигнатуру или поведение, чтобы избежать обнаружения[38]. Дополнительно, 76% фишинговых кампаний теперь используют полиморфные тактики, такие как динамические URL или переписанные искусственным интеллектом полезные нагрузки[38]. Инструменты, подобные предложениям темной паутины WormGPT и FraudGPT (неограниченные клоны ChatGPT) позволяют даже неспециалистам генерировать вредоносные программы-дропперы, кейлоггеры или код для выкупа, просто описав то, что они хотят.[39]. В результате появляется множество новых вариантов вредоносного ПО. Например, в 2024 году похититель информации под названием BlackMamba возникла, которая была полностью созданный искусственным интеллектомИспользуя ChatGPT, он писал свой код сегментами - при каждом выполнении создавался немного другой двоичный файл, что сбивало с толку традиционные антивирусы, основанные на сигнатурах.[38]. Исследователи безопасности также продемонстрировали сгенерированные искусственным интеллектом полиморфные доказательства концепций, которые могут обойти многие средства защиты конечных точек.[40].

Кроме того, злоумышленники используют искусственный интеллект для тонкой настройки своих доставка вредоносных программ. ИИ может грамотно составлять сценарии фишинговых писем (как уже говорилось), содержащих ссылки на вредоносные программы. Он также может помочь в разработке эксплойтов - например, использовать ИИ для поиска новых уязвимостей или оптимизации шелл-кода. По имеющимся данным, государственные субъекты используют продвинутые модели ИИ для обнаружения эксплойтов нулевого дня и разработки специализированных вредоносных программ для целей.[41]. Все эти тенденции означают, что вредоносное ПО в 2025 году станет более скрытным и адаптивным. Оно часто "Совместное создание" с искусственным интеллектомчто затрудняет его обнаружение с помощью обычных правил.

Защитные меры - ИИ против ИИ в защите от вредоносного ПО: Защита от вредоносных программ, созданных искусственным интеллектом, требует сочетания передовых методов обнаружения и анализа на основе искусственного интеллекта на стороне защиты. Многие организации расширяют свои защита конечных точек и EDR (Endpoint Detection & Response) с моделями AI/ML, которые ищут поведенческие паттерны кода, созданного ИИ. Например, внезапные трансформации кода на хосте или необычные шаблоны вызовов API могут указывать на то, что PROMPTFLUX регенерирует сам себя. Аналогично, мониторинг сети может выявить аномалии, например, вредоносное ПО, обращающееся к сервисам ИИ (что не является "нормальным" для пользовательских приложений). Поставщики обучают детекторы на основе ML на семьи выявленных на данный момент вредоносных программ с искусственным интеллектом, что улучшает распознавание этих новых угроз.

Одним из новых решений является интегрированное сканирование контента с помощью ИИ в конвейеры разработчиков и сборки. Это означает использование детекторов на основе искусственного интеллекта для анализа скриптов, сборок программного обеспечения и даже изменений конфигурации на предмет наличия вредоносного или созданного искусственным интеллектом содержимого. Например, Детектор TruthScan, работающий в режиме реального времени Можно использовать не только текст - мультимодальный анализ может выявить подозрительный код или конфигурационные файлы, распознав, были ли они созданы машиной с использованием шаблонов обфускации.[42][43]. Команды разработчиков и MSSP начинают сканировать скрипты инфраструктуры-как-код, журналы PowerShell и другие артефакты на предмет признаков написанных ИИ сегментов, которые могут указывать на руку злоумышленника. Несмотря на то что эта область только зарождается, она многообещающа: в одном случае команда безопасности использовала детектор ИИ для обнаружения обфусцированного файла фишингового набора, который "казался" сгенерированным ИИ, а на самом деле был частью атаки[44]. Код файла был слишком сложным и многословным (отличительные признаки генерации ИИ), и сканирование содержимого ИИ подтвердило высокую вероятность того, что он был написан не человеком.[40].

Наконец, крайне важен обмен информацией об угрозах, ориентированный на угрозы ИИ. Когда Google GTIG публикует подробности о вредоносных программах на основе Prompt или когда исследователи сообщают о новых методах обхода ИИ, организации должны включить их в свою систему обнаружения. Поведенческая аналитика - поиск таких действий, как порождение процессом сценария, который переписывает код того же процесса, - может выявить аномалии, которые демонстрируют вредоносные программы с искусственным интеллектом. Одним словом, защитники должны бороться с огнем с помощью огня: развертывать Средства безопасности на основе искусственного интеллекта которые могут адаптироваться так же быстро, как и вредоносные программы, управляемые искусственным интеллектом. Сюда входит все: от антивирусов с поддержкой ИИ до аналитики поведения пользователей, которая позволяет определить, когда учетная запись или система начинает вести себя "не совсем по-человечески". Применяя ИИ для защиты, команды безопасности смогут противостоять преимуществам в скорости и масштабе, которые ИИ дает злоумышленникам.

Синтетические личности и схемы мошенничества с использованием искусственного интеллекта

Переход от вредоносных программ к миру мошенничества: мошенничество с использованием синтетических данных взорвалась благодаря генеративному искусственному интеллекту. Синтетическое мошенничество с идентификацией личности предполагает создание фиктивных личностей путем комбинирования реальных и поддельных данных (например, настоящий SSN + поддельное имя и документы). Эти "франкенштейновские" личности затем используются для открытия банковских счетов, подачи заявок на кредит или прохождения KYC-проверки, что в конечном итоге приводит к невыплаченным кредитам или отмыванию денег. Это уже было одним из самых быстрорастущих видов мошенничества, а теперь ИИ подлил масла в огонь. Убытки от мошенничества с использованием синтетических идентификаторов $35 миллиардов в 2023 году[45]а к началу 2025 года, по некоторым оценкам Почти 25% всех потерь от банковского мошенничества были обусловлены синтетическими идентичностями[46]. Аналитики Experian обнаружили, что более 80% случаев мошенничества с новыми счетами на некоторых рынках теперь связаны с синтетическими идентификаторами[19] - ошеломляющая статистика, подчеркивающая, насколько распространенным стало это мошенничество.

Генеративный ИИ усиливает синтетическое мошенничество несколькими способами. Во-первых, ИИ позволяет легко создавать "Документы для заводчика" и цифровые следы, необходимые для продажи поддельных документов. В прошлом мошенник мог отфотошопить удостоверение личности или вручную создать поддельные счета за коммунальные услуги. Теперь же существуют инструменты для создания Подлинные фотографии, удостоверения личности, паспорта, банковские выписки, даже профили в социальных сетях использование генераторов изображений и языковых моделей ИИ[47][48]. Например, с помощью ИИ можно создать реалистичную фотографию головы несуществующего человека (что препятствует легкому поиску по обратному изображению) и сгенерировать подходящее поддельное водительское удостоверение с этой фотографией. ИИ также может имитировать "признаки жизни" личности - например, создавать записи о синтетических родителях, адреса или сообщения в социальных сетях чтобы прояснить предысторию[49]. ФРС Бостона отметила, что искусственный интеллект может даже производить глубокая подделка аудио и видео поддельного человека - Например, синтетический пользователь может "появиться" на видео с верификацией селфи, с уникальным лицом и голосом, созданным искусственным интеллектом.[50].

Во-вторых, искусственный интеллект помогает мошенникам увеличивать масштаб их операций. Вместо того чтобы подделывать по одной-две личности за раз, они могут программно генерировать сотни или тысячи полных пакетов документов и массово заполнять заявки на открытие новых счетов.[51][52]. Некоторые сервисы темной паутины эффективно предлагают "Синтетические личности как услуга"В ходе программ по оказанию помощи при пандемии COVID-19 преступники использовали ботов, сгенерированных искусственным интеллектом, чтобы массово подавать заявки на получение кредитов и пособий. Например, во время программ помощи при пандемии COVID-19 преступники использовали ботов с созданными искусственным интеллектом идентификационными данными для массового обращения за кредитами и пособиями, переполняя систему поддельными заявителями. По прогнозам Juniper Research, глобальные затраты на мошенничество с цифровыми идентификационными данными (подпитываемое этими тактиками) составят рост 153% к 2030 году по сравнению с 2025 годом[53].

Защитные меры - проверка личности в мире ИИ: Традиционные методы подтверждения личности испытывают трудности в борьбе с подделками, создаваемыми искусственным интеллектом. Чтобы адаптироваться, организации внедряют многоуровневая проверка личности и поведения усиленный искусственным интеллектом. Ключевым слоем является передовой криминалистическая экспертиза документов и изображений. Например, ИИ-детектор изображений TruthScan и Детектор поддельных документов позволяют анализировать загруженные удостоверения личности, селфи или документы на предмет признаков синтеза или фальсификации. Эти инструменты изучают артефакты на уровне пикселей, несоответствия освещения и метаданные, чтобы определить, является ли изображение сгенерированным ИИ или подвергшимся манипуляциям. Они могут уловить тонкие признаки - например, идентичные фоновые рисунки на фотографиях, сгенерированных GAN, или шрифты и интервалы в удостоверении личности, которые не соответствуют ни одному из известных правительственных шаблонов. Развернув такие детекторы на этапе регистрации, банки смогут автоматически отмечать водительские права или селфи заявителя, если они, скорее всего, сгенерированы искусственным интеллектом (например, система TruthScan отметила бы поддельный военный билет, использовавшийся в деле о фишинге от Kimsuky APT).[5]). Согласно пресс-релизу TruthScan, их платформа используется финансовыми учреждениями для масштабной проверки подлинности документов, выявляя глубокие подделки с чрезвычайно высокой точностью.[54].

Другой слой - это поведенческая аналитика и проверки перекрестных ссылок. Настоящие личности обладают глубиной - многолетняя история, публичные записи, активность в социальных сетях и т. д. Идентификаторы, созданные искусственным интеллектом, какими бы отточенными они ни были, часто не имеют таких глубоких корней. Банки и кредиторы теперь используют искусственный интеллект для перекрестной корреляции данных заявки с публичными и собственными данными: Есть ли история использования телефонного номера и электронной почты этого человека? Имеет ли смысл геолокация устройства или IP-адреса? Вводят ли они данные в формы по-человечески или копируют (как это делают боты)? Модели искусственного интеллекта можно обучить отличать подлинное поведение клиентов от синтетических шаблонов. Федеральная резервная система США отметила, что "Синтетические личности неглубоки, и ИИ это видит". - Проверка на основе искусственного интеллекта позволяет быстро найти цифровой след личности и подать сигнал тревоги в случае его отсутствия.[55]. На практике сервисы проверки личности теперь используют искусственный интеллект, который проверяет, совпадает ли селфи пользователя с прошлыми фотографиями (чтобы обнаружить подмену лица), и даже предлагает пользователям произвольные действия (например, определенные позы или фразы) во время проверки живости, что затрудняет правильную реакцию глубоких подделок.[56][57].

Наконец-то, непрерывный мониторинг Анализ поведения учетной записи после регистрации помогает выявить синтетические учетные записи, которые проскочили мимо. Поскольку эти счета не привязаны к реальной личности, их модели использования в конечном итоге часто выделяются (например, совершение идеально своевременных транзакций для наращивания кредита, а затем его максимальное использование). Мониторинг мошенничества с помощью искусственного интеллекта (например, платформы Sift или Feedzai) может выявить аномалии в использовании учетных записей и отметить потенциальные синтетические счета для проверки. Таким образом, для борьбы с мошенничеством с использованием искусственного интеллекта необходимо Подтверждение личности с помощью искусственного интеллекта - сочетает в себе экспертизу документов, проверку биометрических данных, корреляцию данных и поведенческий анализ. Хорошая новость заключается в том, что те же самые достижения в области искусственного интеллекта, которые позволяют выявлять мошенничество, используются и для его обнаружения. Например, компания TruthScan предлагает пакет для проверки личности которая объединяет анализ текста, изображения и голоса для проверки новых пользователей. Используя эти инструменты, один крупный банк отметил значительное снижение числа успешных открытий синтетических счетов, хотя средние показатели по отрасли росли. Гонка вооружений продолжается, но защитники учатся распознавать слабые "цифровые признаки" синтетики, как бы хорошо ИИ ни старался замести следы.

Интеграция обнаружения ИИ в стек безопасности

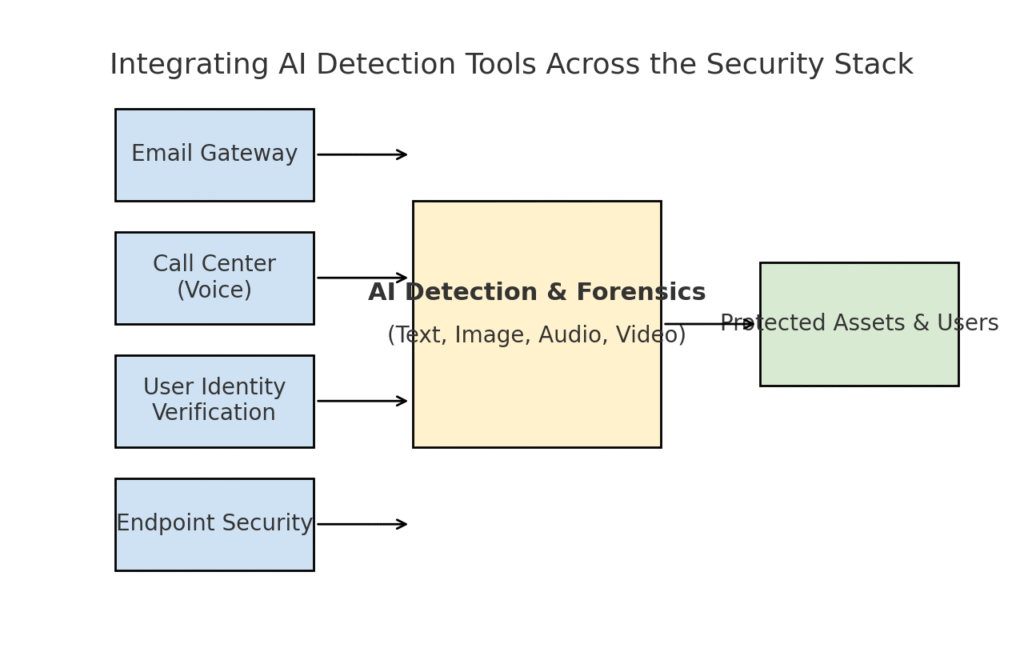

Мы рассмотрели несколько различных областей угроз - фишинг, глубокие подделки, вредоносное ПО, синтетическое мошенничество - все они были усилены искусственным интеллектом. Очевидно, что Нет единого инструмента или одноразового решения решит эту проблему. Вместо этого предприятиям необходима комплексная стратегия, направленная на Встраивайте обнаружение и проверку на основе искусственного интеллекта на каждом уровне в стеке кибербезопасности. Подход должен отражать поверхность атаки, охватывая электронную почту, веб, голосовую связь, документы, идентификационные данные и т. д. На приведенной ниже схеме показано, как организации могут интегрировать средства обнаружения ИИ TruthScan (и аналогичные решения) в общие уровни безопасности предприятия:

Интеграция средств обнаружения ИИ на разных уровнях стека безопасности - от шлюзов электронной почты и центров обработки вызовов до проверки пользователей и защиты конечных точек. ИИ для обнаружения контента (центр) анализирует текст, изображения, аудио и видео в режиме реального времени, создавая точки принуждения, которые защищают активы и пользователей.

В этой модели, Мультимодальные детекторы искусственного интеллекта действуют как центральный мозг взаимодействие с различными средствами контроля безопасности:

- Шлюзы электронной почты: Прежде чем попасть в почтовый ящик, входящие письма проходят через детектор текстов и мошенничества с искусственным интеллектом. Это связано с защитой от фишинга, которую мы обсуждали, например, использование Детектор мошенничества по электронной почте TruthScan через API вашего почтового провайдера для автоматического помещения в карантин подозрительных писем, сгенерированных искусственным интеллектом[18]. Он также может применяться к платформам обмена сообщениями (чат-приложениям, SMS-шлюзам) для проверки содержимого на наличие фишинговых или мошеннических моделей.

- Центры обработки вызовов и голосовые системы: Защита телефонных и VOIP-каналов обеспечивается за счет интеграции технологии глубокого обнаружения подделки голоса. Например, линия поддержки клиентов банка может использовать ИИ-детектор голоса TruthScan анализ звука входящих звонков в режиме реального времени и предупреждение, если отпечаток голоса звонящего является синтетическим или не соответствует его известному профилю[58][59]. Это помогает предотвратить вишинг и атаки с использованием голосовых имперсонаций (например, поддельные звонки генерального директора).

- Процессы верификации личности пользователя: Во время создания счета или действий пользователя с повышенным риском (сброс пароля, банковский перевод) в дело вступает проверка личности с помощью искусственного интеллекта. Загруженное фото удостоверяет личность с помощью инструмента экспертизы изображений (например, проверяет, сгенерировано ли оно ИИ или является фотографией фотографии), а селфи или видеозвонок проверяется детектором фейков. TruthScan's Детектор подделок здесь можно использовать для аутентификации по лицу - убедиться, что человек на камере настоящий и соответствует идентификатору.[60][61]. Поведенческие сигналы (частота набора текста, постоянство устройств) также могут быть использованы в моделях ИИ для обнаружения ботов или синтетических личностей.

- Конечные точки и сеть: Агенты безопасности конечных точек и прокси-серверы могут включать анализ содержимого файлов и скриптов с помощью ИИ. Например, если EDR конечной точки видит, что выполняется новый скрипт или EXE, он может отправить текстовое содержимое файла детектору ИИ, чтобы проверить, не напоминает ли оно известные вредоносные программы, созданные ИИ, или не имеет ли оно признаков обфусцированного кода ИИ. Аналогичным образом DLP-системы (системы предотвращения потери данных) могут использовать обнаружение текстов с ИИ, чтобы отметить конфиденциальный текст, сгенерированный ИИ (что может указывать на инсайдера, использующего ИИ для составления сообщений об утечке данных или фальсификации отчетов). TruthScan's Детектор реального времени разработан для подключения к таким рабочим процессам, предлагая анализ контента на всех платформах в реальном времени и автоматизированные варианты реагирования.[42][62] (например, автоматическая блокировка файла или сообщения, если оно идентифицировано как созданное ИИ вредоносное ПО или дезинформация).

Сайт ключевое преимущество Этот комплексный подход является скорость и последовательность. Атаки с использованием искусственного интеллекта происходят быстро - фишинговые письма, фальшивые голоса и синтетические данные могут воздействовать на множество каналов одновременно. Если оснастить все эти каналы системой обнаружения ИИ, организация получит возможность наблюдать за ситуацией в режиме реального времени и обеспечит всестороннюю защиту. Одна команда описала это как создание "иммунной системы ИИ" для своего предприятия: всякий раз, когда что-то передается (будь то электронное письмо, загрузка документа, голосовой вызов и т. д.), иммунная система ИИ "обнюхивает" это на предмет посторонних (сгенерированных ИИ) сигнатур и нейтрализует, если обнаруживает вредоносность.

Корпоративный пакет TruthScan является примером этого, поскольку он предлагает единая платформа ИИ-обнаружение текста, изображений, аудио и видео, которое может быть развернуто как модульно, так и в комплексе.[63][64]. Многие компании начинают с внедрения одной или двух функций (например, распознавание текста в электронной почте и изображений при регистрации на сайте), а затем расширяют их, когда видят в этом пользу. Важно, что интеграция стала удобной для разработчиков - TruthScan и аналогичные сервисы предоставляют API и SDK, чтобы команды безопасности могли подключать обнаружение к существующим системам без масштабного реинжиниринга. Будь то SIEM, шлюз электронной почты, пользовательское банковское приложение или CRM-система, обнаружение может работать в режиме "за сценой" и передавать оповещения или автоматические действия. Например, крупная платформа социальных сетей интегрировала API для модерации контента, чтобы автоматически удалять видео с подделками в течение нескольких минут после загрузки.[65][66]предотвращая распространение дезинформации, генерируемой искусственным интеллектом.

Заключение: Опережая события

Стремительное распространение угроз, управляемых искусственным интеллектом, в 2025 году бросило организациям новый вызов. Злоумышленники нашли способы масштабной эксплуатации человеческого доверия: они выдают себя за людей, автоматизируют социальную инженерию, обходят защиту с помощью адаптивного кода и создают целые ложные реальности. Это пугающая перспектива для защитников, но не безнадежная. Как преступники используют ИИ, так и мы можем привлечь ИИ на сторону безопасности. Появление Обнаружение контента с помощью искусственного интеллекта, глубокая экспертиза подделок и сканеры синтетической личности дает нам мощные средства противодействия этим новым угрозам. Развертывание этих инструментов и интеграция их на всех уровнях В рамках системы защиты предприятия могут значительно снизить риск прорыва атак с использованием ИИ. Первые компании уже предотвратили многомиллионные попытки мошенничества, поймав подделку на лету.[26]или предотвратить фишинговые катастрофы, отфильтровывая письма, созданные искусственным интеллектом.

Помимо технологий, организациям следует культивировать культуру "доверяй, но проверяй". Сотрудники должны понимать, что в эпоху искусственного интеллекта видеть (или слышать) не всегда означает верить - здоровый скептицизм в сочетании с рабочими процессами проверки может остановить многие уловки социальной инженерии. Обучение и осведомленность в сочетании с автоматические инструменты проверки, такие как TruthScanи образуют грозную защиту. В некотором смысле мы должны поднять планку для проверки подлинности и достоверности информации. Цифровые сообщения и документы больше нельзя принимать за чистую монету; их происхождение должно быть проверено, либо машиной, либо процессом.

По мере продвижения вперед ожидайте, что злоумышленники будут и дальше совершенствовать свои тактики ИИ, но также ожидайте постоянных инноваций в области защитного ИИ. Динамика "кошки-мышки" сохранится. Успех защитников будет зависеть от оперативность и обмен информацией. Те, кто быстро внедряет новые данные об угрозах (например, новые методы обнаружения deepfake или обновленные сигнатуры моделей ИИ), будут опережать злоумышленников, использующих новейшие инструменты ИИ. Сотрудничество между промышленностью, научными кругами и правительством также будет иметь жизненно важное значение в этой борьбе, как видно из предупреждений и рамочных программ, созданных такими агентствами, как NIST's AI Risk Management Framework и межбанковское сотрудничество в области обнаружения мошенничества с помощью ИИ.

В заключение хочу сказать, что индустрия кибербезопасности находится в самом разгаре смены парадигмы, обусловленной ИИ. Угрозы не похожи на те, что были десять лет назад, но мы отвечаем на них столь же беспрецедентными средствами защиты. Благодаря сочетанию передовых технологий обнаружения и надежной стратегии безопасности мы можно Смягчить риски генеративного ИИ и даже обратить его в свою пользу. Такие инструменты, как набор TruthScan для обнаружения ИИ, позволяют нам восстановление доверия в мире с нулевым уровнем доверия - чтобы убедиться, что человек на другом конце провода настоящий, что документ в нашем почтовом ящике подлинный, а код, работающий в нашей сети, не был подделан вредоносным ИИ. Инвестируя в эти возможности сейчас, организации не только защитят себя от сегодняшних атак с использованием ИИ, но и обеспечат устойчивость к угрозам завтрашнего дня. Вывод очевиден: ИИ, возможно, усиливает кибератаки, но при правильном подходе он может усилить и нашу защиту.

Источники: Соответствующие данные и примеры были взяты из 2025 отчетов по анализу угроз и от экспертов, включая Mayer Brown's Cyber Incident Trends[1][67]Обзор угроз 2025 года от компании Fortinet[2][19]Исследование Barracuda об атаках на электронную почту с использованием искусственного интеллекта[6][7]Отчет Google GTIG об угрозах искусственного интеллекта[34]Федеральная резервная система Бостона рассказывает о синтетическом мошенничестве[45][50]а также опубликованные компанией TruthScan тематические исследования и пресс-релизы[30][26], среди прочих. Они демонстрируют масштабы угроз, управляемых ИИ, и эффективность мер противодействия, ориентированных на ИИ, в реальных сценариях. Изучение этих данных и внедрение передовых инструментов позволит нам уверенно двигаться в эпоху киберрисков, создаваемых искусственным интеллектом.

[1] [67] Тенденции киберинцидентов 2025 года, что нужно знать вашему бизнесу | Insights | Mayer Brown

[2] [3] [19] Статистика кибербезопасности: Факты, статистика и взломы за 2025 год

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Мошенничество с помощью искусственного интеллекта в сфере финансовых услуг: Последние тенденции и решения | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan обнаружил северокорейскую фальшивую атаку на чиновников оборонного ведомства - Bryan County Magazine

[6] [7] [14] Половина спама в вашем почтовом ящике генерируется искусственным интеллектом - его использование в продвинутых атаках находится на ранней стадии | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Индекс цифрового доверия за второй квартал 2025 года: Данные о мошенничестве с использованием искусственного интеллекта | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Угрозы кибербезопасности ИИ 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Последние данные об угрозах | TruthScan

[18] [63] [64] TruthScan - корпоративный искусственный интеллект для обнаружения и защиты контента

[23] [46] [56] [57] Глубокие подделки и депозиты: Как бороться с мошенничеством с помощью генеративного ИИ

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake-атаки и фишинг, генерируемый искусственным интеллектом: статистика 2025 года

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] ИИ-детектор голоса для глубоких подделок и клонирования голоса | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Детектор фальшивок - выявление поддельных и искусственных видео - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Прогресс в использовании инструментов искусственного интеллекта угрожающими акторами | Блог Google Cloud

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Хакеры обфусцировали вредоносное ПО с помощью многословного кода искусственного интеллекта

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Обнаружение искусственного интеллекта в реальном времени - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Операторы EvilAI используют сгенерированный искусственным интеллектом код и поддельные приложения для дальних ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Ген ИИ усиливает угрозу синтетического мошенничества с идентификацией личности - Федеральный резервный банк Бостона

[53] Синтетическое мошенничество с использованием личных данных 2025: Стратегии обнаружения и предотвращения с помощью искусственного интеллекта