Frauda în asigurări intră într-o nouă eră, alimentată de inteligența artificială. Atât rețelele sofisticate de fraudă, cât și escrocii izolați exploatează instrumente generative de inteligență artificială pentru a produce cereri de despăgubire false, identități sintetice, dovezi falsificate în profunzime și escrocherii extrem de convingătoare prin impostură. Acest whitepaper examinează cele mai recente tendințe din 2025 privind frauda în asigurări generată de inteligența artificială - de la cererile de despăgubire și documentele generate de inteligența artificială la înșelăciunile cu voce falsă - și prezintă modul în care asigurătorii pot răspunde. Prezentăm date recente, cazuri din lumea reală și perspective strategice pentru subscriitori, investigatori de fraude, echipe de securitate cibernetică, gestionari de despăgubiri și lideri C-suite care trebuie să înțeleagă acest peisaj al amenințărilor care evoluează rapid.

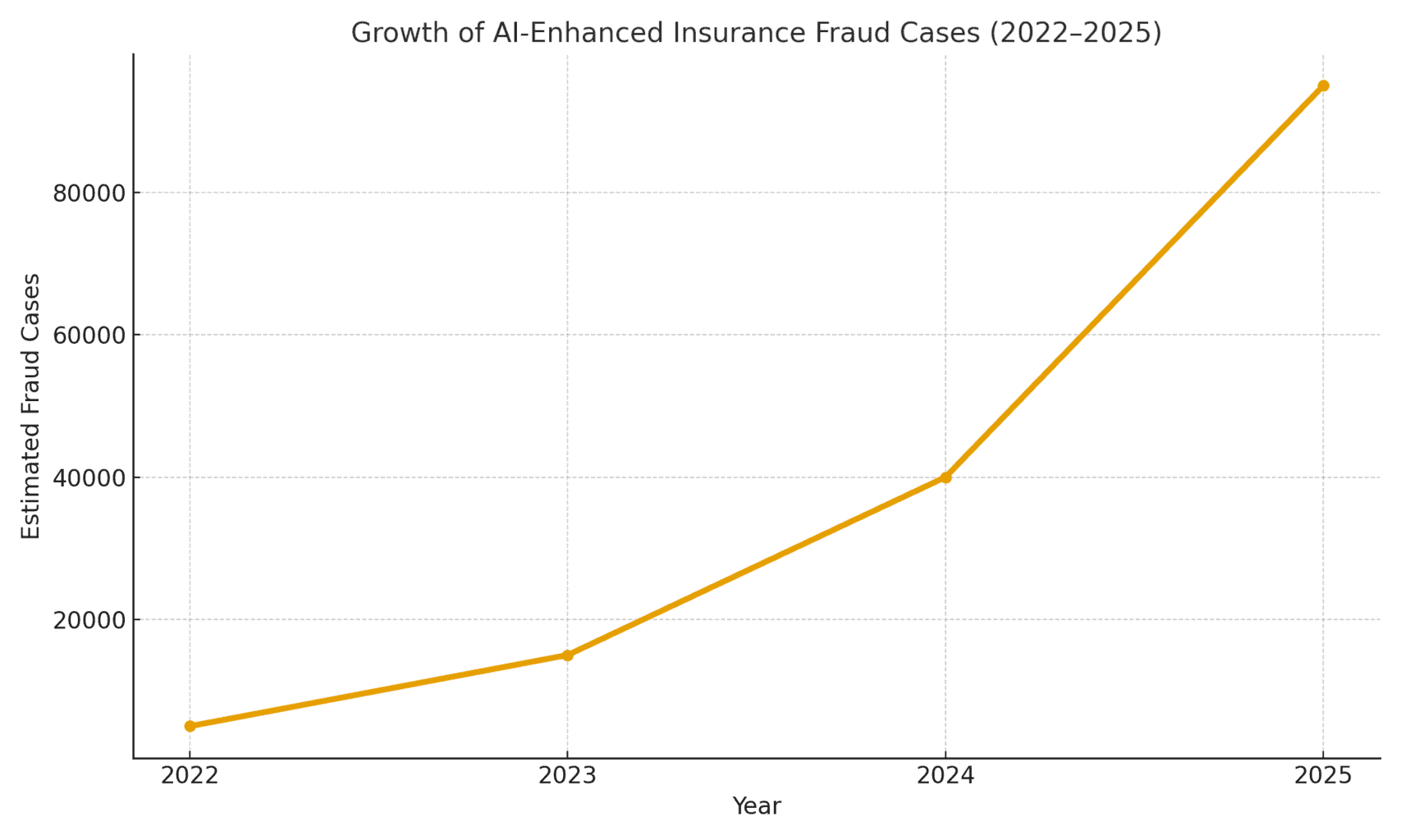

Dimensiunea amenințării: Frauda generată de inteligența artificială este în creștere. Un raport de expertiză contabilă judiciară din 2025 a constatat că Escrocheriile bazate pe inteligența artificială reprezintă în prezent peste jumătate din toate fraudele financiare digitale[1]. În special în domeniul asigurărilor, firma de securitate vocală Pindrop a observat o Creșterea cu 475% a atacurilor frauduloase cu voce sintetică la adresa companiilor de asigurări în 2024, contribuind la o creștere de 19% de la an la an a numărului total de tentative de fraudă în domeniul asigurărilor[2]. Asigurătorii se confruntă cu aproximativ Expunere la fraudă de 20 de ori mai mare decât a băncilor, datorată în parte dependenței mari de documente, imagini și verificări vocale în cadrul cererilor de despăgubire[3]. Figura 1 de mai jos ilustrează creșterea explozivă a incidentelor de fraudă în asigurări potențată de IA în perioada 2022-2025, deoarece mai multe rapoarte din industrie au indicat creșteri procentuale cu trei sau patru cifre de la an la an în ceea ce privește implicarea IA detectată în fraude.

Figura 1: Creșterea rapidă a cazurilor de fraudă în asigurări generată de IA (creștere indexată 2022-2025). Datele din industrie indică o creștere exponențială a conținutului generat de IA găsit în cererile de despăgubire frauduloase, în special începând cu 2023.[4][2]

Afirmații generate de AI și dovezi false

Una dintre cele mai răspândite tendințe este utilizarea inteligenței artificiale generative pentru a crea cereri de despăgubire inventate în întregime. Cu ajutorul generatoarelor avansate de text cu inteligență artificială, escrocii pot scrie descrieri realiste ale incidentelor, rapoarte medicale sau declarații ale poliției prin simpla apăsare a unui buton. Aceste relatări scrise cu ajutorul inteligenței artificiale sunt adesea citite ca fiind elaborate și plauzibile, ceea ce îngreunează identificarea neconcordanțelor de către ajustori. De exemplu, escrocii au folosit ChatGPT pentru a redacta descrieri detaliate ale accidentelor sau rapoarte de rănire care par profesioniste și convingătoare - o sarcină care altădată necesita un efort semnificativ și abilități de scriere.

Mai îngrijorător este faptul că infractorii asociază acum aceste relatări false cu Dovezi justificative generate de AI. Modelele de generare a imaginilor (precum Midjourney sau DALL-E) și instrumentele de editare pot produce fotografii fotorealiste ale daunelor și rănilor. Conform rapoartelor din industrie, unii șoferi au început prezentarea de imagini generate de inteligența artificială pentru a exagera daunele produse vehiculelor în cadrul cererilor de despăgubire auto[5]. Inteligența artificială generativă poate crea o fotografie a unei mașini distruse sau a unei case inundate care nu a existat niciodată în realitate. Aceste imagini sunt adesea mai realiste decât cele pe care le puteau obține tehnicile Photoshop mai vechi[6], ceea ce le face dificil de detectat cu ochiul liber. În aprilie 2025, Zurich Insurance a constatat o creștere a cererilor de despăgubire cu facturi falsificate, estimări ale reparațiilor fabricate și fotografii modificate digital, inclusiv cazurile în care numerele de înmatriculare ale vehiculelor au fost inserate cu ajutorul inteligenței artificiale în imagini ale mașinilor recuperate[7][8]. Astfel de dovezi false, atunci când sunt combinate cu un formular de cerere bine conceput și redactat de inteligența artificială, pot scăpa de verificările manuale.

Un caz impresionant din Regatul Unit a implicat fraudatori care au luat un fotografia de pe rețelele de socializare a unei furgonete a unui comerciant și utilizarea AI pentru a adăuga o bară de protecție crăpată, prezentând-o apoi împreună cu o factură falsă de reparații în valoare de 1 000 de lire sterline, ca parte a unei reclamații false de accident[9]. Escrocheria a fost descoperită abia când anchetatorii au observat același fotografia vanului (înainte de deteriorare) pe pagina de Facebook a proprietarului[10]. Acest lucru ilustrează un fenomen mai larg: asigurătorii raportează o 300% salt în editarea imaginilor "shallowfake" (manipulări digitale simple pentru a adăuga daune sau a modifica detalii) în doar un an (2021-2022 vs 2022-2023)[4]. Allianz UK a avertizat în 2024 că fotografiile digitale distorsionate și documentele false au "toate semnele de a deveni ultima mare înșelătorie care a lovit industria"[4]. De asemenea, șeful departamentului de fraude al Zurich a observat că ceea ce în trecut presupunea punerea în scenă a unui accident de mașină fizic se poate face acum în întregime în spatele unui computer - escrocii pot "crea o cerere de despăgubire frauduloasă din spatele tastaturii lor și pot extrage sume semnificative" cu ajutorul unor fotografii și rapoarte false privind daunele totale[11][12]. Această schimbare nu numai că crește volumul cererilor de despăgubire false, dar reduce și bariera de intrare pentru potențialii escroci.

Nu vă mai îngrijorați niciodată de frauda AI. TruthScan Vă poate ajuta:

- Detectarea AI generate imagini, text, voce și video.

- Evitați fraudă majoră generată de IA.

- Protejați-vă cele mai sensibile activele întreprinderii.

Dincolo de automobile, despăgubiri de bunuri și accidente constată o inflație a pierderilor asistată de inteligența artificială. Sunt raportate fotografii false pentru asigurarea de călătorie (de exemplu, "deteriorarea" bagajelor sau scene de furt înscenate) și chitanțe generate de AI pentru articole scumpe care nu au fost niciodată achiziționate. Asigurări de viață și sănătate nu sunt nici ele imune - escrocii au generat falsuri facturi medicale și certificate de deces folosind AI pentru falsificarea documentelor. De fapt, Zurich a observat că tehnologia deepfake este utilizată pentru a crea evaluări ale inginerilor și rapoarte medicale complet fictive în pachetele de reclamații[11]. Aceste documente generate de AI, adesea completate cu logo-uri și semnături realiste, pot fi imposibil de distins de documentele autentice. O preocupare emergentă pentru asigurătorii de viață este fraudarea necrologului și a certificatului de deces: infractorii pot utiliza inteligența artificială pentru a produce necrologuri false sau scrisori medicale în sprijinul unei cereri de despăgubire în caz de deces pentru o persoană care, de fapt, este încă în viață (sau care nu a existat niciodată, așa cum vom vedea în continuare).

Titularii de polițe și identitățile sintetice

Poate cea mai insidioasă evoluție este frauda de identitate sintetică în asigurări. Frauda de identitate sintetică presupune crearea unei persoane sau entități fictive prin combinarea datelor reale (numere de asigurări sociale furate, adrese etc.) cu detalii fabricate (nume false, documente de identitate false). Progresele în domeniul inteligenței artificiale au facilitat în mod banal generarea profiluri personale realiste - inclusiv fotografii și ID-uri - pentru persoane care nu există[13][14]. În prezent, escrocii pot crea în mod algoritmic un client complet fals, pot achiziționa o poliță în numele acestuia și, ulterior, pot organiza cereri de despăgubire sau beneficii pentru acea identitate falsă.

În sectorul asigurărilor de viață, sistemele de identitate sintetică au a crescut vertiginos. Cercetările din industrie estimează că, în 2025, costurile fraudei de identitate sintetică peste $30 miliarde anual, reprezentând până la 80-85% din toate cazurile de fraudă a identității în toate serviciile financiare[15][16]. Asigurătorii de viață au fost afectați în mod deosebit: escrocii au fost cunoscuți pentru să obțină polițe de asigurare de viață pentru o persoană fictivă și apoi să "ucidă" acea persoană pe hârtie pentru a încasa beneficiul de deces[17]. De exemplu, un escroc ar putea crea un client sintetic "John Doe", să plătească primele timp de un an, apoi să depună o cerere de despăgubire cu un certificat de deces fals și un necrolog pentru decesul prematur al lui John Doe. Deoarece identitatea a fost construită cu atenție (istoricul de credit, înregistrările publice etc.), cererea de despăgubire pentru deces poate părea legitimă - până când nu pot fi găsite cadavrul sau rudele reale. În momentul în care frauda este descoperită, autorii au plecat de mult cu plata.

Schemele de identitate sintetică sunt, de asemenea, o plagă asigurare de sănătate și asigurare auto. Cercurile criminale creează identități "Frankenstein" prin utilizarea numerelor de securitate socială ale copiilor sau ale persoanelor în vârstă (care nu au istoric de credit) combinate cu nume și permise de conducere generate de inteligența artificială[15]. Ei apoi să cumpere polițe de sănătate sau polițe auto pentru aceste persoane false și, la scurt timp după aceea, să depună cereri de despăgubire mari. O variantă este înființarea de sindicate întreprinderi false (societăți fantomă) - de exemplu, o firmă de camioane fictivă - și achiziționarea unei asigurări comerciale pentru aceasta, doar pentru a solicita ulterior despăgubiri pentru accidente înscenate sau vătămări ale angajaților fictivi[18][19]. Deoarece afacerea există doar pe hârtie (cu înregistrări de afaceri și coduri fiscale generate de AI), această "fraudă sintetică "bazată pe entități de multe ori nu este descoperită decât după plata despăgubirilor[18][20].

De ce sunt identitățile sintetice atât de eficiente? În primul rând, acestea trec adesea cu bine de verificările automate ale identității. Birourile de credit și sistemele KYC pot găsi nu există steaguri roșii deoarece identitatea include unele date reale, valide (de exemplu, un SSN real cu un cazier curat)[21]. Între timp, fotografiile de profil generate de inteligența artificială și scanările documentelor de identitate pot părea complet autentice - inteligența artificială de astăzi poate produce un chip uman pe care chiar și recunoașterea facială avansată l-ar putea accepta ca fiind real. Rezultatul: majoritatea sistemelor automate recunosc aceste profiluri ca fiind legitime iar frauda este descoperită (dacă este descoperită) numai după pierderi majore[22].

Impact în lumea reală: RGA raportează că frauda de identitate sintetică în domeniul asigurărilor de viață costă în prezent industria aproximativ $30B pe an și a crescut cu aproape 400% din 2020[15][16]. Comisia federală pentru comerț din SUA estimează că identitățile sintetice reprezintă marea majoritate a incidentelor de fraudă a identității[16]. Aceste pierderi afectează în cele din urmă portofelele asiguraților cinstiți - fiecare familie plătește aproximativ \$700 în plus în prime în fiecare an din cauza sarcinii mai mari de fraudă a asigurătorilor[15]. Asigurătorii răspund prin intensificarea verificării la înscriere și la depunerea cererilor de despăgubire: punerea în aplicare a verificărilor bazei de date pentru corelarea identității, monitorizarea polițelor multiple la aceeași adresă și chiar efectuarea de teste de "vivacitate" (verificări video selfie pentru a se asigura că un solicitant este o persoană reală, nu doar o imagine AI)[23][24]. Dar, după cum vom vedea, escrocii contracarează cu inteligența artificială în următoarea arenă: voci și videoclipuri false.

Voci și afirmații video Deepfake

Generate de AI deepfakes audio și video adaugă o nouă dimensiune alarmantă fraudei în domeniul asigurărilor. În 2023 și 2024, au existat mai multe incidente în care infractorii au folosit clonarea vocii pentru a se da drept persoane la telefon - o tactică întâlnită inițial în jafurile bancare (cum ar fi infamul apel telefonic deepfake al directorului general care a furat $35 milioane în 2020), dar care se răspândește acum și în asigurări. Escrocii clonează vocile asiguraților, ale medicilor sau ale experților în despăgubiri și le folosesc în escrocherii de inginerie socială. Analiza Pindrop din 2024 a avertizat că "Deepfakes, tehnologia vocii sintetice și înșelătoriile bazate pe inteligența artificială remodelează peisajul fraudelor", cu fraudă vocală scalarea la o rată fără precedent[25]. Aceștia au descoperit că centrele de apel pentru asigurări au fost bombardate de actori rău intenționați din străinătate care foloseau falsuri de voce: de exemplu, apelurile ar fi venit furnizând SSN-ul și datele personale furate ale unui titular de poliță real, iar dacă un agent răspundea, vocea clonată de AI a apelantului ar putea păcăli agentul prin autentificarea bazată pe cunoștințe și să solicite o plată frauduloasă[26]. În cazul unui asigurător de pe coasta de vest, atacatorii au folosit în mod repetat această metodă pentru a încerca să preia conturile și să redirecționeze plățile, exploatând faptul că verificarea ID-ului de la centrul de apeluri se baza pe voce și informații personale care pot fi falsificate[26].

Asimilarea vocii a fost utilizată și de consumatori: Escrocii au sunat victime ale accidentelor sau beneficiari în timp ce pretinzând că sunt reprezentanți de asigurări, folosind vocile AI pentru a părea oficiale, în scopul de a fura informații sensibile sau chiar plăți. În schimb, un escroc ar putea să se dea drept client la o linie telefonică de asistență pentru reclamații, pentru a să depună o cerere prin telefon folosind o voce falsă care se potrivește cu sexul/vârsta clientului, ocolind astfel controalele biometrice vocale. Statisticile recente privind fraudele dau de gândit: experții din domeniu estimează o 162% Creșterea numărului de atacuri frauduloase deepfake împotriva asigurătorilor în anul următor[27], iar Pindrop a înregistrat un 475% intensificarea atacurilor cu voce sintetică în 2024 după cum s-a menționat anterior[2]. Aceste atacuri depășesc rapid vectorii mai tradiționali de fraudă cibernetică.

Dincolo de apelurile telefonice, deepfakes bazate pe video apar în procesul de soluționare a cererilor de despăgubire. Mulți asigurători au adoptat inspecțiile virtuale ale cererilor de despăgubire și videoconferințele (accelerate de pandemie), pentru a verifica pierderile sau a intervieva reclamanții de la distanță. Acum, fraudatorii sunt utilizarea avatarelor AI și a videoclipurilor deepfake pentru a păcăli aceste verificări. Au fost raportate cazuri de solicitanți care au folosit Avatari generați de AI în cadrul apelurilor video live cu ajustori, pentru a se deghiza în altcineva sau pentru a ascunde semnele de inconsecvență[28]. De exemplu, o rețea de fraudă ar putea utiliza un deepfake înregistrare video "live" a unui presupus solicitant care își arată daunele prin intermediul unui smartphoneatunci când, de fapt, persoana de pe cameră este un compozit sintetizat de AI sau un actor angajat care poartă filtre de modificare a feței. Un scenariu speculativ, dar plauzibil, este utilizarea unui deepfake al unui decedat persoană: Într-o fraudă legată de anuități sau de asigurări de viață, un membru al familiei ar putea folosi o înregistrare video deepfake a persoanei recent decedate în timpul unui apel de rutină de verificare a vieții pentru a continua să primească plățile[29]. Deși încă nu a fost dat publicității niciun caz important de această natură, asigurătorii se pregătesc pentru el. Autoritățile de reglementare iau, de asemenea, notă - în SUA și în Europa au loc discuții privind clasificarea falsurilor profunde în cadrul furtului de identitate și actualizarea orientărilor privind verificarea dovezilor în asigurări[30].

Detectarea înregistrărilor video și audio "deepfake" este foarte dificilă fără instrumente tehnice. Ajustorii umani nu sunt instruiți să distingă problemele subtile de sincronizare a buzelor sau ciudățeniile acustice. Cu toate acestea, au existat semnale de alarmă în unele cazuri: de exemplu, clipire nenaturală sau defecte faciale pe o înregistrare video sau artefacte audio de fundal pe un apel care au avertizat anchetatorii. Totuși, în general, frauda de asigurare deepfake este încă în stadiu incipient, iar urmărirea penală rămâne rară - până în 2023, definițiile juridice erau neclare, iar dovedirea faptului că un videoclip a fost generat de AI era dificilă fără o analiză de specialitate[31]. Acest lucru le oferă escrocilor un sentiment de impunitate. Cursa înarmărilor a început: asigurătorii apelează acum la inteligență artificială criminalistică pentru a combate inteligența artificială, care utilizează algoritmi de detectare a falsurilor profunde pentru a examina cadru cu cadru videoclipurile suspecte în căutarea unor semne de manipulare[24]. Furnizorii de biometrie vocală lansează detectoare de voce falsă profundă care analizează modelele spectrale și cadența vocală pentru autenticitate[32]. Vom discuta despre aceste tehnologii defensive într-o secțiune ulterioară.

Phishing și înșelăciuni prin impostură îmbunătățite prin inteligență artificială

Nu toate fraudele bazate pe inteligența artificială provin din departamentul de reclamații; unele ținte sunt clienți și angajați prin inginerie socială. E-mailuri și texte de phishing create de AI au devenit o amenințare majoră în domeniul asigurărilor. În cadrul acestor scheme, escrocii utilizează chatbots AI și instrumente de traducere pentru a genera comunicări înșelătoare extrem de convingătoare. De exemplu, infractorii pot imita marca și stilul de scriere ale unei companii de asigurări pentru a trimite e-mailuri de phishing în masă titularilor de polițe, spunându-le că "este necesară o acțiune urgentă pentru a preveni anularea poliței" și direcționându-i către un site web fals. Spre deosebire de e-mailurile neîndemânatice de escrocherie din trecut, AI asigură o gramatică impecabilă și chiar personalizare, făcându-le mult mai credibile. Am văzut cum inteligența artificială este folosită pentru a căuta în rețelele de socializare detalii care sunt integrate în mesaje de spear-phishing, cum ar fi trimiterea la o achiziție recentă de mașină într-un anunț fals de asigurare auto.

Un alt vector este Însușirea identității unor agenți sau executivi cu ajutorul IA. Au existat cazuri în care escrocii au clonat vocea proprietarului unei agenții de asigurări și au lăsat clienților mesaje vocale în care solicitau actualizarea informațiilor bancare - în fapt, un atac de phishing vocal. În mod similar, frauda internă poate proveni din imitarea inteligenței artificiale: departamentul financiar al unui asigurător aproape că a căzut victimă atunci când escrocii au trimis un mesaj audio "deepfake pretins de la CEO autorizarea unui transfer de fonduri (o variantă a "fraudei CEO", acoperită în prezent de unele polițe de asigurare împotriva criminalității electronice[33]). Potrivit Liberty Specialty Markets, aceste tipuri de înșelăciuni bazate pe inteligența artificială au crescut cu 17% în 2023[33]și se așteaptă ca acestea să continue să crească.

Consumatorii sunt, de asemenea, vizați de escrocherii prin media sintetică legate de asigurări. Coaliția împotriva fraudei în asigurări menționează cazuri de impostori care se dau drept experți în asigurări, contactează victimele accidentelor pretinzând că se ocupă de cererea lor de despăgubire și apoi solicitarea unei plăți imediate sau a unor date sensibile[23]. Clienții care nu bănuiesc nimic, ușurați să audă de la un presupus reprezentant, s-ar putea conforma, mai ales dacă apelantul cunoaște detalii despre accidentul lor (pe care AI le-ar putea afla din hacking sau din surse publice). Publicul este puțin conștient de aceste tactici; prin urmare, experții în prevenirea fraudelor îndeamnă asigurătorii să informarea deținătorilor de polițe de asigurare cu privire la verificarea identității apelanților și a e-mailurilor[23][34]. La fel cum băncile își avertizează clienții cu privire la phishing, asigurătorii din 2025 încep să includă avertismente privind înșelăciunile de tip deepfake în comunicările lor.

Un punct comun al acestor scheme îmbunătățite de inteligența artificială este utilizarea kiturilor "fraudă ca serviciu" ușor accesibile[35]. Pe dark web, infractorii pot cumpăra sau se pot abona la instrumente care oferă voci deepfake predefinite, modele de documente false, generatoare de e-mailuri de phishing și multe altele. Această democratizare a instrumentelor AI înseamnă chiar și escrocii slab calificați pot lansa atacuri frauduloase sofisticate[35]. Pentru companiile de asigurări, acest lucru se traduce printr-o avalanșă de tentative de fraudă mai convingătoare, venite din toate unghiurile - reclamații, serviciul clienți, e-mail, chiar și social media. Acest lucru subliniază necesitatea unei strategii de apărare pe mai multe fronturi, care să combine tehnologia, vigilența umană și colaborarea interindustrială.

Detectare și apărare: Un răspuns alimentat de inteligența artificială

Combaterea fraudei bazate pe IA necesită Apărare bazată pe inteligență artificială. Asigurătorii apelează din ce în ce mai mult la tehnologii avansate de detectare și la procese reînnoite pentru a contracara atacul. În esență, asigurătorii trebuie să integreze puncte de control pentru autentificarea conținutului pe tot parcursul ciclului de viață al asigurărilor - de la subscriere la solicitări de despăgubiri și interacțiuni cu clienții - pentru a depista falsurile AI. Figura 2 prezintă o defalcare a principalelor tipuri de fraudă activate de IA și prevalența acestora, iar secțiunile următoare detaliază modul de detectare și descurajare a fiecăruia.

Figura 2: Tipuri de fraude în asigurări potențate de IA în 2025 (pondere estimată în funcție de sistem). Imaginile false (fotografii falsificate ale daunelor) și identitățile sintetice se numără printre cele mai mari categorii, urmate de documentele falsificate de AI (de exemplu, chitanțe, certificate) și escrocheriile audio/video de tip deepfake.

1. Instrumente de detectare a conținutului AI: Noile servicii de detectare a IA pot analiza texte, imagini, materiale audio și video pentru a determina dacă acestea au fost generate sau manipulate automat. De exemplu, asigurătorii pot utiliza soluții precum Detectoare AI de text și imagine TruthScan care utilizează inteligența artificială precisă 99%+ pentru a semnala documentele scrise de inteligența artificială sau fotografiile falsificate[36]. O companie de asigurări ar putea integra acești detectoare în sistemul său de cereri de despăgubire: atunci când o cerere de despăgubire și dovezile aferente sunt trimise, descrierea textului poate fi scanată automat pentru a detecta modele lingvistice generate de inteligența artificială, iar orice imagine încărcată poate fi scanată pentru a detecta semne evidente de CGI sau editare. Instrumentele la nivel de întreprindere pot identificarea textului generat de AI în documente, e-mailuri și comunicări cu o precizie de 99%[36], și în mod similar detectarea imaginilor generate sau manipulate de AI pentru a asigura autenticitatea conținutului vizual[36]. Acest lucru înseamnă că o relatare falsă a accidentului produsă de ChatGPT sau o fotografie falsă a daunei la mijlocul călătoriei ar fi semnalată pentru revizuire manuală înainte ca cererea de despăgubire să fie procesată. Asigurătorii din 2025 adoptă din ce în ce mai mult o astfel de autentificare a conținutului AI - de fapt, 83% dintre profesioniștii antifraudă intenționează să integreze detecția generativă a IA până în 2025, conform unui sondaj ACFE, în creștere de la doar 18% care îl utilizează astăzi[37][38].

2. Verificarea identității și verificări biometrice: Pentru a face față identităților sintetice, asigurătorii îmbunătățesc protocoalele KYC și cu ajutorul inteligenței artificiale. Serviciile de validare a identității pot verifica încrucișat datele solicitanților în mai multe baze de date și pot utiliza recunoașterea facială cu teste de vivacitate. De exemplu, solicitarea unui scurt selfie video în timpul înscrierii (și utilizarea comparării feței cu actul de identitate furnizat) poate contracara multe identități sintetice. Chiar mai avansate tehnologic, companii precum TruthScan oferă expertize judiciare ale imaginilor care pot spot fotografii de profil, avatare și imagini sintetice ale persoanelor generate de AI - detectorul lor de imagini AI este antrenate să identifice fețe realizate de generatoare precum StyleGAN sau ThisPersonDoesNotExist[39]. Prin implementarea unor astfel de instrumente, un asigurător poate detecta dacă selfie-ul unui solicitant de asigurare de viață nu este un om real. Pe partea de voce, autentificare biometrică vocală pentru apelurile de la serviciul clienți poate fi de ajutor; detectoarele moderne de AI pentru voce sunt capabile să identificarea vocilor sintetice și a tentativelor de clonare a vocii în timp real[40]. De exemplu, TruthScan's Detectarea vocii AI sistemul utilizează analiza acustică pentru a recunoașterea vocilor generate de AI și a falsurilor audio înainte ca acestea să păcălească personalul centrelor de apel[40]. Aceste soluții acționează ca un firewall - dacă cineva sună pretinzând că este John Doe și amprenta sa vocală nu se potrivește cu vocea autentică a lui John Doe (sau se potrivește cu caracteristicile deepfake cunoscute), apelul poate fi marcat sau pot fi solicitate dovezi suplimentare de identitate. Autentificarea cu mai mulți factori (confirmare prin e-mail/SMS, coduri de acces unice etc.) adaugă obstacole suplimentare pe care imitatorii trebuie să le depășească.

3. Deepfake Video & Image Forensics: În ceea ce privește probele video, asigurătorii încep să pună în aplicare analize criminalistice specializate. Software-ul avansat poate analiza metadatele video, coerența cadrelor și nivelurile de eroare pentru a detecta falsurile profunde. Unele instrumente examinează reflexiile, umbrele și indicii fiziologice (cum ar fi pulsul în gât al unei persoane pe o înregistrare video) pentru a se asigura că o înregistrare video este autentică. Criminalistica metadatelor este, de asemenea, valoroasă: examinarea metadatelor fișierelor și a amprentelor de generare din imagini sau PDF-uri poate dezvălui dacă ceva a fost probabil produs de un instrument AI[41]. De exemplu, asigurătorii ar trebui să solicite fișiere foto originale (care conțin metadate) mai degrabă decât simple capturi de ecran sau copii tipărite. Echipa de combatere a fraudelor de la Zurich a înregistrat succes în detectarea imaginilor false ale mașinilor prin observarea anomaliilor din metadatele imaginii și analiza nivelului de eroare[41]. Detectoare de escrocherii prin e-mail poate, de asemenea, să scaneze comunicațiile primite pentru a detecta semne de conținut de phishing scris de AI sau semnături malițioase cunoscute[42]. În prezent, mulți asigurători folosesc simulări de phishing și exemple de înșelăciuni create de inteligența artificială în cadrul formării angajaților pentru a crește gradul de conștientizare.

4. Schimbări de procese și formare umană: Tehnologia în sine nu este un glonț de argint. Îmbunătățiri ale procesului cum ar fi efectuarea mai frecventă de verificări aleatorii în persoană pentru cererile cu valoare ridicată sau solicitarea de documente fizice în anumite cazuri. Unii asigurători au amânat procesarea complet automatizată a cererilor de despăgubire, reintroducând controlul uman pentru cererile de despăgubire care au un scor ridicat în cadrul unui model de risc de fraudă al IA. Pe partea umană, formarea este esențială. Anchetatorii antifraudă și ajustorii sunt instruiți să recunoască semnalele de alarmă ale IA: de exemplu, cereri de despăgubire multiple care utilizează formulări identice (stilul ChatGPT), imagini lipsite de un caracter aleatoriu real (de exemplu, modele repetate în ceea ce ar trebui să fie daune organice) sau voci care sună aproape corect, dar au o cadență robotizată. Asigurătorii își educă, de asemenea, clienții: trimițând alerte de fraudă cu privire la schemele deepfake și sfătuind cum să verifice identitatea unui reprezentant de asigurări (de exemplu, furnizând un număr de apel cunoscut).

5. Eforturi de colaborare: Colaborarea la nivelul întregului sector se intensifică. În Regatul Unit, Insurance Fraud Bureau și Association of British Insurers au format grupuri de lucru privind frauda AI, iar guvernul Carta privind frauda în asigurări (2024) stimulează schimbul de date și inițiativele comune[43]. La nivel mondial, asigurătorii se asociază cu firme de securitate cibernetică și cu startup-uri din domeniul IA. În special, apar noi produse de asigurare: Liberty Mutual a lansat o asigurare împotriva criminalității informatice pentru IMM-uri, care acoperă în mod specific înșelăciunile de tip deepfake și frauda directorilor executivi[44][33], subliniind că acest risc este foarte real. Acest lucru înseamnă, de asemenea, că asigurătorii s-ar putea trezi atât victime, cât și soluționatori ai fraudei AI - plătind pentru o înșelătorie deepfake dacă nu este detectată, dar oferind, de asemenea, acoperire pentru alții care suferă astfel de atacuri.

Integrarea tehnologiei de detectare în fluxurile de lucru poate fi vizualizată ca o apărare multipunct în ciclul de viață al cererilor de despăgubire. După cum se arată în Figura 3, asigurătorii pot introduce etape de verificare AI la aplicarea politicii (pentru depistarea identităților sintetice prin verificarea documentelor de identitate și a selfie-urilor), la depunerea cererilor (pentru a analiza automat documentele, fotografiile sau fișierele audio încărcate pentru generarea de inteligență artificială), în timpul revizuirea/investigarea cererilor de despăgubire (pentru a efectua analize criminalistice deepfake asupra probelor suspecte și pentru a verifica orice interacțiune vocală) și chiar înainte de plată (o ultimă autentificare a identității pentru a se asigura că beneficiarul plății este legitim). Prin depistarea fraudelor la timp - în mod ideal, în momentul integrării sau al primei notificări de pierdere - asigurătorii economisesc costurile de investigare și evită plățile nejustificate.

Figura 3: Integrarea punctelor de detectare a IA în ciclul de viață al asigurărilor. La înscrierea în poliță, validarea identității bazată pe AI verifică identitățile sintetice sau false. Atunci când se depune o cerere de despăgubire, detectoarele automate scanează textul, documentele și imaginile cererii de despăgubire pentru a detecta conținut generat de AI. În timpul revizuirii cererilor de despăgubire, instrumentele specializate de analiză vocală și a falsurilor verifică orice dovadă audio/video. Înainte de plată, verificarea biometrică a identității confirmă identitatea beneficiarului. Această abordare pe mai multe niveluri ajută la interceptarea fraudei în mai multe etape.

Asigurătorii nu trebuie să construiască toate aceste capabilități la nivel intern - mulți apelează la soluții de întreprindere precum Suita de detecție AI a TruthScan, care oferă o serie de instrumente care pot fi integrate API în sistemele asigurătorilor. De exemplu, Serviciul de detectare a imaginilor AI și Deepfake al TruthScan poate fi utilizat pentru a verifica autenticitatea imaginilor și a clipurilor video cu o precizie de peste 99%[45]. lor Detector de text AI semnalează textul scris de AI în cereri sau e-mailuri[36], în timp ce Detector de voce AI oferă detectarea clonării vocii și verificarea difuzorului pentru a opri impostorii de telefoane[40]. Există chiar și instrumente de nișă, cum ar fi un Detector de chitanță falsă pentru a analiza instantaneu facturile/chitanțele pentru a găsi semne de falsificare sau fonturi/layout-uri generate de AI[46] - extrem de util, având în vedere prevalența facturilor de reparații false în cererile de despăgubire. Prin implementarea unei combinații a acestor instrumente, un asigurător își poate îmbunătăți drastic rata de detectare a fraudelor. Un asigurător Fortune 500 a raportat că a prins 97% de încercări deepfake în 2024, prin utilizarea unei abordări de screening bazate pe inteligență artificială pe mai multe niveluri (text, imagine, voce), evitând astfel pierderi estimate la $20M[47][48].

Concluzie

Inteligența artificială transformă câmpul de luptă împotriva fraudei în asigurări la scară globală. Escrocii inovează cu ajutorul inteligenței artificiale generative pentru a crea falsuri care sunt mai convingătoare ca oricând - de la persoane și accidente inventate în întregime la imitații care pot înșela chiar și profesioniști experimentați. Datele pentru perioada 2024-2025 arată o creștere alarmantă a acestor scheme alimentate de IA, dar evidențiază, de asemenea, faptul că asigurătorii care investesc în detectare și prevenire pot rămâne cu un pas înaintea lor. Prin combinarea tehnologie de detecție AI de ultimă oră - cum ar fi criminalistica imaginilor, autentificarea vocii și analiza textului - cu fluxuri de lucru actualizate și educație, industria poate reduce riscurile fără a sacrifica eficiența pe care o aduc procesele digitale.

În esență, este vorba de o cursă a înarmărilor tehnologice[49]. După cum a remarcat un expert în prevenirea fraudelor, "În această nouă realitate, vigilența este prima care trebuie plătită"[50]. Companiile de asigurări trebuie să promoveze o cultură a vigilenței și să utilizeze cele mai bune instrumente disponibile pentru a păstra încrederea în procesul de despăgubire. Aceasta înseamnă verificarea veridicității documentelor, vocilor și imaginilor cu aceeași rigoare cu care subscriitorii evaluează riscul. Aceasta înseamnă, de asemenea, colaborarea la nivelul întregului sector pentru schimbul de informații cu privire la tacticile emergente de fraudă cu inteligență artificială și dezvoltarea în comun a unor standarde (de exemplu, cerințe standard privind metadatele pentru documentele media transmise sau liste negre ale identităților false cunoscute).

2025 este un punct de cotitură: asigurătorii care adaptarea proactivă la frauda generată de IA își vor proteja clienții și bilanțurile, în timp ce cei care reacționează lent se pot trezi ținta unor escrocherii care vor ține capul de afiș. Vestea încurajatoare este că tehnologia de ripostă există și se maturizează rapid - aceeași inteligență artificială care dă putere escrocilor poate da putere asigurătorilor. Prin implementarea unor soluții precum suita multimodală de detectare a IA a TruthScan pentru verificarea cererilor de despăgubire și a identității, asigurătorii pot reduce dramatic rata de succes a tentativelor de fraudă generate de IA[51][52]. În acest fel, nu numai că previn pierderile, dar trimit și un mesaj clar potențialilor escroci: indiferent de cât de inteligente sunt instrumentele, frauda va fi descoperită.

Pe scurt, frauda în asigurări generată de inteligența artificială este o provocare formidabilă, dar care poate fi întâmpinată cu o apărare la fel de inteligentă. Cu vigilență, strategie interfuncțională și partenerii tehnologici potriviți, sectorul asigurărilor poate continua să respecte promisiunea fundamentală care stă la baza activității sale - de a plăti numai despăgubiri legitime și de a face acest lucru rapid și sigur într-o lume din ce în ce mai digitală.

Referințe:

- Asociația Asigurătorilor Britanici - Statistici privind frauda 2023[53][54]

- Allianz și Zurich cu privire la creșterea numărului de cereri de despăgubire de tip "shallowfake" - The Guardian, 2024[4][11]

- Facia.ai - "Frauda de asigurări Deepfake: Cum AI rescrie regulile," Octombrie 2025[55][56]

- Coaliția împotriva fraudei în asigurări - Frauda sintetică în asigurări (Quantexa), decembrie 2024[21][17]

- RGA - "Noua frontieră a luptei împotriva fraudei: identitățile sintetice," Iunie 2025[15][16]

- Pindrop - Raport privind frauda vocală, via FierceHealthcare, iunie 2025[2][3]

- Întoarcerea numerelor - "Topul schemelor de fraudă financiară 2025," Octombrie 2025[1][57]

- TruthScan - AI Detection Platform (prezentare generală a serviciilor), 2025[51][52]

- TruthScan - Pagina produsului AI Image Detector, 2025[45][39]

- TruthScan - Pagina produsului AI Voice Detector, 2025[40]

- TruthScan - Fake Receipt Detector pagina produsului, 2025[46]

- Liberty Specialty Markets - Deepfake/Cyber Fraud Insurance Comunicat de presă, Martie 2025[33]

- Facia.ai - Blog: Cursa înarmărilor pentru prevenirea fraudelor în asigurări, 2025[24][32]

- Insurance Business UK - "Imagini generate de inteligența artificială utilizate pentru fraudarea autovehiculelor," Apr 2025[7][58]

- The Guardian - "Fotografiile false ale daunelor auto alarmează asigurătorii," Mai 2024[9][12]

[1] [35] [57] 2025 Scheme de fraudă financiară: Amenințările și semnalele de alarmă ale IA

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Frauda în asigurări a crescut cu 19% din cauza atacurilor vocale în 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Escrocii editează fotografiile vehiculelor pentru a adăuga daune false în înșelăciunea privind asigurările din Marea Britanie | Industria asigurărilor | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Imaginile generate de inteligența artificială sunt utilizate acum pentru fraudarea asigurărilor auto - raport | Insurance Business UK

[13] [14] [15] [16] Noua frontieră a luptei împotriva fraudei: identitățile sintetice și cursa înarmării cu IA | RGA

[17] [18] [19] [20] [21] [22] JIFA: Frauda sintetică: Frauda sintetică fiind deja prezentă în ecosistemul lor, asigurătorii trebuie să gândească mai mult ca băncile - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Frauda de asigurare Deepfake: Cum rescrie AI regulile cererilor de despăgubire

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Amenințarea tăcută: De ce frauda în asigurări se mută pe linia telefonică

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] Asigurarea împotriva criminalității electronice pentru IMM-uri vizează frauda CEO, deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - Detectarea IA la nivel de întreprindere și securitatea conținutului

[37] Studiu: 8 din 10 luptători împotriva fraudelor se așteaptă să implementeze inteligența artificială generativă până în 2025

[38] Perspective din raportul 2024 de evaluare comparativă a tehnologiei antifraudă

[39] [45] Detector de imagini AI | Detectează fotografiile false și manipulate - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] Detector de voce AI pentru Deepfakes și clonarea vocii | TruthScan

https://truthscan.com/ai-voice-detector

[46] Detector de chitanțe false TruthScan | Verificarea autenticității chitanțelor

https://truthscan.com/fake-receipt-detector

[47] Asigurătorul Fortune 500 detectează 97% de Deepfakes și oprește ...