Introducere: O nouă eră a atacurilor bazate pe inteligența artificială

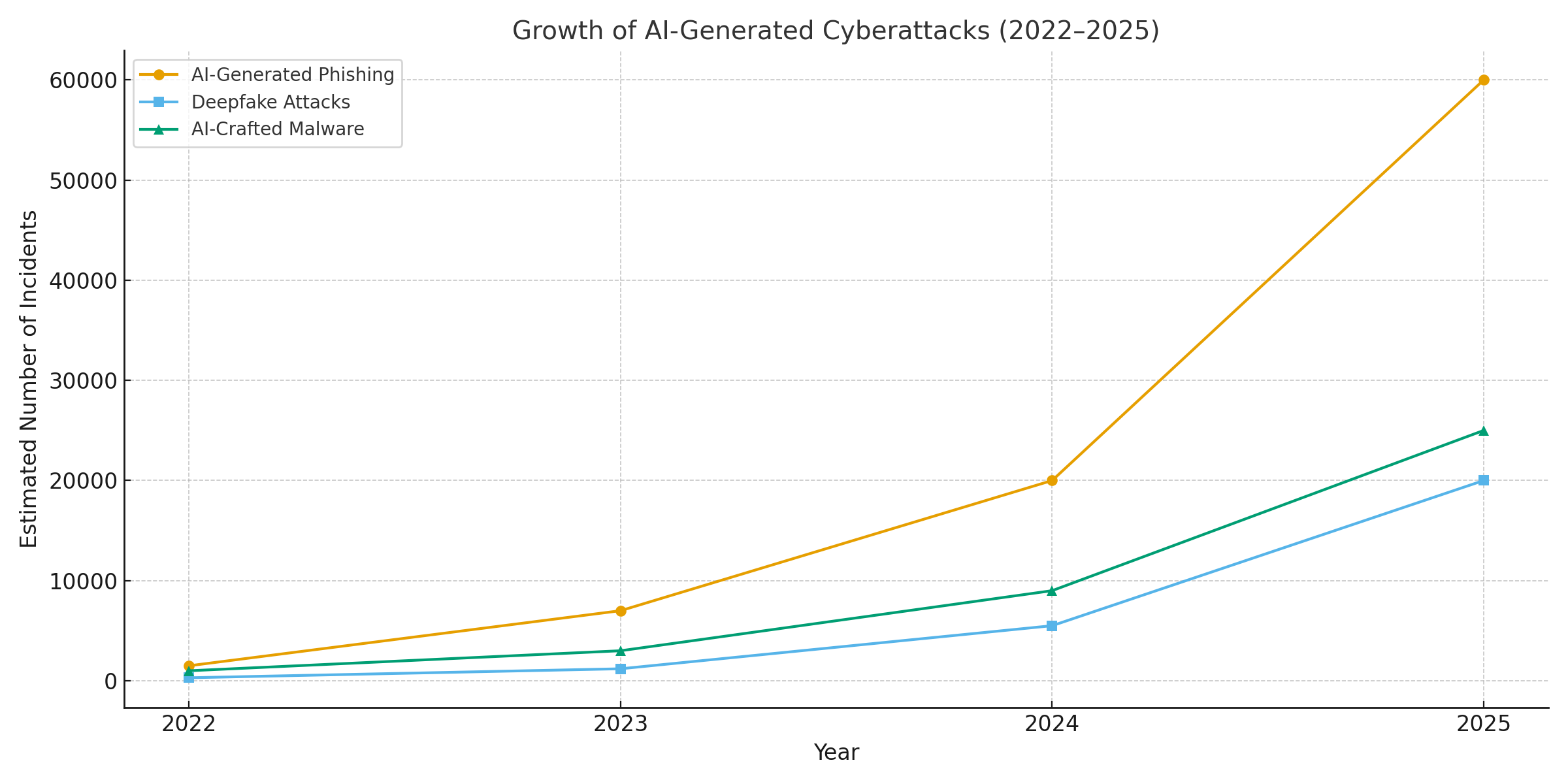

Anul 2025 a marcat un punct de cotitură în securitatea cibernetică. Inteligența artificială generativă a supraîncărcat atacurile cibernetice, permițând actorilor amenințători să lanseze mai frecvente, realiste și scalabile decât oricând înainte. De fapt, în ultimul an, un număr estimat de 16% din incidentele cibernetice raportate au implicat atacatori care au utilizat instrumente AI (de exemplu, modele de generare de imagini și limbaj) pentru a îmbunătăți ingineria socială[1]. De la e-mailuri de phishing ultraconvingătoare la înșelătorii audio/video deepfake, actorii rău intenționați folosesc inteligența artificială în toate sectoarele. Majoritatea profesioniștilor din domeniul securității atribuie acum creșterea atacurilor cibernetice datorită AI generativ, care oferă actorilor răi modalități mai rapide și mai inteligente de a exploata victimele[2]. Inteligența artificială generativă reduce efectiv nivelul de calificare pentru criminalitatea informatică, sporindu-i în același timp potența.

De ce este acest lucru atât de îngrijorător? Inteligența artificială poate produce instantaneu conținut rafinat, conștient de context, care păcălește chiar și utilizatorii instruiți. Aceasta poate imita voci și chipuri cu o precizie înspăimântătoare și poate chiar genera coduri malițioase care se transformă pentru a se sustrage detectării. Ca urmare, atacurile cibernetice au devenit mai greu de detectat și mai ușor de executat. A Forumul Economic Mondial avertizează că 72% dintre organizații au înregistrat o creștere a riscurilor cibernetice - în special inginerie socială și fraudă - din cauza capacităților în creștere ale AI generative[3]. Incidentele din lumea reală confirmă acest lucru: La începutul anului 2024, infractorii au folosit o inteligență artificială generată apel video deepfake să se dea drept directorul financiar al unei companii și să păcălească un angajat să transfere $25,6 milioane escrocilor[4]. Și într-un alt caz, hackerii nord-coreeni au folosit Documente de identitate false generate de AI pentru a ocoli controalele de securitate într-o campanie de phishing de apărare[5]. Aceste exemple evidențiază mizele - inteligența artificială generativă permite înșelăciuni care ocolesc controalele umane și tehnice.

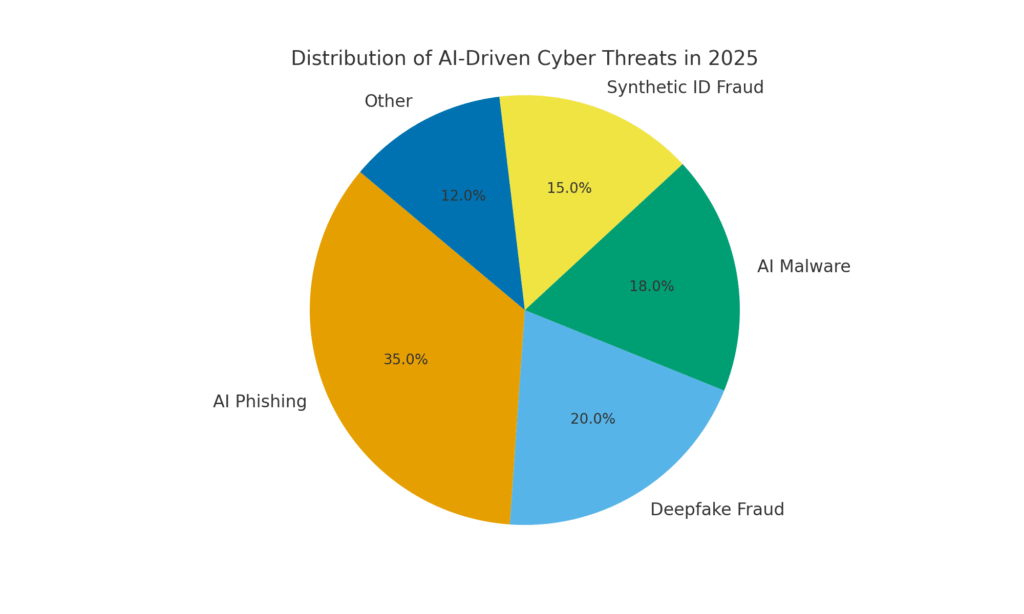

Totuși, inteligența artificială este, de asemenea, o parte a soluției. Instrumentele avansate de detectare (precum cele de la TruthScan) utilizează AI împotriva AI - analizarea conținutului pentru a descoperi semnăturile subtile ale generării de mașini. În acest whitepaper, vom examina principalele amenințări cibernetice generate de IA în 2025 și modul în care organizațiile le pot atenua. De la Phishing generat de inteligența artificială la deepfake fraudă CEO, Programe malware create de AI, identități sinteticeși multe altele, vom explora modul în care AI-ul generativ remodelează atacurile. De asemenea, vom discuta măsuri concrete de apărare, inclusiv Detectarea conținutului AI, deepfake forensics și tehnologii de verificare a identității care pot ajuta echipele de securitate să recâștige avantajul. Scopul este de a clarifica modul în care întreprinderile, MSSPs, CISOs și investigatorii de fraude pot să integreze instrumentele de detectare a inteligenței artificiale în toate sistemele lor de securitate cibernetică pentru a contracara acest val de amenințări bazate pe inteligența artificială.

Nu vă mai îngrijorați niciodată de frauda AI. TruthScan Vă poate ajuta:

- Detectarea AI generate imagini, text, voce și video.

- Evitați fraudă majoră generată de IA.

- Protejați-vă cele mai sensibile activele întreprinderii.

Phishing și BEC generate de IA: înșelătorii la o scară fără precedent

Unul dintre cele mai clare impacturi ale AI generativ a fost asupra phishing-ului și compromiterea e-mailului de afaceri (BEC) scheme. Modelele lingvistice bazate pe inteligența artificială pot redacta în câteva secunde e-mailuri fluente, adaptate în funcție de context, eliminând greșelile gramaticale și frazele ciudate care odată trădau phishing-ul. Rezultatul este o avalanșă de e-mailuri și texte înșelătoare extrem de convingătoare. Până în aprilie 2025, peste jumătate din e-mailurile spam (51%) au fost scrise de AI, față de aproape zero cu doi ani înainte[6]. Și mai alarmant, cercetătorii au descoperit că aproximativ 14% din e-mailurile de atac BEC au fost generate de AI până în 2025[7] - o cifră care se așteaptă să crească pe măsură ce infractorii adoptă instrumente precum ChatGPT. Unele studii estimează că peste 80% de e-mailuri de phishing ar putea fi acum asistate de inteligența artificială în elaborarea acestora[8].

Volumul acestor momeli generate de AI a explodat. Analizele de securitate arată că atacurile de phishing legate de inteligența artificială generativă au crescut cu 1,265% într-un interval scurt[9]. Într-o perioadă, rapoartele privind incidentele de phishing au crescut 466% într-un singur trimestru, în mare parte din cauza kiturilor automate de phishing și a roboților care pompează momeli personalizate[9][10]. De ce o astfel de creștere? Deoarece AI permite atacatorilor scară operațiunile lor în mod dramatic. Un singur infractor poate utiliza un AI chatbot pentru a genera mii de e-mailuri frauduloase personalizate care vizează diferiți angajați sau clienți, toate în timpul necesar pentru a crea unul singur. Această automatizare în masă a determinat FBI să avertizeze că pierderile cauzate de BEC (care erau deja de $2,7 miliarde în 2022) nu vor face decât să se accelereze pe măsură ce IA "amenință să împingă aceste pierderi și mai sus"[11][12].

Nu numai că există mai multe e-mailuri de phishing, dar sunt și mai eficient. Victimele sunt păcălite în mai mare măsură de limbajul rafinat și de detaliile contextuale pe care AI le poate încorpora. În cadrul testelor de laborator, e-mailurile de phishing redactate de AI au atins o 54% rata de click-through - cu mult peste cele ~12% pentru încercările tradiționale de phishing[13]. Aceste mesaje se citesc în stilul unui director general autentic sau fac referire la evenimente reale ale companiei, ceea ce scade garda destinatarilor. Atacatorii folosesc chiar inteligența artificială pentru a testa diferite formulări și pentru a repeta cele mai reușite cârlige[14]. Și, spre deosebire de oameni, inteligența artificială nu face greșeli de scriere sau nu obosește - ea poate lansa variante nesfârșite până când una trece de filtre și păcălește pe cineva.

Exemplu concret: La mijlocul anului 2025, o Reuters investigația a dezvăluit modul în care escrocii din Asia de Sud-Est au folosit ChatGPT pentru a automatiza comunicațiile frauduloase[15]. Aceștia au generat în masă e-mailuri bancare convingătoare și texte ale serviciilor pentru clienți, mărind considerabil aria de acoperire a schemelor lor. Poliția europeană a raportat, în mod similar, kituri de phishing bazate pe inteligență artificială vândute pe internetul întunecat pentru mai puțin de $20, permițând actorilor puțin calificați să lanseze campanii sofisticate[16][17]. Bariera de intrare pentru BEC și phishing s-a evaporat practic.

Măsuri defensive - Stoparea AI Phish: Având în vedere atacul, organizațiile trebuie să își fortifice canalele de e-mail și de mesagerie. Acesta este locul în care Detectarea conținutului AI poate ajuta. Instrumente precum Detector de text AI TruthScan și specializate scanere de e-mail poate analiza mesajele primite pentru a găsi markerii statistici ai textului generat de AI. De exemplu, aplicația Detector de escrocherii prin e-mail TruthScan utilizează analiza limbajului natural pentru a semnala e-mailurile care probabil provin de la un AI, chiar dacă acestea par legitime[18]. Aceste detectoare examinează aspecte precum gramatica perfect îngrijită, complexitatea propozițiilor și modelele stilometrice neobișnuite pentru scriitorii umani. Cu scanare în timp real, e-mailurile suspecte pot fi puse în carantină sau marcate pentru revizuire înainte ca acestea să ajungă la utilizatori. Echipele de securitate ale întreprinderilor încep să implementeze astfel de filtre bazate pe inteligență artificială la gateway-urile de e-mail și la platformele de mesagerie. În practică, acest lucru adaugă un nou nivel de apărare peste filtrele tradiționale de spam - unul reglat în mod explicit pentru a prinde conținutul scris de AI. Începând cu 2025, întreprinderile de top integrează soluții precum TruthScan prin API în gateway-urile lor de e-mail securizate și în suitele de colaborare în cloud, creând un punct de control automat pentru Phishing generat de inteligența artificială conținut.

Imitații vocale și video Deepfake: Frauda "Vederea este înșelătoare"

Poate că cea mai viscerală amenințare generată de IA în 2025 este creșterea atacuri deepfake vocale și video. Folosind modele AI, infractorii pot clona vocea unei persoane pornind de la doar câteva secunde de înregistrare audio sau pot genera un videoclip realist al feței unei persoane pornind de la câteva fotografii. Aceste falsuri profunde sunt folosite pentru escrocherii cu miză mare - de la fraudarea directorilor executivi (apeluri de tip "director executiv fals") la conferințe video false și nu numai. Un raport recent al industriei a dezvăluit 47% din organizații s-au confruntat cu atacuri deepfake de vreun fel[19]. Și nu este doar teoretic: mai multe jafuri din 2023-2025 au demonstrat că deepfakes pot învinge autentificarea supremă - proprii noștri ochi și urechi.

Un caz infam a implicat un transfer bancar internațional de $25 milioane după ce un angajat a fost înșelat de o conferință video de tip deepfake. Atacatorii au folosit inteligența artificială pentru a sintetiza asemănarea directorului financiar al companiei într-o convorbire Zoom, cu vocea și manierele sale, instruindu-l pe angajat să transfere fonduri[4][20]. Într-un alt incident din Australia, un guvern local a pierdut $2,3 milioane când escrocii au falsificat atât vocea, cât și înregistrările video ale funcționarilor municipali pentru a aproba plăți frauduloase[21]. În mod îngrijorător, infractorii folosesc voci clonate de inteligență artificială în "înșelăciunile cu bunici" - sunând persoane în vârstă și dându-se drept rudele lor aflate în dificultate. În FBI și FinCEN a emis alerte la sfârșitul anului 2024 cu privire la o creștere a fraudelor care utilizează Mass-media "deepfake" generată de AI, inclusiv agenți falși de servicii pentru clienți și identități sintetice pentru a ocoli verificările KYC[22].

Frecvența infracțiunilor bazate pe deepfake crește rapid. Până la sfârșitul anului 2024, o analiză a arătat că o nouă înșelătorie deepfake avea loc la fiecare cinci minute în medie[23]. Numai în Q1 2025, incidentele deepfake raportate au crescut cu 19% față de toate din 2024[24][25]. Deepfakes reprezintă în prezent aproximativ 6,5% din totalul atacurilor frauduloase, a 2,137% creștere din 2022[26][27]. Tehnologia necesară a devenit ușor accesibilă - adesea este nevoie de doar 30 de secunde de audio pentru a clona o voce sau mai puțin de o oră de mostre de filmare pentru a modela în mod convingător fața unei persoane[20]. Pe scurt, nu a fost niciodată mai ușor să "falsificarea" identității unei persoane de încredere și păcălesc victimele să le dea bani sau informații.

Măsuri defensive - Autentificarea realității: Pentru a contracara amenințările de tip deepfake, organizațiile apelează la soluții avansate detectarea mediilor sintetice instrumente. De exemplu, Detectorul de voce AI al TruthScan și Detectorul TruthScan Deepfake utilizează inteligența artificială pentru a analiza înregistrările audio și video în căutarea semnelor de manipulare. Aceste sisteme efectuează o analiză cadru cu cadru și a formei de undă pentru a detecta artefacte precum mișcări faciale nefirești, probleme de sincronizare a buzelor sau neregularități spectrale audio care trădează un clip generat de AI. În cadrul testelor, algoritmii TruthScan au obținut 99%+ precizie în identificarea vocilor generate de AI și a detectat cadrele video manipulate în timp real[28][29]. De fapt, cercetătorii de la Genians Security Center au folosit recent analiza criminalistică a imaginilor TruthScan pentru a analiza o carte de identitate falsă folosită de hackerii nord-coreeni - detectorul de imagini false al TruthScan a marcat documentul ca fiind neautentic cu 98% încredere, dejucând tentativa de spear-phishing[5][30].

Pentru o apărare practică, întreprinderile implementează aceste capacități de detectare în punctele cheie de strangulare. Verificare vocală se adaugă la fluxurile de lucru ale centrelor de apeluri - de exemplu, atunci când un "client" solicită un transfer mare prin telefon, sunetul poate fi rulat printr-un detector de falsificare profundă a vocii pentru a se asigura că este chiar el (și nu un imitator AI). De asemenea, platforme de videoconferință pot integra scanarea deepfake live a fluxurilor video ale participanților, pentru a detecta orice fețe sintetice. De exemplu, suita de detectare deepfake a TruthScan oferă analiza apelurilor video în timp real și autentificarea facială care se poate conecta la Zoom sau WebEx prin API[31][29]. Acest lucru înseamnă că, dacă cineva încearcă să se alăture unei întâlniri folosind un videoclip creat de AI cu CEO-ul dumneavoastră, sistemul poate semnala "posibilul deepfake" înainte ca daunele să fie făcute. În plus, tranzacțiile importante includ acum adesea o etapă de verificare (în afara benzii sau cu mai mulți factori) care poate valorifica autentificarea conținutului - de exemplu, solicitarea unei scurte confirmări verbale care este apoi verificată de un detector de voce AI pentru autenticitate. Prin stratificarea acestor instrumente, companiile creează o plasă de siguranță: chiar dacă angajații a se vedea sau auzi ceva plauzibil, o investigație criminalistică în spatele scenei privind IA va pune la îndoială realitatea acestuia. Într-un peisaj al amenințărilor penetrat de IA, "Nu aveți încredere - verificați" devine mantra pentru orice comunicare vocală sau video care implică bani sau acces sensibil.

Programe malware create de AI și coduri ofuscate: Amenințări în evoluție în cod

Influența inteligenței artificiale nu se limitează la ingineria socială - aceasta schimbă, de asemenea, regulile jocului în dezvoltarea programelor malware și a codurilor de atac evazive. În 2025, Threat Intelligence Group al Google a descoperit primele tulpini de malware care utilizează inteligența artificială în timpul execuție pentru a le modifica comportamentul[32][33]. Un exemplu, denumit PROMPTFLUXa fost un script malițios care a apelat de fapt la un API AI (modelul Gemini al Google) pentru a să își rescrie propriul cod din mers, producerea de noi variante ofuscate pentru a evita detectarea antivirus[34][35]. Această evoluție "just-in-time" a inteligenței artificiale marchează un salt către programe malware autonome, polimorfe. Un alt exemplu, PROMPTSTEAL, a utilizat un asistent de codare AI pentru a genera comenzi Windows pe o singură linie pentru furtul de date, externalizând practic părți ale logicii sale către un motor AI în timp real[36][37]. Aceste inovații indică un viitor în care programele malware se pot modifica în mod continuu - la fel ca un pen-tester uman - pentru a învinge apărarea.

Chiar și fără inteligență artificială imediată, atacatorii folosesc inteligența artificială în timpul dezvoltării pentru a crea coduri malițioase mai puternice. Inteligența artificială generativă poate produce programe malware care sunt foarte ofuscat, conținând straturi de logică confuză care împiedică ingineria inversă. Conform rapoartelor de informații privind amenințările, peste 70% din încălcările majore în 2025 au implicat o formă de malware polimorf care își schimbă semnătura sau comportamentul pentru a evita detectarea[38]. În plus, 76% de campanii de phishing utilizează acum tactici polimorfe precum URL-uri dinamice sau sarcini utile rescrise de AI[38]. Instrumente precum ofertele dark-web WormGPT și FraudăGPT (clone nerestricționate ale ChatGPT) permit chiar și neexperților să genereze dropperi malware, keyloggeri sau cod ransomware prin simpla descriere a ceea ce doresc[39]. Rezultatul este o abundență de noi variante de programe malware. De exemplu, în 2024, un sustragător de informații numit BlackMamba a apărut care a fost generată în întregime de AI, folosind ChatGPT pentru a-și scrie codul în segmente - fiecare execuție a produs un binar ușor diferit, confundând antivirusurile tradiționale bazate pe semnături[38]. Cercetătorii în domeniul securității au demonstrat, de asemenea, dovezi de concepte polimorfe generate de AI care ar putea eluda multe protecții ale punctelor finale[40].

În plus, atacatorii folosesc inteligența artificială pentru a-și perfecționa livrare de malware. Inteligența artificială poate scrie în mod inteligent e-mailuri de phishing (după cum s-a discutat) care conțin linkuri malware. De asemenea, poate ajuta la dezvoltarea exploatărilor - de exemplu, folosind inteligența artificială pentru a găsi noi vulnerabilități sau pentru a optimiza shellcode-ul. Se pare că actori ai statelor naționale au utilizat modele avansate de inteligență artificială pentru a ajuta la descoperirea exploatărilor de tip zero-day și la dezvoltarea de programe malware personalizate pentru ținte[41]. Toate aceste tendințe înseamnă că în 2025 programele malware vor fi mai invizibile și mai adaptabile. Acesta este adesea "co-create" cu AI, ceea ce îngreunează detectarea cu ajutorul regulilor convenționale.

Măsuri defensive - AI vs. AI în apărarea împotriva programelor malware: Apărarea împotriva programelor malware create de inteligența artificială necesită o combinație de detectare avansată și de analiză bazată pe inteligența artificială pe partea defensivă. Multe organizații își sporesc protecție endpoint și EDR (Endpoint Detection & Response) cu modele AI/ML care caută modele comportamentale ale codului generat de AI. De exemplu, transformările bruște ale codului pe gazdă sau modelele neobișnuite de apeluri API ar putea indica ceva de genul regenerării PROMPTFLUX. În mod similar, monitorizarea rețelei poate detecta anomalii precum malware-ul care ajunge la serviciile AI (ceea ce nu este "normal" pentru aplicațiile utilizatorilor). Furnizorii antrenează detectoare bazate pe ML pe familii de programe malware asistate de IA identificate până în prezent, îmbunătățind recunoașterea acestor amenințări noi.

O soluție emergentă este scanarea integrată a conținutului AI în conductele de dezvoltare și construire. Acest lucru înseamnă utilizarea detectoarelor bazate pe inteligență artificială pentru a analiza scripturi, programe software sau chiar modificări ale configurației pentru conținut rău intenționat sau generat de inteligență artificială. De exemplu, Detectorul în timp real al TruthScan poate fi implementat dincolo de text - analiza sa multimodală poate semnala coduri sau fișiere de configurare suspecte, recunoscând dacă acestea au fost generate automat cu modele de ofuscare[42][43]. Echipele de dezvoltare și MSSPs încep să scaneze scripturile de tip "infrastructure-as-code", jurnalele PowerShell și alte artefacte pentru a găsi semne de segmente scrise de AI care ar putea indica mâna unui atacator. Deși acesta este un domeniu incipient, este promițător: într-un caz, o echipă de securitate a utilizat un detector de inteligență artificială pentru a prinde un fișier de kit de phishing ofuscat care "părea" generat de inteligență artificială și care făcea într-adevăr parte dintr-un atac[44]. Codul fișierului era excesiv de complex și verbose (semne distinctive ale generației AI), iar o scanare a conținutului AI a confirmat o probabilitate ridicată ca acesta să nu fi fost scris de om[40].

În cele din urmă, schimbul de informații privind amenințările axat pe amenințările IA este esențial. Atunci când Google GTIG publică detalii despre programele malware bazate pe Prompt sau când cercetătorii raportează noi tehnici de evaziune a IA, organizațiile ar trebui să le introducă în ingineria lor de detectare. Analiză comportamentală - căutând acțiuni precum un proces care generează un script care rescrie codul aceluiași proces - poate detecta anomaliile pe care le prezintă programele malware asistate de inteligență artificială. Pe scurt, apărătorii trebuie să combată focul cu foc: să implementeze Instrumente de securitate bazate pe inteligență artificială care se pot adapta la fel de rapid ca și programele malware bazate pe inteligență artificială. Aceasta include orice, de la antivirus îmbunătățit cu inteligență artificială la analiza comportamentului utilizatorului, care poate identifica momentul în care un cont sau un sistem începe să se comporte "nu tocmai uman". Prin adoptarea AI pentru apărare, echipele de securitate pot contracara avantajele de viteză și amploare pe care AI le oferă atacatorilor.

Identități sintetice și scheme de fraudă alimentate de inteligența artificială

Trecerea de la programele malware la lumea fraudei: frauda de identitate sintetică a explodat cu ajutorul inteligenței artificiale generative. Frauda de identitate sintetică presupune crearea de persoane fictive prin combinarea datelor reale și a celor false (de exemplu, CNP real + nume și documente false). Aceste identități "Frankenstein" sunt apoi utilizate pentru a deschide conturi bancare, pentru a solicita credite sau pentru a trece verificările KYC - ceea ce duce în cele din urmă la împrumuturi neplătite sau la spălare de bani. Acesta era deja unul dintre tipurile de fraudă cu cea mai rapidă creștere, iar inteligența artificială a pus acum gaz pe foc. Pierderi cauzate de frauda cu identitate sintetică a depășit $35 miliarde în 2023[45], iar până la începutul anului 2025 unele estimări indicau aproape 25% din totalul pierderilor din fraude bancare au fost datorate identităților sintetice[46]. Analiștii Experian au constatat că peste 80% de fraude cu conturi noi pe anumite piețe este acum legată de identificările sintetice[19] - o statistică uluitoare care evidențiază cât de răspândită a devenit această înșelătorie.

Inteligența artificială generativă amplifică frauda sintetică în mai multe moduri. În primul rând, AI face trivială producerea "documente pentru crescători" și amprentele digitale necesare pentru a vinde o identitate falsă. În trecut, un escroc putea crea în Photoshop un act de identitate sau putea crea manual facturi de utilități false. În prezent, există instrumente pentru a genera fotografii de profil cu aspect autentic, acte de identitate, pașapoarte, extrase bancare, chiar și profiluri de social media utilizarea generatoarelor de imagini AI și a modelelor lingvistice[47][48]. De exemplu, se poate utiliza inteligența artificială pentru a crea o fotografie realistă a capului unei persoane care nu există (împiedicând astfel căutarea ușoară a imaginii inverse) și pentru a genera un permis de conducere fals corespunzător cu fotografia respectivă. IA poate, de asemenea, să simuleze "semnele de viață" ale unei identități - de exemplu, crearea înregistrări ale părinților sintetici, adrese sau postări pe rețelele sociale pentru a completa o poveste de fundal[49]. Boston Fed a observat că Gen AI poate produce chiar și deepfake audio și video ale unei persoane false - de exemplu, un utilizator sintetic ar putea "apărea" într-un videoclip de verificare selfie, cu o față și o voce unice, toate generate de inteligența artificială[50].

În al doilea rând, IA îi ajută pe escroci mărire operațiunilor lor. În loc să falsifice una sau două identități la un moment dat, acestea pot genera în mod programatic sute sau mii de pachete complete de identități și pot completa automat, în masă, cereri pentru conturi noi[51][52]. Unele servicii dark web oferă efectiv "Identități sintetice ca serviciu", folosind automatizarea pentru a produce conturi verificate pentru vânzare. În timpul programelor de ajutor în caz de pandemie COVID-19, de exemplu, infractorii au folosit roboți cu identități generate de AI pentru a solicita în masă împrumuturi și beneficii, copleșind sistemul cu solicitanți falși. După cum estimează Juniper Research, costul global al fraudei de identitate digitală (alimentată de aceste tactici) va crește 153% până în 2030 comparativ cu 2025[53].

Măsuri defensive - Verificarea identității într-o lume a IA: Metodele tradiționale de verificare a identității se luptă cu falsurile create de inteligența artificială. Pentru a se adapta, organizațiile adoptă verificare multistratificată a identității și a comportamentului susținută de inteligența artificială. Un strat cheie este cel avansat criminalistica documentelor și a imaginilor. De exemplu, Detectorul de imagini AI al TruthScan și Detector de documente false oferă posibilitatea de a analiza documente de identitate, selfie-uri sau documente încărcate pentru a găsi semne de sinteză sau manipulare. Aceste instrumente examinează artefactele la nivel de pixel, inconsecvențele de iluminare și metadatele pentru a determina dacă o imagine este generată sau manipulată de AI. Ele pot detecta indicii subtile - cum ar fi modele identice de fundal din fotografii generate de GAN sau fonturi și spațiere pe un act de identitate care nu se potrivesc cu niciun model guvernamental cunoscut. Prin implementarea unor astfel de detectoare la înscriere, băncile pot semnala automat permisul de conducere sau selfie-ul unui solicitant dacă este probabil generat de AI (de exemplu, sistemul TruthScan ar fi semnalat legitimația militară falsă utilizată în cazul de phishing Kimsuky APT[5]). Conform unui comunicat de presă al TruthScan, platforma lor a fost utilizată de instituțiile financiare pentru a valida autenticitatea documentelor la scară largă, identificând falsurile profunde cu o precizie extrem de ridicată[54].

Un alt strat este analiza comportamentală și verificări ale referințelor încrucișate. Identitățile reale au profunzime - ani de istorie, înregistrări publice, activitate în social media etc. Identitățile generate de inteligența artificială, oricât de perfecționate ar fi, sunt adesea lipsite de aceste rădăcini adânci. Băncile și creditorii folosesc acum inteligența artificială pentru a corela datele din cereri cu date publice și private: Numărul de telefon și adresa de e-mail ale acestei persoane prezintă un istoric de utilizare? Are sens geolocalizarea dispozitivului sau a IP-ului? Tastează datele în formulare într-un mod uman sau le copiază (așa cum fac roboții)? Modelele AI pot fi antrenate pentru a distinge comportamentul autentic al clienților de modelele sintetice. Rezerva Federală a observat că "identitățile sintetice sunt superficiale, iar inteligența artificială poate vedea asta" - Verificarea bazată pe inteligență artificială poate căuta rapid amprenta digitală a unei identități și poate trage un semnal de alarmă în cazul în care nu este găsită nicio amprentă[55]. În practică, serviciile de verificare a identității utilizează acum AI care verifică dacă selfie-ul unui utilizator se potrivește cu fotografiile anterioare (pentru a detecta schimburile de fețe) și chiar solicită utilizatorilor acțiuni aleatorii (cum ar fi poziții sau fraze specifice) în timpul verificărilor liveness, ceea ce face mai dificil pentru deepfakes să răspundă corect[56][57].

În cele din urmă, monitorizare continuă a comportamentului contului după integrare ajută la detectarea conturilor sintetice care au scăpat. Deoarece aceste conturi nu sunt legate de o persoană reală, modelele lor de utilizare ies adesea în evidență în cele din urmă (de exemplu, efectuarea de tranzacții perfect sincronizate pentru a construi creditul, apoi maximizarea acestuia). Monitorizarea fraudelor bazată pe inteligența artificială (cum ar fi platformele Sift sau Feedzai) poate identifica anomalii în modul în care sunt utilizate conturile, semnalând potențialele conturi sintetice pentru revizuire. Pe scurt, combaterea fraudei de identitate bazate pe IA necesită Verificarea identității cu ajutorul IA - combinând criminalistica documentelor, verificările biometrice, corelarea datelor și analiza comportamentală. Vestea bună este că aceleași progrese ale inteligenței artificiale care permit frauda sunt utilizate și pentru detectarea acesteia. TruthScan, de exemplu, oferă un suita de verificare a identității care integrează analiza textului, a imaginii și a vocii pentru verificarea noilor utilizatori. Prin utilizarea acestor instrumente, o mare bancă a observat o scădere semnificativă a numărului de deschideri de conturi sintetice reușite, chiar dacă media industriei era în creștere. Cursa înarmărilor continuă, dar apărătorii învață să detecteze "semnele digitale" slabe ale unui cont sintetic, indiferent cât de bine încearcă AI să își acopere urmele.

Integrarea detecției AI în întreaga stivă de securitate

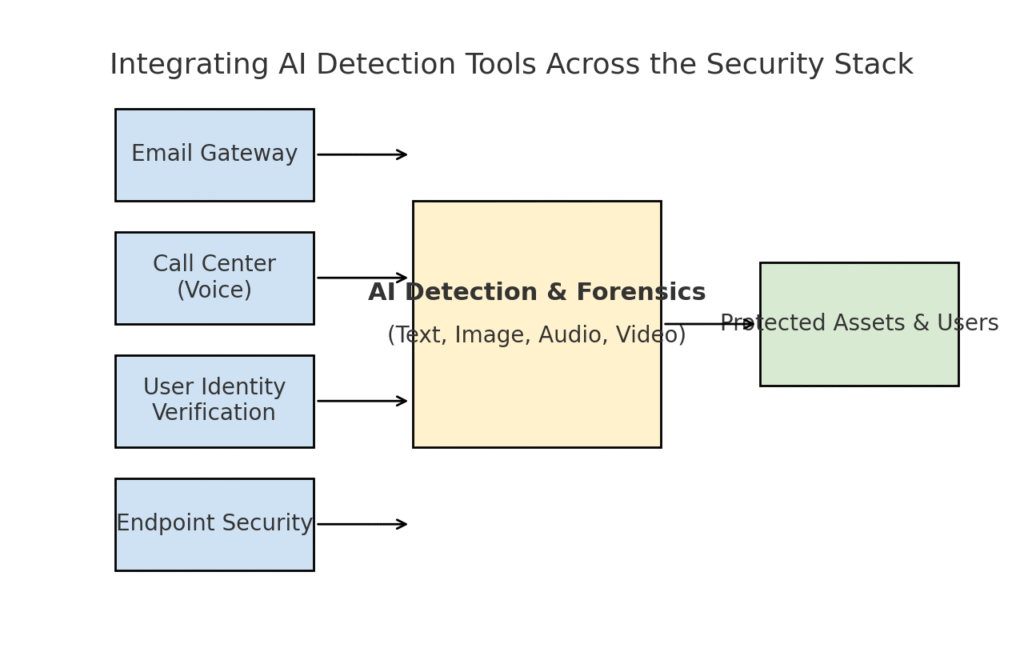

Am explorat mai multe domenii distincte de amenințare - phishing, deepfakes, malware, fraudă sintetică - toate supraîncărcate de AI. Este clar că nu există un instrument unic sau o soluție unică va rezolva provocarea. În schimb, întreprinderile au nevoie de o strategie cuprinzătoare pentru a încorporarea detecției și verificării bazate pe IA la fiecare nivel a pachetului lor de securitate cibernetică. Abordarea trebuie să reflecte suprafața de atac, acoperind e-mail, web, voce, documente, identitate și nu numai. Diagrama de mai jos ilustrează modul în care organizațiile pot integra instrumentele de detectare a IA de la TruthScan (și soluții similare) în straturile de securitate comune ale întreprinderii:

Integrarea instrumentelor de detectare AI la mai multe niveluri ale stivei de securitate - de la gateway-uri de e-mail și centre de apel la verificarea utilizatorilor și protecția punctelor finale. Detectarea conținutului AI (centru) analizează textul, imaginile, materialele audio și video în timp real, alimentând punctele de aplicare care protejează activele și utilizatorii.

În acest model, detectoarele AI multimodale acționează ca un creier central care interfețează cu diverse controale de securitate:

- Gateway-uri de e-mail: E-mailurile primite trec printr-un detector AI de text/escrocherie înainte de a ajunge în inbox. Acest lucru este legat de apărarea împotriva phishing-ului pe care am discutat-o - de exemplu, utilizarea Detectorul de escrocherii prin e-mail al TruthScan prin API la furnizorul dvs. de e-mail pentru a pune automat în carantină e-mailurile suspecte generate de AI[18]. De asemenea, poate fi aplicat platformelor de mesagerie (aplicații de chat, gateway-uri SMS) pentru a scana conținutul în căutarea tiparelor de phishing sau înșelătorie.

- Centre de apel și sisteme vocale: Canalele telefonice și VOIP sunt securizate prin integrarea detecției Deepfake a vocii. De exemplu, linia de asistență pentru clienți a unei bănci ar putea utiliza Detectorul de voce AI al TruthScan să analizeze în timp real sunetul apelantului și să alerteze în cazul în care amprenta vocală a apelantului este sintetică sau nu corespunde profilului său cunoscut[58][59]. Acest lucru ajută la prevenirea reușitei atacurilor de tip vishing și de impostură vocală (cum ar fi apelurile false ale directorului general).

- Procese de verificare a identității utilizatorului: În timpul creării unui cont sau al acțiunilor cu risc ridicat ale utilizatorului (resetarea parolei, transferuri bancare), intervine verificarea identității bazată pe AI. O fotografie de identificare încărcată este verificată de un instrument de analiză criminalistică a imaginilor (de exemplu, se verifică dacă este generată de AI sau este o fotografie a unei fotografii), iar un selfie sau un apel video este analizat de un detector de falsuri adânci. Programul TruthScan Detector Deepfake pot fi utilizate aici pentru a efectua autentificarea facială - asigurându-se că persoana de pe cameră este reală și corespunde ID-ului[60][61]. Semnalele comportamentale (cadența tastării, consecvența dispozitivelor) pot fi, de asemenea, introduse în modelele AI pentru a detecta roboții sau identitățile sintetice.

- Puncte finale și rețea: Agenții de securitate pentru puncte terminale și serverele proxy pot încorpora analiza conținutului AI pentru fișiere și scripturi. De exemplu, în cazul în care un EDR pentru punctul terminal vede un script sau un EXE nou care se execută, acesta ar putea trimite conținutul textului fișierului către un detector de inteligență artificială pentru a verifica dacă acesta seamănă cu malware cunoscut generat de inteligență artificială sau prezintă trăsături ale codului de inteligență artificială ofuscat. În mod similar, sistemele DLP (prevenirea pierderilor de date) ar putea utiliza detectarea textului AI pentru a semnala textul sensibil generat de AI (care ar putea indica o persoană din interior care utilizează AI pentru a redacta mesaje de exfiltrare a datelor sau pentru a falsifica rapoarte). Sistemul TruthScan Detector în timp real este conceput pentru a se integra în astfel de fluxuri de lucru, oferind o analiză în timp real a conținutului pe toate platformele, cu opțiuni automate de răspuns[42][62] (de exemplu, blocarea automată a unui fișier sau mesaj dacă acesta este identificat ca malware sau dezinformare generată de AI).

The beneficiu cheie a acestei abordări integrate este viteză și coerență. Atacurile AI se mișcă rapid - e-mailurile de phishing, vocile false și datele sintetice pot atinge mai multe canale simultan. Prin instrumentarea tuturor acestor canale cu detectarea AI, o organizație obține vizibilitate în timp real și apărare în profunzime. O echipă a descris acest lucru ca fiind crearea unui "sistem imunitar AI" pentru întreprinderea lor: ori de câte ori se comunică ceva (fie că este vorba de un e-mail, de încărcarea unui document, de un apel vocal etc.), sistemul imunitar AI "adulmecă" semnăturile străine (generate de AI) și le neutralizează dacă sunt considerate rău intenționate.

Suita enterprise TruthScan exemplifică acest lucru, deoarece oferă o platformă unificată care acoperă detectarea AI pentru text, imagine, audio și video și care poate fi implementat modular sau ca un întreg[63][64]. Multe companii încep prin implementarea uneia sau a două capabilități (de exemplu, detectarea textului în e-mail și detectarea imaginilor în onboarding) și apoi se extind la altele odată ce își văd valoarea. În mod important, integrarea este facilitată dezvoltatorilor - TruthScan și serviciile similare oferă API-uri și SDK-uri, astfel încât echipele de securitate să poată conecta detecția la sistemele existente fără o reinginerie masivă. Fie că este vorba de un SIEM, un gateway de e-mail, o aplicație bancară personalizată sau un sistem CRM, detecția poate funcționa în spatele scenei și poate alimenta alerte sau acțiuni automate. De exemplu, o mare platformă de social media a integrat API-uri de moderare a conținutului pentru a elimina automat videoclipurile deepfake în câteva minute de la încărcare[65][66], împiedicând răspândirea dezinformării generate de AI.

Concluzii: Rămâneți înaintea curbei

Proliferarea rapidă a amenințărilor generate de inteligența artificială în 2025 a provocat organizații în moduri noi. Atacatorii au găsit mijloace de exploatare a încrederii umane la scară largă - impersonând voci și identități, automatizând ingineria socială, evitând apărarea prin cod adaptiv și fabricând realități false întregi. Este o perspectivă descurajantă pentru apărători, dar nu una fără speranță. La fel cum infractorii exploatează inteligența artificială, la fel și noi putem înrola inteligența artificială de partea securității. Apariția Detectarea conținutului AI, analiza criminalistică a falsurilor profunde și scanerele de identitate sintetică ne oferă mijloace puternice de contracarare a acestor noi amenințări. Prin implementarea acestor instrumente și integrarea acestora în toate straturile de apărare, întreprinderile pot reduce drastic riscul ca atacurile bazate pe inteligența artificială să treacă neobservate. Utilizatorii timpurii au contracarat deja încercări de fraudă de milioane de dolari prin prinderea în flagrant a deepfakes[26]sau a prevenit dezastrele de phishing prin filtrarea e-mailurilor create de AI.

Dincolo de tehnologie, organizațiile ar trebui să cultive o cultură a "încrederii, dar verificării". Angajații ar trebui să fie conștienți de faptul că, în era inteligenței artificiale, a vedea (sau a auzi) nu înseamnă întotdeauna a crede - un scepticism sănătos, asociat cu fluxuri de verificare, poate stopa multe scheme de inginerie socială. Formarea și conștientizarea, combinate cu instrumente de verificare automată precum TruthScan, formează o apărare formidabilă. Într-un fel, trebuie să ridicăm ștacheta pentru autentificarea și validarea informațiilor. Comunicările și documentele digitale nu mai pot fi luate ca atare; proveniența lor trebuie să fie verificată, fie prin mașină, fie prin proces.

Pe măsură ce avansăm, ne așteptăm ca atacatorii să își perfecționeze în continuare tacticile în materie de inteligență artificială, dar ne așteptăm și la inovații continue în materie de inteligență artificială defensivă. Dinamica "șoarecele și pisica" va persista. Succesul apărătorilor va depinde de agilitate și schimbul de informații. Cei care încorporează rapid noi informații privind amenințările (de exemplu, tehnici noi de detectare a falsurilor profunde sau semnături actualizate ale modelelor AI) vor rămâne înaintea atacatorilor care utilizează cele mai recente instrumente AI. Colaborările dintre industrie, mediul academic și cel guvernamental vor fi, de asemenea, vitale în această luptă, după cum se poate observa din alertele și cadrele care apar de la agenții precum AI Risk Management Framework al NIST și colaborările interbancare privind detectarea fraudelor cu ajutorul IA.

În concluzie, industria securității cibernetice se află în mijlocul unei schimbări de paradigmă determinată de IA. Amenințările sunt diferite de cele de acum un deceniu, dar le facem față cu mijloace de apărare la fel de inedite. Cu o combinație de tehnologie avansată de detectare și o strategie robustă de securitate, putem poate să atenuăm riscurile IA generativă și chiar să o transformăm în avantajul nostru. Instrumente precum suita de detectare a IA a TruthScan ne permit să restabilirea încrederii într-o lume fără încredere - pentru a ne asigura că persoana de la celălalt capăt al firului este reală, că documentul din căsuța de primire este autentic și că codul care rulează în rețeaua noastră nu a fost modificat de un AI rău intenționat. Investind acum în aceste capacități, organizațiile nu numai că se vor proteja de atacurile actuale bazate pe inteligența artificială, dar își vor consolida și rezistența împotriva amenințărilor în continuă evoluție de mâine. Concluzia este clară: Este posibil ca inteligența artificială să potențeze atacurile cibernetice, dar, cu o abordare corectă, poate potența și apărarea noastră.

Surse: Datele și exemplele relevante au fost extrase din rapoartele de informații privind amenințările din 2025 și de la experți, inclusiv din Raportul Mayer Brown Cyber Incident Trends[1][67], Fortinet's 2025 threat roundup[2][19], Cercetare Barracuda privind atacurile prin e-mail cu inteligență artificială[6][7], Raportul Google GTIG privind amenințările IA[34], Perspective ale Rezervei Federale din Boston privind frauda sintetică[45][50], precum și studiile de caz și comunicatele de presă publicate de TruthScan[30][26], printre altele. Acestea ilustrează amploarea amenințărilor generate de IA și eficacitatea contramăsurilor bazate pe IA în scenarii reale. Învățând din astfel de informații și utilizând instrumente de ultimă oră, putem naviga cu încredere în era riscurilor cibernetice potențate de IA.

[1] [67] 2025 Tendințe privind incidentele cibernetice - Ce trebuie să știe afacerea dumneavoastră | Insights | Mayer Brown

[2] [3] [19] Statistici de top privind securitatea cibernetică: Fapte, statistici și breșe pentru 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Frauda generată de IA în serviciile financiare: Tendințe recente și soluții | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan detectează un atac Deepfake nord-coreean asupra oficialilor din domeniul apărării - Bryan County Magazine

[6] [7] [14] Jumătate din spam-ul din inbox-ul dvs. este generat de inteligența artificială - utilizarea acesteia în atacuri avansate este într-un stadiu incipient | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] T2 2025 Indicele încrederii digitale: Date și informații privind frauda AI | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Amenințările de securitate cibernetică ale IA în 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Ultimele informații despre amenințări | TruthScan

[18] [63] [64] TruthScan - Detectarea IA la nivel de întreprindere și securitatea conținutului

[23] [46] [56] [57] Deepfakes și depozite: Cum să combatem frauda generată de inteligența artificială generativă

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Atacuri Deepfake și phishing generat de AI: statistici 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] Detector de voce AI pentru Deepfakes și clonarea vocii | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Detector Deepfake - Identificați videoclipurile false și AI - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Progrese în utilizarea de către actorii amenințători a instrumentelor AI | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackerii au ofuscat programele malware cu un cod AI verbos

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Detectarea AI în timp real - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Operatorii EvilAI folosesc coduri generate de AI și aplicații false pentru ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Generația AI sporește amenințarea fraudei de identitate sintetică - Federal Reserve Bank of Boston

[53] Frauda de identitate sintetică 2025: Strategii de detectare și prevenire a IA