Introducere

Inteligența artificială transformă peisajul fraudei financiare în moduri fără precedent. La începutul anului 2024, escrocii au folosit deepfakes generate de inteligența artificială pentru a se da drept executivi în cadrul unui apel video - păcălind un angajat din Hong Kong să transfere $25 milioane pentru escroci[1][2]. Incidente precum acesta demonstrează modul în care inteligența artificială generativă le permite infractorilor să creeze escrocherii extrem de convingătoare care vizează băncile și clienții acestora. Autoritățile de reglementare trag un semnal de alarmă: FinCEN din cadrul Trezoreriei SUA a emis o alertă la sfârșitul anului 2024, avertizând cu privire la creșterea fraudelor care utilizează mijloace "deepfake" generate de AI, inclusiv documente de identitate false pentru a ocoli verificările bancare[3][4]. Acest whitepaper examinează cele mai recente Tendințele în materie de fraudă AI în serviciile financiare și analizează modul în care instituțiile își pot consolida apărarea. Explorăm modul în care escrocii folosesc inteligența artificială generativă - de la imitații false la identități sintetice - și prezentăm tehnologii și strategii (inclusiv instrumente avansate de detectare precum TruthScan) pe care echipele de combatere a fraudelor și directorii le pot implementa pentru a contracara această amenințare în continuă evoluție.

Principalele tendințe în materie de fraudă AI în sectorul serviciilor financiare

Inteligența artificială și învățarea automată sunt utilizate de actorii răi pentru a comite fraude la o scară mai mare și mai sofisticate. Notabil Tactici de fraudă bazate pe inteligența artificială cu impact asupra băncilor, fintech-urilor și asigurătorilor includ:

- Escrocherii de substituire a identității Deepfake: Infractorii folosesc Video și audio generate de AI pentru a se da drept persoane de încredere (directori executivi, clienți etc.) în timp real. De exemplu, în atacurile de tip vishing (phishing vocal) au fost utilizate voci deepfake realiste pentru a autoriza transferuri bancare frauduloase, iar înregistrările video create de AI au păcălit angajații să aprobe tranzacții false[1][5]. Aceste mijloace de comunicare sintetice fac dificil să știi dacă vorbești cu adevărat cu persoana care crezi că ești, permițând jafuri de mare valoare precum cazul $25M deepfake de mai sus. Deepfakes devin accesibile și ușor de produs, care necesită doar 20-30 de secunde de sunet pentru a clona o voce sau mai puțin de o oră pentru a genera un videoclip aparent autentic[6].

- Phishing și BEC îmbunătățite prin IA: Inteligența artificială generativă stimulează schemele de inginerie socială, cum ar fi e-mailurile de phishing și compromiterea e-mailului de afaceri (BEC). Roboții de chat cu inteligență artificială pot redacta e-mailuri înșelătoare extrem de personalizate într-un limbaj de afaceri perfect, imitând stilul de scriere al unui CEO sau creând la scară largă facturi false convingătoare ale furnizorilor. De fapt, instrumente subterane precum FraudăGPT și WormGPT (versiuni nefiltrate ale ChatGPT) au apărut pentru a ajuta infractorii cibernetici să automatizeze crearea de phishing și malware[7][8]. Acest lucru înseamnă că un potențial escroc cu competențe minime poate genera cu ușurință campanii de phishing sau coduri malițioase perfecționate. Cu ajutorul inteligenței artificiale, un singur infractor poate trimite mii de e-mailuri sau mesaje text înșelătoare personalizate, mărind considerabil amploarea tentativelor de fraudă tradiționale. Centrul pentru infracțiuni pe internet al FBI a observat deja peste $2,7 miliarde pierdute din cauza înșelăciunilor BEC în 2022, iar inteligența artificială generativă amenință să crească și mai mult aceste pierderi în anii următori[9][10].

- Identități sintetice și fraudarea documentelor: Inteligența artificială generativă alimentează un boom al fraudei de identitate sintetică, unul dintre tipurile de infracțiuni financiare cu cea mai rapidă creștere[11][12]. Fraudatorii combină date personale reale și false pentru a crea identități "Frankenstein", apoi folosesc inteligența artificială pentru a să prezinte documente justificative realiste - de la pașapoarte false și extrase de cont la adeverințe de salariu[7]. Generatoarele de imagini AI și instrumentele de editare pot falsifica acte de identitate și fotografii cu aspect autentic care trec de o inspecție întâmplătoare. Chiar și verificările legate de vivacitate sau de selfie-uri pot fi învinse de imagini sau clipuri video manipulate de AI. Prin automatizarea creării a mii de persoane false (fiecare cu fotografii de profil, rețele de socializare etc. generate de inteligența artificială), infractorii pot deschide conturi bancare sau solicita împrumuturi în masă și spăla bani sau nu pot rambursa creditele. Pierderile cauzate de frauda de identitate sintetică au fost estimate la aproximativ $35 miliarde în 2023[13], iar inteligența artificială generativă nu face decât să accelereze această tendință, făcând identitățile false mai ieftine și mai greu de detectat.

- Fraudă și evaziune automatizate: Pe lângă crearea de conținut fals, inteligența artificială îi ajută și pe escroci să maximizeze succesul schemelor lor. Roboții avansați pot testa rapid detaliile cardurilor de credit furate pe site-urile de comerț electronic, folosind ML pentru a evita declanșarea detecției. Inteligența artificială îi poate ajuta pe infractori să identifice cele mai slabe verigi ale securității unei organizații sau chiar să sintetizeze răspunsuri vocale pentru a învinge verificarea identității prin telefon. O industrie artizanală de pe internetul întunecat vinde în prezent instrumente de IA "fraudă ca serviciu" pentru doar $20[14]. Această democratizare a capacităților AI înseamnă că și infractorii de nivel scăzut pot lansa atacuri frauduloase extrem de sofisticate. Cursa înarmărilor se extinde la evitarea detectării - escrocii folosesc inteligența artificială pentru a sonda sistemele antifraudă ale băncilor și pentru a-și perfecționa abordarea până când găsesc o metodă care trece de filtre[15]. Pe scurt, inteligența artificială permite desfășurarea fraudelor la o scară și eficiență nemaivăzute până acum, sfidând apărarea convențională.

Aceste tactici bazate pe inteligența artificială sunt deja proliferarea într-un ritm alarmant. Schemele tradiționale de fraudă, cum ar fi falsificarea cecurilor sau phishing-ul, există de ani de zile, însă inteligența artificială le sporește volumul și realismul. Datele spun o poveste clară: Frauda AI este în creștere.

Nu vă mai îngrijorați niciodată de frauda AI. TruthScan Vă poate ajuta:

- Detectarea AI generate imagini, text, voce și video.

- Evitați fraudă majoră generată de IA.

- Protejați-vă cele mai sensibile activele întreprinderii.

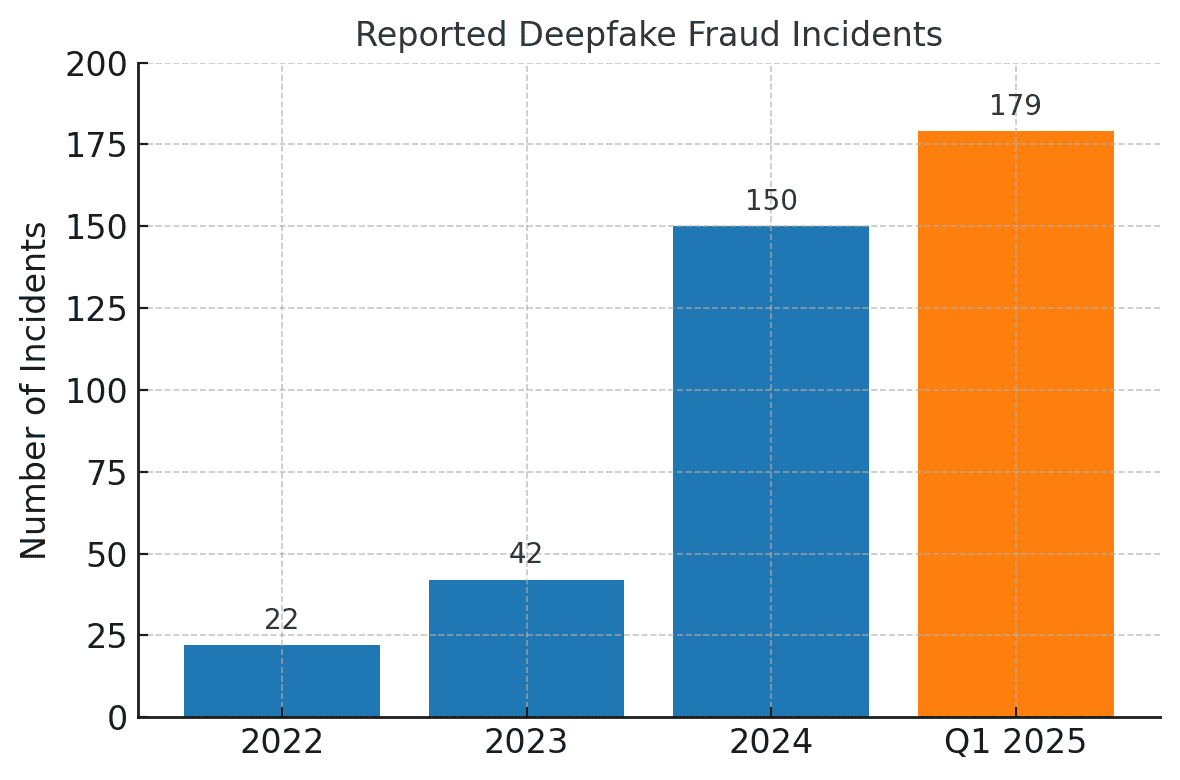

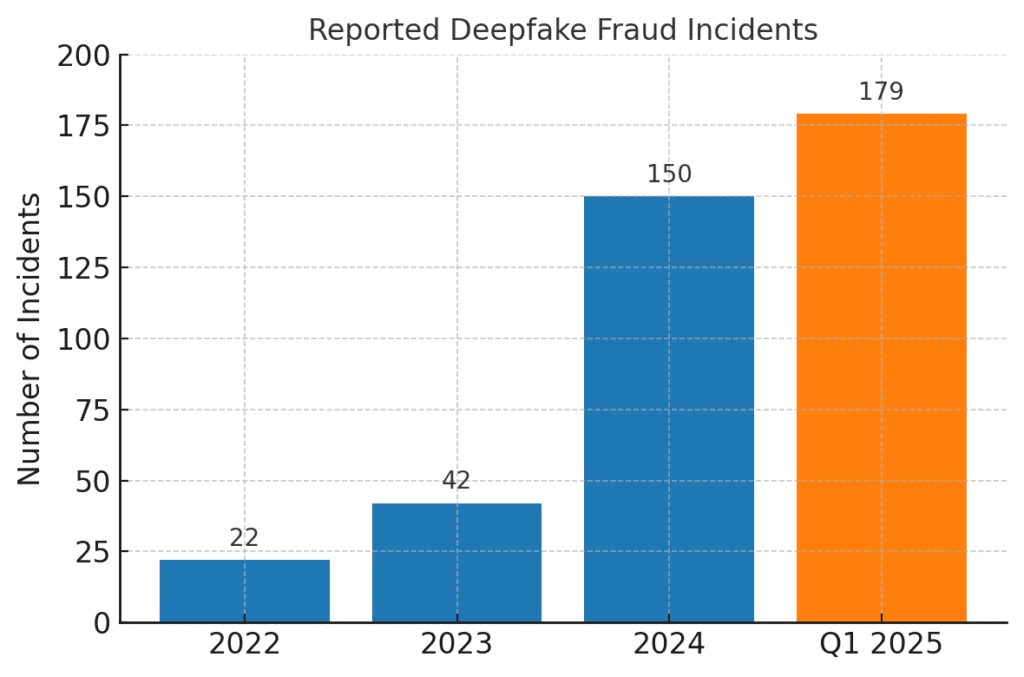

Incidentele de fraudă legate de Deepfake au crescut vertiginos. În 2022, au fost înregistrate doar 22 de cazuri de fraudă deepfake, dar în 2023 au fost 42, iar în 2024 incidentele au explodat la 150. Doar în primul trimestru al anului 2025, 179 de incidente de fraudă deepfake au fost raportate - depășind totalul pentru tot anul 2024[16][17].

Analizele recente ale industriei reflectă aceste tendințe. Un raport a remarcat o 700% creșterea numărului de incidente deepfake care vizează firmele fintech în 2023[18]. Chiar mai uimitor, America de Nord a înregistrat o 1,740% creșterea numărului de cazuri de fraudă deepfake între 2022 și 2023[19]. Infractorii financiari adoptă rapid aceste instrumente pentru că funcționează - multe bănci și victime nu sunt încă pregătite să detecteze înșelăciunea generată de inteligența artificială.

Impactul și provocările pentru instituțiile financiare

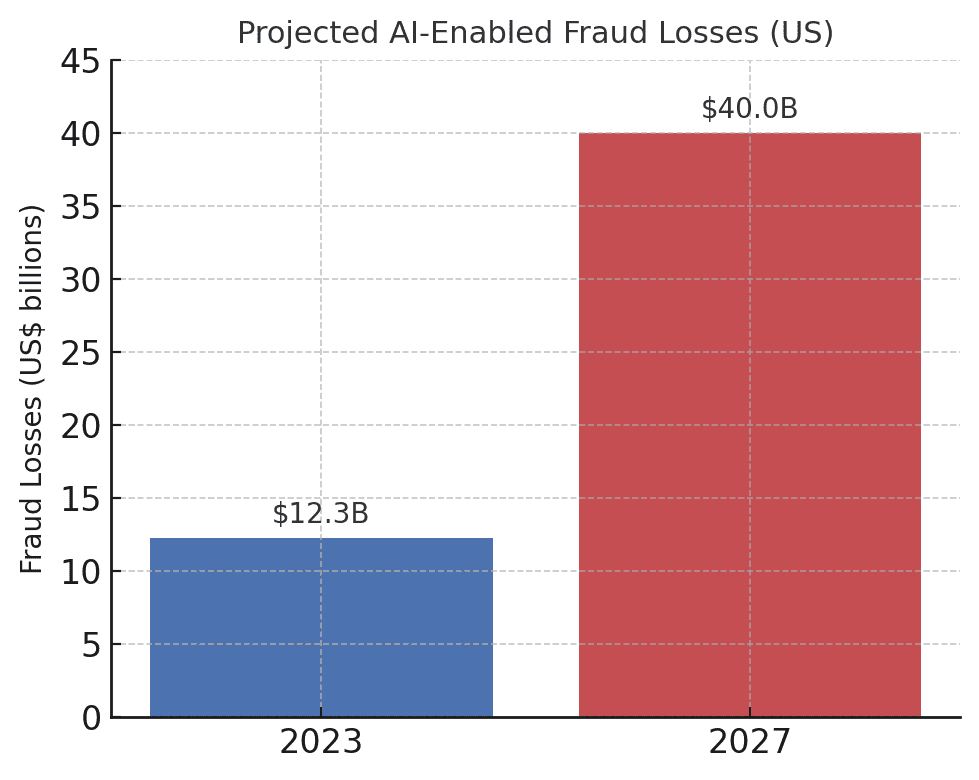

Creșterea fraudei bazate pe inteligența artificială reprezintă impacturi semnificative asupra instituțiilor financiare, a clienților acestora și a sistemului financiar în general. Impactul cel mai imediat este pierderea monetară. Previziunile din industrie estimează că, până în 2027, pierderile cauzate de frauda generată de IA generativă ar putea ajunge la $40 miliarde în SUA, în creștere de la $12,3 miliarde în 2023[20]. Această creștere de peste trei ori (o 32% CAGR) reflectă cât de repede crește riscul de fraudă în dolari.

Pierderile preconizate în urma fraudelor bazate pe inteligența artificială cresc dramatic. Deloitte estimează că pierderile din fraudele financiare din SUA legate de inteligența artificială generativă vor crește de la $12,3 miliarde în 2023 la $40 miliarde până în 2027[20].

Dincolo de pierderile brute, există pierderi reputaționale și costuri fiduciare. Consumatorii se așteaptă ca băncile lor să îi protejeze, însă escrocheriile care utilizează inteligența artificială subminează încrederea în canalele digitale. De exemplu, dacă un client este victima unei înșelătorii convingătoare de tip deepfake (cum ar fi un apel video fals cu un bancher), acesta poate da vina pe bancă pentru securitatea inadecvată. Încrederea publică în verificarea vocii, e-mailuri și chiar videoconferințe se poate eroda dacă "ceea ce vezi/auzi" nu mai poate fi considerat real[21]. Conform sondajelor, 85% dintre profesioniștii din domeniul financiar din SUA/Regatul Unit consideră escrocheriile deepfake drept o amenințare "existențială" la adresa securității organizației lor[22]. Mai mult de jumătate dintre companiile de pe aceste piețe raportează că au fost vizate de o înșelătorie bazată pe deepfake și, în mod alarmant 43% dintre cei vizați au recunoscut că atacul a reușit în a le păcăli[23]. Fiecare incident de succes cauzează nu numai prejudicii financiare, ci și pierderea încrederii clienților în instituție.

Firmele financiare se confruntă, de asemenea, cu provocări operaționale și de conformitate din frauda AI. Echipele antifraudă se confruntă cu o creștere a numărului de alerte și incidente, ceea ce limitează resursele de investigare. Modelele existente de detectare a fraudelor (dintre care multe se bazează pe reguli sau pe tehnici mai vechi de învățare automată) pot avea dificultăți în a recunoaște conținutul sintetizat de AI care pare legitim. De fapt, sistemele de ultimă generație de detectare a falsurilor profunde, dezvoltate în laboratoare, își reduc precizia cu aproape 50% atunci când sunt confruntate cu lumea reală deepfakes în sălbăticie[24]. Personalul uman nu se descurcă mult mai bine - studiile arată că oamenii pot detecta videoclipuri deepfake de înaltă calitate doar în jurul valorii de 55%-60% din timp, abia mai bună decât șansa[25]. Acest lucru indică faptul că, fără instrumente noi, băncile vor rata o mare parte din tentativele de fraudă bazate pe inteligența artificială.

Există, de asemenea, un dimensiunea de reglementare. Autoritățile de reglementare și de aplicare a legii sunt perfect conștiente de riscuri (după cum reiese din alerta FinCEN) și se așteaptă ca instituțiile financiare să se adapteze. Băncile s-ar putea confrunta cu orientări mai stricte privind verificarea clienților și raportarea fraudelor în era IA. De exemplu, dacă un angajat al unei bănci este păcălit de un deepfake să aprobe un transfer de $10 milioane, autoritățile de reglementare ar putea examina controalele și procesele de due diligence ale băncii. De asemenea Legea privind secretul bancar include acum în mod explicit raportarea infracțiunilor cibernetice suspectate și a activităților legate de deepfake[26][4], ceea ce înseamnă că băncile trebuie să instruiască personalul să recunoască și să raporteze indicatorii de fraudă generați de IA în rapoartele de activitate suspectă (SAR). Nereușita de a ține pasul cu tehnicile de fraudă bazate pe inteligența artificială ar putea conduce la încălcări ale conformității sau la răspundere juridică în cazul în care clienții sau contrapărțile susțin că banca nu a făcut suficient pentru a preveni înșelăciunile previzibile bazate pe inteligența artificială.

Poate cea mai mare provocare este caracterul asimetric al acestei noi amenințări. Inteligența artificială generativă reduce considerabil costurile și bariera competențelor pentru atacatori, crescând în același timp exponențial volumul și realismul atacurilor. Un singur zvon viral de tip deepfake sau un apel convingător de clonare a vocii pot înfrânge investiții de milioane de dolari în autentificare. Între timp, apărătorii trebuie să verifice autenticitatea fiecărei tranzacții și interacțiuni, o sarcină mult mai dificilă. Este cu adevărat o cursă a înarmărilor: Inteligența artificială oferă escrocilor un set de instrumente care se actualizează automat pentru a ocoli securitatea, ceea ce impune băncilor să își actualizeze în permanență și sistemul de apărare[15][27]. Multe instituții financiare recunosc că nu sunt pregătite corespunzător - peste 80% din companii nu dispun de un plan formal de răspuns la atacurile deepfake, iar mai mult de jumătate nu au oferit niciun fel de instruire angajaților cu privire la riscurile deepfake[28][29]. Acest deficit de pregătire înseamnă că organizațiile sunt vulnerabile în prezent, dar evidențiază și domeniile în care este nevoie de acțiune.

O măsurătoare demnă de remarcat și care dă de gândit provine dintr-un raport recent al industriei: 42,5% din tentativele de fraudă din sectorul financiar implică în prezent o formă de IA[30]. Cu alte cuvinte, aproape jumătate din atacurile frauduloase cu care se confruntă băncile au o componentă de inteligență artificială - fie că este vorba despre un document generat de inteligență artificială, o voce sintetizată sau un mesaj de phishing generat de o mașină. Această statistică subliniază faptul că inteligența artificială nu este o amenințare ipotetică pentru viitor; este deja aici, forțând instituțiile financiare să se adapteze sau să se confrunte cu pierderi tot mai mari.

Apărarea împotriva fraudei bazate pe IA: Strategii și soluții

Confruntarea cu frauda generată de inteligența artificială necesită o evoluție a strategiilor de prevenire a fraudei. Abordările tradiționale (cum ar fi verificarea manuală sau motoarele de reguli statice) nu pot face față înșelăciunilor bazate pe inteligența artificială care își schimbă forma. În schimb, băncile trebuie să îmbrățișeze technology (like making sure they have a Secure SSL Certificate), training, and teamwork pentru a inversa tendința. Mai jos, prezentăm strategiile cheie și soluțiile emergente:

- Utilizarea IA pentru combaterea IA (instrumente avansate de detectare): Instituțiile financiare apelează din ce în ce mai mult la Soluții de detectare bazate pe inteligență artificială pentru a identifica conținutul generat de AI și anomaliile. În esență, trebuie să combateți focul cu foc. Noile instrumente pentru întreprinderi, cum ar fi TruthScan oferă detectare AI multimodală în text, imagini, voce și video pentru a ajuta la autentificarea conținutului în timp real[31]. De exemplu, băncile pot implementa detectoare de text AI pentru a scana comunicațiile primite (e-mailuri, mesaje de chat) pentru a detecta semne de limbaj generat de AI care ar putea indica un e-mail de phishing sau o întrebare falsă a clientului. Sistemul de detectare a textului AI de la TruthScan poate identifica conținutul scris de AI din modele precum GPT-4 cu 99%+ precizie, chiar și identificarea precisă a propozițiilor care sunt probabil generate de AI[32][33]. În mod similar, instrumentele criminalistice de imagine AI pot verifica documente și imagini; o Detector de imagini AI poate semnala dacă un permis de conducere sau o factură de utilități prezentate au fost create digital sau manipulate prin compararea acestora cu modele cunoscute de imagini generate de AI[34]. Pentru amenințările audio, băncile încep să utilizeze detectoare de voce deepfake - care analizează sunetul apelurilor pentru amprentele acustice ale vorbirii sintetice. AI Voice Detector de la TruthScan, de exemplu, detectează semnele evidente ale clonării vocii și poate verificați autenticitatea vorbitorului pentru a preveni apelurile impostorilor[35]. Prin integrarea acestor detectoare prin API în fluxurile lor de lucru, instituțiile financiare pot depista în mod automat conținutul IA în contextul tranzacțiilor și interacțiunilor. Acest lucru oferă un nivel suplimentar de apărare care funcționează la viteza mașinii, prinzând ceea ce ochii/urechile umane ar putea rata.

- Implementarea verificării multifactoriale și în afara benzii: Întrucât inteligența artificială face mai dificilă încrederea în voci sau imagini, băncile ar trebui să se bazeze mai mult pe metode de verificare pe care inteligența artificială nu le poate falsifica cu ușurință. Aceasta include autentificarea cu mai mulți factori (MFA) prin canale securizate. De exemplu, dacă o cerere de transfer bancar vine prin e-mail sau apel video, solicitați un al doilea factor, cum ar fi un cod de acces unic trimis pe dispozitivul mobil cunoscut al solicitantului sau un apel înapoi la un număr de telefon de încredere din dosar. Unele bănci adaugă verificări de "vivacitate" pentru tranzacțiile cu risc ridicat - de exemplu, cerând unui client să își facă un selfie live cu un anumit gest sau cuvânt, care este mai greu de reprodus de un video deepfake. Autentificatoarele biometrice pot fi îmbunătățite cu măsuri antispoofing (de exemplu, scanarea în 3D a profunzimii feței sau monitorizarea mișcărilor subtile ale ochilor pe care deepfakes nu reușesc adesea să le imite[27]). Cheia este evitarea punctelor unice de eșec. Chiar dacă un AI deepfake poate păcăli un canal (de exemplu, verificarea vocală), o verificare coordonată în afara benzii sau un test biometric poate oferi provocarea necesară pentru a descoperi frauda. Principiile încrederii zero ar trebui aplicată: tratați orice instrucțiune nesolicitată sau neașteptată (chiar și din partea unui director sau client "cunoscut") ca fiind suspectă până când este verificată printr-un canal independent.

- Formarea angajaților și conștientizarea fraudei: Tehnologia în sine nu este un glonț de argint - mai ales că escrocii vor viza veriga cea mai slabă, care este adesea încrederea umană. Instituțiile financiare ar trebui să investească în formarea periodică a echipelor de prevenire a fraudelor și a personalului din prima linie cu privire la înșelătoriile bazate pe inteligența artificială. Angajații trebuie să învețe să recunoască semnalele de alarmă ale deepfakes și ale ingineriei sociale. Aceasta ar putea include instruirea privind anomaliile subtile (de exemplu, probleme de sincronizare a buzelor într-un apel video sau un sunet care conține o intonație nefirească sau prea puțin zgomot de fond - semne potențiale ale unei voci sintetice). Încurajați o cultură a verificare: angajații ar trebui să se simtă împuterniciți să întrerupă o tranzacție sau o cerere suspectă și să o verifice independent, chiar dacă pare să provină de la CEO. Cazul Încercare de falsificare a vocii CEO-ului Ferrari este instructiv - un executiv a descoperit șiretlicul doar punând o întrebare personală la care impostorul nu a putut răspunde[36]. Simulările de phishing/deepfake pot fi, de asemenea, utile. La fel cum companiile efectuează simulări de phishing pentru a instrui personalul, ele pot simula un mesaj vocal fals sau o întâlnire video falsă și pot vedea dacă angajații îl detectează. Acest lucru construiește memoria musculară pentru a rezista atacurilor reale. Având în vedere că mai mult de 50% din companii nu au protocoale de răspuns la deepfake și au puțină formare în vigoare[29], instituirea unor astfel de programe este o măsură de îmbunătățire a rezilienței.

- Analiza fraudelor și detectarea anomaliilor: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier sunete generate de AI sau excesiv de formulaic (asociat cu detectarea textului AI menționată anterior). Bănci precum JPMorgan au început să utilizeze modele lingvistice mari în comunicațiile lor interne pentru a detecta frazele sau contextele care ar putea indica o încercare de inginerie socială[37]. Rețelele de plăți precum Mastercard analizează cu ajutorul inteligenței artificiale seturi vaste de date (miliarde de tranzacții) pentru a identifica tranzacțiile frauduloase pe care regulile tradiționale le-ar omite[38]. Concluzia este că AI defensivă trebuie să fie la fel de inovatoare ca inteligența artificială ofensivă. Firmele ar trebui să ia în considerare dezvoltarea sau achiziționarea de modele de inteligență artificială special concepute pentru a detecta conținutul fals, identitățile sintetice și modelele generative de atac. În mod esențial, aceste modele ar trebui să fie reantrenate în permanență pe baza celor mai recente exemple de fraudă AI (o practică numită învățare online sau învățare federată), astfel încât să țină pasul cu tacticile în evoluție rapidă ale infractorilor[39][40].

- Colaborarea și schimbul de informații: Combaterea fraudei bazate pe IA va necesita colaborarea atât în cadrul instituțiilor, cât și între acestea. Eforturile izolate sunt mai puțin eficiente împotriva unei amenințări care transcende granițele organizaționale. Echipe de prevenire a fraudelor, echipe de securitate cibernetică și IT trebuie să lucreze mână în mână - de exemplu, echipele de securitate pot implementa detectarea deepfake în instrumentele de videoconferință, în timp ce echipele de fraudă integrează scanările de conținut în monitorizarea tranzacțiilor. La un nivel mai larg, băncile ar trebui să participe la grupuri industriale precum Centrul de analiză și partajare a informațiilor privind serviciile financiare (FS-ISAC) pentru a face schimb de informații privind noile scheme de fraudă bazate pe inteligența artificială[41]. În cazul în care o bancă descoperă un nou vector de atac deepfake, împărtășirea acestei informații le poate ajuta pe celelalte să elimine decalajul înainte de a fi afectate. Exercițiile comune sau simulările "echipei roșii" cu scenarii care implică inteligența artificială (de exemplu, o înșelătorie executivă deepfake sau o ocolire a verificării identității generată de inteligența artificială) pot fi efectuate prin intermediul consorțiilor din sector sau cu sprijinul autorităților de reglementare. Autoritățile de reglementare se concentrează asupra riscurilor legate de inteligența artificială, astfel încât este înțelept să se implice în mod proactiv. Prin contribuția la standardele și orientările privind utilizarea IA, băncile pot contribui la crearea unui ecosistem mai sigur. În cele din urmă, deoarece o amenințare la adresa unei bănci este o amenințare la adresa tuturor în acest spațiu[42], o abordare colectivă de apărare va consolida capacitatea tuturor de a detecta și descuraja frauda potențată de IA.

- Educația clienților și măsurile de încredere: În cele din urmă, instituțiile financiare nu ar trebui să ignore rolul sensibilizării clienților. Având în vedere că escrocheriile de tip deepfakes și AI vizează publicul larg (de exemplu, voci false în escrocheriile cu bunici sau chat-uri false de "asistență tehnică" generate de AI), băncile pot contribui la educarea clienților cu privire la aceste pericole. Multe bănci trimit deja alerte cu privire la phishing; ele le pot extinde pentru a menționa clonarea vocii AI și videoclipurile deepfake, oferind sfaturi cu privire la modul de verificare a cererilor. Unele organizații progresiste trimit notificări push sau avertismente în aplicațiile lor în cazul în care circulă o înșelătorie cunoscută (de exemplu, "Atenție: escrocii pot folosi clone vocale ale membrilor familiei care cer bani")[43]. Deși nu previne în mod direct atacurile, educația poate reduce rata de succes și poate consolida faptul că banca este un partener în domeniul securității. În plus, băncile care investesc în prevenirea fraudelor de ultimă generație ar trebui să evidențieze acest lucru în fața clienților ca o diferențiator - de exemplu, informarea clienților că toate apelurile video sau documentele transmise sunt scanate de AI pentru autenticitate (fără a divulga metode sensibile) îi poate asigura pe clienți că banca utilizează toate instrumentele disponibile pentru a-i proteja. Păstrarea încrederii digitale va fi esențială pentru ca băncile să exploateze pe deplin beneficiile AI în domeniul serviciilor, astfel încât transparența și măsurile de protecție orientate către client fac parte dintr-o apărare holistică.

Rolul serviciilor de detectare a conținutului cu inteligență artificială

O piatră de temelie a setului de instrumente antifraudă în era IA este utilizarea Servicii de detectare a conținutului AI. Aceste servicii sunt specializate în depistarea "amprentelor" conținutului generat de inteligența artificială care ar putea scăpa examinatorilor umani. TruthScan este un astfel de furnizor care oferă un serviciu Suita de detecție AI acoperind mai multe tipuri de conținut. Instituțiile financiare pot integra aceste instrumente pentru a depista automat falsurile și indicatorii de fraudă:

- Verificarea documentelor și a imaginilor: Platforma TruthScan permite băncilor să testarea în timp real a documentelor financiare pentru fraude generate de AI[44]. Acest lucru înseamnă că atunci când se deschide un cont nou sau când o cerere de împrumut este însoțită de un act de identitate cu fotografie și de un talon de salariu, sistemul poate analiza instantaneu aceste imagini pentru a detecta semne de generare sintetică sau de falsificare. Cu o precizie a țintei de peste 99%[45]Detectorul de imagini AI poate detecta imagini de identitate false sau PDF-uri falsificate pe care un om le-ar putea aproba la prima vedere. Acest tip de verificarea autenticității documentelor este esențială pentru a opri frauda de identitate sintetică înainte chiar de deschiderea conturilor.

- Monitorizarea în timp real a tranzacțiilor: Prin implementarea de integrări API, TruthScan se poate conecta la procesarea tranzacțiilor băncilor și poate semnala anomalii în timp real. Dacă primiți o instrucțiune prin e-mail care pare suspectă, Email Scam Detector poate analiza conținutul mesajului și poate detecta dacă acesta a fost probabil scris de un model AI care încearcă să falsifice un furnizor sau un executiv[46]. În mod similar, Detector AI în timp real poate monitoriza comunicațiile în direct (cum ar fi chat-urile sau platformele de colaborare) pentru a furniza alerte instantanee dacă, de exemplu, un flux video deepfake impostor este detectat în timpul unei reuniuni cu miză mare[47][48]. Monitorizarea continuă cu alerte instantanee și răspunsuri automate ajută la reducerea intervalului în care frauda poate apărea nedetectată.

- Apărarea Deepfake pentru voce și video: Pentru centrele de apeluri și managerii de relații, încorporarea tehnologiei TruthScan Detector de voce AI adaugă un nivel suplimentar de securitate. Dacă un escroc sună în locul unui client folosind o clonă vocală, sistemul poate analiza sunetul apelului și poate semnala dacă acesta conține elemente sintetizate de inteligența artificială (cum ar fi micro pauze naturale lipsă sau artefacte în undele sonore)[35]. Pe frontul video, Detector Deepfake aplică algoritmi de viziune computerizată cadrelor video pentru a detecta inconsecvențele - cum ar fi mișcările faciale nefirești, iluminarea ciudată sau sincronizarea buzelor nepotrivită - care dezvăluie un fals[49][50]. Prin verificarea integrității vocilor și a fețelor în interacțiunile cheie, băncile pot împiedica impostorii care încearcă să își înșele angajații. Aceste instrumente acționează ca un detector de minciuni high-tech pentru conținutul digital, funcționând invizibil în fundal.

Este demn de remarcat faptul că implementarea unei astfel de tehnologii de detectare nu este un remediu universal; aceasta ar trebui calibrată și adaptată la fluxurile de lucru ale instituției. Falsele rezultate pozitive trebuie gestionate (de exemplu, un detector de text cu inteligență artificială ar putea semnala drept suspecte comunicările legitime bazate pe șabloane, până când își va da seama de diferență). Cu toate acestea, atunci când sunt integrate corespunzător, aceste instrumente îmbunătățesc semnificativ capacitatea unei organizații de a depistați conținutul fraudulos înainte ca acesta să producă daune. De asemenea, acestea generează piste de audit și rapoarte analitice utile pentru conformitate și pentru îmbunătățirea continuă a modelelor de fraudă.

În mod esențial, eficacitatea instrumentelor de detectare a IA depinde de actualizări constante. La fel cum software-ul antivirus are nevoie de semnături noi pentru viruși noi, detectoarele de inteligență artificială au nevoie de recalificare cu privire la cele mai recente tehnici de falsificare profundă și modele de inteligență artificială. Furnizori precum TruthScan își actualizează algoritmii pentru a face față noilor modele generative și tactici de evitare, menținând o acuratețe ridicată chiar și pe măsură ce AI evoluează[51]. Acest lucru ușurează sarcina echipelor interne și garantează că băncile nu se luptă cu războiul de ieri, în timp ce infractorii trec la noi trucuri de inteligență artificială.

Concluzie

Industria serviciilor financiare se află la o răscruce de drumuri în lupta împotriva fraudei. Pe de o parte, infractorii adoptă rapid IA generativă pentru a lansa escrocherii care sunt mai convingătoare și mai răspândite ca niciodată. Pe de altă parte, băncile și luptătorii împotriva fraudelor au la dispoziție un arsenal din ce în ce mai mare de mijloace de apărare bazate pe IA. Instituțiile care vor prospera sunt cele care să recunoască noul peisaj al amenințărilor și să răspundă cu aceeași ingeniozitate. Aceasta înseamnă investiții în capacități avansate de detectare, integrarea proceselor de verificare pe mai multe niveluri, educarea atât a personalului, cât și a clienților și promovarea unei culturi a vigilenței și a adaptării.

Frauda bazată pe inteligența artificială este o țintă care se mișcă rapid - înșelătoria deepfake care a păcălit o companie astăzi ar putea fi contracarată mâine prin noi tehnici de detectare, pentru ca apoi fraudatorii să își modifice metodele săptămâna viitoare. Prin urmare, o strategie de prevenire a fraudelor "standard pentru industrie" în 2025 este una care pune accentul pe agilitate și pe îmbunătățirea continuă. Organizațiile financiare ar trebui să își trateze sistemele de apărare împotriva fraudei ca entități vii, care învață care evoluează în tandem cu tacticile infracționale. Exploatarea parteneriatelor cu furnizorii de tehnologie este o scurtătură inteligentă pentru dezvoltarea acestor capacități. De exemplu, colaborarea cu firme specializate precum TruthScan (care oferă soluții adaptate pentru sectorul bancar și financiar) poate accelera capacitatea unei instituții de a prevenirea fraudei bazate pe IA, menținând în același timp conformitatea cu reglementările și încrederea clienților[52].

În cele din urmă, protecția împotriva fraudei bazate pe inteligența artificială nu ține doar de tehnologie, ci și de păstrarea principiilor fundamentale ale încredere care stă la baza finanțelor. Clienții trebuie să aibă încredere că banca lor poate deosebi o tranzacție reală de una falsă, un client real de un impostor AI. Prin implementarea unor instrumente de detectare a IA de ultimă generație, consolidarea protocoalelor de verificare și anticiparea amenințărilor emergente, firmele de servicii financiare pot menține această încredere. Drumul care ne așteaptă va prezenta, fără îndoială, mai multe tentative de fraudă din partea adversarilor, dar, prin pregătire și investiții adecvate, băncile se pot asigura că IA devine mai mult un avantaj decât o amenințare în domeniul prevenirii fraudelor. Este un obiectiv realizabil: aceleași tehnologii de inteligență artificială care amenință să provoace perturbări pot fi exploatate pentru a proteja integritatea sistemului nostru financiar. Acum este momentul ca echipele de prevenire a fraudelor și directorii executivi să acționeze decisiv, adoptarea de soluții și strategii avansate pentru a fi mai inteligenți decât fraudatorii și să asigure viitorul finanțelor digitale.

Surse: Rapoartele recente din industrie, alertele de reglementare și whitepaper-urile tehnologice au fost menționate pe tot parcursul (Deloitte[20][18], Forumul Economic Mondial[19][24], Trezoreria S.U.A. FinCEN[3][4], Rezerva Federală[13], Keepnet Labs[16][30], printre altele) pentru a furniza date și exemple. Toate datele și exemplele sunt citate in-line pentru a permite cititorilor să exploreze mai departe.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking și riscul de fraudă prin IA | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Detectarea inteligenței artificiale periculoase este esențială în era deepfake | World Economic Forum

[3] [4] [26] FinCEN emite o alertă privind schemele de fraudă care implică Deepfake Media și vizează instituțiile financiare | FinCEN.gov

[7] [8] FraudGPT și GenAI: Cum vor utiliza fraudatorii IA în continuare? | Alloy

[11] Frauda de identitate sintetică: Cum schimbă AI jocul - Federal Reserve Bank of Boston

[12] [13] Inteligența artificială generativă sporește amenințările de fraudare a identității sintetice

[16] [17] [22] [23] [28] [29] [30] Statistici și tendințe Deepfake 2025 | Date și informații cheie - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Detectarea IA la nivel de întreprindere și securitatea conținutului

[32] [33] [51] Detector AI: Detectarea textului AI de nivel enterprise - TruthScan

[44] [45] [52] Detectarea fraudei prin IA în sectorul bancar | Soluții CRO | TruthScan

[49] [50] Detector Deepfake - Identificați videoclipurile false și AI - TruthScan