Introdução

A IA generativa está a revolucionar os cuidados de saúde - e nem sempre para melhor. Em 2025, os esquemas de fraude nos cuidados de saúde aumentaram mais digital e sofisticado, alimentado por violações de dados, automação e IA generativa[1]. Os criminosos estão a explorar as ferramentas de IA para criar identidades falsas de pacientes, pedidos de seguro sintéticos, documentos médicos gerados por IA, receitas médicas falsas e até interações médico-paciente falsas. Estes logros de alta tecnologia elevam a fraude a novos patamares, ameaçando as finanças das seguradoras e a segurança dos doentes em todo o mundo. O desafio é enorme: a fraude nos cuidados de saúde já custa dezenas de milhares de milhões de euros por ano e o aumento da IA é intensificando tanto a escala como a complexidade de burlas[2][3]. Este whitepaper fornece uma visão detalhada das últimas tendências de fraude orientada por IA nos cuidados de saúde, casos reais de 2025 e estratégias - desde detectores de conteúdo de IA até à verificação de identidade - para combater esta ameaça em evolução.

A ascensão dos esquemas de fraude com recurso à IA nos cuidados de saúde

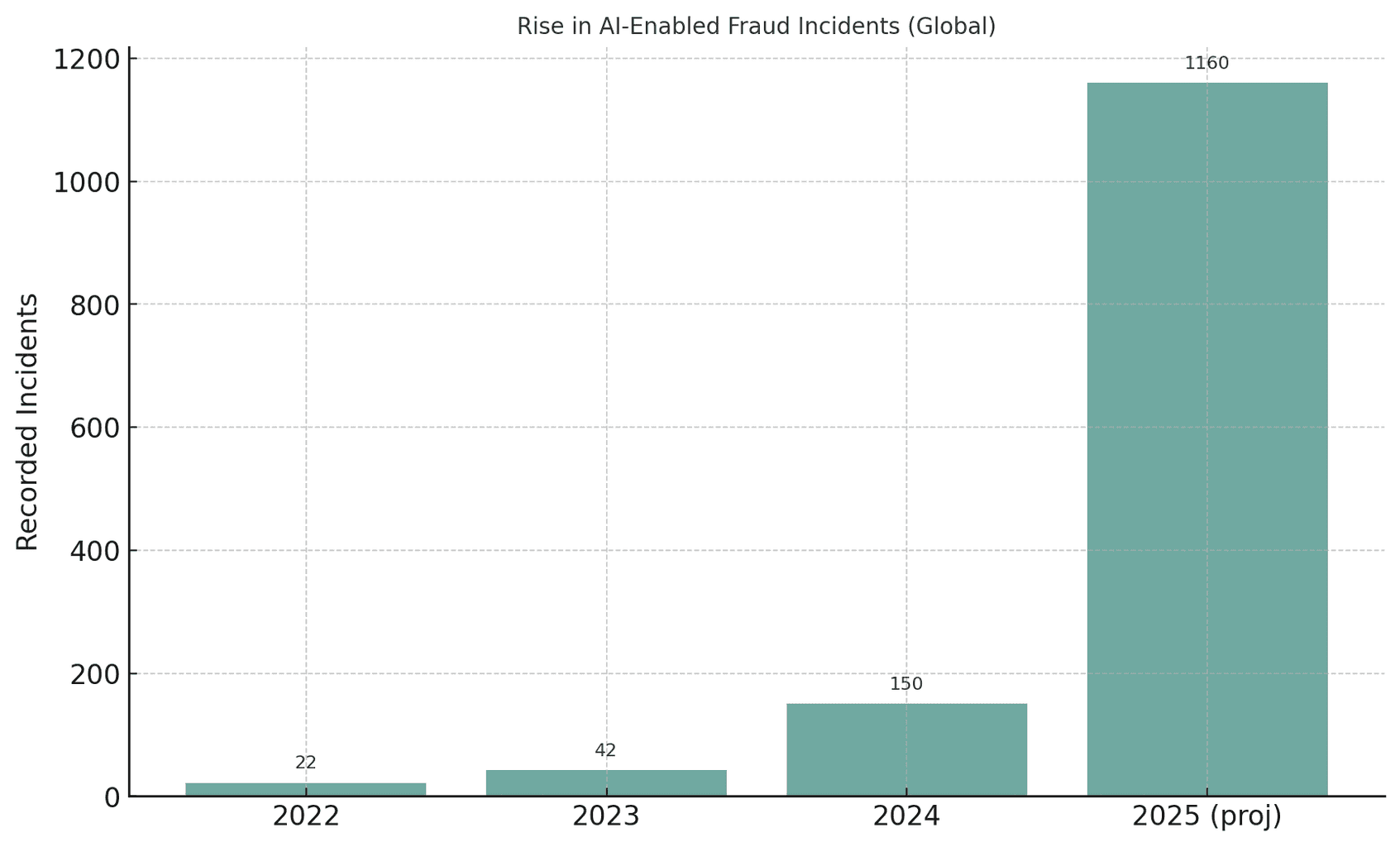

O sector dos cuidados de saúde a nível mundial está a atravessar um período de aumento sem precedentes das tentativas de fraude com recurso à IA. À medida que a IA generativa se torna acessível, os autores de fraudes podem automatizar o que costumava ser fraudes manuais, produzindo identidades, documentos e até vozes ou vídeos falsos convincentes em grande escala. Por exemplo, as autoridades observaram que as tentativas de fraude envolvendo meios de comunicação "deepfake" aumentaram 3,000% em 2023 sozinho[4][5]. Os incidentes relacionados com o deepfake quase duplicaram de 22 em 2022 para 42 em 2023, tendo depois explodido para 150 incidentes em 2024; surpreendentemente, no primeiro trimestre de 2025 registaram-se 179 casos de fraude deepfake - ultrapassando já o total de 2024[6][7]. Esta tendência sugere uma crescimento desenfreado da fraude baseada em IAOs analistas prevêem que a IA generativa poderá conduzir a perdas por fraude de $12,3 mil milhões em 2023 para $40 mil milhões em 2027 (32% CAGR)[8].

Figura: O crescimento explosivo dos incidentes de fraude com recurso à IA nos últimos anos. Os casos detetados de fraude deepfake ou assistida por IA aumentaram drasticamente entre 2022 e 2025, ilustrando como as ferramentas generativas de IA sobrecarregaram as tentativas de fraude[4][7].

Nunca mais se preocupe com fraudes de IA. TruthScan Pode ajudar-vos:

- Detetar a IA gerada imagens, texto, voz e vídeo.

- Evitar grandes fraudes impulsionadas pela IA.

- Proteja os seus mais sensível activos da empresa.

Os cuidados de saúde são particularmente vulneráveis a esta onda de criminalidade alimentada pela IA. O vasto e fragmentado ecossistema do sector - que abrange hospitais, clínicas, seguradoras, farmácias e plataformas de telessaúde - oferece milhares de pontos de ataque[9][10]. As burlas tradicionais (por exemplo, cartões de seguro falsos ou identificações de doentes roubadas) têm evoluiu para uma exploração sistémica utilizando a IA[10][11]. Em 2025, o Departamento de Justiça dos EUA acusou 324 arguidos de esquemas que totalizavam $14,6 mil milhões em alegações falsas - o maior caso de fraude no sector dos cuidados de saúde de sempre[12][13]. Muitas fraudes envolveram consultas de telemedicina e fraudes em testes genéticos, e um novo relatório do DOJ Centro de Fusão de Dados sobre Fraude no Setor da Saúde utilizou a análise de IA para detetar padrões de forma proactiva[14][15]. É evidente que a IA é uma faca de dois gumes: está a ajudar os investigadores a apanhar fraudes, mas também permitindo que os criminosos cometam fraudes a uma escala e sofisticação sem precedentes[11][2].

Técnicas comuns de fraude impulsionadas por IA nos cuidados de saúde (2025)

Os autores de fraudes em 2025 dispõem de uma caixa de ferramentas com tácticas baseadas em IA para defraudar os sistemas de saúde e as seguradoras. Os principais esquemas incluem a falsificação de identidades e documentos, a geração de dados médicos falsos e a representação de pessoal confiável por meio de deepfakes. Abaixo, detalhamos as técnicas de fraude orientadas por IA mais prevalentes e como elas são usadas contra organizações de saúde:

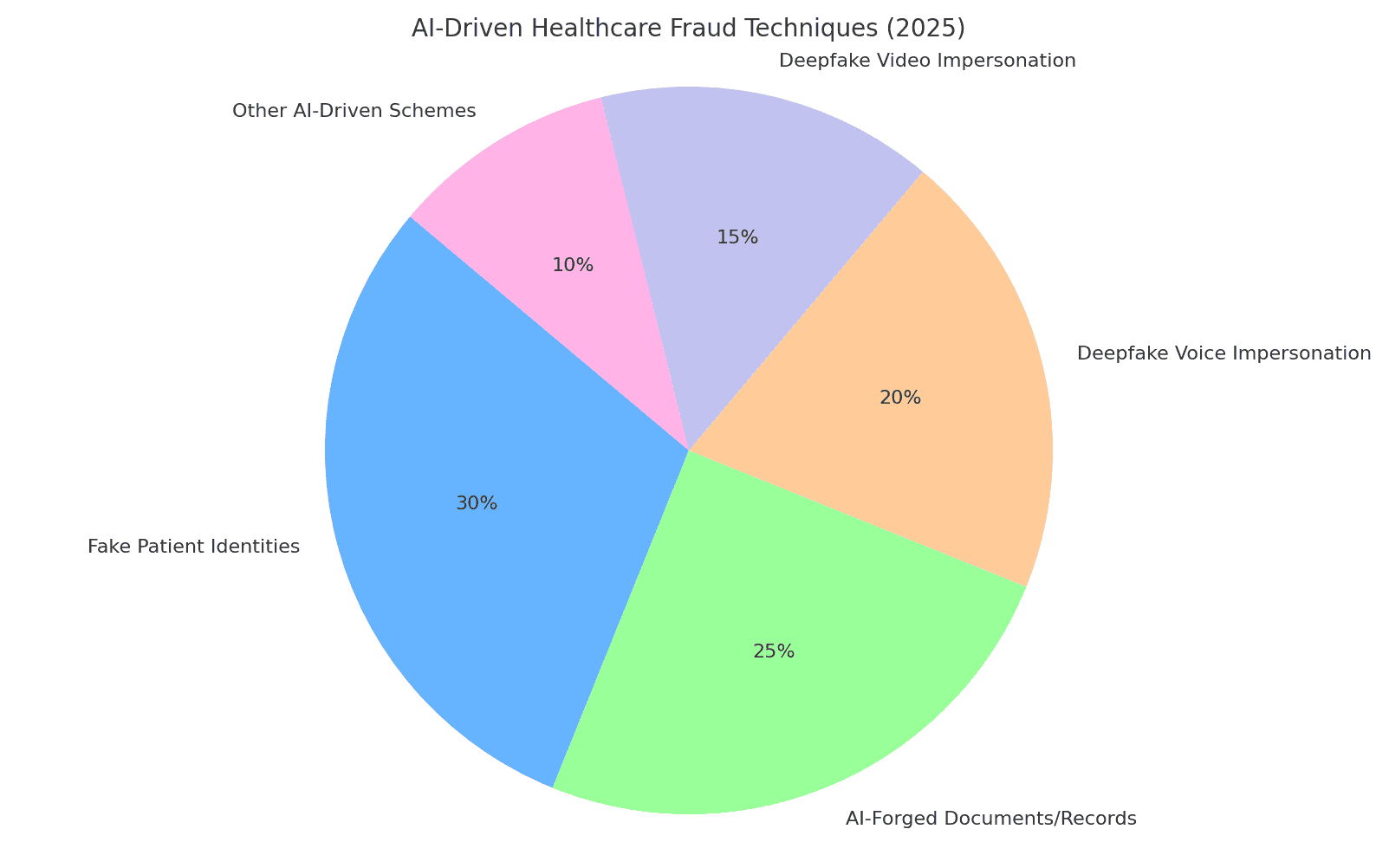

Figura: Repartição das principais técnicas de fraude nos cuidados de saúde baseadas em IA em 2025. Identidades falsas de doentes e Documentos forjados por IA (por exemplo, registos médicos, pedidos de indemnização) constituem uma grande parte dos esquemas, enquanto os esquemas de deepfake voz e imitações em vídeo são uma ameaça em rápido crescimento. "Outros esquemas orientados para a IA" incluem e-mails de phishing criados por IA, bots que atacam portais de pacientes e explorações semelhantes (percentagens estimadas com base em relatórios do sector[8][16]).

Identidades sintéticas dos doentes

Identidades falsas de doentes - frequentemente criadas com a ajuda da IA - são uma tática de fraude fundamental. Em vez de roubar a identidade de uma pessoa, os criminosos combinam dados reais de várias pessoas com pormenores fabricados para criar identidades sintéticas que se fazem passar por novos doentes[17][18]. A IA generativa acelera este processo produzindo registos pessoais realistas. Por exemplo, a IA pode gerar registos pessoais plausíveis Identificações, perfis e até histórias de família ("pais sintéticos") para um doente falso[19][20]. Estes pacientes-fantasma são depois utilizados para abrir contas, obter apólices de seguro ou faturar serviços que nunca ocorreram. Durante a pandemia de COVID-19, os autores de fraudes utilizaram identificações sintéticas para obter benefícios de saúde de emergência; agora utilizam-nas para apresentar falsas declarações de seguro ou obter receitas médicassabendo que uma identidade bem elaborada pode escapar à deteção[21][22]. De acordo com a Reserva Federal dos EUA, as perdas resultantes da fraude de identidade sintética atingiram $35 mil milhões em 2023 e continuam a aumentar[23]. O impacto nos cuidados de saúde é grave: os burlões podem utilizar o número da Segurança Social roubado a uma criança para criar um doente falso com crédito perfeito ou misturar dados roubados de doentes para contornar a verificação da seguradora[17][24]. Cada paciente sintético introduzido no sistema compromete a integridade dos dados e pode levar a pagamentos indevidos ou mesmo erros clínicos se a identidade falsa se misturar com registos médicos reais.

Documentos médicos gerados por IA e pedidos de indemnização de seguros

A IA generativa está agora a ser utilizada para forjar documentos médicos, registos e pedidos de seguro completos. Os modelos linguísticos podem produzir notas médicas de aspeto autêntico, resumos de alta, resultados laboratoriais ou declarações de faturação repletas de jargão médico - tudo feito à medida para apoiar uma queixa fraudulenta. De facto, os observadores do sector relatam um 89% aumento dos documentos médicos gerados por IA em relação aos anos anteriores[25][26]. Os burlões utilizam estes registos falsos para justificar procedimentos ou medicamentos dispendiosos que nunca foram fornecidos, ou para inflacionar os códigos de reembolso. Por exemplo, uma IA pode gerar um registo falso relatório de diagnóstico por imagem ou resultado de laboratório para fundamentar um pedido de indemnização por custos elevados de medicamentos oncológicos. As seguradoras e os sistemas de saúde enfrentam uma avalanche de papelada sintéticatornando mais difícil distinguir os pedidos de indemnização legítimos dos falsos. No Reino Unido, as seguradoras registam um utilização cada vez mais frequente de falsificações profundas e de documentos falsificados na fraude relativa a sinistrosfrequentemente em pedidos de indemnização aparentemente rotineiros e de baixo valor para evitar o controlo[27]. Mesmo a imagiologia clínica não está imune - há provas de que Os autores de fraudes utilizam a IA generativa para imitar imagens médicas como radiografias ou ecografias[3]. As consequências vão para além das perdas financeiras: se os registos médicos falsificados entrarem nos processos dos doentes, podem dar origem a diagnósticos errados ou a tratamentos inadequados. Assim, Os documentos de saúde redigidos por IA representam um grave risco para a integridade e a segurança.

Receitas falsas e fraude farmacêutica

A fraude na prescrição médica entrou na era digital com a IA. Receitas médicas falsificadas - tradicionalmente feitas com blocos de receitas roubados ou edição rudimentar - podem agora ser geradas automaticamente com detalhes realistas e assinaturas de médicos. Os geradores de imagens ou modelos de IA tornam trivial a criação de impressões de receitas electrónicas com aspeto autêntico ou formulários de encomenda de farmácia. Mais insidiosamente, os criminosos utilizam clonagem de voz para se fazerem passar por médicos em chamadas com farmacêuticos. Numa das tendências comunicadas, os burlões invadiram os registos médicos para roubar os números de registo DEA dos médicos e utilizaram essas credenciais para enviar receitas electrónicas de substâncias controladas[28]. Registaram-se casos de Falsificação de voz por IA utilizada para autorizar recargas - um farmacêutico recebe uma chamada que soa exatamente como um médico conhecido a confirmar uma receita, mas na realidade é uma voz gerada por IA. Como resultado, os medicamentos controlados (como opiáceos ou estimulantes) podem ser obtidos e desviados ilegalmente. A fraude de receitas médicas falsas não só causa perdas financeiras às seguradoras e farmácias, como também põe em perigo os doentes, que podem receber medicamentos incorrectos nos seus registos. Por exemplo, se um fraudador se fizer passar por um doente para obter receitas de opiáceos, o o processo médico de um doente real pode ser atualizado com medicamentos que este nunca tomou, o que pode dar origem a interações perigosas ou ser assinalado como um doente que procura drogas[29]. Esta mistura de cibercrime e exploração de IA suscitou avisos dos reguladores. As organizações de cuidados de saúde têm agora de verificar se cada prescrição - especialmente de medicamentos de alto risco - é legítima e verdadeiramente provenientes do fornecedor autorizadonão é um deepfake ou uma violação de dados.

Falsas imitações de médico e paciente

Talvez o desenvolvimento que mais chama a atenção seja a utilização de deepfakes para se fazer passar por profissionais de saúde ou doentes. Em contextos de telemedicina e de serviço ao cliente, os burlões utilizam vídeo e áudio gerados por IA para enganar as pessoas do outro lado. Por exemplo, os criminosos criaram vídeos deepfake de doentes para consultas de tele-saúde, enganando os médicos para que forneçam "tratamento" ou encaminhamentos que são depois facturados aos seguros[30][31]. Por outro lado, um burlão pode falsificar a imagem de um médico - utilizando o rosto e a voz de um médico respeitável - numa videochamada para convencer um doente a pagar um serviço fraudulento ou a divulgar informações pessoais. Os especialistas em TI no sector da saúde alertam para o facto de a tele-saúde tornou-se um alvo fácil: é possível marcar uma consulta virtual utilizando uma identidade de doente falsa e, em seguida, fazer com que um avatar de IA assista ao vídeo para obter receitas ou conselhos médicos sob falsos pretextos[31][32]. Para além da telemedicina, os deepfakes estão a saturar as redes sociais sob a forma de vídeos de "médicos" que promovem curas milagrosas. Em 2024, os peritos observaram que os vídeos falsos de médicos famosos "realmente decolou," dirigida a públicos mais velhos com falsas dicas de saúde e produtos fraudulentos[33][34]. Médicos de confiança da televisão no Reino Unido e em França viram as suas imagens clonadas para promoverem falsas curas para a diabetes e suplementos para a tensão arterial[35][36]. Até metade dos telespectadores não conseguiu perceber que estes vídeos médicos deepfake eram falsos[37]. Esta erosão da verdade tem custos tangíveis: os doentes podem seguir conselhos prejudiciais de um vídeo falso de um médico, ou os burlões podem faturar às seguradoras consultas que nunca aconteceram, exceto como uma gravação deepfake. No total, A falsificação de identidade baseada na IA mina a confiança fundamental nas interações com os cuidados de saúde - se não pudermos confiar que a pessoa no ecrã ou no telefone é quem diz ser, todo o sistema está em risco.

Impacto e escala: a fraude de 2025 em números

A fraude baseada em IA já não é uma questão marginal - é agora um grande sorvedouro financeiro e uma ameaça à segurança nos sistemas de saúde mundiais. Considere as seguintes estatísticas e casos recentes que ilustram a dimensão do problema:

- Perdas anuais: Estima-se que a fraude no sector da saúde custe aos EUA $68 mil milhões de euros ou mais por ano[25], aproximadamente 3-10% de todas as despesas de saúde[38]. A nível mundial, a fraude pode consumir cerca de 6% das despesas de saúde[39] - um valor surpreendente, tendo em conta que as despesas de saúde a nível mundial ascendem a biliões de dólares. Estas perdas traduzem-se, em última análise, em prémios mais elevados, aumento dos custos hospitalares e redução dos recursos destinados aos cuidados dos doentes.

- Aumento da fraude em 2023-2025: O advento da IA generativa conduziu a uma explosão de tentativas de fraude. Os incidentes de fraude relacionados com o Deepfake aumentaram dez vezes mais de 2022 a 2023[4]. Em 2024, os incidentes de deepfake registados aumentaram para 150 (um aumento de 257%)[40]e 2025 está em vias de ultrapassar largamente esse valor (580 incidentes só no primeiro semestre de 2025, quase 4 vezes o total de 2024)[7]. Os peritos em fraudes observam que 46% depararam-se com fraudes de identificação sintética, 37% com falsificações de voz e 29% com falsificações de vídeo nas suas investigações[8] - que mostra como estas técnicas de IA se tornaram comuns.

- Recordes de derrubadas: As agências de aplicação da lei estão a responder com maiores medidas de repressão. Em junho de 2025, o DOJ dos EUA anunciou a a maior apreensão de fraudes no sector da saúde da história, acusando 324 indivíduos e descobrindo $14,6 mil milhões em pedidos fraudulentos[1][13]. Os esquemas incluíam golpes de consultas de telessaúde, fraudes em testes genéticos e fraudes com equipamentos médicos duráveis em grande escala[13]. Como parte deste esforço, o Medicare suspendeu $4 mil milhões em pagamentos pendentes considerado suspeito[41]e evitar essas perdas. Um caso fundamental ("Operação Gold Rush") revelou uma rede internacional que utilizava identidades roubadas para registar $10,6 mil milhões de euros em falsos pedidos de indemnização por fornecimentos médicos[42] - uma prova de até onde os criminosos vão quando armados com dados violados e automação.

- Impactos nas seguradoras: As seguradoras de todo o mundo estão a assistir a um aumento da fraude relacionada com a IA. No Reino Unido, as seguradoras referem que as falsificações profundas são cada vez mais utilizadas nos sinistros (frequentemente sinistros de "baixo contacto" para evitar a deteção)[27]. Uma importante empresa de resseguros alerta para o facto de os registos médicos falsificados e as condições de saúde falsas estarem a prejudicar a subscrição de seguros e poderem fazer aumentar as perdas nos seguros de vida e de saúde[43]. Uma análise da Deloitte de 2024 previa que até 2027, A fraude gerada pela IA poderá representar $40 mil milhões de perdas anuais nos EUA. (a partir de $12,3 mil milhões em 2023)[8]. Esta trajetória implica um impacto significativo nos resultados das seguradoras se não forem adoptadas medidas sólidas de combate.

- Vítimas doentes: Os doentes e o público também estão a perder dinheiro com estas fraudes. Os adultos mais velhos, em particular, têm sido alvo de golpes de voz de IA (chamadas telefónicas para "netos em perigo") e de golpes de saúde deepfake. Em 2023, os idosos dos EUA comunicaram $3,4 mil milhões em perdas por fraude, um aumento de 11% em relação ao ano anterior[44][45] - alguns dos quais são impulsionados por esquemas melhorados pela IA. E para além do custo monetário, há um custo humanoAconselhamento médico fraudulento e tratamentos falsos publicitados através da IA podem provocar danos físicos ou a perda de confiança em orientações de saúde legítimas.

De um modo geral, 2025 deixou claro que A IA está a turbinar a fraude tradicional nos cuidados de saúde. O que costumava ser esquemas mais pequenos e oportunistas transformou-se em operações industrializadas que abrangem continentes. A combinação de grandes volumes de dados (muitas vezes provenientes de violações) e a geração de IA significa que os esquemas podem ser implementados com uma velocidade e plausibilidade assustadoras. As perdas globais são da ordem das dezenas de milhares de milhões e estão a aumentarA indústria está a perder tempo, e todas as partes interessadas - desde hospitais e seguradoras a doentes - estão em risco. A próxima secção aborda a forma como a indústria pode ripostar utilizando tecnologias e estratégias igualmente avançadas.

Defesa contra a fraude baseada em IA: Estratégias e soluções

Enfrentar a fraude nos cuidados de saúde com recurso à IA requer um arsenal de defesas igualmente avançadas. Os executivos do sector da saúde, as equipas de cibersegurança, os responsáveis pela conformidade e as seguradoras devem coordenar-se para adotar medidas antifraude em todos os pontos vulneráveis - desde a integração do paciente até ao pagamento dos sinistros. Abaixo estão as principais estratégias e soluções técnicas para combater a fraude impulsionada por IA:

- Ferramentas de deteção de conteúdos com IA: Tal como os criminosos utilizam a IA para fabricar conteúdos, as organizações podem utilizar a IA para os detetar. Avançada Detectores de conteúdos escritos por IA (como o conjunto do TruthScan) analisam texto, imagens, áudio e vídeo para identificar sinais reveladores de geração de IA. Por exemplo, a plataforma do TruthScan aplica a aprendizagem automática para detetar os padrões estatísticos e as peculiaridades linguísticas que indicam texto gerado por IA com mais de Precisão 99%[46][47]. Estas ferramentas podem ser integradas em sistemas de gestão de pedidos de indemnização ou registos de saúde electrónicos para assinalar automaticamente documentos suspeitos - por exemplo, um relatório médico que foi provavelmente escrito por ChatGPT - para revisão manual. Do mesmo modo, a análise forense de imagens com IA pode detetar exames médicos manipulados ou identificações falsas, e os algoritmos de deteção de deepfake podem analisar vídeos para detetar sinais de síntese (artefactos em pixéis, tempo estranho de movimentos faciais, etc.)[48][49]. Ao implementar detectores de IA multimodais, as organizações de saúde podem filtrar uma grande parte dos conteúdos forjados por IA em tempo real antes de causar danos.

- Registo médico e verificação de documentos: Os prestadores de cuidados de saúde estão a recorrer a soluções especializadas para verificar a autenticidade dos registos e documentos de sinistros. Isto inclui o hashing e a assinatura digital de registos legítimos, bem como a utilização de bases de dados de modelos de documentos conhecidos como bons para comparar com as submissões. Os serviços de verificação baseados em IA (por exemplo, o TruthScan's Autenticação de documentos médicos pode analisar instantaneamente o conteúdo e os metadados de um documento para determinar se este foi gerado ou alterado por uma máquina[50][51]. Procuram incoerências que um humano poderia não detetar, como anomalias subtis de formatação ou metadados que indiquem que uma imagem foi produzida por IA. Monitorização em tempo real dos registos dos doentes e dos pedidos de indemnização dos seguros para detetar anomalias também é essencial[52]. Ao analisar continuamente as novas entradas (resultados de laboratório, notas médicas, anexos de pedidos de indemnização), estes sistemas podem detetar registos falsos antes de que conduzam a pagamentos fraudulentos ou a erros clínicos. Algumas seguradoras implementaram regras segundo as quais qualquer documentação de sinistro identificada como gerada por IA é automaticamente retirada para investigação de fraude. O objetivo é garantir que todos os registos médicos ou pedidos de reembolso que entram no fluxo de trabalho são fiáveis e inalterados.

- Comprovação e validação da identidade: O reforço da verificação da identidade é fundamental na era das identificações sintéticas. As entidades do sector da saúde devem aplicar prova de identidade rigorosa para novos pacientes, prestadores de serviços e fornecedores. Isto pode envolver a autenticação multifactor, verificações biométricas (como o reconhecimento facial ou impressões digitais no registo) e a utilização de serviços de verificação de identidade que utilizam a IA para detetar Identificações falsas ou dados pessoais incorrectos. Por exemplo, o reconhecimento facial pode ser combinado com testes de vivacidade para evitar que um rosto gerado por IA se faça passar por um doente real através de uma fotografia. Na retaguarda, os algoritmos podem verificar os dados de um doente (morada, telefone, correio eletrónico, presença nas redes sociais) para detetar identidades "finas" que não têm um historial normal - um indício conhecido de identificações sintéticas[53]. As instituições financeiras têm utilizado com grande eficácia esses controlos de consistência de antecedentes baseados em IA[54]Os serviços de saúde podem fazer o mesmo: por exemplo, assinalar um novo requerente do Medicare se não tiver uma pegada digital anterior a este ano. Validação de identidades de fornecedores é igualmente importante - garantir que o médico num vídeo de tele-saúde está licenciado e é efetivamente quem afirma ser, talvez através da emissão de certificados digitais ou de feeds de vídeo com marca de água que são difíceis de imitar por deepfakes. Nas farmácias, o pessoal deve verificar novamente os pedidos de prescrição invulgares através de chamadas diretas para os prestadores de serviços e utilizar frases de código ou perguntas de verificação para derrotar os possíveis impostores de voz com IA.

- Deteção integrada de fraudes em fluxos de trabalho: Para proteger verdadeiramente o sistema, a deteção de fraudes não pode ser um passo isolado - tem de ser integrado em todos os fluxos de trabalho numa organização de saúde.

Na prática, isto significa que os hospitais e as seguradoras estão a implementar integrações de API para chamar serviços de deteção de fraudes em momentos críticos. Por exemplo, quando um provedor envia um pedido de reembolso com documentos anexados, um serviço de IA pode avaliar automaticamente a autenticidade desses anexos em segundos. Se uma consulta de telessaúde for iniciada, a plataforma pode executar uma análise de voz passiva em segundo plano para garantir que o chamador não esteja usando uma voz sintetizada. Controlo contínuo também é fundamental: as plataformas modernas de combate à fraude oferecem painéis de controlo que acompanham os sinais de fraude em toda a organização (validações falhadas, sinalização frequente dos pedidos de uma determinada clínica, etc.) para identificar padrões, tais como uma rede de fraude organizada que opera em vários pedidos. Ao tratar a fraude nos cuidados de saúde de forma mais semelhante às ciberameaças - com Monitorização 24 horas por dia, 7 dias por semana, deteção de anomalias e resposta rápida a incidentes - as organizações podem detetar os problemas antes que se agravem[55].

- IA para análise de fraudes e reconhecimento de padrões: O volume de dados sobre cuidados de saúde é tão grande que a IA é indispensável para encontrar padrões de fraude que os humanos não detectam. Os modelos de aprendizagem automática podem ser treinados em casos de fraude históricos para detetar novos casos (por exemplo, agrupamento de pedidos de reembolso com códigos ICD invulgares semelhantes ou identificação de desvios significativos na faturação de um médico em relação aos seus pares). As seguradoras já estão a utilizar a análise preditiva para classificar os pedidos de indemnização em função do risco de fraude em tempo real. Técnicas emergentes como as redes neurais gráficas podem mapear as relações entre pacientes, fornecedores, diagnósticos e pedidos de indemnização para detetar ligações improváveis (como o mesmo número de série de dispositivo utilizado em pedidos de indemnização de diferentes estados). O conjunto de fraudes de seguros do TruthScan, por exemplo, inclui reconhecimento de padrões de reclamações e modelação preditiva para detetar redes de fraude organizadas e padrões atípicos antes que as perdas se acumulem[56][57]. O Centro de Fusão do DOJ de 2025 exemplificou esta abordagem - agregando dados do Medicare e de seguradoras privadas para encontrar proactivamente grupos de actividades suspeitas[58]. As organizações de saúde devem igualmente partilhar dados e modelos de IA em consórcios para alargar os sinais de fraude que cada um pode detetar. Quanto mais dados (dentro dos limites da privacidade) alimentarem estes modelos, melhor se tornarão a discernir o comportamento normal do comportamento fraudulento.

- Formação do pessoal e controlo dos processos: A tecnologia é crucial, mas a consciencialização humana continua a ser uma defesa poderosa. O pessoal de saúde e os administradores devem receber formação sobre tácticas de fraude baseadas em IA - por exemplo, saber que um uma mensagem eletrónica perfeitamente escrita por um diretor executivo pode ser um phishing criado por IAou que devem verificar a identidade dos autores de videochamadas se algo parecer "estranho" (movimentos oculares estranhos ou desfasamento de áudio podem indiciar um deepfake). Podem ser implementados exercícios e dicas regulares (semelhantes à formação de sensibilização para o phishing) para novas ameaças, como as fraudes telefónicas de deepfake. Os controlos de processo simples acrescentam camadas de segurança: exigir chamadas de retorno ou verificação secundária para pedidos de pagamento grandes ou invulgares, utilizar canais de comunicação seguros conhecidos para informações sensíveis e manter um plano de resposta a incidentes especificamente para suspeitas de fraude mediada por IA. É importante que as organizações cultivem uma cultura em que os trabalhadores sentem-se habilitados a questionar anomaliasMesmo que se trate de um "médico" em vídeo a fazer um pedido estranho. Muitos esquemas de deepfake são bem sucedidos explorando a confiança e a autoridade; uma força de trabalho vigilante que conheça estes truques pode impedir os incidentes numa fase inicial. Como observou um especialista, confrontar os deepfakes pode tornar-se tão rotineiro como detetar e-mails de phishing - uma parte normal da higiene da cibersegurança[32][59].

- Aproveitamento de serviços especializados: Dada a rápida evolução das ameaças de IA, muitas organizações de cuidados de saúde estabelecem parcerias com fornecedores especializados em prevenção de fraudes. Serviços como TruthScan para cuidados de saúde oferecem soluções completas adaptadas a casos de utilização médica, incluindo: monitorização em tempo real da integridade dos registos médicos electrónicos (EMR), verificação de documentos do doente contra a manipulação da IA, a deteção de falsificações profundas (deepfake) para a telessaúde e os relatórios de conformidade (por exemplo, pistas de auditoria que provam a devida diligência na deteção de fraudes para os reguladores)[60][51]. Estas plataformas fornecem frequentemente Integração da API para uma integração perfeita nos sistemas existentes e são concebidos para cumprir os regulamentos relativos aos cuidados de saúde (HIPAA, GDPR)[61][62]. Ao utilizar ferramentas de nível empresarial, mesmo as clínicas mais pequenas ou as seguradoras regionais podem ter acesso a capacidades avançadas de deteção de IA sem as desenvolverem internamente. Além disso, as seguradoras e os fornecedores devem estar atentos às actualizações dos regulamentos e das normas da indústria - por exemplo, novas leis contra a fraude deepfake (algumas jurisdições proíbem agora explicitamente as deepfakes médicas, e os EUA estão a expandir os estatutos de roubo de identidade para abranger a imitação de IA[63]). O alinhamento com essas normas e a utilização de ferramentas de ponta não só reduzirão as perdas por fraude, como também demonstrarão uma forte postura de segurança aos parceiros, auditores e pacientes.

Conclusão e perspectivas

O ano de 2025 demonstrou que a o génio saiu da garrafa - A IA generativa e a automatização estão agora interligadas com a fraude no sector da saúde. No futuro, é provável que os autores de fraudes continuem a inovar: podemos ver modelos de IA que aprendem a imitar estilos de escrita de médicos específicos ou deepfakes que reagem em tempo real a perguntas desafiantes. A batalha será uma corrida ao armamento contínua. No entanto, o sector dos cuidados de saúde está a responder com igual vigor, investindo em defesas baseadas em IA e em fluxos de trabalho de segurança mais rigorosos. Ao combinar tecnologia de deteção de ponta, processos de verificação rigorosos, partilha de dados entre sectores e vigilância dos trabalhadoresSe o sistema de saúde não for capaz de responder à ameaça de fraude facilitada pela IA, as organizações de saúde podem mitigar substancialmente essa ameaça.

Crucialmente, não se trata apenas de uma questão de TI - é uma questão de governação e de confiança. Os conselhos de administração e os executivos do sector da saúde têm de reconhecer a fraude com IA como um risco estratégico para as finanças e para a confiança dos doentes, que merece atenção e recursos regulares. As equipas de conformidade devem atualizar as avaliações de risco de fraude para incluir aspectos de IA, e as seguradoras podem repensar os pressupostos de subscrição, sabendo que uma certa percentagem de reclamações pode ser fraude assistida por IA. Por outro lado, a utilização ética da IA nos cuidados de saúde (para apoio à decisão clínica, eficiência da faturação, etc.) continuará a trazer grandes benefícios - desde que existam salvaguardas sólidas para evitar abusos.

Em resumo, a IA generativa mudou o jogo da fraude nos cuidados de saúde, mas com sensibilização e contramedidas avançadas, não tem de sobrecarregar o sistema. As organizações bem-sucedidas serão aquelas que se mantiverem informadas sobre as ameaças emergentes, se adaptarem rapidamente com defesas baseadas em IA e promoverem uma cultura de "verificar e confiar" em vez de "confiar por padrão". Ao fazê-lo, os cuidados de saúde podem aproveitar com segurança os aspectos positivos da IA e, ao mesmo tempo, neutralizar a sua má utilização, protegendo tanto os resultados como o bem-estar dos doentes na era digital.

Fontes: Relatórios e casos recentes do sector, tal como acima referidos, incluindo Pymnts (julho de 2025)[2][3], Instituto Swiss Re (junho de 2025)[27], Banco da Reserva Federal de Boston (abril de 2025)[19], BMJ (2024)[37]e resumos de soluções TruthScan (2025)[51][64], entre outros. Todos os dados e citações reflectem os mais recentes disponíveis em 2024-2025, ilustrando o estado atual da fraude impulsionada pela IA nos cuidados de saúde e as respostas para a combater.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] DOJ dá crédito às ferramentas de IA na repressão histórica da fraude nos cuidados de saúde

[4] [5] [6] [7] [16] [40] [44] [45] Estatísticas e tendências do Deepfake 2025 | Principais dados e percepções - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes e a crise do conhecimento | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] A geração IA está a aumentar a ameaça de fraude de identidade sintética - Federal Reserve Bank of Boston

[25] [26] [56] [57] [62] [64] Deteção de fraude por IA em seguros de saúde e de vida | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Como os deepfakes, a desinformação e a IA amplificam a fraude de seguros | Swiss Re

[28] DEA alerta para fraude na prescrição eletrónica - Pharmacy Practice News

[29] [39] Cibersegurança e fraude nos cuidados de saúde: Um mergulho profundo nos maiores riscos e defesas da atualidade | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] A ameaça evolutiva dos esquemas de telemedicina Deepfake, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Especialistas alertam para o facto de os burlões usarem "deepfakes" de médicos famosos nas redes sociais

[35] [36] [37] Médicos de confiança da TV "falsificaram" para promover esquemas de saúde nas redes sociais - BMJ Group

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] estado atual da investigação Ajit Appari e M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - Deteção de IA empresarial e segurança de conteúdos

[50] [51] [52] [60] [61] Deteção de fraude em registros médicos por IA | Soluções CRO para o setor de saúde | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Quão perigosos são os Deepfakes e outras fraudes com recurso a IA?