A fraude no sector dos seguros está a entrar numa nova era impulsionada pela inteligência artificial. Anéis de fraude sofisticados e golpistas solitários estão a explorar ferramentas de IA generativas para produzir reivindicações falsas, identidades sintéticas, provas falsas e esquemas de personificação altamente convincentes. Este whitepaper examina as mais recentes tendências da fraude de seguros baseada em IA - desde sinistros e documentos gerados por IA até fraudes de voz falsa - e descreve como as seguradoras podem responder. Apresentamos dados recentes, casos do mundo real e insights estratégicos para subscritores, investigadores de fraude, equipes de segurança cibernética, gerentes de sinistros e líderes C-suite que precisam entender esse cenário de ameaças em rápida evolução.

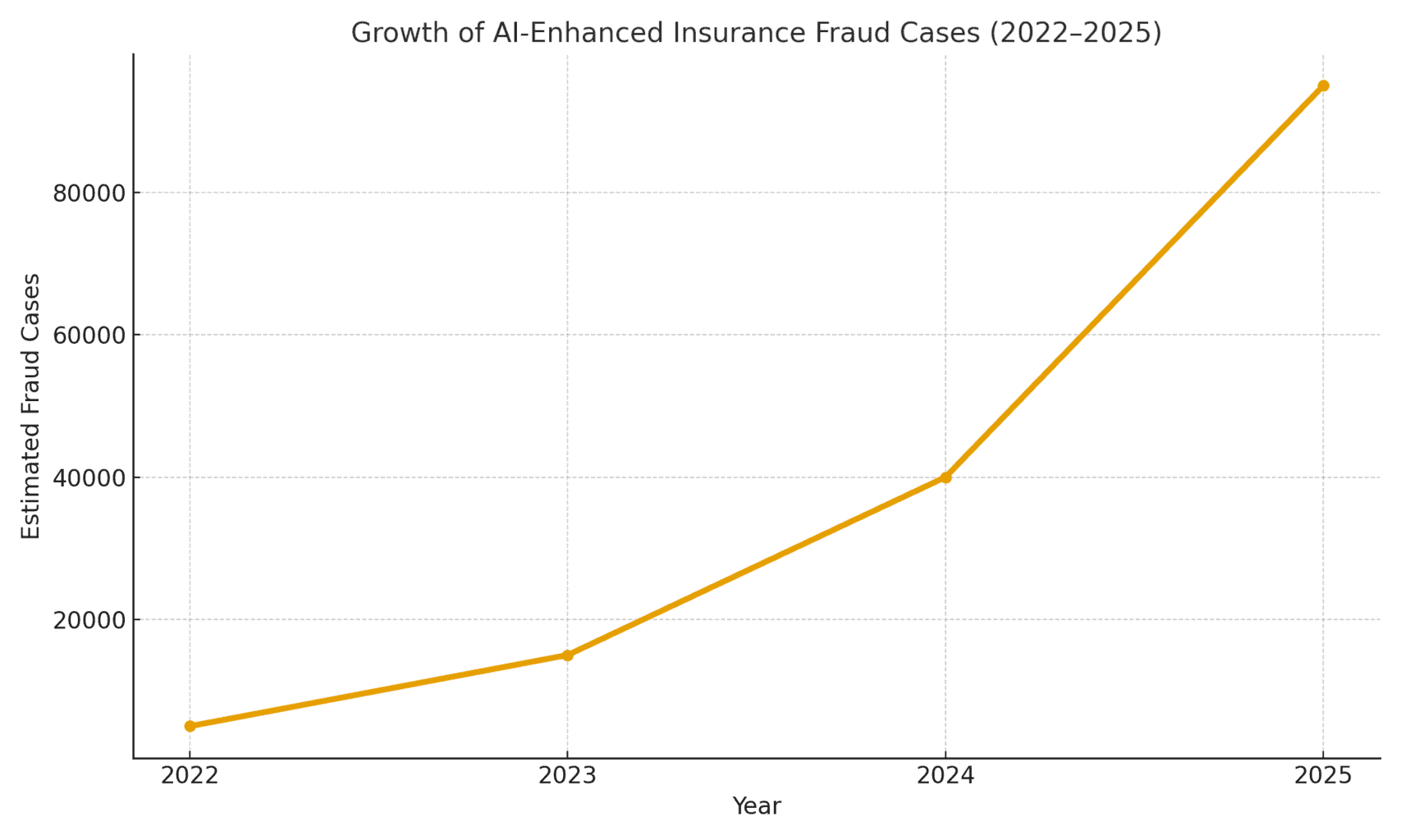

A dimensão da ameaça: A fraude possibilitada pela IA está a aumentar. Um relatório de contabilidade forense de 2025 concluiu que As fraudes baseadas em IA representam atualmente mais de metade de todas as fraudes financeiras digitais[1]. No sector dos seguros, especificamente, a empresa de segurança vocal Pindrop observou um 475% aumento dos ataques de fraude de voz sintética nas companhias de seguros em 2024contribuindo para um aumento anual de 19% das tentativas globais de fraude no sector dos seguros[2]. As seguradoras enfrentam cerca de Exposição à fraude 20 vezes maior do que a dos bancosdevido, em parte, à forte dependência de documentos, imagens e verificações vocais nos pedidos de indemnização[3]. A Figura 1 abaixo ilustra o crescimento explosivo de incidentes de fraude de seguros com IA de 2022 a 2025, já que vários relatórios do setor indicaram aumentos percentuais de três ou quatro dígitos ano a ano no envolvimento de IA detectado em fraudes.

Figura 1: Aumento rápido de casos de fraude de seguros com IA (crescimento indexado 2022-2025). Os dados do setor indicam aumentos exponenciais no conteúdo gerado por IA encontrado em reivindicações fraudulentas, especialmente desde 2023.[4][2]

Alegações geradas por IA e provas falsas

Uma das tendências mais prevalecentes é a utilização de IA generativa para criar pedidos de indemnização de seguros totalmente falsos. Com geradores de texto de IA avançados, os autores de fraudes podem escrever descrições realistas de incidentes, relatórios médicos ou declarações policiais com um simples clique num botão. Estas narrativas escritas por IA são frequentemente lidas como polidas e plausíveis, tornando mais difícil para os avaliadores detetar inconsistências. Por exemplo, os burlões utilizaram o ChatGPT para redigir descrições detalhadas de acidentes ou relatórios de ferimentos que soam profissionais e convincentes - uma tarefa que, em tempos, exigia um esforço significativo e capacidade de escrita.

Mais preocupante é o facto de os criminosos associarem agora estas narrativas falsas a Provas de apoio geradas por IA. Os modelos de geração de imagens (como Midjourney ou DALL-E) e as ferramentas de edição podem produzir fotografias fotorrealistas de danos e ferimentos. De acordo com relatórios do sector, alguns condutores começaram a apresentação de imagens geradas por IA para exagerar os danos do veículo em sinistros automóveis[5]. A IA generativa pode criar uma fotografia de um carro destruído ou de uma casa inundada que nunca existiu de facto. Estas imagens são frequentemente mais realistas do que as técnicas antigas do Photoshop conseguiam alcançar[6]tornando-os difíceis de detetar a olho nu. Em abril de 2025, a Zurich Insurance registou um aumento dos sinistros com facturas falsificadas, estimativas de reparação fabricadas e fotografias alteradas digitalmente, incluindo os casos em que os números de registo de veículos foram inseridos por IA em imagens de carros recuperados[7][8]. Estas provas falsas, quando combinadas com um formulário de pedido de indemnização bem elaborado por uma IA, podem passar despercebidas nas revisões manuais.

Um caso notável no Reino Unido envolveu burlões que roubaram um fotografia nas redes sociais de uma carrinha de um comerciante e utilizar a IA para adicionar um para-choques rachadoe depois apresentá-la juntamente com uma fatura de reparação falsa no valor de 1000 libras como parte de um falso pedido de indemnização por acidente[9]. O esquema só foi descoberto quando os investigadores repararam que o mesmo fotografia da carrinha (antes dos danos) na página do Facebook do proprietário[10]. Este facto ilustra um fenómeno mais amplo: as seguradoras comunicam um 300% salto nas edições de imagens "shallowfake (manipulações digitais simples para acrescentar danos ou alterar pormenores) em apenas um ano (2021-2022 vs 2022-2023)[4]. A Allianz UK alertou em 2024 para o facto de as distorções de fotografias digitais e os documentos falsos terem "todos os sinais de se tornarem a última grande burla a atingir o sector"[4]. O diretor de fraude de sinistros da Zurich observou igualmente que o que antes exigia a encenação de um acidente de viação físico pode agora ser feito inteiramente atrás de um computador - os burlões podem "criar um pedido de indemnização fraudulento a partir do seu teclado e extrair somas significativas" com fotografias e relatórios de perda total falsos[11][12]. Esta mudança não só aumenta o volume de pedidos de indemnização falsos, como também reduz a barreira à entrada de potenciais autores de fraudes.

Nunca mais se preocupe com fraudes de IA. TruthScan Pode ajudar-vos:

- Detetar a IA gerada imagens, texto, voz e vídeo.

- Evitar grandes fraudes impulsionadas pela IA.

- Proteja os seus mais sensível activos da empresa.

Para além dos automóveis, sinistros de bens e acidentes estão a assistir a uma inflação de perdas assistida por IA. Há relatos de fotografias falsas para seguros de viagem (por exemplo, "danos" na bagagem ou cenas de roubo encenadas) e recibos gerados por IA para artigos caros que nunca foram comprados. Sinistros de vida e saúde também não estão imunes - os autores de fraudes criaram falsos facturas médicas e certidões de óbito utilizando falsificadores de documentos com IA. De facto, a Zurich constatou que a tecnologia deepfake estava a ser utilizada para criar avaliações de engenheiros e relatórios médicos inteiramente fictícios nos pacotes de reclamações[11]. Estes documentos gerados por IA, muitas vezes completos com logótipos e assinaturas realistas, podem ser indistinguíveis da documentação genuína. Uma preocupação emergente para as seguradoras de vida é fraude nos obituários e nas certidões de óbitoOs criminosos podem utilizar a IA para produzir obituários falsos ou cartas de médicos para apoiar um pedido de indemnização por morte de alguém que na realidade ainda está vivo (ou que nunca existiu, como se verá a seguir).

Tomadores de seguros e identidades sintéticas

Talvez o desenvolvimento mais insidioso seja fraude de identidade sintética nos seguros. A fraude de identidade sintética envolve a criação de uma pessoa ou entidade fictícia, combinando dados reais (números roubados da Segurança Social, endereços, etc.) com detalhes fabricados (nomes falsos, documentos de identificação falsos). Os avanços na IA tornaram trivialmente fácil gerar perfis pessoais realistas - incluindo fotografias e IDs - para pessoas que não existem[13][14]. Os autores de fraudes podem agora produzir algoritmicamente um cliente completamente falso, comprar uma apólice em seu nome e, mais tarde, apresentar pedidos de indemnização ou benefícios da apólice para essa identidade falsa.

No sector dos seguros de vida, os sistemas de identidade sintética têm disparou. A investigação do sector em 2025 estima que os custos da fraude de identidade sintética mais de $30 mil milhões por ano, representando cerca de 80-85% de todos os casos de fraude de identidade em todos os serviços financeiros[15][16]. As seguradoras de vida foram particularmente afectadas: os vigaristas são conhecidos por obter apólices de seguro de vida para uma pessoa fictícia e depois "matar" essa pessoa no papel para receber o subsídio por morte[17]. Por exemplo, um burlão pode criar um cliente sintético "John Doe", pagar prémios durante um ano e, em seguida, apresentar um pedido de indemnização com uma certidão de óbito e um obituário falsos para a morte prematura de John Doe. Uma vez que a identidade foi cuidadosamente construída (historial de crédito, registos públicos, etc.), o pedido de indemnização por morte pode parecer legítimo - até não ser encontrado qualquer corpo ou familiares reais. Quando a fraude é descoberta, os autores já se foram embora com o pagamento.

Os esquemas de identidade sintética também afectam seguro de saúde e seguro automóvel. As redes criminosas criam identidades "Frankenstein" através de utilizando números de Segurança Social de crianças ou idosos (que não têm historial de crédito) combinados com nomes e cartas de condução gerados por IA[15]. Em seguida compram apólices de saúde ou apólices de seguro automóvel para esses indivíduos falsos e, pouco depois, apresentam pedidos de indemnização elevados. Uma variante é a criação de sindicatos empresas falsas (empresas de fachada) - por exemplo, uma empresa de camionagem fictícia - e a subscrição de um seguro comercial para a mesma, apenas para mais tarde reclamar acidentes encenados ou ferimentos de empregados fantasma[18][19]. Uma vez que a empresa existe apenas no papel (com registos comerciais e identificações fiscais gerados por IA), este "fraude sintética "baseada em entidades muitas vezes só é descoberto após o pagamento dos sinistros[18][20].

Porque é que as identidades sintéticas são tão eficazes? Por um lado, passam frequentemente por controlos automatizados de verificação de identidade. As agências de crédito e os sistemas KYC podem encontrar sem sinais de alerta porque a identidade inclui alguns dados reais e válidos (por exemplo, um SSN real com um registo limpo)[21]. Entretanto, as fotografias de perfil e as digitalizações de identificação geradas pela IA podem parecer completamente autênticas - a IA atual pode produzir um rosto humano que até o reconhecimento facial avançado pode aceitar como real. O resultado: a maioria dos sistemas automatizados reconhece estes perfis como legítimos e a fraude só é detectada (se é que é detectada) depois de grandes perdas[22].

Impacto no mundo real: A RGA refere que a fraude de identidade sintética nos seguros de vida custa atualmente ao sector cerca de $30B por ano e cresceu quase 400% desde 2020[15][16]. A Comissão Federal do Comércio dos EUA estima que as identificações sintéticas constituem a grande maioria dos incidentes de fraude de identidade[16]. Estas perdas acabam por afetar as carteiras dos tomadores de seguros honestos - estima-se que cada família pague mais \$700 em prémios todos os anos devido à maior carga de fraude que recai sobre as seguradoras[15]. As seguradoras estão a reagir reforçando a verificação na integração e nos pedidos de indemnização: implementando verificações da base de dados para ligação da identidade, monitorizando a existência de várias apólices no mesmo endereço e até realizando testes de "vivacidade" (verificações de vídeo selfie para garantir que um requerente é uma pessoa real e não apenas uma imagem de IA)[23][24]. Mas, como veremos, os autores de fraudes estão a contra-atacar com IA na próxima arena: vozes e vídeos deepfake.

Vozes e alegações de vídeo Deepfake

Gerado por IA deepfakes de áudio e vídeo acrescentam uma nova e alarmante dimensão à fraude no sector dos seguros. Em 2023 e 2024, registaram-se vários incidentes de criminosos que utilizaram clonagem de voz para se fazerem passar por pessoas ao telefone - uma tática originalmente utilizada em assaltos a bancos (como a infame chamada telefónica do CEO "deepfake" que roubou $35 milhões em 2020), mas que agora se está a estender aos seguros. Os autores de fraudes estão a clonar as vozes de segurados, médicos ou reguladores de sinistros e a utilizá-las em esquemas de engenharia social. A análise da Pindrop de 2024 alertou para o facto de "deepfakes, tecnologia de voz sintética e fraudes baseadas em IA estão a remodelar o panorama da fraude", com fraude vocal escalonamento a um ritmo sem precedentes[25]. Descobriram que os centros de atendimento de seguros eram bombardeados por maus actores estrangeiros que utilizavam falsificações de voz: por exemplo, as chamadas eram recebidas com o SSN e os dados pessoais roubados de um tomador de seguro real e, se um agente atendesse, o a voz clonada pela IA do autor da chamada pode enganar o agente através da autenticação baseada no conhecimento e solicitar um desembolso fraudulento[26]. No caso de uma seguradora da Costa Oeste, os atacantes utilizaram repetidamente este método para tentar assumir o controlo das contas e redirecionar os pagamentos, explorando o facto de a verificação da identificação do centro de atendimento telefónico se basear na voz e em informações pessoais que podem ser falsificadas[26].

A imitação de voz também tem sido utilizada pelo consumidor: Os burlões telefonaram a vítimas de acidentes ou a beneficiários enquanto fazer-se passar por representantes de segurosO fraudador pode, por exemplo, usar vozes de IA para parecer oficial, a fim de obter informações sensíveis ou mesmo pagamentos. Por outro lado, um fraudador pode fazer-se passar por um cliente numa linha direta de reclamações para apresentar uma reclamação por telefone utilizando uma voz falsa que corresponde ao sexo/idade do clientecontornando assim os controlos biométricos por voz. As estatísticas recentes sobre fraude são preocupantes: os peritos do sector prevêem um aumento de 162% crescimento dos ataques de fraude deepfake contra seguradoras no próximo ano[27]e o Pindrop registou um 475% pico de ataques de voz sintética em 2024 como mencionado anteriormente[2]. Estes ataques estão a ultrapassar rapidamente os vectores de fraude cibernética mais tradicionais.

Para além das chamadas telefónicas, deepfakes baseados em vídeo estão a surgir no processo de sinistros. Muitas seguradoras adoptaram as inspecções virtuais de sinistros e a videoconferência (acelerada pela pandemia), para verificar as perdas ou entrevistar os sinistrados à distância. Agora, os autores de fraudes estão a utilizando avatares de IA e vídeos deepfake para enganar estas verificações. Houve relatos de requerentes que utilizaram Avatares gerados por IA em chamadas de vídeo em direto com ajustadores, para se fazer passar por outra pessoa ou para ocultar sinais de incoerência[28]. Por exemplo, uma rede de fraude pode utilizar um deepfake vídeo "em direto" de um suposto requerente a mostrar os seus danos através de um smartphonequando, na realidade, a pessoa que está a ser filmada é uma composição sintetizada por uma IA ou um ator contratado que utiliza filtros que alteram o rosto. Um cenário especulativo mas plausível é a utilização de um deepfake de um falecido pessoa: Numa fraude de anuidade ou de seguro de vida, um membro da família pode utilizar um vídeo falso da pessoa recentemente falecida durante uma chamada de rotina de prova de vida para continuar a receber pagamentos[29]. Embora ainda não tenha sido divulgado nenhum caso de grande visibilidade desta natureza, as seguradoras estão a preparar-se para ele. Os reguladores também estão a tomar nota - estão em curso discussões nos EUA e na Europa sobre a classificação das falsificações profundas (deepfakes) como roubo de identidade e a atualização das orientações para a verificação de provas no domínio dos seguros[30].

A deteção de vídeos e áudio deepfake é um grande desafio sem ferramentas técnicas. Os avaliadores humanos não estão treinados para discernir problemas subtis de sincronização labial ou anomalias acústicas. No entanto, em alguns casos, houve sinais de alerta: por exemplo, pestanejar não natural ou falhas faciais no vídeo, ou artefactos de áudio de fundo numa chamada que alertaram os investigadores. No geral, porém, a fraude deepfake no sector dos seguros ainda está na fase iniciale a ação penal continua a ser rara - em 2023, as definições legais não eram claras e provar que um vídeo era gerado por IA era difícil sem uma análise especializada[31]. Isto dá aos autores de fraudes uma sensação de impunidade. A corrida ao armamento começou: as seguradoras estão agora a recorrer a IA forense para combater a IA, utilizando algoritmos de deteção de falsificações profundas (deepfake) para analisar vídeos suspeitos, fotograma a fotograma, em busca de sinais de manipulação[24]. Os fornecedores de biometria vocal estão a lançar detectores de voz "deepfake" que analisam os padrões espectrais e a cadência vocal para verificar a autenticidade[32]. Estas tecnologias defensivas serão abordadas numa secção posterior.

Golpes de phishing e de falsificação de identidade com IA

Nem todas as fraudes com recurso à IA passam pelo departamento de sinistros; alguns alvos são clientes e funcionários através de engenharia social. E-mails e textos de phishing criados por IA tornaram-se uma grande ameaça no domínio dos seguros. Nestes esquemas, os autores de fraudes utilizam chatbots de IA e ferramentas de tradução para gerar comunicações fraudulentas altamente convincentes. Por exemplo, os criminosos podem imitar a marca e o estilo de escrita de uma companhia de seguros para enviar e-mails de phishing em massa aos segurados, dizendo-lhes que "é necessária uma ação urgente para evitar o cancelamento da apólice" e direcionando-os para um site falso. Ao contrário dos desajeitados e-mails fraudulentos do passado, A IA garante uma gramática impecável e até personalizaçãotornando-as muito mais credíveis. Já vimos a IA ser utilizada para procurar nas redes sociais detalhes que são incorporados em mensagens de spear-phishing, como a referência a uma compra recente de um carro num aviso falso de seguro automóvel.

Outro vetor é Falsificação de identidade de agentes ou executivos assistida por IA. Houve casos em que os burlões clonaram a voz do proprietário de uma agência de seguros e deixaram mensagens de correio de voz para os clientes a pedir actualizações de informações bancárias - efetivamente um ataque de phishing de voz. Do mesmo modo, a fraude interna pode resultar da imitação da IA: o departamento financeiro de uma seguradora quase foi vítima quando os burlões enviaram uma mensagem áudio falsa supostamente do diretor executivo autorizar uma transferência de fundos (uma variante da "fraude do diretor executivo" atualmente coberta por algumas apólices de seguro contra crimes electrónicos[33]). Estes tipos de esquemas de falsificação de identidade orientados por IA aumentaram 17% em 2023, de acordo com a Liberty Specialty Markets[33]e prevê-se que continue a aumentar.

Os consumidores estão também a ser alvo de burlas nos meios de comunicação social sintéticos ligados aos seguros. A Coligação contra a Fraude de Seguros regista casos de impostores que se fazem passar por peritos de seguros, contactam as vítimas de acidentes alegando que estão a tratar do seu pedido de indemnização e depois exigir pagamento imediato ou dados sensíveis[23]. Os clientes desprevenidos, aliviados por ouvirem um suposto representante, podem aceitar, especialmente se o autor da chamada souber pormenores do seu acidente (que a IA pode obter através de pirataria informática ou de fontes públicas). A sensibilização do público para estas tácticas é reduzida, pelo que os especialistas em prevenção da fraude instam as seguradoras a informar os tomadores de seguros sobre a verificação da identidade dos autores das chamadas e das mensagens de correio eletrónico[23][34]. Tal como os bancos avisam os clientes sobre o phishing, as seguradoras em 2025 estão a começar a incluir avisos de fraude deepfake nas suas comunicações.

Um traço comum a estes esquemas reforçados com IA é a utilização de kits de "fraude como serviço" facilmente disponíveis[35]. Na dark web, os criminosos podem comprar ou subscrever ferramentas que fornecem vozes deepfake pré-fabricadas, modelos de documentos falsos, geradores de e-mails de phishing e muito mais. Esta democratização das ferramentas de IA significa mesmo os burlões pouco qualificados podem lançar ataques sofisticados de fraude[35]. Para as companhias de seguros, isto traduz-se num dilúvio de tentativas de fraude mais convincentes vindas de todos os ângulos - reclamações, serviço ao cliente, correio eletrónico e até redes sociais. Isto sublinha a necessidade de uma estratégia de defesa multifacetada, combinando tecnologia, vigilância humana e colaboração entre sectores.

Deteção e defesa: Uma resposta alimentada por IA

A luta contra a fraude baseada na IA exige Defesa orientada para a IA. As seguradoras estão a recorrer cada vez mais a tecnologias de deteção avançadas e a processos renovados para combater o ataque. Essencialmente, as seguradoras devem incorporar pontos de controlo da autenticação de conteúdos em todo o ciclo de vida do seguro - desde a subscrição até aos sinistros e às interações com os clientes - para detetar falsificações de IA. A Figura 2 apresenta uma análise dos principais tipos de fraude possibilitados pela IA e sua prevalência, e as seções a seguir detalham como detetar e impedir cada um deles.

Figura 2: Tipos de fraude de seguros com recurso a IA em 2025 (quota estimada por esquema). Imagens falsas (fotos adulteradas de danos) e identidades sintéticas estão entre as maiores categorias, seguidas por documentos falsificados por IA (por exemplo, recibos, certificados) e fraudes de áudio/vídeo deepfake.

1. Ferramentas de deteção de conteúdos com IA: Os novos serviços de deteção de IA podem analisar texto, imagens, áudio e vídeo para determinar se foram gerados ou manipulados por máquinas. Por exemplo, as seguradoras podem tirar partido de soluções como Detectores de texto e imagem com IA do TruthScan que utilizam a IA de precisão 99%+ para assinalar documentos escritos com IA ou fotografias adulteradas[36]. Uma companhia de seguros pode integrar estes detectores no seu sistema de sinistros: quando um sinistro e as suas provas são apresentados, a descrição do texto pode ser automaticamente analisada em busca de padrões de linguagem gerados por IA, e quaisquer imagens carregadas podem ser analisadas em busca de sinais reveladores de CGI ou edição. As ferramentas de nível empresarial podem identificar texto gerado por IA em documentos, e-mails e comunicações com uma precisão de 99%[36]e, do mesmo modo detetar imagens geradas ou manipuladas por IA para garantir a autenticidade do conteúdo visual[36]. Isso significa que uma narrativa falsa de acidente produzida pelo ChatGPT ou uma foto de danos falsificada no meio da viagem seria sinalizada para revisão manual antes que o sinistro fosse processado. Em 2025, as seguradoras estão a adotar cada vez mais este tipo de autenticação de conteúdos por IA - de facto, 83% dos profissionais antifraude planeiam integrar a deteção de IA generativa até 2025de acordo com um inquérito da ACFE, contra apenas 18% que o utilizam atualmente[37][38].

2. Verificação da identidade e controlos biométricos: Para fazer face às identidades sintéticas, as seguradoras estão também a melhorar os protocolos KYC com IA. Os serviços de validação de identidade podem fazer a verificação cruzada dos dados do candidato em vários bancos de dados e usar o reconhecimento facial com testes de vivacidade. Por exemplo, exigir uma pequena selfie em vídeo durante a integração (e usar a correspondência facial com a identificação fornecida) pode impedir muitas identificações sintéticas. Ainda mais tecnológicas, empresas como a TruthScan oferecem análises forenses de imagens que podem detetar fotografias de perfil geradas por IA, avatares e imagens sintéticas de personagens - o seu detetor de imagens de IA é treinados para identificar rostos criados por geradores como StyleGAN ou ThisPersonDoesNotExist[39]. Ao utilizar estas ferramentas, uma seguradora pode detetar se a selfie de um candidato a seguro de vida não é de um ser humano real. No que respeita à voz, autenticação biométrica vocal para chamadas de serviço ao cliente pode ajudar; os detectores modernos de IA de voz são capazes de identificar vozes sintéticas e tentativas de clonagem de voz em tempo real[40]. Por exemplo, o TruthScan's Deteção de voz AI O sistema utiliza a análise acústica para reconhecer vozes geradas por IA e deepfakes de áudio antes que enganem o pessoal do centro de atendimento[40]. Estas soluções actuam como uma firewall - se alguém ligar a fingir ser fulano de Tal e a sua impressão vocal não corresponder à voz autêntica de fulano de Tal (ou corresponder a caraterísticas conhecidas de deepfake), a chamada pode ser assinalada ou pode ser exigida uma prova de identidade adicional. A autenticação multifactor (confirmação por correio eletrónico/SMS, códigos de acesso únicos, etc.) acrescenta obstáculos adicionais a ultrapassar pelos falsificadores.

3. Análise forense de vídeos e imagens Deepfake: No que diz respeito às provas de vídeo, as seguradoras estão a começar a implementar uma análise forense especializada. O software avançado pode analisar os metadados do vídeo, a consistência dos fotogramas e os níveis de erro para detetar falsificações profundas. Algumas ferramentas examinam reflexos, sombras e sinais fisiológicos (como a pulsação na garganta de uma pessoa num vídeo) para garantir que um vídeo é genuíno. Análise forense de metadados também é valiosa: examinar os metadados dos ficheiros e as pegadas de geração em imagens ou PDFs pode revelar se algo foi provavelmente produzido por uma ferramenta de IA[41]. As seguradoras devem exigir ficheiros de fotografias originais (que contêm metadados) em vez de apenas capturas de ecrã ou cópias impressas, por exemplo. A equipa antifraude da Zurich registou um êxito na deteção de imagens falsas de automóveis ao detetar anomalias nos metadados da imagem e na análise do nível de erro[41]. Detectores de fraudes de correio eletrónico pode igualmente analisar as comunicações de entrada para detetar sinais de conteúdo de phishing escrito por IA ou assinaturas maliciosas conhecidas[42]. Atualmente, muitas seguradoras utilizam simulações de phishing e exemplos de esquemas fraudulentos criados por IA na formação dos funcionários para os sensibilizar.

4. Alterações de processos e formação humana: A tecnologia, por si só, não é uma solução milagrosa. Melhorias no processo estão a ser feitas, tais como verificações aleatórias presenciais mais frequentes para sinistros de elevado valor, ou a exigência de documentação física em determinados casos. Algumas seguradoras atrasaram o processamento direto e totalmente automatizado dos sinistros, reintroduzindo a análise humana para os sinistros com uma pontuação elevada num modelo de risco de fraude com IA. Do lado humano, a formação é crucial. Os investigadores e ajustadores de fraudes estão a ser treinados para reconhecer os sinais de alerta da IA: por exemplo, vários pedidos de indemnização com palavras idênticas ("estilo" ChatGPT), imagens sem verdadeira aleatoriedade (por exemplo, padrões repetidos no que deveriam ser danos orgânicos) ou vozes que soam quase mas têm uma cadência robótica. As seguradoras também estão a educar os clientes: enviando alertas de fraude sobre esquemas de deepfake e aconselhando como verificar a identidade de um representante de seguros (por exemplo, fornecendo um número de chamada de retorno conhecido).

5. Esforços de colaboração: A colaboração a nível da indústria está a aumentar. No Reino Unido, o Insurance Fraud Bureau e a Associação de Seguradoras Britânicas formaram grupos de trabalho sobre a fraude com IA, e o projeto governamental Carta da Fraude de Seguros (2024) está a promover a partilha de dados e iniciativas conjuntas[43]. A nível mundial, as seguradoras estão a estabelecer parcerias com empresas de cibersegurança e startups de IA. Nomeadamente, estão a surgir novos produtos de seguros: A Liberty Mutual lançou um seguro contra a criminalidade eletrónica para as PME que cobre especificamente as fraudes "deepfake" e as fraudes dos diretores executivos[44][33]O que significa que as seguradoras podem ser simultaneamente vítimas e solucionadoras de fraudes com IA - pagando por uma fraude de deepfake se não for detectada, mas também oferecendo cobertura a outros que sofram tais ataques. Isto também significa que as seguradoras podem ser simultaneamente vítimas e solucionadoras de fraudes de IA - pagando por um esquema de deepfake se não for detectado, mas também oferecendo cobertura para outros que sofram tais ataques.

A integração da tecnologia de deteção nos fluxos de trabalho pode ser visualizada como uma defesa multiponto no ciclo de vida dos sinistros. Como mostrado em Figura 3as seguradoras podem inserir etapas de verificação da IA em aplicação da política (para detetar identidades sintéticas através de controlos de documentos de identificação e selfies), em apresentação de pedidos (para analisar automaticamente documentos, fotografias ou áudio carregados para geração de IA), durante análise/investigação de sinistros (para efetuar uma análise forense deepfake em provas suspeitas e verificar quaisquer interações de voz), e imediatamente antes de pagamento (uma autenticação final da identidade para garantir que o beneficiário é legítimo). Ao detetar a fraude numa fase inicial - idealmente na integração ou no primeiro aviso de perda - as seguradoras poupam custos de investigação e evitam pagamentos indevidos.

Figura 3: Integração de pontos de deteção de IA no ciclo de vida do seguro. Na integração da apólice, a validação de identidade baseada em IA verifica se existem identidades sintéticas ou falsas. Quando um pedido de indemnização é apresentado, os detectores automatizados analisam o texto, os documentos e as imagens do pedido de indemnização em busca de conteúdo gerado por IA. Durante a análise dos sinistros, ferramentas especializadas de análise de voz e deepfake verificam quaisquer provas de áudio/vídeo. Antes do pagamento, a verificação biométrica da identidade confirma a identidade do beneficiário. Esta abordagem multi-camadas ajuda a intercetar a fraude em várias fases.

As seguradoras não têm de criar todas estas capacidades internamente - muitas estão a recorrer a soluções empresariais como Conjunto de deteção de IA do TruthScanque oferece uma gama de ferramentas que podem ser integradas por API nos sistemas das seguradoras. Por exemplo, Serviço de deteção de imagens e deepfake com IA do TruthScan pode ser utilizado para verificar a autenticidade de imagens e vídeos com uma precisão superior a 99%[45]. Os seus Detetor de texto com IA assinala texto escrito por IA em reclamações ou mensagens de correio eletrónico[36], enquanto o Detetor de voz AI permite a deteção de clonagem de voz e a verificação do altifalante para travar os impostores de telefones[40]. Existem até ferramentas de nicho como um Detetor de recibos falsos analisar instantaneamente facturas/recibos para detetar sinais de adulteração ou tipos de letra/layouts gerados por IA[46] - extremamente útil, dada a prevalência de facturas de reparação falsas nos sinistros. Ao utilizar uma combinação destas ferramentas, uma seguradora pode melhorar drasticamente a sua taxa de deteção de fraudes. Uma seguradora da Fortune 500 informou ter apanhado 97% de tentativas de deepfake em 2024, utilizando uma abordagem de rastreio de IA por camadas (texto, imagem, voz) e evitando assim um prejuízo estimado em \$20M[47][48].

Conclusão

A IA está a transformar o campo de batalha da fraude nos seguros a uma escala global. Os fraudadores estão a inovar com IA generativa para criar falsidades que são mais convincentes do que nunca - desde pessoas e acidentes totalmente fabricados a imitações que podem enganar até mesmo profissionais experientes. Os dados de 2024-2025 mostram um crescimento alarmante nestes esquemas alimentados por IA, mas também destacam que as seguradoras que investem na deteção e prevenção podem estar um passo à frente. Ao combinar tecnologia de deteção de IA de ponta - como a análise forense de imagens, a autenticação de voz e a análise de texto - com fluxos de trabalho actualizados e formação, a indústria pode atenuar os riscos sem sacrificar as eficiências que os processos digitais trazem.

No fundo, trata-se de uma corrida ao armamento tecnológico[49]. Como observou um perito em prevenção da fraude, "Nesta nova realidade, a vigilância é o prémio que deve ser pago"[50]. As companhias de seguros devem promover uma cultura de vigilância e utilizar as melhores ferramentas disponíveis para preservar a confiança no processo de sinistros. Isso significa verificar a veracidade de documentos, vozes e imagens com o mesmo rigor que os subscritores utilizam para avaliar o risco. Significa também colaborar com toda a indústria para partilhar informações sobre as tácticas emergentes de fraude com IA e desenvolver em conjunto normas (por exemplo, requisitos de metadados normalizados para os meios de comunicação apresentados ou listas negras da indústria de identidades falsas conhecidas).

2025 é um ponto de viragem: as seguradoras que adaptar-se de forma proactiva à fraude baseada em IA As seguradoras que não reagirem com rapidez protegerão os seus clientes e os seus balanços, enquanto as que demorarem a reagir poderão ser alvo de fraudes que se tornarão notícia. A notícia encorajadora é que a tecnologia para lutar existe e está a amadurecer rapidamente - a mesma IA que dá poder aos fraudadores pode dar poder às seguradoras. Ao implementar soluções como o conjunto de deteção de IA multimodal do TruthScan para reclamações e verificação de identidade, as seguradoras podem reduzir drasticamente a taxa de sucesso das tentativas de fraude geradas por IA[51][52]. Ao fazê-lo, não só evitam perdas, como também enviam uma mensagem clara aos potenciais autores de fraudes: por mais inteligentes que sejam as ferramentas, a fraude será descoberta.

Em resumo, a fraude de seguros baseada em IA é um desafio formidável, mas que pode ser enfrentado com uma defesa igualmente inteligente. Com vigilância, estratégia multifuncional e os parceiros tecnológicos certos, o sector dos seguros pode continuar a cumprir a promessa fundamental no centro do seu negócio - pagar apenas sinistros legítimos e fazê-lo de forma rápida e segura num mundo cada vez mais digital.

Referências:

- Associação de Seguradoras Britânicas - Estatísticas de fraude 2023[53][54]

- Allianz & Zurich sobre o aumento dos pedidos de indemnização "shallowfake" da IA - The Guardian, 2024[4][11]

- Facia.ai - "Fraude de seguros Deepfake: Como a IA está a reescrever as regras". outubro de 2025[55][56]

- Coligação contra a Fraude no Setor dos Seguros Fraude sintética nos seguros (Quantexa), dezembro de 2024[21][17]

- RGA - "A nova fronteira da luta contra a fraude: identidades sintéticas". junho de 2025[15][16]

- Pingo de água - Relatório de fraude de voz, via FierceHealthcare, Jun 2025[2][3]

- Transformar números - "Os principais esquemas de fraude financeira em 2025," outubro de 2025[1][57]

- TruthScan - Plataforma de deteção de IA (visão geral dos serviços), 2025[51][52]

- TruthScan - Página do produto AI Image Detetor, 2025[45][39]

- TruthScan - Página do produto AI Voice Detetor, 2025[40]

- TruthScan - Página do produto Detetor de recibos falsos, 2025[46]

- Liberty Specialty Markets - Comunicado de imprensa sobre o seguro contra fraudes cibernéticas/ Deepfake, março de 2025[33]

- Facia.ai - Blogue: Corrida armamentista para a prevenção da fraude no sector dos seguros, 2025[24][32]

- Negócios de seguros no Reino Unido - "Imagens geradas por IA utilizadas para fraude automóvel," abril de 2025[7][58]

- The Guardian - "Fotografias falsas de danos em automóveis alarmam as seguradoras," maio de 2024[9][12]

[1] [35] [57] 2025 Esquemas de fraude financeira: Ameaças de IA e sinais de alerta

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] A fraude nos seguros aumentou 19% devido a ataques de voz em 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Fraudadores editam fotografias de veículos para adicionar danos falsos em fraudes de seguros no Reino Unido | Setor dos seguros | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Imagens geradas por IA estão agora a ser utilizadas para fraude no seguro automóvel - relatório | Insurance Business UK

[13] [14] [15] [16] A nova fronteira da luta contra a fraude: identidades sintéticas e uma corrida ao armamento da IA | RGA

[17] [18] [19] [20] [21] [22] JIFA: Fraude sintética: Com a fraude sintética já no seu ecossistema, as seguradoras precisam de pensar mais como os bancos - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Fraude de seguros Deepfake: Como a IA está a reescrever as regras dos pedidos de indemnização de seguros

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] A Ameaça Silenciosa: Porque é que a fraude de seguros está a mudar para a linha telefónica

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] O seguro contra o crime eletrónico para as PME visa a fraude dos CEO e os deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - Deteção de IA empresarial e segurança de conteúdos

[37] Estudo: 8 em cada 10 combatentes da fraude esperam implementar a IA generativa até 2025

[38] Informações do relatório de avaliação comparativa da tecnologia antifraude de 2024

[39] [45] Detetor de imagens com inteligência artificial para detetar fotos falsas e manipuladas - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] Detetor de voz AI para Deepfakes e clonagem de voz | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Detetor de recibos falsos | Verificar a autenticidade do recibo

https://truthscan.com/fake-receipt-detector

[47] Seguradora da Fortune 500 detecta 97% de Deepfakes e pára de fazer sintéticos ...