Um guia completo para compreender, detetar e prevenir a fraude de voz com IA na empresa

A chamada de voz de $25 milhões que nunca aconteceu

Em fevereiro de 2024, uma funcionária da área financeira de uma empresa multinacional em Hong Kong recebeu uma videochamada do seu diretor financeiro.

A voz do outro lado era inconfundível; todas as inflexões, todas as pausas e até o ligeiro sotaque eram imediatamente reconhecidos.

Pediu-lhe com urgência que processasse 15 transferências electrónicas, num total de $25 milhões, para finalizar uma aquisição confidencial.

Nunca mais se preocupe com fraudes de IA. TruthScan Pode ajudar-vos:

- Detetar a IA gerada imagens, texto, voz e vídeo.

- Evitar grandes fraudes impulsionadas pela IA.

- Proteja os seus mais sensível activos da empresa.

O diretor financeiro nunca tomou essa decisão. Foi completamente gerada por IA.

Este não foi um caso isolado. As instituições financeiras estão a assistir a um aumento acentuado das fraudes "deepfake".

Nos últimos três anos, os casos aumentaram 2,137%, e a IA é agora responsável por 42,5% de todas as tentativas de fraude no sector.

Mesmo com o aumento da fraude de voz com IA, mais de metade dos líderes empresariais admitem que os seus funcionários não receberam formação para detetar ou responder a ataques de deepfake; quase 80% das empresas não têm protocolos formais em vigor para lidar com estes incidentes.

Como funciona a clonagem de voz por IA e porque é que é uma ameaça

A síntese de voz da IA moderna precisa de surpreendentemente poucos dados. Apenas alguns segundos de áudio podem clonar uma voz com uma precisão de até 85%.

O processo resume-se a três etapas principais:

- Recolha de dados: Os burlões recolhem amostras de voz de fontes públicas, como chamadas em conferência, entrevistas em podcast, clips de redes sociais ou mesmo publicações de vídeo no LinkedIn.

- Formação de modelos: A IA analisa caraterísticas vocais como o tom, o timbre, o sotaque, o ritmo e os padrões de respiração.

- Geração: O sistema cria um discurso sintético suficientemente convincente para enganar até colegas próximos.

O problema da acessibilidade

O que torna esta ameaça ainda mais perigosa é a sua democratização. Os burlões já não precisam de recursos ao nível de Hollywood.

Tudo o que é necessário é um software acessível para clonar uma voz a partir de um pequeno clip das redes sociais; as ferramentas de código aberto e os serviços de IA baseados na nuvem tornaram a clonagem de voz acessível a qualquer pessoa com conhecimentos técnicos básicos.

Porque é que os executivos são os principais alvos de fraude

Os executivos enfrentam uma mistura perigosa de factores de risco.

A sua exposição pública através das redes sociais faz com que as amostras de voz sejam fáceis de encontrar e a sua autoridade leva muitas vezes os funcionários a agir rapidamente em relação a pedidos urgentes.

Em média, um em cada quatro executivos tem um conhecimento limitado da tecnologia deepfake.

As estatísticas actuais mostram um quadro preocupante

Num Inquérito Deloitte 2024No ano passado, 25,9% dos executivos afirmaram que as suas organizações tinham sido confrontadas com pelo menos um incidente de deepfake que visava dados financeiros ou contabilísticos, e metade dos inquiridos acreditava que esses ataques iriam aumentar nos próximos 12 meses.

Mais preocupante: apenas 52% das organizações se sentem confiantes de que poderiam detetar um deepfake do seu CEO.

Como detetar fraudes de voz com IA

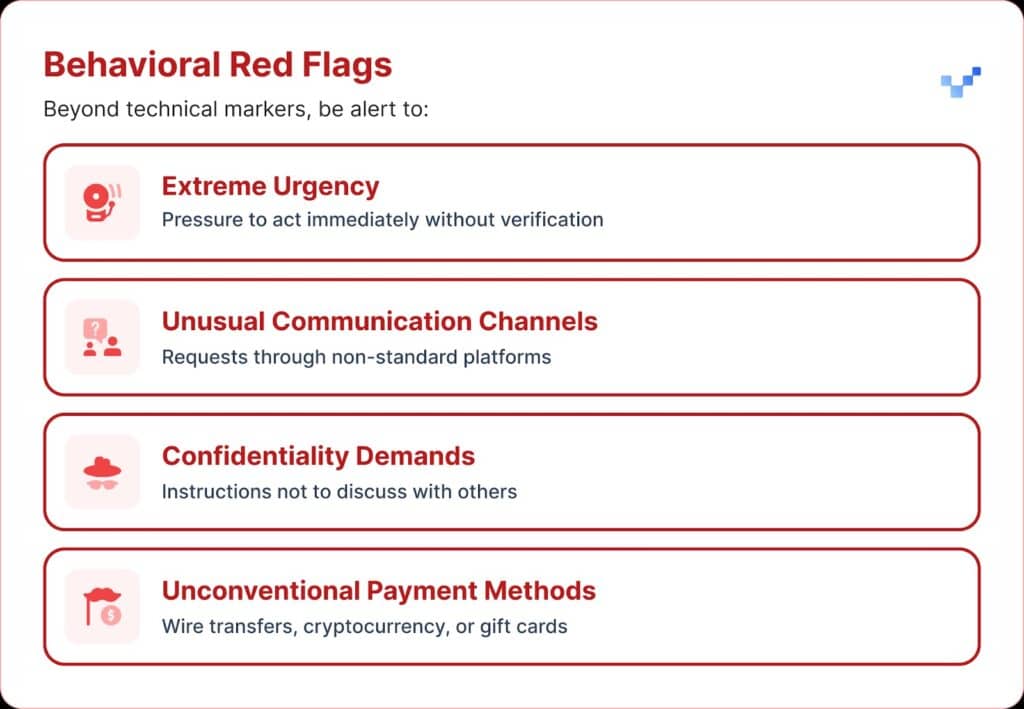

Quando recebe uma comunicação de voz suspeita, há alguns sinais de aviso a que deve estar atento.

Os esquemas de voz com IA soam frequentemente monótonos ou monótonos. Pode também notar um ritmo invulgar, com pausas estranhas ou um ritmo não natural.

O áudio também pode apresentar zumbidos ou ecos electrónicos fracos, especialmente durante chamadas mais longas.

E, em muitos casos, a voz repete frases limitadas que parecem ter sido escritas ou ensaiadas.

Impacto financeiro e custos reais

A maioria das organizações perdeu, em média, cerca de $450.000, mas no sector dos serviços financeiros as perdas ultrapassaram os $603.000.

E nos casos mais graves, 1 em cada 10 organizações registou perdas superiores a $1 milhões.

Esta tendência está a crescer rapidamente. Estudos anteriores de 2022 indicavam que o encargo financeiro médio da fraude de identidade era de cerca de $230.000, quase metade do valor atual.

Perdas futuras projectadas

De acordo com o Centro de Serviços Financeiros da Deloitte, o dinheiro perdido devido a fraudes de IA nos EUA poderá aumentar de $12,3 mil milhões em 2023 para $40 mil milhões em 2027. Isso representa um crescimento de cerca de 32% por ano.

Vulnerabilidade regional

A América do Norte registou um aumento de 1740% na fraude deepfake.

Este aumento regional significativo sugere que a América do Norte pode ser o principal alvo dos autores de fraudes deepfake, provavelmente devido à sua grande economia digital e à utilização generalizada de serviços em linha.

Abordagens estratégicas para a proteção de executivos

1. Implementar protocolos de verificação

Uma forma de reforçar as defesas é utilizar um sistema de "palavras seguras", frases de autenticação pré-acordadas e partilhadas com o pessoal-chave.

Um burlão que utilize a clonagem de voz por IA não saberá as respostas corretas às perguntas de verificação pessoal.

Outra salvaguarda é a verificação multi-canal.

Qualquer pedido financeiro invulgar deve ser confirmado através de um canal de comunicação separado, nunca confiando apenas no método de contacto original.

As empresas devem também estabelecer regras claras de escalonamento, com períodos de espera e etapas de aprovação para grandes transacções financeiras, independentemente de quem as solicita.

2. Cuidado com a exposição digital

Outra camada de proteção consiste em limitar a quantidade de áudio e vídeo executivo disponível online. Quanto mais amostras os burlões conseguirem recolher, mais convincentes se tornam os seus clones.

Também ajuda definir orientações claras para os executivos nas redes sociais, especialmente no que diz respeito à publicação de vídeos com áudio limpo.

E no que diz respeito a conferências, as organizações devem ter em atenção as conversas ou entrevistas gravadas que dão longos trechos de amostras de voz.

3. Implementar soluções técnicas

É aqui que a tecnologia avançada de deteção de IA se torna crítica.

As organizações precisam de autenticação de voz de nível empresarial e deteção de deepfake capacidades que proporcionam:

- Análise em tempo real: Detetar vozes sintéticas durante comunicações em direto

- Verificação histórica: Analisar a autenticidade das chamadas e mensagens gravadas

- Capacidades de integração: Trabalhar sem problemas com as plataformas de comunicação existentes

- Elevados índices de precisão: Minimizar os falsos positivos e detetar falsificações sofisticadas

4. Programas de formação abrangentes

As equipas de liderança precisam de formação específica sobre ameaças de voz da IA e procedimentos de verificação.

Igualmente importante é a sensibilização dos trabalhadores.

Todos, em qualquer função, devem estar preparados para detetar potenciais deepfakes e impedir que as ciberameaças entrem na organização.

Exercícios regulares de simulação podem reforçar esta preparação, utilizando tentativas simuladas de fraude vocal para testar e aperfeiçoar os procedimentos de resposta.

Soluções avançadas de deteção de voz com IA

As defesas tradicionais foram criadas para ameaças baseadas em rede, não para a personificação humana alimentada por IA.

As principais razões pelas quais as ferramentas normais de cibersegurança não conseguem lidar com a engenharia social baseada na voz:

- Sem assinatura de malware: As chamadas de voz não accionam os sistemas de segurança tradicionais

- Fator de confiança humana: As pessoas confiam naturalmente no que ouvem, especialmente em vozes familiares

- Lacunas na tecnologia de deteção: Apesar do aumento das tentativas de fraude baseadas em IA, incluindo deepfakes, apenas 22% das instituições financeiras implementaram ferramentas de prevenção de fraude baseadas em IA

A necessidade de uma deteção de voz especializada

A fraude vocal moderna exige capacidades de deteção modernas.

De nível empresarial Sistemas de deteção de voz com IA pode:

- Analisar biomarcadores vocais: Detetar inconsistências subtis no discurso sintético

- Processamento em tempo real: Fornecer alertas imediatos durante chamadas suspeitas

- Aprendizagem contínua: Adaptar-se a novas técnicas de síntese vocal

- Pronto para integração: Trabalhar com as infra-estruturas de comunicação existentes

As organizações que pretendem seriamente proteger-se contra a fraude de voz têm de investir em tecnologia de deteção de IA especificamente concebida para corresponder à sofisticação das ameaças que enfrentam.

A fraude de voz já existe e está a aumentar

No primeiro trimestre de 2025, a fraude deepfake e o roubo de identidade causaram mais de $200 milhões em perdas.

O phishing de voz com clones de IA aumentou 442%, e mais de 400 empresas por dia estão a ser atingidas por esquemas de deepfake de CEO ou CFO.

Embora 56% das empresas digam que se sentem muito confiantes para detetar as falsificações profundas, apenas 6% evitaram efetivamente sofrer perdas financeiras com elas.

O que importa não é se a sua organização vai ser visada, mas se está preparada para isso.

A fraude por voz está a mudar a face da cibersegurança. As defesas tradicionais não conseguem acompanhar a falsificação de identidade alimentada por IA.

Para se manterem protegidas, as organizações precisam de melhores ferramentas de deteção, programas de formação sólidos e procedimentos de verificação claros.

A tecnologia para combater a fraude já existe. A verdadeira questão é saber se a vai utilizar antes ou depois do primeiro incidente de fraude vocal.