Wprowadzenie

Generatywna sztuczna inteligencja rewolucjonizuje opiekę zdrowotną - i nie zawsze na lepsze. W 2025 r. liczba oszustw związanych z opieką zdrowotną wzrosła bardziej cyfrowy i wyrafinowany, napędzany przez naruszenia danych, automatyzację i generatywną sztuczną inteligencję[1]. Przestępcy wykorzystują narzędzia sztucznej inteligencji do tworzenia fałszywe tożsamości pacjentów, syntetyczne roszczenia ubezpieczeniowe, dokumenty medyczne generowane przez sztuczną inteligencję, sfałszowane recepty, a nawet głęboko sfałszowane interakcje między lekarzem a pacjentem. Te zaawansowane technologicznie oszustwa osiągają nowy poziom, zagrażając finansom ubezpieczycieli i bezpieczeństwu pacjentów na całym świecie. Wyzwanie jest ogromne: oszustwa związane z opieką zdrowotną już teraz kosztują dziesiątki miliardów rocznie, a rozwój sztucznej inteligencji zwiększając zarówno skalę, jak i złożoność oszustw[2][3]. Ten oficjalny dokument zawiera szczegółowe spojrzenie na najnowsze trendy w zakresie oszustw opartych na sztucznej inteligencji w opiece zdrowotnej, rzeczywiste przypadki z 2025 r. oraz strategie - od wykrywaczy treści AI po weryfikację tożsamości - w celu zwalczania tego ewoluującego zagrożenia.

Wzrost liczby oszustw z wykorzystaniem sztucznej inteligencji w opiece zdrowotnej

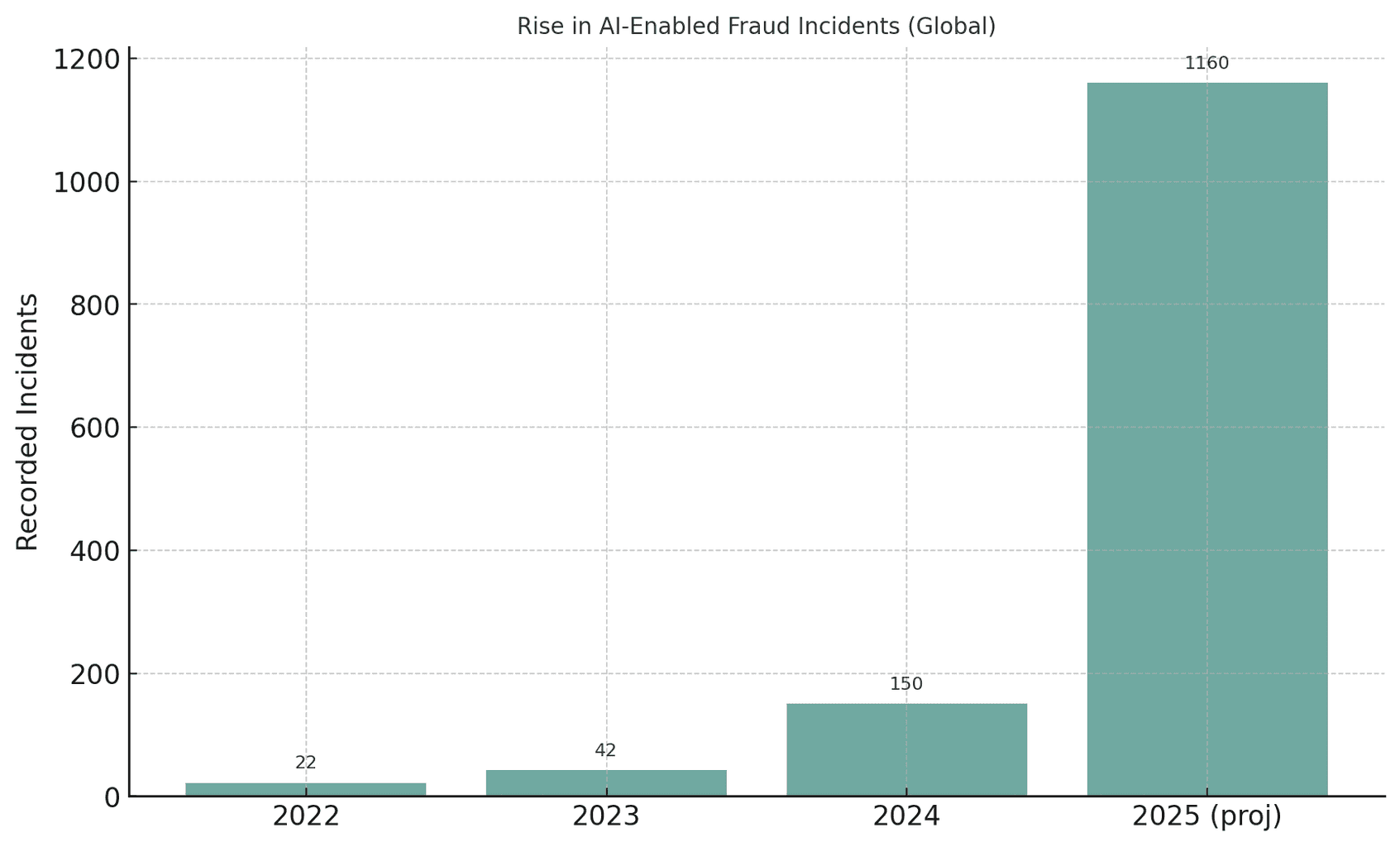

Globalny sektor opieki zdrowotnej doświadcza bezprecedensowy wzrost liczby prób oszustw z wykorzystaniem sztucznej inteligencji. W miarę jak generatywna sztuczna inteligencja staje się dostępna, oszuści mogą zautomatyzować to, co kiedyś było ręcznymi oszustwami, tworząc przekonujące fałszywe tożsamości, dokumenty, a nawet głosy lub filmy na dużą skalę. Na przykład władze zauważyły, że liczba prób oszustw z wykorzystaniem fałszywych mediów wzrosła o 3,000% w 2023 r. sam[4][5]. Liczba incydentów związanych z deepfake'ami niemal podwoiła się z 22 w 2022 r. do 42 w 2023 r., a następnie eksplodowała do 150 incydentów w 2024 r.; co zaskakujące, w pierwszym kwartale 2025 r. odnotowano 179 przypadków oszustw związanych z deepfake'ami - już przekraczając łączną liczbę w 2024 r.[6][7]. Tendencja ta sugeruje Gwałtowny wzrost oszustw opartych na sztucznej inteligencjiAnalitycy przewidują, że generatywna sztuczna inteligencja może zwiększyć straty związane z oszustwami z $12,3 mld euro w 2023 r. do $40 mld euro do 2027 r. (32% CAGR)[8].

Rysunek: Gwałtowny wzrost liczby oszustw z wykorzystaniem sztucznej inteligencji w ostatnich latach. Wykryte przypadki oszustw typu deepfake lub wspomaganych przez sztuczną inteligencję dramatycznie wzrosły w latach 2022-2025, ilustrując, w jaki sposób generatywne narzędzia sztucznej inteligencji zwiększyły liczbę prób oszustw.[4][7].

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

Opieka zdrowotna jest szczególnie podatna na tę napędzaną przez sztuczną inteligencję falę przestępczości. Rozległy, rozdrobniony ekosystem tego sektora - obejmujący szpitale, kliniki, ubezpieczycieli, apteki i platformy telezdrowia - oferuje tysiące punktów ataku[9][10]. Tradycyjne oszustwa (np. fałszywe karty ubezpieczeniowe lub skradzione dowody tożsamości pacjentów) mają ewoluowały w systemowe wykorzystywanie przy użyciu sztucznej inteligencji[10][11]. W amerykańskim procesie wszczętym w 2025 r. Departament Sprawiedliwości oskarżył 324 oskarżonych o udział w programach o łącznej wartości $14,6 mld w fałszywych roszczeniach - największa w historii sprawa dotycząca oszustw w opiece zdrowotnej[12][13]. Wiele oszustw wiązało się z konsultacjami telemedycznymi i oszustwami związanymi z testami genetycznymi. Centrum syntezy danych o oszustwach w opiece zdrowotnej wykorzystał analitykę AI do proaktywnego wykrywania wzorców[14][15]. Oczywiste jest, że sztuczna inteligencja to miecz obosieczny: pomaga śledczym w łapaniu oszustw, ale także umożliwiając przestępcom popełnianie oszustw na niespotykaną dotąd skalę i w wyrafinowany sposób[11][2].

Powszechne techniki oszustw oparte na sztucznej inteligencji w opiece zdrowotnej (2025)

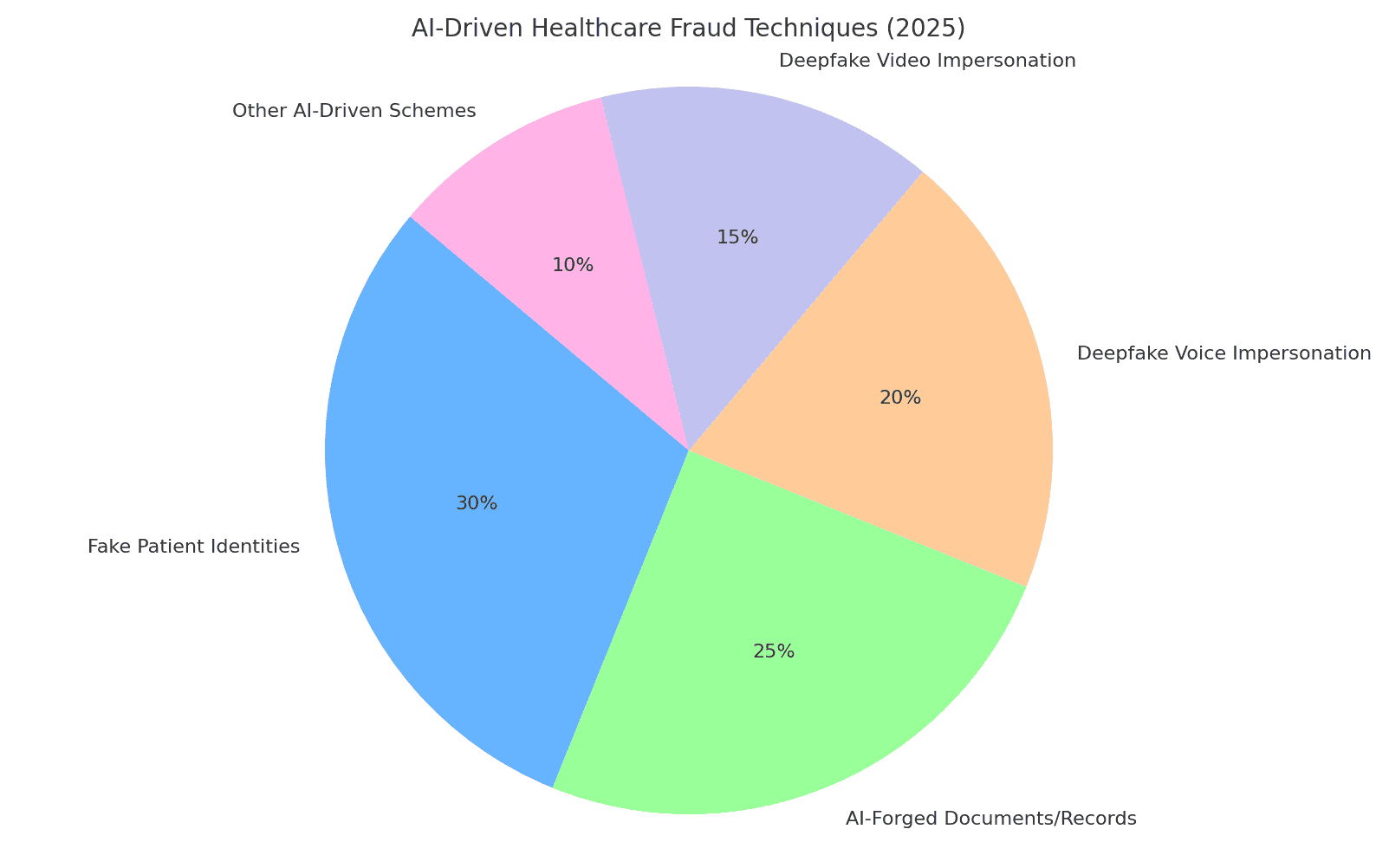

Oszuści w 2025 roku będą dysponować zestawem taktyk wykorzystujących sztuczną inteligencję do oszukiwania systemów opieki zdrowotnej i ubezpieczycieli. Kluczowe schematy obejmują fałszowanie tożsamości i dokumentów, generowanie fałszywych danych medycznych i podszywanie się pod zaufany personel za pomocą deepfake. Poniżej przedstawiamy najbardziej rozpowszechnione techniki oszustw oparte na sztucznej inteligencji i sposób ich wykorzystania przeciwko organizacjom opieki zdrowotnej:

Rysunek: Podział głównych technik oszustw związanych z opieką zdrowotną opartych na sztucznej inteligencji w 2025 r. Fałszywe tożsamości pacjentów i Dokumenty sfałszowane przez sztuczną inteligencję (np. dokumentacja medyczna, roszczenia) stanowią dużą część schematów, podczas gdy deepfake głos i Podszywanie się pod wideo stanowią szybko rosnące zagrożenie. "Inne schematy oparte na sztucznej inteligencji" obejmują spreparowane przez sztuczną inteligencję wiadomości phishingowe, boty atakujące portale pacjentów i podobne exploity (szacunkowy odsetek na podstawie raportów branżowych).[8][16]).

Syntetyczne tożsamości pacjentów

Fałszywe tożsamości pacjentów - często tworzone z pomocą sztucznej inteligencji - są podstawową taktyką oszustwa. Zamiast kraść tożsamość jednej osoby, przestępcy łączą prawdziwe dane od wielu osób ze sfabrykowanymi szczegółami, aby stworzyć syntetyczne tożsamości które podają się za nowych pacjentów[17][18]. Generatywna sztuczna inteligencja przyspiesza to poprzez tworzenie realistycznych danych osobowych. Na przykład, sztuczna inteligencja może generować wiarygodne Identyfikatory, profile, a nawet historie rodzinne ("syntetyczni rodzice") dla fałszywego pacjenta[19][20]. Ci fantomowi pacjenci są następnie wykorzystywani do otwierać konta, uzyskiwać polisy ubezpieczeniowe lub wystawiać rachunki za usługi które nigdy nie miały miejsca. Podczas pandemii COVID-19 oszuści używali syntetycznych dokumentów tożsamości do korzystania z awaryjnych świadczeń zdrowotnych; teraz używają ich do składać fałszywe wnioski ubezpieczeniowe lub uzyskiwać receptywiedząc, że dobrze spreparowana tożsamość może uniknąć wykrycia[21][22]. Według amerykańskiej Rezerwy Federalnej, straty spowodowane oszustwami związanymi z syntetyczną tożsamością wyniosły ponad $35 mld euro w 2023 r. i nadal rosną[23]. Wpływ na opiekę zdrowotną jest poważny: oszuści mogą wykorzystać skradziony numer ubezpieczenia społecznego dziecka, aby stworzyć fałszywego pacjenta z doskonałym kredytem lub połączyć skradzione dane pacjenta, aby ominąć weryfikację ubezpieczyciela[17][24]. Każdy syntetyczny pacjent wprowadzony do systemu podważa integralność danych i może prowadzić do niesłusznych wypłat a nawet błędy kliniczne, jeśli fałszywa tożsamość zostanie powiązana z prawdziwą dokumentacją medyczną.

Dokumenty medyczne i roszczenia ubezpieczeniowe generowane przez AI

Generatywna sztuczna inteligencja jest obecnie wykorzystywana do tworzenia dokumenty medyczne, zapisy i całe roszczenia ubezpieczeniowe. Modele językowe mogą tworzyć autentycznie wyglądające notatki lekarskie, podsumowania wypisów, wyniki badań laboratoryjnych lub oświadczenia rozliczeniowe wypełnione żargonem medycznym - wszystko dostosowane do fałszywych roszczeń. W rzeczywistości obserwatorzy branży zgłaszają 89% Wzrost liczby dokumentów medycznych generowanych przez sztuczną inteligencję w porównaniu z poprzednimi latami[25][26]. Oszuści wykorzystują te fałszywe zapisy do uzasadnienia drogich procedur lub leków, które nigdy nie zostały dostarczone, lub do zawyżania kodów refundacyjnych. Na przykład, sztuczna inteligencja może wygenerować fałszywy raport z obrazowania diagnostycznego lub wynik badania laboratoryjnego aby uzasadnić roszczenie dotyczące wysokich kosztów leków onkologicznych. Ubezpieczyciele i systemy opieki zdrowotnej stoją w obliczu zalewu takich roszczeń. papiery syntetyczneco utrudnia odróżnienie uzasadnionych roszczeń od fałszywych. W Wielkiej Brytanii ubezpieczyciele odnotowują szybko rosnące wykorzystanie podróbek i sfałszowanych dokumentów w oszustwach związanych z roszczeniamiczęsto w pozornie rutynowych roszczeniach o niskiej wartości, aby uniknąć kontroli[27]. Nawet obrazy kliniczne nie są odporne - istnieją dowody na to, że Oszuści wykorzystują generatywną sztuczną inteligencję do naśladowania obrazów medycznych jak zdjęcia rentgenowskie lub skany[3]. Konsekwencje wykraczają poza straty finansowe: jeśli sfałszowana dokumentacja medyczna trafi do akt pacjenta, może prowadzić do błędnych diagnoz lub niewłaściwego leczenia. Tak więc, Dokumenty zdrowotne napisane przez sztuczną inteligencję stanowią poważne zagrożenie dla integralności i bezpieczeństwa.

Sfałszowane recepty i oszustwa apteczne

Oszustwa związane z receptami wkroczyły w erę cyfrową dzięki sztucznej inteligencji. Sfałszowane recepty - tradycyjnie wykonywane przy użyciu skradzionych bloczków recept lub podstawowej edycji - teraz mogą być automatycznie generowane z realistycznymi szczegółami i podpisami lekarzy. Generatory obrazów AI lub szablony sprawiają, że tworzenie jest banalnie proste. autentycznie wyglądające wydruki e-recept lub formularze zamówień w aptekach. Co gorsza, przestępcy wykorzystują klonowanie głosu do podszywania się pod lekarzy w rozmowach z farmaceutami. W jednym ze zgłoszonych przypadków oszuści włamali się do dokumentacji medycznej w celu kradzieży numerów rejestracyjnych DEA lekarzy, a następnie wykorzystali te dane uwierzytelniające do wysyłania elektronicznych recept na substancje kontrolowane[28]. Zdarzały się przypadki Fałszywy głos AI używany do autoryzacji doładowań - farmaceuta otrzymuje telefon, który brzmi dokładnie tak, jak znany lekarz potwierdzający receptę, ale w rzeczywistości jest to głos wygenerowany przez sztuczną inteligencję. W rezultacie leki kontrolowane (takie jak opioidy lub stymulanty) mogą być nielegalnie pozyskiwane i rozprowadzane. Oszustwa związane ze sfałszowanymi receptami nie tylko powodują straty finansowe dla ubezpieczycieli i aptek, ale także zagrażają pacjentom, którzy mogą otrzymać nieprawidłowe leki. Na przykład, jeśli oszust podszywa się pod pacjenta w celu uzyskania recept na opioidy, to Dokumentacja medyczna prawdziwego pacjenta może zostać zaktualizowana o leki, których nigdy nie przyjmował, co może prowadzić do niebezpiecznych interakcji lub oznaczenia go jako osoby poszukującej narkotyków.[29]. To połączenie cyberprzestępczości i wykorzystywania sztucznej inteligencji wywołało ostrzeżenia ze strony organów regulacyjnych. Organizacje opieki zdrowotnej muszą teraz weryfikować, czy każda recepta - zwłaszcza na leki wysokiego ryzyka - jest legalna i zgodna z prawem. naprawdę pochodzi od autoryzowanego dostawcya nie deepfake czy naruszenie danych.

Fałszywe podszywanie się pod lekarza i pacjenta

Być może najbardziej rzucającą się w oczy zmianą jest wykorzystanie podszywanie się pod personel medyczny lub pacjentów. W telemedycynie i obsłudze klienta oszuści wykorzystują generowane przez sztuczną inteligencję wideo i audio, aby oszukać osoby po drugiej stronie. Na przykład, przestępcy stworzyli Fałszywe nagrania wideo pacjentów za konsultacje telezdrowia, oszukując lekarzy w celu zapewnienia "leczenia" lub skierowań, które są następnie rozliczane z ubezpieczycielem.[30][31]. I odwrotnie, oszust może podrobić wizerunek lekarza - używając twarzy i głosu renomowanego lekarza - w rozmowie wideo w celu przekonać pacjenta do zapłacenia za oszukańczą usługę lub ujawnienia danych osobowych. Eksperci IT w służbie zdrowia ostrzegają, że telezdrowie stało się dojrzałym celemMożna umówić się na wirtualną wizytę przy użyciu fałszywej tożsamości pacjenta, a następnie poprosić awatara AI, by pod fałszywym pretekstem uzyskał receptę lub poradę medyczną.[31][32]. Poza telemedycyną, deepfakes nasycają media społecznościowe w postaci Filmy "lekarskie" promujące cudowne leki. W 2024 r. eksperci zauważyli, że głęboko sfałszowane filmy znanych lekarzy "naprawdę wystartował" skierowany do starszych odbiorców z fałszywymi poradami zdrowotnymi i oszukańczymi produktami[33][34]. Zaufani lekarze telewizyjni w Wielkiej Brytanii i Francji zostali sklonowani, aby promować fałszywe leki na cukrzycę i suplementy na ciśnienie krwi[35][36]. Nawet połowa widzów nie była w stanie stwierdzić, że te fałszywe filmy medyczne są fałszywe[37]. Ta erozja prawdy pociąga za sobą wymierne koszty: pacjenci mogą stosować się do szkodliwych porad z fałszywych filmów wideo lekarzy lub oszuści mogą wystawiać ubezpieczycielom rachunki za konsultacje, które nigdy nie miały miejsca, z wyjątkiem fałszywych nagrań. Podsumowując, Podszywanie się pod sztuczną inteligencję podważa fundamentalne zaufanie w interakcjach związanych z opieką zdrowotną. - Jeśli nie można ufać, że osoba na ekranie lub telefonie jest tym, za kogo się podaje, cały system jest zagrożony.

Wpływ i skala: Oszustwa 2025 według liczb

Oszustwa oparte na sztucznej inteligencji nie są już kwestią marginalną - obecnie stanowią poważne zagrożenie finansowe i zagrożenie dla bezpieczeństwa w globalnych systemach opieki zdrowotnej. Rozważmy następujące najnowsze statystyki i przypadki ilustrujące skala problemu:

- Roczne straty: Oszustwa związane z opieką zdrowotną kosztują USA szacunkowo $68 miliardów lub więcej każdego roku[25]mniej więcej 3-10% wszystkich wydatków na opiekę zdrowotną[38]. W skali globalnej oszustwa mogą pochłonąć ok. 6% wydatków na opiekę zdrowotną[39] - Jest to oszałamiająca liczba, biorąc pod uwagę, że światowe wydatki na opiekę zdrowotną sięgają bilionów dolarów. Straty te ostatecznie przekładają się na wyższe składki, zwiększone koszty hospitalizacji i zmniejszone zasoby na opiekę nad pacjentami.

- Wzrost liczby oszustw w latach 2023-2025: Pojawienie się generatywnej sztucznej inteligencji doprowadziło do eksplozji prób oszustw. Liczba incydentów związanych z oszustwami Deepfake wzrosła dziesięciokrotnie w latach 2022-2023[4]. W 2024 r. liczba zgłoszonych incydentów deepfake wzrosła do 150 (wzrost o 257%)[40]a rok 2025 jest na dobrej drodze, aby znacznie przekroczyć tę liczbę (580 incydentów w pierwszej połowie 2025 r., prawie 4 razy więcej niż w 2024 r.).[7]. Eksperci ds. oszustw zauważają, że 46% zetknęło się z oszustwami związanymi z syntetycznymi identyfikatorami, 37% z fałszerstwami głosu, a 29% z fałszerstwami wideo w ich dochodzeniach[8] - podkreślając, jak powszechne stały się te techniki sztucznej inteligencji.

- Rekordowe obalenia: Organy ścigania reagują coraz większymi represjami. W czerwcu 2025 r. amerykański Departament Sprawiedliwości ogłosił, że największe w historii oszustwo związane z opieką zdrowotnąobciążając 324 osoby i ujawniając $14,6 mld w nieuczciwych roszczeniach[1][13]. Schematy obejmowały oszustwa związane z konsultacjami telezdrowia, oszustwa związane z testami genetycznymi i oszustwa związane z trwałym sprzętem medycznym na masową skalę[13]. W ramach tych wysiłków Medicare zawieszone $4 miliardów w oczekujących wypłatach uznane za podejrzane[41]zapobiegając tym stratom. Jedna z kluczowych spraw ("Operacja Gorączka Złota") ujawniła międzynarodowy pierścień wykorzystujący skradzione tożsamości do składania $10,6 miliarda fałszywych roszczeń dotyczących materiałów medycznych[42] - Świadczy to o tym, jak daleko posuną się przestępcy uzbrojeni w naruszone dane i automatyzację.

- Wpływ na ubezpieczyciela: Ubezpieczyciele na całym świecie obserwują wzrost liczby oszustw związanych ze sztuczną inteligencją. W Wielkiej Brytanii ubezpieczyciele donoszą, że podróbki są coraz częściej wykorzystywane w roszczeniach (często są to roszczenia typu "low touch", aby uniknąć wykrycia).[27]. Wiodąca firma reasekuracyjna ostrzega, że sfałszowana dokumentacja medyczna i fałszywe warunki zdrowotne podważają wiarygodność ubezpieczeniową i mogą zwiększyć straty w ubezpieczeniach na życie i zdrowotnych.[43]. Analiza Deloitte z 2024 r. przewidywała, że do 2027 r, oszustwa generowane przez sztuczną inteligencję mogą odpowiadać za $40 mld rocznych strat w USA. (wzrost z $12,3 mld euro w 2023 r.)[8]. Taka trajektoria oznacza znaczny wpływ na wyniki finansowe ubezpieczycieli, jeśli nie zostaną przyjęte solidne środki zaradcze.

- Ofiary wśród pacjentów: Pacjenci i społeczeństwo również tracą pieniądze w wyniku tych oszustw. W szczególności osoby starsze stały się celem oszustw głosowych z wykorzystaniem sztucznej inteligencji (połączenia telefoniczne typu "wnuczek w niebezpieczeństwie") i oszustw związanych z fałszywymi informacjami zdrowotnymi. W 2023 r. amerykańscy seniorzy zgłosili $3.4 mld w stratach spowodowanych oszustwami, co stanowi wzrost o 11% w porównaniu z rokiem poprzednim[44][45] - niektóre z nich są napędzane przez systemy wspomagane przez sztuczną inteligencję. Poza kosztami pieniężnymi, istnieje również koszt ludzkiOszukańcze porady medyczne i fałszywe metody leczenia reklamowane za pośrednictwem sztucznej inteligencji mogą prowadzić do obrażeń fizycznych lub utraty zaufania do legalnych wytycznych dotyczących opieki zdrowotnej.

Ogólnie rzecz biorąc, rok 2025 jasno pokazał, że Sztuczna inteligencja przyspiesza tradycyjne oszustwa związane z opieką zdrowotną. To, co kiedyś było mniejszymi, oportunistycznymi schematami, przekształciło się w uprzemysłowione operacje obejmujące kontynenty. Połączenie dużych zbiorów danych (często pochodzących z naruszeń) i sztucznej inteligencji oznacza, że oszustwa mogą być wdrażane z przerażającą szybkością i wiarygodnością. Globalne straty liczone są w dziesiątkach miliardów i wciąż rosnąZagrożeni są wszyscy interesariusze - od szpitali i ubezpieczycieli po pacjentów. W następnej sekcji omówiono, w jaki sposób branża może walczyć, wykorzystując równie zaawansowane technologie i strategie.

Obrona przed oszustwami opartymi na sztucznej inteligencji: Strategie i rozwiązania

Przeciwdziałanie oszustwom związanym z opieką zdrowotną z wykorzystaniem sztucznej inteligencji wymaga arsenału równie zaawansowanych środków obrony. Kierownictwo służby zdrowia, zespoły ds. cyberbezpieczeństwa, specjaliści ds. zgodności i ubezpieczyciele muszą koordynować działania, aby wdrożenie środków zapobiegających oszustwom w każdym wrażliwym punkcie - od przyjęcia pacjenta do wypłaty odszkodowania. Poniżej znajdują się kluczowe strategie i rozwiązania techniczne mające na celu przeciwdziałanie oszustwom opartym na sztucznej inteligencji:

- Narzędzia do wykrywania treści AI: Podobnie jak przestępcy wykorzystują sztuczną inteligencję do tworzenia treści, organizacje mogą wykorzystywać sztuczną inteligencję do ich wykrywania. Zaawansowane Detektory treści napisane przez sztuczną inteligencję (takie jak pakiet TruthScan) analizują tekst, obrazy, audio i wideo w celu zidentyfikowania charakterystycznych oznak generowania przez sztuczną inteligencję. Przykładowo, platforma TruthScan wykorzystuje uczenie maszynowe do wykrywania wzorców statystycznych i dziwactw językowych, które wskazują na tekst wygenerowany przez sztuczną inteligencję. Dokładność 99%[46][47]. Narzędzia te można zintegrować z systemami zarządzania roszczeniami lub elektroniczną dokumentacją medyczną, aby automatycznie oznaczać podejrzane dokumenty - np. raport medyczny, który prawdopodobnie został napisany przez ChatGPT - do ręcznego przeglądu. Podobnie, kryminalistyka obrazu AI może wykrywać zmanipulowane skany medyczne lub fałszywe dokumenty tożsamości, a algorytmy głębokiego wykrywania podróbek mogą analizować filmy pod kątem oznak syntezy (artefakty w pikselach, dziwne czasy ruchów twarzy itp.).[48][49]. Wdrażając multimodalne detektory AI, organizacje opieki zdrowotnej mogą ekranowanie dużej części treści stworzonych przez sztuczną inteligencję w czasie rzeczywistym zanim spowoduje szkody.

- Weryfikacja dokumentacji medycznej i dokumentów: Dostawcy usług medycznych zwracają się ku specjalistycznym rozwiązaniom, aby weryfikować autentyczność zapisów i dokumentów dotyczących roszczeń. Obejmuje to haszowanie i cyfrowe podpisywanie legalnych rekordów, a także korzystanie z baz danych znanych dobrych szablonów dokumentów do porównywania ze zgłoszeniami. Usługi weryfikacji oparte na sztucznej inteligencji (na przykład TruthScan's Uwierzytelnianie dokumentów medycznych rozwiązanie) może natychmiast przeanalizować zawartość i metadane dokumentu w celu ustalenia, czy został on wygenerowany maszynowo lub zmieniony[50][51]. Zwracają uwagę na niespójności, które człowiek mógłby przeoczyć - takie jak subtelne anomalie formatowania lub metadane wskazujące, że obraz został wyprodukowany przez sztuczną inteligencję. Monitorowanie dokumentacji pacjentów i roszczeń ubezpieczeniowych w czasie rzeczywistym dla anomalii jest również niezbędna[52]. Dzięki ciągłemu skanowaniu nowych wpisów (wyników badań laboratoryjnych, notatek lekarskich, załączników do wniosków), systemy te mogą wychwytywać fałszywe rekordy przed prowadzą do nieuczciwych wypłat lub błędów klinicznych. Niektórzy ubezpieczyciele wdrożyli zasady, zgodnie z którymi każda dokumentacja roszczenia zidentyfikowana jako wygenerowana przez sztuczną inteligencję jest automatycznie pobierana w celu zbadania oszustwa. Celem jest zapewnienie, że każda dokumentacja medyczna lub wniosek, które trafiają do obiegu pracy, są wiarygodne i niezmienione.

- Potwierdzanie i weryfikacja tożsamości: Wzmocnienie weryfikacji tożsamości ma kluczowe znaczenie w dobie syntetycznych dokumentów tożsamości. Podmioty opieki zdrowotnej powinny egzekwować rygorystyczne potwierdzanie tożsamości nowych pacjentów, usługodawców i sprzedawców. Może to obejmować uwierzytelnianie wieloskładnikowe, kontrole biometryczne (takie jak rozpoznawanie twarzy lub odcisków palców podczas rejestracji) oraz korzystanie z usług weryfikacji tożsamości, które wykorzystują sztuczną inteligencję do wykrywania Fałszywe dokumenty tożsamości lub niezgodne dane osobowe. Na przykład, rozpoznawanie twarzy może być połączone z testami żywotności, aby zapobiec sytuacji, w której twarz wygenerowana przez sztuczną inteligencję zostanie uznana za prawdziwego pacjenta za pomocą zdjęcia. Z drugiej strony algorytmy mogą weryfikować dane pacjenta (adres, telefon, adres e-mail, obecność w mediach społecznościowych), aby wykryć "cienkie" tożsamości, które nie mają normalnej historii - znanej z syntetycznych identyfikatorów[53]. Instytucje finansowe wykorzystują takie oparte na sztucznej inteligencji kontrole spójności tła z doskonałym skutkiem[54]Opieka zdrowotna może zrobić to samo: np. oznaczyć nowego wnioskodawcę Medicare, jeśli nie ma on cyfrowego śladu sprzed tego roku. Weryfikacja tożsamości dostawcy Równie ważne jest upewnienie się, że lekarz na filmie telezdrowia jest licencjonowany i faktycznie jest tym, za kogo się podaje, być może poprzez wydawanie cyfrowych certyfikatów lub kanałów wideo ze znakami wodnymi, które są trudne do naśladowania przez deepfake. W aptekach personel powinien dwukrotnie sprawdzać nietypowe prośby o receptę poprzez bezpośrednie połączenia telefoniczne z dostawcami i używać fraz kodowych lub pytań weryfikacyjnych, aby pokonać potencjalnych oszustów głosowych AI.

- Zintegrowane wykrywanie oszustw w przepływach pracy: Aby naprawdę chronić system, wykrywanie nadużyć nie może być samodzielnym krokiem - musi to być wplecione w każdy przepływ pracy w organizacji ochrony zdrowia.

W praktyce oznacza to, że szpitale i ubezpieczyciele wdrażają integracje API w celu wywoływania usług wykrywania oszustw w krytycznych momentach. Na przykład, gdy dostawca składa wniosek z załączonymi dokumentami, usługa AI może automatycznie ocenić te załączniki pod kątem autentyczności w ciągu kilku sekund. Jeśli zainicjowana zostanie wizyta telezdrowia, platforma może uruchomić pasywną analizę głosu w tle, aby upewnić się, że dzwoniący nie używa syntetyzowanego głosu. Ciągłe monitorowanie Nowoczesne platformy do zwalczania nadużyć oferują pulpity nawigacyjne, które śledzą sygnały nadużyć w całej organizacji (nieudane walidacje, częste oznaczanie roszczeń określonej kliniki itp.) w celu identyfikacji wzorców, takich jak zorganizowany pierścień oszustw działający na wielu roszczeniach. Traktując oszustwa związane z opieką zdrowotną bardziej jak cyberzagrożenia - z Monitorowanie 24/7, wykrywanie anomalii i szybkie reagowanie na incydenty - organizacje mogą wychwycić problemy, zanim wpadną w spiralę[55].

- Sztuczna inteligencja do analizy oszustw i rozpoznawania wzorców: Ilość danych dotyczących opieki zdrowotnej jest tak duża, że sztuczna inteligencja jest niezbędna do znajdowania wzorców oszustw, których ludzie nie dostrzegają. Modele uczenia maszynowego mogą być szkolone na historycznych przypadkach oszustw, aby wykrywać nowe (na przykład grupowanie roszczeń, które mają podobne nietypowe kody ICD lub identyfikowanie, kiedy rozliczenia jednego lekarza znacznie odbiegają od innych). Ubezpieczyciele już teraz wykorzystują analitykę predykcyjną do Ocena roszczeń pod kątem ryzyka oszustwa w czasie rzeczywistym. Nowe techniki, takie jak sieci neuronowe grafów, mogą mapować relacje między pacjentami, dostawcami, diagnozami i roszczeniami w celu wykrycia nieprawdopodobnych powiązań (takich jak ten sam numer seryjny urządzenia używany w roszczeniach z różnych stanów). Pakiet TruthScan do wykrywania oszustw ubezpieczeniowych obejmuje na przykład rozpoznawanie wzorców roszczeń i modelowanie predykcyjne w celu wychwytywania zorganizowanych pierścieni oszustw i nietypowych wzorców, zanim straty się skumulują.[56][57]. Centrum Fusion Departamentu Sprawiedliwości w 2025 r. było przykładem tego podejścia - agregowania danych z Medicare i prywatnych ubezpieczycieli w celu proaktywnego znajdowania skupisk podejrzanych działań[58]. Organizacje opieki zdrowotnej powinny również udostępnianie danych i modeli AI w konsorcjach, aby poszerzyć zakres sygnałów oszustw, które każdy z nich może wykryć. Im więcej danych (w granicach prywatności) zasila te modele, tym lepiej radzą sobie one z rozróżnianiem zachowań normalnych od nieuczciwych.

- Szkolenie personelu i kontrola procesów: Technologia ma kluczowe znaczenie, ale ludzka świadomość pozostaje potężną obroną. Personel medyczny i administratorzy powinni zostać przeszkoleni w zakresie taktyk oszustw wykorzystujących sztuczną inteligencję - na przykład wiedząc, że Idealnie napisany e-mail od CEO może być phishingiem stworzonym przez sztuczną inteligencjęlub że powinni weryfikacja tożsamości rozmówców wideo jeśli coś wydaje się "nie tak" (dziwne ruchy gałek ocznych lub opóźnienie dźwięku mogą wskazywać na deepfake). Regularne ćwiczenia i wskazówki (podobne do szkolenia w zakresie świadomości phishingu) mogą być wdrażane w przypadku nowych zagrożeń, takich jak oszustwa telefoniczne typu deepfake. Proste kontrole procesów dodają warstwy bezpieczeństwa: wymaganie oddzwaniania lub dodatkowej weryfikacji w przypadku dużych lub nietypowych żądań płatności, korzystanie ze znanych bezpiecznych kanałów komunikacji w przypadku wrażliwych informacji oraz utrzymywanie planu reagowania na incydenty specjalnie w przypadku podejrzenia oszustwa za pośrednictwem sztucznej inteligencji. Co ważne, organizacje powinny kultywować kulturę, w której pracownicy czują się upoważnieni do kwestionowania nieprawidłowościNawet jeśli jest to "lekarz" na wideo proszący o dziwną prośbę. Wiele oszustw typu deepfake udaje się wykorzystać zaufanie i autorytet; czujni pracownicy, którzy wiedzą o tych sztuczkach, mogą wcześnie powstrzymać incydenty. Jak zauważył jeden z ekspertów, konfrontacja z deepfake'ami może stać się tak rutynowa, jak wykrywanie wiadomości phishingowych - standardową częścią higieny cyberbezpieczeństwa[32][59].

- Wykorzystanie specjalistycznych usług: Biorąc pod uwagę szybką ewolucję zagrożeń związanych ze sztuczną inteligencją, wiele organizacji opieki zdrowotnej współpracuje z wyspecjalizowanymi dostawcami usług zapobiegania oszustwom. Usługi takie jak TruthScan dla służby zdrowia oferuje kompleksowe rozwiązania dostosowane do zastosowań medycznych, w tym: monitorowanie w czasie rzeczywistym integralności elektronicznej dokumentacji medycznej (EMR), weryfikacja dokumentów pacjenta przeciwko manipulacjom AI, wykrywanie deepfake dla telezdrowia i raportowanie zgodności (np. ścieżki audytu, które dowodzą należytej staranności w wykrywaniu oszustw dla organów regulacyjnych).[60][51]. Takie platformy często zapewniają Integracja API bezproblemowe dopasowanie do istniejących systemów i zgodność z przepisami dotyczącymi opieki zdrowotnej (HIPAA, RODO)[61][62]. Korzystając z narzędzi klasy korporacyjnej, nawet mniejsze kliniki lub regionalni ubezpieczyciele mogą uzyskać dostęp do zaawansowanych możliwości wykrywania AI bez konieczności opracowywania ich we własnym zakresie. Ponadto ubezpieczyciele i dostawcy usług powinni zwracać uwagę na aktualizacje przepisów i standardów branżowych - na przykład nowe przepisy dotyczące oszustw typu deepfake (niektóre jurysdykcje wyraźnie zakazują obecnie medycznych deepfake'ów, a Stany Zjednoczone rozszerzają przepisy dotyczące kradzieży tożsamości, aby objąć nimi podszywanie się pod sztuczną inteligencję).[63]). Dostosowanie się do takich standardów i wdrożenie najnowocześniejszych narzędzi nie tylko zmniejszy straty związane z oszustwami, ale także zademonstruje silną pozycję w zakresie bezpieczeństwa partnerom, audytorom i pacjentom.

Wnioski i perspektywy

Rok 2025 pokazał, że Dżin wyszedł z butelki - Generatywna sztuczna inteligencja i automatyzacja są obecnie powiązane z oszustwami związanymi z opieką zdrowotną. W przyszłości oszuści będą prawdopodobnie nadal wprowadzać innowacje: możemy zobaczyć modele sztucznej inteligencji, które uczą się naśladować style pisania określonych lekarzy lub deepfake, które reagują w czasie rzeczywistym na pytania dotyczące wyzwań. Bitwa będzie ciągłym wyścigiem zbrojeń. Jednak branża opieki zdrowotnej reaguje z równą energią, inwestując w mechanizmy obronne oparte na sztucznej inteligencji i ściślejsze przepływy pracy w zakresie bezpieczeństwa. Łącząc najnowocześniejsza technologia wykrywania, rygorystyczne procesy weryfikacji, międzybranżowa wymiana danych i czujność pracownikóworganizacje opieki zdrowotnej mogą znacznie złagodzić zagrożenie oszustwami wspieranymi przez sztuczną inteligencję.

Co najważniejsze, nie jest to tylko kwestia IT - to kwestia zarządzania i zaufania. Zarządy i kadra kierownicza w sektorze opieki zdrowotnej muszą uznać oszustwa związane ze sztuczną inteligencją za strategiczne ryzyko dla finansów i zaufania pacjentów, gwarantujące regularną uwagę i zasoby. Zespoły ds. zgodności z przepisami powinny zaktualizować oceny ryzyka nadużyć, aby uwzględnić aspekty AI, a ubezpieczyciele mogą ponownie przemyśleć założenia dotyczące gwarantowania emisji, wiedząc, że pewien procent roszczeń może być oszustwem wspomaganym przez AI. Z drugiej strony, etyczne wykorzystanie sztucznej inteligencji w opiece zdrowotnej (do wspomagania decyzji klinicznych, wydajności rozliczeń itp.) będzie nadal przynosić ogromne korzyści - o ile istnieją silne zabezpieczenia zapobiegające nadużyciom.

Podsumowując, generatywna sztuczna inteligencja zmieniła grę w oszustwa w opiece zdrowotnej, ale dzięki świadomości i zaawansowanym środkom zaradczym nie musi przytłaczać systemu. Organizacje, które odniosą sukces, będą tymi, które będą na bieżąco informowane o pojawiających się zagrożeniach, szybko dostosują się do nich dzięki mechanizmom obronnym opartym na sztucznej inteligencji i będą wspierać kulturę "weryfikacji i zaufania", a nie "domyślnego zaufania". W ten sposób opieka zdrowotna może bezpiecznie wykorzystać zalety sztucznej inteligencji, jednocześnie neutralizując jej niewłaściwe użycie, chroniąc zarówno wyniki finansowe, jak i dobre samopoczucie pacjentów w erze cyfrowej.

Źródła: Najnowsze raporty branżowe i sprawy cytowane powyżej, w tym Pymnts (lipiec 2025 r.)[2][3], Instytut Swiss Re (czerwiec 2025 r.)[27], Bank Rezerwy Federalnej w Bostonie (kwiecień 2025)[19], BMJ (2024)[37]oraz briefy dotyczące rozwiązań TruthScan (2025)[51][64]między innymi. Wszystkie dane i cytaty odzwierciedlają najnowsze dane dostępne w latach 2024-2025, ilustrując obecny stan oszustw opartych na sztucznej inteligencji w opiece zdrowotnej i reakcje na ich zwalczanie.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] DOJ docenia narzędzia AI w historycznej walce z oszustwami w opiece zdrowotnej

[4] [5] [6] [7] [16] [40] [44] [45] Statystyki i trendy Deepfake 2025 | Kluczowe dane i spostrzeżenia - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes i kryzys wiedzy | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] Generacja AI zwiększa zagrożenie oszustwami związanymi z syntetyczną tożsamością - Bank Rezerwy Federalnej w Bostonie

[25] [26] [56] [57] [62] [64] Wykrywanie oszustw AI w ubezpieczeniach zdrowotnych i na życie | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Jak deepfake, dezinformacja i sztuczna inteligencja wzmacniają oszustwa ubezpieczeniowe | Swiss Re

[28] DEA ostrzega przed oszustwami związanymi z elektronicznymi receptami - Pharmacy Practice News

[29] [39] Cyberbezpieczeństwo i oszustwa w opiece zdrowotnej: A Deep Dive Into Today's Greatest Risks and Defenses | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] Ewoluujące zagrożenie oszustwami telemedycznymi Deepfake, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Eksperci ostrzegają przed oszustami wykorzystującymi "podróbki" znanych lekarzy w mediach społecznościowych

[35] [36] [37] Zaufani lekarze telewizyjni "podrabiani" w celu promowania oszustw zdrowotnych w mediach społecznościowych - BMJ Group

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] aktualny stan badań Ajit Appari i M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - wykrywanie AI w przedsiębiorstwie i bezpieczeństwo treści

[50] [51] [52] [60] [61] AI Medical Record Fraud Detection | Healthcare CRO Solutions | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Jak niebezpieczne są Deepfakes i inne oszustwa oparte na sztucznej inteligencji?