Wprowadzenie: Nowa era ataków opartych na sztucznej inteligencji

Rok 2025 wyznaczył punkt zwrotny w cyberbezpieczeństwie. Generatywna sztuczna inteligencja przyspieszyła cyberataki, umożliwiając podmiotom stanowiącym zagrożenie uruchamianie więcej częste, realistyczne i skalowalne kampanii niż kiedykolwiek wcześniej. Szacuje się, że w ciągu ostatniego roku 16% zgłoszonych incydentów cybernetycznych obejmowało atakujących wykorzystujących narzędzia AI (np. modele generowania obrazów i języka) w celu ulepszenia inżynierii społecznej[1]. Od niezwykle przekonujących wiadomości phishingowych po oszustwa typu deepfake audio/wideo, złośliwi aktorzy wykorzystują sztuczną inteligencję we wszystkich sektorach. Większość specjalistów ds. bezpieczeństwa przypisuje obecnie wzrost liczby cyberataków spowodowany generatywną sztuczną inteligencjąco daje złym aktorom szybsze i inteligentniejsze sposoby wykorzystywania ofiar[2]. Generatywna sztuczna inteligencja skutecznie obniża poprzeczkę umiejętności dla cyberprzestępców, jednocześnie zwiększając ich potencjał.

Dlaczego jest to tak niepokojące? Sztuczna inteligencja może błyskawicznie tworzyć dopracowane, kontekstowe treści, które oszukują nawet przeszkolonych użytkowników. Może podszywać się pod głosy i twarze z przerażającą dokładnością, a nawet generować złośliwy kod, który zmienia się, aby uniknąć wykrycia. W rezultacie cyberataki stały się trudniejsze do wykrycia i łatwiejsze do przeprowadzenia. The Światowe Forum Ekonomiczne ostrzega, że 72% organizacji zaobserwowało zwiększone ryzyko cybernetyczne - zwłaszcza inżynierię społeczną i oszustwa - ze względu na rosnące możliwości generatywnej sztucznej inteligencji[3]. Potwierdzają to incydenty w świecie rzeczywistym: Na początku 2024 roku przestępcy użyli wygenerowanego przez sztuczną inteligencję Fałszywe połączenie wideo podszyć się pod dyrektora finansowego firmy i nakłonić pracownika do przeniesienia $25,6 mln dla oszustów[4]. W innym przypadku hakerzy z Korei Północnej wykorzystali Fałszywe dokumenty tożsamości generowane przez sztuczną inteligencję aby ominąć kontrole bezpieczeństwa w obronnej kampanii phishingowej[5]. Przykłady te podkreślają stawkę - generatywna sztuczna inteligencja umożliwia oszustwa, które omijają zarówno ludzką, jak i techniczną kontrolę.

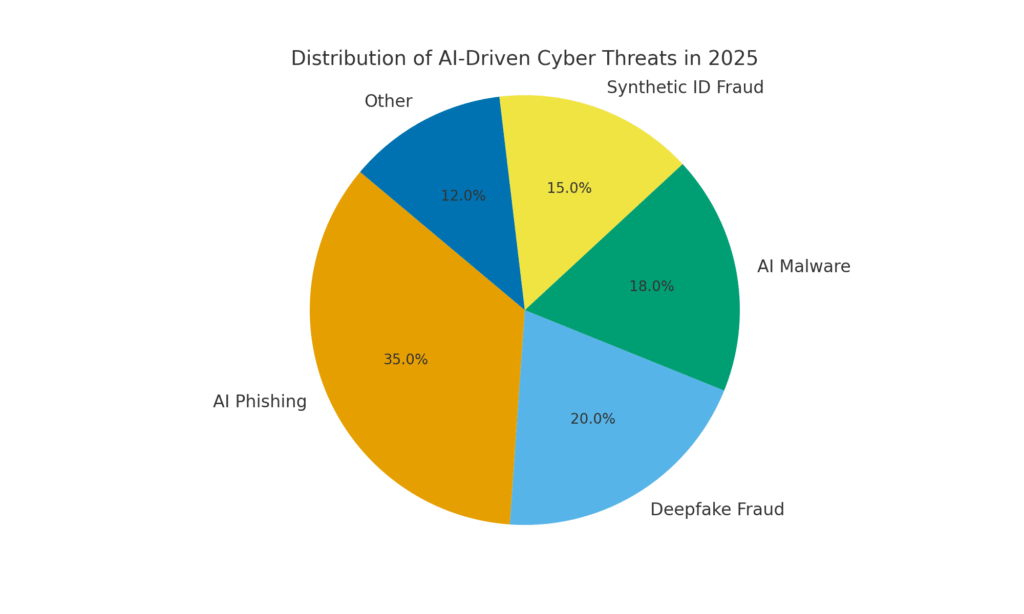

Sztuczna inteligencja jest jednak również częścią rozwiązania. Zaawansowane narzędzia wykrywające (takie jak te od TruthScan) wykorzystują sztuczną inteligencję przeciwko Sztuczna inteligencja - analiza treści pod kątem subtelnych sygnatur generowania maszynowego. W tym oficjalnym dokumencie przeanalizujemy najważniejsze cyberzagrożenia oparte na sztucznej inteligencji w 2025 r. oraz sposoby, w jakie organizacje mogą je złagodzić. Od Phishing generowany przez sztuczną inteligencję do Oszustwo CEO deepfake, Złośliwe oprogramowanie stworzone przez sztuczną inteligencję, syntetyczne tożsamościi nie tylko, zbadamy, w jaki sposób generatywna sztuczna inteligencja przekształca ataki. Omówimy również konkretne środki obronne, w tym Wykrywanie zawartości za pomocą sztucznej inteligencji, deepfake forensics i technologie weryfikacji tożsamości, które mogą pomóc zespołom ds. bezpieczeństwa odzyskać przewagę. Celem jest wyjaśnienie, w jaki sposób przedsiębiorstwa, MSSP, CISO i śledczy ds. oszustw mogą integracja narzędzi do wykrywania sztucznej inteligencji w całym stosie cyberbezpieczeństwa aby przeciwdziałać tej fali zagrożeń opartych na sztucznej inteligencji.

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

Phishing i BEC generowane przez sztuczną inteligencję: oszustwa na niespotykaną dotąd skalę

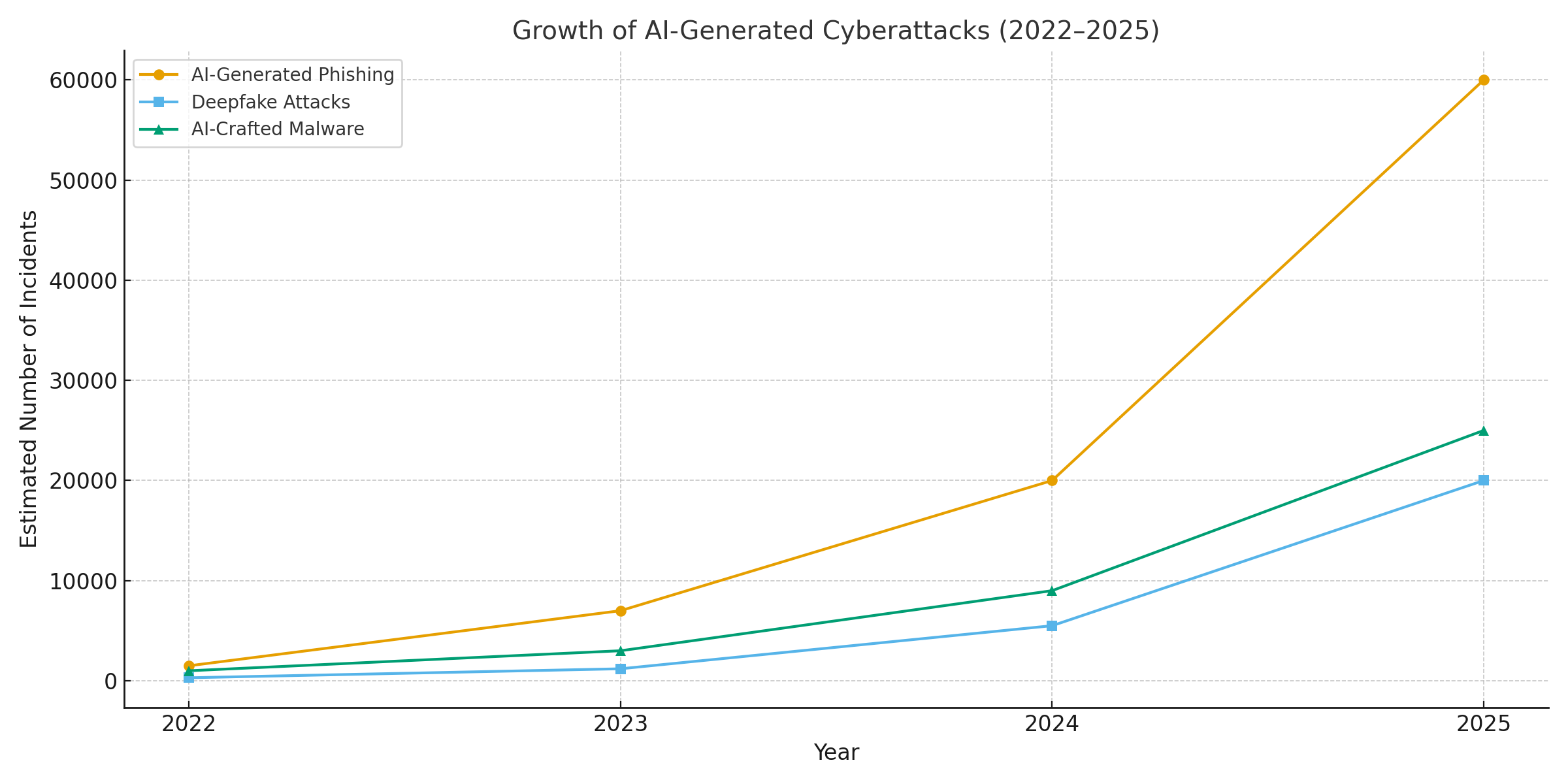

Jednym z najwyraźniejszych skutków generatywnej sztucznej inteligencji jest phishing i cyberprzestępczość. kompromitacja biznesowej poczty e-mail (BEC) schematy. Modele językowe oparte na sztucznej inteligencji mogą tworzyć płynne, kontekstowo dostosowane wiadomości e-mail w ciągu kilku sekund - eliminując charakterystyczne błędy gramatyczne i niezręczne sformułowania, które kiedyś zdradzały phishing. Rezultatem jest zalew wysoce przekonujących wiadomości e-mail i SMS-ów. Do kwietnia 2025 r, ponad połowa wiadomości spamowych (51%) została napisana przez sztuczną inteligencjęwzrost z praktycznie zera dwa lata wcześniej[6]. Co jeszcze bardziej niepokojące, naukowcy odkryli, że około 14% wiadomości e-mail dotyczących ataków BEC zostało wygenerowanych przez sztuczną inteligencję do 2025 r.[7] - a liczba ta będzie rosnąć w miarę jak przestępcy będą korzystać z narzędzi takich jak ChatGPT. Niektóre badania szacują ponad 80% wiadomości phishingowych może teraz korzystać z pomocy sztucznej inteligencji w ich tworzeniu[8].

Liczba tych przynęt generowanych przez sztuczną inteligencję eksplodowała. Analizy bezpieczeństwa pokazują, że ataki phishingowe związane z generatywną sztuczną inteligencją wzrosły o 1,265% w krótkim okresie[9]. W jednym okresie liczba zgłoszeń incydentów phishingowych wzrosła 466% w jednym kwartalew dużej mierze z powodu zautomatyzowanych zestawów phishingowych i botów wypompowujących spersonalizowane przynęty[9][10]. Skąd taki wzrost? Ponieważ AI pozwala atakującym skala ich operacje dramatycznie. Pojedynczy przestępca może użyć chatbota AI do wygenerowania tysiące spersonalizowanych oszukańczych wiadomości e-mail skierowanych do różnych pracowników lub klientów, a wszystko to w czasie potrzebnym na stworzenie jednej. Ta masowa automatyzacja doprowadziła FBI do ostrzeżenia, że straty BEC (które już w 2022 r. wyniosły $2,7 mld) tylko przyspieszą, ponieważ sztuczna inteligencja "grozi jeszcze większymi stratami"[11][12].

Nie tylko jest więcej wiadomości phishingowych, ale także bardziej efektywny. Ofiary są oszukiwane w większym stopniu dzięki dopracowanemu językowi i szczegółom kontekstowym, które może zawierać sztuczna inteligencja. W testach laboratoryjnych e-maile phishingowe napisane przez sztuczną inteligencję osiągnęły wynik 54% współczynnik klikalności - znacznie powyżej ~12% dla tradycyjnych prób phishingu[13]. Wiadomości te brzmią jak prawdziwy styl CEO lub odnoszą się do prawdziwych wydarzeń w firmie, obniżając czujność odbiorców. Atakujący używają nawet sztucznej inteligencji do testowania A/B różnych sformułowań i iteracji najbardziej skutecznych haczyków[14]. W przeciwieństwie do ludzi, sztuczna inteligencja nie popełnia literówek i nie męczy się - może wyrzucać z siebie nieskończoną liczbę wariantów, aż któryś prześlizgnie się przez filtry i kogoś oszuka.

Przykład w punkt: W połowie 2025 r. Reuters Dochodzenie ujawniło, w jaki sposób oszuści z Azji Południowo-Wschodniej wykorzystali ChatGPT do zautomatyzowania komunikacji związanej z oszustwami.[15]. Masowo generowali przekonujące e-maile bankowe i SMS-y do obsługi klienta, znacznie zwiększając zasięg swoich programów. Europejska policja podobnie donosiła o zestawach phishingowych opartych na sztucznej inteligencji sprzedawanych w ciemnej sieci za mniej niż $20, umożliwiając nisko wykwalifikowanym aktorom uruchamianie wyrafinowanych kampanii[16][17]. Bariera wejścia dla BEC i phishingu zasadniczo wyparowała.

Środki obronne - powstrzymywanie phishingu AI: Biorąc pod uwagę ten atak, organizacje muszą wzmocnić swoje kanały e-mail i wiadomości. To właśnie tutaj Wykrywanie zawartości za pomocą sztucznej inteligencji może pomóc. Narzędzia takie jak Detektor tekstu AI TruthScan i wyspecjalizowane skanery poczty e-mail może analizować przychodzące wiadomości pod kątem statystycznych markerów tekstu generowanego przez sztuczną inteligencję. Na przykład Wykrywacz oszustw e-mail TruthScan wykorzystuje analizę języka naturalnego do oznaczania wiadomości e-mail, które prawdopodobnie pochodzą od sztucznej inteligencji, nawet jeśli wyglądają na legalne[18]. Detektory te badają takie rzeczy, jak perfekcyjnie dopracowana gramatyka, złożoność zdań i wzorce stylometryczne, które są nietypowe dla ludzkich pisarzy. Z Skanowanie w czasie rzeczywistymPodejrzane wiadomości e-mail mogą zostać poddane kwarantannie lub oznaczone do sprawdzenia, zanim dotrą do użytkowników. Zespoły ds. bezpieczeństwa w przedsiębiorstwach zaczynają wdrażać takie filtry oparte na sztucznej inteligencji na bramach e-mail i platformach komunikacyjnych. W praktyce dodaje to nową warstwę obrony do tradycyjnych filtrów antyspamowych - wyraźnie dostosowaną do wychwytywania treści napisanych przez sztuczną inteligencję. Od 2025 r. wiodące przedsiębiorstwa integrują rozwiązania takie jak TruthScan za pośrednictwem interfejsu API ze swoimi bezpiecznymi bramami poczty elektronicznej i pakietami do współpracy w chmurze, tworząc zautomatyzowany punkt kontrolny dla Phishing generowany przez sztuczną inteligencję zawartość.

Deepfake Voice & Video Impersonation: Oszustwo "widzenie jest mylące"

Być może najbardziej namacalnym zagrożeniem związanym ze sztuczną inteligencją w 2025 r. jest rozwój fałszywe ataki głosowe i wideo. Korzystając z modeli sztucznej inteligencji, przestępcy mogą sklonować głos danej osoby na podstawie zaledwie kilku sekund nagrania audio lub wygenerować realistyczny film przedstawiający czyjąś twarz na podstawie kilku zdjęć. Te głębokie podróbki są wykorzystywane do oszustw polegających na podszywaniu się pod inne osoby - od oszustw związanych z prezesami (połączenia "fałszywych prezesów") po fałszywe wideokonferencje i nie tylko. Niedawny raport branżowy ujawnił 47% organizacji doświadczyło ataków deepfake jakiegoś rodzaju[19]. I nie jest to tylko teoria: wielokrotne włamania w latach 2023-2025 dowiodły, że deepfake może pokonać ostateczne uwierzytelnienie - nasze własne oczy i uszy.

Jedna z niesławnych spraw dotyczyła międzynarodowego przelewu bankowego na kwotę $25 mln po tym, jak pracownik został oszukany przez fałszywą wideokonferencję. Atakujący wykorzystali sztuczną inteligencję do zsyntetyzowania podobieństwa do dyrektora finansowego firmy podczas rozmowy Zoom, wraz z jej głosem i manierami, instruując pracownika, aby przelał fundusze[4][20]. W innym incydencie w Australii samorząd lokalny stracił $2,3 miliona gdy oszuści podrobili zarówno głos, jak i wideo urzędników miejskich, aby zatwierdzić oszukańcze płatności[21]. Co niepokojące, przestępcy wykorzystują sklonowane przez sztuczną inteligencję głosy w "oszustwach dziadkowych" - dzwoniąc do seniorów i podszywając się pod ich krewnych w niebezpieczeństwie. The FBI i FinCEN pod koniec 2024 r. wydała ostrzeżenia o wzroście liczby oszustw z wykorzystaniem Generowane przez sztuczną inteligencję "fałszywe" mediaw tym fałszywi agenci obsługi klienta i syntetyczne tożsamości w celu ominięcia weryfikacji KYC.[22].

Częstotliwość przestępstw opartych na deepfake'ach szybko rośnie. Jedna z analiz wykazała, że do końca 2024 r. nowe oszustwo deepfake pojawiało się co pięć minut średnio[23]. W samym tylko pierwszym kwartale 2025 r. liczba zgłoszonych incydentów deepfake wzrosła o 19% w porównaniu do wszystko z 2024 r.[24][25]. Szacuje się, że podróbki stanowią obecnie 6,5% wszystkich ataków typu fraud, a 2,137% wzrost od 2022 r.[26][27]. Wymagana technologia stała się łatwo dostępna - często wymaga zaledwie 30 sekund dźwięku aby sklonować głos, lub poniżej godziny przykładowego nagrania, aby przekonująco wymodelować twarz osoby[20]. Krótko mówiąc, nigdy nie było łatwiej "podrobić" tożsamość zaufanej osoby i nakłaniają ofiary do przekazania pieniędzy lub informacji.

Środki obronne - uwierzytelnianie rzeczywistości: Aby przeciwdziałać zagrożeniom typu deepfake, organizacje zwracają się ku zaawansowanym wykrywanie nośników syntetycznych narzędzia. Na przykład, Detektor głosu AI firmy TruthScan i TruthScan Deepfake Detector wykorzystują sztuczną inteligencję do analizy audio i wideo pod kątem oznak manipulacji. Systemy te wykonują analizę klatka po klatce i analizę kształtu fali, aby wykryć artefakty, takie jak nienaturalne ruchy twarzy, problemy z synchronizacją ust lub nieregularności widma dźwięku, które zdradzają klip wygenerowany przez sztuczną inteligencję. W testach algorytmy TruthScan osiągnęły następujące wyniki 99%+ dokładność w identyfikowaniu głosów generowanych przez sztuczną inteligencję i wykrywał zmanipulowane klatki wideo w czasie rzeczywistym[28][29]. W rzeczywistości badacze z Genians Security Center wykorzystali niedawno kryminalistykę obrazu TruthScan do analizy fałszywego dowodu osobistego używanego przez północnokoreańskich hakerów - detektor głębokich fałszywych obrazów TruthScan oznaczył dokument jako nieautentyczny za pomocą 98% zaufanieudaremnienie próby spear-phishingu[5][30].

W celu praktycznej obrony przedsiębiorstwa wdrażają te funkcje wykrywania w kluczowych punktach węzłowych. Weryfikacja głosowa jest dodawany do przepływów pracy call center - np. gdy "klient" żąda dużego transferu przez telefon, dźwięk może zostać przepuszczony przez detektor deepfake głosu, aby upewnić się, że to naprawdę on (a nie mimika AI). Podobnie, platformy do wideokonferencji może zintegrować skanowanie deepfake na żywo strumieni wideo uczestników, aby wychwycić wszelkie syntetyczne twarze. Pakiet wykrywania deepfake TruthScan oferuje na przykład Analiza połączeń wideo w czasie rzeczywistym i uwierzytelnianie twarzy które można podłączyć do Zoom lub WebEx za pośrednictwem API[31][29]. Oznacza to, że jeśli ktoś próbuje dołączyć do spotkania przy użyciu stworzonego przez sztuczną inteligencję filmu przedstawiającego dyrektora generalnego, system może oznaczyć "możliwy deepfake", zanim zostaną wyrządzone jakiekolwiek szkody. Ponadto ważne transakcje często obejmują obecnie etap weryfikacji (pozapasmowy lub wieloczynnikowy), który może wykorzystywać uwierzytelnianie treści - np. wymagając krótkiego potwierdzenia głosowego, które jest następnie sprawdzane przez detektor głosu AI pod kątem autentyczności. Łącząc te narzędzia, firmy tworzą sieć bezpieczeństwa: nawet jeśli pracownicy zob. lub słyszeć coś prawdopodobnego, zakulisowy kryminalistyczny AI zakwestionuje jego rzeczywistość. W krajobrazie zagrożeń przesiąkniętym sztuczną inteligencją, "Nie ufaj - weryfikuj" staje się mantrą dla każdej komunikacji głosowej lub wideo związanej z pieniędzmi lub poufnym dostępem.

Złośliwe oprogramowanie stworzone przez sztuczną inteligencję i zaciemniony kod: Ewoluujące zagrożenia w kodzie

Wpływ sztucznej inteligencji nie ogranicza się do inżynierii społecznej - zmienia ona również grę w zakresie tworzenia złośliwego oprogramowania i unikania kodu ataku. W 2025 r. Threat Intelligence Group Google odkryła, że pierwsze szczepy złośliwego oprogramowania wykorzystujące sztuczną inteligencję podczas wykonanie w celu zmiany ich zachowania[32][33]. Jeden przykład, nazwany PROMPTFLUXBył to złośliwy skrypt, który faktycznie wywoływał interfejs API sztucznej inteligencji (model Google Gemini) w celu przepisywanie własnego kodu w locietworząc nowe, zaciemnione warianty w celu uniknięcia wykrycia przez programy antywirusowe.[34][35]. Ta ewolucja sztucznej inteligencji "just-in-time" oznacza skok w kierunku autonomicznego, polimorficznego złośliwego oprogramowania. Kolejna próbka, PROMPTSTEALwykorzystał asystenta kodowania sztucznej inteligencji do generowania jednowierszowych poleceń systemu Windows w celu kradzieży danych, zasadniczo zlecając części swojej logiki silnikowi sztucznej inteligencji w czasie rzeczywistym[36][37]. Te innowacje wskazują na przyszłość, w której złośliwe oprogramowanie może stale się zmieniać - podobnie jak ludzki pen-tester - aby pokonać mechanizmy obronne.

Nawet bez sztucznej inteligencji w locie, atakujący używają sztucznej inteligencji podczas programowania, aby tworzyć silniejszy złośliwy kod. Generatywna sztuczna inteligencja może tworzyć złośliwe oprogramowanie, które jest wysoce zaciemnionezawierające warstwy mylącej logiki, które utrudniają inżynierię wsteczną. Według raportów wywiadu o zagrożeniach, ponad 70% poważnych naruszeń w 2025 r. wiązało się z jakąś formą polimorficznego złośliwego oprogramowania który zmienia swoją sygnaturę lub zachowanie, aby uniknąć wykrycia[38]. Dodatkowo, 76% kampanii phishingowych stosują teraz taktyki polimorficzne, takie jak dynamiczne adresy URL lub ładunki przepisane przez sztuczną inteligencję[38]. Narzędzia takie jak oferta dark-web WormGPT i FraudGPT (nieograniczone klony ChatGPT) pozwalają nawet nie-ekspertom generować droppery złośliwego oprogramowania, keyloggery lub kod ransomware, po prostu opisując, czego chcą[39]. Rezultatem jest mnóstwo nowych wariantów złośliwego oprogramowania. Na przykład w 2024 r. złodziej informacji o nazwie BlackMamba pojawił się, który był w całości wygenerowane przez sztuczną inteligencjęużywając ChatGPT do pisania swojego kodu w segmentach - każde wykonanie tworzyło nieco inny plik binarny, myląc tradycyjne programy antywirusowe oparte na sygnaturach[38]. Badacze bezpieczeństwa zademonstrowali również polimorficzne koncepcje generowane przez sztuczną inteligencję, które mogą ominąć wiele zabezpieczeń punktów końcowych[40].

Co więcej, atakujący wykorzystują sztuczną inteligencję, aby dopracować swoje dostawa złośliwego oprogramowania. Sztuczna inteligencja może inteligentnie skryptować wiadomości phishingowe (jak omówiono), które zawierają linki do złośliwego oprogramowania. Może również pomagać w opracowywaniu exploitów - np. wykorzystując sztuczną inteligencję do znajdowania nowych luk w zabezpieczeniach lub optymalizacji kodu powłoki. Podmioty państwowe podobno wykorzystywały zaawansowane modele sztucznej inteligencji, aby pomóc w odkrywaniu exploitów zero-day i opracowywaniu złośliwego oprogramowania dostosowanego do celów[41]. Wszystkie te trendy oznaczają, że złośliwe oprogramowanie w 2025 roku będzie bardziej ukryte i adaptacyjne. Często "Współtworzony" ze sztuczną inteligencjąco utrudnia wykrycie przy użyciu konwencjonalnych reguł.

Środki obronne - AI vs. AI w obronie przed złośliwym oprogramowaniem: Obrona przed złośliwym oprogramowaniem stworzonym przez sztuczną inteligencję wymaga połączenia zaawansowanego wykrywania i analizy opartej na sztucznej inteligencji po stronie obronnej. Wiele organizacji rozszerza swoje ochrona punktów końcowych i EDR (Endpoint Detection & Response) z modelami AI/ML, które szukają wzorców zachowań kodu generowanego przez AI. Na przykład nagłe transformacje kodu na hoście lub nietypowe wzorce wywołań API mogą wskazywać na coś takiego jak regeneracja PROMPTFLUX. Podobnie monitorowanie sieci może wychwycić anomalie, takie jak złośliwe oprogramowanie docierające do usług AI (co nie jest "normalne" dla aplikacji użytkownika). Dostawcy szkolą detektory oparte na uczenie maszynowym w zakresie rodziny zidentyfikowanego do tej pory złośliwego oprogramowania wspomaganego przez sztuczną inteligencję, poprawiając rozpoznawanie tych nowych zagrożeń.

Jednym z pojawiających się rozwiązań jest zintegrowane skanowanie treści AI w potokach deweloperskich i kompilacyjnych. Oznacza to wykorzystanie detektorów opartych na sztucznej inteligencji do analizowania skryptów, kompilacji oprogramowania, a nawet zmian konfiguracji pod kątem złośliwej lub generowanej przez sztuczną inteligencję zawartości. Na przykład, Detektor czasu rzeczywistego TruthScan można wdrożyć nie tylko tekst - jego multimodalna analiza może potencjalnie oznaczać podejrzany kod lub pliki konfiguracyjne, rozpoznając, czy zostały one wygenerowane maszynowo przy użyciu wzorców zaciemniania.[42][43]. Zespoły programistów i MSSP zaczynają skanować skrypty infrastruktury jako kodu, dzienniki PowerShell i inne artefakty w poszukiwaniu oznak segmentów napisanych przez sztuczną inteligencję, które mogą wskazywać na rękę atakującego. Chociaż jest to dopiero rozwijający się obszar, jest obiecujący: w jednym przypadku zespół ds. bezpieczeństwa użył detektora sztucznej inteligencji, aby złapać zaciemniony plik zestawu phishingowego, który "wydawał się" wygenerowany przez sztuczną inteligencję i rzeczywiście był częścią ataku[44]. Kod pliku był zbyt skomplikowany i rozwlekły (cechy charakterystyczne generacji AI), a skan zawartości AI potwierdził wysokie prawdopodobieństwo, że nie został napisany przez człowieka[40].

Wreszcie, udostępnianie informacji o zagrożeniach skoncentrowanych na zagrożeniach związanych ze sztuczną inteligencją ma kluczowe znaczenie. Gdy Google GTIG publikuje szczegóły dotyczące złośliwego oprogramowania opartego na Prompt lub gdy badacze zgłaszają nowe techniki omijania sztucznej inteligencji, organizacje powinny wprowadzić je do swojej inżynierii wykrywania. Analityka behawioralna - szukając działań takich jak proces odradzający skrypt, który przepisuje kod tego samego procesu - może wychwycić anomalie, które wykazuje złośliwe oprogramowanie wspomagane przez sztuczną inteligencję. Krótko mówiąc, obrońcy muszą zwalczać ogień ogniem: wdrażać Narzędzia bezpieczeństwa oparte na sztucznej inteligencji które mogą dostosowywać się tak szybko, jak złośliwe oprogramowanie oparte na sztucznej inteligencji. Obejmuje to wszystko, od antywirusa z ulepszoną sztuczną inteligencją po analizę zachowań użytkowników, która może zidentyfikować, kiedy konto lub system zaczyna zachowywać się "niezupełnie ludzko". Wykorzystując sztuczną inteligencję do obrony, zespoły ds. bezpieczeństwa mogą przeciwdziałać przewadze szybkości i skali, jaką sztuczna inteligencja zapewnia atakującym.

Syntetyczne tożsamości i oszustwa napędzane sztuczną inteligencją

Przejście od złośliwego oprogramowania do świata oszustw: oszustwo związane z tożsamością syntetyczną eksplodowała dzięki generatywnej sztucznej inteligencji. Syntetyczne oszustwa związane z tożsamością polegają na tworzeniu fikcyjnych person poprzez łączenie prawdziwych i fałszywych danych (np. prawdziwy numer SSN + fałszywe nazwisko i dokumenty). Te tożsamości "Frankensteina" są następnie wykorzystywane do otwierania rachunków bankowych, ubiegania się o kredyt lub przechodzenia kontroli KYC - ostatecznie skutkując niespłaconymi pożyczkami lub praniem pieniędzy. Był to już jeden z najszybciej rozwijających się rodzajów oszustw, a sztuczna inteligencja dolała oliwy do ognia. Straty spowodowane oszustwami związanymi z syntetycznymi identyfikatorami przekroczyła $35 mld w 2023 r.[45]a na początku 2025 r. niektóre szacunki wskazywały prawie 25% wszystkich strat z tytułu oszustw bankowych wynikały z syntetycznych tożsamości[46]. Analitycy Experian stwierdzili, że ponad 80% nowych oszustw związanych z kontami na niektórych rynkach jest obecnie powiązany z syntetycznymi identyfikatorami[19] - Oszałamiające statystyki podkreślają, jak wszechobecne stało się to oszustwo.

Generatywna sztuczna inteligencja wzmacnia syntetyczne oszustwa na kilka sposobów. Po pierwsze, sztuczna inteligencja sprawia, że wyprodukowanie "dokumenty hodowlane" i cyfrowych śladów potrzebnych do sprzedaży fałszywej tożsamości. W przeszłości oszust mógł sfotografować dowód tożsamości lub ręcznie stworzyć fałszywe rachunki za media. Obecnie istnieją narzędzia do generowania autentycznie wyglądające zdjęcia profilowe, dokumenty tożsamości, paszporty, wyciągi bankowe, a nawet profile w mediach społecznościowych przy użyciu generatorów obrazów AI i modeli językowych[47][48]. Na przykład, można użyć sztucznej inteligencji do stworzenia realistycznego zdjęcia głowy osoby, która nie istnieje (zapobiegając łatwemu wyszukiwaniu odwrotnych obrazów) i wygenerować pasujące fałszywe prawo jazdy z tym zdjęciem. Sztuczna inteligencja może również symulować "oznaki życia" tożsamości - np. tworząc rejestry syntetycznych rodziców, adresy lub posty w mediach społecznościowych aby rozwinąć historię[49]. Bostoński Fed zauważył, że Gen AI może nawet produkować deepfake audio i wideo fałszywej osoby - Na przykład, syntetyczny użytkownik może "pojawić się" w filmie weryfikacyjnym selfie, wraz z unikalną twarzą i głosem, wszystkie wygenerowane przez sztuczną inteligencję[50].

Po drugie, sztuczna inteligencja pomaga oszustom zwiększanie skali swoich operacji. Zamiast podrabiać jedną lub dwie tożsamości na raz, mogą programowo generować setki lub tysiące kompletnych pakietów tożsamości i automatycznie wypełniać nowe wnioski o konto masowo[51][52]. Niektóre usługi dark web skutecznie oferują "Syntetyczne tożsamości jako usługa"wykorzystując automatyzację do tworzenia zweryfikowanych kont na sprzedaż. Na przykład podczas programów pomocy w związku z pandemią COVID-19 przestępcy wykorzystywali boty z tożsamościami wygenerowanymi przez sztuczną inteligencję do masowego ubiegania się o pożyczki i świadczenia, przytłaczając system fałszywymi wnioskodawcami. Zgodnie z projektami Juniper Research, globalny koszt oszustw związanych z tożsamością cyfrową (napędzanych przez te taktyki) wyniesie wzrost 153% do 2030 r. w porównaniu do 2025 r.[53].

Środki obronne - weryfikacja tożsamości w świecie sztucznej inteligencji: Tradycyjne metody potwierdzania tożsamości zmagają się z podróbkami stworzonymi przez sztuczną inteligencję. Aby się dostosować, organizacje przyjmują Wielowarstwowa weryfikacja tożsamości i zachowania wspierane przez sztuczną inteligencję. Kluczową warstwą jest zaawansowana kryminalistyka dokumentów i obrazów. Na przykład, Detektor obrazów AI TruthScan i Wykrywacz fałszywych dokumentów zapewniają możliwość analizowania przesłanych dokumentów tożsamości, selfie lub dokumentów pod kątem oznak syntezy lub manipulacji. Narzędzia te badają artefakty na poziomie pikseli, niespójności oświetlenia i metadane w celu ustalenia, czy obraz został wygenerowany przez sztuczną inteligencję lub zmanipulowany. Mogą wychwycić subtelne wskazówki - takie jak identyczne wzory tła ze zdjęć wygenerowanych przez GAN lub czcionki i odstępy na identyfikatorze, które nie pasują do żadnego znanego szablonu rządowego. Wdrażając takie detektory podczas wdrażania, banki mogą automatycznie oznaczać prawo jazdy lub selfie wnioskodawcy, jeśli jest ono prawdopodobnie wygenerowane przez sztuczną inteligencję (na przykład system TruthScan oznaczyłby fałszywy dowód wojskowy użyty w sprawie phishingu Kimsuky APT).[5]). Zgodnie z komunikatem prasowym TruthScan, ich platforma była wykorzystywana przez instytucje finansowe do weryfikacji autentyczności dokumentów na dużą skalę, identyfikując głębokie podróbki z niezwykle wysoką dokładnością[54].

Kolejną warstwą jest analityka behawioralna i kontrole porównawcze. Prawdziwe tożsamości mają głębię - lata historii, rejestry publiczne, aktywność w mediach społecznościowych itp. Tożsamości generowane przez sztuczną inteligencję, bez względu na to, jak dopracowane, często nie mają tych głębokich korzeni. Banki i pożyczkodawcy wykorzystują obecnie sztuczną inteligencję do krzyżowej korelacji danych aplikacji z danymi publicznymi i zastrzeżonymi: Czy numer telefonu i adres e-mail tej osoby pokazują historię użytkowania? Czy geolokalizacja urządzenia lub adresu IP ma sens? Czy wpisuje dane w formularzach w sposób ludzki, czy kopiuje-wkleja (jak robią to boty)? Modele sztucznej inteligencji mogą być szkolone w celu odróżnienia prawdziwych zachowań klientów od syntetycznych wzorców. Rezerwa Federalna zauważyła, że "syntetyczne tożsamości są płytkie i AI to widzi". - Weryfikacja oparta na sztucznej inteligencji może szybko wyszukać cyfrowy ślad tożsamości i podnieść alarm, jeśli nie zostanie znaleziony żaden ślad.[55]. W praktyce usługi weryfikacji tożsamości wykorzystują obecnie sztuczną inteligencję, która sprawdza, czy selfie użytkownika pasuje do poprzednich zdjęć (w celu wykrycia zamiany twarzy), a nawet monituje użytkowników o losowe działania (takie jak określone pozy lub frazy) podczas sprawdzania żywotności, utrudniając deepfake'om prawidłową reakcję[56][57].

Wreszcie, ciągłe monitorowanie zachowanie konta po wdrożeniu pomaga wychwycić konta syntetyczne, które się prześlizgnęły. Ponieważ konta te nie są powiązane z prawdziwą osobą, ich wzorce użytkowania często się wyróżniają (np. dokonywanie transakcji w idealnym momencie w celu zbudowania kredytu, a następnie maksymalne wykorzystanie). Monitorowanie oszustw oparte na sztucznej inteligencji (takie jak platformy Sift lub Feedzai) może zidentyfikować anomalie w sposobie korzystania z kont, oznaczając potencjalne syntetyki do przeglądu. Podsumowując, zwalczanie oszustw związanych z tożsamością opartych na sztucznej inteligencji wymaga Potwierdzanie tożsamości z wykorzystaniem sztucznej inteligencji - łącząc kryminalistykę dokumentów, kontrole biometryczne, korelację danych i analizę behawioralną. Dobrą wiadomością jest to, że te same postępy w sztucznej inteligencji, które umożliwiają oszustwa, są również wykorzystywane do ich wykrywania. TruthScan, na przykład, oferuje usługę pakiet do weryfikacji tożsamości która integruje analizę tekstu, obrazu i głosu w celu weryfikacji nowych użytkowników. Wykorzystując te narzędzia, jeden z dużych banków odnotował znaczny spadek udanych otwarć kont syntetycznych, nawet gdy średnie w branży rosły. Wyścig zbrojeń trwa, ale obrońcy uczą się dostrzegać słabe "cyfrowe sygnały" syntetyków, bez względu na to, jak dobrze sztuczna inteligencja stara się zatrzeć ślady.

Integracja wykrywania AI w całym stosie zabezpieczeń

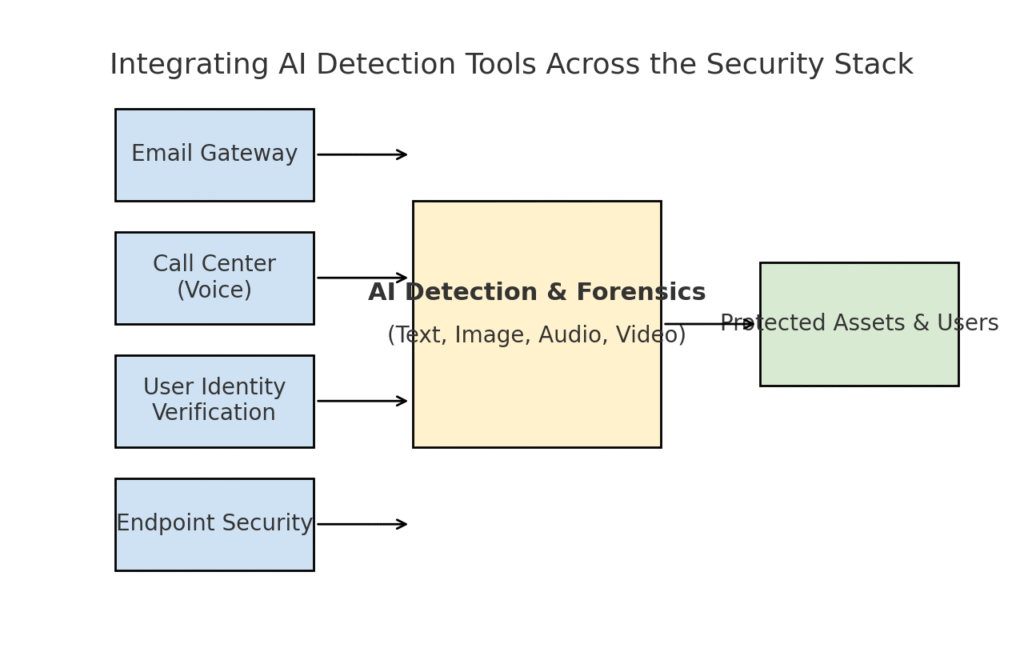

Przeanalizowaliśmy kilka różnych obszarów zagrożeń - phishing, deepfake, złośliwe oprogramowanie, oszustwa syntetyczne - wszystkie doładowane sztuczną inteligencją. Jasne jest, że Brak pojedynczego narzędzia lub jednorazowej poprawki nie rozwiąże tego wyzwania. Zamiast tego przedsiębiorstwa potrzebują kompleksowej strategii, aby Wbudowanie wykrywania i weryfikacji opartej na sztucznej inteligencji w każdej warstwie. ich stosu cyberbezpieczeństwa. Podejście musi odzwierciedlać powierzchnię ataku, obejmującą pocztę elektroniczną, sieć, głos, dokumenty, tożsamość i nie tylko. Poniższy diagram ilustruje, w jaki sposób organizacje mogą zintegrować narzędzia do wykrywania sztucznej inteligencji TruthScan (i podobne rozwiązania) we wspólnych warstwach bezpieczeństwa przedsiębiorstwa:

Integracja narzędzi do wykrywania AI na wielu warstwach stosu zabezpieczeń - od bramek e-mail i centrów telefonicznych po weryfikację użytkowników i ochronę punktów końcowych. Wykrywanie treści AI (centrum) analizuje tekst, obrazy, dźwięk i wideo w czasie rzeczywistym, zasilając punkty egzekwowania, które chronią zasoby i użytkowników.

W tym modelu, multimodalne detektory AI działają jak centralny mózg który łączy się z różnymi kontrolami bezpieczeństwa:

- Bramki e-mail: Przychodzące wiadomości e-mail przechodzą przez wykrywacz tekstu/oszustw AI, zanim dotrą do skrzynki odbiorczej. Wiąże się to z omawianą przez nas obroną przed phishingiem - np. przy użyciu Wykrywacz oszustw e-mail TruthScan za pośrednictwem interfejsu API u dostawcy poczty e-mail, aby automatycznie poddawać kwarantannie podejrzane wiadomości e-mail generowane przez sztuczną inteligencję[18]. Może być również stosowany do platform komunikacyjnych (aplikacje do czatowania, bramki SMS) w celu skanowania treści w poszukiwaniu wzorców phishingu lub oszustw.

- Centra telefoniczne i systemy głosowe: Kanały telefoniczne i VOIP są zabezpieczone poprzez integrację wykrywania fałszywych połączeń głosowych. Na przykład, linia obsługi klienta banku może wykorzystywać Detektor głosu AI firmy TruthScan analizować dźwięk przychodzących połączeń w czasie rzeczywistym i ostrzegać, jeśli głos dzwoniącego jest syntetyczny lub nie pasuje do jego znanego profilu.[58][59]. Pomaga to zapobiegać atakom typu vishing i podszywaniu się pod głos (np. fałszywym telefonom od prezesów).

- Procesy weryfikacji tożsamości użytkownika: Podczas tworzenia konta lub działań użytkownika o wysokim ryzyku (resetowanie hasła, przelewy bankowe) uruchamiana jest weryfikacja tożsamości oparta na sztucznej inteligencji. Przesłany identyfikator zdjęcia jest weryfikowany przez narzędzie do analizy obrazu (np. sprawdzanie, czy jest to zdjęcie wygenerowane przez sztuczną inteligencję lub zdjęcie zdjęcia), a selfie lub rozmowa wideo są sprawdzane przez detektor deepfake. TruthScan's Deepfake Detector można wykorzystać do uwierzytelniania twarzy - upewniając się, że osoba w kamerze jest prawdziwa i pasuje do identyfikatora[60][61]. Sygnały behawioralne (częstotliwość pisania, spójność urządzeń) mogą być również wprowadzane do modeli sztucznej inteligencji w celu wykrywania botów lub syntetycznych tożsamości.

- Punkty końcowe i sieć: Agenci bezpieczeństwa punktów końcowych i serwery proxy mogą obejmować analizę zawartości AI dla plików i skryptów. Na przykład, jeśli EDR punktu końcowego zobaczy nowy skrypt lub EXE, może wysłać zawartość tekstową pliku do detektora AI, aby sprawdzić, czy przypomina on znane złośliwe oprogramowanie generowane przez AI lub wykazuje cechy zaciemnionego kodu AI. Podobnie, systemy DLP (zapobieganie utracie danych) mogą wykorzystywać wykrywanie tekstu AI do oznaczania wrażliwego tekstu, który został wygenerowany przez AI (co może wskazywać na insidera używającego AI do przygotowywania wiadomości o eksfiltracji danych lub fałszowania raportów). TruthScan's Detektor czasu rzeczywistego został zaprojektowany z myślą o podłączeniu do takich przepływów pracy, oferując analizę treści na żywo na różnych platformach z opcjami automatycznej odpowiedzi[42][62] (na przykład automatyczne blokowanie pliku lub wiadomości, jeśli zostaną zidentyfikowane jako złośliwe oprogramowanie lub dezinformacja wygenerowane przez sztuczną inteligencję).

The kluczowa korzyść tego zintegrowanego podejścia jest Szybkość i spójność. Ataki z wykorzystaniem sztucznej inteligencji przebiegają szybko - wiadomości phishingowe, fałszywe głosy i syntetyczne dane mogą atakować wiele kanałów jednocześnie. Dzięki oprzyrządowaniu wszystkich tych kanałów w wykrywanie AI, organizacja zyskuje widoczność w czasie rzeczywistym i dogłębną obronę. Jeden z zespołów opisał to jako tworzenie "systemu odpornościowego AI" dla swojego przedsiębiorstwa: za każdym razem, gdy coś jest komunikowane (czy to e-mail, przesłanie dokumentu, połączenie głosowe itp.), system odpornościowy AI "wącha" go pod kątem obcych (generowanych przez AI) sygnatur i neutralizuje go, jeśli okaże się złośliwy.

Pakiet TruthScan dla przedsiębiorstw jest tego przykładem, ponieważ oferuje ujednolicona platforma obejmujące wykrywanie tekstu, obrazu, dźwięku i wideo AI, które można wdrożyć modułowo lub jako całość[63][64]. Wiele firm zaczyna od wdrożenia jednej lub dwóch funkcji (powiedzmy, wykrywanie tekstu w wiadomościach e-mail i wykrywanie obrazów w onboardingu), a następnie rozszerza je na inne, gdy zobaczą wartość. Co ważne, integracja jest przyjazna dla deweloperów - TruthScan i podobne usługi zapewniają interfejsy API i zestawy SDK, dzięki czemu zespoły ds. bezpieczeństwa mogą podłączyć wykrywanie do istniejących systemów bez konieczności masowej przebudowy. Niezależnie od tego, czy jest to SIEM, brama e-mail, niestandardowa aplikacja bankowa czy system CRM, wykrywanie może działać za kulisami i generować alerty lub zautomatyzowane działania. Na przykład duża platforma mediów społecznościowych zintegrowała interfejsy API moderacji treści, aby automatycznie usuwać filmy typu deepfake w ciągu kilku minut od przesłania[65][66]zapobiegając rozprzestrzenianiu się dezinformacji generowanych przez sztuczną inteligencję.

Wnioski: Wyprzedzanie krzywej

Gwałtowne rozprzestrzenianie się zagrożeń opartych na sztucznej inteligencji w 2025 roku stanowi wyzwanie dla organizacji na nowe sposoby. Atakujący znaleźli sposoby na wykorzystanie ludzkiego zaufania na dużą skalę - podszywanie się pod głosy i tożsamości, automatyzacja inżynierii społecznej, omijanie zabezpieczeń za pomocą adaptacyjnego kodu i tworzenie całej fałszywej rzeczywistości. Jest to zniechęcająca perspektywa dla obrońców, ale nie beznadziejna. Tak jak przestępcy wykorzystują sztuczną inteligencję, tak i my możemy wykorzystać ją po stronie bezpieczeństwa. Pojawienie się Wykrywanie treści za pomocą sztucznej inteligencji, deepfake forensics i syntetyczne skanery tożsamości daje nam potężne możliwości przeciwdziałania tym nowym zagrożeniom. Wdrażając te narzędzia i integrując je we wszystkich warstwach przedsiębiorstwa mogą radykalnie zmniejszyć ryzyko prześlizgnięcia się ataków opartych na sztucznej inteligencji. Wcześni użytkownicy już udaremnili próby oszustw o wartości wielu milionów dolarów, łapiąc deepfake'i na gorącym uczynku[26]lub zapobiec katastrofom phishingowym poprzez filtrowanie wiadomości e-mail stworzonych przez sztuczną inteligencję.

Poza technologią, organizacje powinny kultywować kulturę "ufaj, ale weryfikuj". Pracownicy powinni być świadomi, że w erze sztucznej inteligencji nie zawsze można uwierzyć w to, co się widzi (lub słyszy) - zdrowy sceptycyzm w połączeniu z procesami weryfikacji może powstrzymać wiele sztuczek socjotechnicznych. Szkolenie i świadomość w połączeniu z narzędzia do automatycznej weryfikacji, takie jak TruthScantworzą potężną obronę. W pewnym sensie musimy podnieść poprzeczkę w zakresie uwierzytelniania i walidacji informacji. Komunikacja cyfrowa i dokumenty nie mogą być już traktowane jako wiarygodne; ich pochodzenie musi zostać sprawdzone przez maszynę lub proces.

W miarę postępów należy oczekiwać, że atakujący będą dalej udoskonalać swoje taktyki AI - ale także oczekiwać ciągłych innowacji w zakresie defensywnej AI. Dynamika zabawy w kotka i myszkę będzie się utrzymywać. Sukces obrońców będzie zależał od sprawność i wymiana informacji. Ci, którzy szybko wprowadzą nowe informacje o zagrożeniach (np. nowatorskie techniki wykrywania deepfake lub zaktualizowane sygnatury modeli AI), wyprzedzą atakujących wykorzystujących najnowsze narzędzia AI. Współpraca między przemysłem, środowiskiem akademickim i rządem będzie miała również kluczowe znaczenie w tej walce, o czym świadczą alerty i ramy wyłaniające się z agencji, takich jak AI Risk Management Framework NIST, oraz współpraca międzybankowa w zakresie wykrywania oszustw AI.

Podsumowując, branża cyberbezpieczeństwa jest w trakcie zmiany paradygmatu napędzanej przez sztuczną inteligencję. Zagrożenia nie przypominają tych sprzed dekady, ale stawiamy im czoła za pomocą równie bezprecedensowych środków obrony. Dzięki połączeniu zaawansowanej technologii wykrywania i solidnej strategii bezpieczeństwa, my może złagodzić ryzyko związane z generatywną sztuczną inteligencją, a nawet obrócić ją na naszą korzyść. Narzędzia takie jak pakiet wykrywania sztucznej inteligencji TruthScan umożliwiają nam przywrócić zaufanie w świecie zerowego zaufania - aby upewnić się, że osoba po drugiej stronie linii jest prawdziwa, że dokument w naszej skrzynce odbiorczej jest autentyczny i że kod działający w naszej sieci nie został zmodyfikowany przez złośliwą sztuczną inteligencję. Inwestując w te możliwości już teraz, organizacje nie tylko ochronią się przed dzisiejszymi atakami wykorzystującymi sztuczną inteligencję, ale także zbudują odporność na ewoluujące zagrożenia jutra. Wniosek jest jasny: Sztuczna inteligencja może napędzać cyberataki, ale przy odpowiednim podejściu może również wzmocnić naszą obronę.

Źródła: Odpowiednie dane i przykłady zostały zaczerpnięte z 2025 raportów wywiadowczych dotyczących zagrożeń i ekspertów, w tym Mayer Brown's Cyber Incident Trends[1][67]Przegląd zagrożeń Fortinet w 2025 r.[2][19]Barracuda bada ataki e-mailowe z wykorzystaniem sztucznej inteligencji[6][7]raport Google GTIG na temat zagrożeń związanych ze sztuczną inteligencją[34], Bostońska Rezerwa Federalna spostrzeżenia na temat oszustw syntetycznych[45][50]oraz opublikowane przez TruthScan studia przypadków i komunikaty prasowe[30][26]między innymi. Ilustrują one zakres zagrożeń opartych na sztucznej inteligencji i skuteczność środków zaradczych skoncentrowanych na sztucznej inteligencji w rzeczywistych scenariuszach. Ucząc się na podstawie takiej inteligencji i wdrażając najnowocześniejsze narzędzia, możemy pewnie poruszać się w erze cyberzagrożeń opartych na sztucznej inteligencji.

[1] [67] Trendy dotyczące cyberincydentów w 2025 r. Co Twoja firma powinna wiedzieć | Insights | Mayer Brown

[2] [3] [19] Najważniejsze statystyki dotyczące cyberbezpieczeństwa: Fakty, statystyki i naruszenia w 2025 r.

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Oszustwa oparte na sztucznej inteligencji w usługach finansowych: Najnowsze trendy i rozwiązania | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan wykrywa północnokoreański atak Deepfake na urzędników obrony - Bryan County Magazine

[6] [7] [14] Połowa spamu w skrzynce odbiorczej jest generowana przez sztuczną inteligencję - jej wykorzystanie w zaawansowanych atakach jest na wczesnym etapie | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Cyfrowy indeks zaufania za II kwartał 2025 r: Dane i spostrzeżenia dotyczące oszustw AI | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Zagrożenia cyberbezpieczeństwa AI 2025: Deepfake $25.6M

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Najnowsza analiza zagrożeń | TruthScan

[18] [63] [64] TruthScan - wykrywanie AI w przedsiębiorstwie i bezpieczeństwo treści

[23] [46] [56] [57] Deepfakes i depozyty: Jak walczyć z oszustwami generowanymi przez sztuczną inteligencję

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Ataki Deepfake i phishing generowany przez sztuczną inteligencję: statystyki z 2025 r.

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] Detektor głosu AI do Deepfakes i klonowania głosu | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - identyfikacja fałszywych filmów i sztucznej inteligencji - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Postępy w korzystaniu z narzędzi AI przez aktorów zagrożeń | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hakerzy zaciemnili złośliwe oprogramowanie za pomocą szczegółowego kodu sztucznej inteligencji

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Wykrywanie AI w czasie rzeczywistym - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Operatorzy EvilAI wykorzystują kod generowany przez sztuczną inteligencję i fałszywe aplikacje do ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Generacja AI zwiększa zagrożenie oszustwami związanymi z syntetyczną tożsamością - Bank Rezerwy Federalnej w Bostonie

[53] Syntetyczne oszustwa tożsamości 2025: Strategie wykrywania i zapobiegania sztucznej inteligencji