Oszustwa ubezpieczeniowe wkraczają w nową erę napędzaną przez sztuczną inteligencję. Wyrafinowane pierścienie oszustów i samotni oszuści wykorzystują generatywne narzędzia sztucznej inteligencji do tworzenia fałszywych roszczeń, syntetycznych tożsamości, głęboko sfałszowanych dowodów i bardzo przekonujących oszustw polegających na podszywaniu się pod inne osoby. Niniejsza biała księga analizuje najnowsze trendy 2025 w oszustwach ubezpieczeniowych opartych na sztucznej inteligencji - od roszczeń i dokumentów generowanych przez sztuczną inteligencję po oszustwa głosowe - i nakreśla, w jaki sposób ubezpieczyciele mogą reagować. Przedstawiamy najnowsze dane, rzeczywiste przypadki i strategiczne spostrzeżenia dla ubezpieczycieli, śledczych ds. oszustw, zespołów ds. cyberbezpieczeństwa, kierowników ds. roszczeń i liderów C-suite, którzy muszą zrozumieć ten szybko zmieniający się krajobraz zagrożeń.

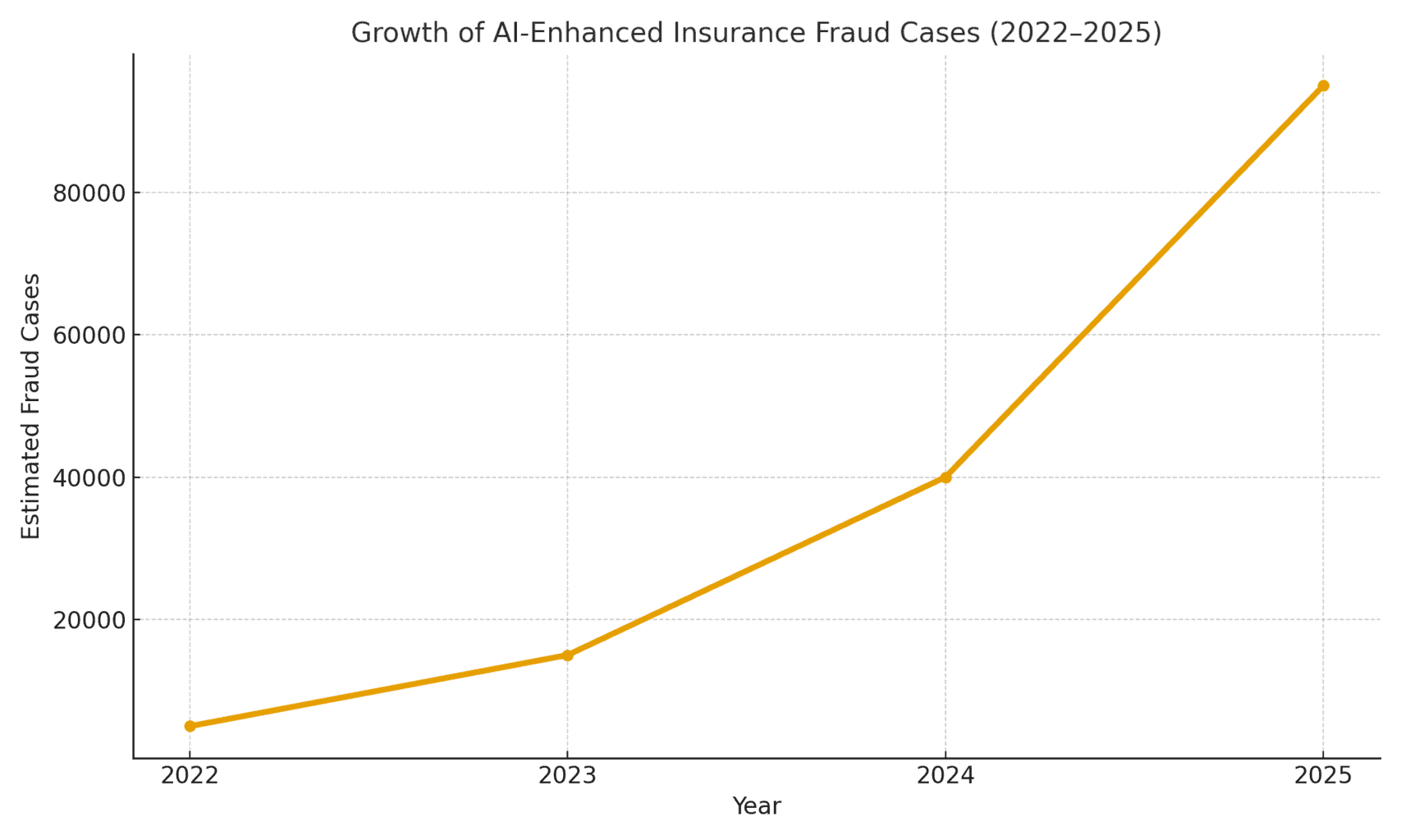

Skala zagrożenia: Rośnie liczba oszustw umożliwianych przez sztuczną inteligencję. Raport księgowości sądowej z 2025 r. wykazał, że Oszustwa oparte na sztucznej inteligencji stanowią obecnie ponad połowę wszystkich cyfrowych oszustw finansowych.[1]. W szczególności w ubezpieczeniach firma Pindrop zajmująca się bezpieczeństwem głosowym zaobserwowała 475% wzrost liczby syntetycznych ataków głosowych na firmy ubezpieczeniowe w 2024 r.przyczyniając się do wzrostu ogólnej liczby prób oszustw ubezpieczeniowych o 19% rok do roku[2]. Ubezpieczyciele muszą stawić czoła mniej więcej 20 razy większe narażenie na oszustwa niż w przypadku bankówczęściowo ze względu na dużą zależność od dokumentów, obrazów i weryfikacji głosowych w roszczeniach[3]. Poniższy rysunek 1 ilustruje gwałtowny wzrost liczby incydentów związanych z oszustwami ubezpieczeniowymi z wykorzystaniem sztucznej inteligencji w latach 2022-2025, ponieważ wiele raportów branżowych wskazuje na trzy- lub czterocyfrowe wzrosty procentowe rok do roku w wykrytym zaangażowaniu sztucznej inteligencji w oszustwa.

Rysunek 1: Gwałtowny wzrost liczby przypadków oszustw ubezpieczeniowych z wykorzystaniem sztucznej inteligencji (indeksowany wzrost w latach 2022-2025). Dane branżowe wskazują na gwałtowny wzrost ilości treści generowanych przez sztuczną inteligencję w nieuczciwych roszczeniach, zwłaszcza od 2023 roku.[4][2]

Twierdzenia generowane przez sztuczną inteligencję i fałszywe dowody

Jednym z najbardziej rozpowszechnionych trendów jest wykorzystanie generatywnej sztucznej inteligencji do tworzenia oprogramowania. całkowicie sfabrykowane roszczenia ubezpieczeniowe. Dzięki zaawansowanym generatorom tekstu sztucznej inteligencji oszuści mogą tworzyć realistyczne opisy zdarzeń, raporty medyczne lub zeznania policyjne za jednym kliknięciem przycisku. Te pisane przez sztuczną inteligencję narracje często są odczytywane jako dopracowane i wiarygodne, co utrudnia rzeczoznawcom wykrycie niespójności. Przykładowo, oszuści wykorzystują ChatGPT do sporządzania szczegółowych opisów wypadków lub raportów o obrażeniach, które brzmią profesjonalnie i przekonująco - zadanie, które kiedyś wymagało znacznego wysiłku i umiejętności pisarskich.

Bardziej niepokojące jest to, że przestępcy łączą teraz te fałszywe narracje z Dowody generowane przez sztuczną inteligencję. Modele generowania obrazu (takie jak Midjourney lub DALL-E) i narzędzia do edycji mogą tworzyć fotorealistyczne zdjęcia uszkodzeń i obrażeń. Według raportów branżowych, niektórzy kierowcy zaczęli Przesyłanie obrazów wygenerowanych przez sztuczną inteligencję w celu wyolbrzymienia uszkodzeń pojazdu w roszczeniach samochodowych[5]. Generatywna sztuczna inteligencja może stworzyć zdjęcie rozbitego samochodu lub zalanego domu, który w rzeczywistości nigdy nie istniał. Te obrazy są często bardziej realistyczne niż to, co można było osiągnąć starszymi technikami Photoshopa[6]przez co są trudne do wykrycia gołym okiem. W kwietniu 2025 r. firma Zurich Insurance odnotowała wzrost liczby roszczeń związanych z sfałszowane faktury, sfabrykowane kosztorysy napraw i cyfrowo zmienione zdjęciaw tym przypadki, w których Numery rejestracyjne pojazdów zostały wstawione przez sztuczną inteligencję do obrazów uszkodzonych samochodów.[7][8]. Takie fałszywe dowody, w połączeniu z dobrze przygotowanym formularzem roszczenia napisanym przez sztuczną inteligencję, mogą ominąć ręczną weryfikację.

Uderzający przypadek w Wielkiej Brytanii dotyczył oszustów biorących zdjęcie furgonetki handlarza w mediach społecznościowych i użycie sztucznej inteligencji do dodania pękniętego zderzakaa następnie przedłożył ją wraz z fałszywą fakturą za naprawę na kwotę 1000 funtów w ramach fałszywego roszczenia z tytułu kolizji.[9]. Oszustwo zostało odkryte dopiero wtedy, gdy śledczy zauważyli ten sam zdjęcie vana (przed uszkodzeniem) na stronie właściciela na Facebooku[10]. Ilustruje to szersze zjawisko: ubezpieczyciele zgłaszają 300% skok w edycji "płytkich podróbek" obrazów (proste manipulacje cyfrowe w celu dodania uszkodzeń lub zmiany szczegółów) w ciągu zaledwie jednego roku (2021-2022 vs 2022-2023).[4]. Allianz UK ostrzegł w 2024 r., że cyfrowe zniekształcenia zdjęć i fałszywe dokumenty mają "wszystkie oznaki stania się najnowszym wielkim oszustwem, które uderzyło w branżę"[4]. Szef działu odszkodowań Zurich również zauważył, że to, co kiedyś wymagało zainscenizowania fizycznego wypadku samochodowego, teraz może być wykonane w całości za pomocą komputera - oszuści mogą "utworzyć fałszywe roszczenie zza klawiatury i wyłudzić znaczne kwoty" za pomocą fałszywych zdjęć i raportów o całkowitej utracie.[11][12]. Ta zmiana nie tylko zwiększa liczbę fałszywych roszczeń, ale także obniża barierę wejścia dla potencjalnych oszustów.

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

Poza samochodami, roszczenia majątkowe i wypadkowe obserwują inflację strat wspomaganą przez sztuczną inteligencję. Istnieją doniesienia o fałszywych zdjęciach do ubezpieczenia podróżnego (np. "uszkodzenie" bagażu lub zainscenizowane sceny kradzieży) i generowanych przez sztuczną inteligencję paragonach za drogie przedmioty, które nigdy nie zostały zakupione. Roszczenia dotyczące życia i zdrowia również nie są odporni - oszuści wygenerowali fałszywe rachunki medyczne i akty zgonu przy użyciu sztucznej inteligencji do fałszowania dokumentów. W rzeczywistości Zurych zauważył, że technologia deepfake jest wykorzystywana do tworzenia całkowicie fikcyjne oceny inżynierów i raporty medyczne w pakietach roszczeń[11]. Te generowane przez sztuczną inteligencję dokumenty, często z realistycznymi logo i podpisami, mogą być nie do odróżnienia od prawdziwych dokumentów. Pojawiającym się problemem dla ubezpieczycieli na życie jest Fałszowanie nekrologów i aktów zgonuPrzestępcy mogą wykorzystywać sztuczną inteligencję do tworzenia fałszywych nekrologów lub listów lekarskich w celu poparcia wniosku o śmierć osoby, która w rzeczywistości nadal żyje (lub która nigdy nie istniała, o czym mowa poniżej).

Syntetyczni ubezpieczający i tożsamości

Być może najbardziej podstępną zmianą jest oszustwo związane z tożsamością syntetyczną w ubezpieczeniach. Oszustwa związane z tożsamością syntetyczną polegają na tworzeniu fikcyjnej osoby lub podmiotu poprzez łączenie prawdziwych danych (skradzionych numerów ubezpieczenia społecznego, adresów itp.) ze sfabrykowanymi szczegółami (fałszywe nazwiska, fałszywe dokumenty tożsamości). Postępy w dziedzinie sztucznej inteligencji sprawiły, że generowanie fałszywych danych stało się banalnie proste. realistyczne profile osobiste - w tym zdjęcia i identyfikatory - osób, które nie istnieją[13][14]. Oszuści mogą teraz algorytmicznie stworzyć całkowicie fałszywego klienta, zakupić polisę w jego imieniu, a następnie wystawić roszczenia lub świadczenia z polisy dla tej fałszywej tożsamości.

W sektorze ubezpieczeń na życie syntetyczne systemy tożsamości poszybował w górę. Badania branżowe w 2025 r. szacują koszty oszustw związanych z syntetyczną tożsamością ponad $30 miliardów roczniestanowiąc aż 80-85% wszystkich przypadków oszustw związanych z tożsamością w usługach finansowych[15][16]. Szczególnie mocno ucierpieli ubezpieczyciele na życie: oszuści znani są z tego, że zabezpieczyć polisy ubezpieczeniowe na życie dla fikcyjnej osoby, a następnie "zabić" tę osobę na papierze, aby odebrać świadczenie z tytułu śmierci.[17]. Przykładowo, oszust może stworzyć syntetycznego klienta "John Doe", opłacać składki przez rok, a następnie złożyć wniosek z fałszywym aktem zgonu i nekrologiem dotyczącym przedwczesnej śmierci Johna Doe. Ponieważ tożsamość została starannie zbudowana (historia kredytowa, rejestry publiczne itp.), roszczenie z tytułu śmierci może wydawać się uzasadnione - dopóki nie można znaleźć prawdziwego ciała lub prawdziwych krewnych. Zanim oszustwo zostanie wykryte, sprawcy już dawno zniknęli wraz z wypłatą.

Syntetyczne schematy tożsamości również są plagą ubezpieczenie zdrowotne i ubezpieczenie samochodu. Kręgi przestępcze tworzą tożsamości "Frankensteina" poprzez korzystanie z numerów ubezpieczenia społecznego dzieci lub osób starszych (które nie mają historii kredytowej) w połączeniu z wygenerowanymi przez sztuczną inteligencję nazwiskami i prawami jazdy[15]. Następnie kupują polisy zdrowotne lub polisy samochodowe dla tych fałszywych osób, a wkrótce potem zgłaszają duże roszczenia. Jednym z wariantów jest tworzenie syndykatów fałszywe firmy (firmy fasadowe) - na przykład fikcyjna firma transportowa - i wykupienie dla niej ubezpieczenia komercyjnego, tylko po to, aby później dochodzić roszczeń z tytułu zainscenizowanych wypadków lub pozorowanych obrażeń pracowników.[18][19]. Ponieważ firma istnieje tylko na papierze (z wygenerowanymi przez sztuczną inteligencję rejestracjami biznesowymi i identyfikatorami podatkowymi), to "Oszustwa syntetyczne oparte na podmiotach często nie są ujawniane aż do momentu wypłaty odszkodowania[18][20].

Dlaczego syntetyczne tożsamości są tak skuteczne? Po pierwsze, często przechodzą przez zautomatyzowane kontrole weryfikacji tożsamości. Biura kredytowe i systemy KYC mogą znaleźć brak czerwonych flag ponieważ tożsamość zawiera prawdziwe, prawidłowe dane (np. prawdziwy numer SSN z czystą kartoteką)[21]. Tymczasem generowane przez SI zdjęcia profilowe i skany dokumentów tożsamości mogą wyglądać całkowicie autentycznie - dzisiejsza sztuczna inteligencja może stworzyć ludzką twarz, którą nawet zaawansowane rozpoznawanie twarzy może zaakceptować jako prawdziwą. Rezultat: większość zautomatyzowanych systemów rozpoznaje te profile jako legalne a oszustwa są wychwytywane (jeśli w ogóle) dopiero po dużych stratach[22].

Wpływ na rzeczywistość: RGA informuje, że oszustwa związane z syntetyczną tożsamością w ubezpieczeniach na życie kosztują obecnie branżę około $30B rocznie i wzrosła o prawie 400% od 2020 r.[15][16]. Amerykańska Federalna Komisja Handlu szacuje, że syntetyczne identyfikatory stanowią zdecydowaną większość incydentów związanych z fałszowaniem tożsamości[16]. Straty te ostatecznie uderzają w portfele uczciwych ubezpieczających - szacuje się, że każda rodzina płaci co roku dodatkowe składki z powodu większego obciążenia ubezpieczycieli oszustwami[15]. Ubezpieczyciele reagują, wzmacniając weryfikację przy wprowadzaniu na pokład i roszczeniach: wdrażanie kontroli baz danych pod kątem powiązania tożsamości, monitorowanie wielu polis pod tym samym adresem, a nawet przeprowadzanie testów "żywotności" (sprawdzanie wideo selfie, aby upewnić się, że wnioskodawca jest prawdziwą osobą, a nie tylko obrazem sztucznej inteligencji).[23][24]. Ale jak zobaczymy, oszuści kontratakują za pomocą sztucznej inteligencji na kolejnej arenie: głębokich fałszywych głosach i filmach.

Deepfake Voices i twierdzenia dotyczące wideo

Generowane przez sztuczną inteligencję Podróbki audio i wideo nadają oszustwom ubezpieczeniowym nowy, niepokojący wymiar. W latach 2023 i 2024 doszło do kilku incydentów, w których przestępcy wykorzystali klonowanie głosu do podszywania się pod osoby fizyczne przez telefon - taktyka pierwotnie stosowana w oszustwach bankowych (takich jak niesławny telefon prezesa deepfake, który ukradł $35 milionów w 2020 roku), ale teraz rozprzestrzenia się na ubezpieczenia. Oszuści klonują głosy ubezpieczających, lekarzy lub likwidatorów szkód i wykorzystują je w oszustwach socjotechnicznych. Analiza Pindrop z 2024 r. ostrzega, że "deepfakes, syntetyczna technologia głosowa i oszustwa oparte na sztucznej inteligencji zmieniają krajobraz oszustw"z oszustwem głosowym Skalowanie w bezprecedensowym tempie[25]. Okazało się, że call center ubezpieczeniowe były bombardowane przez zagranicznych złych aktorów używających podróbek głosu: na przykład, połączenia przychodzące podawały skradziony numer SSN i dane osobowe prawdziwego ubezpieczającego, a jeśli agent odebrał, to sklonowany przez sztuczną inteligencję głos dzwoniącego mógł oszukać agenta dzięki uwierzytelnianiu opartemu na wiedzy i zażądać oszukańczej wypłaty[26]. W przypadku jednego z ubezpieczycieli z zachodniego wybrzeża atakujący wielokrotnie wykorzystywali tę metodę, próbując przejąć konta i przekierować wypłaty, wykorzystując fakt, że weryfikacja tożsamości w call center opierała się na głosie i danych osobowych, które można sfałszować[26].

Podszywanie się pod głos było również wykorzystywane po stronie konsumentów: Oszuści dzwonili do ofiar wypadków lub beneficjentów, podczas gdy Podszywanie się pod przedstawicieli ubezpieczeniowychwykorzystując głosy sztucznej inteligencji, aby brzmieć oficjalnie, w celu wyłudzenia poufnych informacji lub nawet płatności. I odwrotnie, oszust może podszywać się pod klienta na infolinii reklamacyjnej, aby złożyć wniosek przez telefon, używając fałszywego głosu, który pasuje do płci/wieku klientaomijając w ten sposób kontrole biometryczne głosu. Najnowsze statystyki dotyczące oszustw są otrzeźwiające: eksperci branżowi przewidują, że 162% Wzrost liczby ataków typu deepfake na ubezpieczycieli w nadchodzącym roku[27]a Pindrop zarejestrował 475% wzrost liczby syntetycznych ataków głosowych w 2024 r. jak wspomniano wcześniej[2]. Ataki te szybko wyprzedzają bardziej tradycyjne wektory oszustw cybernetycznych.

Poza rozmowami telefonicznymi, Podróbki wideo pojawiają się w procesie likwidacji szkód. Wielu ubezpieczycieli przyjęło wirtualne inspekcje szkód i wideokonferencje (przyspieszone przez pandemię), aby zdalnie weryfikować straty lub przesłuchiwać wnioskodawców. Teraz oszuści są wykorzystując awatary AI i fałszywe filmy wideo, aby oszukać te weryfikacje. Pojawiły się doniesienia o wnioskodawcach korzystających z Awatary generowane przez sztuczną inteligencję w rozmowach wideo na żywo z regulatorami, w celu maskowania się jako ktoś inny lub ukrywania oznak niespójności[28]. Na przykład pierścień oszustów może wykorzystywać deepfake Wideo "na żywo" rzekomego powoda pokazującego swoje uszkodzenia za pomocą smartfonagdy w rzeczywistości osoba w kamerze jest kompozytem zsyntetyzowanym przez sztuczną inteligencję lub wynajętym aktorem noszącym filtry zmieniające twarz. Jednym ze spekulatywnych, ale prawdopodobnych scenariuszy jest użycie głębokiej podróbki zmarły osoba: W przypadku oszustwa związanego z rentą dożywotnią lub ubezpieczeniem na życie, członek rodziny może wykorzystać fałszywe nagranie wideo niedawno zmarłego podczas rutynowej rozmowy potwierdzającej życie, aby nadal otrzymywać wypłaty[29]. Chociaż żaden głośny przypadek tego rodzaju nie został jeszcze nagłośniony, ubezpieczyciele przygotowują się na to. Organy regulacyjne również zwracają na to uwagę - W Stanach Zjednoczonych i Europie trwają dyskusje na temat zaklasyfikowania fałszerstw jako kradzieży tożsamości i aktualizacji wytycznych dotyczących weryfikacji dowodów w ubezpieczeniach.[30].

Wykrywanie deepfake'ów wideo i audio jest bardzo trudne bez narzędzi technicznych. Ludzcy korektorzy nie są przeszkoleni do rozpoznawania subtelnych problemów z synchronizacją warg lub dziwactw akustycznych. Jednak w niektórych przypadkach pojawiły się czerwone flagi: na przykład nienaturalne mruganie lub mimika twarzy na wideo lub artefakty dźwiękowe w tle podczas rozmowy, które zwróciły uwagę śledczych. Ogólnie jednak, Fałszywe oszustwa ubezpieczeniowe są wciąż na wczesnym etapiea ściganie pozostaje rzadkością - do 2023 r. definicje prawne były niejasne, a udowodnienie, że wideo zostało wygenerowane przez sztuczną inteligencję, było trudne bez analizy eksperckiej[31]. Daje to oszustom poczucie bezkarności. Wyścig zbrojeń trwa: ubezpieczyciele zwracają się teraz do Śledcza sztuczna inteligencja do walki ze sztuczną inteligencjąwdrażanie algorytmów głębokiego wykrywania podróbek w celu analizowania podejrzanych filmów klatka po klatce pod kątem oznak manipulacji[24]. Dostawcy biometrii głosowej wprowadzają głębokie wykrywacze fałszywego głosu, które analizują wzorce widmowe i kadencję głosu pod kątem autentyczności[32]. Omówimy te technologie obronne w późniejszej sekcji.

Oszustwa phishingowe i podszywanie się pod inne osoby z wykorzystaniem sztucznej inteligencji

Nie wszystkie oszustwa z wykorzystaniem sztucznej inteligencji przechodzą przez dział reklamacji; niektóre cele to klienci i pracownicy poprzez inżynierię społeczną. Wiadomości phishingowe i SMS-y spreparowane przez sztuczną inteligencję stały się głównym zagrożeniem w dziedzinie ubezpieczeń. W tych schematach oszuści wykorzystują chatboty AI i narzędzia tłumaczeniowe do generowania bardzo przekonujących wiadomości phishingowych. Przestępcy mogą na przykład podszywać się pod markę i styl pisania firmy ubezpieczeniowej, aby wysyłać masowe wiadomości phishingowe do posiadaczy polis, informując ich, że "konieczne jest pilne działanie, aby zapobiec anulowaniu polisy" i kierując ich na fałszywą stronę internetową. W przeciwieństwie do nieudolnych e-maili phishingowych z przeszłości, Sztuczna inteligencja zapewnia nienaganną gramatykę, a nawet personalizacjęczyniąc je znacznie bardziej wiarygodnymi. Widzieliśmy sztuczną inteligencję wykorzystywaną do skrobania mediów społecznościowych w poszukiwaniu szczegółów, które są wplatane w wiadomości spear-phishingowe, takie jak odniesienie do niedawnego zakupu samochodu w fałszywym powiadomieniu o ubezpieczeniu samochodowym.

Innym wektorem jest Wspomagane przez sztuczną inteligencję podszywanie się pod agentów lub kierownictwo. Zdarzały się przypadki, w których oszuści klonowali głos właściciela agencji ubezpieczeniowej i zostawiali klientom wiadomości na poczcie głosowej z prośbą o aktualizację informacji bankowych - w rzeczywistości był to głosowy atak phishingowy. Podobnie, wewnętrzne oszustwa mogą wynikać z podszywania się pod sztuczną inteligencję: dział finansowy jednego z ubezpieczycieli prawie padł ofiarą, gdy oszuści wysłali fałszywą wiadomość audio. rzekomo od CEO autoryzacja przelewu środków (wariant "oszustwa CEO" obecnie objęty niektórymi polisami ubezpieczeniowymi od przestępczości elektronicznej)[33]). Według Liberty Specialty Markets, tego rodzaju oszustwa związane z podszywaniem się pod sztuczną inteligencję wzrosły o 17% w 2023 roku[33]i oczekuje się ich dalszego wzrostu.

Konsumenci są również celem oszustw w mediach syntetycznych związane z ubezpieczeniami. Koalicja przeciwko oszustwom ubezpieczeniowym odnotowuje przypadki oszustów podszywających się pod rzeczoznawców ubezpieczeniowych, kontaktujących się z ofiarami wypadków, twierdząc, że zajmują się ich roszczeniami, a następnie żądanie natychmiastowej zapłaty lub poufnych danych[23]. Niczego niepodejrzewający klienci, z ulgą przyjmujący wiadomość od rzekomego przedstawiciela, mogą się zgodzić, zwłaszcza jeśli dzwoniący zna szczegóły ich wypadku (które AI może uzyskać z hakowania lub źródeł publicznych). Świadomość społeczna tych taktyk jest niska, dlatego eksperci ds. zapobiegania oszustwom wzywają ubezpieczycieli do edukowanie posiadaczy polis w zakresie weryfikacji tożsamości osób dzwoniących i wysyłających wiadomości e-mail[23][34]. Podobnie jak banki ostrzegają klientów przed phishingiem, ubezpieczyciele w 2025 r. zaczynają uwzględniać w swojej komunikacji ostrzeżenia o oszustwach typu deepfake.

Jednym wspólnym wątkiem w tych schematach wspomaganych przez sztuczną inteligencję jest wykorzystanie łatwo dostępnych zestawów "oszustwo jako usługa"[35]. W ciemnej sieci przestępcy mogą kupować lub subskrybować narzędzia, które zapewniają gotowe deepfake'owe głosy, szablony fałszywych dokumentów, generatory phishingowych wiadomości e-mail i nie tylko. Ta demokratyzacja narzędzi sztucznej inteligencji oznacza Nawet oszuści o niskich umiejętnościach mogą przeprowadzać wyrafinowane ataki.[35]. Dla firm ubezpieczeniowych przekłada się to na zalew bardziej przekonujących prób oszustw pochodzących ze wszystkich stron - roszczeń, obsługi klienta, poczty elektronicznej, a nawet mediów społecznościowych. Podkreśla to potrzebę wielopłaszczyznowej strategii obronnej, łączącej technologię, ludzką czujność i współpracę międzybranżową.

Wykrywanie i obrona: Reakcja oparta na sztucznej inteligencji

Zwalczanie oszustw opartych na sztucznej inteligencji wymaga Obrona oparta na sztucznej inteligencji. Ubezpieczyciele coraz częściej sięgają po zaawansowane technologie wykrywania i ulepszone procesy, aby przeciwdziałać atakowi. Zasadniczo ubezpieczyciele muszą punkty kontrolne uwierzytelniania treści w całym cyklu życia ubezpieczenia - od gwarantowania, przez roszczenia, po interakcje z klientami - w celu wykrycia fałszerstw AI. Rysunek 2 przedstawia zestawienie kluczowych rodzajów oszustw umożliwianych przez sztuczną inteligencję i ich rozpowszechnienie, a poniższe sekcje szczegółowo opisują sposoby wykrywania i powstrzymywania każdego z nich.

Rysunek 2: Rodzaje oszustw ubezpieczeniowych z wykorzystaniem sztucznej inteligencji w 2025 r. (szacowany udział według systemu). Fałszywe obrazy (sfałszowane zdjęcia uszkodzeń) i syntetyczne tożsamości należą do największych kategorii, a następnie dokumenty sfałszowane przez sztuczną inteligencję (np. pokwitowania, certyfikaty) i oszustwa audio/wideo typu deepfake.

1. Narzędzia do wykrywania treści AI: Nowe usługi wykrywania AI mogą analizować tekst, obrazy, audio i wideo w celu ustalenia, czy zostały one wygenerowane maszynowo lub zmanipulowane. Ubezpieczyciele mogą na przykład korzystać z rozwiązań takich jak Detektory tekstu i obrazów AI TruthScan które wykorzystują dokładną sztuczną inteligencję 99%+ do oznaczania dokumentów napisanych przez sztuczną inteligencję lub sfałszowanych zdjęć[36]. Firma ubezpieczeniowa mogłaby zintegrować te detektory ze swoim systemem roszczeń: gdy roszczenie i jego dowody są przesyłane, opis tekstowy może być automatycznie skanowany pod kątem wzorców językowych generowanych przez sztuczną inteligencję, a wszelkie przesłane obrazy mogą być skanowane pod kątem charakterystycznych oznak CGI lub edycji. Narzędzia klasy korporacyjnej mogą identyfikować tekst generowany przez sztuczną inteligencję w dokumentach, wiadomościach e-mail i komunikacji z dokładnością 99%[36]i podobnie wykrywanie obrazów wygenerowanych lub zmanipulowanych przez sztuczną inteligencję w celu zapewnienia autentyczności treści wizualnych[36]. Oznacza to, że fałszywe opisy wypadków stworzone przez ChatGPT lub sfałszowane zdjęcia uszkodzeń w trakcie podróży zostaną oznaczone do ręcznego sprawdzenia przed przetworzeniem roszczenia. Ubezpieczyciele w 2025 r. coraz częściej stosują takie uwierzytelnianie treści za pomocą sztucznej inteligencji - w rzeczywistości, 83% specjalistów ds. zwalczania nadużyć finansowych planuje zintegrować generatywne wykrywanie AI do 2025 r., według ankiety ACFE, w porównaniu do zaledwie 18% korzystających z niego obecnie[37][38].

2. Weryfikacja tożsamości i kontrole biometryczne: Aby poradzić sobie z syntetycznymi tożsamościami, ubezpieczyciele ulepszają również protokoły KYC za pomocą sztucznej inteligencji. Usługi walidacji tożsamości mogą krzyżowo weryfikować dane wnioskodawców w wielu bazach danych i wykorzystywać rozpoznawanie twarzy z testami żywotności. Na przykład, wymaganie krótkiego wideo selfie podczas onboardingu (i wykorzystanie dopasowania twarzy do dostarczonego identyfikatora) może udaremnić wiele syntetycznych identyfikatorów. Jeszcze bardziej zaawansowane technologicznie firmy, takie jak TruthScan, oferują kryminalistykę obrazu, która może zdjęcia profilowe generowane przez sztuczną inteligencję, awatary i syntetyczne wizerunki osób - ich detektor obrazu AI to wyszkolony do identyfikowania twarzy stworzonych przez generatory takie jak StyleGAN lub ThisPersonDoesNotExist[39]. Wdrażając takie narzędzia, ubezpieczyciel może wykryć, czy selfie osoby ubiegającej się o ubezpieczenie na życie nie jest prawdziwym człowiekiem. Po stronie głosu, biometryczne uwierzytelnianie głosowe w przypadku połączeń z obsługą klienta; nowoczesne detektory głosowej sztucznej inteligencji są w stanie identyfikacja głosów syntetycznych i prób klonowania głosu w czasie rzeczywistym[40]. Na przykład, TruthScan Wykrywanie głosu AI System wykorzystuje analizę akustyczną do rozpoznawać głosy generowane przez sztuczną inteligencję i podróbki audio, zanim oszukają pracowników call center[40]. Rozwiązania te działają jak zapora ogniowa - jeśli ktoś dzwoni podając się za Johna Doe, a jego odcisk głosu nie pasuje do autentycznego głosu Johna Doe (lub pasuje do znanych cech deepfake), połączenie może zostać oflagowane lub wymagane jest dalsze potwierdzenie tożsamości. Uwierzytelnianie wieloskładnikowe (potwierdzenie e-mail/SMS, jednorazowe kody dostępu itp.) stanowi dodatkową przeszkodę dla podszywających się osób.

3. Deepfake Video & Image Forensics: Jeśli chodzi o dowody wideo, ubezpieczyciele zaczynają wdrażać specjalistyczne analizy kryminalistyczne. Zaawansowane oprogramowanie może analizować metadane wideo, spójność klatek i poziomy błędów w celu wykrycia podróbek. Niektóre narzędzia badają odbicia, cienie i wskazówki fizjologiczne (takie jak puls w gardle osoby na wideo), aby upewnić się, że wideo jest autentyczne. Kryminalistyka metadanych jest również cenne: badanie metadanych plików i śladów generowania w obrazach lub plikach PDF może ujawnić, czy coś zostało prawdopodobnie wyprodukowane przez narzędzie sztucznej inteligencji[41]. Ubezpieczyciele powinni wymagać oryginalnych plików zdjęciowych (zawierających metadane), a nie tylko zrzutów ekranu lub wydrukowanych kopii. Zespół ds. oszustw w Zurich odnotował sukces w wykrywaniu fałszywych zdjęć samochodów dzięki zauważaniu anomalii w metadanych obrazu i analizie poziomu błędów[41]. Wykrywacze oszustw e-mail może również skanować komunikację przychodzącą w poszukiwaniu oznak treści phishingowych napisanych przez sztuczną inteligencję lub znanych złośliwych sygnatur.[42]. Wielu ubezpieczycieli prowadzi obecnie symulacje phishingu i przykłady oszustw opracowane przez sztuczną inteligencję w ramach szkoleń dla pracowników w celu zwiększenia świadomości.

4. Zmiany procesów i szkolenie pracowników: Sama technologia nie jest srebrną kulą. Ulepszenia procesów Wprowadzane są nowe rozwiązania, takie jak częstsze wyrywkowe kontrole osobiste w przypadku roszczeń o wysokiej wartości lub wymaganie fizycznej dokumentacji w niektórych przypadkach. Niektórzy ubezpieczyciele opóźnili w pełni zautomatyzowane bezpośrednie przetwarzanie roszczeń, ponownie wprowadzając ludzką weryfikację roszczeń, które uzyskały wysokie wyniki w modelu ryzyka oszustwa AI. Po stronie ludzkiej kluczowe znaczenie ma szkolenie. Śledczy ds. nadużyć finansowych i likwidatorzy szkód są szkoleni w zakresie rozpoznawania sygnałów ostrzegawczych AI: np. wielu roszczeń wykorzystujących identyczne sformułowania ("styl" ChatGPT), obrazów pozbawionych prawdziwej losowości (np. powtarzających się wzorców w tym, co powinno być uszkodzeniem organicznym) lub głosów, które brzmią prawie ale mają kadencję robota. Ubezpieczyciele edukują również klientów: wysyłając ostrzeżenia o oszustwach dotyczących programów typu deepfake i doradzając, jak zweryfikować tożsamość przedstawiciela ubezpieczeniowego (na przykład podając znany numer oddzwonienia).

5. Wspólne wysiłki: Współpraca w całej branży nabiera tempa. W Wielkiej Brytanii Biuro ds. Oszustw Ubezpieczeniowych i Stowarzyszenie Brytyjskich Ubezpieczycieli utworzyły grupy robocze ds. oszustw związanych ze sztuczną inteligencją, a rządowa organizacja ds. Karta oszustwa ubezpieczeniowego (2024) wspiera wymianę danych i wspólne inicjatywy[43]. Na całym świecie ubezpieczyciele współpracują z firmami zajmującymi się cyberbezpieczeństwem i startupami AI. W szczególności pojawiają się nowe produkty ubezpieczeniowe: Liberty Mutual uruchomiło Ubezpieczenie od e-przestępczości dla MŚP, które obejmuje w szczególności oszustwa typu deepfake i oszustwa prezesów.[44][33]podkreślając, że ryzyko to jest bardzo realne. Oznacza to również, że ubezpieczyciele mogą stać się zarówno ofiarami, jak i sprawcami oszustw związanych ze sztuczną inteligencją - wypłacając odszkodowanie za oszustwo typu deepfake, jeśli nie zostanie wykryte, ale także oferując ochronę innym osobom, które padły ofiarą takich ataków.

Integracja technologii wykrywania z przepływami pracy może być wizualizowana jako wielopunktowa obrona w cyklu życia roszczeń. Jak pokazano na Rysunek 3Ubezpieczyciele mogą wprowadzić etapy weryfikacji AI na stronie zastosowanie polityki (do sprawdzania syntetycznych tożsamości za pomocą kontroli dokumentów tożsamości i selfie), pod adresem składanie roszczeń (do automatycznej analizy przesłanych dokumentów, zdjęć lub dźwięku pod kątem generowania sztucznej inteligencji), podczas przegląd/dochodzenie roszczeń (aby przeprowadzić głęboką analizę kryminalistyczną podejrzanych dowodów i zweryfikować wszelkie interakcje głosowe), a tuż przed wypłata (ostateczne uwierzytelnienie tożsamości w celu upewnienia się, że odbiorca płatności jest legalny). Dzięki wczesnemu wychwytywaniu oszustw - najlepiej podczas wdrażania lub pierwszego zawiadomienia o szkodzie - ubezpieczyciele oszczędzają koszty dochodzenia i unikają niesłusznych wypłat.

Rysunek 3: Integracja punktów wykrywania AI w cyklu życia ubezpieczenia. Podczas wdrażania polisy, walidacja tożsamości oparta na sztucznej inteligencji sprawdza syntetyczne lub fałszywe tożsamości. Po złożeniu roszczenia zautomatyzowane detektory skanują tekst roszczenia, dokumenty i obrazy w poszukiwaniu treści wygenerowanych przez sztuczną inteligencję. Podczas weryfikacji roszczeń, wyspecjalizowane narzędzia deepfake i analizy głosu weryfikują wszelkie dowody audio/wideo. Przed wypłatą środków, biometryczna weryfikacja tożsamości potwierdza tożsamość beneficjenta. To wielowarstwowe podejście pomaga przechwytywać oszustwa na wielu etapach.

Ubezpieczyciele nie muszą budować wszystkich tych funkcji we własnym zakresie - wielu z nich korzysta z rozwiązań korporacyjnych, takich jak Pakiet do wykrywania sztucznej inteligencji TruthScanktóra oferuje szereg narzędzi, które można zintegrować z systemami ubezpieczycieli za pomocą interfejsu API. Na przykład, Usługa AI Image & Deepfake Detection firmy TruthScan może być używany do weryfikacji autentyczności obrazów i filmów z dokładnością ponad 99%[45]. Ich Detektor tekstu AI flagi tekstu napisanego przez sztuczną inteligencję w roszczeniach lub wiadomościach e-mail[36]podczas gdy Detektor głosu AI zapewnia wykrywanie klonowania głosu i weryfikację mówcy w celu powstrzymania oszustów telefonicznych[40]. Istnieją nawet narzędzia niszowe, takie jak Detektor fałszywych paragonów natychmiastowe analizowanie faktur/paragonów pod kątem śladów manipulacji lub czcionek/układów wygenerowanych przez sztuczną inteligencję[46] - Niezwykle przydatne, biorąc pod uwagę powszechność fałszywych rachunków za naprawy w roszczeniach. Wdrażając kombinację tych narzędzi, ubezpieczyciel może drastycznie poprawić wskaźnik wykrywania oszustw. Jeden z ubezpieczycieli z listy Fortune 500 zgłosił wykrycie 97% prób deepfake'ów w 2024 r. poprzez zastosowanie warstwowego podejścia do kontroli AI (tekst, obraz, głos), a tym samym uniknięcie szacowanych strat w wysokości $20M[47][48].

Wnioski

Sztuczna inteligencja zmienia pole bitwy oszustw ubezpieczeniowych na skalę globalną. Oszuści wprowadzają innowacje za pomocą generatywnej sztucznej inteligencji, aby tworzyć fałsze, które są bardziej przekonujące niż kiedykolwiek - od całkowicie sfabrykowanych osób i wypadków po podszywanie się pod osoby, które mogą oszukać nawet doświadczonych profesjonalistów. Dane z lat 2024-2025 pokazują niepokojący wzrost liczby oszustw opartych na sztucznej inteligencji, ale podkreślają również, że ubezpieczyciele, którzy inwestują w wykrywanie i zapobieganie, mogą być o krok do przodu. Łącząc Najnowocześniejsza technologia wykrywania AI - takich jak kryminalistyka obrazu, uwierzytelnianie głosowe i analiza tekstu - dzięki zaktualizowanym przepływom pracy i edukacji branża może ograniczyć ryzyko bez poświęcania wydajności, jaką zapewniają procesy cyfrowe.

W swej istocie jest to technologiczny wyścig zbrojeń[49]. Jak zauważył jeden z ekspertów ds. zapobiegania oszustwom, "W tej nowej rzeczywistości czujność jest ceną, którą należy zapłacić".[50]. Firmy ubezpieczeniowe muszą wspierać kulturę czujności i wykorzystywać najlepsze dostępne narzędzia, aby zachować zaufanie do procesu likwidacji szkód. Oznacza to weryfikację prawdziwości dokumentów, głosów i obrazów z takim samym rygorem, jaki stosują ubezpieczyciele do oceny ryzyka. Oznacza to również współpracę w całej branży w celu dzielenia się informacjami na temat pojawiających się taktyk oszustw AI i wspólnego opracowywania standardów (na przykład standardowych wymagań dotyczących metadanych dla przesyłanych mediów lub branżowych czarnych list znanych fałszywych tożsamości).

Rok 2025 to punkt krytyczny: ubezpieczyciele, którzy proaktywne dostosowywanie się do oszustw opartych na sztucznej inteligencji będą chronić swoich klientów i bilanse, podczas gdy ci, którzy reagują powoli, mogą stać się celem oszustw przyciągających uwagę nagłówków. Pocieszającą wiadomością jest to, że technologia do walki z oszustwami istnieje i szybko dojrzewa - ta sama sztuczna inteligencja, która wzmacnia pozycję oszustów, może wzmocnić pozycję ubezpieczycieli. Wdrażając rozwiązania takie jak wielomodalny pakiet wykrywania AI TruthScan do weryfikacji roszczeń i tożsamości, ubezpieczyciele mogą znacznie zmniejszyć wskaźnik powodzenia prób oszustw generowanych przez AI[51][52]. W ten sposób nie tylko zapobiegają stratom, ale także wysyłają jasny komunikat do potencjalnych oszustów: bez względu na to, jak sprytne są narzędzia, oszustwo zostanie wykryte.

Podsumowując, oszustwa ubezpieczeniowe oparte na sztucznej inteligencji są ogromnym wyzwaniem, ale można mu sprostać za pomocą równie inteligentnej obrony. Dzięki czujności, wielofunkcyjnej strategii i odpowiednim partnerom technologicznym branża ubezpieczeniowa może nadal dotrzymywać fundamentalnej obietnicy leżącej u podstaw jej działalności - wypłacać tylko uzasadnione roszczenia oraz robić to szybko i bezpiecznie w coraz bardziej cyfrowym świecie.

Referencje:

- Stowarzyszenie Brytyjskich Ubezpieczycieli - Statystyki dotyczące oszustw w 2023 r.[53][54]

- Allianz i Zurich o wzroście liczby roszczeń "płytko sfałszowanych" przez sztuczną inteligencję - The Guardian, 2024 r.[4][11]

- Facia.ai - "Deepfake Insurance Fraud: How AI is Rewriting the Rules," Październik 2025 r.[55][56]

- Koalicja przeciwko oszustwom ubezpieczeniowym - Syntetyczne oszustwa w ubezpieczeniach (Quantexa), Grudzień 2024 r.[21][17]

- RGA - "Fraud Fight's New Frontier: Synthetic Identities," Czerwiec 2025 r.[15][16]

- Pindrop - Raport dotyczący oszustw głosowych, przez FierceHealthcare, czerwiec 2025 r.[2][3]

- Obracanie liczb - "Największe oszustwa finansowe w 2025 r." Październik 2025 r.[1][57]

- TruthScan - Platforma wykrywania AI (przegląd usług), 2025[51][52]

- TruthScan - Strona produktu AI Image Detector, 2025[45][39]

- TruthScan - Strona produktu AI Voice Detector, 2025[40]

- TruthScan - Strona produktu Fake Receipt Detector, 2025[46]

- Liberty Specialty Markets - Informacja prasowa dotycząca ubezpieczenia Deepfake/Cyber Fraud, Marzec 2025 r.[33]

- Facia.ai - Blog: Wyścig zbrojeń w zapobieganiu oszustwom ubezpieczeniowym, 2025[24][32]

- Insurance Business UK - "Obrazy generowane przez sztuczną inteligencję wykorzystywane do oszustw samochodowych" Kwiecień 2025 r.[7][58]

- The Guardian - "Fałszywe zdjęcia uszkodzeń samochodów alarmują ubezpieczycieli" Maj 2024 r.[9][12]

[1] [35] [57] Oszustwa finansowe do 2025 roku: Zagrożenia związane ze sztuczną inteligencją i czerwone flagi

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Oszustwa ubezpieczeniowe wzrosły o 19% w wyniku ataków głosowych w 2024 r.

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Oszuści edytujący zdjęcia pojazdów w celu dodania fałszywych uszkodzeń w brytyjskim oszustwie ubezpieczeniowym | Branża ubezpieczeniowa | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Obrazy generowane przez sztuczną inteligencję są obecnie wykorzystywane do oszustw związanych z ubezpieczeniami komunikacyjnymi - raport | Insurance Business UK

[13] [14] [15] [16] Fraud Fight's New Frontier: Syntetyczne tożsamości i wyścig zbrojeń AI | RGA

[17] [18] [19] [20] [21] [22] JIFA: Syntetyczne oszustwa: Syntetyczne oszustwa są już obecne w ekosystemie ubezpieczycieli, dlatego muszą oni myśleć jak banki - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Oszustwa ubezpieczeniowe Deepfake: Jak sztuczna inteligencja zmienia zasady roszczeń ubezpieczeniowych

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Ciche zagrożenie: Dlaczego oszustwa ubezpieczeniowe przenoszą się na linię telefoniczną

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] Ubezpieczenie od cyberprzestępczości dla MŚP ukierunkowane na oszustwa CEO, deepfake - LSM | Insurance Business UK

[36] [42] [51] TruthScan - wykrywanie AI w przedsiębiorstwie i bezpieczeństwo treści

[37] Badanie: 8 na 10 osób zwalczających oszustwa spodziewa się wdrożyć generatywną sztuczną inteligencję do 2025 r.

[38] Spostrzeżenia z raportu porównawczego technologii zwalczania nadużyć finansowych na 2024 r.

[39] [45] AI Image Detector | Wykrywanie fałszywych i zmanipulowanych zdjęć - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] Detektor głosu AI do Deepfakes i klonowania głosu | TruthScan

https://truthscan.com/ai-voice-detector

[46] Wykrywacz fałszywych paragonów TruthScan | Weryfikacja autentyczności paragonów

https://truthscan.com/fake-receipt-detector

[47] Ubezpieczyciel z listy Fortune 500 wykrywa 97% Deepfake'ów i zatrzymuje syntetyczne ...