Wprowadzenie

Sztuczna inteligencja zmienia krajobraz oszustw finansowych na niespotykane dotąd sposoby. Na początku 2024 r. oszuści wykorzystali generowane przez sztuczną inteligencję deepfake'i, aby podszyć się pod kadrę kierowniczą w rozmowie wideo i nakłonić pracownika z Hongkongu do przelania pieniędzy na konto bankowe. $25 mln dla oszustów[1][2]. Incydenty takie jak ten pokazują, w jaki sposób generatywna sztuczna inteligencja umożliwia przestępcom tworzenie bardzo przekonujących oszustw wymierzonych w banki i ich klientów. Organy regulacyjne biją na alarm: FinCEN Departamentu Skarbu USA wydał pod koniec 2024 r. ostrzeżenie o rosnącej liczbie oszustw z wykorzystaniem generowanych przez sztuczną inteligencję mediów "deepfake", w tym fałszywych dokumentów tożsamości w celu ominięcia weryfikacji bankowych[3][4]. Ta biała księga analizuje najnowsze Trendy związane z oszustwami AI w usługach finansowych i omawiamy, w jaki sposób instytucje mogą wzmocnić swoją obronę. Badamy, w jaki sposób oszuści bronią generatywnej sztucznej inteligencji - od głębokiego podszywania się po syntetyczne tożsamości - oraz przedstawiamy technologie i strategie (w tym zaawansowane narzędzia do wykrywania, takie jak TruthScan), które zespoły ds. oszustw i kadra kierownicza mogą wdrożyć, aby przeciwdziałać temu ewoluującemu zagrożeniu.

Kluczowe trendy związane z oszustwami AI w usługach finansowych

Sztuczna inteligencja i uczenie maszynowe są wykorzystywane przez złych aktorów do przeprowadzania oszustw na większą skalę i w bardziej wyrafinowany sposób. Godne uwagi Taktyki oszustw oparte na sztucznej inteligencji wpływające na banki, fintechy i ubezpieczycieli obejmują:

- Oszustwa związane z podszywaniem się pod Deepfake: Przestępcy używają Wideo i audio generowane przez sztuczną inteligencję do podszywania się pod zaufane osoby (dyrektorów generalnych, klientów itp.) w czasie rzeczywistym. Na przykład, realistyczne głosy deepfake były wykorzystywane w atakach typu vishing (phishing głosowy) w celu autoryzacji oszukańczych przelewów bankowych, a filmy stworzone przez sztuczną inteligencję oszukiwały pracowników do zatwierdzania fałszywych transakcji[1][5]. Te syntetyczne media sprawiają, że trudno jest ustalić, czy naprawdę rozmawiasz z osobą, za którą się uważasz, co umożliwia dokonywanie napadów o dużej wartości, takich jak powyższy przypadek deepfake $25M. Deepfakes stają się przystępna cena i łatwość produkcjiWymagając zaledwie 20-30 sekund dźwięku, aby sklonować głos, lub mniej niż godzinę, aby wygenerować pozornie autentyczne wideo[6].

- Phishing i BEC z wykorzystaniem sztucznej inteligencji: Generatywna sztuczna inteligencja turbodoładowuje schematy inżynierii społecznej, takie jak wiadomości phishingowe i kompromitacja biznesowej poczty e-mail (BEC). Chatboty wykorzystujące sztuczną inteligencję mogą tworzyć wysoce spersonalizowane oszukańcze wiadomości e-mail w doskonałym języku biznesowym, naśladując styl pisania dyrektora generalnego lub tworząc przekonujące fałszywe faktury od dostawców na dużą skalę. W rzeczywistości podziemne narzędzia, takie jak FraudGPT i WormGPT (niefiltrowane wersje ChatGPT) pojawiły się, aby pomóc cyberprzestępcom zautomatyzować phishing i tworzenie złośliwego oprogramowania[7][8]. Oznacza to, że niedoszły oszust o minimalnych umiejętnościach może z łatwością generować dopracowane kampanie phishingowe lub złośliwy kod. Dzięki sztucznej inteligencji pojedynczy przestępca może wysyłać tysiące dostosowanych wiadomości e-mail lub wiadomości tekstowych, znacznie zwiększając zasięg tradycyjnych prób oszustwa. Centrum Przestępczości Internetowej FBI zaobserwowało już ponad $2,7 mld euro straconych w wyniku oszustw BEC w 2022 r., a generatywna sztuczna inteligencja grozi jeszcze większymi stratami w nadchodzących latach.[9][10].

- Syntetyczne tożsamości i oszustwa związane z dokumentami: Generatywna sztuczna inteligencja napędza boom na oszustwa związane z syntetyczną tożsamościąjeden z najszybciej rozwijających się rodzajów przestępstw finansowych[11][12]. Oszuści łączą prawdziwe i fałszywe dane osobowe w celu stworzenia tożsamości "Frankensteina", a następnie wykorzystują sztuczną inteligencję do przedstawić realistyczne dokumenty potwierdzające - od fałszywych paszportów i wyciągów bankowych po odcinki wypłat[7]. Generatory obrazów AI i narzędzia do edycji mogą podrobić autentycznie wyglądające dokumenty tożsamości i zdjęcia które przejdą przypadkową inspekcję. Nawet kontrole żywotności lub weryfikacje selfie mogą zostać potencjalnie pokonane przez obrazy lub wideo zmanipulowane przez sztuczną inteligencję. Automatyzując tworzenie tysięcy fałszywych person (każda z wygenerowanymi przez sztuczną inteligencję zdjęciami profilowymi, mediami społecznościowymi itp.), przestępcy mogą masowo otwierać konta bankowe lub ubiegać się o pożyczki i prać pieniądze lub nie spłacać kredytów. Straty wynikające z oszustw związanych z syntetyczną tożsamością oszacowano na około $35 mld euro w 2023 r.[13]a generatywna sztuczna inteligencja tylko przyspiesza ten trend, czyniąc fałszywe tożsamości tańszymi i trudniejszymi do wykrycia.

- Zautomatyzowane oszustwa i uchylanie się od płacenia: Poza tworzeniem fałszywych treści, sztuczna inteligencja pomaga również oszustom zmaksymalizować sukces swoich programów. Zaawansowane boty mogą szybko testować skradzione dane kart kredytowych w witrynach handlu elektronicznego, wykorzystując uczenie maszynowe do unikania wyzwalaczy wykrywania. Sztuczna inteligencja może pomóc przestępcom zidentyfikować najsłabsze ogniwa w zabezpieczeniach organizacji, a nawet syntetyzować odpowiedzi głosowe, aby pokonać telefoniczną weryfikację tożsamości. Chałupnicza branża w ciemnej sieci sprzedaje obecnie narzędzia AI typu "oszustwo jako usługa" już za $20.[14]. Ta demokratyzacja możliwości sztucznej inteligencji oznacza, że nawet przestępcy niskiego szczebla mogą przeprowadzać wysoce wyrafinowane ataki. Wyścig zbrojeń rozciąga się również na unikanie wykrycia - oszuści wykorzystują sztuczną inteligencję do sondowania bankowych systemów antyfraudowych i udoskonalania swojego podejścia, dopóki nie znajdą metody, która prześlizgnie się przez filtry[15]. Krótko mówiąc, sztuczna inteligencja umożliwia przeprowadzanie oszustw w skali i wydajności niespotykanej wcześniejrzucając wyzwanie konwencjonalnej obronie.

Te taktyki oparte na sztucznej inteligencji są już stosowane rozprzestrzeniają się w alarmującym tempie. Tradycyjne schematy oszustw, takie jak fałszowanie czeków lub phishing, istnieją od lat, ale sztuczna inteligencja zwiększa ich liczbę i realizm. Dane mówią jasno: Oszustwa związane ze sztuczną inteligencją to wzrost.

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

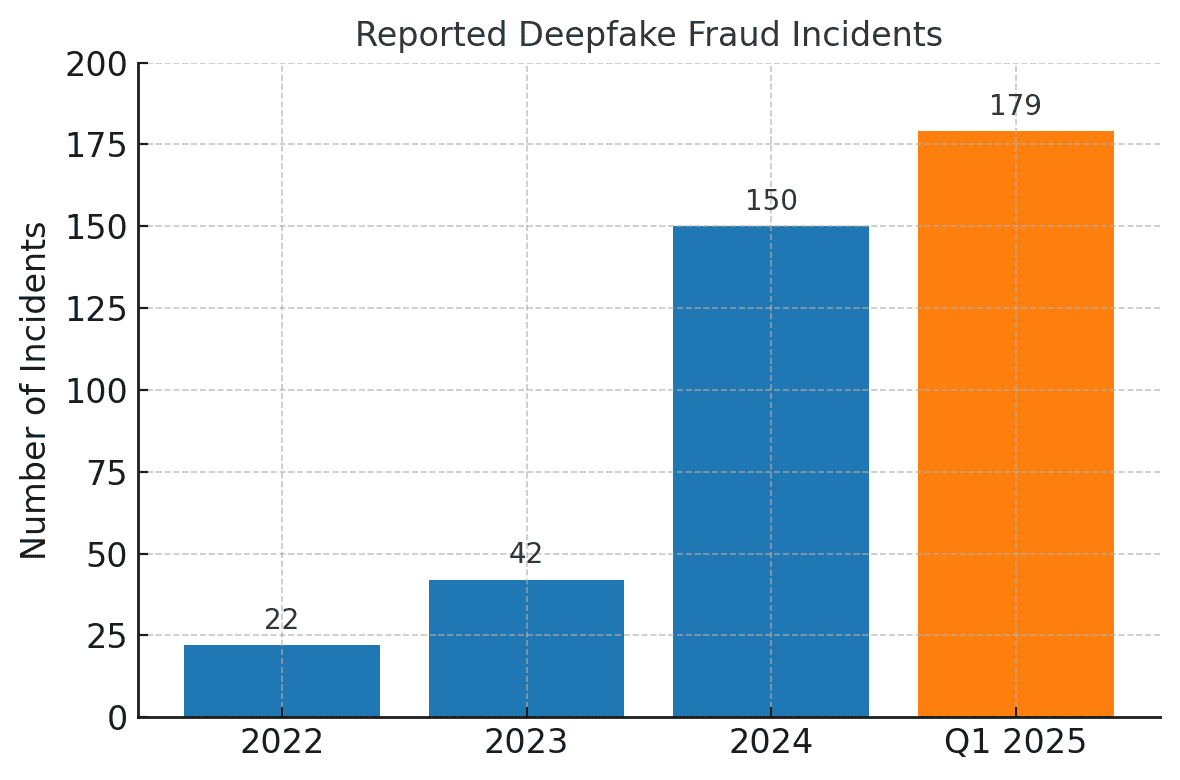

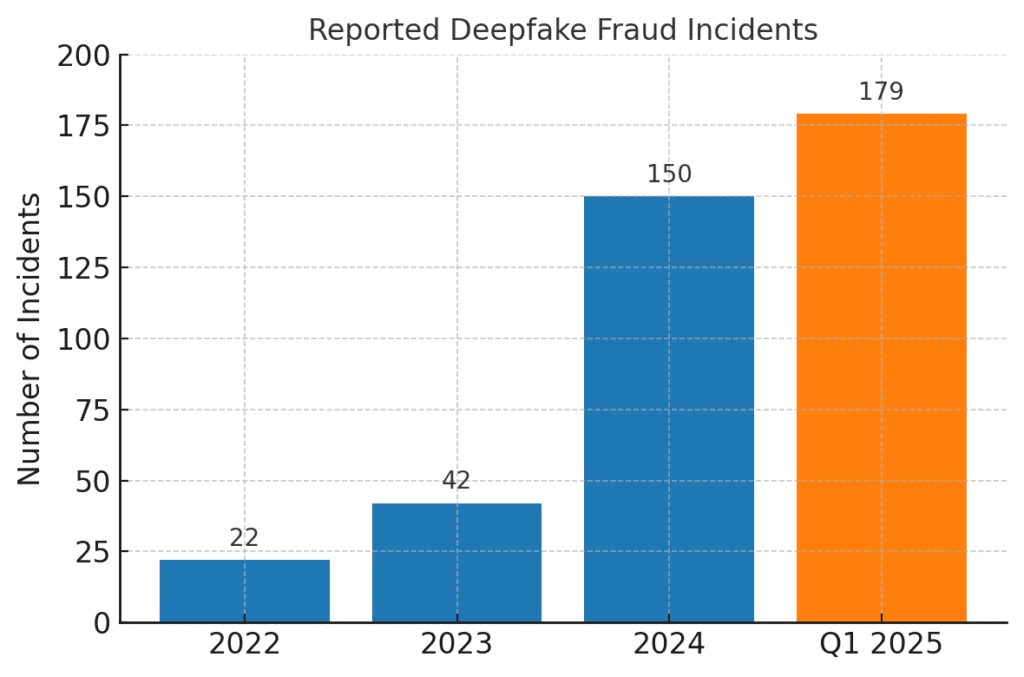

Liczba incydentów związanych z oszustwami typu deepfake gwałtownie wzrosła. W 2022 r. odnotowano tylko 22 przypadki oszustw typu deepfake, ale w 2023 r. było ich 42, a do 2024 r. liczba incydentów wzrosła do 150. Tylko w pierwszym kwartale 2025 r, 179 incydentów oszustw typu deepfake zgłoszono - przekraczając łączną liczbę w całym 2024 r.[16][17].

Najnowsze analizy branżowe odzwierciedlają te trendy. W jednym z raportów odnotowano 700% wzrost liczby incydentów typu deepfake skierowane do firm fintech w 2023 r.[18]. Jeszcze bardziej zdumiewające jest to, że w Ameryce Północnej odnotowano 1,740% wzrost liczby przypadków oszustw typu deepfake między 2022 a 2023 r.[19]. Przestępcy finansowi szybko przyjmują te narzędzia, ponieważ działają - wiele banków i ofiar nie jest jeszcze przygotowanych do wykrywania oszustw generowanych przez sztuczną inteligencję.

Skutki i wyzwania dla instytucji finansowych

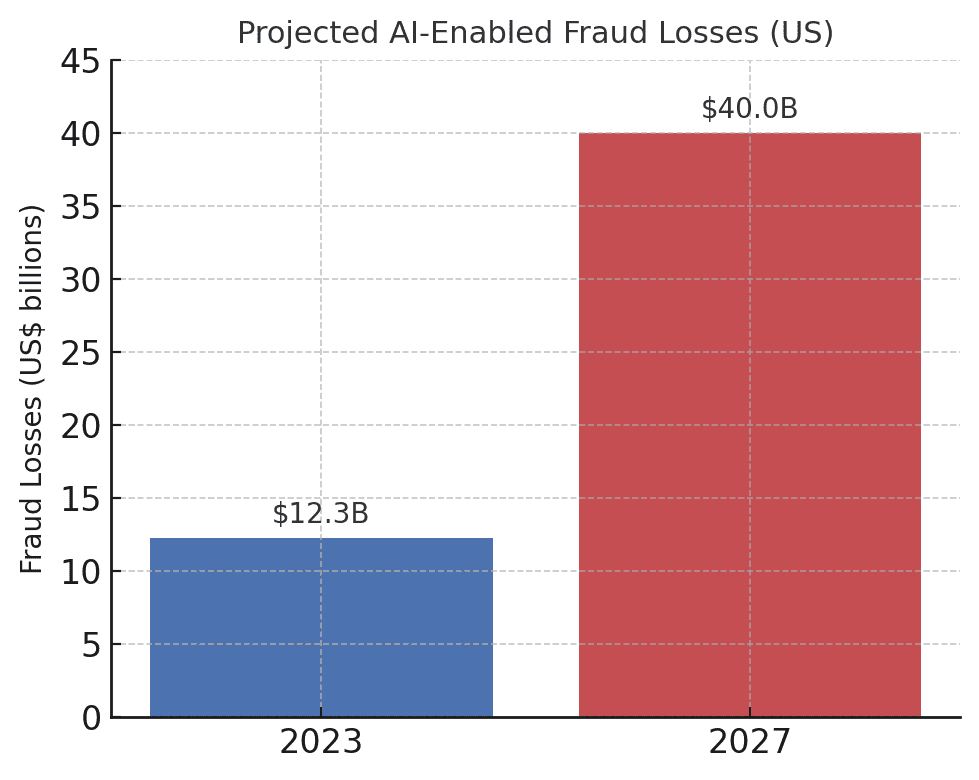

Wzrost liczby oszustw opartych na sztucznej inteligencji znaczący wpływ na instytucje finansowe, ich klientów i szerszy system finansowy. Najbardziej bezpośrednim skutkiem są straty pieniężne. Prognozy branżowe przewidują, że do 2027 r, Straty związane z oszustwami finansowanymi przez generatywną sztuczną inteligencję mogą osiągnąć $40 miliardów w USAz $12,3 mld euro w 2023 r.[20]. Ten ponad trzykrotny wzrost (a 32% CAGR) odzwierciedla, jak szybko rośnie ryzyko oszustwa w dolarach.

Prognozowane straty z tytułu oszustw z wykorzystaniem sztucznej inteligencji dramatycznie rosną. Deloitte szacuje, że straty z tytułu oszustw finansowych w USA związanych z generatywną sztuczną inteligencją wzrosną z $12,3 mld euro w 2023 r. do $40 mld euro do 2027 r.[20].

Oprócz surowych strat, istnieją również te związane z reputacją i koszty powiernicze. Konsumenci oczekują, że ich banki będą ich chronić - ale oszustwa wykorzystujące sztuczną inteligencję podważają zaufanie do kanałów cyfrowych. Na przykład, jeśli klient padnie ofiarą przekonującego oszustwa typu deepfake (np. fałszywej rozmowy wideo z bankierem), może obwiniać bank za nieodpowiednie zabezpieczenia. Zaufanie publiczne Weryfikacja głosowa, e-maile, a nawet wideokonferencje mogą ulec pogorszeniu, jeśli "to, co widzisz/słyszysz" nie będzie mogło być uznane za prawdziwe.[21]. Według badań 85% specjalistów ds. finansów w USA i Wielkiej Brytanii postrzega oszustwa typu deepfake jako "egzystencjalne" zagrożenie dla bezpieczeństwa ich organizacji[22]. Ponad połowa firm na tych rynkach zgłosiła, że padła ofiarą oszustwa opartego na deepfake'ach, a niepokojące jest to, że 43% osób będących celem ataku przyznało, że atak się powiódł w oszukiwaniu ich[23]. Każdy udany incydent nie tylko powoduje straty finansowe, ale także podważa zaufanie klientów do instytucji.

Firmy finansowe również zmagają się z Wyzwania operacyjne i związane ze zgodnością od oszustw związanych ze sztuczną inteligencją. Zespoły ds. zwalczania nadużyć finansowych borykają się z gwałtownym wzrostem liczby alertów i incydentów, co nadwyręża zasoby dochodzeniowe. Istniejące modele wykrywania oszustw (z których wiele opiera się na regułach lub starszych technikach uczenia maszynowego) mogą mieć trudności z rozpoznaniem treści zsyntetyzowanych przez sztuczną inteligencję, które wyglądają na legalne. W rzeczywistości najnowocześniejsze systemy głębokiego wykrywania fałszywych treści opracowane w laboratoriach odnotowują spadek dokładności o prawie 50% w konfrontacji z deepfakes w świecie rzeczywistym na wolności[24]. Personel ludzki nie radzi sobie dużo lepiej - badania wykazały, że ludzie są w stanie wykryć wysokiej jakości deepfake'owe filmy tylko w okolicach 55%-60% czasuledwie lepszy niż przypadek[25]. Wskazuje to, że bez nowych narzędzi banki przegapią dużą część prób oszustw opartych na sztucznej inteligencji.

Istnieje również wymiar regulacyjny. Organy regulacyjne i organy ścigania są świadome zagrożeń (o czym świadczy ostrzeżenie FinCEN) i oczekują, że instytucje finansowe się dostosują. Banki mogą stanąć w obliczu surowszych wytycznych dotyczących weryfikacji klientów i zgłaszania oszustw w erze sztucznej inteligencji. Na przykład, jeśli pracownik banku zostanie oszukany przez deepfake do zatwierdzenia przelewu o wartości $10 milionów, organy regulacyjne mogą przeanalizować kontrole banku i procesy należytej staranności. The Ustawa o tajemnicy bankowej teraz wyraźnie obejmuje zgłaszanie podejrzeń o cyberprzestępczość i aktywność związaną z deepfake.[26][4]Oznacza to, że banki muszą przeszkolić pracowników w zakresie rozpoznawania i zgłaszania wskaźników oszustw generowanych przez sztuczną inteligencję w raportach o podejrzanych działaniach (SAR). Nienadążanie za technikami oszustw z wykorzystaniem sztucznej inteligencji może prowadzić do naruszeń zgodności lub odpowiedzialności prawnej, jeśli klienci lub kontrahenci twierdzą, że bank nie zrobił wystarczająco dużo, aby zapobiec możliwym do przewidzenia oszustwom z wykorzystaniem sztucznej inteligencji.

Być może największym wyzwaniem jest asymetryczny charakter tego nowego zagrożenia. Generatywna sztuczna inteligencja znacznie obniża koszty i barierę umiejętności dla atakujących, jednocześnie wykładniczo zwiększając ilość i realizm ataków. Pojedyncza wirusowa plotka deepfake lub przekonujące połączenie klonowane głosowo może pokonać miliony dolarów inwestycji w uwierzytelnianie. Tymczasem obrońcy muszą weryfikować autentyczność każdej transakcji i interakcji, co jest znacznie trudniejszym zadaniem. To prawdziwy wyścig zbrojeń: Sztuczna inteligencja daje oszustom samoaktualizujący się zestaw narzędzi do omijania zabezpieczeń, wymagając od banków ciągłego aktualizowania swoich mechanizmów obronnych[15][27]. Wiele instytucji finansowych przyznaje, że nie są odpowiednio przygotowane. ponad 80% firm nie posiada formalnego planu reagowania na ataki deepfakea ponad połowa nie zapewniła pracownikom żadnych szkoleń na temat zagrożeń związanych z deepfake.[28][29]. Ta luka w gotowości oznacza, że organizacje są obecnie podatne na zagrożenia, ale także wskazuje, gdzie potrzebne są działania.

Godne uwagi i otrzeźwiające dane pochodzą z najnowszego raportu branżowego: 42,5% prób oszustw w sektorze finansowym obejmuje obecnie jakąś formę sztucznej inteligencji.[30]. Innymi słowy, prawie połowa ataków oszustw, z którymi spotykają się banki, ma komponent sztucznej inteligencji - niezależnie od tego, czy jest to dokument wygenerowany przez sztuczną inteligencję, zsyntetyzowany głos czy wiadomość phishingowa wygenerowana maszynowo. Statystyki te podkreślają, że sztuczna inteligencja nie jest hipotetycznym przyszłym zagrożeniem; już tu jest, zmuszając instytucje finansowe do dostosowania się lub stawienia czoła rosnącym stratom.

Obrona przed oszustwami z wykorzystaniem sztucznej inteligencji: Strategie i rozwiązania

Konfrontacja z oszustwami opartymi na sztucznej inteligencji wymaga ewolucji strategii zapobiegania oszustwom. Tradycyjne podejścia (takie jak ręczna weryfikacja lub statyczne silniki reguł) nie pasują do zmieniających kształt oszustw AI. Zamiast tego banki muszą przyjąć technology (like making sure they have a Secure SSL Certificate), training, and teamwork aby odwrócić bieg wydarzeń. Poniżej przedstawiamy kluczowe strategie i nowe rozwiązania:

- Wykorzystaj sztuczną inteligencję do walki ze sztuczną inteligencją (zaawansowane narzędzia do wykrywania): Instytucje finansowe coraz częściej sięgają po Rozwiązania do wykrywania oparte na sztucznej inteligencji aby zidentyfikować treści i anomalie generowane przez sztuczną inteligencję. Zasadniczo trzeba zwalczać ogień ogniem. Nowe narzędzia dla przedsiębiorstw, takie jak TruthScan oferować multimodalne wykrywanie AI w tekście, obrazach, głosie i wideo, aby pomóc w uwierzytelnianiu treści w czasie rzeczywistym[31]. Na przykład banki mogą wdrożyć detektory tekstu AI do skanowania przychodzącej komunikacji (wiadomości e-mail, wiadomości na czacie) pod kątem oznak języka generowanego przez AI, które mogą wskazywać na phishing lub fałszywe zapytanie klienta. System wykrywania tekstu AI firmy TruthScan może identyfikować treści napisane przez AI na podstawie modeli takich jak GPT-4 z Dokładność 99%+nawet wskazując, które zdania są prawdopodobnie generowane przez sztuczną inteligencję[32][33]. Podobnie, narzędzia do analizy obrazu AI mogą weryfikować dokumenty i obrazy; a Detektor obrazu AI może oznaczyć, czy przesłane prawo jazdy lub rachunek za media zostały utworzone cyfrowo lub zmanipulowane, porównując je ze znanymi wzorcami obrazów generowanych przez sztuczną inteligencję[34]. W przypadku zagrożeń dźwiękowych banki zaczynają stosować wykrywacze fałszywych alarmów głosowych - rozwiązania, które analizują dźwięk połączeń pod kątem akustycznych odcisków palców mowy syntetycznej. Na przykład AI Voice Detector firmy TruthScan nasłuchuje charakterystycznych oznak klonowania głosu i może weryfikacja autentyczności mówcy aby zapobiec fałszywym połączeniom[35]. Integrując te detektory za pośrednictwem interfejsu API ze swoimi przepływami pracy, instytucje finansowe mogą automatycznie sprawdzać zawartość AI w tle transakcji i interakcji. Zapewnia to dodatkową warstwę obrony, która działa z prędkością maszyny, wyłapując to, co ludzkie oczy/uszy mogą przegapić.

- Wdrożenie weryfikacji wieloskładnikowej i pozapasmowej: Ponieważ sztuczna inteligencja utrudnia zaufanie głosom lub obrazom, banki powinny w większym stopniu polegać na metodach weryfikacji, których sztuczna inteligencja nie może łatwo podrobić. Obejmuje to uwierzytelnianie wieloskładnikowe (MFA) przy użyciu bezpiecznych kanałów. Na przykład, jeśli żądanie przelewu przychodzi za pośrednictwem wiadomości e-mail lub połączenia wideo, należy wymagać drugiego czynnika, takiego jak jednorazowy kod dostępu wysłany na znane urządzenie mobilne wnioskodawcy lub oddzwonienie na zaufany numer telefonu w pliku. Niektóre banki dodają kontrole "aktywności" dla transakcji wysokiego ryzyka - na przykład prosząc klienta o zrobienie selfie na żywo z określonym gestem lub słowem, co jest trudniejsze do odtworzenia przez deepfake wideo. Uwierzytelniacze biometryczne można wzbogacić o środki zapobiegające fałszerstwom (np. skanowanie pod kątem głębi twarzy 3D lub monitorowanie subtelnych ruchów oczu, których deepfake często nie jest w stanie naśladować).[27]). Kluczem jest unikanie pojedynczych punktów awarii. Nawet jeśli deepfake sztucznej inteligencji może oszukać jeden kanał (powiedzmy weryfikację głosową), skoordynowana kontrola poza pasmem lub test biometryczny może stanowić wyzwanie niezbędne do ujawnienia oszustwa. Zasady zerowego zaufania należy stosować: traktować wszelkie niezamówione lub nieoczekiwane instrukcje (nawet od "znanego" kierownika lub klienta) jako podejrzane, dopóki nie zostaną zweryfikowane za pośrednictwem niezależnego kanału.

- Szkolenie pracowników i świadomość oszustw: Sama technologia nie jest najlepszym rozwiązaniem - zwłaszcza, że oszuści będą atakować najsłabsze ogniwo, którym często jest ludzkie zaufanie. Instytucje finansowe powinny inwestować w regularne szkolenia dla zespołów ds. zapobiegania oszustwom i pracowników pierwszej linii na temat oszustw opartych na sztucznej inteligencji. Pracownicy muszą nauczyć się rozpoznawać czerwone flagi deepfake i inżynierii społecznej. Może to obejmować szkolenie w zakresie subtelnych anomalii (np. problemy z synchronizacją ruchu warg w rozmowie wideo lub dźwięk zawierający nienaturalną intonację lub zbyt mały hałas w tle - potencjalne oznaki syntetycznego głosu). Zachęcanie do kultury weryfikacjaPracownicy powinni czuć się upoważnieni do wstrzymania podejrzanej transakcji lub żądania i zweryfikowania go niezależnie, nawet jeśli wydaje się, że pochodzi od dyrektora generalnego. Przypadek Próba podrobienia głosu CEO Ferrari jest pouczające - kierownik odkrył podstęp tylko dzięki zadaniu osobistego pytania, na które oszust nie mógł odpowiedzieć[36]. Przydatne mogą być również symulowane ćwiczenia phishingowe/deepfake. Podobnie jak firmy przeprowadzają symulacje phishingu w celu przeszkolenia personelu, mogą symulować fałszywą pocztę głosową lub fałszywe spotkanie wideo i sprawdzić, czy pracownicy je wykryją. Buduje to pamięć mięśniową, aby oprzeć się prawdziwym atakom. Biorąc pod uwagę, że ponad 50% firm nie posiada protokołów reagowania na deepfake i niewiele szkoleń w tym zakresie[29]Wdrożenie takich programów jest nisko wiszącym owocem w celu poprawy odporności.

- Analiza oszustw i wykrywanie anomalii: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier dźwięki generowane przez AI lub zbyt formalne (w połączeniu ze wspomnianym wcześniej wykrywaniem tekstu przez sztuczną inteligencję). Banki takie jak JPMorgan zaczęły wykorzystywać duże modele językowe w swojej wewnętrznej komunikacji, aby wykrywać frazy lub konteksty, które mogą wskazywać na próbę inżynierii społecznej[37]. Sieci płatnicze, takie jak Mastercard, skanują ogromne zbiory danych (miliardy transakcji) za pomocą sztucznej inteligencji, aby zidentyfikować nieuczciwe transakcje, które tradycyjne zasady mogłyby przeoczyć[38]. Wniosek jest taki, że defensywna sztuczna inteligencja musi być równie innowacyjna, co ofensywna sztuczna inteligencja. Firmy powinny rozważyć opracowanie lub zakup modeli sztucznej inteligencji specjalnie w celu wykrywania fałszywych treści, syntetycznych tożsamości i generatywnych wzorców ataków. Co najważniejsze, modele te powinny być stale szkolone na najnowszych przykładach oszustw AI (praktyka zwana uczeniem się online lub uczeniem federacyjnym), aby nadążały za szybko ewoluującymi taktykami przestępców[39][40].

- Współpraca i wymiana informacji: Walka z oszustwami opartymi na sztucznej inteligencji będzie wymagać współpracy zarówno wewnątrz instytucji, jak i między nimi. Silosowe wysiłki są mniej skuteczne w walce z zagrożeniem, które przekracza granice organizacyjne. Zespoły ds. zapobiegania oszustwom, zespoły ds. cyberbezpieczeństwa i IT muszą pracować ramię w ramię - na przykład zespoły ds. bezpieczeństwa mogą wdrożyć wykrywanie deepfake w narzędziach do wideokonferencji, podczas gdy zespoły ds. oszustw integrują skanowanie treści z monitorowaniem transakcji. Na szerszym poziomie banki powinny uczestniczyć w grupach branżowych, takich jak Financial Services Information Sharing and Analysis Center (FS-ISAC), aby wymieniać się informacjami na temat nowych schematów oszustw AI[41]. Jeśli jeden bank odkryje nowy wektor ataku deepfake, podzielenie się tym spostrzeżeniem może pomóc innym wypełnić lukę, zanim zostaną trafieni. Wspólne ćwiczenia lub symulacje "czerwonego zespołu" ze scenariuszami obejmującymi sztuczną inteligencję (np. oszustwo wykonawcze typu deepfake lub obejście weryfikacji tożsamości generowane przez sztuczną inteligencję) mogą być przeprowadzane za pośrednictwem konsorcjów branżowych lub przy wsparciu organów regulacyjnych. Same organy regulacyjne koncentrują się na zagrożeniach związanych ze sztuczną inteligencją, więc proaktywne angażowanie się w nie jest rozsądne. Przyczyniając się do tworzenia standardów i wytycznych dotyczących wykorzystania sztucznej inteligencji, banki mogą pomóc w kształtowaniu bezpieczniejszego ekosystemu. Ostatecznie, ponieważ zagrożenie dla jednego banku jest zagrożeniem dla wszystkich w tej przestrzeni[42]Zbiorowe podejście do obrony wzmocni zdolność wszystkich do wykrywania i powstrzymywania oszustw z wykorzystaniem sztucznej inteligencji.

- Edukacja klientów i środki zaufania: Wreszcie, instytucje finansowe nie powinny pomijać roli świadomości klientów. Biorąc pod uwagę oszustwa deepfake i AI skierowane do ogółu społeczeństwa (na przykład fałszywe głosy w oszustwach dziadków lub fałszywe czaty "wsparcia technicznego" generowane przez AI), banki mogą pomóc w edukowaniu klientów o tych zagrożeniach. Wiele banków wysyła już ostrzeżenia o phishingu; mogą je rozszerzyć, aby wspomnieć o klonowaniu głosu AI i deepfake'owych filmach, podając wskazówki, jak weryfikować żądania. Niektóre postępowe organizacje wysyłają powiadomienia push lub ostrzeżenia w swoich aplikacjach, jeśli znane jest oszustwo (np. "Uwaga: oszuści mogą używać klonów głosowych członków rodziny proszących o pieniądze").[43]. Edukacja, choć nie zapobiega bezpośrednio atakom, może zmniejszyć wskaźnik powodzenia i wzmocnić przekonanie, że bank jest partnerem w zakresie bezpieczeństwa. Co więcej, banki, które inwestują w najnowocześniejsze metody zapobiegania oszustwom, powinny podkreślać to klientom jako wyróżnik - Na przykład poinformowanie klientów, że wszystkie rozmowy wideo lub przesłane dokumenty są skanowane przez sztuczną inteligencję pod kątem autentyczności (bez ujawniania wrażliwych metod) może zapewnić klientów, że bank wykorzystuje wszystkie dostępne narzędzia, aby ich chronić. Zachowanie cyfrowego zaufania będzie miało kluczowe znaczenie dla banków, aby w pełni wykorzystać zalety sztucznej inteligencji w usługach, więc przejrzystość i zabezpieczenia zorientowane na klienta są częścią holistycznej obrony.

Rola usług wykrywania treści AI

Kamieniem węgielnym zestawu narzędzi do zwalczania nadużyć finansowych w erze sztucznej inteligencji jest wykorzystanie Usługi wykrywania treści za pomocą sztucznej inteligencji. Usługi te specjalizują się w wykrywaniu "odcisków palców" treści generowanych przez sztuczną inteligencję, które mogą umknąć ludzkim recenzentom. TruthScan jest jednym z takich dostawców oferujących usługę klasy korporacyjnej AI Detection Suite obejmujące wiele typów treści. Instytucje finansowe mogą zintegrować te narzędzia, aby automatycznie sprawdzać wskaźniki fałszerstw i oszustw:

- Weryfikacja dokumentów i obrazów: Platforma TruthScan umożliwia bankom testowanie dokumentów finansowych pod kątem oszustw generowanych przez sztuczną inteligencję w czasie rzeczywistym[44]. Oznacza to, że po otwarciu nowego konta lub otrzymaniu wniosku o pożyczkę wraz z dokumentem tożsamości ze zdjęciem i odcinkiem wypłaty, system może natychmiast przeanalizować te obrazy pod kątem oznak syntetycznego generowania lub manipulacji. Z dokładnością ponad 99%[45]Wykrywacz obrazów AI może wychwycić fałszywe obrazy identyfikacyjne lub sfałszowane pliki PDF, które człowiek może zatwierdzić za dobrą monetę. Ten rodzaj Weryfikacja autentyczności dokumentów ma kluczowe znaczenie dla powstrzymania oszustw związanych z syntetyczną tożsamością jeszcze przed otwarciem kont.

- Monitorowanie transakcji w czasie rzeczywistym: Wdrażając integracje API, TruthScan może podłączyć się do przetwarzania transakcji banków i oznaczyć anomalie w czas rzeczywisty. Jeśli instrukcja przychodzi pocztą e-mail, która wydaje się podejrzana, Email Scam Detector może przeanalizować treść wiadomości i wykryć, czy została ona prawdopodobnie napisana przez model sztucznej inteligencji próbujący podszyć się pod dostawcę lub kierownictwo[46]. Podobnie Detektor AI działający w czasie rzeczywistym może monitorować komunikację na żywo (taką jak czaty lub platformy współpracy), aby zapewnić natychmiastowe alerty, jeśli na przykład podczas spotkania o wysokiej stawce zostanie wykryty fałszywy kanał wideo.[47][48]. Ciągłe monitorowanie z natychmiastowymi alertami i zautomatyzowanymi reakcjami pomaga zmniejszyć okno, w którym oszustwo może zostać niewykryte.

- Obrona przed fałszerstwami głosowymi i wideo: Dla centrów telefonicznych i menedżerów relacji, włączenie TruthScan Detektor głosu AI dodaje dodatkową warstwę zabezpieczeń. Jeśli oszust zadzwoni podszywając się pod klienta używającego klonu głosowego, system może przeanalizować dźwięk połączenia i oznaczyć, czy zawiera on elementy zsyntetyzowane przez sztuczną inteligencję (takie jak brakujące naturalne mikropauzy lub artefakty w falach dźwiękowych)[35]. Na froncie wideo Deepfake Detector stosuje algorytmy wizji komputerowej do klatek wideo, aby wychwycić niespójności - takie jak nienaturalne ruchy twarzy, dziwne oświetlenie lub niedopasowana synchronizacja ust - które ujawniają fałszerstwo.[49][50]. Weryfikując integralność głosów i twarzy w kluczowych interakcjach, banki mogą udaremnić oszustów próbujących oszukać ich pracowników. Narzędzia te działają jak zaawansowany technologicznie wykrywacz kłamstw dla treści cyfrowych, działając niewidocznie w tle.

Warto zauważyć, że wdrożenie takiej technologii wykrywania nie jest lekarstwem typu plug-and-play; należy ją skalibrować i dostosować do przepływów pracy instytucji. Należy zarządzać fałszywymi alarmami (na przykład detektor tekstu AI może oznaczać legalną komunikację opartą na szablonach jako podejrzaną, dopóki nie nauczy się różnicy). Jednakże, gdy narzędzia te są odpowiednio zintegrowane, znacznie poprawiają zdolność organizacji do wykrywanie fałszywych treści, zanim spowodują szkody. Generują również ścieżki audytu i raporty analityczne, które są przydatne do zapewnienia zgodności i ciągłego ulepszania modeli oszustw.

Co najważniejsze, skuteczność narzędzi do wykrywania sztucznej inteligencji zależy od stałe aktualizacje. Tak jak oprogramowanie antywirusowe wymaga nowych sygnatur dla nowych wirusów, tak detektory AI wymagają ponownego przeszkolenia w zakresie najnowszych technik deepfake i modeli AI. Dostawcy tacy jak TruthScan aktualizują swoje algorytmy, aby obsługiwać nowe modele generatywne i taktyki unikania, utrzymując wysoką dokładność nawet w miarę ewolucji sztucznej inteligencji[51]. Odciąża to zespoły wewnętrzne i zapewnia, że banki nie walczą we wczorajszej wojnie, podczas gdy przestępcy przechodzą do nowych sztuczek AI.

Wnioski

Branża usług finansowych stoi na rozdrożu w walce z oszustwami. Z jednej strony przestępcy szybko wykorzystują generatywną sztuczną inteligencję do wprowadzania oszustw, które są bardziej przekonujące i powszechne niż kiedykolwiek. Z drugiej strony, banki i osoby walczące z oszustwami mają do dyspozycji coraz większy arsenał środków obronnych opartych na sztucznej inteligencji. Instytucje, które będą prosperować, to te, które rozpoznać nowy krajobraz zagrożeń i reagować z równą pomysłowością. Oznacza to inwestowanie w zaawansowane możliwości wykrywania, integrację wielowarstwowych procesów weryfikacji, edukowanie zarówno pracowników, jak i klientów oraz wspieranie kultury czujności i adaptacji.

Oszustwa oparte na sztucznej inteligencji są szybko zmieniającym się celem - oszustwo typu deepfake, które dziś oszukało firmę, może zostać zwalczone przez nowe techniki wykrywania jutro, tylko po to, by oszuści zmienili swoje metody w przyszłym tygodniu. W związku z tym strategia zapobiegania oszustwom w 2025 r. "zgodna ze standardami branżowymi" to taka, która kładzie nacisk na elastyczność i ciągłe doskonalenie. Organizacje finansowe powinny traktować swoje systemy ochrony przed oszustwami jako żywe, uczące się jednostki które ewoluują wraz z taktykami przestępców. Wykorzystanie partnerstwa z dostawcami technologii to sprytny skrót do budowania tych możliwości. Na przykład współpraca z wyspecjalizowanymi firmami, takimi jak TruthScan (która oferuje rozwiązania dostosowane do bankowości i finansów), może przyspieszyć zdolność instytucji do zapobieganie oszustwom z wykorzystaniem sztucznej inteligencji przy jednoczesnym zachowaniu zgodności z przepisami i zaufania klientów[52].

Ostatecznie ochrona przed oszustwami opartymi na sztucznej inteligencji to nie tylko kwestia technologii - chodzi o zachowanie fundamentalnych zaufanie która leży u podstaw finansów. Klienci muszą mieć pewność, że ich bank może odróżnić prawdziwą transakcję od fałszywej, prawdziwego klienta od oszusta AI. Wdrażając najnowocześniejsze narzędzia do wykrywania sztucznej inteligencji, wzmacniając protokoły weryfikacji i wyprzedzając pojawiające się zagrożenia, firmy świadczące usługi finansowe mogą utrzymać to zaufanie. Przyszłość niewątpliwie będzie obfitować w kolejne próby oszustw ze strony przeciwników, ale dzięki gotowości i odpowiednim inwestycjom banki mogą zapewnić, że Sztuczna inteligencja staje się bardziej atutem niż zagrożeniem w dziedzinie zapobiegania oszustwom. Jest to osiągalny cel: te same technologie sztucznej inteligencji, które zagrażają zakłóceniom, można wykorzystać do ochrony integralności naszego systemu finansowego. Nadszedł czas, aby zespoły ds. zapobiegania oszustwom i kadra kierownicza podjęły zdecydowane działania, wdrażanie zaawansowanych rozwiązań i strategii w celu przechytrzenia oszustów i zabezpieczyć przyszłość finansów cyfrowych.

Źródła: Najnowsze raporty branżowe, ostrzeżenia regulacyjne i oficjalne dokumenty technologiczne zostały przywołane w całym tekście (Deloitte[20][18]Światowe Forum Ekonomiczne[19][24], Departament Skarbu USA FinCEN[3][4]Rezerwa Federalna[13]Keepnet Labs[16][30]między innymi) w celu dostarczenia danych i przykładów. Wszystkie dane i przykłady są cytowane w tekście, aby umożliwić czytelnikom dalszą analizę.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking i ryzyko oszustw związanych ze sztuczną inteligencją | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Wykrywanie niebezpiecznej sztucznej inteligencji jest niezbędne w erze deepfake | Światowe Forum Ekonomiczne

[3] [4] [26] FinCEN wydaje ostrzeżenie o oszustwach z wykorzystaniem fałszywych mediów wymierzonych w instytucje finansowe | FinCEN.gov

[7] [8] FraudGPT i GenAI: Jak oszuści będą wykorzystywać sztuczną inteligencję? | Alloy

[11] Syntetyczne oszustwa tożsamościowe: Jak sztuczna inteligencja zmienia zasady gry - Bank Rezerwy Federalnej w Bostonie

[12] [13] Generatywna sztuczna inteligencja zwiększa zagrożenia związane z oszustwami dotyczącymi tożsamości syntetycznej

[16] [17] [22] [23] [28] [29] [30] Statystyki i trendy Deepfake 2025 | Kluczowe dane i spostrzeżenia - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - wykrywanie AI w przedsiębiorstwie i bezpieczeństwo treści

[32] [33] [51] AI Detector: Wykrywanie tekstu AI klasy korporacyjnej - TruthScan

[44] [45] [52] Wykrywanie oszustw bankowych AI | Rozwiązania CRO | TruthScan

[49] [50] Deepfake Detector - identyfikacja fałszywych filmów i sztucznej inteligencji - TruthScan