Kompleksowy przewodnik po zrozumieniu, wykrywaniu i zapobieganiu oszustwom głosowym AI w przedsiębiorstwie

Milionowe połączenie głosowe $25, które nigdy nie miało miejsca

W lutym 2024 roku pracownica działu finansów w międzynarodowej firmie w Hongkongu otrzymała połączenie wideo od swojego dyrektora finansowego.

Głos po drugiej stronie był niepowtarzalny; każda fleksja, każda pauza, a nawet lekki akcent zostały natychmiast rozpoznane.

Pilnie poprosił ją o przetworzenie 15 przelewów bankowych na łączną kwotę $25 milionów w celu sfinalizowania poufnego przejęcia.

Nigdy więcej nie martw się o oszustwa związane ze sztuczną inteligencją. TruthScan Może ci pomóc:

- Wykrywanie wygenerowanych przez AI obrazy, tekst, głos i wideo.

- Unikać poważne oszustwa oparte na sztucznej inteligencji.

- Chroń swoje najbardziej wrażliwy aktywa przedsiębiorstwa.

Dyrektor finansowy nigdy nie wykonał tego połączenia. Został on całkowicie wygenerowany przez sztuczną inteligencję.

Nie był to odosobniony przypadek. Instytucje finansowe odnotowują gwałtowny wzrost liczby oszustw typu deepfake.

W ciągu ostatnich trzech lat liczba przypadków wzrosła o 217%, a sztuczna inteligencja odpowiada obecnie za 42,5% wszystkich prób oszustw w tym sektorze.

Nawet przy wzroście liczby oszustw głosowych z wykorzystaniem sztucznej inteligencji, ponad połowa liderów biznesowych przyznaje, że ich pracownicy nie zostali przeszkoleni w zakresie wykrywania lub reagowania na ataki typu deepfake; prawie 80% firm nie ma formalnych protokołów do obsługi takich incydentów.

Jak działa klonowanie głosu AI i dlaczego stanowi zagrożenie?

Nowoczesna synteza głosu AI potrzebuje zaskakująco mało danych. Zaledwie kilka sekund dźwięku może sklonować głos z dokładnością do 85%.

Proces ten sprowadza się do trzech głównych kroków:

- Gromadzenie danych: Oszuści zbierają próbki głosu z publicznych źródeł, takich jak połączenia konferencyjne, wywiady podcastowe, klipy z mediów społecznościowych, a nawet posty wideo na LinkedIn.

- Szkolenie modelowe: Sztuczna inteligencja analizuje cechy głosu, takie jak wysokość, ton, akcent, tempo i sposób oddychania.

- Generacja: System tworzy syntetyczną mowę na tyle przekonującą, by oszukać nawet bliskich współpracowników.

Problem z dostępnością

To, co czyni to zagrożenie jeszcze bardziej niebezpiecznym, to jego demokratyzacja. Oszuści nie potrzebują już zasobów na poziomie Hollywood.

Wszystko, czego potrzeba, to dostępne oprogramowanie do klonowania głosu z krótkiego klipu w mediach społecznościowych; narzędzia open source i oparte na chmurze usługi AI sprawiły, że klonowanie głosu stało się dostępne dla każdego z podstawowymi umiejętnościami technicznymi.

Dlaczego kadra kierownicza jest głównym celem oszustw?

Kadra kierownicza stoi w obliczu niebezpiecznej mieszanki czynników ryzyka.

Ich publiczna ekspozycja w mediach społecznościowych sprawia, że próbki głosowe są łatwe do znalezienia, a ich autorytet często skłania pracowników do szybkiego działania w przypadku pilnych wniosków.

Średnio jeden na czterech dyrektorów ma ograniczoną wiedzę na temat technologii deepfake.

Aktualne statystyki przedstawiają niepokojący obraz

W Badanie Deloitte z 2024 r.25,9% dyrektorów stwierdziło, że ich organizacje miały do czynienia z co najmniej jednym incydentem typu deepfake wymierzonym w dane finansowe lub księgowe w ciągu ostatniego roku, a połowa wszystkich respondentów uważa, że takie ataki będą się nasilać w ciągu najbliższych 12 miesięcy.

Co najbardziej niepokojące: tylko 52% organizacji czuje się pewnie, że mogłoby wykryć deepfake swojego CEO.

Jak rozpoznać oszustwa głosowe związane ze sztuczną inteligencją

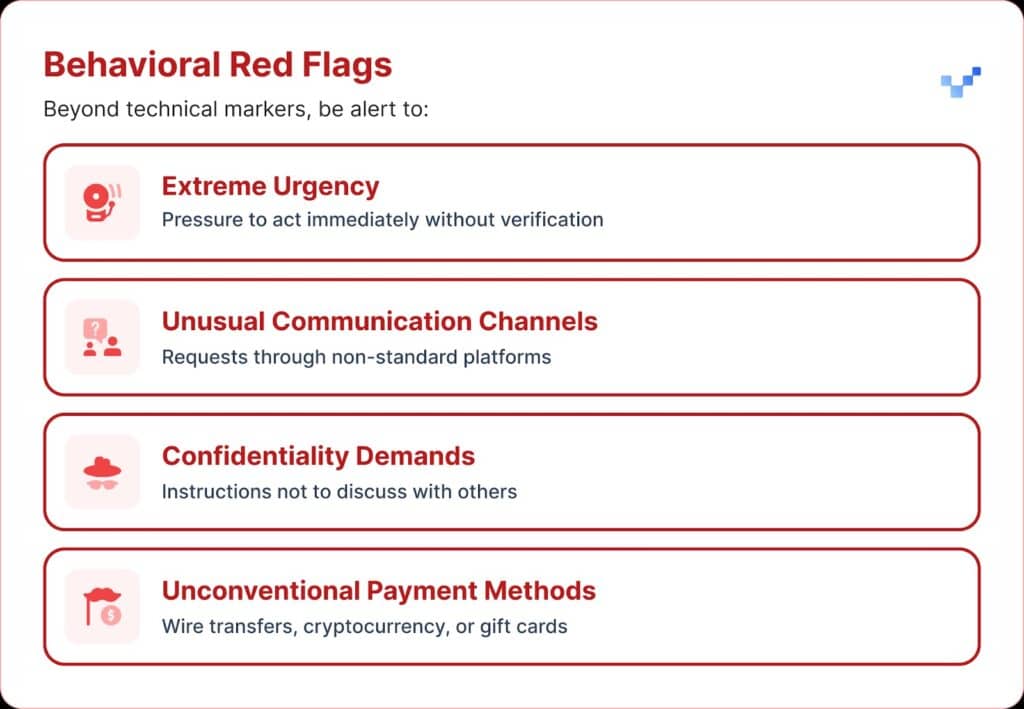

Po otrzymaniu podejrzanego komunikatu głosowego należy zwrócić uwagę na kilka znaków ostrzegawczych.

Oszustwa głosowe AI często brzmią monotonnie lub płasko. Można również zauważyć nietypowe tempo, z dziwnymi pauzami lub nienaturalnym rytmem.

Dźwięk może również przenosić słabe elektroniczne brzęczenie lub echo, szczególnie podczas dłuższych połączeń.

W wielu przypadkach głos powtarza ograniczone frazy, które wydają się być skryptowane lub przećwiczone.

Wpływ finansowy i rzeczywiste koszty

Większość organizacji straciła średnio około $450,000, ale w sektorze usług finansowych straty wzrosły powyżej $603,000.

W najpoważniejszych przypadkach 1 na 10 organizacji zgłosiła straty przekraczające $1 milionów.

Trend ten szybko się nasilił. Wcześniejsze badania z 2022 r. wskazywały, że średnie obciążenie finansowe związane z oszustwami dotyczącymi tożsamości wynosiło około $230 000, czyli prawie połowę obecnej wartości.

Prognozowane przyszłe straty

Według Deloitte's Center for Financial Services, pieniądze utracone w wyniku oszustw związanych ze sztuczną inteligencją w USA mogą wzrosnąć z $12,3 miliarda w 2023 roku do $40 miliarda do 2027 roku. To około 32% wzrostu każdego roku.

Podatność regionalna

W Ameryce Północnej odnotowano wzrost liczby oszustw typu deepfake o 1740%.

Ten znaczny wzrost regionalny sugeruje, że Ameryka Północna może być głównym celem oszustów typu deepfake, prawdopodobnie ze względu na dużą gospodarkę cyfrową i powszechne korzystanie z usług online.

Strategiczne podejście do ochrony kadry kierowniczej

1. Wdrożenie protokołów weryfikacji

Jednym ze sposobów na wzmocnienie obrony jest użycie systemu "bezpiecznych słów", czyli wcześniej uzgodnionych zwrotów uwierzytelniających udostępnianych kluczowym pracownikom.

Oszust korzystający z klonowania głosu za pomocą sztucznej inteligencji nie będzie znał właściwych odpowiedzi na osobiste pytania weryfikacyjne.

Kolejnym zabezpieczeniem jest weryfikacja wielokanałowa.

Wszelkie nietypowe żądania finansowe powinny być potwierdzane za pośrednictwem osobnego kanału komunikacji, nigdy nie polegając wyłącznie na pierwotnej metodzie kontaktu.

Firmy powinny również ustanowić jasne zasady eskalacji, z okresami oczekiwania i etapami zatwierdzania dużych transakcji finansowych, niezależnie od tego, kto o nie wnioskuje.

2. Pamiętaj o ekspozycji cyfrowej

Kolejna warstwa ochrony polega na ograniczeniu ilości wykonawczych materiałów audio i wideo dostępnych online. Im więcej próbek mogą zebrać oszuści, tym bardziej przekonujące stają się ich klony.

Pomocne jest również ustalenie jasnych wytycznych dotyczących mediów społecznościowych dla kadry kierowniczej, zwłaszcza w zakresie publikowania filmów z czystym dźwiękiem.

A jeśli chodzi o konferencje, organizacje powinny uważać na nagrane rozmowy lub wywiady, które zawierają długie fragmenty próbek głosu.

3. Wdrażanie rozwiązań technicznych

To właśnie tutaj zaawansowana technologia wykrywania AI staje się kluczowa.

Organizacje potrzebują uwierzytelniania głosowego klasy korporacyjnej i Wykrywanie podróbek możliwości, które zapewniają:

- Analiza w czasie rzeczywistym: Wykrywanie syntetycznych głosów podczas komunikacji na żywo

- Weryfikacja historyczna: Analiza nagranych rozmów i wiadomości pod kątem autentyczności

- Możliwości integracji: Bezproblemowa współpraca z istniejącymi platformami komunikacyjnymi

- Wysoka dokładność: Minimalizacja fałszywych alarmów przy jednoczesnym wychwytywaniu wyrafinowanych podróbek

4. Kompleksowe programy szkoleniowe

Zespoły kierownicze potrzebują ukierunkowanych szkoleń na temat zagrożeń głosowych AI i procedur weryfikacji.

Równie ważne jest podnoszenie świadomości pracowników.

Każdy, na dowolnym stanowisku, powinien być przygotowany do wykrywania potencjalnych deepfake'ów i zapobiegania cyberzagrożeniom przedostającym się do organizacji.

Regularne ćwiczenia symulacyjne mogą wzmocnić tę gotowość, wykorzystując pozorowane próby oszustw głosowych do testowania i udoskonalania procedur reagowania.

Zaawansowane rozwiązania AI do wykrywania głosu

Tradycyjne mechanizmy obronne zostały stworzone z myślą o zagrożeniach sieciowych, a nie o podszywaniu się pod człowieka z wykorzystaniem sztucznej inteligencji.

Główne powody, dla których standardowe narzędzia cyberbezpieczeństwa nie są w stanie poradzić sobie z inżynierią społeczną opartą na głosie:

- Brak sygnatury złośliwego oprogramowania: Połączenia głosowe nie uruchamiają tradycyjnych systemów bezpieczeństwa

- Czynnik ludzkiego zaufania: Ludzie naturalnie ufają temu, co słyszą, zwłaszcza znajomym głosom

- Luki w technologii wykrywania: Pomimo wzrostu liczby prób oszustw opartych na sztucznej inteligencji, w tym deepfake, tylko 22% instytucji finansowych wdrożyło narzędzia zapobiegania oszustwom oparte na sztucznej inteligencji

Potrzeba specjalistycznego wykrywania głosu

Nowoczesne oszustwa głosowe wymagają nowoczesnych możliwości wykrywania.

Klasa korporacyjna Systemy wykrywania głosu AI może:

- Analiza biomarkerów głosu: Wykrywanie subtelnych niespójności w mowie syntetycznej

- Przetwarzanie w czasie rzeczywistym: Natychmiastowe powiadomienia podczas podejrzanych połączeń

- Ciągłe uczenie się: Adaptacja do nowych technik syntezy głosu

- Gotowość do integracji: Praca z istniejącą infrastrukturą komunikacyjną

Organizacje poważnie myślące o ochronie przed oszustwami głosowymi muszą zainwestować w specjalnie opracowaną technologię wykrywania AI, która może dorównać wyrafinowaniu zagrożeń, z którymi mają do czynienia.

Oszustwa głosowe już tu są i nasilają się

W pierwszym kwartale 2025 r. oszustwa typu deepfake i kradzież tożsamości spowodowały ponad $200 milionów strat.

Phishing głosowy z klonami AI podskoczył o 442%, a ponad 400 firm dziennie jest atakowanych przez oszustwa typu deepfake CEO lub CFO.

Podczas gdy 56% firm twierdzi, że czuje się bardzo pewnie w wykrywaniu podróbek, tylko 6% faktycznie uniknęło strat finansowych z ich powodu.

Nie chodzi o to, czy Twoja organizacja będzie celem ataku, ale o to, czy jesteś na to gotowy.

Oszustwa głosowe zmieniają oblicze cyberbezpieczeństwa. Tradycyjne mechanizmy obronne nie nadążają za podszywaniem się pod AI.

Aby zachować ochronę, organizacje potrzebują lepszych narzędzi wykrywania, solidnych programów szkoleniowych i jasnych procedur weryfikacji.

Technologia do walki z oszustwami już tu jest. Prawdziwe pytanie brzmi, czy użyjesz jej przed pierwszym incydentem związanym z oszustwem głosowym, czy po nim.