Inleiding: Een nieuw tijdperk van AI-gestuurde aanvallen

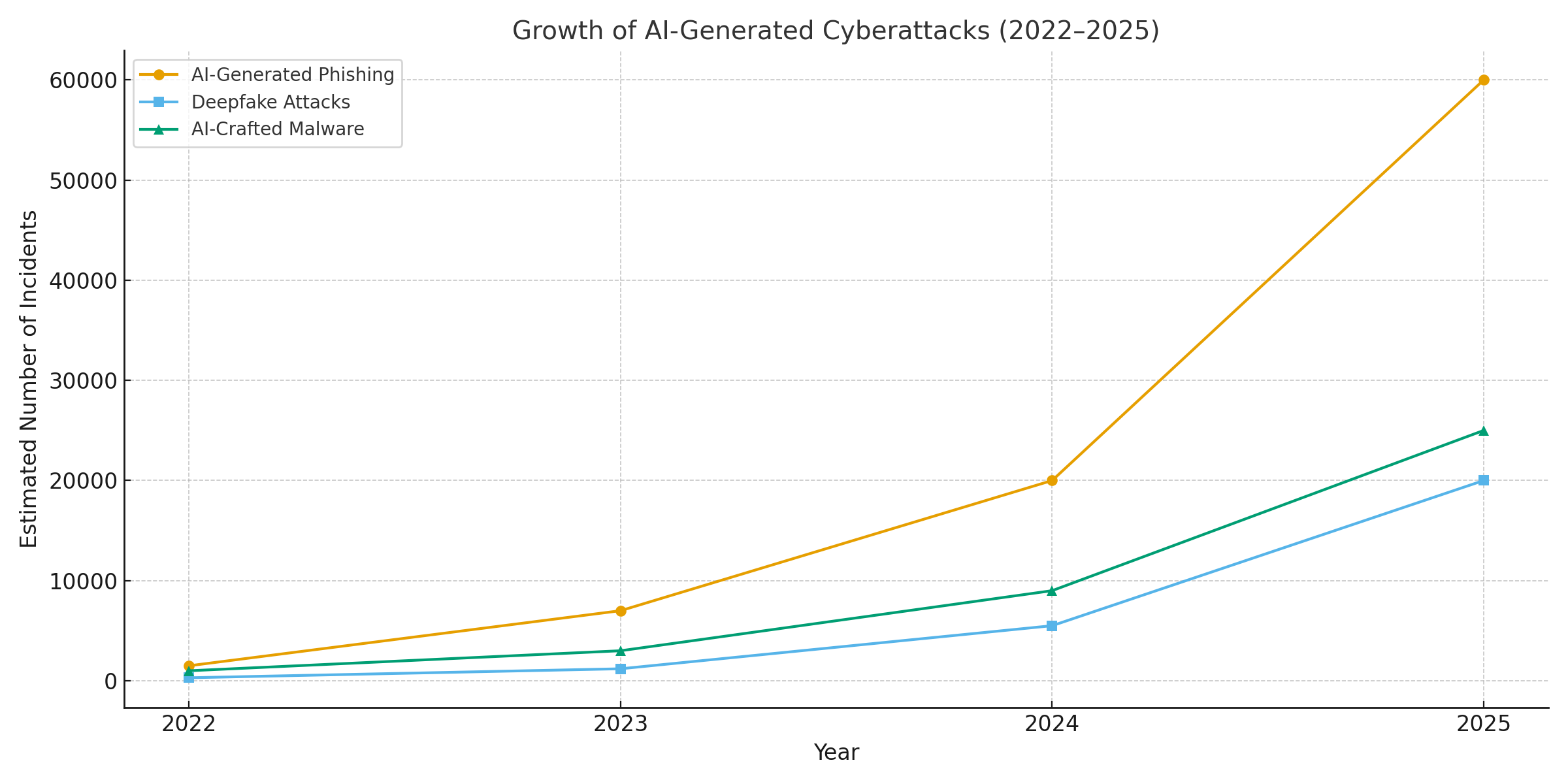

Het jaar 2025 markeert een kantelpunt in cyberbeveiliging. Generatieve AI heeft cyberaanvallen supercharged, waardoor dreigingsactoren meer frequent, realistisch en schaalbaar campagnes dan ooit tevoren. In het afgelopen jaar heeft naar schatting 16% van de gerapporteerde cyberincidenten betrof aanvallers die AI-tools inzetten (bijv. modellen voor het genereren van afbeeldingen en taal) om social engineering te verbeteren[1]. Van ultra-overtuigende phishing-e-mails tot deepfake audio/video-oplichting, kwaadwillende actoren maken in alle sectoren gebruik van AI. Een meerderheid van de beveiligingsprofessionals schrijft de toename cyberaanvallen aan generatieve AIwaardoor slechte actoren sneller en slimmer misbruik kunnen maken van slachtoffers[2]. Generatieve AI verlaagt in feite de vaardigheidsdrempel voor cybercriminaliteit, terwijl de potentie ervan toeneemt.

Waarom is dit zo verontrustend? AI kan direct gepolijste, contextbewuste inhoud produceren die zelfs getrainde gebruikers voor de gek houdt. Het kan zich met angstaanjagende nauwkeurigheid voordoen als stemmen en gezichten en zelfs kwaadaardige code genereren die verandert om detectie te omzeilen. Hierdoor zijn cyberaanvallen moeilijker te detecteren en eenvoudiger uit te voeren. De Wereld Economisch Forum waarschuwt dat 72% van de organisaties verhoogde cyberrisico's heeft gezien - met name social engineering en fraude - als gevolg van de toenemende mogelijkheden van generatieve AI.[3]. Incidenten in de echte wereld bevestigen dit: Begin 2024 gebruikten criminelen een door AI gegenereerde deepfake videogesprek om zich voor te doen als de CFO van een bedrijf en een werknemer te verleiden tot overplaatsing $25,6 miljoen aan de fraudeurs[4]. En in een ander geval gebruikten Noord-Koreaanse hackers AI-gegenereerde valse ID-documenten om veiligheidscontroles te omzeilen in een phishingcampagne van de verdediging[5]. Deze voorbeelden maken duidelijk wat er op het spel staat - generatieve AI maakt zwendel mogelijk die zowel menselijke als technische controles omzeilt.

Toch is AI ook een deel van de oplossing. Geavanceerde detectietools (zoals die van TruthScan) maken gebruik van AI tegen AI - het analyseren van inhoud voor de subtiele handtekeningen van machinale generatie. In deze whitepaper onderzoeken we de belangrijkste AI-gedreven cyberbedreigingen van 2025 en hoe organisaties deze kunnen beperken. Van AI-gegenereerde phishing naar deepfake CEO-fraude, AI-gecreëerde malware, synthetische identiteitenWe zullen onderzoeken hoe generatieve AI aanvallen opnieuw vormgeeft. We bespreken ook concrete verdedigingsmaatregelen, waaronder AI-inhouddetectie, deepfake forensisch onderzoek en technologieën voor identiteitsverificatie die beveiligingsteams kunnen helpen om de overhand te krijgen. Het doel is om te laten zien hoe ondernemingen, MSSP's, CISO's en fraudeonderzoekers het volgende kunnen doen AI-detectietools integreren in hun hele cyberbeveiligingspakket om deze golf van AI-bedreigingen tegen te gaan.

Maak je nooit meer zorgen over AI-fraude. TruthScan Kan je helpen:

- AI-opgewekt detecteren afbeeldingen, tekst, spraak en video.

- Vermijd grote AI-gestuurde fraude.

- Bescherm uw meest gevoelig bedrijfsmiddelen.

AI-gegenereerde phishing en BEC: oplichting op ongekende schaal

Een van de duidelijkste invloeden van generatieve AI is op phishing en zakelijke e-mailcompromittering (BEC) programma's. AI-taalmodellen kunnen binnen enkele seconden vloeiende, op de context afgestemde e-mails opstellen - zonder de verraderlijke grammaticafouten en onhandige zinsconstructies die phishing ooit verraadden. Het resultaat is een stortvloed aan zeer overtuigende frauduleuze e-mails en sms'jes. Tegen april 2025, meer dan de helft van de spam e-mails (51%) werd geschreven door AIvan vrijwel nul twee jaar eerder[6]. Nog verontrustender was dat onderzoekers ontdekten dat ongeveer 14% van BEC-aanvalsmails waren door AI gegenereerd tegen 2025[7] - Een cijfer dat naar verwachting zal stijgen naarmate criminelen tools zoals ChatGPT gaan gebruiken. Sommige studies schatten over 80% van phishingmails heeft nu mogelijk hulp van AI bij het maken ervan[8].

Het aantal van deze AI-gegenereerde lokmiddelen is explosief gestegen. Beveiligingsanalyses laten zien dat phishingaanvallen die zijn gekoppeld aan generatieve AI zijn gestegen met 1,265% in een korte tijd[9]. In één periode stegen de meldingen van phishing-incidenten met 466% in één kwartaalgrotendeels te wijten aan geautomatiseerde phishingkits en bots die aangepast aas oppompen[9][10]. Waarom zo'n piek? Omdat AI aanvallers schaal hun operaties dramatisch. Een enkele crimineel kan een AI-chatbot gebruiken om duizenden van gepersonaliseerde oplichtingsmails gericht op verschillende werknemers of klanten, allemaal in de tijd die het vroeger kostte om er een te maken. Deze massa-automatisering heeft ertoe geleid dat de FBI waarschuwt dat de BEC-verliezen (die in 2022 al $2,7 miljard bedroegen) alleen maar zullen toenemen nu AI "deze verliezen nog verder dreigt op te drijven".[11][12].

Er zijn niet alleen meer phishing e-mails, ze zijn ook effectiever. Slachtoffers worden sneller misleid door het gepolijste taalgebruik en de contextuele details die AI kan inbouwen. In laboratoriumtests behaalden AI-geschreven phishing e-mails een 54% doorklikratio - ver boven de ~12% voor traditionele phishingpogingen[13]. Deze berichten lezen als de stijl van een echte CEO of verwijzen naar echte bedrijfsgebeurtenissen, waardoor ontvangers minder op hun hoede zijn. Aanvallers gebruiken zelfs AI om verschillende formuleringen te A/B-testen en de meest succesvolle haakjes te herhalen.[14]. En in tegenstelling tot mensen, maakt AI geen typefouten of wordt het niet moe - het kan eindeloos varianten spuwen totdat er eentje langs de filters glipt en iemand voor de gek houdt.

Puntje bij paaltje: Medio 2025 zal een Reuters Onderzoek toonde aan hoe Zuidoost-Aziatische oplichters ChatGPT gebruikten om fraudecommunicatie te automatiseren.[15]. Ze genereerden massaal overtuigende e-mails van banken en klantenserviceteksten, waardoor het bereik van hun complotten enorm toenam. De Europese politie maakte ook melding van AI-gestuurde phishingkits die op het dark web werden verkocht voor minder dan $20, waarmee laagopgeleide actoren geavanceerde campagnes konden opzetten.[16][17]. De drempel voor BEC en phishing is in wezen weggevallen.

Verdedigingsmaatregelen - AI Phish stoppen: Gezien de aanval moeten organisaties hun e-mail- en berichtenkanalen versterken. Dit is waar AI-inhouddetectie kan helpen. Hulpmiddelen zoals AI-tekstdetector van TruthScan en gespecialiseerde e-mailscanners kan binnenkomende berichten analyseren op statistische markers van door AI gegenereerde tekst. De TruthScan e-mail scam detector maakt gebruik van natuurlijke taalanalyse om e-mails te markeren die waarschijnlijk afkomstig zijn van een AI, zelfs als ze er legitiem uitzien[18]. Deze detectoren onderzoeken zaken als perfect gepolijste grammatica, zinscomplexiteit en stylometrische patronen die ongebruikelijk zijn voor menselijke schrijvers. Met real-time scannenkunnen verdachte e-mails in quarantaine worden geplaatst of worden gemarkeerd voor controle voordat ze gebruikers bereiken. Beveiligingsteams van bedrijven beginnen dergelijke AI-filters in te zetten bij e-mailgateways en berichtenplatforms. In de praktijk voegt dit een nieuwe verdedigingslaag toe aan de traditionele spamfilters - een laag die expliciet is afgestemd op AI-gebaseerde inhoud. Vanaf 2025 integreren toonaangevende bedrijven oplossingen zoals TruthScan via API in hun beveiligde e-mailgateways en samenwerkingspakketten in de cloud, waardoor een geautomatiseerd controlepunt ontstaat voor AI-gegenereerde phishing inhoud.

Deepfake stem- en video-impersonatie: De "zien is bedriegen" fraude

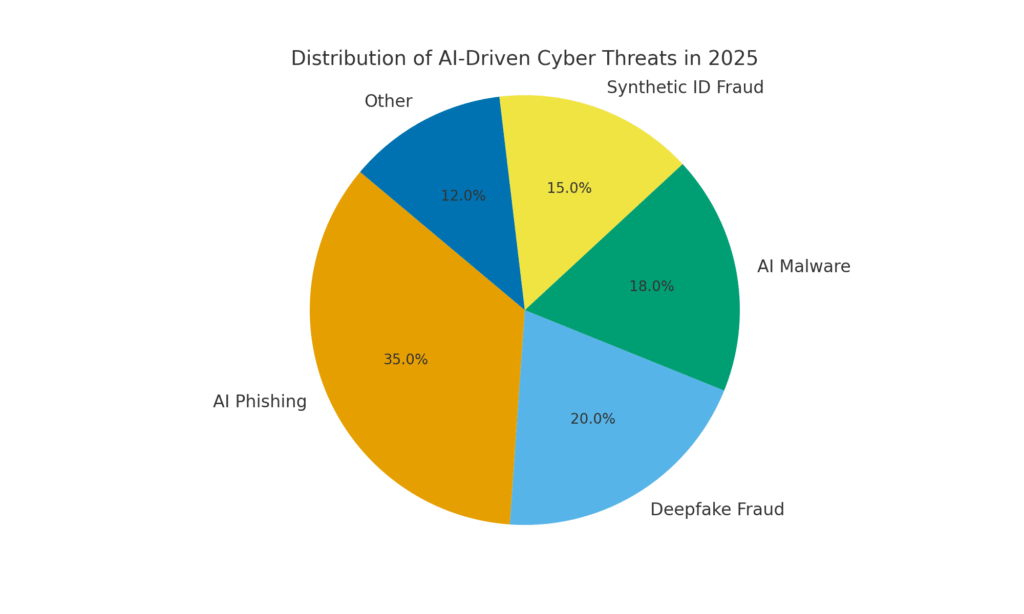

De grootste AI-bedreiging in 2025 is misschien wel de opkomst van deepfake spraak- en videoaanvallen. Met behulp van AI-modellen kunnen criminelen de stem van een persoon klonen op basis van slechts een paar seconden audio, of een realistische video van iemands gezicht genereren op basis van een handvol foto's. Deze deepfakes worden ingezet voor oplichtingspraktijken met een hoge inzet - van CEO-fraude ("nep-CEO" telefoontjes) tot nep-videoconferenties en nog veel meer. Een recent industrierapport onthulde 47% van de organisaties heeft te maken gehad met deepfake-aanvallen van een soort[19]. En het is niet alleen theoretisch: meerdere heists in 2023-2025 hebben bewezen dat deepfakes de ultieme authenticatie kunnen verslaan - onze eigen ogen en oren.

Een berucht geval betrof een internationale bankoverschrijving van $25 miljoen nadat een werknemer was misleid door een deepfake videoconferentie. De aanvallers gebruikten AI om de gelijkenis van de CFO van het bedrijf te synthetiseren tijdens een Zoom-gesprek, compleet met haar stem en maniertjes.[4][20]. In een ander incident in Australië heeft een lokale overheid verloren $2,3 miljoen toen oplichters zowel de stem als de video van stadsambtenaren vervalsten om frauduleuze betalingen goed te keuren[21]. En het is verontrustend dat criminelen AI-gekloonde stemmen gebruiken in "grootouderzwendel" - waarbij ze senioren bellen en zich voordoen als hun familieleden in nood. De FBI en FinCEN waarschuwde eind 2024 voor een toename van fraude met AI-gegenereerde "deepfake" mediazoals nepklantenservicemedewerkers en synthetische identiteiten om KYC-verificaties te omzeilen[22].

De frequentie van op deepfake gebaseerde misdaden stijgt snel. Eén analyse toonde aan dat tegen het einde van 2024 er elke vijf minuten een nieuwe deepfake zwendel plaatsvond gemiddeld[23]. Alleen al in het eerste kwartaal van 2025 steeg het aantal gerapporteerde deepfake-incidenten met 19% vergeleken met alle van 2024[24][25]. Deepfakes zijn nu goed voor naar schatting 6,5% van alle fraudeaanvallen, a 2.137% toename sinds 2022[26][27]. De benodigde technologie is gemakkelijk toegankelijk geworden - vaak is er niet meer voor nodig dan 30 seconden audio om een stem te klonen, of minder dan een uur beeldmateriaal om iemands gezicht overtuigend te modelleren[20]. Kortom, het is nog nooit zo eenvoudig geweest om "De identiteit van een vertrouwd persoon "vervalsen en slachtoffers verleiden tot het overhandigen van geld of informatie.

Defensieve maatregelen - De werkelijkheid authenticeren: Om deepfake bedreigingen tegen te gaan, wenden organisaties zich tot geavanceerde detectie van synthetische media gereedschappen. Bijvoorbeeld, AI-spraakdetector van TruthScan en TruthScan Deepfake Detector gebruiken AI om audio en video te analyseren op tekenen van manipulatie. Deze systemen voeren frame-voor-frame en golfvormanalyses uit om artefacten zoals onnatuurlijke gezichtsbewegingen, lipsync-problemen of onregelmatigheden in het audiospectrum op te sporen die een door AI gegenereerde clip verraden. In tests bereikten de algoritmen van TruthScan het volgende 99%+ nauwkeurigheid bij het identificeren van AI-gegenereerde stemmen en detecteerde gemanipuleerde videoframes in realtime[28][29]. Onderzoekers van het Genians Security Center hebben onlangs TruthScan's beeldforensisch onderzoek gebruikt om een valse ID-kaart te analyseren die werd gebruikt door Noord-Koreaanse hackers. TruthScan's deepfake beelddetector markeerde het document als niet-authentiek met de volgende kenmerken 98% vertrouwenDe spear-phishing-poging verijdelen[5][30].

Voor een praktische verdediging zetten bedrijven deze detectiemogelijkheden in op belangrijke knelpunten. Stemverificatie wordt toegevoegd aan callcenterworkflows - bijvoorbeeld wanneer een "klant" telefonisch een grote overboeking aanvraagt, kan de audio door een stemdetector worden gehaald om er zeker van te zijn dat hij het echt is (en niet een AI-imitatie). Evenzo, videoconferentie platforms kan live deepfake scannen van videostreams van deelnemers integreren om alle synthetische gezichten op te vangen. De deepfake detectie suite van TruthScan biedt bijvoorbeeld real-time analyse van videogesprekken en gezichtsverificatie die kan worden aangesloten op Zoom of WebEx via API[31][29]. Dit betekent dat als iemand probeert deel te nemen aan een vergadering met behulp van een AI-gecreëerde video van uw CEO, het systeem "mogelijke deepfake" kan markeren voordat er schade is aangericht. Daarnaast bevatten belangrijke transacties nu vaak een verificatiestap (out-of-band of multi-factor) die gebruik kan maken van inhoudsverificatie - bijvoorbeeld een korte gesproken bevestiging die vervolgens door een AI-stemdetector wordt gecontroleerd op echtheid. Door deze tools in lagen onder te verdelen, creëren bedrijven een vangnet: zelfs als werknemers zie of horen iets aannemelijks, zal een AI forensisch onderzoek achter de schermen de realiteit ervan in twijfel trekken. In een door AI doordrongen bedreigingslandschap, "Vertrouw niet - controleer". wordt de mantra voor elke spraak- of videocommunicatie waarbij geld of gevoelige toegang betrokken is.

AI-geconstrueerde malware en versleutelde code: Evoluerende bedreigingen in de code

De invloed van AI is niet beperkt tot social engineering - het verandert ook de ontwikkeling van malware en ontwijkende aanvalscode. In 2025 ontdekte de Threat Intelligence Group van Google de eerste malwarestammen met AI tijdens uitvoering om hun gedrag te veranderen[32][33]. Eén voorbeeld, genaamd PROMPTFLUXwas een kwaadaardig script dat een AI API aanriep (Google's Gemini model) om zijn eigen code on the fly herschrijvenNieuwe versleutelde varianten maken om antivirusdetectie te omzeilen[34][35]. Deze "just-in-time" AI-evolutie betekent een sprong in de richting van autonome, polymorfe malware. Nog een voorbeeld, PROMPTSTEALgebruikte een AI-coderingsassistent om eenregelige Windows-commando's te genereren voor gegevensdiefstal, waarbij in wezen delen van de logica in realtime werden uitbesteed aan een AI-engine[36][37]. Deze innovaties wijzen op een toekomst waarin malware zichzelf voortdurend kan veranderen - net zoals een menselijke pentester dat zou doen - om verdedigingen te verslaan.

Zelfs zonder on-the-fly AI gebruiken aanvallers AI tijdens de ontwikkeling om krachtigere kwaadaardige code te maken. Generatieve AI kan malware produceren die zeer versluierdHet bevat lagen verwarrende logica die reverse engineering bemoeilijken. Volgens informatie over bedreigingen, bij meer dan 70% van de grote inbreuken in 2025 was een vorm van polymorfe malware betrokken die zijn handtekening of gedrag wijzigt om detectie te vermijden[38]. Bovendien, 76% van phishing-campagnes gebruiken nu polymorfe tactieken zoals dynamische URL's of door AI herschreven payloads[38]. Hulpmiddelen zoals het dark-web aanbod WormGPT en FraudeGPT (onbeperkte klonen van ChatGPT) kunnen zelfs niet-deskundigen malware droppers, keyloggers of ransomware code genereren door simpelweg te beschrijven wat ze willen.[39]. Het resultaat is een overvloed aan nieuwe malwarevarianten. In 2024 bijvoorbeeld werd een infosteler genaamd BlackMamba naar voren kwam dat was volledig door AI gegenereerdgebruikt ChatGPT om zijn code in segmenten te schrijven - elke uitvoering produceerde een iets andere binary, waardoor traditionele antivirusprogramma's met handtekeningen in de war raakten.[38]. Beveiligingsonderzoekers demonstreerden ook AI-gegenereerde polymorfe proof-of-concepts die veel endpoint-beveiligingen kunnen omzeilen.[40].

Daar komt nog bij dat aanvallers AI inzetten om hun aanvallen te verfijnen. levering van malware. AI kan op intelligente wijze phishingmails scripten (zoals besproken) met malwarelinks. Het kan ook helpen bij de ontwikkeling van exploits, bijvoorbeeld door AI te gebruiken om nieuwe kwetsbaarheden te vinden of shellcode te optimaliseren. Staatsactoren hebben naar verluidt geavanceerde AI-modellen gebruikt om te helpen bij het ontdekken van 'zero-day'-exploits en het ontwikkelen van malware op maat voor doelwitten.[41]. Al deze trends betekenen dat malware in 2025 heimelijker en adaptiever is. Het is vaak "co-creatie" met AIwaardoor het moeilijker te detecteren is met conventionele regels.

Defensieve maatregelen - AI versus AI in de verdediging tegen malware: Verdediging tegen AI-malware vereist een combinatie van geavanceerde detectie en AI-gebaseerde analyse aan de verdedigingskant. Veel organisaties breiden hun endpointbescherming en EDR (Endpoint Detection & Response) met AI/ML-modellen die zoeken naar gedragspatronen van AI-gegenereerde code. Bijvoorbeeld, plotselinge on-host code transformaties of ongebruikelijke API aanroep patronen kunnen duiden op iets als PROMPTFLUX die zichzelf regenereert. Op dezelfde manier kan netwerkmonitoring anomalieën detecteren, zoals malware die uitreikt naar AI-services (wat niet "normaal" is voor gebruikersapplicaties). Leveranciers trainen ML-gebaseerde detectors op de gezinnen van AI-ondersteunde malware die tot nu toe is geïdentificeerd, waardoor deze nieuwe bedreigingen beter worden herkend.

Een opkomende oplossing is AI-inhoud scannen geïntegreerd in ontwikkel- en bouwpijplijnen. Dit betekent het gebruik van AI-gestuurde detectors om scripts, software builds of zelfs configuratiewijzigingen te analyseren op kwaadaardige of door AI gegenereerde inhoud. Bijvoorbeeld, Realtime detector van TruthScan kan verder worden ingezet dan alleen tekst - de multimodale analyse kan verdachte code of configuratiebestanden mogelijk markeren door te herkennen of ze machinaal zijn gegenereerd met obfuscatiepatronen[42][43]. Ontwikkelingsteams en MSSP's beginnen infrastructure-as-code scripts, PowerShell logs en andere artefacten te scannen op tekenen van door AI geschreven segmenten die zouden kunnen duiden op de hand van een aanvaller. Hoewel dit een opkomend gebied is, is het veelbelovend: in één geval gebruikte een beveiligingsteam een AI-detector om een gecodeerd phishingkit-bestand op te sporen dat "aanvoelde" alsof het door AI was gegenereerd en dat inderdaad deel uitmaakte van een aanval.[44]. De code van het bestand was overdreven complex en langdradig (kenmerken van AI-generatie) en een AI-inhoudsscan bevestigde dat het hoogstwaarschijnlijk niet door mensen was geschreven.[40].

Tot slot is het delen van informatie over AI-bedreigingen van cruciaal belang. Wanneer Google GTIG details publiceert over op Prompt gebaseerde malware of wanneer onderzoekers nieuwe AI-ontwijkingstechnieken melden, moeten organisaties deze in hun detectietechnieken invoeren. Gedragsanalyse - Door te zoeken naar acties zoals een proces dat een script voortbrengt dat de code van datzelfde proces herschrijft, kunnen afwijkingen worden ontdekt die AI-ondersteunde malware vertoont. Kortom, verdedigers moeten vuur met vuur bestrijden: zet AI-gestuurde beveiligingstools die zich net zo snel kan aanpassen als de AI-gestuurde malware. Dit omvat alles van AI-verrijkte antivirus tot analyses van gebruikersgedrag die kunnen vaststellen wanneer een account of systeem zich "niet helemaal menselijk" begint te gedragen. Door AI te omarmen voor verdediging, kunnen beveiligingsteams de snelheids- en schaalvoordelen tegengaan die AI aanvallers biedt.

Synthetische identiteiten en AI-fraudeconstructies

Van malware naar de wereld van fraude: synthetische identiteitsfraude is geëxplodeerd met behulp van generatieve AI. Bij synthetische identiteitsfraude worden fictieve personages gecreëerd door echte en valse gegevens te combineren (bijv. echte SSN + valse naam en documenten). Deze "Frankenstein"-identiteiten worden vervolgens gebruikt om bankrekeningen te openen, krediet aan te vragen of door KYC-controles te komen - wat uiteindelijk resulteert in onbetaalde leningen of het witwassen van geld. Het was al een van de snelst groeiende vormen van fraude en AI heeft nu olie op het vuur gegooid. Verliezen door synthetische ID-fraude overschreed $35 miljard in 2023[45]en begin 2025 wezen sommige schattingen op bijna 25% van alle bankfraudeverliezen waren te wijten aan synthetische identiteiten[46]. De analisten van Experian ontdekten dat meer dan 80% aan fraude met nieuwe rekeningen in bepaalde markten is nu gekoppeld aan synthetische ID's[19] - een onthutsend cijfer dat onderstreept hoe wijdverbreid deze zwendel is geworden.

Generatieve AI versterkt synthetische fraude op een paar manieren. Ten eerste maakt AI het triviaal om de "fokdocumenten" en digitale voetafdrukken die nodig zijn om een valse identiteit te verkopen. In het verleden photoshopte een fraudeur een identiteitsbewijs of maakte hij handmatig valse energierekeningen. Nu bestaan er tools om authentiek ogende profielfoto's, ID's, paspoorten, bankafschriften, zelfs profielen van sociale media met behulp van AI-beeldgeneratoren en taalmodellen[47][48]. Je kunt bijvoorbeeld een AI gebruiken om een realistische hoofdfoto te maken van een persoon die niet bestaat (waardoor je niet makkelijk kunt zoeken naar omgekeerde afbeeldingen), en met die foto een bijpassend vals rijbewijs genereren. AI kan ook "levenstekens" van een identiteit simuleren, bijvoorbeeld door het creëren van gegevens van synthetische ouders, adressen of berichten op sociale media een achtergrondverhaal uitwerken[49]. De Boston Fed merkte op dat Gen AI zelfs het volgende kan produceren deepfake audio en video van een neppersoon - Een synthetische gebruiker kan bijvoorbeeld "verschijnen" in een selfie verificatievideo, compleet met uniek gezicht en stem, allemaal door AI gegenereerd.[50].

Ten tweede helpt AI fraudeurs opschalen hun activiteiten. In plaats van één of twee identiteiten per keer te vervalsen, kunnen ze programmatisch honderden of duizenden complete identiteitspakketten genereren en massaal nieuwe accountaanvragen automatisch invullen.[51][52]. Sommige dark web services bieden effectief "Synthetische identiteiten als dienstZe gebruiken automatisering om geverifieerde accounts te verkopen. Tijdens de COVID-19 pandemische hulpprogramma's, bijvoorbeeld, gebruikten criminelen bots met AI-gegenereerde identiteiten om massaal leningen en uitkeringen aan te vragen, waardoor het systeem overspoeld werd met valse aanvragers. Juniper Research voorspelt dat de wereldwijde kosten van digitale identiteitsfraude (aangewakkerd door deze tactieken) als volgt zullen zijn stijging 153% tegen 2030 vergeleken met 2025[53].

Defensieve maatregelen - Identiteit verifiëren in een AI-wereld: Traditionele methodes om identiteit te bewijzen hebben het moeilijk tegen door AI gecreëerde vervalsingen. Om zich aan te passen gebruiken organisaties meerlaagse verificatie van identiteit en gedrag versterkt door AI. Een belangrijke laag is geavanceerde forensisch onderzoek van documenten en afbeeldingen. Bijvoorbeeld, AI-beelddetector van TruthScan en Valse Documenten Detector bieden de mogelijkheid om geüploade ID's, selfies of documenten te analyseren op tekenen van synthese of manipulatie. Deze tools onderzoeken artefacten op pixelniveau, inconsistenties in de belichting en metadata om te bepalen of een afbeelding door AI is gegenereerd of gemanipuleerd. Ze kunnen subtiele aanwijzingen opvangen, zoals identieke achtergrondpatronen van GAN-gegenereerde foto's of lettertypen en spatiëring op een ID die niet overeenkomen met een bekend overheidssjabloon. Door dergelijke detectoren in te zetten bij onboarding, kunnen banken het rijbewijs of de selfie van een sollicitant automatisch markeren als deze waarschijnlijk door AI is gegenereerd (het systeem van TruthScan zou bijvoorbeeld het valse militaire identiteitsbewijs dat werd gebruikt in de Kimsuky APT phishingzaak hebben gemarkeerd).[5]). Volgens een persbericht van TruthScan is hun platform gebruikt door financiële instellingen om de authenticiteit van documenten op grote schaal te valideren, waarbij deepfakes met extreem hoge nauwkeurigheid worden geïdentificeerd.[54].

Een andere laag is gedragsanalyse en kruisverwijzingen. Echte identiteiten hebben diepgang - jarenlange geschiedenis, openbare documenten, sociale media-activiteit, enz. AI-gegenereerde identiteiten, hoe gepolijst ook, missen vaak deze diepe wortels. Banken en kredietverstrekkers gebruiken nu AI om aanvraaggegevens te vergelijken met openbare en bedrijfseigen gegevens: Vertonen het telefoonnummer en de e-mail van deze persoon een gebruiksgeschiedenis? Is de geolocatie van het apparaat of IP logisch? Tikken ze gegevens op een menselijke manier in formulieren of kopiëren ze deze (zoals bots doen)? AI-modellen kunnen worden getraind om echt klantgedrag te onderscheiden van synthetische patronen. De Federal Reserve merkte op dat "synthetische identiteiten zijn oppervlakkig en AI kan dat zien". - AI-gebaseerde verificatie kan snel zoeken naar de digitale voetafdruk van een identiteit en alarm slaan als er weinig of geen wordt gevonden[55]. In de praktijk maken identiteitsverificatiediensten nu gebruik van AI die controleert of de selfie van een gebruiker overeenkomt met eerdere foto's (om gezichtsverwisselingen te detecteren) en gebruikers zelfs vraagt om gerandomiseerde acties uit te voeren (zoals specifieke poses of zinnen) tijdens controles op echtheid, waardoor het moeilijker wordt voor deepfakes om correct te reageren.[56][57].

Eindelijk, voortdurende controle van accountgedrag post-onboarding helpt bij het opsporen van synthetische accounts die zijn doorgeschoten. Omdat deze accounts niet zijn gekoppeld aan een echte persoon, vallen hun gebruikspatronen uiteindelijk vaak op (bijv. het maken van perfect getimede transacties om krediet op te bouwen en vervolgens de limiet opheffen). AI-gestuurde fraudebewaking (zoals de platforms van Sift of Feedzai) kan afwijkingen identificeren in het gebruik van accounts en zo potentiële synthetische accounts markeren voor herziening. Samengevat vereist het bestrijden van AI-gebaseerde identiteitsfraude het volgende AI-gebaseerde identiteitscontrole - waarbij forensisch onderzoek van documenten, biometrische controles, datacorrelatie en gedragsanalyse worden gecombineerd. Het goede nieuws is dat dezelfde AI-ontwikkelingen die fraude mogelijk maken, ook worden gebruikt om fraude op te sporen. TruthScan biedt bijvoorbeeld een suite voor identiteitscontrole dat tekst-, beeld- en stemanalyse integreert om nieuwe gebruikers te screenen. Door gebruik te maken van deze tools zag een grote bank het aantal succesvolle synthetische accountopeningen aanzienlijk dalen, zelfs terwijl de sectorgemiddelden stegen. De wapenwedloop gaat door, maar verdedigers leren de vage "digitale sporen" van een synthetische te herkennen, hoe goed AI ook probeert zijn sporen uit te wissen.

AI-detectie integreren in de hele beveiligingsketen

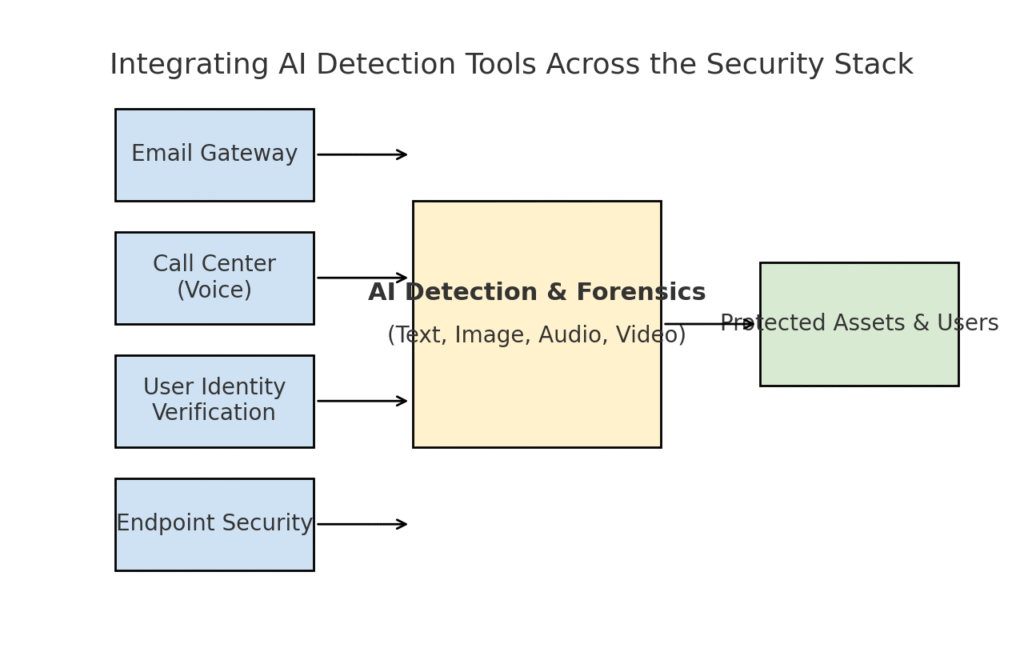

We hebben verschillende bedreigingsgebieden onderzocht - phishing, deepfakes, malware, synthetische fraude - allemaal versterkt door AI. Het is duidelijk dat geen hulpmiddel of eenmalige oplossing de uitdaging zal oplossen. In plaats daarvan hebben bedrijven een allesomvattende strategie nodig om AI-gestuurde detectie en verificatie in elke laag inbouwen van hun cyberbeveiligingspakket. De aanpak moet het aanvalsoppervlak weerspiegelen en e-mail, internet, spraak, documenten, identiteit en meer omvatten. Het diagram hieronder laat zien hoe organisaties de AI-detectietools van TruthScan (en vergelijkbare oplossingen) kunnen integreren in gemeenschappelijke beveiligingslagen van de onderneming:

AI-detectietools integreren in meerdere lagen van de beveiligingsstapel - van e-mailgateways en callcenters tot gebruikersverificatie en endpointbescherming. AI-contentdetectie (centrum) analyseert tekst, afbeeldingen, audio en video in realtime en levert handhavingspunten op die bedrijfsmiddelen en gebruikers beschermen.

In dit model, multimodale AI-detectoren fungeren als centrale hersenen die interfaces heeft met verschillende beveiligingscontroles:

- E-mail gateways: Inkomende e-mails passeren een AI-tekst/scamdetector voordat ze de inbox bereiken. Dit sluit aan bij de verdediging tegen phishing die we hebben besproken - bijv. met behulp van TruthScan's e-mailoplichtingsdetector via API bij je e-mailprovider om verdachte AI-gegenereerde e-mails automatisch in quarantaine te plaatsen[18]. Het kan ook worden toegepast op berichtenplatforms (chatapps, sms-gateways) om inhoud te scannen op phishing- of oplichtingspatronen.

- Callcenters en spraaksystemen: Telefoon- en VOIP-kanalen worden beveiligd door het integreren van voice deepfake detectie. De klantenservicelijn van een bank kan bijvoorbeeld het volgende gebruiken AI-spraakdetector van TruthScan de audio van inkomende bellers in realtime analyseren en waarschuwen als de stemafdruk van een beller synthetisch is of niet overeenkomt met hun bekende profiel[58][59]. Dit helpt voorkomen dat vishing- en stemvervalsingsaanvallen (zoals valse CEO-oproepen) slagen.

- Processen voor identiteitsverificatie van gebruikers: Bij het aanmaken van een account of bij gebruikersacties met een hoog risico (wachtwoord resetten, geld overmaken) wordt AI-gestuurde identiteitsverificatie ingezet. Een geüploade foto-ID wordt gescreend door een beeldforensisch hulpmiddel (dat bijvoorbeeld controleert of het een AI-gegenereerde foto is of een foto van een foto) en een selfie of videogesprek wordt gescreend door een deepfake-detector. TruthScan's Deepfake detector kan hier worden gebruikt om gezichtsverificatie uit te voeren - om er zeker van te zijn dat de persoon op de camera echt is en overeenkomt met de ID[60][61]. Gedragssignalen (typecadans, apparaatconsistentie) kunnen ook worden ingevoerd in AI-modellen om bots of synthetische identiteiten te detecteren.

- Eindpunten en netwerk: Beveiligingsagenten voor endpoints en proxyservers kunnen AI-inhoudsanalyse voor bestanden en scripts integreren. Als een endpoint EDR bijvoorbeeld een nieuw script of EXE ziet uitvoeren, kan het de tekstinhoud van het bestand naar een AI-detector sturen om te controleren of het lijkt op bekende AI-gegenereerde malware of kenmerken vertoont van versluierde AI-code. Op dezelfde manier kunnen DLP-systemen (Data Loss Prevention) AI-tekstdetectie gebruiken om gevoelige tekst te markeren die door AI is gegenereerd (wat zou kunnen duiden op een insider die AI gebruikt om exfiltratieberichten op te stellen of rapporten te vervalsen). TruthScan's Real-Time Detector is ontworpen om aan te sluiten op dergelijke workflows en biedt live analyse van inhoud op verschillende platforms met geautomatiseerde antwoordopties[42][62] (bijvoorbeeld een bestand of bericht automatisch blokkeren als het wordt geïdentificeerd als door AI gegenereerde malware of desinformatie).

De belangrijk voordeel van deze geïntegreerde aanpak is snelheid en consistentie. AI-aanvallen gaan snel - phishing-e-mails, nepstemmen en synthetische gegevens kunnen veel kanalen tegelijk treffen. Door al deze kanalen te voorzien van AI-detectie krijgt een organisatie real-time zichtbaarheid en defense-in-depth. Eén team beschreef het als het creëren van een "AI-immuunsysteem" voor hun onderneming: telkens wanneer er iets wordt gecommuniceerd (of het nu een e-mail, een documentupload of een telefoongesprek is), "snuffelt" het AI-immuunsysteem naar vreemde (door AI gegenereerde) handtekeningen en neutraliseert het als het kwaadaardig wordt bevonden.

De zakelijke suite van TruthScan is hier een goed voorbeeld van. uniform platform voor AI-detectie van tekst, afbeeldingen, audio en video die modulair of als geheel kan worden ingezet[63][64]. Veel bedrijven beginnen met het inzetten van één of twee mogelijkheden (bijvoorbeeld tekstdetectie in e-mail en afbeeldingsdetectie in onboarding) en breiden dan uit naar andere mogelijkheden zodra ze de waarde ervan inzien. Belangrijk is dat integratie ontwikkelaarsvriendelijk is gemaakt - TruthScan en vergelijkbare services bieden API's en SDK's zodat beveiligingsteams detectie kunnen koppelen aan bestaande systemen zonder grootschalige re-engineering. Of het nu gaat om een SIEM, een e-mailgateway, een aangepaste bankieren-app of een CRM-systeem, de detectie kan achter de schermen worden uitgevoerd en waarschuwingen of geautomatiseerde acties voeden. Een groot platform voor sociale media heeft bijvoorbeeld API's voor inhoudsbeoordeling geïntegreerd om deepfake video's automatisch te verwijderen binnen enkele minuten na het uploaden.[65][66]De verspreiding van door AI gegenereerde desinformatie voorkomen.

Conclusie: Voorblijven op de curve

De snelle verspreiding van AI-gestuurde bedreigingen in 2025 heeft organisaties op nieuwe manieren uitgedaagd. Aanvallers hebben middelen gevonden om het vertrouwen van mensen op grote schaal uit te buiten - door zich voor te doen als stemmen en identiteiten, door social engineering te automatiseren, door verdedigingsmiddelen te omzeilen met adaptieve code en door volledige valse realiteiten te creëren. Het is een ontmoedigend vooruitzicht voor verdedigers, maar niet hopeloos. Net zoals criminelen AI inzetten, kunnen we AI ook aan de kant van de beveiliging scharen. De opkomst van AI-inhoudsdetectie, deepfake forensisch onderzoek en synthetische identiteitsscanners geeft ons krachtige middelen om deze nieuwe bedreigingen het hoofd te bieden. Door deze tools in te zetten en ze integreren in alle lagen Met deze verdedigingslinie kunnen bedrijven het risico dat AI-aanvallen door de mazen van het net glippen drastisch verkleinen. Early adopters hebben al pogingen tot miljoenenfraude verijdeld door deepfakes op heterdaad te betrappen.[26]of phishingrampen voorkomen door AI-geconstrueerde e-mails te filteren.

Naast technologie moeten organisaties een cultuur van "vertrouwen maar verifiëren" cultiveren. Werknemers moeten zich ervan bewust zijn dat in het tijdperk van AI zien (of horen) niet altijd geloven is - een gezonde scepsis in combinatie met verificatie-workflows kan veel social engineering-trucs tegenhouden. Training en bewustzijn, gecombineerd met geautomatiseerde verificatietools zoals TruthScanvormen een formidabele verdediging. In zekere zin moeten we de lat voor authenticatie en validatie van informatie hoger leggen. Digitale communicatie en documenten kunnen niet langer op hun waarde worden geschat; hun herkomst moet worden gecontroleerd, hetzij machinaal, hetzij door het proces.

Verwacht dat aanvallers hun AI-tactieken verder zullen verfijnen, maar verwacht ook voortdurende innovatie in verdedigende AI. De kat-en-muis dynamiek zal blijven bestaan. Het succes van verdedigers zal afhangen van wendbaarheid en het delen van inlichtingen. Degenen die snel nieuwe informatie over bedreigingen (zoals nieuwe deepfake detectietechnieken of bijgewerkte AI-modelhandtekeningen) integreren, zullen aanvallers die gebruikmaken van de nieuwste AI-tools voorblijven. Samenwerking tussen het bedrijfsleven, de academische wereld en de overheid zal ook van vitaal belang zijn in deze strijd, zoals blijkt uit de waarschuwingen en raamwerken die verschijnen van instanties zoals het AI Risk Management Framework van NIST en de samenwerking tussen banken op het gebied van AI-detectie van fraude.

Tot slot zit de cyberbeveiligingsindustrie midden in een AI-gedreven paradigmaverschuiving. De bedreigingen zijn anders dan tien jaar geleden, maar we gaan ze te lijf met een even ongekende verdediging. Met een combinatie van geavanceerde detectietechnologie en een robuuste beveiligingsstrategie kunnen we kan de risico's van generatieve AI beperken en zelfs in ons voordeel gebruiken. Tools zoals de AI-detectiesuite van TruthScan stellen ons in staat om vertrouwen herstellen in een zero-trust wereld - om er zeker van te zijn dat de persoon aan de andere kant van de lijn echt is, dat het document in onze inbox authentiek is en dat de code in ons netwerk niet is gemanipuleerd door een kwaadwillende AI. Door nu in deze mogelijkheden te investeren, beschermen organisaties zichzelf niet alleen tegen de AI-aanvallen van vandaag, maar bouwen ze ook veerkracht op tegen de evoluerende bedreigingen van morgen. De conclusie is duidelijk: AI kan cyberaanvallen superchargen, maar met de juiste aanpak kan het ook onze verdediging superchargen.

Bronnen: Relevante gegevens en voorbeelden zijn afkomstig uit 2025 rapporten over bedreigingen en deskundigen, waaronder Cyber Incident Trends van Mayer Brown.[1][67]Fortinet's 2025 bedreigingenoverzicht[2][19], Barracuda onderzoek naar AI e-mailaanvallen[6][7]Google GTIG's AI-bedreigingsrapport[34]Inzichten van de Boston Federal Reserve over synthetische fraude[45][50]en de gepubliceerde casestudies en persberichten van TruthScan[30][26]onder andere. Deze illustreren de reikwijdte van AI-gestuurde bedreigingen en de effectiviteit van AI-gerichte tegenmaatregelen in echte scenario's. Door te leren van dergelijke intelligentie en geavanceerde tools in te zetten, kunnen we met vertrouwen navigeren in het tijdperk van AI-verhoogde cyberrisico's.

[1] [67] 2025 Cyberincidenttrends wat uw bedrijf moet weten | Insights | Mayer Brown

[2] [3] [19] Topstatistieken over cyberbeveiliging: Feiten, statistieken en inbreuken voor 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] AI-gestuurde fraude in financiële diensten: Recente trends en oplossingen | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan ontdekt Noord-Koreaanse Deepfake-aanval op defensieambtenaren - Bryan County Magazine

[6] [7] [14] De helft van de spam in je inbox wordt gegenereerd door AI - het gebruik ervan in geavanceerde aanvallen is in een eerder stadium | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Q2 2025 Digital Trust Index: AI-fraudegegevens en inzichten | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] AI-bedreigingen voor cyberveiligheid 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Nieuwste informatie over bedreigingen | TruthScan

[18] [63] [64] TruthScan - AI-detectie en inhoudbeveiliging voor ondernemingen

[23] [46] [56] [57] Deepfakes en stortingen: Hoe generatieve AI-fraude te bestrijden

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake-aanvallen en AI-gegenereerde phishing: statistieken voor 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI-stemdetector voor deepfakes en stemkloon | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identificeer nep- en AI-video's - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI-bedreigingstracker: Vooruitgang in het gebruik van AI-tools door bedreigers | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackers versluieren malware met overdreven AI-code

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] AI-detectie in realtime - TruthScan

https://truthscan.com/real-time-ai-detector

[44] EvilAI Operators gebruiken AI-gegenereerde code en nep-apps voor ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Gen AI verhoogt de dreiging van synthetische identiteitsfraude - Federal Reserve Bank of Boston

[53] Synthetische identiteitsfraude 2025: AI-opsporings- en preventiestrategieën