Inleiding

Kunstmatige intelligentie verandert het landschap van financiële fraude op ongekende manieren. Begin 2024 gebruikten fraudeurs door AI gegenereerde deepfakes om zich tijdens een videogesprek voor te doen als leidinggevenden en zo een werknemer in Hongkong te verleiden tot het overmaken van geld. $25 miljoen aan de oplichters[1][2]. Incidenten zoals deze laten zien hoe generatieve AI criminelen in staat stelt om zeer overtuigende zwendelpraktijken te ontwikkelen die gericht zijn op banken en hun klanten. Regelgevers luiden de noodklok: FinCEN, het Amerikaanse ministerie van Financiën, gaf eind 2024 een waarschuwing uit waarin werd gewaarschuwd voor toenemende fraude met behulp van door AI gegenereerde "deepfake" media, waaronder valse identiteitsdocumenten om bankverificaties te omzeilen.[3][4]. Deze whitepaper onderzoekt de nieuwste AI-fraude trends in financiële diensten en bespreekt hoe instellingen hun verdediging kunnen versterken. We onderzoeken hoe fraudeurs gebruikmaken van generatieve AI - van nepimitaties tot synthetische identiteiten - en schetsen technologie en strategieën (waaronder geavanceerde detectietools zoals TruthScan) die fraudeteams en leidinggevenden kunnen inzetten om deze veranderende dreiging tegen te gaan.

Belangrijkste AI-fraude trends in de financiële dienstverlening

AI en machine learning worden door kwaadwillenden ingezet om op grotere schaal en geraffineerder fraude te plegen. Opmerkelijk AI-gestuurde fraudetactieken die van invloed zijn op banken, fintechs en verzekeraars zijn onder andere:

- Deepfake imitatiezwendel: Criminelen gebruiken AI-gegenereerde video en audio om zich in realtime voor te doen als vertrouwde personen (CEO's, klanten, etc.). Levensechte nepstemmen zijn bijvoorbeeld gebruikt in vishing-aanvallen (voice phishing) om frauduleuze overboekingen goed te keuren, en met AI gemaakte video's hebben werknemers misleid om valse transacties goed te keuren.[1][5]. Deze synthetische media maken het moeilijk om te weten of je echt spreekt met de persoon die je denkt te spreken, waardoor waardevolle heists zoals de $25M deepfake zaak hierboven mogelijk worden. Deepfakes worden betaalbaar en gemakkelijk te producerenEr zijn slechts 20-30 seconden audio nodig om een stem te klonen, of minder dan een uur om een schijnbaar authentieke video te genereren.[6].

- AI-geoptimaliseerde phishing en BEC: Generatieve AI zorgt voor een turbo voor social engineering-schema's zoals phishing-e-mails en zakelijke e-mailcompromittering (BEC). AI-chatbots kunnen zeer persoonlijke oplichtingsmails opstellen in perfecte zakelijke taal, de schrijfstijl van een CEO nabootsen of op grote schaal overtuigende valse facturen van verkopers maken. Ondergrondse tools zoals FraudeGPT en WormGPT (ongefilterde versies van ChatGPT) zijn opgedoken om cybercriminelen te helpen bij het automatisch maken van phishing en malware.[7][8]. Dit betekent dat een potentiële fraudeur met minimale vaardigheden gemakkelijk gepolijste phishing-campagnes of kwaadaardige code kan genereren. Met AI kan een enkele crimineel duizenden op maat gemaakte e-mails of sms-berichten versturen, waardoor het bereik van traditionele fraudepogingen enorm toeneemt. Het Internet Crime Center van de FBI heeft al het volgende geconstateerd meer dan $2,7 miljard verloren door BEC-fraude in 2022, en generatieve AI dreigt deze verliezen de komende jaren nog verder op te drijven.[9][10].

- Synthetische identiteiten en documentfraude: Generatieve AI voedt een hausse in synthetische identiteitsfraudeeen van de snelst groeiende vormen van financiële criminaliteit[11][12]. Fraudeurs combineren echte en valse persoonlijke gegevens om "Frankenstein"-identiteiten te creëren en gebruiken vervolgens AI om realistische bewijsstukken overleggen - van valse paspoorten en bankafschriften tot loonstrookjes[7]. AI afbeeldingsgeneratoren en bewerkingstools kunnen vervalsen Authentiek ogende ID's en foto's die een toevallige inspectie doorstaan. Zelfs echtheidscontroles of selfie-verificaties kunnen mogelijk worden omzeild door met AI gemanipuleerde afbeeldingen of video. Door het automatiseren van de creatie van duizenden valse persona's (elk met door AI gegenereerde profielfoto's, sociale media, etc.) kunnen criminelen massaal bankrekeningen openen of leningen aanvragen en geld witwassen of wanbetalen. Verliezen door synthetische identiteitsfraude worden geschat op ongeveer $35 miljard in 2023[13]en generatieve AI versnelt deze trend alleen maar door valse identiteiten goedkoper en moeilijker op te sporen te maken.

- Geautomatiseerde fraude en ontwijking: Naast het creëren van valse content helpt AI ook fraudeurs het succes van hun programma's maximaliseren. Geavanceerde bots kunnen snel gestolen creditcardgegevens testen op e-commercesites, waarbij ze ML gebruiken om detectietriggers te omzeilen. AI kan criminelen helpen bij het identificeren van de zwakste schakels in de beveiliging van een organisatie of zelfs stemreacties synthetiseren om identiteitsverificatie via de telefoon te omzeilen. Een huisnijverheid op het dark web verkoopt nu AI-tools voor "fraude als een dienst" voor slechts $20[14]. Deze democratisering van AI-mogelijkheden betekent dat zelfs laaggeplaatste criminelen zeer geavanceerde fraudeaanvallen kunnen uitvoeren. De wapenwedloop strekt zich uit tot het ontwijken van detectie - fraudeurs gebruiken AI om fraudebestrijdingssystemen van banken te onderzoeken en hun aanpak te verfijnen totdat ze een methode vinden die door de filters glipt.[15]. Kortom, AI maakt fraude mogelijk op een schaal en efficiëntie die nog niet eerder is vertoondconventionele verdediging op de proef stellen.

Deze op AI gebaseerde tactieken zijn al prolifereren in een alarmerend tempo. Traditionele fraudeconstructies zoals het vervalsen van cheques of phishing bestaan al jaren, maar AI vergroot de omvang en het realisme ervan. De gegevens vertellen een duidelijk verhaal: AI-fraude is schommelend.

Maak je nooit meer zorgen over AI-fraude. TruthScan Kan je helpen:

- AI-opgewekt detecteren afbeeldingen, tekst, spraak en video.

- Vermijd grote AI-gestuurde fraude.

- Bescherm uw meest gevoelig bedrijfsmiddelen.

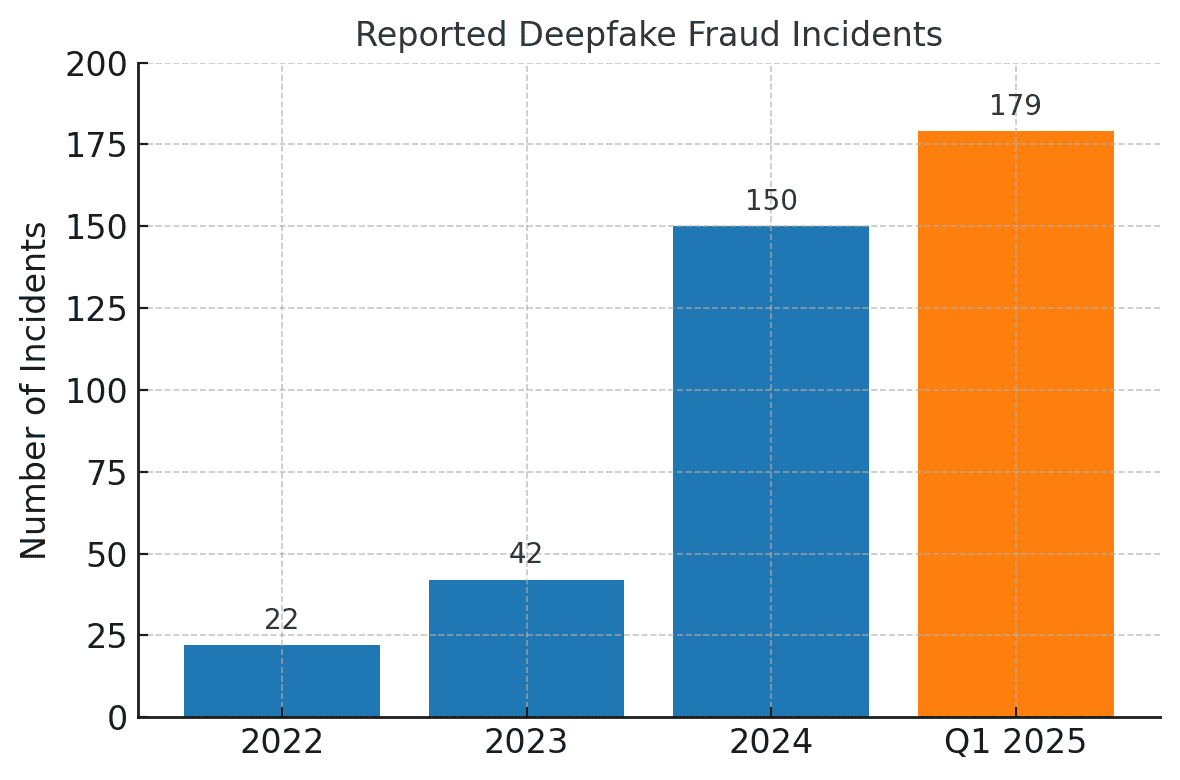

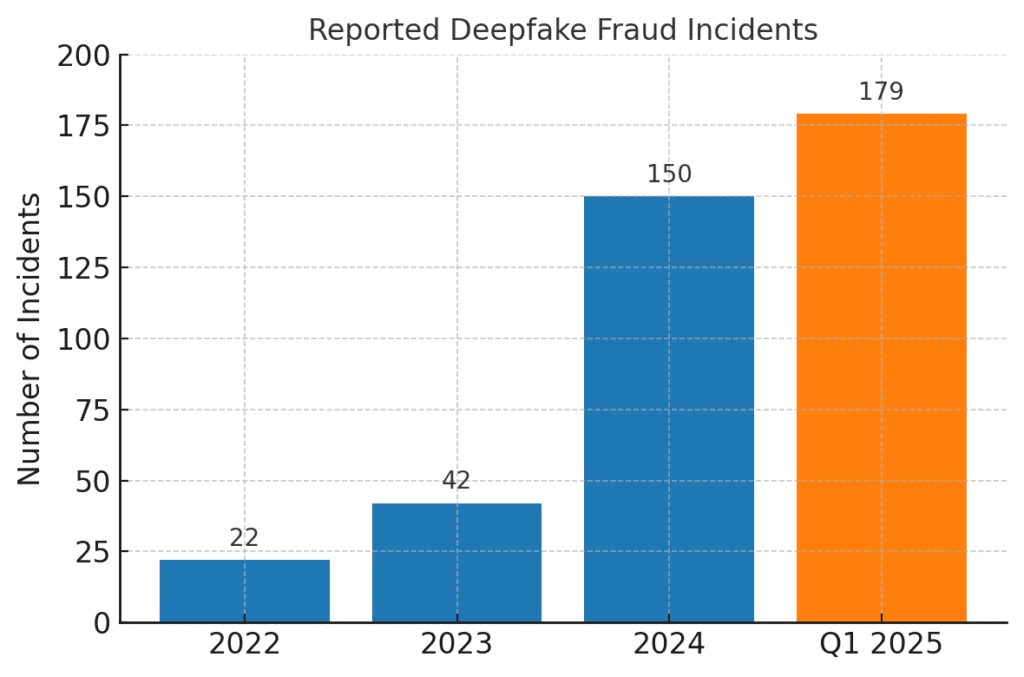

Deepfake-gerelateerde fraude-incidenten zijn explosief gestegen. In 2022 werden er slechts 22 gevallen van deepfake-fraude geregistreerd, maar in 2023 waren dat er 42 en in 2024 waren er al 150 incidenten. In het eerste kwartaal van 2025, 179 gevallen van deepfake-fraude werden gemeld - meer dan het totaal voor heel 2024[16][17].

Recente analyses van de sector weerspiegelen deze trends. In één rapport werd een 700% toename van deepfake-incidenten gericht op fintechbedrijven in 2023[18]. Nog onthutsender is dat Noord-Amerika een 1,740% toename van het aantal gevallen van nepfraude tussen 2022 en 2023[19]. Financiële criminelen maken snel gebruik van deze tools omdat ze werken - veel banken en slachtoffers zijn nog niet voorbereid op het detecteren van AI-gegenereerd bedrog.

Gevolgen en uitdagingen voor financiële instellingen

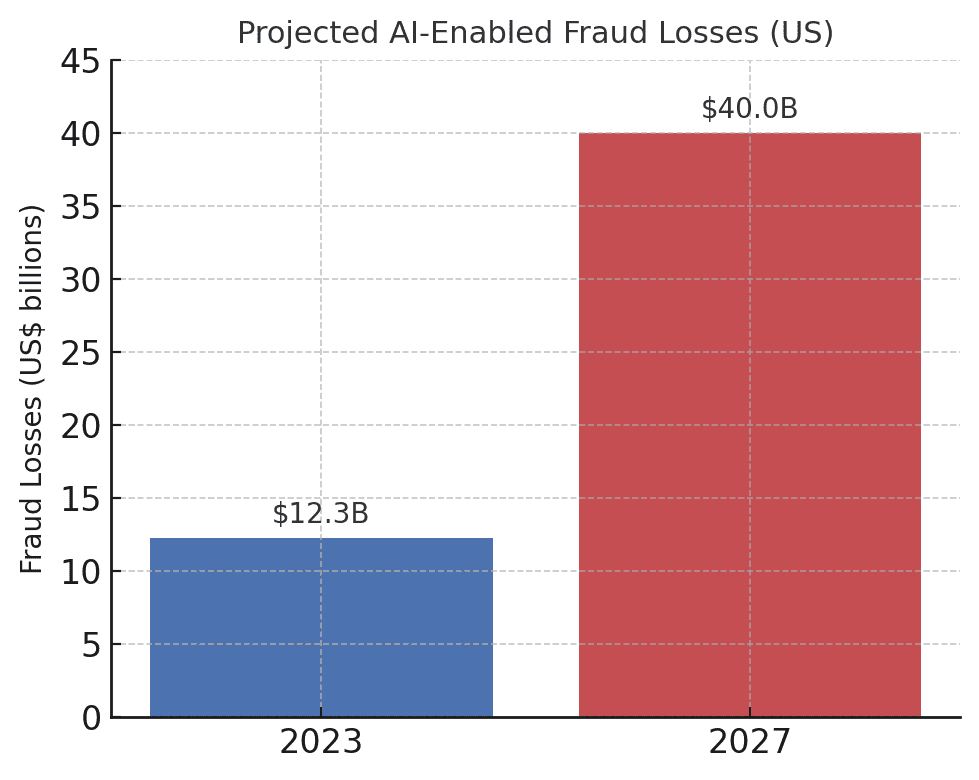

De opkomst van AI-gestuurde fraude zorgt voor aanzienlijke gevolgen op financiële instellingen, hun klanten en het bredere financiële systeem. De meest directe impact is geldelijk verlies. Prognoses uit de sector voorspellen dat tegen 2027, Fraude door generatieve AI kan oplopen tot $40 miljard in de VSvan $12,3 miljard in 2023[20]. Deze meer dan verdrievoudiging (een 32% CAGR) geeft weer hoe snel het frauderisico in dollars groeit.

De verwachte verliezen door AI-fraude nemen dramatisch toe. Deloitte schat dat de verliezen als gevolg van financiële fraude door AI in de VS zullen stijgen van $12,3 miljard in 2023 tot $40 miljard in 2027[20].

Naast ruwe verliezen zijn er ook reputatieschade en trustkosten. Consumenten verwachten dat hun bank hen beschermt, maar zwendel met AI ondermijnt het vertrouwen in digitale kanalen. Als een klant bijvoorbeeld het slachtoffer wordt van een overtuigende deepfake-fraude (zoals een nepvideogesprek met een bankier), kan hij de bank de schuld geven van onvoldoende beveiliging. Publiek vertrouwen in stemverificatie, e-mails en zelfs videoconferenties kan eroderen als "wat je ziet/hoort" niet langer als echt kan worden aangenomen.[21]. Volgens onderzoeken ziet 85% van de financiële professionals in de VS en het VK deepfake scams als een "existentiële" bedreiging voor de veiligheid van hun organisatie.[22]. Meer dan de helft van de bedrijven in deze markten zegt het doelwit te zijn geweest van een op deepfake gebaseerde zwendel, en alarmerend 43% van de doelwitten gaf toe dat de aanval geslaagd was om ze voor de gek te houden[23]. Elk succesvol incident veroorzaakt niet alleen financiële schade, maar tast ook het vertrouwen van de klant in de instelling aan.

Financiële bedrijven worstelen ook met uitdagingen op het gebied van bedrijfsvoering en naleving van AI-fraude. Fraudebestrijdingsteams krijgen te maken met een sterke toename van waarschuwingen en incidenten, waardoor onderzoeksmiddelen onder druk komen te staan. Bestaande fraudedetectiemodellen (waarvan er veel zijn gebaseerd op regels of oudere machine-learningtechnieken) kunnen moeite hebben met het herkennen van door AI gesynthetiseerde inhoud die er legitiem uitziet. Het is zelfs zo dat geavanceerde deepfake detectiesystemen die in laboratoria zijn ontwikkeld, hun nauwkeurigheid met bijna 50% zien dalen wanneer ze worden geconfronteerd met echte deepfakes in het wild[24]. Menselijk personeel doet het niet veel beter - uit onderzoek blijkt dat mensen alleen deepfake video's van hoge kwaliteit kunnen herkennen rond 55%-60% van de tijdnauwelijks beter dan toeval[25]. Dit geeft aan dat banken zonder nieuwe tools een groot deel van de AI-gestuurde fraudepogingen zullen missen.

Er is ook een regulerende dimensie. Regelgevers en wetshandhavers zijn zich terdege bewust van de risico's (zoals blijkt uit de FinCEN-waarschuwing) en verwachten dat financiële instellingen zich aanpassen. Banken kunnen in het tijdperk van AI te maken krijgen met strengere richtlijnen voor klantverificatie en frauderapportage. Als een bankmedewerker bijvoorbeeld door een deepfake wordt misleid om een overboeking van $10 miljoen goed te keuren, kunnen toezichthouders de controles en due diligence-processen van de bank onder de loep nemen. De Wet op het bankgeheim omvat nu expliciet het melden van verdachte cybercriminaliteit en deepfake-gerelateerde activiteiten[26][4]Dit betekent dat banken hun personeel moeten trainen om AI-gegenereerde fraude-indicatoren te herkennen en te rapporteren in Suspicious Activity Reports (SAR's). Het niet bijhouden van AI-ondersteunde fraudetechnieken kan leiden tot compliance-overtredingen of wettelijke aansprakelijkheid als klanten of tegenpartijen aanvoeren dat de bank niet genoeg heeft gedaan om voorspelbare AI-fraude te voorkomen.

De grootste uitdaging is misschien wel de asymmetrische aard van deze nieuwe bedreiging. Generatieve AI verlaagt de kosten en de vaardigheidsdrempel voor aanvallers enorm, terwijl het volume en realisme van aanvallen exponentieel toeneemt. Eén enkel viraal deepfake gerucht of een overtuigend telefoontje van een stemkloon kan miljoenen dollars aan authenticatie-investeringen tenietdoen. Ondertussen moeten verdedigers de authenticiteit van elke transactie en interactie verifiëren, een veel moeilijkere taak. Het is echt een wapenwedloop: AI geeft fraudeurs een zelfontwikkelende toolkit om de beveiliging te omzeilen, waardoor banken hun verdediging ook voortdurend moeten bijwerken.[15][27]. Veel financiële instellingen geven toe dat ze niet voldoende voorbereid zijn... meer dan 80% van de bedrijven heeft geen formeel reactieplan voor deepfake-aanvallenen meer dan de helft heeft geen training gegeven aan werknemers over de risico's van deepfake[28][29]. Dit gebrek aan paraatheid betekent dat organisaties op dit moment kwetsbaar zijn, maar het laat ook zien waar actie nodig is.

Een opmerkelijk en ontnuchterend cijfer komt uit een recent rapport van de industrie: Bij 42,5% van de fraudepogingen in de financiële sector is nu een vorm van AI betrokken.[30]. Met andere woorden, bijna de helft van de fraudeaanvallen die banken tegenkomen heeft een AI-component - of het nu gaat om een AI-gegenereerd document, een gesynthetiseerde stem of een machinaal gegenereerd phishingbericht. Deze statistiek onderstreept dat AI geen hypothetische toekomstige bedreiging is; het is er al en dwingt financiële instellingen zich aan te passen of geconfronteerd te worden met oplopende verliezen.

Verdedigen tegen AI-gebaseerde fraude: Strategieën en oplossingen

De aanpak van AI-fraude vereist een evolutie in fraudepreventiestrategieën. Traditionele benaderingen (zoals handmatige verificatie of statische rules engines) zijn geen partij voor AI-fraude die van vorm verandert. In plaats daarvan moeten banken technology (like making sure they have a Secure SSL Certificate), training, and teamwork om het tij te keren. Hieronder schetsen we de belangrijkste strategieën en opkomende oplossingen:

- AI inzetten om AI te bestrijden (Geavanceerde opsporingstools): Financiële instellingen wenden zich steeds vaker tot AI-gestuurde detectieoplossingen om AI-gegenereerde inhoud en afwijkingen te identificeren. In wezen moet je vuur met vuur bestrijden. Nieuwe zakelijke tools zoals TruthScan multi-modale AI-detectie bieden voor tekst, afbeeldingen, spraak en video om inhoud in realtime te helpen verifiëren[31]. Banken kunnen bijvoorbeeld AI-tekstdetectoren inzetten om inkomende communicatie (e-mails, chatberichten) te scannen op tekenen van door AI gegenereerde taal die kan duiden op een phishing-e-mail of een nep-klantenonderzoek. Het AI-tekstdetectiesysteem van TruthScan kan AI-geschreven inhoud van modellen zoals GPT-4 identificeren met 99%+ nauwkeurigheidzelfs welke zinnen waarschijnlijk door AI zijn gegenereerd[32][33]. Op dezelfde manier kunnen AI-beeldforensische tools documenten en afbeeldingen verifiëren; een AI beelddetector kan aangeven of een ingediend rijbewijs of elektriciteitsrekening digitaal is gemaakt of gemanipuleerd door deze te vergelijken met bekende patronen van door AI gegenereerd beeldmateriaal[34]. Voor audiobedreigingen beginnen banken stem dieptedetectoren - oplossingen die audio van gesprekken analyseren op de akoestische vingerafdrukken van synthetische spraak. De AI Voice Detector van TruthScan, bijvoorbeeld, luistert naar opvallende tekenen van stemkloon en kan de authenticiteit van de spreker verifiëren om bedrieglijke oproepen te voorkomen[35]. Door deze detectoren via API's in hun workflows te integreren, kunnen financiële instellingen automatisch op de achtergrond van transacties en interacties screenen op AI-inhoud. Dit biedt een extra verdedigingslaag die op machinesnelheid werkt en opvangt wat menselijke ogen/oren misschien over het hoofd zien.

- Multi-Factor en Out-of-Band Verificatie implementeren: Nu AI het moeilijker maakt om stemmen of beelden te vertrouwen, moeten banken meer vertrouwen op verificatiemethoden die AI niet gemakkelijk kan faken. Dit omvat multifactorauthenticatie (MFA) via veilige kanalen. Als een verzoek tot overboeking bijvoorbeeld via e-mail of een videogesprek binnenkomt, vraag dan om een tweede factor zoals een eenmalige wachtwoordcode die naar het bekende mobiele apparaat van de aanvrager wordt gestuurd, of een terugbelverzoek op een vertrouwd telefoonnummer in het bestand. Sommige banken voegen "levendigheidscontroles" toe voor transacties met een hoog risico, bijvoorbeeld door een klant te vragen een live selfie te nemen met een specifiek gebaar of woord, wat moeilijker na te maken is voor een deepfake video. Biometrische verificatiemiddelen kunnen worden uitgebreid met maatregelen om vervalsing tegen te gaan (zoals het scannen van 3D-gezichtsdiepte of het controleren op de subtiele oogbewegingen die deepfakes vaak niet kunnen nabootsen).[27]). De sleutel is om single points of failure te vermijden. Zelfs als een AI deepfake één kanaal kan misleiden (bijvoorbeeld stemverificatie), kan een gecoördineerde out-of-band controle of biometrische test de nodige uitdaging bieden om de fraude te onthullen. Zero-trustprincipes moet worden toegepast: behandel elke ongevraagde of onverwachte instructie (zelfs van een "bekende" leidinggevende of klant) als verdacht totdat deze via een onafhankelijk kanaal is geverifieerd.

- Training van werknemers en bewustwording van fraude: Technologie alleen is geen wondermiddel - vooral omdat fraudeurs zich zullen richten op de zwakste schakel, wat vaak menselijk vertrouwen is. Financiële instellingen moeten investeren in regelmatige training voor fraudepreventieteams en eerstelijnspersoneel over AI-gebaseerde oplichting. Medewerkers moeten rode vlaggen van deepfakes en social engineering leren herkennen. Dit kan training in subtiele anomalieën omvatten (bijv. lipsync-problemen in een videogesprek, of audio met onnatuurlijke intonatie of te weinig achtergrondgeluid - mogelijke tekenen van een synthetische stem). Een cultuur van verificatie: Medewerkers moeten zich bevoegd voelen om een verdachte transactie of verzoek op te schorten en onafhankelijk te verifiëren, zelfs als het van de CEO lijkt te komen. Het geval van de Spoofingpoging stem CEO Ferrari is leerzaam - een leidinggevende ontdekte de list alleen door een persoonlijke vraag te stellen die de bedrieger niet kon beantwoorden[36]. Gesimuleerde phishing/deepfake oefeningen kunnen ook nuttig zijn. Net zoals bedrijven phishing-simulaties houden om personeel te trainen, kunnen ze een deepfake voicemail of nep-videovergadering simuleren en kijken of werknemers deze detecteren. Hierdoor wordt het spiergeheugen opgebouwd om echte aanvallen te weerstaan. Aangezien meer dan 50% van de bedrijven heeft geen deepfake responsprotocollen en weinig training op zijn plaats[29]Het opzetten van dergelijke programma's is laaghangend fruit om de veerkracht te verbeteren.

- Fraudeanalyse en anomaliedetectie: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier geluiden AI-gegenereerd of te formeel (in combinatie met de eerder genoemde AI-tekstdetectie). Banken zoals JPMorgan zijn begonnen met het gebruik van grote taalmodellen voor hun interne communicatie om zinnen of contexten te herkennen die kunnen duiden op een poging tot social engineering.[37]. Betalingsnetwerken zoals Mastercard scannen enorme datasets (miljarden transacties) met AI om frauduleuze transacties te identificeren die traditionele regels zouden missen.[38]. De afleiding is dat defensieve AI moet net zo innovatief zijn als offensieve AI. Bedrijven moeten overwegen om AI-modellen te ontwikkelen of aan te schaffen die specifiek bedoeld zijn om deepfake content, synthetische identiteiten en generatieve aanvalspatronen te detecteren. Van cruciaal belang is dat deze modellen voortdurend worden bijgeschoold op basis van de nieuwste voorbeelden van AI-fraude (een praktijk die online leren of federatief leren wordt genoemd), zodat ze gelijke tred houden met de snel veranderende tactieken van criminelen.[39][40].

- Samenwerking en het delen van informatie: De bestrijding van AI-fraude vereist samenwerking binnen en tussen instellingen. Afzonderlijke inspanningen zijn minder effectief tegen een bedreiging die organisatiegrenzen overschrijdt. Fraudepreventieteams, cyberbeveiligingsteams en IT Beveiligingsteams kunnen bijvoorbeeld deepfake-detectie inzetten in tools voor videoconferenties, terwijl fraudeteams contentscans integreren in transactiemonitoring. Op een breder niveau moeten banken deelnemen aan industriegroepen zoals het Financial Services Information Sharing and Analysis Center (FS-ISAC) om informatie uit te wisselen over nieuwe AI-fraudeconstructies.[41]. Als een bank een nieuwe deepfake aanvalsvector ontdekt, kan het delen van dat inzicht anderen helpen het gat te dichten voordat ze worden getroffen. Gezamenlijke oefeningen of 'red team'-simulaties met scenario's waarbij AI een rol speelt (bijv. een deepfake executive scam of door AI gegenereerde omzeiling van ID-verificatie) kunnen worden uitgevoerd door brancheconsortia of met ondersteuning van toezichthouders. Regelgevers richten zich zelf op AI-risico's, dus het is verstandig om proactief met hen samen te werken. Door bij te dragen aan standaarden en richtlijnen voor het gebruik van AI kunnen banken helpen een veiliger ecosysteem te creëren. Uiteindelijk, omdat een bedreiging voor één bank is een bedreiging voor alle banken in deze ruimte[42]Een collectieve verdedigingsaanpak zal iedereen beter in staat stellen om fraude met AI op te sporen en te ontmoedigen.

- Maatregelen voor klanteneducatie en vertrouwen: Tot slot mogen financiële instellingen de rol van klantbewustzijn niet over het hoofd zien. Nu deepfakes en AI-fraude zich richten op het grote publiek (bijvoorbeeld nepstemmen in grootouderfraude of neppe "technische ondersteuning"-chats die worden gegenereerd door AI), kunnen banken helpen bij het voorlichten van klanten over deze gevaren. Veel banken sturen al waarschuwingen over phishing; ze kunnen deze uitbreiden met AI-stemkloon en deepfake-video's en tips geven over hoe ze verzoeken kunnen verifiëren. Sommige vooruitstrevende organisaties sturen pushmeldingen of waarschuwingen in hun apps als er een bekende zwendel in omloop is (bijv. "Pas op: fraudeurs kunnen stemklonen van familieleden gebruiken om geld te vragen")[43]. Hoewel aanvallen niet direct kunnen worden voorkomen, kan voorlichting het slagingspercentage verlagen en versterken dat de bank een partner in veiligheid is. Bovendien moeten banken die investeren in geavanceerde fraudepreventie dit onder de aandacht van hun klanten brengen als een manier om fraude te voorkomen. differentiator - Door klanten bijvoorbeeld te laten weten dat alle videogesprekken of ingediende documenten door AI worden gescand op echtheid (zonder gevoelige methoden te onthullen), kunnen klanten worden gerustgesteld dat de bank alle beschikbare middelen gebruikt om hen te beschermen. Het behoud van digitaal vertrouwen zal voor banken van cruciaal belang zijn om de voordelen van AI in hun dienstverlening volledig te benutten, dus transparantie en klantgerichte beveiligingen maken deel uit van een holistische verdediging.

Rol van AI-inhouddetectiediensten

Een hoeksteen van de fraudebestrijdingstoolkit in het AI-tijdperk is het gebruik van AI-inhouddetectiediensten. Deze diensten zijn gespecialiseerd in het opsporen van de "vingerafdrukken" van AI-gegenereerde inhoud die langs menselijke beoordelaars zou kunnen glippen. TruthScan is zo'n aanbieder die een enterprise-grade AI-detectiesuite die meerdere inhoudstypen omvatten. Financiële instellingen kunnen deze tools integreren om automatisch te screenen op vervalsing en fraude-indicatoren:

- Document- en beeldverificatie: Het platform van TruthScan stelt banken in staat om financiële documenten in realtime testen op AI-gegenereerde fraude[44]. Dit betekent dat wanneer er een nieuwe rekening wordt geopend of een lening wordt aangevraagd met een foto-ID en loonstrookje, het systeem deze afbeeldingen onmiddellijk kan analyseren op tekenen van synthetische generatie of manipulatie. Met meer dan 99% doelnauwkeurigheid[45]De AI-beelddetector kan valse ID-afbeeldingen of vervalste PDF's detecteren die een mens op het eerste gezicht zou goedkeuren. Dit soort verificatie van de echtheid van documenten is van cruciaal belang om synthetische identiteitsfraude te stoppen nog voordat er rekeningen worden geopend.

- Transactiemonitoring in realtime: Door de inzet van API-integraties kan TruthScan inhaken op de transactieverwerking van banken en onregelmatigheden signaleren in realtime. Als een instructie via e-mail binnenkomt die verdacht lijkt, kan de Email Scam Detector de inhoud van het bericht analyseren en detecteren of het waarschijnlijk is geschreven door een AI-model dat probeert een verkoper of leidinggevende te spoofen.[46]. Ook de Realtime AI-detector kan live communicatie bewaken (zoals chats of samenwerkingsplatforms) om direct waarschuwingen te geven als er bijvoorbeeld een bedrieglijke deepfake videofeed wordt gedetecteerd tijdens een vergadering waar veel op het spel staat[47][48]. Continue bewaking met onmiddellijke waarschuwingen en geautomatiseerde reacties helpt de periode waarin fraude onopgemerkt kan plaatsvinden te verkleinen.

- Stem en video Deepfake-verdediging: Voor callcenters en relatiemanagers is het integreren van TruthScan's AI-stemdetector voegt een extra beveiligingslaag toe. Als een fraudeur belt en zich voordoet als een klant met een stemkloon, kan het systeem de audio van het gesprek analyseren en markeren of deze AI-gesynthetiseerde elementen bevat (zoals ontbrekende natuurlijke micro-pauzes of artefacten in de geluidsgolven).[35]. Op het videofront is de Deepfake detector past computervisiealgoritmen toe op videoframes om inconsistenties op te sporen, zoals onnatuurlijke gezichtsbewegingen, vreemde belichting of lipsync die een vervalsing verraden.[49][50]. Door de integriteit van stemmen en gezichten in belangrijke interacties te verifiëren, kunnen banken bedriegers verijdelen die hun medewerkers proberen te misleiden. Deze tools werken als een high-tech leugendetector voor digitale content, onzichtbaar op de achtergrond.

Het is de moeite waard om op te merken dat het inzetten van dergelijke detectietechnologie geen kant-en-klare oplossing is; het moet worden gekalibreerd en afgestemd op de workflows van de instelling. Fout-positieven moeten worden beheerst (een AI-tekstdetector kan bijvoorbeeld legitieme communicatie op basis van sjablonen als verdacht markeren totdat het het verschil leert kennen). Wanneer deze tools echter op de juiste manier zijn geïntegreerd, verbeteren ze aanzienlijk het vermogen van een organisatie om frauduleuze inhoud herkennen voordat deze schade veroorzaakt. Ze genereren ook audit trails en analytische rapporten die nuttig zijn voor compliance en voor het continu verbeteren van de fraudemodellen.

Cruciaal is dat de effectiviteit van AI-detectietools afhangt van constante updates. Net zoals antivirussoftware nieuwe handtekeningen nodig heeft voor nieuwe virussen, moeten AI-detectors worden bijgeschoold voor de nieuwste deepfake-technieken en AI-modellen. Leveranciers zoals TruthScan werken hun algoritmen bij om nieuwe generatieve modellen en ontwijkingstactieken aan te kunnen, zodat de nauwkeurigheid hoog blijft terwijl AI zich ontwikkelt.[51]. Dit ontlast interne teams en zorgt ervoor dat banken niet de oorlog van gisteren uitvechten terwijl criminelen op zoek gaan naar nieuwe AI-trucs.

Conclusie

De financiële dienstverleningssector staat op een kruispunt in de strijd tegen fraude. Aan de ene kant maken criminelen in hoog tempo gebruik van generatieve AI om zwendelpraktijken te lanceren die overtuigender en wijdverspreider zijn dan ooit. Aan de andere kant hebben banken en fraudebestrijders een groeiend arsenaal aan AI-gestuurde verdedigingsmiddelen tot hun beschikking. De instellingen die het goed zullen doen, zijn de instellingen die het nieuwe bedreigingslandschap herkennen en er met evenveel vindingrijkheid op reageren. Dit betekent investeren in geavanceerde detectiemogelijkheden, het integreren van meerlagige verificatieprocessen, het opleiden van zowel personeel als klanten en het stimuleren van een cultuur van waakzaamheid en aanpassing.

AI-gebaseerde fraude is een snel bewegend doelwit - de deepfake-fraude die vandaag een bedrijf voor de gek houdt, kan morgen worden tegengegaan door nieuwe detectietechnieken, maar fraudeurs kunnen hun methoden volgende week weer aanpassen. Een "industriestandaard" fraudepreventiestrategie in 2025 is er dus een die de nadruk legt op flexibiliteit en voortdurende verbetering. Financiële organisaties moeten hun fraudebestrijdingssystemen behandelen als levende, lerende entiteiten die gelijke tred houden met criminele tactieken. Samenwerkingsverbanden aangaan met technologieleveranciers is een slimme manier om deze capaciteiten op te bouwen. Door samen te werken met gespecialiseerde bedrijven zoals TruthScan (dat oplossingen op maat biedt voor het bankwezen en de financiële sector) kan een instelling bijvoorbeeld sneller in staat zijn om AI-gebaseerde fraude voorkomen met behoud van naleving van regelgeving en klantenvertrouwen[52].

Uiteindelijk gaat het bij bescherming tegen AI-fraude niet alleen om technologie - het gaat om het behoud van de fundamentele rechten van de mens. vertrouwen die ten grondslag ligt aan financiën. Klanten moeten erop kunnen vertrouwen dat hun bank het verschil kan zien tussen een echte transactie en een neptransactie, tussen een echte klant en een AI-imitator. Door geavanceerde AI-detectietools in te zetten, verificatieprotocollen te versterken en nieuwe bedreigingen voor te blijven, kunnen financiële dienstverleners dat vertrouwen behouden. De weg die voor ons ligt zal ongetwijfeld gekenmerkt worden door meer pogingen tot fraude-innovatie door tegenstanders, maar met een goede voorbereiding en de juiste investeringen kunnen banken ervoor zorgen dat AI wordt meer een aanwinst dan een bedreiging op het gebied van fraudepreventie. Het is een haalbaar doel: dezelfde AI-technologieën die dreigen te ontwrichten, kunnen worden ingezet om de integriteit van ons financiële systeem te waarborgen. Nu is het tijd voor fraudepreventieteams en C-level executives om resoluut te handelen, omarmen van geavanceerde oplossingen en strategieën om de fraudeurs te slim af te zijn en de toekomst van digitaal financieren veilig te stellen.

Bronnen: Er wordt overal verwezen naar recente rapporten uit de sector, waarschuwingen van regelgevende instanties en whitepapers over technologie (Deloitte[20][18], Wereld Economisch Forum[19][24]Amerikaanse Ministerie van Financiën FinCEN[3][4]Federal Reserve[13], Keepnet Labs[16][30]onder andere) om gegevens en voorbeelden te geven. Alle gegevens en voorbeelden worden inline geciteerd zodat lezers verder kunnen zoeken.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking en AI-frauderisico | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Het opsporen van gevaarlijke AI is essentieel in het deepfake-tijdperk | World Economic Forum

[3] [4] [26] FinCEN geeft waarschuwing uit over fraude met Deepfake Media gericht op financiële instellingen | FinCEN.gov

[7] [8] FraudGPT en GenAI: Hoe zullen fraudeurs AI gebruiken? | Alloy

[11] Synthetische identiteitsfraude: Hoe AI het spel verandert - Federal Reserve Bank of Boston

[12] [13] Generatieve kunstmatige intelligentie verhoogt bedreigingen van synthetische identiteitsfraude

[16] [17] [22] [23] [28] [29] [30] Deepfake statistieken en trends 2025 | Belangrijkste gegevens en inzichten - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - AI-detectie en inhoudbeveiliging voor ondernemingen

[32] [33] [51] AI Detector: AI-tekstdetectie op bedrijfsniveau - TruthScan

[44] [45] [52] AI-fraudedetectie bij banken | CRO-oplossingen | TruthScan

[49] [50] Deepfake Detector - Identificeer nep- en AI-video's - TruthScan