Verzekeringsfraude gaat een nieuw tijdperk in dat wordt aangedreven door kunstmatige intelligentie. Zowel geraffineerde fraudeorganisaties als eenzame oplichters maken gebruik van generatieve AI-tools om valse claims, synthetische identiteiten, vervalst bewijsmateriaal en zeer overtuigende oplichtingspraktijken te produceren. Deze whitepaper onderzoekt de nieuwste trends in 2025 op het gebied van AI-gestuurde verzekeringsfraude - van door AI gegenereerde claims en documenten tot stemfraude - en schetst hoe verzekeraars hierop kunnen reageren. We presenteren recente gegevens, praktijkgevallen en strategische inzichten voor verzekeraars, fraudeonderzoekers, cyberbeveiligingsteams, schadebeheerders en C-suite leiders die inzicht moeten krijgen in dit snel veranderende bedreigingslandschap.

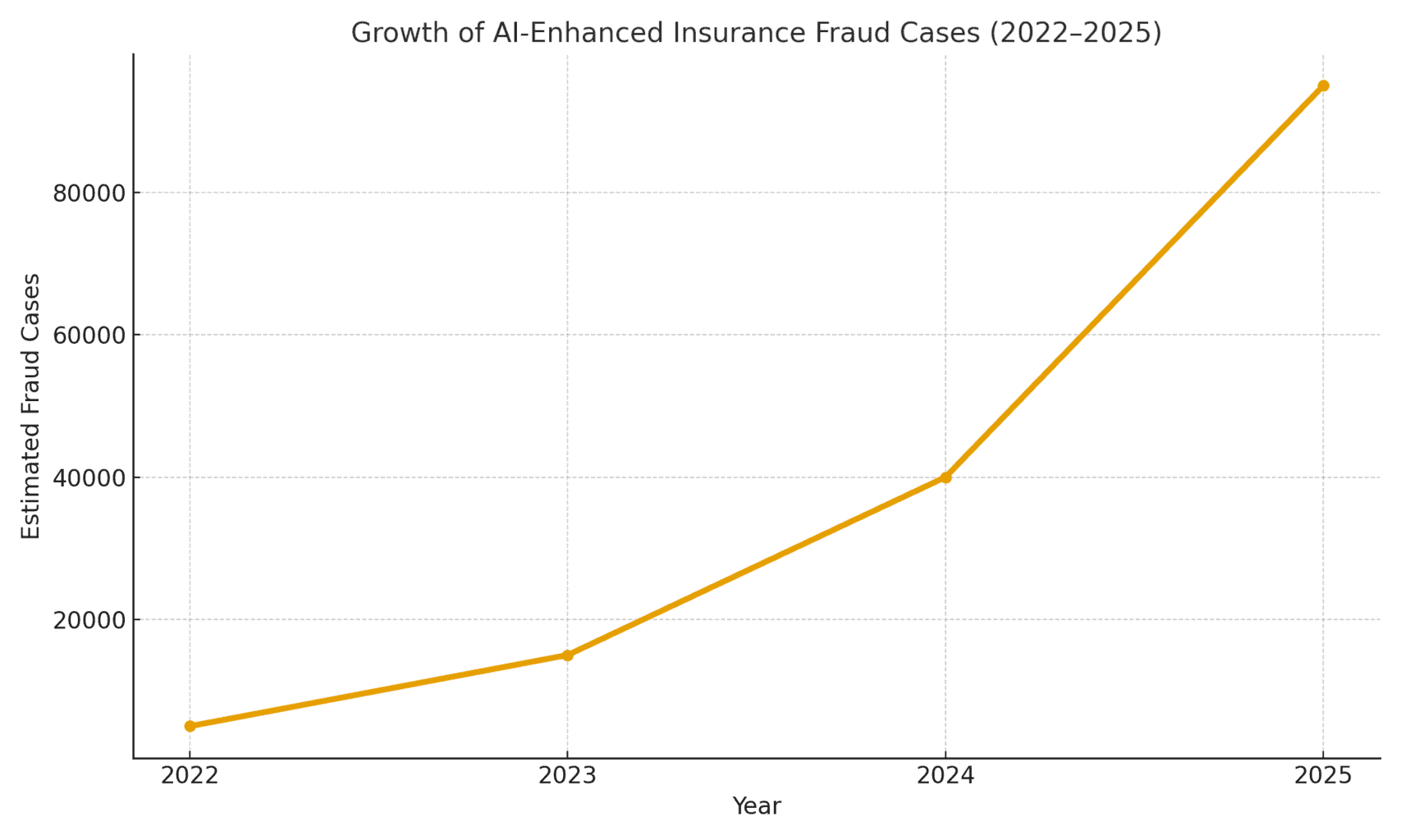

De omvang van de bedreiging: Fraude mogelijk gemaakt door AI neemt toe. Uit een forensisch boekhoudkundig rapport uit 2025 bleek dat AI-gestuurde oplichting is nu goed voor meer dan de helft van alle digitale financiële fraude[1]. In verzekeringen in het bijzonder observeerde spraakbeveiligingsbedrijf Pindrop een 475% toename van fraudeaanvallen met synthetische stem bij verzekeringsmaatschappijen in 2024wat bijdroeg aan een stijging van 19% op jaarbasis in het aantal pogingen tot verzekeringsfraude[2]. Verzekeraars worden geconfronteerd met ruwweg 20 keer meer blootstelling aan fraude dan bankendeels te wijten aan de grote afhankelijkheid van documenten, afbeeldingen en stemverificaties in claims[3]. Figuur 1 hieronder illustreert de explosieve groei van AI-ondersteunde verzekeringsfraude-incidenten van 2022 tot 2025, aangezien meerdere brancherapporten drie- of viercijferige procentuele stijgingen van jaar tot jaar aangeven in gedetecteerde AI-betrokkenheid bij fraude.

Figuur 1: Snelle toename van verzekeringsfraude met AI (geïndexeerde groei 2022-2025). Gegevens uit de sector wijzen op een exponentiële toename van AI-gegenereerde inhoud die wordt aangetroffen in frauduleuze claims, vooral sinds 2023.[4][2]

AI-gegenereerde claims en vals bewijs

Een van de meest voorkomende trends is het gebruik van generatieve AI om volledig verzonnen verzekeringsclaims. Met geavanceerde AI-tekstgeneratoren kunnen fraudeurs met één druk op de knop realistische beschrijvingen van incidenten, medische rapporten of politieverklaringen schrijven. Deze door AI geschreven verhalen komen vaak gepolijst en aannemelijk over, waardoor het voor regelaars moeilijker wordt om inconsistenties te ontdekken. Fraudeurs hebben bijvoorbeeld ChatGPT gebruikt om gedetailleerde beschrijvingen van ongevallen of letselrapporten op te stellen die professioneel en overtuigend klinken - een taak die vroeger aanzienlijke inspanning en schrijfvaardigheid vereiste.

Nog verontrustender is dat criminelen deze valse verhalen nu koppelen aan AI-gegenereerd ondersteunend bewijs. Beeldgeneratiemodellen (zoals Midjourney of DALL-E) en bewerkingstools kunnen fotorealistische schade- en letselfoto's produceren. Volgens rapporten uit de industrie zijn sommige bestuurders begonnen met AI-gegenereerde beelden indienen om autoschade te overdrijven[5]. Generatieve AI kan een foto van een autowrak of een ondergelopen huis maken die nooit echt heeft bestaan. Deze beelden zijn vaak realistischer dan wat oudere Photoshop-technieken konden bereiken[6]waardoor ze moeilijk met het blote oog te detecteren zijn. In april 2025 constateerde Zurich Insurance een stijging van het aantal claims met vervalste facturen, vervalste schattingen van reparaties en digitaal gewijzigde foto'smet inbegrip van gevallen waarin kentekennummers van voertuigen werden AI-ingetekend op afbeeldingen van autowrakken[7][8]. Dergelijk vals bewijs kan, in combinatie met een goed ontworpen AI-claimformulier, langs handmatige controles glippen.

In een opvallend geval in het Verenigd Koninkrijk namen fraudeurs een social media-foto van een busje van een handelaar en AI gebruiken om een gebarsten bumper toe te voegenen diende het vervolgens in samen met een valse reparatiefactuur voor £1,000 als onderdeel van een valse claim voor een aanrijding[9]. De zwendel werd pas ontdekt toen onderzoekers de dezelfde foto van busje (vóór schade) op de Facebook-pagina van de eigenaar[10]. Dit illustreert een breder fenomeen: verzekeraars rapporteren een 300% sprong in "shallowfake" beeldbewerkingen (eenvoudige digitale manipulaties om schade toe te voegen of details te veranderen) in slechts één jaar (2021-2022 vs 2022-2023)[4]. Allianz UK waarschuwde in 2024 dat digitale fotovervormingen en valse documenten "alle tekenen hebben om de nieuwste grote zwendel te worden die de sector treft".[4]. Het hoofd schadefraude van Zurich merkte ook op dat Wat vroeger een fysiek auto-ongeluk vereiste, kan nu volledig achter een computer gebeuren. - Oplichters kunnen "vanachter hun toetsenbord een frauduleuze claim indienen en aanzienlijke bedragen opstrijken" met valse foto's en rapporten van totaal verlies.[11][12]. Deze verschuiving vergroot niet alleen het aantal valse claims, maar verlaagt ook de drempel voor fraudeurs.

Maak je nooit meer zorgen over AI-fraude. TruthScan Kan je helpen:

- AI-opgewekt detecteren afbeeldingen, tekst, spraak en video.

- Vermijd grote AI-gestuurde fraude.

- Bescherm uw meest gevoelig bedrijfsmiddelen.

Verder dan auto's, materiële en schadeclaims zien AI-ondersteunde inflatie van verliezen. Er zijn meldingen van valse foto's voor reisverzekeringen (bijv. bagageschade of in scène gezette diefstal) en door AI gegenereerde bonnetjes voor dure spullen die nooit zijn gekocht. Levens- en gezondheidsclaims zijn ook niet immuun - fraudeurs hebben valse medische rekeningen en overlijdensakten met behulp van AI-documentvervalsers. Zürich constateerde zelfs dat deepfake technologie werd gebruikt om volledig fictieve ingenieursbeoordelingen en medische rapporten in schadepakketten[11]. Deze door AI gegenereerde documenten, vaak compleet met realistische logo's en handtekeningen, kunnen niet van echt papierwerk te onderscheiden zijn. Een opkomende zorg voor levensverzekeraars is fraude met overlijdensberichten en overlijdensaktenCriminelen kunnen AI gebruiken om vervalste overlijdensberichten of doktersbrieven te produceren om een overlijdensclaim te ondersteunen voor iemand die eigenlijk nog leeft (of die helemaal nooit heeft bestaan, zoals hierna wordt besproken).

Synthetische polishouders en identiteiten

Misschien wel de meest verraderlijke ontwikkeling is synthetische identiteitsfraude in verzekeringen. Bij synthetische identiteitsfraude wordt een fictieve persoon of entiteit gecreëerd door echte gegevens (gestolen burgerservicenummers, adressen, enz.) te combineren met verzonnen details (valse namen, valse identiteitsdocumenten). Dankzij de vooruitgang op het gebied van AI is het nu heel eenvoudig om valse gegevens te genereren. realistische persoonlijke profielen - inclusief foto's en ID's - voor mensen die niet bestaan[13][14]. Fraudeurs kunnen nu algoritmisch een volledig valse klant produceren, een polis op hun naam kopen en later claims of polisuitkeringen voor die valse identiteit in scène zetten.

In de levensverzekeringssector hebben synthetische-identiteitssystemen omhooggeschoten. Industrieel onderzoek in 2025 schat de kosten van synthetische identiteitsfraude op meer dan $30 miljard per jaargoed voor maar liefst 80-85% van alle gevallen van identiteitsfraude voor alle financiële diensten[15][16]. Levensverzekeraars zijn bijzonder hard getroffen: oplichters staan erom bekend dat ze levensverzekeringen afsluiten voor een fictief persoon en dan die persoon op papier "vermoorden" om de overlijdensuitkering te innen[17]. Een fraudeur kan bijvoorbeeld een synthetische klant "John Doe" creëren, een jaar lang premies betalen en vervolgens een claim indienen met een valse overlijdensakte en overlijdensadvertentie voor het vroegtijdige overlijden van John Doe. Omdat de identiteit zorgvuldig is opgebouwd (kredietgeschiedenis, openbare documenten, enz.), kan de overlijdensclaim legitiem lijken - totdat er geen echt lichaam of echte familieleden kunnen worden gevonden. Tegen de tijd dat de fraude wordt ontdekt, zijn de daders al lang weg met de uitbetaling.

Synthetische identiteitsconstructies teisteren ook ziektekostenverzekering en autoverzekering. Criminele bendes creëren "Frankenstein"-identiteiten door het gebruik van sofinummers van kinderen of ouderen (die geen kredietgeschiedenis hebben) in combinatie met door AI gegenereerde namen en rijbewijzen[15]. Vervolgens ziektekosten- of autoverzekeringen kopen voor deze neppersonen en kort daarna grote claims indienen. Een variant is het opzetten van syndicaten nepbedrijven (lege vennootschappen) - bijvoorbeeld een schijnvrachtwagenbedrijf - en daarvoor een commerciële verzekering afsluiten, om later een schadeclaim in te dienen voor in scène gezette ongevallen of spookverwondingen van werknemers[18][19]. Omdat het bedrijf alleen op papier bestaat (met door AI gegenereerde bedrijfsregistraties en belasting ID's), is dit "entiteitsgebaseerde" synthetische fraude wordt vaak pas ontdekt nadat claims zijn uitbetaald[18][20].

Waarom zijn synthetische identiteiten zo effectief? Ten eerste komen ze vaak door geautomatiseerde identiteitscontroles heen. Kredietbureaus en KYC-systemen vinden misschien geen rode vlaggen omdat de identiteit echte, geldige gegevens bevat (bijv. een echt SSN met een blanco strafblad)[21]. Ondertussen kunnen AI-gegenereerde profielfoto's en ID-scans er volledig authentiek uitzien - de AI van tegenwoordig kan een menselijk gezicht produceren dat zelfs door geavanceerde gezichtsherkenning als echt wordt geaccepteerd. Het resultaat: de meeste geautomatiseerde systemen herkennen deze profielen als legitiem en de fraude wordt pas ontdekt (als dat al gebeurt) na grote verliezen[22].

Impact in de echte wereld: RGA meldt dat synthetische identiteitsfraude bij levensverzekeringen kost de branche nu ongeveer $30B per jaar en is sinds 2020 bijna 400% gegroeid[15][16]. De U.S. Federal Trade Commission schat dat synthetische ID's de overgrote meerderheid van identiteitsfraude-incidenten uitmaken.[16]. Deze verliezen treffen uiteindelijk de portemonnee van eerlijke polishouders - elk gezin betaalt naar schatting 700 euro extra aan premies per jaar als gevolg van de bredere fraudebelasting van verzekeraars.[15]. Verzekeraars reageren hierop door de verificatie bij onboarding en claims te versterken: databasecontroles voor het koppelen van identiteiten, controle op meerdere polissen op hetzelfde adres en zelfs het uitvoeren van "levendigheidstests" (selfie-videocontroles om er zeker van te zijn dat een eiser een echt persoon is en niet slechts een AI-beeld).[23][24]. Maar zoals we zullen zien, gaan fraudeurs de strijd aan met AI in de volgende arena: deepfake stemmen en video's.

Deepfake stemmen en video claims

AI-gegenereerd audio en video deepfakes voegen een alarmerende nieuwe dimensie toe aan verzekeringsfraude. In 2023 en 2024 waren er verschillende incidenten waarbij criminelen gebruik maakten van stem klonen Een tactiek die oorspronkelijk werd toegepast bij bankovervallen (zoals het beruchte deepfake CEO-telefoontje waarbij in 2020 $35 miljoen werd gestolen), maar die nu ook wordt toegepast bij verzekeringen. Fraudeurs klonen de stemmen van polishouders, artsen of schade-experts en gebruiken deze in social engineering scams. De 2024-analyse van Pindrop waarschuwt dat "Deepfakes, synthetische stemtechnologie en AI-gestuurde zwendel veranderen het frauderelandschap., met stemfraude schaalvergroting in een ongekend tempo[25]. Ze ontdekten dat callcenters voor verzekeringen werden gebombardeerd door overzeese slechte acteurs die gebruik maakten van stemvervalsing: er kwamen bijvoorbeeld telefoontjes binnen met het gestolen SSN en de persoonlijke gegevens van een echte polishouder, en als een agent opnam, werd het gestolen SSN en de persoonlijke gegevens van de polishouder gebruikt. De AI-gekloonde stem van de beller kan de agent misleiden via op kennis gebaseerde verificatie en een frauduleuze uitbetaling aanvragen[26]. In het geval van een verzekeraar aan de westkust gebruikten aanvallers deze methode herhaaldelijk om te proberen rekeningen over te nemen en uitbetalingen om te leiden, waarbij ze gebruik maakten van het feit dat de ID-verificatie door het callcenter berustte op stem- en persoonlijke gegevens die kunnen worden vervalst.[26].

Spraakimitatie is ook gebruikt aan de consumentenkant: Oplichters hebben slachtoffers van ongevallen of begunstigden gebeld terwijl zich voordoen als verzekeringsagentZe gebruiken AI-stemmen om officieel te klinken en zo gevoelige informatie of zelfs betalingen af te troggelen. Omgekeerd kan een fraudeur zich voordoen als een klant bij een hotline voor schadeclaims om via de telefoon een claim indienen met een nepstem die overeenkomt met het geslacht/de leeftijd van de klanten omzeilt zo de stembiometrische controles. Recente fraudestatistieken zijn ontnuchterend: industrie-experts voorspellen een 162% groei in deepfake fraudeaanvallen tegen verzekeraars in het komende jaar[27]en Pindrop nam een 475% piek in synthetische spraakaanvallen in 2024 zoals eerder vermeld[2]. Deze aanvallen overtreffen snel de meer traditionele vectoren van cyberfraude.

Niet alleen telefoongesprekken, op video gebaseerde deepfakes ontstaan in het claimproces. Veel verzekeraars zijn overgestapt op virtuele schade-inspecties en videoconferenties (versneld door de pandemie) om verliezen te verifiëren of eisers op afstand te ondervragen. Nu zijn fraudeurs AI avatars en deepfake video's gebruiken om deze verificaties te misleiden. Er zijn meldingen van aanvragers die AI-gegenereerde avatars bij live videogesprekken met afstellers, om zich voor te doen als iemand anders of om tekenen van inconsistentie te verbergen[28]. Een fraudebende kan bijvoorbeeld een deepfake "live" video van een vermeende eiser die zijn schade laat zien via een smartphoneterwijl de persoon op camera een AI-compositie is of een ingehuurde acteur met gezichtsveranderende filters. Een speculatief maar plausibel scenario is het gebruik van een deepfake van een overleden persoon: Bij lijfrente- of levensverzekeringsfraude kan een familielid een deepfake video van de overledene gebruiken tijdens een routine-oproep voor een bewijs van leven om uitbetalingen te blijven ontvangen.[29]. Hoewel er nog geen geruchtmakende zaak van deze aard bekend is gemaakt, bereiden verzekeraars zich erop voor. Toezichthouders nemen ook nota - Er zijn discussies gaande in de VS en Europa over het classificeren van deepfakes onder identiteitsdiefstal en het updaten van richtlijnen voor bewijsverificatie in verzekeringen.[30].

Het detecteren van deepfake video's en audio is een hele uitdaging zonder technische hulpmiddelen. Menselijke afstellers zijn niet getraind om subtiele lipsync-problemen of akoestische eigenaardigheden te onderscheiden. Toch zijn er in sommige gevallen rode vlaggen geweest: bijvoorbeeld onnatuurlijk knipperen of gezichtsstoringen op video, of achtergrondgeluidsartefacten in een gesprek die onderzoekers hebben getipt. Maar over het algemeen, deepfake verzekeringsfraude is nog in een vroeg stadiumen vervolging blijft zeldzaam - vanaf 2023 waren juridische definities onduidelijk en was het moeilijk om te bewijzen dat een video AI-gegenereerd was zonder analyse door een expert.[31]. Dit geeft fraudeurs een gevoel van straffeloosheid. De wapenwedloop is begonnen: verzekeraars wenden zich nu tot forensische AI om AI te bestrijdenDeepfake-detectiealgoritmen gebruiken om verdachte video's frame voor frame te onderzoeken op tekenen van manipulatie.[24]. Leveranciers van stembiometrie zijn bezig met het uitrollen van deepfake stemdetectoren die spectrale patronen en stemcadans analyseren voor authenticiteit.[32]. We zullen deze verdedigingstechnologieën later bespreken.

AI-geoptimaliseerde phishing en imitatiezwendel

Niet alle AI-fraude komt via de schadeafdeling; sommige doelwitten zijn klanten en werknemers via social engineering. Phishingmails en -teksten gemaakt door AI zijn een grote bedreiging geworden op het gebied van verzekeringen. Bij deze zwendel gebruiken fraudeurs AI-chatbots en vertaaltools om zeer overtuigende zwendelcommunicatie te genereren. Criminelen kunnen bijvoorbeeld het merk en de schrijfstijl van een verzekeringsmaatschappij imiteren om massale phishing-e-mails naar polishouders te sturen met de boodschap "Er moet dringend actie worden ondernomen om te voorkomen dat de polis wordt geannuleerd" en ze door te sturen naar een nepwebsite. In tegenstelling tot de onhandige oplichtingsmails uit het verleden, AI zorgt voor onberispelijke grammatica en zelfs personalisatiewaardoor ze veel geloofwaardiger worden. We hebben gezien dat AI wordt gebruikt om sociale media af te speuren naar details die in spear-phishingberichten worden verweven, zoals een verwijzing naar een recente autoaankoop in een vals verzekeringsbericht.

Een andere vector is AI-ondersteunde imitatie van agenten of leidinggevenden. Er zijn gevallen bekend waarbij oplichters de stem van de eigenaar van een verzekeringsagentschap kloonden en voicemailberichten achterlieten voor klanten waarin ze vroegen om updates van bankgegevens - in feite een gesproken phishingaanval. Ook interne fraude kan voortkomen uit AI-imitatie: de financiële afdeling van een verzekeraar werd bijna het slachtoffer toen fraudeurs een deepfake audiobericht stuurden. naar verluidt van de CEO een geldoverdracht autoriseren (een variant van "CEO-fraude" die nu door sommige e-crimeverzekeringen wordt gedekt)[33]). Dit soort AI-gestuurde oplichtingspraktijken steeg volgens Liberty Specialty Markets met 17% in 2023.[33]en zullen naar verwachting blijven stijgen.

Consumenten zijn ook het doelwit van oplichting via synthetische media die te maken hebben met verzekeringen. De Coalition Against Insurance Fraud maakt melding van gevallen van bedriegers die zich voordoen als verzekeringsagenten, contact opnemen met slachtoffers van ongevallen en beweren dat ze hun claim behandelen en vervolgens onmiddellijke betaling of gevoelige gegevens eisen[23]. Nietsvermoedende klanten die opgelucht zijn om van een zogenaamde vertegenwoordiger te horen, kunnen hieraan gehoor geven, vooral als de beller details over hun ongeval kent (die AI kan achterhalen via hacking of openbare bronnen). Het publiek is zich nauwelijks bewust van deze tactieken; daarom dringen fraudepreventie-experts er bij verzekeraars op aan om polishouders informeren over het verifiëren van de identiteit van bellers en e-mails[23][34]. Net zoals banken klanten waarschuwen voor phishing, beginnen verzekeraars in 2025 waarschuwingen voor deepfake scam op te nemen in hun communicatie.

Een rode draad in deze AI-verrijkte schema's is het gebruik van gemakkelijk verkrijgbare "fraude-als-service" kits.[35]. Op het dark web kunnen criminelen tools kopen of zich abonneren op tools die kant-en-klare deepfake stemmen, sjablonen voor valse documenten, phishing e-mailgenerators en nog veel meer bieden. Deze democratisering van AI-tools betekent zelfs laagopgeleide oplichters kunnen geavanceerde fraudeaanvallen uitvoeren[35]. Voor verzekeringsmaatschappijen vertaalt dit zich in een stortvloed van meer overtuigende fraudepogingen vanuit alle hoeken - claims, klantenservice, e-mail, zelfs sociale media. Dit onderstreept de noodzaak van een meervoudige verdedigingsstrategie, waarbij technologie, menselijke waakzaamheid en brancheoverschrijdende samenwerking worden gecombineerd.

Detectie en verdediging: Een antwoord op AI

Het bestrijden van AI-fraude vereist AI-gestuurde verdediging. Verzekeraars maken steeds meer gebruik van geavanceerde detectietechnologieën en vernieuwde processen om de aanval af te slaan. In essentie moeten verzekeraars controlepunten voor inhoudsverificatie in de hele levenscyclus van verzekeringen - van acceptatie tot schadeclaims en klantinteracties - om AI-vervalsingen op te sporen. Figuur 2 geeft een overzicht van de belangrijkste vormen van fraude die door AI mogelijk worden gemaakt en hoe vaak ze voorkomen.

Figuur 2: Soorten verzekeringsfraude met AI in 2025 (geschat aandeel per regeling). Valse beelden (vervalste foto's van schade) en synthetische identiteiten behoren tot de grootste categorieën, gevolgd door met AI vervalste documenten (bijv. bonnen, certificaten) en deepfake audio-/videofraude.

1. AI-inhouddetectietools: Nieuwe AI-detectiediensten kunnen tekst, afbeeldingen, audio en video analyseren om te bepalen of ze machinaal zijn gegenereerd of gemanipuleerd. Verzekeraars kunnen bijvoorbeeld gebruikmaken van oplossingen zoals AI-tekst- en beelddetectoren van TruthScan die 99%+ nauwkeurige AI gebruiken om AI-geschreven documenten of vervalste foto's te markeren[36]. Een verzekeringsmaatschappij zou deze detectoren kunnen integreren in hun claimsysteem: wanneer een claim en het bijbehorende bewijsmateriaal worden ingediend, kan de tekstbeschrijving automatisch worden gescand op AI-gegenereerde taalpatronen en kunnen geüploade afbeeldingen worden gescand op duidelijke tekenen van CGI of bewerking. Bedrijfskritische tools kunnen met 99% nauwkeurigheid AI-gegenereerde tekst in documenten, e-mails en communicatie identificeren[36]en op dezelfde manier door AI gegenereerde of gemanipuleerde afbeeldingen detecteren om de authenticiteit van visuele inhoud te waarborgen[36]. Dit betekent dat een vals verhaal over een ongeval geproduceerd door ChatGPT of een in het midden van de reis vervalste schadefoto wordt gemarkeerd voor handmatige controle voordat de claim wordt verwerkt. Verzekeraars maken in 2025 steeds meer gebruik van dergelijke AI-contentverificatie, 83% van de fraudebestrijdingsprofessionals is van plan om generatieve AI-detectie te integreren tegen 2025volgens een onderzoek van ACFE, tegenover slechts 18% vandaag.[37][38].

2. Identiteitsverificatie en biometrische controles: Om synthetische identiteiten aan te pakken, breiden verzekeraars KYC-protocollen ook uit met AI. Identiteitsvalidatiediensten kunnen gegevens van aanvragers kruiselings verifiëren aan de hand van meerdere databases en gebruikmaken van gezichtsherkenning met levendigheidstests. Zo kan het vereisen van een korte selfie-video tijdens het inchecken (en het matchen van gezichten met de verstrekte ID) veel synthetische ID's verijdelen. Nog geavanceerder zijn bedrijven als TruthScan, die beeldforensisch onderzoek aanbieden dat het volgende kan doen spot AI-gegenereerde profielfoto's, avatars en synthetische personageafbeeldingen - hun AI-beelddetector is getraind om gezichten te identificeren die zijn gemaakt door generatoren zoals StyleGAN of ThisPersonDoesNotExist[39]. Door dergelijke tools in te zetten, kan een verzekeraar detecteren of de selfie van een levensverzekeringsaanvrager geen echt mens is. Aan de stemkant, biometrische stemverificatie voor klantenservicegesprekken kan helpen; moderne voice AI-detectoren zijn in staat om synthetische stemmen en pogingen tot stemkloon herkennen in realtime[40]. Bijvoorbeeld TruthScan's AI-spraakdetectie Het systeem gebruikt akoestische analyse om AI-gegenereerde stemmen en audio-fakes herkennen voordat ze callcentermedewerkers voor de gek houden[40]. Deze oplossingen werken als een firewall - als iemand belt die zich voordoet als John Doe en zijn of haar stemafdruk komt niet overeen met de authentieke stem van John Doe (of komt overeen met bekende deepfake kenmerken), dan kan de oproep worden gemarkeerd of verder identiteitsbewijs worden gevraagd. Multi-factor authenticatie (e-mail/SMS bevestiging, eenmalige wachtwoorden, etc.) voegt extra hindernissen toe die impersonators moeten overwinnen.

3. Deepfake video- en beeldforensisch onderzoek: Als het aankomt op videobewijs, beginnen verzekeraars gespecialiseerde forensische analyse te implementeren. Geavanceerde software kan videometadata, frame consistentie en foutniveaus analyseren om deepfakes te detecteren. Sommige tools onderzoeken reflecties, schaduwen en fysiologische aanwijzingen (zoals de polsslag in iemands keel op video) om er zeker van te zijn dat een video echt is. Forensisch onderzoek van metadata is ook waardevol: onderzoek van bestandsmetadata en generatievoetafdrukken in afbeeldingen of PDF's kan onthullen of iets waarschijnlijk door een AI-tool is geproduceerd.[41]. Verzekeraars zouden bijvoorbeeld originele fotobestanden (die metadata bevatten) moeten eisen in plaats van alleen screenshots of afgedrukte kopieën. Het fraudeteam van Zürich merkte succes op bij het opsporen van valse afbeeldingen van auto's door anomalieën op te merken in de metagegevens van de afbeelding en analyse van het foutenniveau.[41]. Detectoren van e-mailoplichting kan ook inkomende communicatie scannen op tekenen van door AI geschreven phishing-inhoud of bekende schadelijke handtekeningen[42]. Veel verzekeraars gebruiken nu phishing-simulaties en AI-opgezette scam-voorbeelden in de training van werknemers om het bewustzijn te vergroten.

4. Procesveranderingen en menselijke training: Technologie alleen is geen wondermiddel. Procesverbeteringen worden gemaakt, zoals frequentere steekproefsgewijze persoonlijke controles voor claims met een hoge waarde, of het vereisen van fysieke documentatie in bepaalde gevallen. Sommige verzekeraars hebben de volledig geautomatiseerde verwerking van claims uitgesteld en voeren opnieuw menselijke beoordelingen uit voor claims die hoog scoren op een AI-frauderisicomodel. Aan de menselijke kant is training cruciaal. Fraudeonderzoekers en schade-experts worden getraind in het herkennen van AI-vlaggen: bijv. meerdere claims met identieke bewoordingen (ChatGPT "stijl"), beelden zonder echte willekeur (bijv. herhalende patronen in wat organische schade zou moeten zijn), of stemmen die klinken alsof er een AI-claim is ingediend. bijna rechts, maar hebben een robotachtige cadans. Verzekeraars geven ook voorlichting aan klanten: ze sturen fraudewaarschuwingen over deepfake-complotten en adviseren hoe ze de identiteit van een verzekeringsvertegenwoordiger kunnen verifiëren (bijvoorbeeld door een bekend terugbelnummer op te geven).

5. Samenwerkingsverbanden: De samenwerking binnen de sector neemt toe. In het Verenigd Koninkrijk hebben het Insurance Fraud Bureau en de Association of British Insurers werkgroepen gevormd op het gebied van AI-fraude. Handvest verzekeringsfraude (2024) bevordert het delen van gegevens en gezamenlijke initiatieven[43]. Wereldwijd werken verzekeraars samen met cyberbeveiligingsbedrijven en AI-startups. Er verschijnen met name nieuwe verzekeringsproducten: Liberty Mutual lanceerde een e-crimeverzekering voor kmo's die specifiek deepfake scams en CEO-fraude dekt[44][33]Dit benadrukt dat dit risico zeer reëel is. Dit betekent ook dat verzekeraars zowel slachtoffers als oplossers van AI-fraude kunnen zijn - uitbetalen voor een deepfake-zwendel als deze niet wordt ontdekt, maar ook dekking bieden voor anderen die het slachtoffer worden van dergelijke aanvallen.

De integratie van detectietechnologie in workflows kan worden gevisualiseerd als een verdediging op meerdere punten in de levenscyclus van claims. Zoals weergegeven in Figuur 3verzekeraars kunnen AI-verificatiestappen invoegen op beleidstoepassing (om te screenen op synthetische identiteiten via ID-documenten en selfie-controles), op indienen van claims (om geüploade documenten, foto's of audio automatisch te analyseren voor AI-generatie), tijdens beoordeling/onderzoek claim (om deepfake forensische analyse uit te voeren op verdacht bewijs en eventuele steminteracties te verifiëren), en vlak voor uitbetaling (een laatste identiteitsverificatie om er zeker van te zijn dat de begunstigde legitiem is). Door fraude in een vroeg stadium op te sporen - idealiter bij onboarding of de eerste schademelding - besparen verzekeraars op onderzoekskosten en voorkomen ze onterechte uitbetalingen.

Figuur 3: Integratie van AI-detectiepunten in de levenscyclus van verzekeringen. Bij het afsluiten van een polis controleert AI-gebaseerde identiteitsvalidatie op synthetische of valse identiteiten. Wanneer een claim wordt ingediend, scannen geautomatiseerde detectors claimtekst, documenten en afbeeldingen op AI-gegenereerde inhoud. Tijdens het beoordelen van claims verifiëren gespecialiseerde deepfake en stemanalyse tools alle audio-/videobewijs. Voorafgaand aan de uitbetaling bevestigt biometrische identiteitsverificatie de identiteit van de begunstigde. Deze gelaagde aanpak helpt fraude in meerdere stadia te onderscheppen.

Verzekeraars hoeven al deze mogelijkheden niet zelf te ontwikkelen - veel verzekeraars maken gebruik van bedrijfsoplossingen zoals De AI-detectiesuite van TruthScandie een reeks tools biedt die API-geïntegreerd kunnen worden in systemen van verzekeraars. Bijvoorbeeld, AI-beeld- en Deepfake-detectieservice van TruthScan kan worden gebruikt om de authenticiteit van afbeeldingen en video's te verifiëren met een nauwkeurigheid van meer dan 99%[45]. Hun AI-tekstdetector markeert AI-geschreven tekst in claims of e-mails[36]terwijl de AI-stemdetector Biedt detectie van stemkloon en verificatie van de spreker om telefoonbedriegers tegen te houden[40]. Er zijn zelfs nichehulpmiddelen zoals een Valse ontvangstbewijsdetector facturen/bonnen onmiddellijk analyseren op tekenen van manipulatie of AI-gegenereerde lettertypen/lay-outs[46] - uiterst nuttig gezien de prevalentie van valse reparatienota's in schadeclaims. Door een combinatie van deze tools in te zetten, kan een verzekeraar zijn fraudedetectie drastisch verbeteren. Een Fortune 500 verzekeraar rapporteerde het vangen van 97% van pogingen tot deepfake in 2024 door gebruik te maken van een gelaagde AI-screeningaanpak (tekst, beeld, stem) en zo naar schatting \$20M aan verliezen te vermijden[47][48].

Conclusie

AI verandert het slagveld van verzekeringsfraude op wereldwijde schaal. Fraudeurs innoveren met generatieve AI om valsheden te creëren die overtuigender zijn dan ooit - van volledig verzonnen mensen en ongelukken tot imitaties die zelfs doorgewinterde professionals kunnen misleiden. De gegevens van 2024-2025 laten een alarmerende groei zien van deze AI-oplichtingspraktijken, maar laten ook zien dat verzekeraars die investeren in detectie en preventie een stap voor kunnen blijven. Door geavanceerde AI-detectietechnologie - zoals forensisch beeldonderzoek, stemverificatie en tekstanalyse - met bijgewerkte workflows en opleiding kan de sector de risico's beperken zonder de efficiëntie van digitale processen op te offeren.

In de kern is dit een technologische wapenwedloop[49]. Zoals een fraudepreventiedeskundige opmerkte, "In deze nieuwe realiteit is waakzaamheid de premie die moet worden betaald"[50]. Verzekeringsmaatschappijen moeten een cultuur van waakzaamheid koesteren en de beste hulpmiddelen inzetten om het vertrouwen in het claimproces te behouden. Dat betekent dat de waarheid van documenten, stemmen en beelden met dezelfde zorgvuldigheid moet worden geverifieerd als waarmee verzekeraars risico's beoordelen. Het betekent ook samenwerken binnen de branche om informatie te delen over nieuwe AI-fraudetactieken en gezamenlijk standaarden te ontwikkelen (bijvoorbeeld standaardvereisten voor metadata voor ingediende media of zwarte lijsten van bekende valse identiteiten).

2025 is een kantelpunt: de verzekeraars die proactief aanpassen aan AI-gestuurde fraude hun klanten en balansen beschermen, terwijl degenen die traag reageren het doelwit kunnen worden van oplichtingspraktijken die de krantenkoppen halen. Het bemoedigende nieuws is dat de technologie om terug te vechten bestaat en snel volwassen wordt - dezelfde AI die fraudeurs macht geeft, kan verzekeraars macht geven. Door oplossingen zoals TruthScan's multi-modale AI-detectiesuite voor claims en identiteitsverificatie te implementeren, kunnen verzekeraars het succespercentage van AI-gegenereerde fraudepogingen drastisch verlagen.[51][52]. Hiermee voorkomen ze niet alleen verliezen, maar geven ze ook een duidelijke boodschap af aan potentiële fraudeurs: hoe slim de tools ook zijn, fraude zal worden ontdekt.

Kortom, AI-gestuurde verzekeringsfraude is een formidabele uitdaging, maar wel een die kan worden aangegaan met een even intelligente verdediging. Met waakzaamheid, een cross-functionele strategie en de juiste technologische partners kan de verzekeringsbranche de fundamentele belofte in het hart van haar activiteiten blijven nakomen - alleen legitieme claims betalen en dit snel en veilig doen in een steeds digitalere wereld.

Referenties:

- Verbond van Britse Verzekeraars - Fraudestatistieken 2023[53][54]

- Allianz & Zurich over AI-'shallowfake'-claims - Allianz & Zurich over AI-'shallowfake'-claims The Guardian, 2024[4][11]

- Facia.ai - "Deepfake verzekeringsfraude: Hoe AI de regels herschrijft". Okt 2025[55][56]

- Coalitie tegen verzekeringsfraude Synthetische fraude in verzekeringen (Quantexa), Dec 2024[21][17]

- RGA - "De nieuwe grens van fraudebestrijding: synthetische identiteiten". Juni 2025[15][16]

- Pindrop - Rapport stemfraude, via FierceHealthcare, juni 2025[2][3]

- Nummers draaien - "Top financiële fraude 2025". Okt 2025[1][57]

- TruthScan - AI-detectieplatform (dienstenoverzicht), 2025[51][52]

- TruthScan - AI beelddetector productpagina, 2025[45][39]

- TruthScan - AI Voice Detector productpagina, 2025[40]

- TruthScan - Valse ontvangstbewijsdetector productpagina, 2025[46]

- Liberty Speciale Markten - Deepfake/Cyber Fraud Insurance Persbericht, Maart 2025[33]

- Facia.ai - Blog: Wapenwedloop om verzekeringsfraude te voorkomen, 2025[24][32]

- Verzekeringsbedrijf UK - "AI-gegenereerde beelden gebruikt voor motorfraude," Apr 2025[7][58]

- De Wachter - "Nepfoto's van autoschade schrikken verzekeraars af", aldus de website. Mei 2024[9][12]

[1] [35] [57] 2025 Financiële fraude: AI-bedreigingen en rode vlaggen

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Verzekeringsfraude verhoogd met 19% door stemaanvallen in 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Fraudeurs bewerken foto's om valse schade toe te voegen aan Britse verzekeringsfraude | Verzekeringssector | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] AI-gegenereerde beelden worden nu gebruikt voor fraude met autoverzekeringen - rapport | Insurance Business UK

[13] [14] [15] [16] De nieuwe grens van fraudebestrijding: synthetische identiteiten en een AI-wapenwedloop | RGA

[17] [18] [19] [20] [21] [22] JIFA: Synthetische fraude: Met synthetische fraude al in hun ecosysteem, moeten verzekeraars meer denken als banken - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Deepfake verzekeringsfraude: Hoe AI de regels van verzekeringsclaims herschrijft

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] De stille bedreiging: Waarom verzekeringsfraude zich verplaatst naar de telefoonlijn

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] E-crimeverzekering voor kmo's richt zich op CEO-fraude, deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - AI-detectie en inhoudbeveiliging voor ondernemingen

[37] Onderzoek: 8 op de 10 fraudebestrijders verwachten generatieve AI in te zetten tegen 2025

[38] Inzichten uit het 2024 Anti-Fraud Technology Benchmarking Report

[39] [45] AI-beelddetector herkent valse en gemanipuleerde foto's - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI-stemdetector voor deepfakes en stemkloon | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Detector valse ontvangstbewijzen | Controleer de echtheid van ontvangstbewijzen

https://truthscan.com/fake-receipt-detector

[47] Fortune 500 verzekeraar ontdekt 97% van Deepfakes en stopt met synthetische ...