Een uitgebreide gids voor het begrijpen, detecteren en voorkomen van AI-spraakfraude in de onderneming

Het $25 Miljoengesprek dat nooit heeft plaatsgevonden

In februari 2024 kreeg een financiële medewerker van een multinational in Hong Kong een videogesprek met haar CFO.

De stem aan de andere kant was onmiskenbaar; elke stembuiging, elke pauze en zelfs het lichte accent werden onmiddellijk herkend.

Hij vroeg haar dringend om 15 overschrijvingen te verwerken, voor een totaalbedrag van $25 miljoen, om een vertrouwelijke overname af te ronden.

Maak je nooit meer zorgen over AI-fraude. TruthScan Kan je helpen:

- AI-opgewekt detecteren afbeeldingen, tekst, spraak en video.

- Vermijd grote AI-gestuurde fraude.

- Bescherm uw meest gevoelig bedrijfsmiddelen.

De CFO heeft die beslissing nooit genomen. Het was volledig door AI gegenereerd.

Dit was geen op zichzelf staand geval. Financiële instellingen zien een sterke toename van fraude met deepfakes.

In de afgelopen drie jaar is het aantal gevallen met 2.137% gestegen en AI is nu verantwoordelijk voor 42,5% van alle fraudepogingen in de sector.

Zelfs met de toename van AI-spraakfraude geeft meer dan de helft van de bedrijfsleiders toe dat hun werknemers niet zijn getraind om deepfake-aanvallen te herkennen of erop te reageren; bijna 80% van de bedrijven heeft geen formele protocollen om deze incidenten af te handelen.

Hoe AI Voice Cloning werkt en waarom het een bedreiging is

Moderne AI-stemsynthese heeft verrassend weinig gegevens nodig. Slechts een paar seconden audio kunnen een stem klonen met een nauwkeurigheid tot 85%.

Het proces bestaat uit drie belangrijke stappen:

- Gegevensverzameling: Oplichters verzamelen stemvoorbeelden van openbare bronnen zoals conferentiegesprekken, podcastinterviews, fragmenten van sociale media of zelfs LinkedIn-videoposts.

- Modeltraining: AI analyseert stemkenmerken zoals toonhoogte, toon, accent, tempo en ademhalingspatronen.

- Generatie: Het systeem maakt synthetische spraak die overtuigend genoeg is om zelfs naaste collega's voor de gek te houden.

Het toegankelijkheidsprobleem

Wat deze bedreiging nog gevaarlijker maakt, is de democratisering ervan. Oplichters hebben niet langer middelen op Hollywood-niveau nodig.

Het enige dat nodig is, is toegankelijke software om een stem te klonen van een kort social media-fragment; open-source tools en cloud-gebaseerde AI-diensten hebben het klonen van stemmen beschikbaar gemaakt voor iedereen met technische basisvaardigheden.

Waarom leidinggevenden topdoelen voor fraude zijn

Leidinggevenden worden geconfronteerd met een gevaarlijke mix van risicofactoren.

Door hun publieke bekendheid via sociale media zijn stemvoorbeelden gemakkelijk te vinden en hun autoriteit zet werknemers er vaak toe aan om snel te reageren op dringende verzoeken.

Gemiddeld heeft één op de vier leidinggevenden een beperkt begrip van deepfake technologie.

Huidige statistieken geven een verontrustend beeld

In een 2024 Deloitte onderzoek25,9% van de leidinggevenden zei dat hun organisaties het afgelopen jaar te maken hadden gehad met ten minste één deepfake-incident gericht op financiële of boekhoudkundige gegevens, en de helft van alle respondenten geloofde dat dergelijke aanvallen in de komende 12 maanden zouden toenemen.

Het meest verontrustend: slechts 52% van de organisaties heeft er vertrouwen in dat ze een deepfake van hun CEO zouden kunnen herkennen.

Hoe AI-stemzwendel herkennen

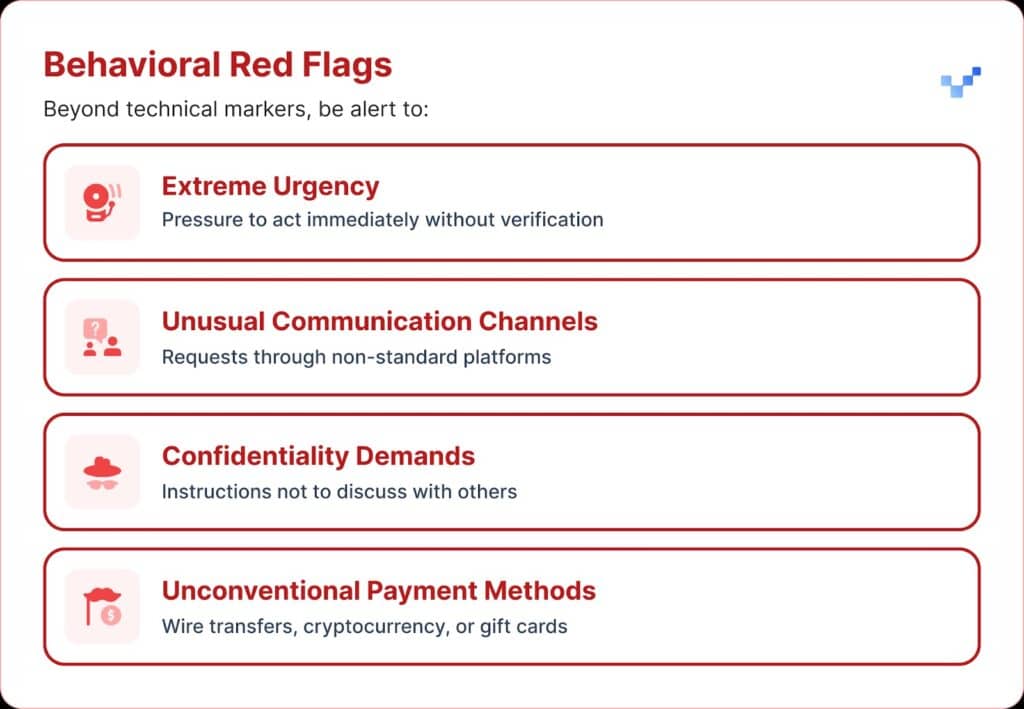

Als je een verdachte gesproken communicatie ontvangt, zijn er een paar waarschuwingssignalen waar je op moet letten.

AI-stemzwendel klinkt vaak monotoon of vlak. Je kunt ook een ongebruikelijk tempo opmerken, met vreemde pauzes of een onnatuurlijk ritme.

Het geluid kan ook een vaag elektronisch gezoem of echo's bevatten, vooral tijdens langere gesprekken.

En in veel gevallen herhaalt de stem beperkte zinnen die overkomen als gescript of ingestudeerd.

Financiële impact en wat het echt kost

De meeste organisaties verloren gemiddeld rond de $450.000, maar in de financiële dienstverleningssector stegen de verliezen tot boven de $603.000.

En in de ernstigste gevallen meldde 1 op de 10 organisaties verliezen van meer dan $1 miljoen.

Deze trend is snel gegroeid. Eerder onderzoek uit 2022 gaf aan dat de gemiddelde financiële last van identiteitsfraude rond de $230.000 lag, bijna de helft van het huidige cijfer.

Verwachte toekomstige verliezen

Volgens het Center for Financial Services van Deloitte kan het geld dat verloren gaat aan AI-fraude in de VS stijgen van $12,3 miljard in 2023 tot $40 miljard in 2027. Dat is ongeveer 32% groei per jaar.

Regionale kwetsbaarheid

Noord-Amerika kende een stijging van 1740% in deepfake fraude.

Deze aanzienlijke regionale toename suggereert dat Noord-Amerika een primair doelwit zou kunnen zijn voor deepfake fraudeurs, waarschijnlijk vanwege de grote digitale economie en het wijdverbreide gebruik van online diensten.

Strategische benaderingen van Executive Protection

1. Verificatieprotocollen implementeren

Eén manier om de verdediging te versterken is het gebruik van een "veilig woord" systeem, vooraf overeengekomen authenticatiezinnen die gedeeld worden met belangrijk personeel.

Een oplichter die gebruik maakt van AI-stemkloon weet niet de juiste antwoorden op persoonlijke verificatievragen.

Een andere beveiliging is verificatie via meerdere kanalen.

Elk ongebruikelijk financieel verzoek moet worden bevestigd via een apart communicatiekanaal, waarbij nooit alleen vertrouwd mag worden op de oorspronkelijke contactmethode.

Bedrijven moeten ook duidelijke regels opstellen voor escalatie, met wachttijden en goedkeuringsstappen voor grote financiële transacties, ongeacht wie daarom vraagt.

2. Let op digitale blootstelling

Een andere beschermingslaag is het beperken van de hoeveelheid uitvoerende audio en video die online beschikbaar is. Hoe meer voorbeelden oplichters kunnen verzamelen, hoe overtuigender hun klonen worden.

Het helpt ook om duidelijke social media-richtlijnen op te stellen voor leidinggevenden, vooral met betrekking tot het plaatsen van video's met duidelijke audio.

En als het gaat om conferenties, moeten organisaties oppassen voor opgenomen gesprekken of interviews die lange stukken van stemvoorbeelden weggeven.

3. Technische oplossingen implementeren

Dit is waar geavanceerde AI-detectietechnologie van cruciaal belang wordt.

Organisaties hebben spraakverificatie en -verificatie op bedrijfsniveau nodig. detectie van deepfakes mogelijkheden die bieden:

- Real-time analyse: Synthetische stemmen detecteren tijdens live communicatie

- Historische verificatie: Analyseer opgenomen gesprekken en berichten op echtheid

- Integratiemogelijkheden: Werkt naadloos samen met bestaande communicatieplatforms

- Hoge nauwkeurigheid: Minimaliseer fout-positieven en vang geavanceerde vervalsingen

4. Uitgebreide trainingsprogramma's

Leiderschapsteams hebben gerichte training nodig over AI-spraakbedreigingen en verificatieprocedures.

Net zo belangrijk is de bewustwording van werknemers.

Iedereen, in welke rol dan ook, moet in staat zijn om potentiële deepfakes te herkennen en te voorkomen dat cyberbedreigingen de organisatie binnenkomen.

Regelmatige simulatieoefeningen kunnen deze paraatheid versterken door neppogingen tot stemfraude te gebruiken om reactieprocedures te testen en te verfijnen.

Geavanceerde AI-oplossingen voor stemdetectie

Traditionele verdedigingsmechanismen zijn gebouwd voor netwerkgebaseerde bedreigingen, niet voor AI-gebaseerde menselijke imitatie.

De belangrijkste redenen waarom standaard cyberbeveiligingstools spraakgebaseerde social engineering niet kunnen aanpakken:

- Geen malware-handtekening: Spraakoproepen triggeren traditionele beveiligingssystemen niet

- Menselijke vertrouwensfactor: Mensen vertrouwen van nature op wat ze horen, vooral bekende stemmen

- Hiaten in detectietechnologie: Ondanks de toename van AI-gestuurde fraudepogingen, waaronder deepfakes, heeft slechts 22% van de financiële instellingen AI-gebaseerde fraudepreventietools geïmplementeerd.

De behoefte aan gespecialiseerde stemdetectie

Moderne spraakfraude vereist moderne detectiemogelijkheden.

Ondernemingsklasse AI-spraakdetectiesystemen kan:

- Vocale biomarkers analyseren: Subtiele inconsistenties in synthetische spraak detecteren

- Real-time verwerking: Direct waarschuwen bij verdachte oproepen

- Voortdurend leren: Aanpassen aan nieuwe spraaksynthesetechnieken

- Klaar voor integratie: Werken met bestaande communicatie-infrastructuur

Organisaties die zich serieus willen beschermen tegen stemfraude moeten investeren in speciaal ontwikkelde AI-detectietechnologie die de geavanceerdheid van de bedreigingen waar ze mee te maken hebben kan evenaren.

Spraakfraude is er nu, en het escaleert

In het eerste kwartaal van 2025 veroorzaakten deepfake fraude en identiteitsdiefstal meer dan $200 miljoen aan verliezen.

Voice phishing met AI-klonen steeg met 442% en meer dan 400 bedrijven per dag worden getroffen door deepfake CEO- of CFO-fraude.

Hoewel 56% van de bedrijven zegt veel vertrouwen te hebben in het herkennen van deepfakes, heeft slechts 6% daadwerkelijk financiële verliezen voorkomen.

Het gaat er niet om of jouw organisatie het doelwit wordt, maar of je er klaar voor bent.

Spraakfraude verandert het gezicht van cyberbeveiliging. Traditionele verdedigingen kunnen de AI-gestuurde imitatie niet bijhouden.

Om beschermd te blijven, hebben organisaties betere detectietools, sterke trainingsprogramma's en duidelijke verificatieprocedures nodig.

De technologie om terug te vechten is er al. De echte vraag is of je het zal gebruiken voor je eerste stemfraude-incident of erna.