Forsikringssvindel er på vei inn i en ny æra drevet av kunstig intelligens. Både sofistikerte svindelringer og enslige svindlere utnytter generative AI-verktøy til å produsere falske krav, syntetiske identiteter, forfalskede bevis og svært overbevisende etterligningssvindel. Dette whitepaperet tar for seg de nyeste trendene innen AI-drevet forsikringssvindel i 2025 - fra AI-genererte krav og dokumenter til svindel med falske stemmer - og skisserer hvordan forsikringsselskapene kan reagere. Vi presenterer ferske data, eksempler fra den virkelige verden og strategisk innsikt for underwritere, svindeletterforskere, cybersikkerhetsteam, skadebehandlere og toppledere som trenger å forstå dette raskt utviklende trusselbildet.

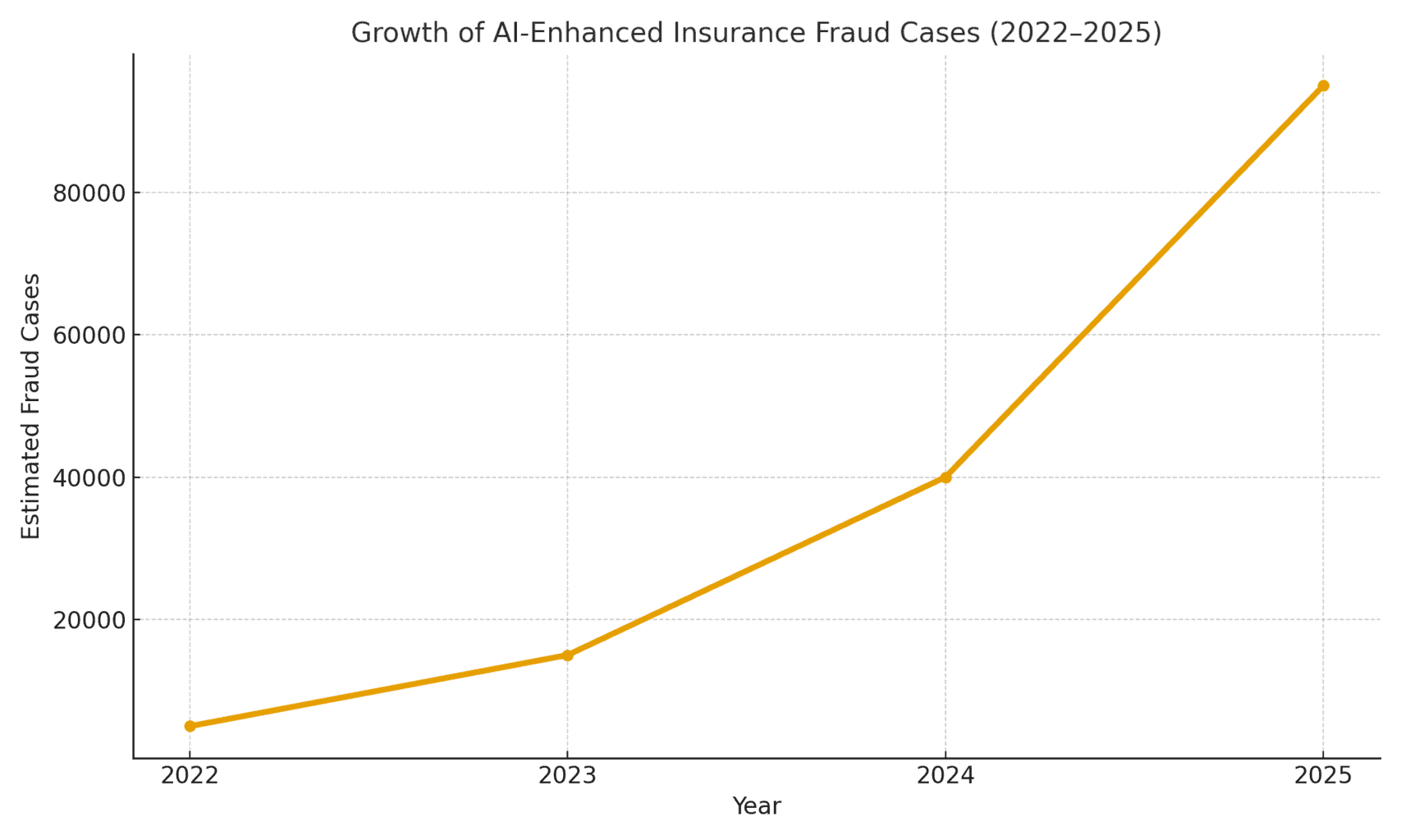

Trusselens omfang: Svindel muliggjort av kunstig intelligens øker kraftig. En rapport fra 2025 om rettsmedisinsk regnskap fant at AI-drevne svindelforsøk står nå for over halvparten av all digital økonomisk svindel[1]. I forsikringsbransjen observerte stemmesikkerhetsselskapet Pindrop en 475% økning i syntetiske stemmeangrep mot forsikringsselskaper i 2024, noe som bidro til en økning på 19% i antall forsøk på forsikringssvindel sammenlignet med året før[2]. Forsikringsselskapene står overfor omtrent 20 ganger høyere svindelrisiko enn bankerblant annet på grunn av den store avhengigheten av dokumenter, bilder og stemmebekreftelser i erstatningssaker[3]. Figur 1 nedenfor illustrerer den eksplosive veksten av AI-forsterket forsikringssvindel fra 2022 til 2025, ettersom flere bransjerapporter har indikert tre- eller firesifrede prosentvise økninger fra år til år i oppdagede AI-relaterte svindeltilfeller.

Figur 1: Rask økning av AI-forbedrede forsikringssvindeltilfeller (indeksert vekst 2022-2025). Bransjedata indikerer en eksponentiell økning i AI-generert innhold i falske krav, spesielt siden 2023.[4][2]

AI-genererte påstander og falske bevis

En av de mest utbredte trendene er bruken av generativ AI for å skape fullstendig fabrikkerte forsikringskrav. Med avanserte AI-tekstgeneratorer kan svindlere skrive realistiske hendelsesbeskrivelser, medisinske rapporter eller politiforklaringer ved å klikke på en knapp. Disse AI-tekstene fremstår ofte som polerte og troverdige, noe som gjør det vanskeligere for takstmenn å oppdage uoverensstemmelser. Svindlere har for eksempel brukt ChatGPT til å utarbeide detaljerte ulykkesbeskrivelser eller skaderapporter som høres profesjonelle og overbevisende ut - en oppgave som tidligere krevde betydelig innsats og skriveferdigheter.

Mer bekymringsfullt er det at kriminelle nå kobler disse falske fortellingene med AI-genererte støttende bevis. Bildegenereringsmodeller (som Midjourney eller DALL-E) og redigeringsverktøy kan produsere fotorealistiske bilder av skader og personskader. Ifølge rapporter fra bransjen har enkelte sjåfører begynt å sende inn AI-genererte bilder for å overdrive skadene på kjøretøyet i bilskader[5]. Generativ kunstig intelligens kan skape et bilde av et bilvrak eller et oversvømt hjem som aldri har eksistert. Disse bildene er ofte mer realistisk enn hva eldre Photoshop-teknikker kunne oppnå[6]noe som gjør dem vanskelige å oppdage med det blotte øye. I april 2025 noterte Zurich Insurance en økning i antall skader med forfalskede fakturaer, fabrikkerte reparasjonsoverslag og digitalt endrede bilder, inkludert tilfeller der registreringsnumre ble AI-innsatt på bilder av vrakede biler[7][8]. Slike falske bevis, kombinert med et godt utformet AI-skjema, kan slippe forbi manuelle gjennomganger.

I et oppsiktsvekkende tilfelle i Storbritannia tok svindlere en bilde av en håndverkerbil på sosiale medier, og bruker AI til å legge til en sprukket støtfangerog deretter sende den inn sammen med en falsk reparasjonsfaktura på 1 000 pund som en del av et falskt krasjkrav[9]. Svindelen ble først avdekket da etterforskerne la merke til samme bilde av varebilen (før skaden) på eierens Facebook-side[10]. Dette illustrerer et mer generelt fenomen: Forsikringsselskapene rapporterer en 300% hopp i "shallowfake" bilderedigeringer (enkle digitale manipulasjoner for å legge til skader eller endre detaljer) på bare ett år (2021-2022 vs 2022-2023)[4]. Allianz UK advarte i 2024 om at digitale bildeforvrengninger og falske dokumenter hadde "alle tegn på å bli den siste store svindelen som rammet bransjen"[4]. Zurichs leder for skadesvindel bemerket likeledes at det som tidligere krevde en fysisk bilulykke, kan nå gjøres helt og holdent bak en datamaskin - Svindlere kan "opprette et bedragersk krav bak tastaturet og hente ut betydelige summer" med falske totalskadebilder og -rapporter[11][12]. Dette skiftet øker ikke bare volumet av falske krav, men senker også inngangsbarrieren for potensielle svindlere.

Aldri bekymre deg for AI-svindel igjen. TruthScan Kan hjelpe deg:

- Oppdage AI generert bilder, tekst, tale og video.

- Unngå stor AI-drevet svindel.

- Beskytt dine mest følsom virksomhetens eiendeler.

Utover biler, skader på eiendom og havari ser AI-assistert inflasjon av tap. Det rapporteres om falske bilder for reiseforsikring (f.eks. "skader" på bagasjen eller iscenesatte tyveriscener) og AI-genererte kvitteringer for dyre varer som aldri ble kjøpt. Livs- og helsekrav er heller ikke immune - svindlere har generert falske legeregninger og dødsattester ved hjelp av AI-dokumentforfalskere. Zurich har faktisk registrert at deepfake-teknologi brukes til å skape helt fiktive ingeniørvurderinger og medisinske rapporter i skadepakker[11]. Disse AI-genererte dokumentene, ofte med realistiske logoer og signaturer, kan være umulig å skille fra ekte papirer. En ny bekymring for livsforsikringsselskapene er svindel med dødsannonser og dødsattester: Kriminelle kan bruke kunstig intelligens til å produsere falske nekrologer eller legeerklæringer for å underbygge et dødskrav for en person som faktisk fortsatt er i live (eller som aldri har eksistert, som vi skal se nærmere på i neste avsnitt).

Syntetiske forsikringstakere og identiteter

Den kanskje mest lumske utviklingen er svindel med syntetisk identitet i forsikring. Syntetisk identitetssvindel innebærer å skape en fiktiv person eller enhet ved å kombinere reelle data (stjålne personnummer, adresser osv.) med fabrikkerte detaljer (falske navn, falske ID-dokumenter). Fremskritt innen kunstig intelligens har gjort det trivielt enkelt å generere realistiske personprofiler - inkludert bilder og ID-er - for personer som ikke finnes[13][14]. Svindlere kan nå algoritmisk produsere en helt falsk kunde, kjøpe en forsikring i deres navn og senere sette opp krav eller forsikringsytelser for den falske identiteten.

I livsforsikringssektoren har ordninger med syntetisk identitet skutt i været. Bransjeforskning i 2025 anslår at syntetisk identitetssvindel koster over $30 milliarder kroner årligog står for så mye som 80-85% av alle identitetsbedragerisaker på tvers av finansielle tjenester[15][16]. Livsforsikringsselskapene har blitt spesielt hardt rammet: Svindlere har vært kjent for å tegne livsforsikringspoliser for en fiktiv person og deretter "drepe" personen på papiret for å få utbetalt dødsfallssummen[17]. En svindler kan for eksempel opprette en syntetisk kunde "John Doe", betale premie i ett år og deretter sende inn et krav med en falsk dødsattest og dødsannonse for John Does alt for tidlige bortgang. Fordi identiteten er bygget opp med omhu (kreditthistorikk, offentlige registre osv.), kan dødsfallet se legitimt ut - helt til det ikke finnes noe lik eller noen ekte slektninger. Når svindelen blir oppdaget, er gjerningsmennene for lengst borte med utbetalingen.

Syntetiske identitetsordninger plager også helseforsikring og bilforsikring. Kriminelle nettverk skaper "Frankenstein"-identiteter ved å bruk av barns eller eldre personers personnummer (som ikke har noen kreditthistorikk) kombinert med AI-genererte navn og førerkort[15]. Deretter kjøpe helseforsikringer eller bilforsikringer for disse falske personene, og kort tid etter sende inn store krav. En variant er syndikater som etablerer falske virksomheter (skallselskaper) - for eksempel et fiktivt lastebilselskap - og kjøper forsikring for det, bare for senere å gjøre krav på grunn av iscenesatte ulykker eller fiktive skader på ansatte[18][19]. Fordi virksomheten bare eksisterer på papiret (med AI-genererte virksomhetsregistreringer og skatte-ID-er), er dette "Entitetsbasert" syntetisk svindel ofte ikke avdekkes før etter at erstatningene er utbetalt[18][20].

Hvorfor er syntetiske identiteter så effektive? For det første går de ofte gjennom automatiserte identitetsverifiseringskontroller. Kredittbyråer og KYC-systemer kan finne ingen røde flagg fordi identiteten inneholder noen reelle, gyldige data (f.eks. et ekte SSN med et rent rulleblad)[21]. I mellomtiden kan AI-genererte profilbilder og ID-skanninger se helt autentiske ut - dagens AI kan produsere et menneskeansikt som til og med avansert ansiktsgjenkjenning kan akseptere som ekte. Resultatet av dette: de fleste automatiserte systemer gjenkjenner disse profilene som legitime og svindelen oppdages først (om i det hele tatt) etter store tap[22].

Virkning i den virkelige verden: RGA rapporterer at Syntetisk identitetssvindel i livsforsikringsbransjen koster nå bransjen rundt $30 milliarder per år og har vokst med nesten 400% siden 2020[15][16]. Den amerikanske Federal Trade Commission anslår at syntetiske ID-er utgjør det store flertallet av identitetssvindeltilfellene[16]. Disse tapene rammer til syvende og sist de ærlige forsikringstakernes lommebøker - hver familie betaler anslagsvis \$700 ekstra i premie hvert år på grunn av den større svindelbelastningen på forsikringsselskapene[15]. Forsikringsselskapene reagerer ved å styrke verifiseringen ved onboarding og skadebehandling: de implementerer databasesjekker for identitetskobling, overvåker om det er flere poliser på samme adresse og kjører til og med "liveness"-tester (selfie-videokontroller for å sikre at en erstatningssøker er en ekte person, ikke bare et AI-bilde).[23][24]. Men som vi skal se, kontrer svindlerne med kunstig intelligens på den neste arenaen: falske stemmer og videoer.

Deepfake-stemmer og videopåstander

AI-generert deepfakes av lyd og video gir forsikringssvindel en ny, alarmerende dimensjon. I 2023 og 2024 var det flere tilfeller av kriminelle som brukte stemmekloning å utgi seg for å være enkeltpersoner over telefon - en taktikk som opprinnelig ble brukt i forbindelse med bankran (som den beryktede deepfake CEO-telefonsamtalen som stjal $35 millioner i 2020), men som nå sprer seg til forsikring. Svindlere kloner stemmene til forsikringstakere, leger eller skaderegulatorer og bruker dem i sosialtekniske svindelforsøk. Pindrops analyse fra 2024 advarte om at "deepfakes, syntetisk stemmeteknologi og AI-drevet svindel er i ferd med å omforme svindellandskapet", med stemmesvindel skalering i et tempo uten sidestykke[25]. De fant ut at forsikringssentrene ble bombardert av utenlandske aktører som brukte stemmeforfalskninger: For eksempel kunne det komme inn samtaler med en ekte forsikringstakers stjålne SSN og personlige data, og hvis en agent svarte, ble innringerens AI-klonede stemme kan lure agenten gjennom kunnskapsbasert autentisering og be om en uredelig utbetaling[26]. Hos et forsikringsselskap på vestkysten brukte angriperne gjentatte ganger denne metoden for å prøve å overta kontoer og omdirigere utbetalinger, og utnyttet det faktum at ID-verifiseringen på kundesenteret baserte seg på stemme- og personopplysninger som kan forfalskes[26].

Stemmeimitasjon har også blitt brukt på forbrukersiden: Svindlere har ringt til ulykkesofre eller begunstigede mens utgir seg for å være forsikringsrepresentanterDe bruker AI-stemmer for å høres offisielle ut, for å lure til seg sensitiv informasjon eller til og med betalinger. Omvendt kan en svindler utgi seg for å være en kunde på en skadetelefon for å sende inn et krav via telefon ved hjelp av en falsk stemme som stemmer overens med kundens kjønn/alderog dermed omgå stemmebiometriske kontroller. Nyere svindelstatistikk er tankevekkende: Bransjeeksperter anslår at 162% vekst i deepfake-angrep mot forsikringsselskaper i det kommende året[27], og Pindrop spilte inn en 475% økning i syntetiske stemmeangrep i 2024 som nevnt tidligere[2]. Disse angrepene er i ferd med å utkonkurrere mer tradisjonelle former for nettsvindel.

Utover telefonsamtaler, videobaserte deepfakes er i ferd med å dukke opp i skadeprosessen. Mange forsikringsselskaper har tatt i bruk virtuelle skadeinspeksjoner og videokonferanser (fremskyndet av pandemien) for å verifisere tap eller intervjue erstatningssøkere på avstand. Nå er svindlere i ferd med å utnytter AI-avatarer og deepfake-videoer for å lure disse verifiseringene. Det har blitt rapportert om kravstillere som bruker AI-genererte avatarer i direktesendte videosamtaler med justeringsmenn, for å utgi seg for å være noen andre eller for å skjule tegn på inkonsekvens[28]. For eksempel kan en svindelring bruke en deepfake "live"-video av en antatt skadelidt som viser skadene sine via smarttelefonnår personen på kameraet i virkeligheten er en AI-syntetisert kompositt eller en innleid skuespiller med ansiktsendrende filtre. Et spekulativt, men plausibelt scenario er å bruke en deepfake av en avdøde person: I et livrente- eller livsforsikringssvindeltilfelle kan et familiemedlem bruke en deepfake-video av den nylig avdøde under en rutinemessig livsforsikringssamtale for å fortsette å motta utbetalinger[29]. Selv om ingen høyprofilerte saker av denne typen har blitt offentliggjort ennå, er forsikringsselskapene forberedt på det. Tilsynsmyndighetene merker seg også - Det pågår diskusjoner i USA og Europa om å klassifisere deepfakes som identitetstyveri og oppdatere retningslinjene for bevisverifisering i forsikringssaker.[30].

Det er svært utfordrende å oppdage falske videoer og lyd uten tekniske verktøy. Menneskelige saksbehandlere er ikke opplært til å oppdage subtile leppesynkroniseringsproblemer eller akustiske rariteter. I noen tilfeller har det imidlertid vært røde flagg: for eksempel unaturlig blunking eller ansiktsflimmer på video, eller bakgrunnslydartefakter i en samtale som tipset etterforskerne. Men alt i alt, deepfake forsikringssvindel er fortsatt i en tidlig faseog rettsforfølgelse er fortsatt sjelden - i 2023 var de juridiske definisjonene uklare, og det var vanskelig å bevise at en video var AI-generert uten ekspertanalyse[31]. Dette gir svindlerne en følelse av straffefrihet. Våpenkappløpet er i gang: Forsikringsselskapene vender seg nå til rettsmedisinsk AI for å bekjempe AI, som bruker deepfake-deteksjonsalgoritmer for å granske mistenkelige videoer bilde for bilde for å se etter tegn på manipulasjon[24]. Leverandører av stemmebiometri lanserer detektorer for falske stemmer som analyserer spektrale mønstre og stemmekadence for å fastslå autentisitet[32]. Vi kommer tilbake til disse defensive teknologiene i et senere avsnitt.

AI-forbedret phishing og svindel med falske identiteter

Ikke alle AI-aktiverte svindelforsøk kommer gjennom skadeavdelingen; noen mål er kunder og ansatte via sosial manipulering. Phishing-e-poster og -meldinger utformet av kunstig intelligens har blitt en stor trussel på forsikringsområdet. Svindlerne bruker AI-chatboter og oversettelsesverktøy til å generere svært overbevisende svindelkommunikasjon. For eksempel kan kriminelle utgi seg for å være et forsikringsselskaps merkevare og skrivestil for å sende ut masse-phishing-e-poster til forsikringstakere med beskjed om at "det haster med å gjøre noe for å forhindre kansellering av forsikringen" og henvise dem til en falsk nettside. I motsetning til tidligere tiders klønete svindel-e-poster, AI sørger for upåklagelig grammatikk og til og med personaliseringog gjør dem langt mer troverdige. Vi har sett at kunstig intelligens brukes til å skrape sosiale medier for å finne detaljer som blir flettet inn i spear-phishing-meldinger, for eksempel ved å henvise til et nylig bilkjøp i en falsk bilforsikringsmelding.

En annen vektor er AI-støttet etterligning av agenter eller ledere. Det har forekommet tilfeller der svindlere har klonet stemmen til eieren av et forsikringsbyrå og lagt igjen talemeldinger til kunder der de ber om oppdateringer av bankinformasjon - i praksis et phishing-angrep. På samme måte kan interne svindelforsøk skyldes etterligning av kunstig intelligens: Et forsikringsselskaps finansavdeling var nær ved å bli offer da svindlere sendte en deepfake-lydmelding angivelig fra administrerende direktør autorisere en pengeoverføring (en variant av "CEO fraud" som nå dekkes av enkelte e-kriminalitetsforsikringer)[33]). Denne typen AI-drevet etterligningssvindel økte 17% i 2023 ifølge Liberty Specialty Markets[33]og forventes å fortsette å stige.

Forbrukerne blir også utsatt for svindelforsøk med syntetiske medier knyttet til forsikring. Coalition Against Insurance Fraud viser til tilfeller der svindlere utgir seg for å være forsikringsagenter, kontakter ulykkesofre og påstår at de håndterer kravet deres, for så å krever umiddelbar betaling eller sensitive opplysninger[23]. Intetanende kunder, som er lettet over å høre fra en antatt representant, kan føye seg, særlig hvis innringeren kjenner til detaljer om ulykken (som AI kan få tak i fra hacking eller offentlige kilder). Offentligheten er lite bevisst på denne taktikken, og eksperter på forebygging av svindel oppfordrer derfor forsikringsselskapene til å informere forsikringstakere om hvordan de kan verifisere identiteten til innringere og e-poster[23][34]. På samme måte som bankene advarer kundene mot phishing, begynner forsikringsselskapene i 2025 å inkludere advarsler om deepfake-svindel i sin kommunikasjon.

En fellesnevner for disse AI-forbedrede svindelforsøkene er bruken av lett tilgjengelige "fraud-as-a-service"-pakker[35]. På det mørke nettet kan kriminelle kjøpe eller abonnere på verktøy som tilbyr ferdiglagde deepfake-stemmer, falske dokumentmaler, phishing-e-postgeneratorer og mer. Denne demokratiseringen av AI-verktøy betyr Selv svindlere med lav kompetanse kan utføre sofistikerte svindelangrep[35]. For forsikringsselskapene betyr dette en flom av mer overbevisende svindelforsøk som kommer fra alle kanter - krav, kundeservice, e-post og til og med sosiale medier. Det understreker behovet for en flerstrenget forsvarsstrategi som kombinerer teknologi, menneskelig årvåkenhet og samarbeid på tvers av bransjer.

Oppdagelse og forsvar: En AI-drevet respons

Bekjempelse av AI-drevet svindel krever AI-drevet forsvar. Forsikringsselskapene vender seg i økende grad til avanserte deteksjonsteknologier og moderniserte prosesser for å motvirke angrepet. I hovedsak må forsikringsselskapene bygge inn kontrollpunkter for innholdsautentisering gjennom hele forsikringens livssyklus - fra forsikringstegning til skadebehandling og kundeinteraksjoner - for å avsløre AI-svindel. Figur 2 gir en oversikt over de viktigste svindeltypene som muliggjøres av kunstig intelligens, og hvor utbredt de er, og i de følgende avsnittene beskrives det hvordan hver enkelt svindeltype kan oppdages og forebygges.

Figur 2: Typer AI-forbedret forsikringssvindel i 2025 (estimert andel per ordning). Falske bilder (manipulerte bilder av skader) og syntetiske identiteter er blant de største kategoriene, etterfulgt av AI-forfalskede dokumenter (f.eks. kvitteringer, sertifikater) og deepfake audio-/videosvindel.

1. AI-verktøy for innholdsdeteksjon: Nye tjenester for AI-deteksjon kan analysere tekst, bilder, lyd og video for å finne ut om de er maskingenererte eller manipulerte. Forsikringsselskaper kan for eksempel utnytte løsninger som TruthScans AI-tekst- og bildedetektorer som bruker 99%+ nøyaktig AI til å flagge AI-skrevne dokumenter eller manipulerte bilder[36]. Et forsikringsselskap kan integrere disse detektorene i skadesystemet sitt: Når et krav og tilhørende bevis sendes inn, kan tekstbeskrivelsen automatisk skannes for AI-genererte språkmønstre, og alle opplastede bilder kan skannes for tegn på CGI eller redigering. Verktøy på bedriftsnivå kan identifisere AI-generert tekst i dokumenter, e-post og kommunikasjon med 99% nøyaktighet[36], og på samme måte oppdage AI-genererte eller manipulerte bilder for å sikre at det visuelle innholdet er autentisk[36]. Dette betyr at en falsk ulykkesfortelling produsert av ChatGPT eller et forfalsket skadebilde midt på reisen vil bli flagget for manuell gjennomgang før kravet blir behandlet. I 2025 tar forsikringsselskapene i økende grad i bruk slik AI-autentisering av innhold - faktisk, 83% av de som jobber med svindelbekjempelse, planlegger å integrere generativ AI-deteksjon innen 2025ifølge en ACFE-undersøkelse, opp fra bare 18% som bruker det i dag[37][38].

2. Identitetsbekreftelse og biometriske kontroller: For å håndtere syntetiske identiteter forbedrer forsikringsselskapene også KYC-protokollene med kunstig intelligens. Identitetsvalideringstjenester kan kryssverifisere søkerdata mot flere databaser og bruke ansiktsgjenkjenning med livlighetstester. Hvis man for eksempel krever en kort video-selfie under onboarding (og bruker ansiktsmatching med den oppgitte ID-en), kan det hindre mange syntetiske ID-er. Selskaper som TruthScan tilbyr enda mer høyteknologisk bildeanalyse som kan få øye på AI-genererte profilbilder, avatarer og syntetiske personbilder - AI-bildedetektoren deres er opplært til å identifisere ansikter laget av generatorer som StyleGAN eller ThisPersonDoesNotExist[39]. Ved å ta i bruk slike verktøy kan et forsikringsselskap oppdage om en livsforsikringssøkers selfie ikke er et ekte menneske. På stemmesiden, stemmebiometrisk autentisering for kundeservicesamtaler kan være til hjelp; moderne stemme-AI-detektorer er i stand til å identifisere syntetiske stemmer og forsøk på stemmekloning i sanntid[40]. For eksempel kan TruthScans AI-stemmeregistrering systemet bruker akustisk analyse for å gjenkjenne AI-genererte stemmer og lydforfalskninger før de lurer de ansatte på kundesenteret[40]. Disse løsningene fungerer som en brannmur - hvis noen ringer og utgir seg for å være NN og stemmeavtrykket ikke stemmer overens med NNs autentiske stemme (eller samsvarer med kjente deepfake-egenskaper), kan samtalen flagges eller ytterligere identitetsbevis kreves. Flerfaktorautentisering (e-post/SMS-bekreftelse, engangskoder osv.) gjør det enda vanskeligere for etterlignerne å overvinne hindringene.

3. Deepfake Video & Image Forensics: Når det gjelder videobevis, har forsikringsselskapene begynt å ta i bruk spesialisert kriminalteknisk analyse. Avansert programvare kan analysere videometadata, bildekonsistens og feilnivåer for å avdekke "deepfakes". Noen verktøy undersøker refleksjoner, skygger og fysiologiske tegn (som puls i halsen på en person på video) for å sikre at en video er ekte. Kriminaltekniske metadata er også verdifullt: Ved å undersøke filmetadata og generasjonsavtrykk i bilder eller PDF-filer kan man finne ut om noe sannsynligvis er produsert av et AI-verktøy[41]. Forsikringsselskapene bør for eksempel kreve originale bildefiler (som inneholder metadata) i stedet for bare skjermdumper eller utskrevne kopier. Zurichs svindelteam har hatt suksess med å avsløre falske bilbilder ved å legge merke til avvik i bildets metadata og analyse av feilnivå[41]. Detektorer for e-postsvindel kan også skanne innkommende kommunikasjon etter tegn på AI-skrevet phishing-innhold eller kjente ondsinnede signaturer[42]. Mange forsikringsselskaper kjører nå phishing-simuleringer og AI-skapte svindeleksempler i opplæringen av ansatte for å øke bevisstheten.

4. Prosessendringer og menneskelig opplæring: Teknologi alene er ingen mirakelkur. Forbedringer i prosessen Det gjøres stadig flere tilfeldige, personlige stikkprøver av krav med høy verdi, eller det kreves fysisk dokumentasjon i visse tilfeller. Noen forsikringsselskaper har utsatt helautomatisk behandling av erstatningskrav, og gjeninnfører menneskelig gjennomgang av krav som scorer høyt på en risikomodell for AI-svindel. På den menneskelige siden er opplæring avgjørende. Svindeletterforskere og takstmenn læres opp til å gjenkjenne AI-varslingsflagg: f.eks. flere krav med identisk ordlyd (ChatGPT-stil), bilder som ikke er helt tilfeldige (f.eks. gjentatte mønstre i noe som burde være organiske skader), eller stemmer som høres ut som nesten rett, men har en robotisert rytme. Forsikringsselskapene informerer også kundene: De sender ut svindelvarsler om deepfake-metoder og gir råd om hvordan man kan verifisere identiteten til en forsikringsrepresentant (for eksempel ved å oppgi et kjent tilbakeringingsnummer).

5. Samarbeidende innsats: Samarbeidet i bransjen er i ferd med å øke. I Storbritannia har Insurance Fraud Bureau og Association of British Insurers dannet arbeidsgrupper om AI-svindel, og regjeringens Charter for forsikringssvindel (2024) fremmer deling av data og felles initiativer[43]. Globalt samarbeider forsikringsselskaper med cybersikkerhetsfirmaer og oppstartsbedrifter innen kunstig intelligens. Det dukker også opp nye forsikringsprodukter: Liberty Mutual lanserte en e-kriminalitetsforsikring for små og mellomstore bedrifter som spesifikt dekker deepfake-svindel og CEO-svindel[44][33]og understreker at denne risikoen er høyst reell. Dette betyr også at forsikringsselskapene kan bli både ofre for og oppklarere av AI-svindel - de kan utbetale for en deepfake-svindel hvis den ikke blir oppdaget, men også tilby dekning for andre som blir utsatt for slike angrep.

Integreringen av deteksjonsteknologi i arbeidsflyten kan visualiseres som et flerpunktsforsvar i kravets livssyklus. Som vist i Figur 3kan forsikringsselskapene legge inn AI-verifiseringstrinn på politisk anvendelse (for å avdekke syntetiske identiteter via ID-dokumenter og selfie-kontroller), på innsending av krav (for automatisk analyse av opplastede dokumenter, bilder eller lyd for AI-generering), under gjennomgang/etterforskning av krav (for å utføre deepfake-analyse på mistenkelige bevis og verifisere eventuelle stemmeinteraksjoner), og rett før utbetaling (en siste identitetsautentisering for å sikre at betalingsmottakeren er legitim). Ved å oppdage svindel tidlig - ideelt sett allerede ved oppstart eller ved første skademelding - sparer forsikringsselskapene etterforskningskostnader og unngår urettmessige utbetalinger.

Figur 3: Integrering av AI-deteksjonspunkter i forsikringens livssyklus. Ved tegning av forsikring sjekker AI-basert identitetsvalidering om det finnes syntetiske eller falske identiteter. Når et krav sendes inn, skanner automatiserte detektorer kravtekst, dokumenter og bilder for AI-generert innhold. Under gjennomgangen av krav verifiserer spesialiserte verktøy for deepfake- og stemmeanalyse eventuelle lyd- og videobevis. Før utbetaling bekrefter biometrisk identitetsverifisering mottakerens identitet. Denne flerlagstilnærmingen bidrar til å fange opp svindel på flere stadier.

Forsikringsselskapene trenger ikke å bygge opp alle disse funksjonene internt - mange benytter seg av bedriftsløsninger som TruthScans AI-deteksjonssuitesom tilbyr en rekke verktøy som kan API-integreres i forsikringsselskapenes systemer. For eksempel TruthScans AI-tjeneste for bilde- og Deepfake-deteksjon kan brukes til å verifisere autentisiteten til bilder og videoer med over 99% nøyaktighet[45]. Deres AI-tekstdetektor flagger AI-tekst i krav eller e-poster[36], mens AI Voice Detector Oppdager stemmekloning og verifiserer høyttaleren for å stoppe telefonbedragerier[40]. Det finnes til og med nisjeverktøy som en Detektor for falske kvitteringer for å umiddelbart analysere fakturaer/kvitteringer for tegn på manipulering eller AI-genererte fonter/oppsett[46] - ekstremt nyttig med tanke på forekomsten av falske reparasjonsregninger i skademeldinger. Ved å ta i bruk en kombinasjon av disse verktøyene kan et forsikringsselskap drastisk forbedre oppdagelsesraten for svindel. Et Fortune 500-forsikringsselskap rapporterte at de fanget opp 97% av deepfake-forsøk i 2024 ved å bruke en lagdelt AI-screeningmetode (tekst, bilde, tale) og dermed unngå tap på anslagsvis \$20 millioner kroner[47][48].

Konklusjon

Kunstig intelligens er i ferd med å forandre slagmarken for forsikringssvindel på global skala. Svindlere bruker generativ kunstig intelligens til å skape løgner som er mer overbevisende enn noensinne - fra helt oppdiktete personer og ulykker til etterligninger som kan lure selv erfarne fagfolk. Dataene fra 2024-2025 viser en alarmerende vekst i disse AI-drevne svindelforsøkene, men de viser også at forsikringsselskaper som investerer i oppdagelse og forebygging, kan ligge et skritt foran. Ved å kombinere banebrytende AI-deteksjonsteknologi - som bildeetterforskning, stemmeautentisering og tekstanalyse - med oppdaterte arbeidsflyter og opplæring kan bransjen redusere risikoen uten å ofre effektiviteten som digitale prosesser fører med seg.

I bunn og grunn er dette et teknologisk våpenkappløp[49]. Som en ekspert på forebygging av svindel bemerket, "I denne nye virkeligheten er årvåkenhet den premien som må betales"[50]. Forsikringsselskapene må fremme en kultur preget av årvåkenhet og ta i bruk de beste tilgjengelige verktøyene for å bevare tilliten til skadebehandlingsprosessen. Det betyr å verifisere sannhetsgehalten i dokumenter, stemmer og bilder med samme strenghet som forsikringsselskapene bruker for å vurdere risiko. Det betyr også at vi må samarbeide på tvers av bransjen for å dele informasjon om nye AI-svindelmetoder og utvikle standarder i fellesskap (for eksempel standard metadatakrav for innsendte medier eller svartelister over kjente falske identiteter).

2025 er et vendepunkt: forsikringsselskapene som proaktiv tilpasning til AI-drevet svindel vil beskytte kundene og balansen, mens de som er trege til å reagere, kan bli utsatt for svindelforsøk som skaper store overskrifter. Den oppmuntrende nyheten er at teknologien som gjør det mulig å slå tilbake, finnes og modnes raskt - den samme kunstige intelligensen som svindlerne bruker, kan også brukes av forsikringsselskapene. Ved å implementere løsninger som TruthScans multimodale AI-deteksjonspakke for krav og identitetsverifisering, kan forsikringsselskapene dramatisk redusere suksessraten for AI-genererte svindelforsøk[51][52]. På den måten forhindrer de ikke bare tap, men sender også en klar beskjed til potensielle svindlere: Uansett hvor smarte verktøyene er, så er det ikke noe problem, svindel vil bli avdekket.

For å oppsummere: AI-drevet forsikringssvindel er en formidabel utfordring, men den kan møtes med et like intelligent forsvar. Med årvåkenhet, en tverrfunksjonell strategi og de rette teknologipartnerne kan forsikringsbransjen fortsette å opprettholde det grunnleggende løftet som er kjernen i virksomheten - å kun utbetale legitime krav, og å gjøre det raskt og sikkert i en stadig mer digital verden.

Referanser:

- Foreningen av britiske forsikringsselskaper - Svindelstatistikk 2023[53][54]

- Allianz og Zurich om AI-"overfladisk forfalskning" av erstatningskrav The Guardian, 2024[4][11]

- Facia.ai - "Deepfake forsikringssvindel: Hvordan kunstig intelligens omskriver reglene" Oktober 2025[55][56]

- Koalisjonen mot forsikringssvindel - Syntetisk svindel i forsikring (Quantexa), Desember 2024[21][17]

- RGA - "Svindelbekjempelsens nye grense: Syntetiske identiteter", "Fraud Fight's New Frontier: Synthetic Identities" Juni 2025[15][16]

- Pindrop - Rapport om stemmesvindel, via FierceHealthcare, juni 2025[2][3]

- Turning Numbers - "De største økonomiske svindelplanene 2025" Oktober 2025[1][57]

- TruthScan - AI Detection Platform (oversikt over tjenester), 2025[51][52]

- TruthScan - AI Image Detector produktside, 2025[45][39]

- TruthScan - AI Voice Detector produktside, 2025[40]

- TruthScan - Produktside for falsk kvitteringsdetektor, 2025[46]

- Liberty Spesialmarkeder Pressemelding fra Deepfake/Cyber Fraud Insurance, Mars 2025[33]

- Facia.ai - Blogg: Våpenkappløp om forebygging av forsikringssvindel, 2025[24][32]

- Forsikringsvirksomhet i Storbritannia - "AI-genererte bilder brukt til motorsvindel" Apr 2025[7][58]

- The Guardian - "Falske bilder av bilskader skremmer forsikringsselskapene" Mai 2024[9][12]

[1] [35] [57] 2025 Finansielle svindelforsøk: AI-trusler og røde flagg

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Forsikringssvindel økte med 19% fra stemmeangrep i 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Svindlere redigerer bilbilder for å legge til falske skader i britisk forsikringssvindel | Forsikringsbransjen | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] AI-genererte bilder brukes nå til svindel med bilforsikring - rapport | Insurance Business UK

[13] [14] [15] [16] Svindelbekjempelsens nye grense: Syntetiske identiteter og et AI-våpenkappløp | RGA

[17] [18] [19] [20] [21] [22] JIFA: Syntetisk svindel: Med syntetisk svindel allerede i økosystemet, må forsikringsselskapene tenke mer som bankene - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Deepfake forsikringssvindel: Hvordan AI omskriver reglene for forsikringskrav

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Den tause trusselen: Hvorfor forsikringssvindel flytter til telefonlinjen

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] E-kriminalitetsforsikring for små og mellomstore bedrifter rettet mot CEO-svindel og deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - AI-deteksjon og innholdssikkerhet for bedrifter

[37] Studie: 8 av 10 svindelbekjempere forventer å ta i bruk generativ AI innen 2025

[38] Innsikt fra 2024-rapporten om benchmarking av teknologi for svindelbekjempelse

[39] [45] AI-bildedetektor - Finn falske og manipulerte bilder - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI-stemmedetektor for deepfakes og stemmekloning | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Fake Receipt Detector | Bekreft kvitteringens ekthet

https://truthscan.com/fake-receipt-detector

[47] Fortune 500-forsikringsselskap oppdager 97% av Deepfakes og stopper syntetisk ...