Innledning

Kunstig intelligens er i ferd med å endre det finansielle svindelbildet på en helt ny måte. Tidlig i 2024 brukte svindlere AI-genererte deepfakes til å utgi seg for å være ledere i en videosamtale - og lurte en ansatt i Hong Kong til å overføre $25 millioner til svindlerne[1][2]. Hendelser som dette viser hvordan generativ AI gjør det mulig for kriminelle å lage svært overbevisende svindelforsøk rettet mot banker og deres kunder. Tilsynsmyndigheter slår alarm: Det amerikanske finansdepartementet FinCEN utstedte i slutten av 2024 en advarsel om økende svindel ved hjelp av AI-genererte "deepfake"-medier, inkludert falske identitetsdokumenter for å omgå bankverifiseringer[3][4]. Dette whitepaperet undersøker de nyeste Trender innen AI-svindel i finansielle tjenester og diskuterer hvordan institusjonene kan styrke forsvaret sitt. Vi utforsker hvordan svindlere bruker generativ kunstig intelligens som våpen - fra falske etterligninger til syntetiske identiteter - og skisserer teknologi og strategier (inkludert avanserte deteksjonsverktøy som TruthScan) som svindelteam og ledere kan ta i bruk for å motvirke denne nye trusselen.

Viktige trender innen AI-svindel i finansielle tjenester

Skurkene utnytter kunstig intelligens og maskinlæring til å gjennomføre bedragerier i stadig større skala og på en mer sofistikert måte. Bemerkelsesverdig AI-drevne svindeltaktikker som påvirker banker, fintechs og forsikringsselskaper, inkluderer

- Deepfake-imitasjonssvindel: Kriminelle bruker AI-generert video og lyd for å utgi seg for å være betrodde personer (administrerende direktører, kunder osv.) i sanntid. For eksempel har naturtro, falske stemmer blitt brukt i vishing-angrep (voice phishing) for å godkjenne falske bankoverføringer, og AI-skapte videoer har lurt ansatte til å godkjenne falske transaksjoner[1][5]. Disse syntetiske mediene gjør det vanskelig å vite om du virkelig snakker med den personen du tror du snakker med, noe som muliggjør verdifulle tyverier som $25M deepfake-saken ovenfor. Deepfakes er i ferd med å bli rimelig og enkel å produsereDet kreves så lite som 20-30 sekunder med lyd for å klone en stemme, eller under en time for å generere en tilsynelatende autentisk video[6].

- AI-forbedret phishing og BEC: Generativ kunstig intelligens setter turbo på sosial manipulering som phishing-e-post og kompromittering av virksomhetens e-post (BEC). AI-chatboter kan skrive svært personlige svindel-e-poster på et perfekt forretningsspråk, etterligne en administrerende direktørs skrivestil eller lage overbevisende falske leverandørfakturaer i stor skala. Faktisk kan undergrunnsverktøy som SvindelGPT og WormGPT (ufiltrerte versjoner av ChatGPT) har dukket opp for å hjelpe nettkriminelle med å automatisere phishing og oppretting av skadelig programvare[7][8]. Dette betyr at en potensiell svindler med minimale ferdigheter enkelt kan generere raffinerte phishing-kampanjer eller ondsinnet kode. Med kunstig intelligens kan en enkelt kriminell sende ut tusenvis av skreddersydde svindel-e-poster eller tekstmeldinger, noe som øker rekkevidden av tradisjonelle svindelforsøk betraktelig. FBIs Internet Crime Center har allerede observert over $2,7 milliarder kroner tapt til BEC-svindel i 2022, og generativ AI truer med å øke disse tapene ytterligere i årene som kommer[9][10].

- Syntetiske identiteter og dokumentbedrageri: Generativ kunstig intelligens driver frem en boom i syntetisk identitetssvindelen av de raskest voksende formene for økonomisk kriminalitet[11][12]. Svindlere kombinerer ekte og falske personopplysninger for å skape "Frankenstein"-identiteter, og bruker deretter kunstig intelligens til å produsere realistiske underlagsdokumenter - fra falske pass og kontoutskrifter til lønnsslipper[7]. AI-bildegeneratorer og redigeringsverktøy kan smi legitimasjon og bilder som ser ekte ut som passerer en tilfeldig inspeksjon. Selv livlighetskontroller eller selfie-verifiseringer kan potensielt overvinnes ved hjelp av AI-manipulerte bilder eller videoer. Ved å automatisere opprettelsen av tusenvis av falske identiteter (hver med AI-genererte profilbilder, sosiale medier osv.) kan kriminelle åpne bankkontoer eller søke om lån en masse og hvitvaske penger eller misligholde kreditt. Tapene som følge av svindel med syntetiske identiteter ble anslått til rundt $35 milliarder kroner i 2023[13]og generativ kunstig intelligens akselererer denne trenden ved å gjøre falske identiteter billigere og vanskeligere å oppdage.

- Automatisert svindel og unndragelse: I tillegg til å skape falskt innhold, hjelper kunstig intelligens også svindlere maksimere suksessen til planene sine. Avanserte roboter kan raskt teste stjålne kredittkortopplysninger på netthandelsnettsteder ved hjelp av ML for å unngå å bli oppdaget. Kunstig intelligens kan hjelpe kriminelle med å identifisere de svakeste leddene i en organisasjons sikkerhet eller til og med syntetisere stemmesvar for å omgå telefonbasert identitetsbekreftelse. En egen industri på det mørke nettet selger nå AI-verktøy for "svindel som en tjeneste" for så lite som $20[14]. Denne demokratiseringen av AI-kapasiteter betyr at selv kriminelle på lavt nivå kan iverksette svært sofistikerte svindelangrep. Våpenkappløpet omfatter også det å unngå å bli oppdaget - svindlere bruker kunstig intelligens til å undersøke bankenes antisvindelsystemer og finpusse fremgangsmåten sin til de finner en metode som slipper gjennom filtrene[15]. Kort sagt gjør kunstig intelligens det mulig å svindle i en skala og med en effektivitet vi ikke har sett tidligereog utfordrer det konvensjonelle forsvaret.

Disse AI-aktiverte taktikkene er allerede sprer seg i et alarmerende tempo. Tradisjonelle svindelmetoder som sjekkforfalskning og phishing har eksistert i årevis, men kunstig intelligens øker omfanget og realismen. Dataene forteller en klar historie: AI-svindel er økende.

Aldri bekymre deg for AI-svindel igjen. TruthScan Kan hjelpe deg:

- Oppdage AI generert bilder, tekst, tale og video.

- Unngå stor AI-drevet svindel.

- Beskytt dine mest følsom virksomhetens eiendeler.

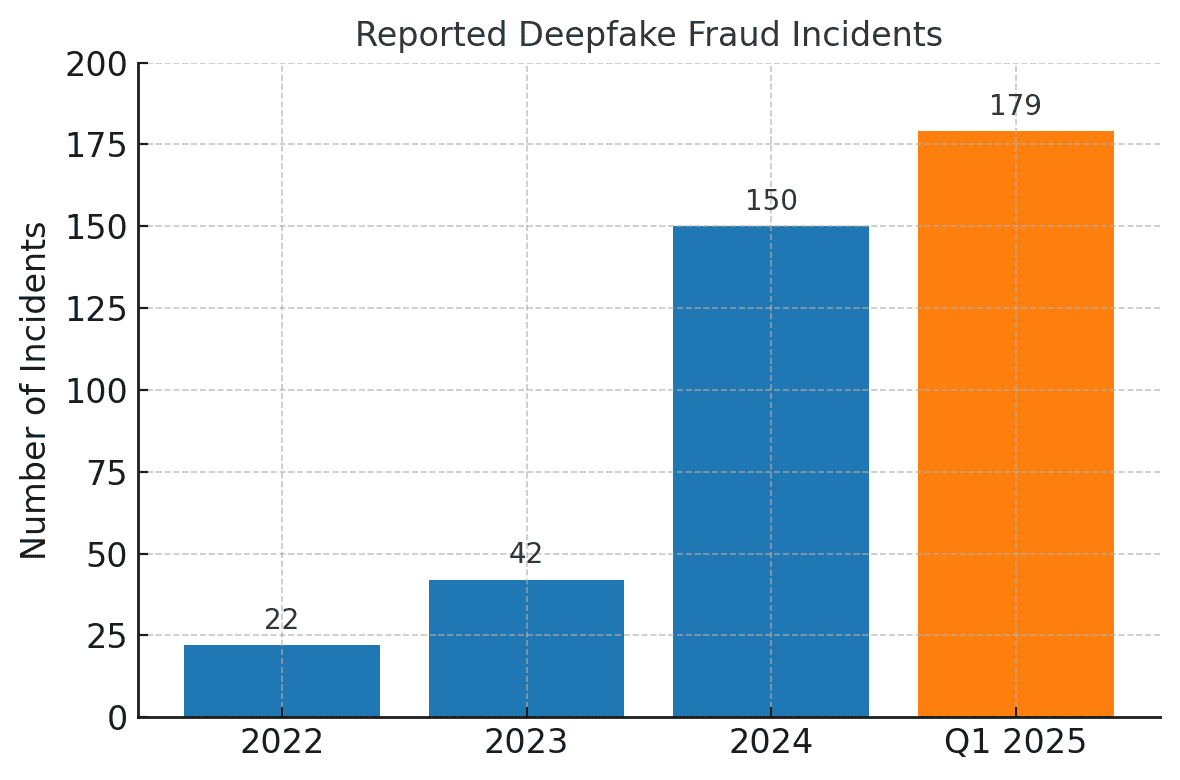

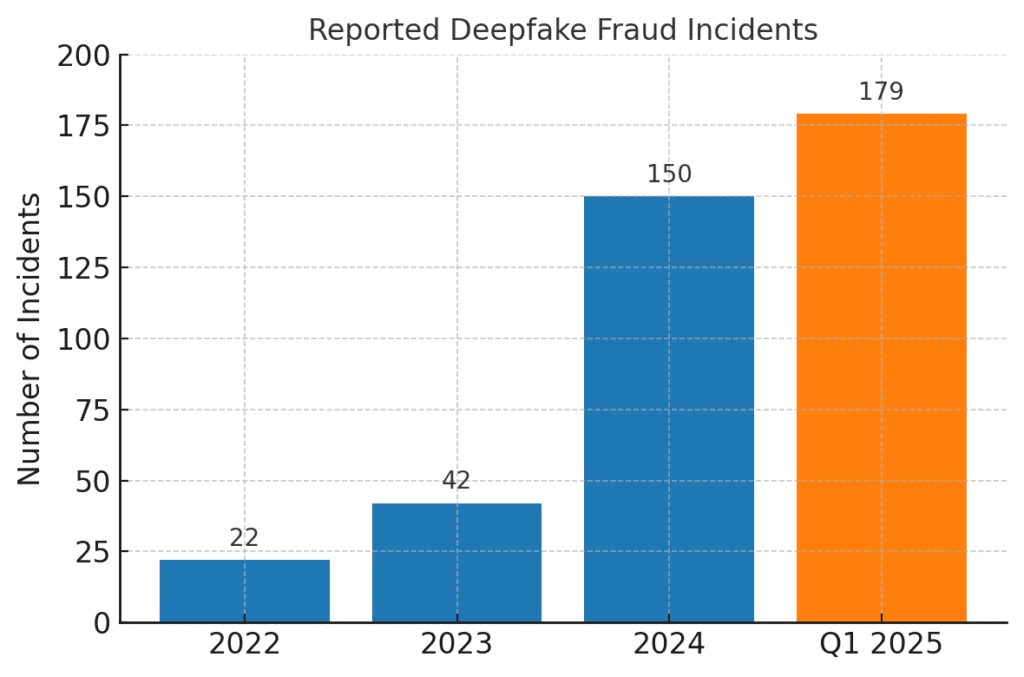

Deepfake-relaterte svindeltilfeller har skutt i været. I 2022 ble det bare registrert 22 tilfeller av deepfake-svindel, men i 2023 var det 42, og i 2024 eksploderte antallet hendelser til 150. Bare i løpet av det første kvartalet i 2025 179 deepfake-svindelhendelser ble rapportert - noe som overstiger totalen for hele 2024[16][17].

Nyere bransjeanalyser gjenspeiler disse trendene. I en rapport ble det notert en 700% økning i antall deepfake-hendelser rettet mot fintech-selskaper i 2023[18]. Enda mer oppsiktsvekkende er det at Nord-Amerika opplevde en 1,740% økning i antall deepfake-svindelsaker mellom 2022 og 2023[19]. Finanskriminelle tar raskt i bruk disse verktøyene fordi de fungerer - mange banker og ofre er ennå ikke forberedt på å oppdage AI-genererte bedrag.

Konsekvenser og utfordringer for finansinstitusjonene

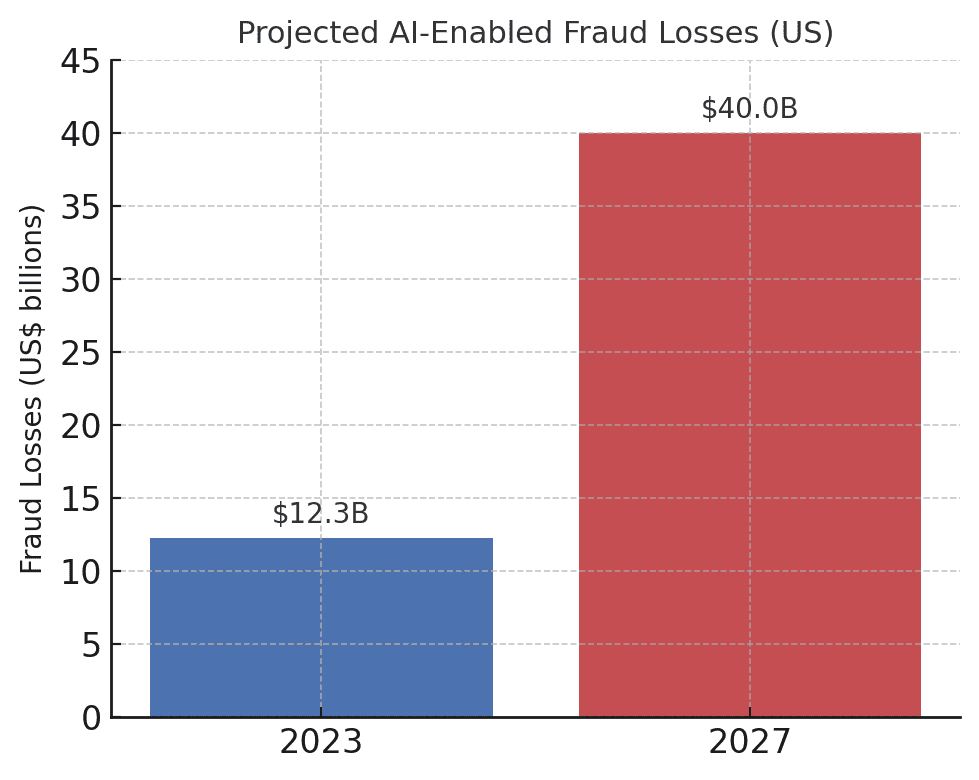

Fremveksten av AI-drevet svindel utgjør betydelige konsekvenser på finansinstitusjonene, kundene deres og det bredere finansielle systemet. Den mest umiddelbare effekten er økonomiske tap. Prognoser i bransjen spår at innen 2027 vil Svindeltap muliggjort av generativ AI kan nå $40 milliarder i USA, opp fra $12,3 milliarder i 2023[20]. Denne mer enn tredoble økningen (en 32% CAGR) gjenspeiler hvor raskt svindelrisikoen vokser målt i dollar.

De forventede tapene som følge av svindel med kunstig intelligens øker dramatisk. Deloitte anslår at tapene knyttet til økonomisk svindel med generativ AI i USA vil øke fra $12,3 milliarder i 2023 til $40 milliarder innen 2027[20].

I tillegg til tap i kroner og øre, er det omdømme- og tillitskostnader. Forbrukerne forventer at bankene beskytter dem - men svindel ved hjelp av kunstig intelligens undergraver tilliten til digitale kanaler. Hvis en kunde for eksempel blir offer for en overbevisende deepfake-svindel (som en falsk videosamtale med en bankmann), kan de klandre banken for mangelfull sikkerhet. Publikums tillit i talebekreftelse, e-post og til og med videokonferanser kan forvitre hvis "det du ser/hører" ikke lenger kan antas å være ekte[21]. Ifølge undersøkelser ser 85% av finansansatte i USA/Storbritannia på deepfake-svindel som en "eksistensiell" trussel mot organisasjonens sikkerhet[22]. Mer enn halvparten av selskapene i disse markedene rapporterer at de har blitt utsatt for en deepfake-drevet svindel, og det er alarmerende 43% av de utsatte innrømmet at angrepet lyktes i å lure dem[23]. Hver eneste vellykkede hendelse påfører ikke bare økonomisk skade, men svekker også kundenes tillit til institusjonen.

Finansbedrifter sliter også med utfordringer knyttet til drift og etterlevelse fra AI-svindel. Svindelbekjempelsesteamene står overfor en kraftig økning i antall varsler og hendelser, noe som legger press på etterforskningsressursene. Eksisterende modeller for å oppdage svindel (mange av dem baserer seg på regler eller eldre maskinlæringsteknikker) kan slite med å gjenkjenne AI-syntetisert innhold som ser legitimt ut. Faktisk ser toppmoderne deepfake-deteksjonssystemer utviklet i laboratorier at nøyaktigheten deres faller med nesten 50% når de konfronteres med deepfakes i den virkelige verden i naturen[24]. Menneskelige ansatte klarer seg ikke mye bedre - studier viser at folk bare kan oppdage deepfake-videoer av høy kvalitet rundt 55%-60% av tiden, knapt bedre enn tilfeldighetene[25]. Dette indikerer at bankene uten nye verktøy vil gå glipp av en stor del av de AI-drevne svindelforsøkene.

Det finnes også en regulatorisk dimensjon. Tilsynsmyndigheter og politi er svært oppmerksomme på risikoen (som det fremgår av FinCEN-varselet), og de forventer at finansinstitusjonene tilpasser seg. Bankene kan bli stilt overfor strengere retningslinjer for kundeverifisering og bedragerirapportering i en tid med kunstig intelligens. Hvis en bankansatt for eksempel blir lurt av en deepfake til å godkjenne en overføring på $10 millioner, kan tilsynsmyndighetene komme til å granske bankens kontroller og due diligence-prosesser. De Lov om bankhemmelighold omfatter nå eksplisitt rapportering av mistenkt cyberkriminalitet og deepfake-relatert aktivitet[26][4]Det betyr at bankene må lære opp ansatte i å gjenkjenne og rapportere AI-genererte svindelindikatorer i rapporter om mistenkelig aktivitet (SAR). Hvis banken ikke holder tritt med AI-forbedrede svindelteknikker, kan det føre til brudd på compliance eller juridisk ansvar hvis kunder eller motparter hevder at banken ikke gjorde nok for å forhindre forutsigbare AI-aktiverte svindelforsøk.

Den kanskje største utfordringen er asymmetriske karakter av denne nye trusselen. Generativ kunstig intelligens senker kostnadene og ferdighetene til angriperne betraktelig, samtidig som volumet og realismen i angrepene øker eksponentielt. Et enkelt viralt deepfake-rykte eller en overbevisende stemmeklone kan overvinne investeringer i autentisering verdt millioner av dollar. I mellomtiden må forsvarerne verifisere ektheten til hver eneste transaksjon og interaksjon, noe som er en mye vanskeligere oppgave. Det er i sannhet et våpenkappløp: Kunstig intelligens gir svindlere en selvoppdaterende verktøykasse for å omgå sikkerheten, noe som krever at bankene også må oppdatere forsvaret sitt kontinuerlig[15][27]. Mange finansinstitusjoner innrømmer at de ikke er tilstrekkelig forberedt - og over 80% av selskapene mangler en formell responsplan for deepfake-angrep, og mer enn halvparten har ikke gitt noen opplæring til ansatte om deepfake-risikoer[28][29]. Dette beredskapsgapet betyr at organisasjoner er sårbare, men det viser også hvor det er behov for tiltak.

En bemerkelsesverdig og tankevekkende beregning kommer fra en fersk bransjerapport: 42,5% av svindelforsøkene i finanssektoren involverer nå en eller annen form for kunstig intelligens[30]. Med andre ord har nesten halvparten av svindelangrepene bankene utsettes for en AI-komponent - enten det dreier seg om et AI-generert dokument, syntetisert stemme eller en maskingenerert phishing-melding. Denne statistikken understreker at AI ikke er en hypotetisk fremtidig trussel; den er allerede her, og tvinger finansinstitusjonene til å tilpasse seg for ikke å lide stadig større tap.

Forsvar mot AI-aktivert svindel: Strategier og løsninger

For å bekjempe AI-drevet svindel må strategiene for forebygging av svindel utvikles. Tradisjonelle tilnærminger (som manuell verifisering eller statiske regelmotorer) er ingen match for AI-svindel som skifter form. I stedet må bankene omfavne technology (like making sure they have a Secure SSL Certificate), training, and teamwork for å snu utviklingen. Nedenfor skisserer vi viktige strategier og nye løsninger:

- Utnytt AI til å bekjempe AI (avanserte deteksjonsverktøy): Finansinstitusjoner vender seg i økende grad til AI-drevne deteksjonsløsninger for å identifisere AI-generert innhold og avvik. Du må altså bekjempe ild med ild. Nye bedriftsverktøy som TruthScan tilbyr multimodal AI-deteksjon på tvers av tekst, bilder, tale og video for å autentisere innhold i sanntid[31]. Banker kan for eksempel bruke AI-tekstdetektorer til å skanne innkommende kommunikasjon (e-poster, chat-meldinger) etter tegn på AI-generert språk som kan tyde på en phishing-e-post eller en falsk kundehenvendelse. TruthScans system for AI-tekstdeteksjon kan identifisere AI-skrivet innhold fra modeller som GPT-4 med 99%+ nøyaktighettil og med finne ut hvilke setninger som sannsynligvis er AI-genererte[32][33]. På samme måte kan AI-verktøy for bildekriminalitet verifisere dokumenter og bilder. AI-bildedetektor kan flagge om et førerkort eller en strømregning er digitalt opprettet eller manipulert ved å sammenligne det med kjente mønstre av AI-genererte bilder[34]. For lydtrusler begynner bankene å bruke voice deepfake-detektorer - løsninger som analyserer samtalelyd for å finne akustiske fingeravtrykk av syntetisk tale. TruthScans AI Voice Detector, for eksempel, lytter etter tydelige tegn på stemmekloning og kan verifiser høyttalerens autentisitet for å forhindre falske anrop[35]. Ved å integrere disse detektorene via API i arbeidsflyten, kan finansinstitusjonene automatisk søke etter AI-innhold i bakgrunnen av transaksjoner og interaksjoner. Dette gir et ekstra forsvarslag som fungerer i maskinhastighet, og fanger opp det som menneskelige øyne/ører kanskje overser.

- Implementere flerfaktor- og out-of-band-verifisering: Etter hvert som kunstig intelligens gjør det vanskeligere å stole på stemmer eller bilder, bør bankene i større grad basere seg på verifiseringsmetoder som kunstig intelligens ikke så lett kan forfalske. Dette inkluderer multifaktorautentisering (MFA) ved hjelp av sikre kanaler. Hvis en forespørsel om bankoverføring for eksempel kommer via e-post eller videosamtale, bør man kreve en ekstra faktor, for eksempel et engangspassord som sendes til den forespurte personens kjente mobile enhet, eller en oppringning til et pålitelig telefonnummer som er registrert. Noen banker legger til "liveness"-kontroller for høyrisikotransaksjoner - for eksempel ved å be kunden om å ta en selfie i sanntid med en bestemt gest eller et bestemt ord, noe som er vanskeligere for en deepfake-video å gjenskape. Biometriske autentiseringssystemer kan forbedres med antispoofing-tiltak (f.eks. skanning av 3D-ansiktsdybde eller overvåking av de subtile øyebevegelsene som deepfakes ofte ikke klarer å imitere).[27]). Nøkkelen er å unngå enkeltfeil. Selv om en AI deepfake kan lure én kanal (f.eks. stemmebekreftelse), kan en koordinert out-of-band-sjekk eller biometrisk test gi den nødvendige utfordringen for å avsløre svindelen. Prinsipper for null tillit bør anvendes: Behandle enhver uoppfordret eller uventet instruks (selv fra en "kjent" leder eller kunde) som mistenkelig inntil den er verifisert gjennom en uavhengig kanal.

- Opplæring av ansatte og bevisstgjøring om svindel: Teknologi alene er ingen mirakelkur - spesielt siden svindlere vil gå etter det svakeste leddet, som ofte er menneskelig tillit. Finansinstitusjoner bør investere i regelmessig opplæring om AI-basert svindel for svindelforebyggende team og ansatte i førstelinjen. De ansatte må lære seg å gjenkjenne røde flagg for deepfakes og sosial manipulering. Dette kan omfatte opplæring i subtile avvik (f.eks. problemer med leppesynkronisering i en videosamtale, eller lyd som inneholder unaturlig intonasjon eller for lite bakgrunnsstøy - potensielle tegn på en syntetisk stemme). Oppmuntre til en kultur for verifisering: De ansatte bør føle seg bemyndiget til å stoppe en mistenkelig transaksjon eller forespørsel og verifisere den på egen hånd, selv om den ser ut til å komme fra konsernsjefen. Tilfellet med Ferrari-sjefens stemme forsøkt forfalsket er lærerikt - en leder avslørte svindelen bare ved å stille et personlig spørsmål som bedrageren ikke kunne svare på[36]. Simulert phishing/deepfake-øvelser kan også være nyttig. På samme måte som bedrifter kjører phishing-simuleringer for å trene opp ansatte, kan de simulere en falsk telefonsvarer eller et falskt videomøte og se om de ansatte oppdager det. Dette bygger opp muskelminnet for å motstå virkelige angrep. Gitt at mer enn 50% av selskapene har ingen protokoller for deepfake-respons og lite opplæring på plass[29]er slike programmer en lavthengende frukt for å forbedre motstandskraften.

- Svindelanalyse og oppdagelse av avvik: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier AI-genererte lyder eller altfor formelaktig (sammen med AI-tekstdeteksjonen nevnt tidligere). Banker som JPMorgan har begynt å bruke store språkmodeller på sin interne kommunikasjon for å oppdage setninger eller sammenhenger som kan tyde på forsøk på sosial manipulering[37]. Betalingsnettverk som Mastercard skanner enorme datasett (milliarder av transaksjoner) med kunstig intelligens for å identifisere falske transaksjoner som tradisjonelle regler ville ha oversett[38]. Det vi kan lære av dette er at defensiv AI må være like innovativ som offensiv AI. Bedrifter bør vurdere å utvikle eller kjøpe inn AI-modeller som er spesielt egnet til å oppdage deepfake-innhold, syntetiske identiteter og generative angrepsmønstre. Disse modellene bør kontinuerlig trenes opp på de nyeste eksemplene på AI-svindel (en praksis som kalles nettbasert læring eller føderert læring), slik at de holder tritt med de kriminelles taktikker som utvikler seg raskt[39][40].

- Samarbeid og informasjonsdeling: Bekjempelse av svindel med kunstig intelligens vil kreve samarbeid både innad i og på tvers av institusjoner. Isolert innsats er mindre effektivt mot en trussel som overskrider organisatoriske grenser. Svindelforebyggende team, cybersikkerhetsteam og IT må jobbe hånd i hånd - for eksempel kan sikkerhetsteamene bruke deepfake-deteksjon i videokonferanseverktøy, mens svindelteamene integrerer innholdsskanninger i transaksjonsovervåkingen. På et mer overordnet nivå bør bankene delta i bransjegrupper som Financial Services Information Sharing and Analysis Center (FS-ISAC) for å utveksle informasjon om nye svindelforsøk med kunstig intelligens.[41]. Hvis én bank oppdager en ny deepfake-angrepsvektor, kan deling av denne innsikten hjelpe andre med å tette gapet før de blir rammet. Felles øvelser eller "red team"-simuleringer med scenarier som involverer AI (f.eks. en deepfake-svindel eller AI-generert ID-verifisering) kan gjennomføres gjennom bransjekonsortier eller med støtte fra myndighetene. Tilsynsmyndighetene fokuserer selv på risiko knyttet til kunstig intelligens, så det er lurt å samarbeide proaktivt med dem. Ved å bidra til standarder og retningslinjer for bruk av kunstig intelligens kan bankene bidra til å skape et tryggere økosystem. Til syvende og sist, siden en trussel mot én bank er en trussel mot alle i dette rommet[42]En kollektiv forsvarstilnærming vil styrke alles evne til å oppdage og avskrekke svindel med kunstig intelligens.

- Tiltak for kundeopplæring og tillit: Til slutt bør finansinstitusjonene ikke overse betydningen av kundebevissthet. Med deepfakes og AI-svindel rettet mot allmennheten (for eksempel falske stemmer i besteforeldresvindel eller falske "teknisk support"-chatter generert av AI), kan bankene bidra til å opplyse kundene om disse farene. Mange banker sender allerede ut varsler om phishing. De kan utvide disse til å nevne AI-stemmekloning og deepfake-videoer, og gi tips om hvordan man kan verifisere forespørsler. Noen progressive organisasjoner sender push-varsler eller advarsler i appene deres hvis en kjent svindel er i omløp (f.eks. "Pass på: Svindlere kan bruke stemmekloner av familiemedlemmer for å be om penger")[43]. Selv om det ikke direkte forebygger angrep, kan opplæring redusere suksessraten og forsterke følelsen av at banken er en sikkerhetspartner. Banker som investerer i banebrytende svindelforebygging, bør dessuten fremheve dette overfor kundene som en differensiator - Hvis kundene for eksempel får vite at alle videosamtaler eller dokumenter som sendes inn, skannes av kunstig intelligens for å sikre autentisitet (uten å avsløre sensitive metoder), kan det forsikre kundene om at banken bruker alle tilgjengelige verktøy for å beskytte dem. For at bankene skal kunne utnytte fordelene med kunstig intelligens fullt ut, er det avgjørende å bevare den digitale tilliten, og derfor er åpenhet og kundefokuserte sikkerhetstiltak en del av et helhetlig forsvar.

Rollen til AI-tjenester for innholdsdeteksjon

En hjørnestein i verktøykassen for å bekjempe svindel i AI-æraen er bruken av Tjenester for AI-deteksjon av innhold. Disse tjenestene spesialiserer seg på å oppdage "fingeravtrykkene" i AI-generert innhold som kan gli forbi menneskelige granskere. TruthScan er en slik leverandør som tilbyr en Suite for AI-deteksjon som spenner over flere innholdstyper. Finansinstitusjoner kan integrere disse verktøyene for automatisk å avdekke forfalskninger og svindelindikatorer:

- Dokument- og bildeverifisering: TruthScans plattform gjør det mulig for bankene å Test finansielle dokumenter for AI-generert svindel i sanntid[44]. Det betyr at når en ny konto åpnes eller en lånesøknad kommer inn med bilde-ID og lønnsslipp, kan systemet umiddelbart analysere disse bildene for tegn på syntetisk generering eller manipulering. Med over 99% målnøyaktighet[45]AI Image Detector kan fange opp falske ID-bilder eller forfalskede PDF-filer som et menneske kanskje ville godkjent på papiret. Denne typen verifisering av dokumenters autentisitet er avgjørende for å stoppe svindel med syntetiske identiteter før kontoer i det hele tatt åpnes.

- Transaksjonsovervåking i sanntid: Ved å ta i bruk API-integrasjoner kan TruthScan koble seg på bankenes transaksjonsbehandling og flagge uregelmessigheter i sanntid. Hvis det kommer en instruksjon via e-post som virker mistenkelig, kan Email Scam Detector analysere innholdet i meldingen og oppdage om den sannsynligvis er skrevet av en AI-modell som prøver å forfalske en leverandør eller leder.[46]. På samme måte kan AI-detektor i sanntid kan overvåke live-kommunikasjon (som chatter eller samarbeidsplattformer) for å gi øyeblikkelige varsler hvis det for eksempel oppdages en falsk deepfake-videofeed under et møte der mye står på spill[47][48]. Kontinuerlig overvåking med umiddelbare varsler og automatiserte svar bidrar til å krympe tidsvinduet der svindel kan skje uoppdaget.

- Deepfake-forsvar for stemme og video: For kundesentre og kundebehandlere vil det å innlemme TruthScans AI Voice Detector legger til et ekstra sikkerhetslag. Hvis en svindler ringer inn og utgir seg for å være en kunde ved hjelp av en stemmeklon, kan systemet analysere samtalelyden og flagge om den inneholder AI-syntetiserte elementer (for eksempel manglende naturlige mikropauser eller artefakter i lydbølgene).[35]. På videofronten har Deepfake Detector bruker datasynsalgoritmer på videobilder for å fange opp inkonsekvenser - som unaturlige ansiktsbevegelser, merkelig belysning eller feil leppesynkronisering - som avslører en forfalskning[49][50]. Ved å verifisere integriteten til stemmer og ansikter i viktige interaksjoner kan bankene motvirke bedragere som forsøker å lure de ansatte. Disse verktøyene fungerer som en høyteknologisk løgndetektor for digitalt innhold, og opererer usynlig i bakgrunnen.

Det er verdt å merke seg at slik deteksjonsteknologi ikke er en plug-and-play-løsning; den bør kalibreres og tilpasses institusjonens arbeidsflyt. Falske positive må håndteres (en AI-tekstdetektor kan for eksempel flagge malbasert, legitim kommunikasjon som mistenkelig inntil den lærer seg forskjellen). Når disse verktøyene integreres på riktig måte, forbedrer de imidlertid organisasjonens evne til å oppdage uredelig innhold før det forårsaker skade. De genererer også revisjonsspor og analytiske rapporter som er nyttige for etterlevelse og for kontinuerlig forbedring av svindelmodellene.

Effektiviteten til AI-deteksjonsverktøyene avhenger av stadige oppdateringer. På samme måte som antivirusprogramvare krever nye signaturer for nye virus, må AI-detektorer omskoleres til de nyeste deepfake-teknikkene og AI-modellene. Leverandører som TruthScan oppdaterer algoritmene sine for å kunne håndtere nye generative modeller og omgåelsestaktikker, og opprettholder høy nøyaktighet selv når AI utvikler seg[51]. Dette avlaster de interne teamene og sikrer at bankene ikke utkjemper gårsdagens krig mens de kriminelle går videre til nye AI-triks.

Konklusjon

Finansbransjen står ved et veiskille i kampen mot svindel. På den ene siden tar kriminelle i bruk generativ kunstig intelligens for å lansere svindelforsøk som er mer overbevisende og mer utbredt enn noensinne. På den andre siden har banker og svindelbekjempere et stadig større arsenal av AI-drevne forsvarsmekanismer til rådighet. De institusjonene som kommer til å lykkes, er de som erkjenner det nye trusselbildet og reagerer med samme oppfinnsomhet. Dette innebærer å investere i avanserte deteksjonsfunksjoner, integrere verifiseringsprosesser i flere lag, utdanne både ansatte og kunder og fremme en kultur preget av årvåkenhet og tilpasning.

Svindel med kunstig intelligens er et mål som beveger seg raskt - deepfake-svindelen som lurte et selskap i dag, kan bli motvirket av nye deteksjonsteknikker i morgen, og svindlerne kan endre metodene sine i neste uke. En "bransjestandard" strategi for forebygging av svindel i 2025 er derfor en strategi som legger vekt på smidighet og kontinuerlig forbedring. Finansinstitusjoner bør behandle sine svindelforsvarssystemer som levende, lærende enheter som utvikler seg i takt med kriminelle taktikker. En smart snarvei til å bygge opp denne kompetansen er å inngå partnerskap med teknologileverandører. For eksempel kan samarbeid med spesialiserte firmaer som TruthScan (som tilbyr skreddersydde løsninger for bank- og finanssektoren) øke institusjonens evne til å forhindre AI-aktivert svindel og samtidig opprettholde samsvar med regelverket og kundenes tillit[52].

Til syvende og sist handler beskyttelse mot AI-drevet svindel ikke bare om teknologi - det handler om å bevare den grunnleggende tillit som ligger til grunn for finans. Kundene må kunne stole på at banken deres kan skille en ekte transaksjon fra en falsk, og en ekte kunde fra en AI-bedrager. Ved å ta i bruk banebrytende AI-deteksjonsverktøy, styrke verifiseringsprotokollene og holde seg i forkant av nye trusler kan finansforetak opprettholde denne tilliten. Veien fremover vil utvilsomt by på flere svindelforsøk fra motstandere, men med beredskap og de rette investeringene kan bankene sørge for at AI blir mer en ressurs enn en trussel innen forebygging av svindel. Det er et oppnåelig mål: De samme AI-teknologiene som truer med å forstyrre, kan utnyttes til å beskytte integriteten til finanssystemet vårt. Nå er det på tide at svindelforebyggende team og ledere på toppnivå handler resolutt, ta i bruk avanserte løsninger og strategier for å overliste svindlerne og sikre fremtiden for digital finans.

Kilder: Det er gjennomgående referert til nyere bransjerapporter, varsler fra myndighetene og teknologiske whitepapers (Deloitte[20][18], World Economic Forum[19][24], U.S. Treasury FinCEN[3][4], Federal Reserve[13], Keepnet Labs[16][30](blant andre) for å skaffe til veie data og eksempler. Alle data og eksempler er sitert på linje, slik at leserne kan utforske dem videre.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking og risiko for AI-svindel | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Det er viktig å oppdage farlig AI i deepfake-æraen | World Economic Forum

[3] [4] [26] FinCEN varsler om svindelforsøk med Deepfake Media rettet mot finansinstitusjoner | FinCEN.gov

[7] [8] FraudGPT og GenAI: Hvordan vil svindlere bruke kunstig intelligens i fremtiden? | Alloy

[11] Syntetisk identitetssvindel: Hvordan kunstig intelligens endrer spillet - Federal Reserve Bank of Boston

[12] [13] Generativ kunstig intelligens øker trusselen mot syntetisk identitetssvindel

[16] [17] [22] [23] [28] [29] [30] Deepfake-statistikk og -trender 2025 | Nøkkeldata og innsikt - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - AI-deteksjon og innholdssikkerhet for bedrifter

[32] [33] [51] AI-detektor: AI-tekstdeteksjon på bedriftsnivå - TruthScan

[44] [45] [52] AI-svindeloppdagelse i bankvirksomhet | CRO-løsninger | TruthScan

[49] [50] Deepfake Detector - Identifiser falske og AI-videoer - TruthScan