Innledning

Generativ AI revolusjonerer helsevesenet - og ikke alltid til det bedre. I 2025 har svindel i helsevesenet vokst mer digital og sofistikert, drevet av datainnbrudd, automatisering og generativ AI[1]. Kriminelle utnytter AI-verktøy for å skape falske pasientidentiteter, syntetiske forsikringskrav, AI-genererte medisinske dokumenter, forfalskede resepter og til og med deepfaked lege-pasient-interaksjoner. Disse høyteknologiske bedrageriene tar svindelen til nye høyder og truer forsikringsselskapenes økonomi og pasientsikkerheten over hele verden. Utfordringen er enorm: Svindel i helsevesenet koster allerede titalls milliarder kroner årlig, og fremveksten av kunstig intelligens er intensiverer både omfanget og kompleksiteten av svindelforsøk[2][3]. Dette whitepaperet gir en detaljert oversikt over de nyeste AI-drevne svindeltrendene i helsevesenet, reelle tilfeller fra 2025 og strategier - fra AI-innholdsdetektorer til identitetsverifisering - for å bekjempe denne nye trusselen.

Fremveksten av AI-aktiverte svindelforsøk i helsevesenet

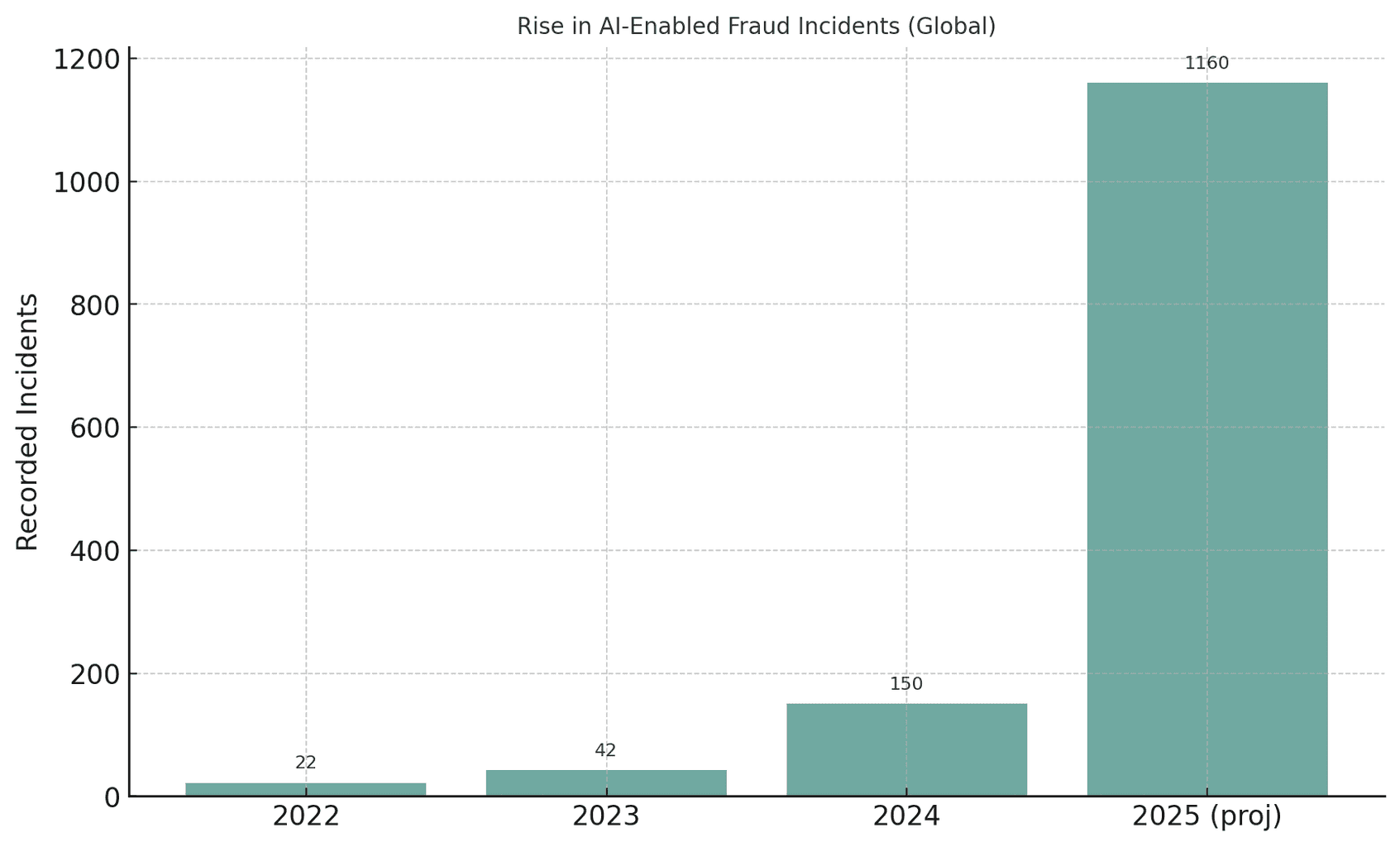

Den globale helsesektoren opplever en enestående økning i AI-drevne svindelforsøk. Etter hvert som generativ AI blir tilgjengelig, kan svindlere automatisere det som tidligere var manuelle svindelforsøk, og produsere overbevisende falske identiteter, dokumenter og til og med stemmer eller videoer i stor skala. Myndighetene bemerket for eksempel at svindelforsøk som involverte deepfake-medier økte med 3 000% i 2023 alene[4][5]. Deepfake-relaterte hendelser ble nesten fordoblet fra 22 i 2022 til 42 i 2023, og eksploderte deretter til 150 hendelser i 2024. Forbløffende nok ble det i første kvartal 2025 registrert 179 tilfeller av deepfake-svindel - noe som allerede oversteg totalen for 2024[6][7]. Denne trenden tyder på en galopperende vekst i AI-drevet svindelAnalytikere spår at generativ kunstig intelligens kan føre til svindeltap fra $12,3 milliarder i 2023 til $40 milliarder innen 2027 (32% CAGR)[8].

Figur: Den eksplosive veksten av AI-aktiverte svindeltilfeller de siste årene. Oppdagede tilfeller av deepfake eller AI-assistert svindel har økt dramatisk fra 2022 til 2025, noe som illustrerer hvordan generative AI-verktøy har forsterket svindelforsøkene[4][7].

Aldri bekymre deg for AI-svindel igjen. TruthScan Kan hjelpe deg:

- Oppdage AI generert bilder, tekst, tale og video.

- Unngå stor AI-drevet svindel.

- Beskytt dine mest følsom virksomhetens eiendeler.

Helsevesenet er spesielt sårbart for denne AI-drevne kriminalitetsbølgen. Sektorens enorme, fragmenterte økosystem - som spenner over sykehus, klinikker, forsikringsselskaper, apotek og telehelseplattformer - byr på tusenvis av angrepspunkter[9][10]. Tradisjonelle svindelforsøk (f.eks. falske forsikringskort eller stjålne pasient-ID-er) har utviklet seg til systemisk utnyttelse ved hjelp av AI[10][11]. I en amerikansk aksjon i 2025 siktet justisdepartementet 324 tiltalte for bedrageri til en samlet verdi av $14,6 milliarder kroner i falske krav - den største svindelsaken innen helsevesenet noensinne[12][13]. Mange svindelforsøk involverte telemedisinske konsultasjoner og svindel med gentester, og en ny rapport fra DOJ Datafusjonssenter for svindel i helsevesenet brukt AI-analyser for å oppdage mønstre proaktivt[14][15]. AI er helt klart et tveegget sverd: Det hjelper etterforskerne med å avsløre svindel, men også gjør det mulig for kriminelle å begå bedrageri i et omfang og på en måte som aldri før har vært så sofistikert[11][2].

Vanlige AI-drevne svindelteknikker i helsevesenet (2025)

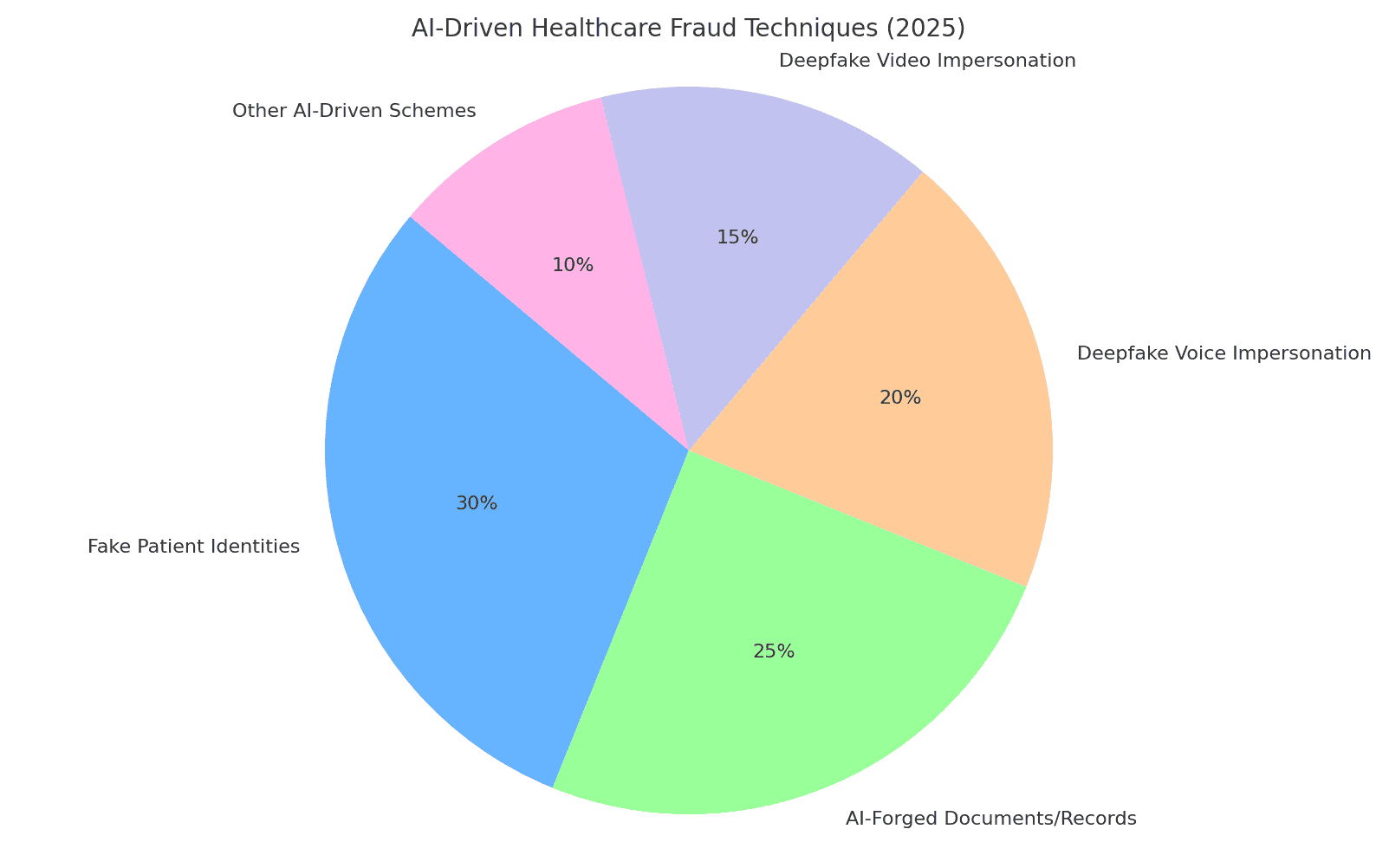

Svindlere i 2025 har en verktøykasse med AI-aktiverte taktikker for å svindle helsesystemer og forsikringsselskaper. Viktige metoder omfatter forfalskning av identiteter og dokumenter, generering av falske medisinske data og etterligning av betrodd personell via deepfakes. Nedenfor går vi gjennom de mest utbredte AI-drevne svindelteknikkene og hvordan de brukes mot helseorganisasjoner:

Figur: Fordeling av de viktigste AI-drevne teknikkene for svindel i helsevesenet i 2025. Falske pasientidentiteter og AI-forfalskede dokumenter (f.eks. medisinske journaler, krav) utgjør en stor andel av svindelforsøkene, mens deepfake stemme og videoimitasjoner er en raskt voksende trussel. "Andre AI-drevne svindelforsøk" inkluderer AI-konstruerte phishing-e-poster, roboter som angriper pasientportaler og lignende utnyttelser (estimerte prosentandeler basert på bransjerapporter[8][16]).

Syntetiske pasientidentiteter

Falske pasientidentiteter - ofte skapt ved hjelp av kunstig intelligens - er en grunnleggende svindeltaktikk. I stedet for å stjele én persons identitet, kombinerer kriminelle ekte data fra flere personer med oppdiktede detaljer for å skape syntetiske identiteter som går for å være nye pasienter[17][18]. Generativ AI fremskynder dette ved å produsere realistiske personregistre. AI kan for eksempel generere plausible ID-er, profiler, til og med familiehistorier ("syntetiske foreldre") for en falsk pasient[19][20]. Disse fantompasientene brukes deretter til å åpne kontoer, tegne forsikringspoliser eller fakturere for tjenester som aldri har funnet sted. Under covid-19-pandemien brukte svindlere syntetiske ID-er for å få tilgang til akutt helsehjelp; nå bruker de dem til å sende inn falske forsikringskrav eller få resepter, vel vitende om at en godt utformet identitet kan unngå å bli oppdaget[21][22]. Ifølge den amerikanske sentralbanken var tapene som følge av syntetisk identitetssvindel på over $35 milliarder kroner i 2023 og fortsetter å stige[23]. Konsekvensene for helsevesenet er alvorlige: Svindlere kan bruke et barns stjålne personnummer til å lage en falsk pasient med perfekt kredittverdighet, eller blande stjålne pasientdata for å omgå forsikringsselskapets verifisering[17][24]. Hver syntetisk pasient som introduseres i systemet undergraver dataintegriteten og kan føre til urettmessige utbetalinger eller til og med kliniske feil hvis den falske identiteten blir blandet med ekte medisinske journaler.

AI-genererte medisinske dokumenter og forsikringskrav

Generativ kunstig intelligens brukes nå til å skape medisinske dokumenter, journaler og hele forsikringskrav. Språkmodeller kan produsere autentisk utseende legenotater, epikriser, laboratorieresultater eller fakturaer fylt med medisinsk sjargong - alt skreddersydd for å underbygge et uredelig krav. Faktisk rapporterer observatører i bransjen om en 89% økning i AI-genererte medisinske dokumenter som sendes inn, sammenlignet med tidligere år[25][26]. Svindlere utnytter disse falske journalene til å rettferdiggjøre dyre prosedyrer eller medisiner som aldri ble gitt, eller til å blåse opp refusjonskoder. En kunstig intelligens kan for eksempel generere en falsk bildediagnostisk rapport eller laboratorieresultat for å underbygge et høykostnadskrav for kreftlegemidler. Forsikringsselskaper og helsesystemer står overfor en flom av slike syntetisk papirarbeidDet gjør det vanskeligere å skille ekte krav fra falske. I Storbritannia har forsikringsselskapene notert seg en raskt økende bruk av forfalskninger og forfalskede dokumenter i skadesaker, ofte i tilsynelatende rutinemessige krav av lav verdi for å unngå granskning[27]. Selv kliniske bilder er ikke immune - det finnes bevis for at Svindlere bruker generativ AI til å etterligne medisinske bilder som røntgenbilder eller skanninger[3]. Konsekvensene går utover det økonomiske tapet: Hvis forfalskede journaler havner i pasientjournaler, kan de føre til feildiagnoser eller feil behandling. Slik er det, AI-skriving av helsedokumenter utgjør en alvorlig integritets- og sikkerhetsrisiko.

Forfalskede resepter og apotekbedrageri

Reseptbedrageri har trådt inn i den digitale tidsalderen med kunstig intelligens. Forfalskede resepter - som tradisjonelt har blitt gjort med stjålne reseptblokker eller rudimentær redigering - kan nå autogenereres med realistiske detaljer og legesignaturer. AI-bildegeneratorer eller maler gjør det trivielt å lage e-reseptutskrifter som ser autentiske ut eller bestillingsskjemaer fra apotek. Kriminelle bruker i enda større grad stemmekloning å utgi seg for å være leger i samtaler med farmasøyter. I en rapportert trend hacket svindlere seg inn i pasientjournaler for å stjele legenes DEA-registreringsnummer, og brukte deretter disse opplysningene til å sende elektroniske resepter på kontrollerte stoffer[28]. Det har vært tilfeller av AI-stemmeforfalskninger brukes til å godkjenne påfyll - en farmasøyt mottar en samtale som høres ut som en kjent lege som bekrefter en resept, men det er i virkeligheten en AI-generert stemme. Resultatet er at kontrollerte legemidler (som opioider eller sentralstimulerende midler) kan skaffes og videresendes på ulovlig vis. Svindel med falske resepter påfører ikke bare forsikringsselskapene og apotekene økonomiske tap, det er også en fare for pasientene, som kan få feil medisiner i journalen sin. Hvis en svindler for eksempel utgir seg for å være en pasient for å få opioidresepter, kan pasientens medisinske journal kan bli oppdatert med legemidler de aldri har tatt, noe som kan føre til farlige interaksjoner eller at de blir flagget som legemiddelsøkende[29]. Denne blandingen av nettkriminalitet og utnyttelse av kunstig intelligens har ført til advarsler fra tilsynsmyndighetene. Helseorganisasjoner må nå verifisere at alle resepter - spesielt høyrisikomedisiner - er legitime og virkelig kommer fra den autoriserte leverandørenikke en deepfake eller et datainnbrudd.

Deepfake lege-pasient-imitasjoner

Den kanskje mest oppsiktsvekkende utviklingen er bruken av deepfakes for å utgi seg for å være helsepersonell eller pasienter. Innen telemedisin og kundeservice bruker svindlere AI-generert video og lyd for å lure folk i den andre enden. For eksempel har kriminelle skapt deepfake-videoer av pasienter for telehelsekonsultasjoner, og lure leger til å gi "behandling" eller henvisninger som deretter faktureres til forsikringsselskapet[30][31]. Omvendt kan en svindler forfalske en leges utseende - ved å bruke en anerkjent leges ansikt og stemme - i en videosamtale for å overtale en pasient til å betale for en bedragersk tjeneste eller utlevere personlig informasjon. IT-eksperter i helsevesenet advarer om at telehelse har blitt et modent mål: man kan bestille en virtuell time ved hjelp av en falsk pasientidentitet, og deretter få en AI-avatar til å stå inn på video for å få resepter eller medisinske råd under falske påskudd[31][32]. Utover telemedisin er deepfakes i ferd med å mette sosiale medier i form av "lege"-videoer som promoterer mirakelkurer. I 2024 observerte eksperter at deepfaked videoer av kjente leger "virkelig tok av," rettet mot eldre målgrupper med falske helsetips og svindelprodukter[33][34]. Betrodde TV-leger i Storbritannia og Frankrike har fått klonet sine likheter for å reklamere for falske diabeteskurer og blodtrykkstilskudd[35][36]. Opptil halvparten av seerne kunne ikke se at disse deepfake medisinske videoene var falske[37]. Denne svekkelsen av sannheten har håndfaste kostnader: Pasienter kan følge skadelige råd fra en falsk legevideo, eller svindlere kan fakturere forsikringsselskaper for konsultasjoner som aldri har funnet sted, bortsett fra som et deepfake-opptak. Alt i alt, AI-drevet etterligning undergraver den grunnleggende tilliten i helsevesenet - Hvis du ikke kan stole på at personen på skjermen eller telefonen er den de utgir seg for å være, er hele systemet i fare.

Virkning og omfang: Svindel i 2025 i tall

AI-drevet svindel er ikke lenger et marginalt problem - det er nå en stor økonomisk belastning og sikkerhetstrussel i globale helsesystemer. Se på følgende nylige statistikker og saker som illustrerer Problemets omfang:

- Årlige tap: Svindel i helsevesenet koster USA anslagsvis $68 milliarder kroner eller mer hvert år[25], omtrent 3-10% av alle helseutgifter[38]. På verdensbasis kan svindel utgjøre rundt 6% av helseutgiftene[39] - et svimlende tall med tanke på at helseutgiftene på verdensbasis beløper seg til billioner av dollar. Disse tapene betyr til syvende og sist høyere premier, økte sykehuskostnader og reduserte ressurser til pasientbehandling.

- Svindeltopp i 2023-2025: Fremveksten av generativ AI har ført til en eksplosjon av svindelforsøk. Deepfake-relaterte svindelhendelser økte tidoblet fra 2022 til 2023[4]. I 2024 økte antallet rapporterte deepfake-hendelser til 150 (en økning på 257%)[40], og 2025 ligger an til å langt overgå dette (580 hendelser bare i første halvdel av 2025, nesten fire ganger så mange som i 2024)[7]. Bedragerieksperter bemerker at 46% har opplevd syntetisk ID-svindel, 37% stemmeforfalskninger og 29% videoforfalskninger i sine undersøkelser[8] - som viser hvor vanlige disse AI-teknikkene har blitt.

- Rekordstore takedowns: Håndhevingsorganene svarer med større aksjoner. I juni 2025 kunngjorde det amerikanske justisdepartementet historiens største oppklaring av svindel i helsevesenet, siktelse av 324 personer og avdekking av $14,6 milliarder kroner i uredelige krav[1][13]. Svindelforsøkene omfattet blant annet telehelsekonsultasjoner, svindel med gentester og svindel med varige medisinske hjelpemidler i stor skala[13]. Som en del av dette arbeidet har Medicare suspenderte $4 milliarder i ventende utbetalinger ansett som mistenkelig[41]og forhindre disse tapene. En hjørnesteinsak ("Operation Gold Rush") avslørte en internasjonal ring som brukte stjålne identiteter til å $10,6 milliarder kroner i falske krav for medisinsk utstyr[42] - et bevis på hvor langt kriminelle er villige til å gå når de er bevæpnet med innbruddsdata og automatisering.

- Forsikringsselskapets innvirkning: Forsikringsselskaper over hele verden ser en økning i AI-relatert svindel. I Storbritannia rapporterer forsikringsselskapene at det i økende grad brukes "deepfakes" i skadesaker (ofte "low touch"-skadesaker for å unngå å bli oppdaget)[27]. Et ledende reassuranseselskap advarer om at forfalskede journaler og falske helsetilstander undergraver tegning av forsikringer og kan føre til økte tap på livs- og helseforsikringer[43]. En Deloitte-analyse fra 2024 anslår at innen 2027, generativ AI-aktivert svindel kan utgjøre $40 milliarder i årlige tap i USA. (opp fra $12,3 milliarder i 2023)[8]. Denne utviklingen innebærer en betydelig nedgang i forsikringsselskapenes bunnlinje hvis det ikke iverksettes robuste mottiltak.

- Pasientofre: Pasienter og publikum taper også penger på disse svindelforsøkene. Særlig eldre voksne har blitt utsatt for svindel med kunstig intelligens ("barnebarn i nød"-samtaler) og deepfake-helsesvindel. I 2023 rapporterte eldre i USA at de $3,4 milliarder kroner i tap til svindel, en økning på 11% fra året før[44][45] - noe av dette drevet av AI-forbedrede ordninger. Og utover de økonomiske kostnadene er det en menneskelige kostnader: falske medisinske råd og falske behandlinger som annonseres via kunstig intelligens, kan føre til fysisk skade eller mistet tillit til legitime helsetjenester.

Samlet sett har 2025 gjort det klart at AI setter turbo på tradisjonell svindel i helsevesenet. Det som tidligere var mindre, opportunistiske svindelforsøk, har utviklet seg til industrialiserte operasjoner som spenner over hele kontinenter. Kombinasjonen av store datamengder (ofte fra datainnbrudd) og kunstig intelligens gjør at svindelforsøk kan iverksettes med skremmende hastighet og troverdighet. De globale tapene er på flere titalls milliarder og økerog alle interessenter - fra sykehus og forsikringsselskaper til pasienter - er i faresonen. I neste avsnitt diskuterer vi hvordan bransjen kan slå tilbake ved hjelp av like avanserte teknologier og strategier.

Forsvar mot AI-drevet svindel: Strategier og løsninger

For å bekjempe AI-aktivert svindel i helsevesenet kreves det et arsenal av like avanserte forsvarsmekanismer. Ledere i helsevesenet, cybersikkerhetsteam, compliance-ansvarlige og forsikringsselskaper må samarbeide for å bygge inn tiltak mot svindel på alle sårbare punkter - fra pasientens onboarding til utbetaling av erstatningskrav. Nedenfor finner du viktige strategier og tekniske løsninger for å motvirke AI-drevet svindel:

- Verktøy for AI-deteksjon av innhold: På samme måte som kriminelle bruker kunstig intelligens til å fabrikkere innhold, kan organisasjoner bruke kunstig intelligens til å oppdage det. Avansert AI-skrevne innholdsdetektorer (som TruthScans suite) analyserer tekst, bilder, lyd og video for å identifisere tydelige tegn på AI-generering. TruthScans plattform bruker for eksempel maskinlæring for å oppdage statistiske mønstre og språklige særegenheter som indikerer AI-generert tekst med over 99% nøyaktighet[46][47]. Disse verktøyene kan integreres i skadebehandlingssystemer eller elektroniske pasientjournaler for automatisk å flagge mistenkelige dokumenter - f.eks. en medisinsk rapport som sannsynligvis er skrevet av ChatGPT - for manuell gjennomgang. På samme måte kan AI-bildeetterforskning oppdage manipulerte medisinske skanninger eller falske ID-er, og algoritmer for deepfake-deteksjon kan analysere videoer for tegn på syntese (artefakter i piksler, merkelig timing av ansiktsbevegelser osv.)[48][49]. Ved å ta i bruk multimodale AI-detektorer kan helseorganisasjoner siler ut en stor del av det AI-forfalskede innholdet i sanntid før det forårsaker skade.

- Journal- og dokumentverifisering: Helseleverandører vender seg til spesialiserte løsninger for å verifisere ektheten til journaler og skadedokumenter. Dette omfatter hashing og digital signering av legitime dokumenter, samt bruk av databaser med kjente, gode dokumentmaler som kan sammenlignes med innsendte dokumenter. AI-drevne verifiseringstjenester (for eksempel TruthScans Autentisering av medisinske dokumenter løsning) kan umiddelbart analysere et dokuments innhold og metadata for å finne ut om det er maskingenerert eller endret[50][51]. De ser etter uoverensstemmelser som et menneske kan overse - for eksempel subtile formateringsavvik eller metadata som indikerer at et bilde er produsert av kunstig intelligens. Overvåking av pasientjournaler og forsikringskrav i sanntid for uregelmessigheter er også viktig[52]. Ved å kontinuerlig skanne nye oppføringer (laboratoriesvar, legenotater, vedlegg til krav) kan disse systemene fange opp falske oppføringer før de fører til falske utbetalinger eller kliniske feil. Noen forsikringsselskaper har innført regler som innebærer at all dokumentasjon som identifiseres som AI-genererte, automatisk blir trukket ut for svindeletterforskning. Målet er å sikre at alle journaler eller krav som kommer inn i arbeidsflyten, er pålitelige og uendrede.

- Identitetssikring og validering: I en tid med syntetiske ID-er er det avgjørende å styrke identitetsverifiseringen. Helseinstitusjoner bør håndheve strenge krav til identitetsbevis for nye pasienter, leverandører og leverandører. Dette kan innebære flerfaktorautentisering, biometriske kontroller (som ansiktsgjenkjenning eller fingeravtrykk ved registrering) og bruk av tjenester for identitetsbekreftelse som utnytter kunstig intelligens til å oppdage falske ID-er eller uoverensstemmende personopplysninger. Ansiktsgjenkjenning kan for eksempel kombineres med livlighetstester for å forhindre at et AI-generert ansikt går for å være en ekte pasient via et bilde. På bakenden kan algoritmer kryssverifisere pasientens opplysninger (adresse, telefon, e-post, tilstedeværelse på sosiale medier) for å oppdage "tynne" identiteter som mangler en normal historikk - et kjent kjennetegn på syntetiske ID-er.[53]. Finansinstitusjoner har brukt slike AI-drevne bakgrunnssjekker med stor effekt[54]og helsevesenet kan gjøre det samme: f.eks. flagge en ny Medicare-søker hvis vedkommende ikke har noe digitalt fotavtrykk fra før i år. Validering av leverandøridentiteter er like viktig - å sikre at legen på en telehelsevideo har lisens og faktisk er den de utgir seg for å være, kanskje ved å utstede digitale sertifikater eller vannmerkede videofeeder som er vanskelige å etterligne for deepfakes. På apotekene bør personalet dobbeltsjekke uvanlige reseptforespørsler via direkte tilbakeringing til leverandørene og bruke kodefraser eller bekreftelsesspørsmål for å motvirke potensielle AI-stemmeforfalskere.

- Integrert svindeloppdagelse i arbeidsflyter: For å virkelig beskytte systemet kan ikke svindeloppdagelse være et enkeltstående trinn - det må være vevd inn i hver eneste arbeidsflyt i en helseorganisasjon.

I praksis betyr dette at sykehus og forsikringsselskaper tar i bruk API-integrasjoner for å kalle opp svindeloppdagelsestjenester på kritiske tidspunkter. Når en leverandør for eksempel sender inn et krav med vedlagte dokumenter, kan en AI-tjeneste automatisk evaluere ektheten av disse vedleggene i løpet av sekunder. Hvis en telehelseavtale settes i gang, kan plattformen kjøre passiv stemmeanalyse i bakgrunnen for å sikre at innringeren ikke bruker en syntetisk stemme. Kontinuerlig overvåking moderne svindelplattformer tilbyr dashbord som sporer svindelsignaler på tvers av organisasjonen (mislykkede valideringer, hyppig flagging av en bestemt klinikks krav osv.) for å identifisere mønstre, for eksempel en organisert svindelring som opererer på tvers av flere krav. Ved å behandle svindel i helsevesenet mer som cybertrusler - med Døgnkontinuerlig overvåking, deteksjon av avvik og rask respons på hendelser - organisasjoner kan fange opp problemer før de utvikler seg til en spiral[55].

- AI for svindelanalyse og mønstergjenkjenning: Datamengden i helsevesenet er så stor at kunstig intelligens er uunnværlig når det gjelder å finne svindelmønstre som mennesker overser. Maskinlæringsmodeller kan trenes opp på historiske svindelsaker for å oppdage nye tilfeller (for eksempel ved å gruppere krav som har lignende uvanlige ICD-koder, eller identifisere når en leges fakturering avviker mye fra andre legers). Forsikringsselskaper bruker allerede prediktiv analyse til å vurdere krav for svindelrisiko i sanntid. Nye teknikker som grafnevrale nettverk kan kartlegge relasjoner mellom pasienter, leverandører, diagnoser og krav for å oppdage usannsynlige forbindelser (for eksempel at samme serienummer brukes i krav fra ulike stater). TruthScans pakke for forsikringssvindel inkluderer for eksempel gjenkjenning av skademønster og prediktiv modellering for å fange opp organiserte svindelringer og atypiske mønstre før tapene akkumuleres[56][57]. DOJ Fusion Center i 2025 var et eksempel på denne tilnærmingen - ved å samle data på tvers av Medicare og private forsikringsselskaper for proaktivt å finne klynger av mistenkelig aktivitet[58]. Helseorganisasjoner bør på samme måte dele data og AI-modeller i konsortier for å utvide svindelsignalene hver enkelt kan oppdage. Jo mer data (innenfor personvernets grenser) som mates inn i disse modellene, desto bedre blir de til å skille mellom normal og uredelig atferd.

- Opplæring av ansatte og prosesskontroll: Teknologien er avgjørende, men menneskelig bevissthet er fortsatt et kraftfullt forsvar. Helsepersonell og administratorer bør få opplæring i AI-aktiverte svindeltaktikker - for eksempel å vite at en perfekt skrevet e-post fra en administrerende direktør kan være AI-forfattet phishingeller at de skal verifisere identiteten til videoanropere hvis noe virker "galt" (merkelige øyebevegelser eller lydforsinkelse kan tyde på en deepfake). Regelmessige øvelser og tips (i likhet med opplæring i phishing) kan implementeres for nye trusler som deepfake-telefonsvindel. Enkle prosesskontroller gir ekstra sikkerhet: Krev tilbakeringing eller sekundær verifisering for store eller uvanlige betalingsforespørsler, bruk av kjente, trygge kommunikasjonskanaler for sensitiv informasjon og opprettholdelse av en hendelsesresponsplan spesielt for mistenkt AI-mediert svindel. Det er viktig at organisasjoner dyrker frem en kultur der medarbeiderne føler seg bemyndiget til å stille spørsmål ved uregelmessigheterselv om det er en "lege" på video som ber om en merkelig forespørsel. Mange deepfake-svindelforsøk lykkes ved å utnytte tillit og autoritet. En årvåken arbeidsstyrke som kjenner til disse triksene, kan stoppe hendelsene tidlig. Som en ekspert bemerket, kan det å konfrontere deepfakes bli like rutinemessig som å oppdage phishing-e-post - en standard del av cybersikkerhetshygienen[32][59].

- Utnyttelse av spesialiserte tjenester: På grunn av den raske utviklingen av AI-trusler samarbeider mange helseorganisasjoner med spesialiserte leverandører av svindelforebygging. Tjenester som TruthScan for helsevesenet tilbyr ende-til-ende-løsninger som er skreddersydd for medisinsk bruk, inkludert: sanntidsovervåking av integriteten til elektroniske pasientjournaler (EPJ), verifisering av pasientdokumenter mot AI-manipulasjon, deepfake-deteksjon for telehelse og samsvarsrapportering (f.eks. revisjonsspor som beviser aktsomhet i forbindelse med svindeloppdagelse for tilsynsmyndigheter)[60][51]. Slike plattformer tilbyr ofte API-integrasjon for sømløs tilpasning til eksisterende systemer og er bygget for å oppfylle helseforskrifter (HIPAA, GDPR)[61][62]. Ved å bruke verktøy på bedriftsnivå kan selv mindre klinikker eller regionale forsikringsselskaper få tilgang til avanserte AI-deteksjonsfunksjoner uten å utvikle dem internt. I tillegg bør forsikringsselskaper og leverandører følge med på oppdateringer i regelverk og bransjestandarder - for eksempel nye lover mot deepfake-svindel (noen jurisdiksjoner forbyr nå eksplisitt medisinske deepfakes, og USA utvider lovene om identitetstyveri til å omfatte etterligning av AI[63]). Ved å tilpasse seg slike standarder og ta i bruk de nyeste verktøyene vil man ikke bare redusere svindeltapene, men også demonstrere en sterk sikkerhetsposisjon overfor partnere, revisorer og pasienter.

Konklusjon og fremtidsutsikter

Året 2025 har vist at den ånden er ute av flasken - generativ AI og automatisering er nå sammenvevd med svindel i helsevesenet. Fremover vil svindlerne sannsynligvis fortsette å innovere: Vi kan komme til å se AI-modeller som lærer seg å etterligne spesifikke legers skrivestil, eller deepfakes som reagerer i sanntid på utfordrende spørsmål. Kampen vil være et pågående våpenkappløp. Helsevesenet reagerer imidlertid med samme kraft og investerer i AI-drevet forsvar og strammere sikkerhetsarbeidsflyter. Ved å kombinere banebrytende deteksjonsteknologi, strenge verifiseringsprosesser, deling av data på tvers av bransjer og årvåkenhet blant de ansattekan helseorganisasjoner i betydelig grad redusere trusselen fra AI-fasilitert svindel.

Dette er ikke bare et IT-problem - det er også et spørsmål om styring og tillit. Styrer og ledere i helsevesenet må anerkjenne svindel med kunstig intelligens som en strategisk risiko for økonomien og pasientenes tillit, noe som krever regelmessig oppmerksomhet og ressurser. Compliance-team bør oppdatere risikovurderinger for svindel ved å inkludere AI-aspekter, og forsikringsselskapene bør kanskje revurdere sine forsikringsforutsetninger når de vet at en viss prosentandel av kravene kan være AI-assistert svindel. På den annen side vil det å utnytte kunstig intelligens på en etisk forsvarlig måte i helsevesenet (for klinisk beslutningsstøtte, faktureringseffektivitet osv.) fortsette å gi store fordeler - så lenge det finnes sterke sikkerhetstiltak for å forhindre misbruk.

For å oppsummere, generativ kunstig intelligens har endret svindelbransjen i helsevesenet, men med bevissthet og avanserte mottiltak trenger det ikke å overvelde systemet. De organisasjonene som lykkes, vil være de som holder seg informert om nye trusler, tilpasser seg raskt med AI-drevet forsvar og fremmer en kultur der man "verifiserer og stoler på" i stedet for "stoler på som standard". På den måten kan helsevesenet trygt utnytte AIs positive sider og samtidig nøytralisere misbruk, og beskytte både bunnlinjen og pasientenes velvære i den digitale tidsalderen.

Kilder: Nyere bransjerapporter og saker som nevnt ovenfor, inkludert Pymnts (juli 2025)[2][3], Swiss Re Institute (juni 2025)[27], Federal Reserve Bank of Boston (april 2025)[19], BMJ (2024)[37]og TruthScan løsningsbeskrivelser (2025)[51][64]blant andre. Alle data og sitater gjenspeiler det siste tilgjengelige i 2024-2025, og illustrerer den nåværende tilstanden for AI-drevet svindel i helsevesenet og tiltakene for å bekjempe det.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] Justisdepartementet anerkjenner AI-verktøy i historisk svindelaksjon i helsevesenet

[4] [5] [6] [7] [16] [40] [44] [45] Deepfake-statistikk og -trender 2025 | Nøkkeldata og innsikt - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes og kunnskapskrisen | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] Gen AI øker trusselen fra syntetisk identitetssvindel - Federal Reserve Bank of Boston

[25] [26] [56] [57] [62] [64] AI-svindeloppdagelse innen helse- og livsforsikring | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Hvordan deepfakes, desinformasjon og AI forsterker forsikringssvindel | Swiss Re

[28] DEA advarer mot elektronisk reseptsvindel - Pharmacy Practice News

[29] [39] Cybersikkerhet og svindel i helsevesenet: Et dypdykk i dagens største risikoer og forsvarsmekanismer | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] Den økende trusselen fra Deepfake-svindel innen telemedisin, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Eksperter advarer mot svindlere som bruker "deepfakes" av kjente leger på sosiale medier

[35] [36] [37] Betrodde TV-leger "deepfaked" for å promotere helsesvindel på sosiale medier - BMJ Group

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] Forskningsstatus Ajit Appari og M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - AI-deteksjon og innholdssikkerhet for bedrifter

[50] [51] [52] [60] [61] AI-deteksjon av journalsvindel | CRO-løsninger for helsevesenet | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Hvor farlig er Deepfakes og annen AI-drevet svindel?