Innledning: En ny æra med AI-drevne angrep

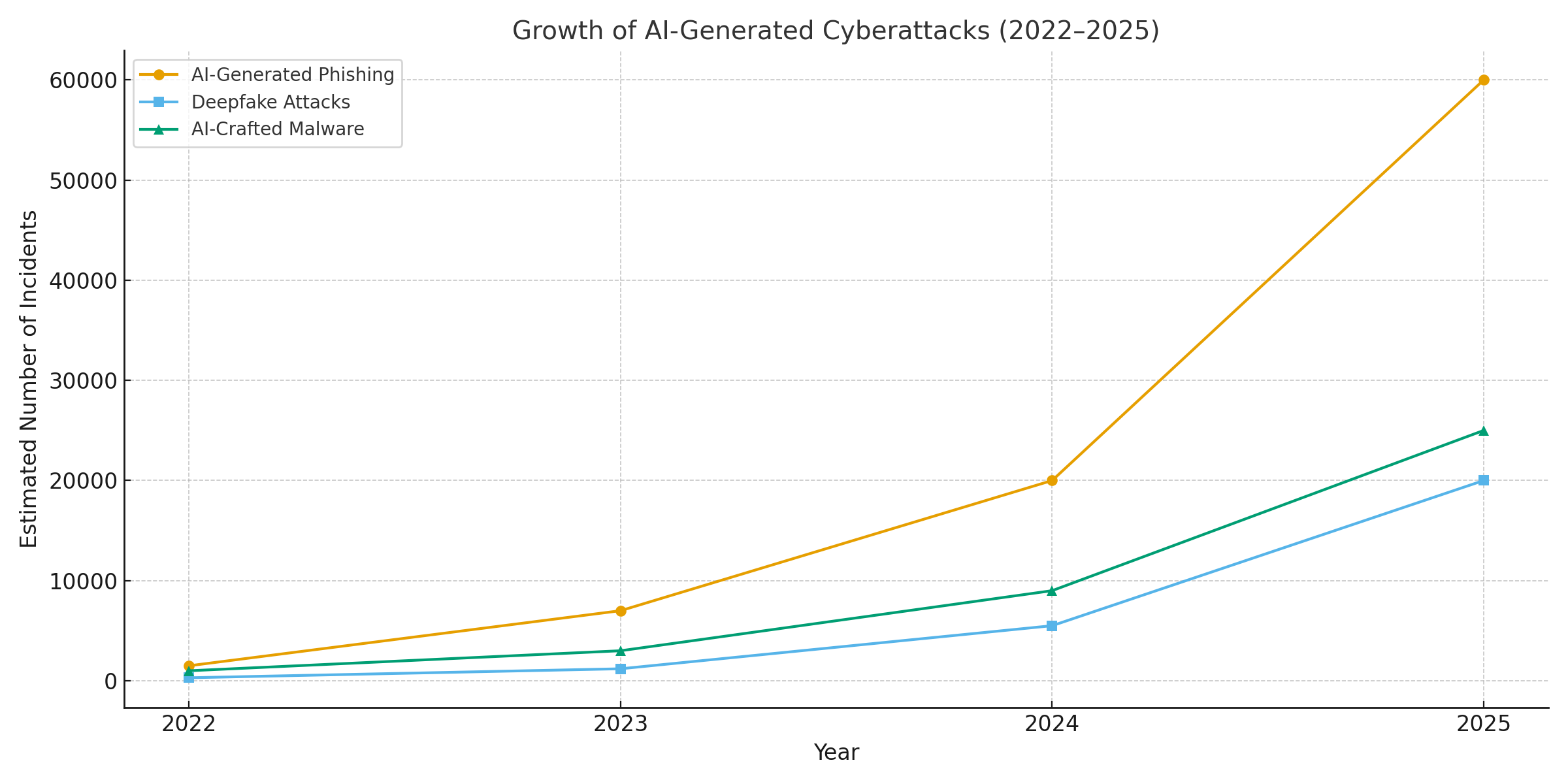

Året 2025 har markert et vendepunkt innen cybersikkerhet. Generativ kunstig intelligens har gitt cyberangrepene ny kraft og gjort det mulig for trusselaktørene å lansere flere hyppig, realistisk og skalerbar kampanjer enn noen gang tidligere. I løpet av det siste året har faktisk anslagsvis 16% av rapporterte cyberhendelser involverte angripere som brukte AI-verktøy (f.eks. modeller for bilde- og språkgenerering) for å forbedre sosial manipulering[1]. Ondsinnede aktører bruker kunstig intelligens som våpen i alle sektorer, fra ultraoverbevisende phishing-e-poster til deepfake audio/video-svindel. Et flertall av sikkerhetseksperter tilskriver nå AI økning i cyberangrep til generativ AI, noe som gir ondsinnede aktører raskere og smartere måter å utnytte ofrene på[2]. Generativ kunstig intelligens senker effektivt terskelen for å begå cyberkriminalitet, samtidig som den øker styrken.

Hvorfor er dette så bekymringsfullt? Kunstig intelligens kan umiddelbart produsere polert, kontekstbevisst innhold som lurer selv trente brukere. Den kan etterligne stemmer og ansikter med skremmende nøyaktighet, og til og med generere ondsinnet kode som endrer seg for å unngå å bli oppdaget. Resultatet er at cyberangrep har blitt vanskeligere å oppdage og enklere å utføre. Det Verdens økonomiske forum advarer om at 72% av organisasjonene har sett økt cyberrisiko - spesielt sosial manipulering og svindel - på grunn av generativ AIs voksende evner[3]. Hendelser i den virkelige verden bekrefter dette: Tidlig i 2024 brukte kriminelle en AI-generert deepfake videosamtale å utgi seg for å være et selskaps finansdirektør og lure en ansatt til å overføre $25,6 millioner til svindlerne[4]. Og i et annet tilfelle brukte nordkoreanske hackere AI-genererte falske ID-dokumenter for å omgå sikkerhetskontroller i en phishing-kampanje[5]. Disse eksemplene viser hva som står på spill - generativ kunstig intelligens muliggjør svindel som omgår både menneskelig og teknisk kontroll.

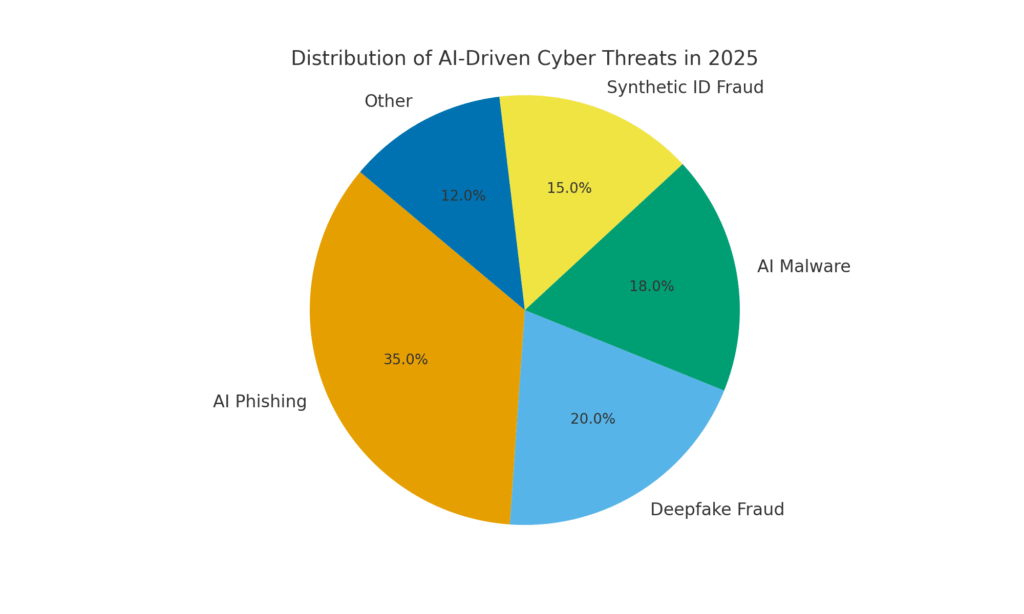

Men AI er også en del av løsningen. Avanserte deteksjonsverktøy (som de fra TruthScan) bruker AI mot AI - analyse av innhold for å finne subtile signaturer på maskingenerering. I dette whitepaperet ser vi nærmere på de største AI-drevne cybertruslene i 2025 og hvordan organisasjoner kan motvirke dem. Fra AI-generert phishing til deepfake CEO-svindel, Skadelig programvare laget av kunstig intelligens, syntetiske identiteterog mer, vil vi utforske hvordan generativ AI omformer angrep. Vi diskuterer også konkrete forsvarstiltak, blant annet AI-deteksjon av innhold, deepfake-forensics og identitetsverifiseringsteknologier som kan hjelpe sikkerhetsteamene med å gjenvinne overtaket. Målet er å belyse hvordan bedrifter, MSSP-er, CISO-er og svindeletterforskere kan integrere AI-deteksjonsverktøy i hele cybersikkerhetsstakken for å motvirke denne bølgen av AI-drevne trusler.

Aldri bekymre deg for AI-svindel igjen. TruthScan Kan hjelpe deg:

- Oppdage AI generert bilder, tekst, tale og video.

- Unngå stor AI-drevet svindel.

- Beskytt dine mest følsom virksomhetens eiendeler.

AI-generert phishing og BEC: Svindel i en skala uten sidestykke

En av de tydeligste effektene av generativ AI har vært på phishing og kompromittering av virksomhetens e-post (BEC) ordninger. AI-språkmodeller kan skrive flytende, kontekstuelt tilpassede e-poster på få sekunder - og eliminerer de avslørende grammatikkfeilene og klossete formuleringene som tidligere avslørte phishing. Resultatet er en flom av svært overbevisende svindel-e-poster og -sms-er. Innen april 2025, over halvparten av spam-e-postene (51%) ble skrevet av AI, opp fra nesten null to år tidligere[6]. Enda mer alarmerende er det at forskerne fant ut at omtrent 14% av e-postene fra BEC-angrep var AI-genererte innen 2025[7] - et tall som forventes å stige etter hvert som kriminelle tar i bruk verktøy som ChatGPT. Noen studier anslår over 80% av phishing-e-poster kan nå få hjelp av kunstig intelligens til å utforme dem[8].

Omfanget av disse AI-genererte lokkemidlene har eksplodert. Sikkerhetsanalyser viser at phishing-angrep knyttet til generativ AI økte med 1,265% i løpet av kort tid[9]. I løpet av én periode økte antallet rapporterte phishing-hendelser 466% i løpet av ett kvartali stor grad på grunn av automatiserte phishing-sett og roboter som pumper ut tilpasset agn[9][10]. Hvorfor en slik økning? Fordi AI lar angriperne skala deres virksomhet dramatisk. En enkelt kriminell kan bruke en AI-chatbot til å generere tusenvis av personaliserte svindel-e-poster rettet mot ulike ansatte eller kunder, alt på den tiden det pleide å ta å lage én. Denne masseautomatiseringen fikk FBI til å advare om at BEC-tapene (som allerede var på $2,7 milliarder i 2022) bare vil akselerere ettersom AI "truer med å øke disse tapene enda mer"[11][12].

Ikke bare er det flere phishing-e-poster, de er også mer effektiv. Ofrene blir i større grad lurt av det polerte språket og de kontekstuelle detaljene som kunstig intelligens kan inkorporere. I laboratorietester oppnådde AI-skrevne phishing-e-poster en 54% klikkfrekvens - langt over ~12% for tradisjonelle phishing-forsøk[13]. Disse meldingene kan se ut som en ekte CEO-stil eller referere til virkelige bedriftshendelser, noe som får mottakerne til å senke garden. Angriperne bruker til og med kunstig intelligens til å A/B-teste ulike formuleringer og iterere på de mest vellykkede krokene[14]. Og i motsetning til mennesker gjør ikke AI skrivefeil eller blir trøtt - den kan spy ut endeløse varianter helt til en slipper forbi filtrene og lurer noen.

Et godt eksempel: I midten av 2025 vil en Reuters etterforskning avslørte hvordan svindlere fra Sørøst-Asia utnyttet ChatGPT til å automatisere svindelkommunikasjon[15]. De genererte overbevisende bank-e-poster og kundeservicetekster i hopetall, noe som økte rekkevidden til svindelen deres betraktelig. Europeisk politi rapporterte også om AI-drevne phishing-sett som ble solgt på det mørke nettet for under $20, noe som gjorde det mulig for ufaglærte aktører å lansere sofistikerte kampanjer[16][17]. Inngangsbarrieren for BEC og phishing har i all hovedsak forsvunnet.

Defensive tiltak - Stopping av AI Phish: I lys av angrepet må organisasjoner styrke e-post- og meldingskanalene sine. Det er her AI-deteksjon av innhold kan være til hjelp. Verktøy som TruthScans AI-tekstdetektor og spesialiserte e-postskannere kan analysere innkommende meldinger for å finne statistiske markører for AI-genererte tekster. For eksempel kan TruthScan e-postsvindel-detektor bruker naturlig språkanalyse til å flagge e-poster som sannsynligvis stammer fra en AI, selv om de ser legitime ut[18]. Disse detektorene undersøker ting som perfekt grammatikk, setningskompleksitet og stilistiske mønstre som er uvanlige for menneskelige skribenter. Med skanning i sanntidkan mistenkelige e-postmeldinger settes i karantene eller flagges for gjennomgang før de når brukerne. Sikkerhetsteam i bedrifter har begynt å ta i bruk slike AI-drevne filtre i e-postgatewayer og meldingsplattformer. I praksis legger dette til et nytt forsvarslag på toppen av tradisjonelle søppelpostfiltre - et lag som er eksplisitt innstilt på å fange opp AI-skrevet innhold. Fra og med 2025 integrerer ledende bedrifter løsninger som TruthScan via API i sine sikre e-postgatewayer og samarbeidspakker i skyen, og skaper et automatisert kontrollpunkt for AI-generert phishing innhold.

Deepfake stemme- og videoimitasjon: Bedrageriet "å se er å bedra"

Den kanskje mest åpenbare AI-drevne trusselen i 2025 er fremveksten av deepfake tale- og videoangrep. Ved hjelp av AI-modeller kan kriminelle klone en persons stemme ut fra bare noen få sekunders lydopptak, eller generere en realistisk video av en persons ansikt ut fra en håndfull bilder. Disse "deepfakes" brukes som våpen i svindelforsøk med høy innsats - fra CEO-svindel ("falske CEO"-samtaler) til falske videokonferanser og mer. En fersk bransjerapport avslørte 47% av alle organisasjoner har opplevd deepfake-angrep av noe slag[19]. Og det er ikke bare teoretisk: Flere tyverier i 2023-2025 har bevist at deepfakes kan overvinne den ultimate autentiseringen - våre egne øyne og ører.

En beryktet sak gjaldt en internasjonal bankoverføring av $25 millioner etter at en ansatt ble lurt av en deepfake-videokonferanse. Angriperne brukte kunstig intelligens til å syntetisere selskapets økonomidirektør i en Zoom-samtale, komplett med hennes stemme og væremåte, og instruerte den ansatte om å overføre penger[4][20]. I en annen hendelse i Australia ble en lokal myndighet tapte $2,3 millioner da svindlere forfalsket både stemmen og videoen til kommunale tjenestemenn for å godkjenne falske betalinger[21]. Og urovekkende nok bruker kriminelle AI-klonede stemmer i "besteforeldresvindel" - de ringer eldre og utgir seg for å være deres pårørende i nød. De FBI og FinCEN i slutten av 2024 om en økning i svindel ved hjelp av AI-genererte "deepfake"-medier, inkludert falske kundeserviceagenter og syntetiske identiteter for å omgå KYC-verifiseringer[22].

Frekvensen av deepfake-baserte forbrytelser øker raskt. Innen utgangen av 2024 viser en analyse at en ny deepfake-svindel skjedde hvert femte minutt i gjennomsnitt[23]. Bare i 1. kvartal 2025 økte antallet rapporterte deepfake-hendelser med 19% sammenlignet med alle av 2024[24][25]. Deepfakes står nå for anslagsvis 6,5% av alle svindelangrep, a 2,137% økning siden 2022[26][27]. Teknologien som kreves, er blitt lett tilgjengelig - ofte kreves det så lite som 30 sekunder med lyd for å klone en stemme, eller under en times opptak for å modellere en persons ansikt på en overbevisende måte[20]. Kort sagt, det har aldri vært enklere å "forfalske" en betrodd persons identitet og lure ofrene til å gi fra seg penger eller informasjon.

Forsvarstiltak - Autentisering av virkeligheten: For å motvirke deepfake-trusler, vender organisasjoner seg til avanserte deteksjon av syntetiske medier verktøy. For eksempel, TruthScans AI-stemmedetektor og TruthScan Deepfake Detector bruker kunstig intelligens til å analysere lyd og video for tegn på manipulasjon. Disse systemene analyserer bilde for bilde og bølgeform for å oppdage artefakter som unaturlige ansiktsbevegelser, leppesynkroniseringsproblemer eller uregelmessigheter i lydspektret som avslører et AI-generert klipp. I tester oppnådde TruthScans algoritmer 99%+ nøyaktighet i identifisering av AI-genererte stemmer og oppdaget manipulerte videobilder i sanntid[28][29]. Faktisk brukte forskere ved Genians Security Center nylig TruthScans bildeanalyse til å analysere et falskt ID-kort som ble brukt av nordkoreanske hackere - TruthScans deepfake-bildedetektor markerte dokumentet som uekte med 98% tillit, forpurrer spear-phishing-forsøket[5][30].

For å sikre et praktisk forsvar bruker bedriftene disse deteksjonsfunksjonene ved viktige strupepunkter. Stemmeverifisering Når en "kunde" for eksempel ber om en stor overføring via telefon, kan lyden kjøres gjennom en deepfake-detektor for å sikre at det virkelig er vedkommende (og ikke en AI-imitator). På samme måte, plattformer for videokonferanser kan integrere deepfake-skanning av deltakernes videostrømmer i sanntid, for å fange opp eventuelle syntetiske ansikter. TruthScans pakke for deepfake-deteksjon tilbyr for eksempel analyse av videosamtaler i sanntid og ansiktsautentisering som kan kobles til Zoom eller WebEx via API[31][29]. Dette betyr at hvis noen prøver å bli med på et møte ved hjelp av en AI-skapt video av administrerende direktør, kan systemet flagge "mulig deepfake" før skaden er skjedd. I tillegg inkluderer viktige transaksjoner nå ofte et verifiseringstrinn (utenfor båndet eller med flere faktorer) som kan utnytte innholdsautentisering - f.eks. ved å kreve en kort muntlig bekreftelse som deretter sjekkes av en AI-stemmedetektor for autentisitet. Ved å kombinere disse verktøyene skaper bedriftene et sikkerhetsnett: Selv om de ansatte se eller høre noe plausibelt, vil en kriminalteknisk AI-analyse i kulissene sette spørsmålstegn ved realiteten. I et AI-gjennomtrengt trussellandskap, "Ikke stol på - verifiser" blir mantraet for all tale- eller videokommunikasjon som involverer penger eller sensitiv tilgang.

Skadelig programvare laget av kunstig intelligens og tilslørt kode: Utviklingen av trusler i koden

AIs innflytelse er ikke begrenset til sosial manipulering - den endrer også spillet når det gjelder utvikling av skadevare og unnvikende angrepskode. I 2025 avslørte Googles Threat Intelligence Group første malware-stammer som bruker AI under utførelse for å endre deres atferd[32][33]. Et eksempel, kalt PROMPTFLUXvar et ondsinnet skript som faktisk kalte opp et AI-API (Googles Gemini-modell) for å omskrive sin egen kode underveisproduserer nye tilslørte varianter for å unngå å bli oppdaget av antivirusprogrammer[34][35]. Denne "just-in-time"-utviklingen av kunstig intelligens markerer et sprang mot autonom, polymorf skadevare. Et annet eksempel, PROMPTSTEALbrukte en AI-kodingsassistent til å generere enlinjers Windows-kommandoer for datatyveri, og outsourcet i hovedsak deler av logikken til en AI-motor i sanntid[36][37]. Disse nyvinningene peker mot en fremtid der skadelig programvare kontinuerlig kan endre seg selv - omtrent som en menneskelig pen-tester ville gjort - for å overvinne forsvarsverk.

Selv uten kunstig intelligens på farten bruker angriperne kunstig intelligens under utviklingen for å skape mer potent skadelig kode. Generativ AI kan produsere skadelig programvare som er svært tilslørtsom inneholder lag med forvirrende logikk som vanskeliggjør reverse engineering. Ifølge trusselen etterretningsrapporter, over 70% av de største innbruddene i 2025 involverte en eller annen form for polymorf skadevare som endrer signatur eller atferd for å unngå å bli oppdaget[38]. I tillegg til dette, 76% av phishing-kampanjer bruker nå polymorfe taktikker som dynamiske nettadresser eller AI-omskrevne nyttelaster[38]. Verktøy som dark-web-tilbudene WormGPT og SvindelGPT (ubegrensede kloner av ChatGPT) gjør det mulig for selv ikke-eksperter å generere skadevare-droppere, keyloggere eller løsepengevirus-kode ved ganske enkelt å beskrive hva de ønsker[39]. Resultatet er en overflod av nye varianter av skadelig programvare. I 2024 ble det for eksempel lansert en informasjonstyv kalt BlackMamba dukket opp som var helt og holdent AI-generertved hjelp av ChatGPT for å skrive koden i segmenter - hver kjøring produserte en litt forskjellig binærfil, noe som forvirret tradisjonelle signaturbaserte antivirusprogrammer[38]. Sikkerhetsforskere demonstrerte også AI-genererte polymorfe proof-of-concepts som kunne omgå mange endepunktsbeskyttelser[40].

På toppen av det hele utnytter angriperne AI til å finjustere sine levering av skadevare. Kunstig intelligens kan lage intelligente skript for phishing-e-poster (som omtalt) som inneholder lenker til skadelig programvare. Den kan også hjelpe til med å utvikle utnyttelser - f.eks. ved å bruke kunstig intelligens til å finne nye sårbarheter eller optimalisere skallkode. Nasjonalstatlige aktører har angivelig brukt avanserte AI-modeller til å oppdage zero-day exploits og utvikle skreddersydd skadevare for mål[41]. Alle disse trendene betyr at skadelig programvare i 2025 er mer skjult og mer tilpasningsdyktig. Den er ofte "samskapt" med kunstig intelligensnoe som gjør det vanskeligere å oppdage ved hjelp av konvensjonelle regler.

Defensive tiltak - AI vs. AI i forsvar mot skadelig programvare: For å forsvare seg mot AI-skapt skadelig programvare kreves det en kombinasjon av avansert deteksjon og AI-drevet analyse på den defensive siden. Mange organisasjoner utvider sine endepunktsbeskyttelse og EDR (Endpoint Detection & Response) med AI/ML-modeller som ser etter atferdsmønstrene til AI-generert kode. For eksempel kan plutselige kodetransformasjoner på vertsdatamaskinen eller uvanlige API-kallmønstre tyde på at PROMPTFLUX regenererer seg selv. På samme måte kan nettverksovervåking fange opp avvik som skadelig programvare som kontakter AI-tjenester (noe som ikke er "normalt" for brukerapplikasjoner). Leverandører trener opp ML-baserte detektorer på familier av AI-assistert skadevare som er identifisert så langt, og gjør det lettere å gjenkjenne disse nye truslene.

En av de nye løsningene er integrert skanning av AI-innhold i utvikler- og byggepipelines. Dette innebærer å bruke AI-drevne detektorer til å analysere skript, programvarekonstruksjoner eller til og med konfigurasjonsendringer for ondsinnet eller AI-generert innhold. For eksempel, TruthScans sanntidsdetektor kan brukes til mer enn bare tekst - den multimodale analysen kan potensielt flagge mistenkelig kode eller konfigurasjonsfiler ved å gjenkjenne om de er maskingenerert med tilsløringsmønstre[42][43]. Utviklingsteam og MSSP-er har begynt å skanne infrastruktur-som-kode-skript, PowerShell-logger og andre artefakter for å se etter tegn på AI-skrevne segmenter som kan tyde på at en angriper står bak. Selv om dette er et nytt område, er det lovende: I ett tilfelle brukte et sikkerhetsteam en AI-detektor til å fange opp en tilslørt phishing-kit-fil som "føltes" AI-generert, og som faktisk var en del av et angrep[44]. Filens kode var altfor kompleks og ordrik (kjennetegn på AI-generering), og en skanning av AI-innholdet bekreftet at det med stor sannsynlighet ikke var skrevet av mennesker[40].

Til slutt er det avgjørende å dele trusselinformasjon med fokus på AI-trusler. Når Google GTIG publiserer detaljer om Prompt-basert skadevare eller når forskere rapporterer om nye teknikker for å omgå kunstig intelligens, bør organisasjoner bruke disse i deteksjonsteknikken sin. Atferdsanalyse - ved å se etter handlinger som at en prosess starter et skript som omskriver den samme prosessens kode - kan fange opp uregelmessigheter som AI-assistert skadelig programvare viser. Kort sagt, forsvarere må bekjempe ild med ild: distribuere AI-drevne sikkerhetsverktøy som kan tilpasse seg like raskt som den AI-drevne skadevaren gjør. Dette omfatter alt fra AI-forbedret antivirus til analyse av brukeratferd som kan identifisere når en konto eller et system begynner å oppføre seg "ikke helt menneskelig". Ved å ta i bruk kunstig intelligens i forsvaret kan sikkerhetsteamene motvirke de hastighets- og skalafordelene som kunstig intelligens gir angriperne.

Syntetiske identiteter og AI-drevne svindelforsøk

Fra skadevare til en verden av svindel: svindel med syntetisk identitet har eksplodert ved hjelp av generativ kunstig intelligens. Syntetisk identitetssvindel innebærer å skape fiktive identiteter ved å kombinere ekte og falske data (f.eks. ekte SSN + falske navn og dokumenter). Disse "Frankenstein-identitetene" brukes deretter til å åpne bankkontoer, søke om kreditt eller passere KYC-sjekker - noe som til slutt resulterer i ubetalte lån eller hvitvasking av penger. Dette var allerede en av de raskest voksende svindeltypene, og kunstig intelligens har nå kastet bensin på bålet. Tap som følge av syntetisk ID-svindel passerte $35 milliarder i 2023[45], og tidlig i 2025 indikerte noen estimater nesten 25% av alle tap i forbindelse med banksvindel skyldtes syntetiske identiteter[46]. Experians analytikere fant at over 80% av svindel med nye kontoer i visse markeder er nå knyttet til syntetiske ID-er[19] - en oppsiktsvekkende statistikk som understreker hvor utbredt denne svindelen har blitt.

Generativ AI forsterker syntetisk svindel på flere måter. For det første gjør kunstig intelligens det trivielt å produsere "Oppdretterdokumenter" og digitale fotavtrykk som trengs for å selge en falsk identitet. Tidligere kunne en svindler photoshoppe en ID eller lage falske regninger manuelt. Nå finnes det verktøy for å generere autentisk utseende profilbilder, ID-kort, pass, kontoutskrifter, til og med profiler på sosiale medier ved hjelp av AI-bildegeneratorer og språkmodeller[47][48]. Man kan for eksempel bruke kunstig intelligens til å lage et realistisk hodeskudd av en person som ikke finnes (noe som forhindrer enkle søk i omvendt bilde), og generere et matchende falskt førerkort med det bildet. AI kan også simulere "livstegn" på en identitet - f.eks. skape Opplysninger om syntetiske foreldre, adresser eller innlegg på sosiale medier for å utdype en bakgrunnshistorie[49]. Boston Fed bemerket at Gen AI til og med kan produsere deepfake lyd og video av en falsk person - For eksempel kan en syntetisk bruker "dukke opp" i en selfie-verifiseringsvideo, komplett med unikt ansikt og stemme, alt generert av kunstig intelligens[50].

For det andre hjelper kunstig intelligens svindlere skalere opp virksomheten deres. I stedet for å forfalske én eller to identiteter om gangen, kan de programmatisk generere hundrevis eller tusenvis av komplette identitetspakker og automatisk fylle ut nye kontosøknader en masse[51][52]. Noen tjenester på det mørke nettet tilbyr i praksis "Syntetiske identiteter som en tjeneste"og bruker automatisering til å produsere verifiserte kontoer for salg. Under hjelpeprogrammene i forbindelse med covid-19-pandemien brukte kriminelle for eksempel roboter med AI-genererte identiteter til å søke om lån og stønader i hopetall, noe som overveldet systemet med falske søkere. Juniper Research anslår at de globale kostnadene ved digital identitetssvindel (drevet av disse taktikkene) vil øke 153% innen 2030 sammenlignet med 2025[53].

Defensive tiltak - Identitetsverifisering i en AI-verden: Tradisjonelle metoder for identitetssikring sliter med å håndtere AI-skapte forfalskninger. For å tilpasse seg, tar organisasjoner i bruk Verifisering av identitet og atferd i flere lag forsterket av kunstig intelligens. Et viktig lag er avansert dokument- og bildeetterforskning. For eksempel, TruthScans AI-bildedetektor og Detektor for falske dokumenter gir muligheten til å analysere opplastede ID-er, selfies eller dokumenter for tegn på syntese eller manipulering. Disse verktøyene undersøker artefakter på pikselnivå, inkonsekvenser i belysning og metadata for å avgjøre om et bilde er AI-generert eller manipulert. De kan fange opp subtile tegn - som identiske bakgrunnsmønstre fra GAN-genererte bilder, eller fonter og mellomrom på en ID som ikke samsvarer med noen kjent mal fra myndighetene. Ved å ta i bruk slike detektorer ved onboarding kan bankene automatisk flagge en søkers førerkort eller selfie hvis det er sannsynlig at det er AI-generert (for eksempel ville TruthScans system ha flagget den falske militær-ID-en som ble brukt i Kimsuky APT-phishing-saken).[5]). Ifølge en pressemelding fra TruthScan har plattformen deres blitt brukt av finansinstitusjoner til å validere dokumenters autentisitet i stor skala og identifisere forfalskninger med ekstremt høy nøyaktighet[54].

Et annet lag er atferdsanalyse og kryssreferanser. Ekte identiteter har dybde - mange års historie, offentlige registre, aktivitet på sosiale medier osv. AI-genererte identiteter, uansett hvor finpussede de er, mangler ofte disse dype røttene. Banker og långivere bruker nå kunstig intelligens til å krysskorrelere søknadsdata med offentlige og proprietære data: Viser denne personens telefonnummer og e-post en brukshistorikk? Gir enhetens eller IP-enhetens geolokalisering mening? Skriver de inn data i skjemaer på en menneskelig måte, eller kopierer de (slik roboter gjør)? AI-modeller kan trenes opp til å skille ekte kundeatferd fra syntetiske mønstre. Federal Reserve bemerket at "syntetiske identiteter er overfladiske, og det kan AI se" - AI-basert verifisering kan raskt søke etter det digitale fotavtrykket til en identitet og utløse alarmer hvis det finnes lite eller ingenting[55]. I praksis bruker tjenester for identitetsbekreftelse nå kunstig intelligens som sjekker om brukerens selfie stemmer overens med tidligere bilder (for å oppdage ansiktsbytter) og til og med ber brukerne om randomiserte handlinger (som spesifikke positurer eller setninger) under livlighetskontroller, noe som gjør det vanskeligere for deepfakes å svare riktig[56][57].

Endelig, kontinuerlig overvåking av kontoatferd etter oppstart bidrar til å fange opp syntetiske kontoer som har sluppet gjennom. Siden disse kontoene ikke er knyttet til en ekte person, vil bruksmønstrene deres ofte skille seg ut etter hvert (f.eks. ved at de foretar perfekt timede transaksjoner for å bygge opp kreditt, for så å maksimere kreditten). AI-drevet svindelovervåking (som Sifts eller Feedzais plattformer) kan identifisere avvik i hvordan kontoer brukes, og flagge potensielle syntetiske kontoer for gjennomgang. For å bekjempe AI-aktivert identitetssvindel kreves det kort sagt AI-aktivert identitetssikring - som kombinerer dokumentetterforskning, biometriske kontroller, datakorrelasjon og atferdsanalyse. Den gode nyheten er at de samme AI-framskrittene som muliggjør svindel, også brukes til å oppdage den. TruthScan tilbyr for eksempel en pakke for identitetsbekreftelse som integrerer tekst-, bilde- og stemmeanalyse for å undersøke nye brukere. Ved å utnytte disse verktøyene merket en stor bank en betydelig nedgang i antall vellykkede syntetiske kontoåpninger, selv om bransjegjennomsnittet økte. Våpenkappløpet fortsetter, men forsvarerne er i ferd med å lære seg å oppdage de svake "digitale kjennetegnene" på en syntetisk konto, uansett hvor godt AI prøver å skjule sporene sine.

Integrering av AI-deteksjon på tvers av sikkerhetsstakken

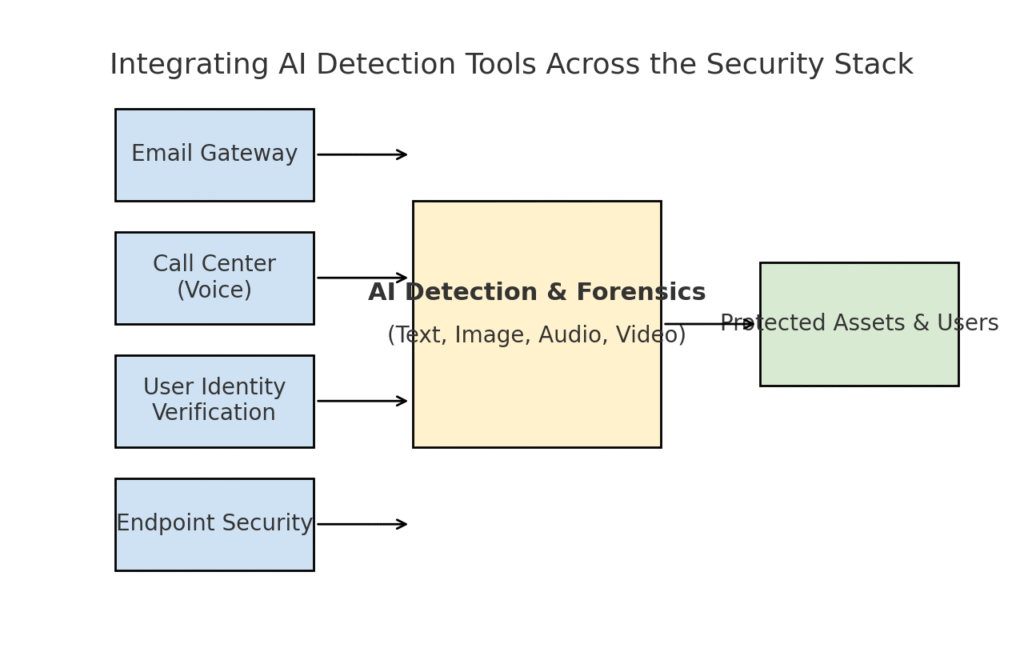

Vi har utforsket flere forskjellige trusselområder - phishing, deepfakes, skadelig programvare, syntetisk svindel - som alle er forsterket av kunstig intelligens. Det er tydelig at ikke noe enkelt verktøy eller noen engangsløsning vil løse utfordringen. I stedet trenger bedriftene en omfattende strategi for å innebygd AI-drevet deteksjon og verifisering i alle lag av cybersikkerhetsstakken deres. Tilnærmingen må speile angrepsflaten og dekke e-post, nett, tale, dokumenter, identitet og mer. Diagrammet nedenfor illustrerer hvordan organisasjoner kan integrere TruthScans AI-deteksjonsverktøy (og lignende løsninger) på tvers av bedriftens vanlige sikkerhetslag:

Integrering av AI-deteksjonsverktøy i flere lag av sikkerhetsstakken - fra e-postgatewayer og kundesentre til brukerverifisering og endepunktsbeskyttelse. AI-innholdsdeteksjon (senter) analyserer tekst, bilder, lyd og video i sanntid, og gir innspill til håndhevingspunkter som beskytter ressurser og brukere.

I denne modellen, multimodale AI-detektorer fungerer som en sentral hjerne som har grensesnitt mot ulike sikkerhetskontroller:

- E-postgatewayer: Innkommende e-post går gjennom en AI-tekst-/svindeldetektor før den når innboksen. Dette er knyttet til phishing-forsvaret vi diskuterte - f.eks. ved å bruke TruthScans e-postsvindel-detektor via API hos e-postleverandøren din for automatisk å sette mistenkelige AI-genererte e-poster i karantene[18]. Den kan også brukes på meldingsplattformer (chat-apper, SMS-gatewayer) for å skanne innhold etter phishing- eller svindelmønstre.

- Kundesentre og talesystemer: Telefon- og VOIP-kanaler sikres ved å integrere deepfake-deteksjon. For eksempel kan en banks kundesupportlinje bruke TruthScans AI-stemmedetektor analysere innkommende lyd i sanntid og varsle hvis innringerens stemmeavtrykk er syntetisk eller ikke stemmer overens med den kjente profilen[58][59]. Dette bidrar til å forhindre at vishing og stemmeimitasjonsangrep (som falske CEO-samtaler) lykkes.

- Prosesser for verifisering av brukeridentitet: Ved kontoopprettelse eller høyrisiko-brukerhandlinger (tilbakestilling av passord, bankoverføringer) settes AI-drevet identitetsverifisering inn. En opplastet bilde-ID blir kontrollert av et verktøy for bildekriminalitet (f.eks. for å sjekke om det er AI-generert eller et bilde av et bilde), og en selfie eller videosamtale blir undersøkt av en deepfake-detektor. TruthScans Deepfake Detector kan her brukes til å utføre ansiktsautentisering - for å sikre at personen på kameraet er ekte og stemmer overens med ID-en[60][61]. Atferdssignaler (skrivefrekvens, enhetskonsistens) kan også mates inn i AI-modeller for å oppdage roboter eller syntetiske identiteter.

- Sluttpunkter og nettverk: Endpoint-sikkerhetsagenter og proxy-servere kan innlemme AI-innholdsanalyse for filer og skript. Hvis en EDR for endepunkter for eksempel ser et nytt skript eller en EXE-fil som kjøres, kan den sende filens tekstinnhold til en AI-detektor for å sjekke om den ligner på kjent AI-generert skadelig programvare eller har trekk som ligner på tilslørt AI-kode. På samme måte kan DLP-systemer (systemer for forebygging av datatap) bruke AI-tekstdeteksjon til å flagge sensitiv tekst som er AI-generert (noe som kan tyde på at en innsider har brukt AI til å utarbeide dataekfiltreringsmeldinger eller forfalske rapporter). TruthScans Sanntidsdetektor er utformet for å kunne kobles til slike arbeidsflyter, og tilbyr direkte analyse av innhold på tvers av plattformer med automatiserte svaralternativer[42][62] (for eksempel automatisk blokkering av en fil eller melding hvis den identifiseres som AI-generert skadelig programvare eller desinformasjon).

Den viktig fordel av denne integrerte tilnærmingen er hastighet og konsistens. AI-angrep beveger seg raskt - phishing-e-post, falske stemmer og syntetiske data kan ramme mange kanaler samtidig. Ved å instrumentere alle disse kanalene med AI-deteksjon, får en organisasjon sanntidssynlighet og dybdeforsvar. Et team beskrev det som å skape et "AI-immunsystem" for bedriften: Hver gang noe kommuniseres (det være seg en e-post, en dokumentopplasting, en taleanrop osv.), "sniffer" AI-immunsystemet det for fremmede (AI-genererte) signaturer og nøytraliserer det hvis det viser seg å være skadelig.

TruthScans bedriftspakke er et godt eksempel på dette, ettersom den tilbyr en enhetlig plattform dekker AI-deteksjon av tekst, bilder, lyd og video, og kan distribueres modulært eller som en helhet[63][64]. Mange selskaper begynner med å ta i bruk én eller to funksjoner (for eksempel tekstdeteksjon i e-post og bildedeteksjon i onboarding), og utvider deretter med andre når de ser verdien av dem. Integrasjonen er dessuten gjort utviklervennlig - TruthScan og lignende tjenester tilbyr API-er og SDK-er, slik at sikkerhetsteamene kan koble deteksjon til eksisterende systemer uten å måtte gjøre omfattende omprosjektering. Enten det er en SIEM, en e-post-gateway, en tilpasset bankapp eller et CRM-system, kan deteksjonen kjøre bak kulissene og mate varsler eller automatiserte handlinger. En stor plattform for sosiale medier har for eksempel integrert API-er for innholdsmoderering for automatisk fjerning av deepfake-videoer i løpet av minutter etter opplasting[65][66]og forhindrer spredning av AI-generert feilinformasjon.

Konklusjon: Å holde seg i forkant av utviklingen

Den raske spredningen av AI-drevne trusler i 2025 har utfordret organisasjoner på nye måter. Angripere har funnet metoder for å utnytte menneskelig tillit i stor skala - ved å utgi seg for å være stemmer og identiteter, automatisere sosial manipulering, omgå forsvarsverk gjennom adaptiv kode og fabrikere hele falske virkeligheter. Det er et skremmende perspektiv for forsvarere, men ikke håpløst. På samme måte som kriminelle utnytter kunstig intelligens, kan vi også få kunstig intelligens på sikkerhetssiden. Fremveksten av AI-innholdsdeteksjon, deepfake-forensics og syntetiske identitetsskannere gir oss kraftige mottrekk mot disse nye truslene. Ved å ta i bruk disse verktøyene og integrere dem på tvers av alle lag kan bedrifter dramatisk redusere risikoen for at AI-drevne angrep slipper gjennom. Tidlige brukere har allerede avverget svindelforsøk verdt flere millioner dollar ved å ta deepfakes på fersk gjerning[26]eller forhindret phishing-katastrofer ved å filtrere bort AI-konstruerte e-poster.

I tillegg til teknologi bør organisasjoner dyrke en kultur der man "stoler på, men verifiserer". Ansatte bør være klar over at i en tid med kunstig intelligens er det ikke alltid slik at man tror det man ser (eller hører) - en sunn skepsis kombinert med arbeidsflyter for verifisering kan stoppe mange sosial manipulering. Opplæring og bevisstgjøring, kombinert med automatiserte verifiseringsverktøy som TruthScanutgjør et formidabelt forsvar. Vi må på sett og vis heve listen for autentisering og validering av informasjon. Digital kommunikasjon og digitale dokumenter kan ikke lenger tas for god fisk; deres opprinnelse må kontrolleres, enten maskinelt eller gjennom en prosess.

Vi kan forvente at angriperne vil videreutvikle sine AI-taktikker, men vi kan også forvente fortsatt innovasjon innen defensiv AI. Katt-og-mus-dynamikken vil vedvare. Forsvarernes suksess vil avhenge av smidighet og deling av etterretning. De som raskt tar i bruk ny trusselinformasjon (f.eks. nye teknikker for å oppdage deepfake eller oppdaterte AI-modellsignaturer), vil ligge foran angriperne som utnytter de nyeste AI-verktøyene. Samarbeid mellom bransjen, akademia og myndighetene vil også være avgjørende i denne kampen, noe som fremgår av varslene og rammeverkene som kommer fra byråer som NISTs rammeverk for AI-risikostyring og samarbeid mellom bankene om AI-deteksjon av svindel.

Avslutningsvis vil jeg si at cybersikkerhetsbransjen står midt oppe i et AI-drevet paradigmeskifte. Truslene er helt annerledes enn for ti år siden, men vi møter dem med forsvarsmekanismer vi aldri har sett maken til. Med en kombinasjon av avansert deteksjonsteknologi og en robust sikkerhetsstrategi kan vi kan redusere risikoen ved generativ AI og til og med snu den til vår fordel. Verktøy som TruthScans AI-deteksjonspakke gjør oss i stand til å gjenopprette tillit i en verden uten tillit - for å sikre at personen i den andre enden av linjen er ekte, at dokumentet i innboksen vår er autentisk, og at koden som kjører i nettverket vårt ikke har blitt tuklet med av en ondsinnet AI. Ved å investere i disse funksjonene nå, vil organisasjoner ikke bare beskytte seg mot dagens AI-aktiverte angrep, men også bygge motstandskraft mot morgendagens trusler. Lærdommen er klar: KI kan øke cyberangrepene, men med riktig tilnærming kan den også øke forsvaret vårt.

Kilder: Relevante data og eksempler er hentet fra 2025 trusseletterretningsrapporter og eksperter, inkludert Mayer Browns Cyber Incident Trends[1][67], Fortinets oversikt over trusler i 2025[2][19], Barracuda-forskning om AI-angrep på e-post[6][7], Google GTIGs rapport om AI-trusler[34], Boston Federal Reserve innsikt i syntetisk svindel[45][50], og TruthScans publiserte casestudier og pressemeldinger[30][26]blant andre. Disse illustrerer omfanget av AI-drevne trusler og effekten av AI-fokuserte mottiltak i virkelige scenarier. Ved å lære av slik intelligens og ta i bruk banebrytende verktøy kan vi navigere trygt i en tid med KI-forsterket cyberrisiko.

[1] [67] 2025 Trender for cyberhendelser - hva virksomheten din trenger å vite | Insights | Mayer Brown

[2] [3] [19] Topp cybersikkerhetsstatistikk: Fakta, statistikk og sikkerhetsbrudd i 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] AI-drevet svindel i finansielle tjenester: Nyere trender og løsninger | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan oppdager nordkoreansk deepfake-angrep på forsvarstjenestemenn - Bryan County Magazine

[6] [7] [14] Halvparten av søppelposten i innboksen din er generert av kunstig intelligens - bruken av kunstig intelligens i avanserte angrep er på et tidlig stadium | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Q2 2025 Digital tillitsindeks: Data og innsikt om AI-svindel | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] AI-trusler mot cybersikkerhet 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Siste trusselinformasjon | TruthScan

[18] [63] [64] TruthScan - AI-deteksjon og innholdssikkerhet for bedrifter

[23] [46] [56] [57] Deepfakes og innskudd: Hvordan bekjempe generativ AI-svindel

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake-angrep og AI-generert phishing: 2025-statistikk

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI-stemmedetektor for deepfakes og stemmekloning | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifiser falske og AI-videoer - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Fremskritt i trusselaktørers bruk av AI-verktøy | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackere tilslørte skadelig programvare med omstendelig AI-kode

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] AI-deteksjon i sanntid - TruthScan

https://truthscan.com/real-time-ai-detector

[44] EvilAI-operatører bruker AI-genererte koder og falske apper for langt ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Gen AI øker trusselen fra syntetisk identitetssvindel - Federal Reserve Bank of Boston

[53] Syntetisk identitetsbedrageri 2025: Strategier for AI-deteksjon og -forebygging