企業におけるAI音声詐欺を理解し、検知し、防止するための包括的ガイド

実現しなかった$2500万の音声通話

2024年2月、香港にある多国籍企業の財務担当者がCFOからビデオ通話を受けた。

相手の声は紛れもなく、抑揚、間、そしてわずかな訛りさえもすぐにわかった。

彼は彼女に、極秘の買収を最終決定するために、15回、合計$2,500万ドルの電信送金を処理するよう緊急に要請した。

もうAI詐欺を心配する必要はない。 TruthScan あなたを助けることができる:

- AIが生成したものを検出する 画像、テキスト、音声、ビデオ。

- 避ける AIによる大規模な詐欺

- 最も大切なものを守る 繊細 企業資産。

CFOがその電話をかけたことはない。完全にAIが生成したものだ。

これは孤立したケースではない。金融機関ではディープフェイク詐欺が急増している。

過去3年間で、ケースは2,137%急増し、AIは現在、この分野における詐欺の試みの42.5%を引き起こしている。

AIの音声詐欺が急増しているにもかかわらず、ビジネスリーダーの半数以上が、従業員がディープフェイク攻撃を発見したり対応したりする訓練を受けていないことを認めており、約80%の企業がこうしたインシデントに対処するための正式なプロトコルを設けていない。

AIボイス・クローニングの仕組みと脅威の理由

最新のAI音声合成に必要なデータは驚くほど少ない。わずか数秒の音声で、最大85%の精度で声のクローンを作ることができる。

そのプロセスは主に3つのステップに分けられる:

- データ収集: 詐欺師は、電話会議、ポッドキャストのインタビュー、ソーシャルメディアのクリップ、あるいはLinkedInのビデオ投稿など、公共のソースからボイスサンプルを収集する。

- モデルトレーニング: AIは、ピッチ、トーン、アクセント、ペース、呼吸パターンなどの声の特徴を分析する。

- 世代だ: このシステムは、親しい同僚でさえ欺くことができるほど説得力のある合成音声を作り出す。

アクセシビリティの問題

この脅威をさらに危険にしているのは、その民主化である。詐欺師はもはやハリウッド・レベルのリソースを必要としない。

オープンソースのツールやクラウドベースのAIサービスにより、基本的な技術スキルがあれば誰でも音声クローンを作成できるようになった。

経営幹部が詐欺のターゲットになる理由

エグゼクティブは危険なリスク要因のミックスに直面している。

ソーシャルメディアを通じて一般に公開されているため、ボイスサンプルは簡単に見つけることができ、その権威によって従業員は緊急の依頼に迅速に対応することが多い。

平均すると、4人に1人の経営幹部がディープフェイク技術をあまり理解していない。

懸念される現在の統計データ

においてである。 2024 デロイト調査エグゼクティブの25.9%は、過去1年間に財務または会計データを標的としたディープフェイクのインシデントに少なくとも1回は直面したと回答しており、回答者全体の半数は、今後12カ月間にこのような攻撃が拡大すると考えている。

最も懸念されるのは、52%の組織しか、自社のCEOのディープフェイクを見抜く自信がないと感じていることだ。

AI音声詐欺を見破る方法

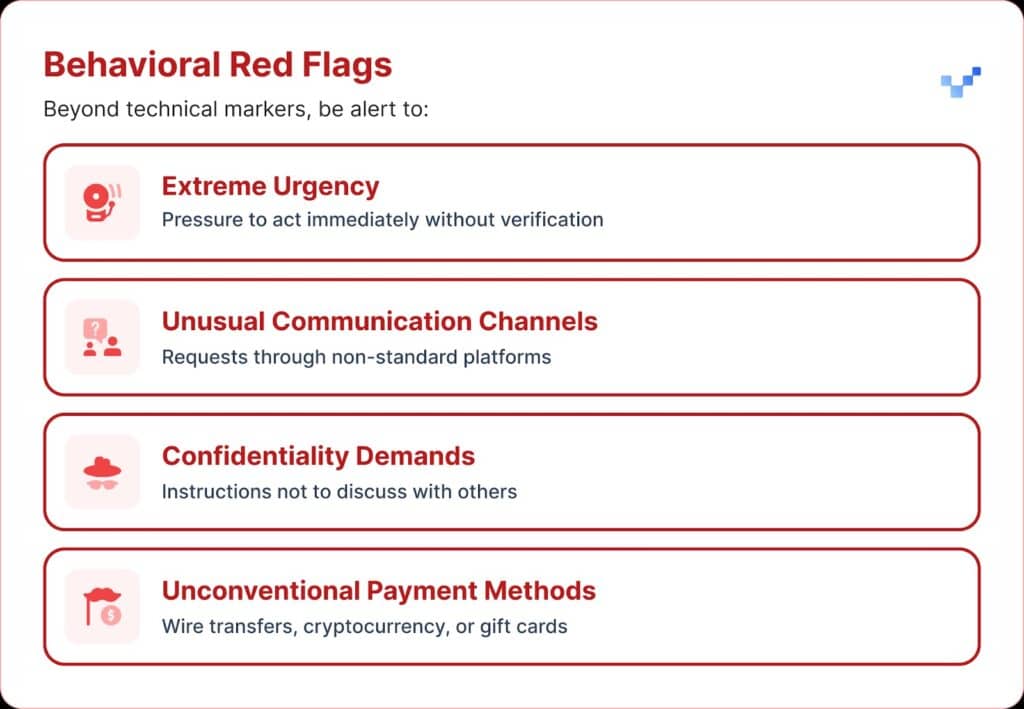

不審な音声通信を受信した場合、注意すべき警告サインがいくつかある。

AIボイス詐欺は、しばしば単調または平坦に聞こえます。また、奇妙な間や不自然なリズムなど、異常なテンポに気づくかもしれない。

また、特に長時間の通話では、音声にかすかな電子音やエコーが聞こえることがある。

そして多くの場合、声は限られたフレーズを繰り返し、台本やリハーサルのように伝わってしまう。

経済的影響と実際にかかる費用

ほとんどの組織で平均$450,000円程度の損失が出たが、金融サービス部門では$603,000円を超えた。

最も深刻なケースでは、10社に1社が$1百万ドル以上の損失を報告している。

この傾向は急速に拡大している。2022年の以前の調査によると、ID詐欺の平均的な金銭的負担は約$230,000であり、これは現在の数字のほぼ半分であった。

将来の予想損失額

デロイトの金融サービスセンターによると、米国でAI詐欺によって失われる金額は、2023年の1TP7123億円から2027年には1TP740億円に増加する可能性があるという。これは毎年約32%の成長だ。

地域の脆弱性

北米ではディープフェイク詐欺が1740%増加した。

この地域的な大幅な増加は、北米がディープフェイク詐欺師の主要なターゲットである可能性を示唆している。

役員保護の戦略的アプローチ

1.検証プロトコルの導入

防御を強化する一つの方法は、「セーフ・ワード」システムを使用することで、主要な担当者と事前に合意した認証フレーズを共有することである。

AIの音声クローンを使った詐欺師は、個人認証の質問に対する正しい答えを知らない。

もうひとつの安全策は、マルチチャンネル検証である。

通常とは異なる金銭的な要求は、別の連絡経路を通じて確認されるべきであり、決して当初の連絡方法だけに頼ってはならない。

企業はまた、大口の金融取引について、誰が要請したかにかかわらず、待機期間や承認ステップを設けるなど、エスカレーションのための明確なルールを設定すべきである。

2.デジタル露出を意識する

もう一つの防御策は、オンラインで入手できるエグゼクティブ・オーディオやビデオの量を制限することだ。詐欺師がサンプルを集めれば集めるほど、彼らのクローンの説得力が増す。

また、経営幹部向けに明確なソーシャルメディア・ガイドラインを設定することも有効だ。

また、カンファレンスに関しては、録音された講演やインタビューが長時間のボイスサンプルとして提供されることに注意する必要がある。

3.テクニカル・ソリューションの展開

そこで重要になるのが、高度なAI検知技術だ。

企業はエンタープライズ・グレードの音声認証と ディープフェイク検出 を提供する:

- リアルタイム分析: ライブ・コミュニケーション中の合成音声を検出

- 歴史的検証: 録音された通話やメッセージの信憑性を分析する

- 統合能力: 既存のコミュニケーション・プラットフォームとシームレスに連携

- 高い精度: 高度な偽物をキャッチしながら、誤検出を最小限に抑える

4.総合的なトレーニングプログラム

リーダーシップチームは、AI音声の脅威と検証手順に関する的を絞ったトレーニングを必要としている。

同様に重要なのは、従業員の意識を高めることだ。

どのような役割の人であれ、誰もが潜在的なディープフェイクを見抜き、サイバー脅威が組織に侵入するのを防ぐ能力を身につけるべきである。

定期的なシミュレーション演習は、模擬的な音声詐欺の試みを用いて対応手順をテストし、洗練させることで、この準備態勢を強化することができる。

高度なAI音声検出ソリューション

従来の防御は、ネットワークベースの脅威のために構築されたもので、AIを利用した人間のなりすましには対応していなかった。

標準的なサイバーセキュリティ・ツールが音声ベースのソーシャル・エンジニアリングに対処できない主な理由:

- マルウェア署名なし: 音声通話は従来のセキュリティ・システムを作動させない

- 人間の信頼要素: 人は自然に耳にしたもの、特に聞き慣れた声を信用する。

- 検出技術のギャップ: ディープフェイクを含むAIによる詐欺の試みが増加しているにもかかわらず、AIベースの詐欺防止ツールを導入している金融機関は22%に過ぎない。

特殊な音声検出の必要性

最新の音声詐欺には最新の検知能力が必要だ。

エンタープライズグレード AI音声検出システム ができる:

- 声のバイオマーカーを分析する: 合成音声の微妙な不一致を検出する

- リアルタイム処理: 不審な電話には即座に警告を発する

- 継続的な学習: 新しい音声合成技術への適応

- 統合準備完了: 既存の通信インフラとの連携

音声詐欺からの保護に真剣に取り組む組織は、直面する脅威の高度さに対応できる専用のAI検出技術に投資する必要がある。

音声詐欺は今、ここにあり、そしてエスカレートしている

2025年第1四半期、ディープフェイク詐欺とID窃盗は$2億ドル以上の損害をもたらした。

AIクローンによる音声フィッシングが442%と急増し、1日に400以上の企業がCEOやCFOを騙った詐欺に遭っている。

56%の企業がディープフェイクを見破る自信があると回答しているが、実際にディープフェイクによる金銭的損失を回避できたのは6%に過ぎない。

重要なのは、あなたの組織が標的にされるかどうかではなく、その準備ができているかどうかだ。

音声詐欺がサイバーセキュリティの様相を変えつつある。従来の防御では、AIによるなりすましには追いつけない。

組織を保護し続けるには、より優れた検知ツール、強力なトレーニングプログラム、明確な検証手順が必要だ。

反撃のためのテクノロジーはすでにここにある。本当の問題は、最初の音声詐欺事件が起きる前に使うか、それとも起きてから使うかだ。