Introduzione: Una nuova era di attacchi guidati dall'intelligenza artificiale

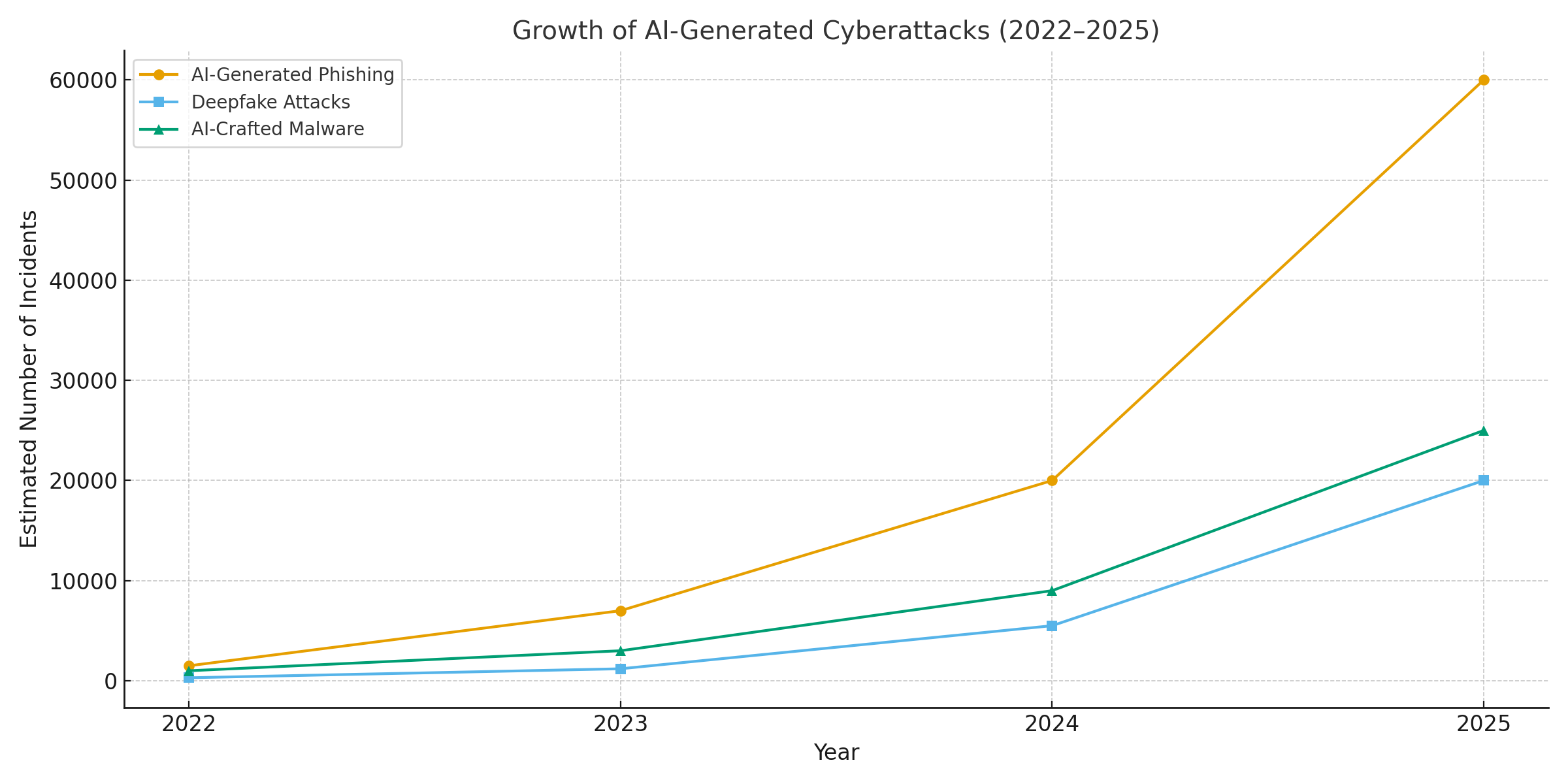

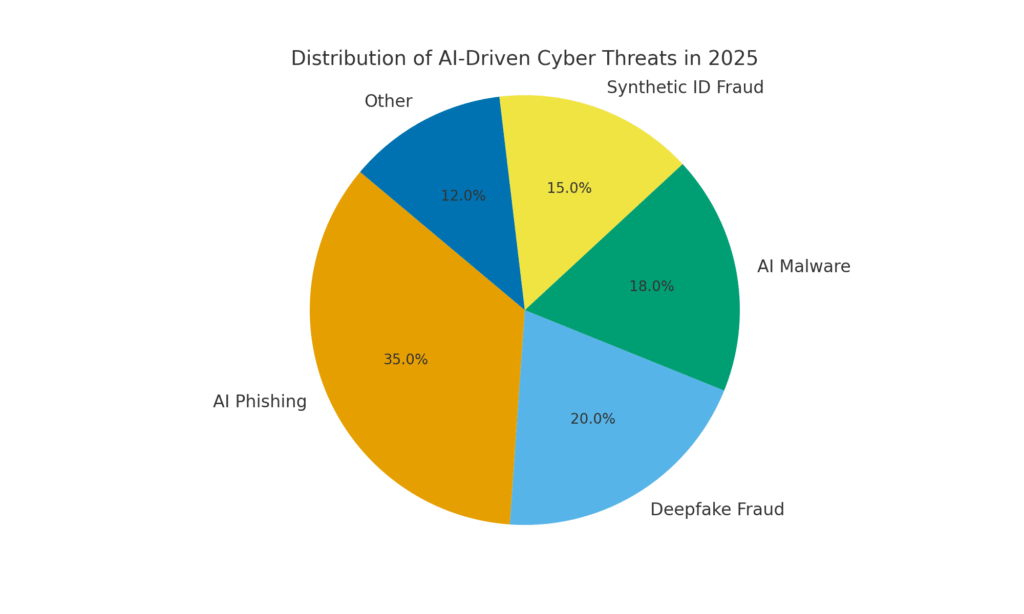

Il 2025 ha segnato un punto di svolta nella sicurezza informatica. L'intelligenza artificiale generativa ha potenziato i cyberattacchi, consentendo agli attori delle minacce di lanciare più frequenti, realistici e scalabili campagne come mai prima d'ora. Infatti, nell'ultimo anno si stima che Il 16% degli incidenti informatici segnalati ha coinvolto aggressori che hanno sfruttato strumenti di IA (ad esempio, modelli di generazione di immagini e linguaggi) per migliorare l'ingegneria sociale.[1]. Dalle e-mail di phishing ultra-convincenti alle truffe audio/video deepfake, i malintenzionati stanno utilizzando l'intelligenza artificiale in tutti i settori. La maggior parte dei professionisti della sicurezza attribuisce oggi all'IA l'aumento dei cyberattacchi all'intelligenza artificiale generativache offre ai malintenzionati modi più rapidi e intelligenti per sfruttare le vittime.[2]. L'intelligenza artificiale generativa sta effettivamente abbassando l'asticella delle competenze per la criminalità informatica, aumentandone al contempo la potenza.

Perché è così preoccupante? L'intelligenza artificiale è in grado di produrre istantaneamente contenuti raffinati e consapevoli del contesto che ingannano persino gli utenti esperti. Può impersonare voci e volti con una precisione spaventosa e persino generare codice maligno che si trasforma per eludere il rilevamento. Di conseguenza, gli attacchi informatici sono diventati più difficili da individuare e più facili da eseguire. Il Forum economico mondiale avverte che il 72% delle organizzazioni ha riscontrato un aumento dei rischi informatici, in particolare per quanto riguarda l'ingegneria sociale e le frodi, a causa delle crescenti capacità dell'IA generativa.[3]. Lo dimostrano gli incidenti del mondo reale: All'inizio del 2024, i criminali hanno utilizzato un'intelligenza artificiale videochiamata deepfake per spacciarsi per il direttore finanziario di un'azienda e ingannare un dipendente per fargli trasferire $25,6 milioni ai truffatori[4]. E in un altro caso, gli hacker nordcoreani hanno utilizzato Documenti d'identità falsi generati dall'intelligenza artificiale per eludere i controlli di sicurezza in una campagna di phishing difensivo.[5]. Questi esempi evidenziano la posta in gioco: l'intelligenza artificiale generativa sta dando vita a truffe che eludono i controlli umani e tecnici.

Tuttavia, anche l'intelligenza artificiale fa parte della soluzione. Gli strumenti di rilevamento avanzati (come quelli di TruthScan) utilizzano l'intelligenza artificiale. contro AI - analisi dei contenuti per individuare le firme più sottili della generazione di macchine. In questo whitepaper esamineremo le principali minacce informatiche guidate dall'IA del 2025 e come le organizzazioni possono mitigarle. Da Phishing generato dall'intelligenza artificiale a frode deepfake CEO, Malware creato dall'intelligenza artificiale, identità sintetichee altro ancora, esploreremo il modo in cui l'intelligenza artificiale generativa sta ridisegnando gli attacchi. Discuteremo inoltre di misure difensive concrete, tra cui Rilevamento dei contenuti AILe tecnologie di deepfake forensics e di verifica dell'identità che possono aiutare i team di sicurezza a riprendere il sopravvento. L'obiettivo è quello di illustrare come le aziende, gli MSSP, i CISO e gli investigatori di frodi possono integrare gli strumenti di rilevamento dell'intelligenza artificiale nel proprio stack di cybersecurity per contrastare questa ondata di minacce basate sull'intelligenza artificiale.

Non preoccupatevi più delle frodi dell'IA. TruthScan Può aiutarvi:

- Rilevare l'IA generata immagini, testo, voce e video.

- Evitare frodi di grande portata guidate dall'intelligenza artificiale.

- Proteggete i vostri prodotti più sensibile beni dell'impresa.

Phishing e BEC generati dall'intelligenza artificiale: truffe su scala senza precedenti

Uno degli impatti più evidenti dell'IA generativa è stato quello sul phishing e sul compromissione della posta elettronica aziendale (BEC) schemi. I modelli linguistici dell'intelligenza artificiale sono in grado di redigere in pochi secondi e-mail fluenti e contestualizzate, eliminando gli errori grammaticali e le frasi maldestre che un tempo facevano pensare al phishing. Il risultato è una marea di e-mail e testi truffaldini estremamente convincenti. Entro aprile 2025, oltre la metà delle e-mail di spam (51%) è stata scritta dall'intelligenza artificiale.rispetto a due anni prima[6]. Ancora più allarmante, i ricercatori hanno scoperto che circa 14% delle e-mail di attacco BEC sono state generate dall'intelligenza artificiale. entro il 2025[7] - una cifra destinata a salire con l'adozione da parte dei criminali di strumenti come ChatGPT. Alcuni studi stimano oltre 80% di e-mail di phishing potrebbe ora essere assistito dall'intelligenza artificiale per la loro creazione.[8].

Il volume di queste esche generate dall'intelligenza artificiale è esploso. Le analisi di sicurezza mostrano che gli attacchi di phishing legati all'IA generativa sono aumentati del 1,265% in un breve lasso di tempo[9]. In un periodo, le segnalazioni di incidenti di phishing sono aumentate 466% in un solo trimestrein gran parte a causa dei kit di phishing automatizzati e dei bot che pompano esche personalizzate.[9][10]. Perché questo picco? Perché l'intelligenza artificiale permette agli aggressori scala le loro operazioni in modo drammatico. Un singolo criminale può utilizzare un chatbot di intelligenza artificiale per generare migliaia di e-mail truffaldine personalizzate rivolte a diversi dipendenti o clienti, il tutto nel tempo necessario per crearne una. Questa automazione di massa ha portato l'FBI ad avvertire che le perdite di BEC (che nel 2022 erano già pari a $2,7 miliardi) non potranno che accelerare, poiché l'intelligenza artificiale "minaccia di spingere tali perdite ancora più in alto".[11][12].

Non solo le e-mail di phishing sono più numerose, ma sono anche più efficace. Le vittime sono ingannate a tassi più elevati dal linguaggio raffinato e dai dettagli contestuali che l'intelligenza artificiale può incorporare. Nei test di laboratorio, le e-mail di phishing scritte dall'intelligenza artificiale hanno raggiunto un 54% tasso di click-through - di gran lunga superiore ai ~12% per i tentativi di phishing tradizionali.[13]. Questi messaggi sembrano lo stile di un vero CEO o fanno riferimento a eventi aziendali reali, abbassando la guardia dei destinatari. Gli aggressori utilizzano persino l'intelligenza artificiale per testare A/B diverse frasi e iterare gli agganci di maggior successo.[14]. Inoltre, a differenza degli esseri umani, l'intelligenza artificiale non commette errori di battitura e non si stanca: può produrre infinite varianti finché una non supera i filtri e inganna qualcuno.

Un esempio su tutti: A metà del 2025, un Reuters L'indagine ha rivelato come i truffatori del sud-est asiatico abbiano sfruttato ChatGPT per automatizzare le comunicazioni di frode.[15]. Hanno generato in massa e-mail bancarie convincenti e testi del servizio clienti, aumentando notevolmente la portata dei loro schemi. La polizia europea ha riferito di kit di phishing guidati dall'intelligenza artificiale venduti sul dark web per meno di $20, consentendo ad attori poco qualificati di lanciare campagne sofisticate.[16][17]. La barriera all'ingresso per BEC e phishing è essenzialmente evaporata.

Misure difensive - Fermare l'AI Phish: Di fronte a questo assalto, le organizzazioni devono rafforzare i propri canali di posta elettronica e di messaggistica. È qui che Rilevamento dei contenuti AI può essere d'aiuto. Strumenti come Rilevatore di testo AI di TruthScan e specializzati scanner per e-mail può analizzare i messaggi in arrivo per individuare i marcatori statistici del testo generato dall'intelligenza artificiale. Ad esempio, il Rilevatore di truffe via e-mail TruthScan utilizza l'analisi del linguaggio naturale per segnalare le e-mail che probabilmente provengono da un'intelligenza artificiale, anche se sembrano legittime.[18]. Questi rilevatori esaminano aspetti come la grammatica perfettamente curata, la complessità delle frasi e i modelli stilistici insoliti per gli scrittori umani. Con scansione in tempo realeLe e-mail sospette possono essere messe in quarantena o segnalate per la revisione prima che raggiungano gli utenti. I team di sicurezza aziendali stanno iniziando a implementare questi filtri basati sull'intelligenza artificiale nei gateway di posta elettronica e nelle piattaforme di messaggistica. In pratica, questo aggiunge un nuovo livello di difesa ai filtri antispam tradizionali, esplicitamente tarato per catturare i contenuti scritti dall'intelligenza artificiale. A partire dal 2025, le aziende leader stanno integrando soluzioni come TruthScan tramite API nei loro gateway di posta elettronica sicuri e nelle suite di collaborazione in-the-cloud, creando un punto di controllo automatizzato per i messaggi di posta elettronica. Phishing generato dall'intelligenza artificiale contenuto.

Deepfake: imitazione di voce e video: La truffa del "vedere per ingannare"

Forse la minaccia più viscerale legata all'Intelligenza Artificiale nel 2025 è l'ascesa del attacchi vocali e video deepfake. Utilizzando modelli di intelligenza artificiale, i criminali possono clonare la voce di una persona a partire da pochi secondi di audio o generare un video realistico del volto di qualcuno a partire da una manciata di foto. Questi deepfakes vengono utilizzati per truffe di impersonificazione ad alto rischio, dalle frodi agli amministratori delegati (chiamate di "falsi amministratori delegati") alle false videoconferenze e altro ancora. Un recente rapporto di settore ha rivelato 47% delle organizzazioni hanno subito attacchi deepfake di qualche tipo[19]. E non è solo teorico: diversi furti nel 2023-2025 hanno dimostrato che i deepfake possono sconfiggere l'autenticazione definitiva: i nostri occhi e le nostre orecchie.

Un caso tristemente noto riguardava un trasferimento bancario internazionale di $25 milioni dopo che un dipendente è stato ingannato da una videoconferenza "deepfake". Gli aggressori hanno utilizzato l'intelligenza artificiale per sintetizzare le sembianze del direttore finanziario dell'azienda durante una chiamata Zoom, con tanto di voce e modi di fare, istruendo il dipendente a trasferire i fondi.[4][20]. In un altro incidente in Australia, un governo locale perso $2,3 milioni quando i truffatori hanno falsificato la voce e il video dei funzionari comunali per approvare i pagamenti fraudolenti.[21]. E, cosa inquietante, i criminali stanno usando voci clonate dall'intelligenza artificiale per le "truffe dei nonni", chiamando gli anziani e spacciandoli per parenti in difficoltà. Il FBI e FinCEN ha lanciato un allarme alla fine del 2024 su un'impennata di frodi che utilizzano Media "deepfake" generati dall'intelligenza artificialecompresi i falsi agenti del servizio clienti e le identità sintetiche per eludere le verifiche KYC.[22].

La frequenza dei crimini basati su deepfake è in rapida ascesa. Entro la fine del 2024, un'analisi ha mostrato che ogni cinque minuti si verificava una nuova truffa deepfake. in media[23]. Solo nel primo trimestre del 2025, gli incidenti di deepfake segnalati sono aumentati di 19% rispetto al primo trimestre del 2025. tutti del 2024[24][25]. I deepfakes rappresentano oggi una stima 6,5% di tutti gli attacchi di frode, a 2.137% aumento dal 2022[26][27]. La tecnologia necessaria è diventata facilmente accessibile e spesso richiede solo un minimo di 30 secondi di audio per clonare una voce, o meno di un'ora di filmati campione per modellare il volto di una persona in modo convincente[20]. In poche parole, non è mai stato così facile "falsificare" l'identità di una persona fidata e ingannare le vittime per farsi consegnare denaro o informazioni.

Misure difensive - Autenticare la realtà: Per contrastare le minacce di deepfake, le organizzazioni si stanno rivolgendo a rilevamento dei supporti sintetici strumenti. Ad esempio, Rilevatore vocale AI di TruthScan e TruthScan Deepfake Detector utilizzano l'intelligenza artificiale per analizzare audio e video alla ricerca di segni di manipolazione. Questi sistemi eseguono un'analisi fotogramma per fotogramma e della forma d'onda per individuare artefatti come movimenti facciali innaturali, problemi di sincronizzazione labiale o irregolarità dello spettro audio che tradiscono un clip generato dall'intelligenza artificiale. Nei test, gli algoritmi di TruthScan hanno raggiunto i seguenti risultati 99%+ precisione nell'identificazione delle voci generate dall'intelligenza artificiale e ha rilevato i fotogrammi video manipolati in tempo reale[28][29]. Infatti, i ricercatori del Genians Security Center hanno recentemente utilizzato l'analisi forense delle immagini di TruthScan per analizzare una carta d'identità falsa utilizzata dagli hacker nordcoreani: il rilevatore di immagini deepfake di TruthScan ha segnalato il documento come non autentico. 98% fiduciasventando il tentativo di spear-phishing[5][30].

Per la difesa pratica, le aziende stanno implementando queste capacità di rilevamento in punti nevralgici. Verifica vocale Quando, ad esempio, un "cliente" richiede un trasferimento di grandi dimensioni per telefono, l'audio può essere sottoposto a un rilevatore di deepfake per verificare che si tratti davvero di lui (e non di un'imitazione dell'intelligenza artificiale). Allo stesso modo, piattaforme di videoconferenza possono integrare la scansione deepfake in diretta dei flussi video dei partecipanti, per individuare eventuali volti sintetici. La suite di rilevamento deepfake di TruthScan, ad esempio, offre analisi delle videochiamate in tempo reale e autenticazione facciale che può collegarsi a Zoom o WebEx tramite API[31][29]. Ciò significa che se qualcuno tenta di partecipare a una riunione utilizzando un video creato dall'intelligenza artificiale del vostro CEO, il sistema può segnalare un "possibile deepfake" prima che il danno sia fatto. Inoltre, le transazioni importanti includono spesso una fase di verifica (fuori banda o a più fattori) che può sfruttare l'autenticazione dei contenuti, ad esempio richiedendo una breve conferma vocale che viene poi controllata da un rilevatore vocale AI per verificarne l'autenticità. Grazie alla stratificazione di questi strumenti, le aziende creano una rete di sicurezza: anche se i dipendenti vedere o sentire Se la minaccia è plausibile, un'analisi forense dell'IA dietro le quinte ne metterà in dubbio la realtà. In un panorama di minacce permeato di IA, "Non fidatevi, verificate". diventa il mantra per qualsiasi comunicazione vocale o video che coinvolga denaro o accessi sensibili.

Malware creato dall'intelligenza artificiale e codice offuscato: Minacce in evoluzione nel codice

L'influenza dell'intelligenza artificiale non si limita all'ingegneria sociale, ma sta anche cambiando le carte in tavola nello sviluppo di malware e codici di attacco evasivi. Nel 2025, il Threat Intelligence Group di Google ha scoperto la I primi ceppi di malware che utilizzano l'intelligenza artificiale durante esecuzione per alterare il loro comportamento[32][33]. Un esempio, soprannominato PROMPTFLUXSi trattava di uno script dannoso che in realtà richiamava un'API di intelligenza artificiale (il modello Gemini di Google) per riscrivere il proprio codice al voloproducendo nuove varianti offuscate per eludere il rilevamento antivirus.[34][35]. Questa evoluzione dell'intelligenza artificiale "just-in-time" segna un salto verso un malware autonomo e polimorfico. Un altro esempio, PROMOTOREha utilizzato un assistente di codifica AI per generare comandi Windows di una sola riga per il furto di dati, esternalizzando essenzialmente parti della sua logica a un motore AI in tempo reale.[36][37]. Queste innovazioni lasciano presagire un futuro in cui il malware potrà modificarsi continuamente, proprio come farebbe un pen-tester umano, per sconfiggere le difese.

Anche senza l'IA on-the-fly, gli aggressori utilizzano l'IA durante lo sviluppo per creare codice maligno più potente. L'intelligenza artificiale generativa può produrre malware che altamente offuscatocontenente strati di logica confusa che ostacolano il reverse engineering. Secondo i rapporti di intelligence sulle minacce, oltre 70% delle principali violazioni nel 2025 hanno coinvolto una qualche forma di malware polimorfico che modifica la propria firma o il proprio comportamento per evitare il rilevamento[38]. Inoltre, 76% di campagne di phishing ora impiegano tattiche polimorfiche come gli URL dinamici o i payload riscritti dall'intelligenza artificiale.[38]. Strumenti come le offerte di dark-web VermeGPT e FrodeGPT (cloni illimitati di ChatGPT) permettono anche ai non esperti di generare dropper malware, keylogger o codice ransomware semplicemente descrivendo ciò che vogliono[39]. Il risultato è un'abbondanza di nuove varianti di malware. Ad esempio, nel 2024, un furto di informazioni chiamato BlackMamba è emerso che era interamente generato dall'intelligenza artificialeutilizzando ChatGPT per scrivere il suo codice in segmenti: ogni esecuzione produce un binario leggermente diverso, confondendo i tradizionali antivirus basati sulle firme.[38]. I ricercatori di sicurezza hanno anche dimostrato che i proof-of-concept polimorfici generati dall'IA sono in grado di eludere molte protezioni per gli endpoint.[40].

Inoltre, gli aggressori stanno sfruttando l'intelligenza artificiale per perfezionare i loro consegna di malware. L'intelligenza artificiale è in grado di scrivere in modo intelligente le e-mail di phishing (come già detto) che contengono link a malware. Può anche aiutare nello sviluppo di exploit, ad esempio utilizzando l'IA per trovare nuove vulnerabilità o ottimizzare lo shellcode. Secondo quanto riferito, gli attori degli Stati nazionali hanno utilizzato modelli avanzati di IA per scoprire exploit zero-day e sviluppare malware su misura per gli obiettivi.[41]. Tutte queste tendenze fanno sì che il malware nel 2025 sia più furtivo e adattivo. Spesso "co-creato" con l'IArendendo più difficile il rilevamento con le regole convenzionali.

Misure difensive - AI contro AI nella difesa da malware: Per difendersi dalle minacce informatiche create dall'intelligenza artificiale è necessaria una combinazione di rilevamento avanzato e di analisi alimentata dall'intelligenza artificiale sul lato difensivo. Molte organizzazioni stanno aumentando le loro protezione degli endpoint e EDR (Endpoint Detection & Response) con modelli AI/ML che cercano gli schemi comportamentali del codice generato dall'AI. Ad esempio, trasformazioni improvvise del codice on-host o modelli insoliti di chiamate API potrebbero indicare che PROMPTFLUX si sta rigenerando. Allo stesso modo, il monitoraggio della rete può rilevare anomalie come il malware che si rivolge ai servizi di IA (cosa non "normale" per le applicazioni degli utenti). I venditori stanno addestrando i rilevatori basati su ML sulla famiglie di malware assistiti dall'intelligenza artificiale identificati finora, migliorando il riconoscimento di queste nuove minacce.

Una soluzione emergente è scansione integrata dei contenuti dell'intelligenza artificiale nelle pipeline di sviluppo e di creazione. Ciò significa utilizzare rilevatori guidati dall'intelligenza artificiale per analizzare script, build del software o persino modifiche della configurazione alla ricerca di contenuti dannosi o generati dall'intelligenza artificiale. Ad esempio, Rilevatore in tempo reale di TruthScan può essere impiegata al di là del semplice testo: la sua analisi multimodale può potenzialmente segnalare codice o file di configurazione sospetti riconoscendo se sono stati generati dalla macchina con modelli di offuscamento.[42][43]. I team di sviluppo e gli MSSP stanno iniziando a scansionare gli script infrastructure-as-code, i log PowerShell e altri artefatti alla ricerca di segni di segmenti scritti dall'AI che potrebbero indicare la mano di un attaccante. Sebbene si tratti di un'area nascente, si tratta di un'attività promettente: in un caso, un team di sicurezza ha utilizzato un rilevatore di intelligenza artificiale per individuare un file di kit di phishing offuscato che "sembrava" generato dall'intelligenza artificiale e in realtà faceva parte di un attacco.[44]. Il codice del file era eccessivamente complesso e prolisso (caratteristiche della generazione di IA) e una scansione del contenuto dell'IA ha confermato un'alta probabilità che non sia stato scritto da un essere umano.[40].

Infine, la condivisione di informazioni sulle minacce incentrate sull'IA è fondamentale. Quando il GTIG di Google pubblica dettagli sulle minacce informatiche basate su Prompt o quando i ricercatori segnalano nuove tecniche di evasione dell'IA, le organizzazioni dovrebbero inserirle nella loro ingegneria di rilevamento. Analisi comportamentale - alla ricerca di azioni come la creazione di uno script da parte di un processo che riscrive il codice di quello stesso processo, possono individuare le anomalie che il malware assistito dall'intelligenza artificiale presenta. In breve, i difensori devono combattere il fuoco con il fuoco: distribuire Strumenti di sicurezza basati sull'intelligenza artificiale in grado di adattarsi con la stessa rapidità delle minacce informatiche. Questo include tutto, dagli antivirus potenziati dall'intelligenza artificiale all'analisi del comportamento dell'utente che può identificare quando un account o un sistema inizia a comportarsi in modo "non del tutto umano". Adottando l'intelligenza artificiale per la difesa, i team di sicurezza possono contrastare i vantaggi di velocità e di scala che l'intelligenza artificiale offre agli aggressori.

Identità sintetiche e schemi di frode alimentati dall'IA

Passare dal malware al mondo delle frodi: frode di identità sintetica è esplosa con l'aiuto dell'intelligenza artificiale generativa. La frode di identità sintetica consiste nel creare personaggi fittizi combinando dati reali e falsi (ad esempio, SSN reale + nome e documenti falsi). Queste identità "Frankenstein" vengono poi utilizzate per aprire conti bancari, richiedere credito o superare i controlli KYC, finendo per causare prestiti non pagati o riciclaggio di denaro. Era già uno dei tipi di frode in più rapida crescita, e l'intelligenza artificiale ha ora gettato benzina sul fuoco. Perdite da frodi di identità sintetiche attraversato $35 miliardi nel 2023[45]e all'inizio del 2025 alcune stime indicavano quasi 25% di tutte le perdite da frode bancaria erano dovuti a identità sintetiche[46]. Gli analisti di Experian hanno rilevato che oltre 80% di frodi su nuovi conti in alcuni mercati è ora collegato a ID sintetici[19] - una statistica sconcertante che sottolinea quanto sia diventata pervasiva questa truffa.

L'IA generativa amplifica le frodi sintetiche in diversi modi. In primo luogo, l'IA rende banale la produzione di frodi sintetiche. "documenti dell'allevatore" e le impronte digitali necessarie per vendere un'identità falsa. In passato, un truffatore poteva creare un documento d'identità con Photoshop o creare manualmente bollette false. Oggi esistono strumenti per generare foto profilo, documenti d'identità, passaporti, estratti conto bancari e persino profili di social media dall'aspetto autentico. utilizzando generatori di immagini AI e modelli linguistici[47][48]. Ad esempio, si può usare l'intelligenza artificiale per creare una foto realistica di una persona che non esiste (impedendo così facili ricerche di immagini inverse) e generare una patente di guida falsa con quella foto. L'IA può anche simulare i "segni vitali" di un'identità, ad esempio creando un'immagine di una persona che non esiste. registrazioni di genitori sintetici, indirizzi o post sui social media per dare corpo a una storia di fondo[49]. La Fed di Boston ha osservato che la Gen AI può addirittura produrre deepfake audio e video di una persona falsa - Per esempio, un utente sintetico potrebbe "apparire" in un video di verifica di un selfie, completo di volto e voce unici, tutti generati dall'intelligenza artificiale.[50].

In secondo luogo, l'intelligenza artificiale aiuta i truffatori scalare le loro operazioni. Invece di falsificare una o due identità alla volta, possono generare in modo programmatico centinaia o migliaia di pacchetti di identità completi e compilare automaticamente in massa le richieste di nuovi account.[51][52]. Alcuni servizi del dark web offrono effettivamente "Identità sintetiche come servizio"utilizzando l'automazione per sfornare account verificati da vendere. Durante i programmi di soccorso per la pandemia COVID-19, ad esempio, i criminali hanno utilizzato bot con identità generate dall'intelligenza artificiale per richiedere in massa prestiti e sussidi, sommergendo il sistema di falsi richiedenti. Secondo le proiezioni di Juniper Research, il costo globale delle frodi di identità digitale (alimentate da queste tattiche) è destinato a aumento 153% entro il 2030 rispetto al 2025[53].

Misure difensive - Verifica dell'identità in un mondo di intelligenza artificiale: I metodi tradizionali di verifica dell'identità si scontrano con i falsi creati dall'intelligenza artificiale. Per adattarsi, le organizzazioni stanno adottando verifica dell'identità e del comportamento a più livelli rafforzato dall'intelligenza artificiale. Un livello chiave è costituito da un'avanzata la forensica dei documenti e delle immagini. Ad esempio, Rilevatore di immagini AI di TruthScan e Rilevatore di documenti falsi forniscono la possibilità di analizzare i documenti d'identità, i selfie o i documenti caricati alla ricerca di segni di sintesi o di manomissione. Questi strumenti esaminano gli artefatti a livello di pixel, le incongruenze di illuminazione e i metadati per determinare se un'immagine è generata dall'intelligenza artificiale o manipolata. Sono in grado di cogliere indizi impercettibili, come modelli di sfondo identici di foto generate da GAN, o caratteri e spaziatura di un documento d'identità che non corrispondono a nessun modello governativo noto. Impiegando tali rilevatori all'atto dell'iscrizione, le banche possono segnalare automaticamente la patente di guida o il selfie di un richiedente se è probabile che sia stato generato dall'intelligenza artificiale (ad esempio, il sistema di TruthScan avrebbe segnalato il falso documento militare utilizzato nel caso di phishing dell'APT Kimsuky).[5]). Secondo un comunicato stampa di TruthScan, la sua piattaforma è stata utilizzata da istituzioni finanziarie per convalidare l'autenticità dei documenti su scala, identificando i falsi profondi con un'accuratezza estremamente elevata.[54].

Un altro strato è analisi comportamentale e controlli incrociati. Le identità reali hanno una profondità: anni di storia, registri pubblici, attività sui social media, ecc. Le identità generate dall'IA, per quanto raffinate, spesso non hanno queste radici profonde. Banche e istituti di credito utilizzano ora l'intelligenza artificiale per incrociare i dati delle domande con quelli pubblici e proprietari: Il numero di telefono e l'e-mail di questa persona mostrano una cronologia di utilizzo? La geolocalizzazione del dispositivo o dell'IP ha senso? Sta digitando i dati nei moduli in modo umano o facendo copia-incolla (come fanno i bot)? I modelli di intelligenza artificiale possono essere addestrati per distinguere il comportamento autentico dei clienti dai modelli sintetici. La Federal Reserve ha osservato che "Le identità sintetiche sono superficiali e l'intelligenza artificiale se ne accorge". - La verifica basata sull'intelligenza artificiale è in grado di ricercare rapidamente l'impronta digitale di un'identità e di lanciare un allarme se non ne viene trovata nessuna.[55]. In pratica, i servizi di verifica dell'identità ora impiegano l'intelligenza artificiale che controlla se il selfie di un utente corrisponde a foto passate (per rilevare scambi di volti) e persino richiede agli utenti azioni randomizzate (come pose o frasi specifiche) durante i controlli di vivacità, rendendo più difficile per i deepfake rispondere correttamente.[56][57].

Infine, monitoraggio continuo Il monitoraggio del comportamento del conto dopo l'inserimento aiuta a individuare i conti sintetici che sono sfuggiti al controllo. Poiché questi conti non sono legati a una persona reale, i loro modelli di utilizzo spesso si distinguono (ad esempio, effettuano transazioni perfettamente tempestive per accumulare credito e poi lo esauriscono). Il monitoraggio delle frodi basato sull'intelligenza artificiale (come le piattaforme di Sift o Feedzai) può identificare le anomalie nel modo in cui vengono utilizzati i conti, segnalando potenziali conti sintetici da esaminare. In sintesi, per combattere le frodi d'identità basate sull'intelligenza artificiale occorre Prova d'identità abilitata dall'intelligenza artificiale - che combina la forensica dei documenti, i controlli biometrici, la correlazione dei dati e l'analisi comportamentale. La buona notizia è che gli stessi progressi dell'intelligenza artificiale che permettono di individuare le frodi vengono utilizzati anche per rilevarle. TruthScan, ad esempio, offre un sistema di suite di verifica dell'identità che integra l'analisi del testo, delle immagini e della voce per controllare i nuovi utenti. Sfruttando questi strumenti, una grande banca ha notato un calo significativo delle aperture di conti sintetici, anche se le medie del settore erano in aumento. La corsa agli armamenti continua, ma i difensori stanno imparando a individuare le deboli "tracce digitali" di un sintetico, per quanto l'intelligenza artificiale cerchi di coprire le proprie tracce.

Integrazione del rilevamento dell'intelligenza artificiale in tutto lo stack di sicurezza

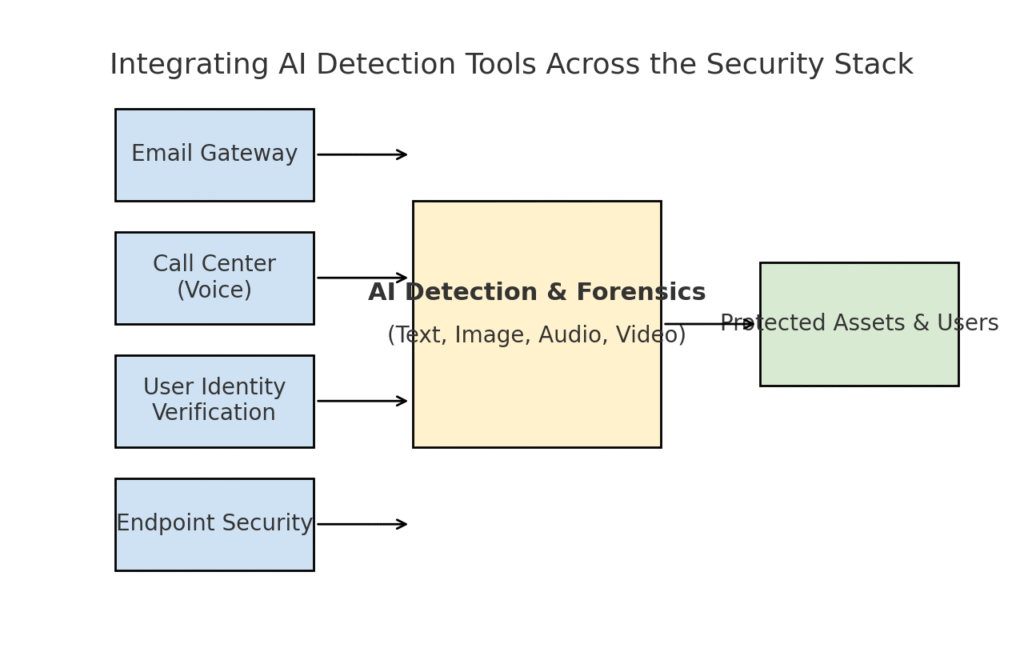

Abbiamo esplorato diverse aree di minaccia distinte - phishing, deepfakes, malware, frodi sintetiche - tutte potenziate dall'intelligenza artificiale. È chiaro che nessun singolo strumento o soluzione unica risolverà la sfida. Le imprese hanno invece bisogno di una strategia completa per incorporare il rilevamento e la verifica basati sull'intelligenza artificiale a ogni livello del loro stack di cybersecurity. L'approccio deve rispecchiare la superficie di attacco, coprendo e-mail, web, voce, documenti, identità e altro. Il diagramma seguente illustra come le organizzazioni possono integrare gli strumenti di rilevamento dell'intelligenza artificiale di TruthScan (e soluzioni simili) nei livelli di sicurezza aziendali comuni:

Integrazione di strumenti di rilevamento dell'intelligenza artificiale a più livelli dello stack di sicurezza, dai gateway e-mail e call center alla verifica degli utenti e alla protezione degli endpoint. Il rilevamento dei contenuti AI (centro) analizza testo, immagini, audio e video in tempo reale, alimentando i punti di applicazione che proteggono le risorse e gli utenti.

In questo modello, i rilevatori multimodali di intelligenza artificiale agiscono come un cervello centrale che si interfaccia con vari controlli di sicurezza:

- Gateway e-mail: Le e-mail in entrata passano attraverso un rilevatore di testo/scam dell'intelligenza artificiale prima di raggiungere la casella di posta. Ciò si ricollega alla difesa dal phishing di cui abbiamo parlato, ad esempio l'utilizzo di Rilevatore di truffe via e-mail di TruthScan tramite API al vostro provider di posta elettronica per mettere automaticamente in quarantena le e-mail sospette generate dall'intelligenza artificiale.[18]. Può essere applicato anche alle piattaforme di messaggistica (app di chat, gateway SMS) per analizzare i contenuti alla ricerca di modelli di phishing o di truffa.

- Call center e sistemi vocali: I canali telefonici e VOIP sono protetti integrando il rilevamento di deepfake vocali. Ad esempio, la linea di assistenza clienti di una banca potrebbe utilizzare Rilevatore vocale AI di TruthScan per analizzare l'audio delle chiamate in arrivo in tempo reale e avvisare se l'impronta vocale di un chiamante è sintetica o non corrisponde al suo profilo conosciuto[58][59]. In questo modo si evita che gli attacchi di vishing e di impersonificazione vocale (come le false chiamate al CEO) vadano a buon fine.

- Processi di verifica dell'identità degli utenti: Durante la creazione di un conto o le azioni ad alto rischio dell'utente (reimpostazione della password, bonifici bancari), entra in gioco la verifica dell'identità guidata dall'intelligenza artificiale. L'ID di una foto caricata viene controllato da uno strumento di image forensics (ad esempio, verificando se si tratta di una foto generata dall'intelligenza artificiale o di una foto di una foto), mentre un selfie o una videochiamata vengono esaminati da un rilevatore di deepfake. TruthScan Rilevatore di deepfake può essere utilizzato per eseguire l'autenticazione facciale, assicurando che la persona ripresa dalla telecamera sia reale e corrisponda all'ID[60][61]. Anche i segnali comportamentali (cadenza di digitazione, coerenza dei dispositivi) possono essere inseriti in modelli di intelligenza artificiale per individuare bot o identità sintetiche.

- Endpoint e rete: Gli agenti di sicurezza degli endpoint e i server proxy possono incorporare l'analisi del contenuto dell'intelligenza artificiale per file e script. Ad esempio, se un EDR per endpoint vede l'esecuzione di un nuovo script o EXE, può inviare il contenuto testuale del file a un rilevatore di intelligenza artificiale per verificare se assomiglia a malware noto generato dall'intelligenza artificiale o se presenta tratti di codice offuscato dall'intelligenza artificiale. Analogamente, i sistemi DLP (Data Loss Prevention) potrebbero utilizzare il rilevamento del testo dell'intelligenza artificiale per segnalare il testo sensibile generato dall'intelligenza artificiale (che potrebbe indicare l'utilizzo dell'intelligenza artificiale da parte di un insider per redigere messaggi di esfiltrazione dei dati o falsificare i rapporti). Il sistema TruthScan Rivelatore in tempo reale è progettato per inserirsi in tali flussi di lavoro, offrendo un'analisi in tempo reale dei contenuti su tutte le piattaforme con opzioni di risposta automatizzate.[42][62] (ad esempio, bloccando automaticamente un file o un messaggio se viene identificato come malware o disinformazione generata dall'intelligenza artificiale).

Il beneficio chiave di questo approccio integrato è velocità e coerenza. Gli attacchi di intelligenza artificiale si muovono rapidamente: e-mail di phishing, voci false e dati sintetici possono colpire molti canali contemporaneamente. Strumentando tutti questi canali con il rilevamento dell'intelligenza artificiale, un'organizzazione ottiene visibilità in tempo reale e difesa in profondità. Un team ha descritto questa soluzione come la creazione di un "sistema immunitario AI" per la propria azienda: ogni volta che viene comunicato qualcosa (che si tratti di un'e-mail, del caricamento di un documento, di una chiamata vocale e così via), il sistema immunitario AI lo "sniffa" alla ricerca di firme estranee (generate dall'AI) e lo neutralizza se lo trova dannoso.

La suite aziendale di TruthScan ne è un esempio, in quanto offre un servizio di piattaforma unificata che copre il rilevamento dell'intelligenza artificiale di testi, immagini, audio e video e che può essere implementato in modo modulare o completo.[63][64]. Molte aziende iniziano con l'implementazione di una o due funzionalità (ad esempio, il rilevamento del testo nelle e-mail e il rilevamento delle immagini nell'onboarding) e poi si espandono ad altre quando ne vedono il valore. L'integrazione è resa più semplice per gli sviluppatori - TruthScan e servizi simili forniscono API e SDK in modo che i team di sicurezza possano agganciare il rilevamento ai sistemi esistenti senza dover ricorrere a una massiccia reingegnerizzazione. Che si tratti di un SIEM, di un gateway di posta elettronica, di un'applicazione bancaria personalizzata o di un sistema CRM, il rilevamento può essere eseguito dietro le quinte e alimentare avvisi o azioni automatizzate. Ad esempio, una grande piattaforma di social media ha integrato le API di moderazione dei contenuti per eliminare automaticamente i video deepfake entro pochi minuti dal caricamento.[65][66]impedendo la diffusione della disinformazione generata dall'intelligenza artificiale.

Conclusioni: Rimanere all'avanguardia

La rapida proliferazione delle minacce guidate dall'intelligenza artificiale nel 2025 ha sfidato le organizzazioni in modi nuovi. Gli aggressori hanno trovato i mezzi per sfruttare la fiducia umana su larga scala: impersonando voci e identità, automatizzando l'ingegneria sociale, eludendo le difese attraverso il codice adattivo e creando intere false realtà. È una prospettiva scoraggiante per i difensori, ma non senza speranza. Così come i criminali stanno sfruttando l'IA, anche noi possiamo arruolare l'IA dalla parte della sicurezza. L'emergere di Rilevamento di contenuti AI, deepfake forensics e scanner di identità sintetiche ci offre potenti contromisure a queste nuove minacce. L'impiego di questi strumenti e integrandoli in tutti i livelli di difesa, le aziende possono ridurre drasticamente il rischio che gli attacchi basati sull'intelligenza artificiale possano sfuggire. I primi utilizzatori hanno già sventato tentativi di frode multimilionari cogliendo sul fatto i deepfake.[26]o di prevenire i disastri del phishing filtrando le e-mail create dall'intelligenza artificiale.

Oltre alla tecnologia, le organizzazioni dovrebbero coltivare una cultura del "fidarsi ma verificare". I dipendenti devono essere consapevoli del fatto che, nell'era dell'intelligenza artificiale, vedere (o sentire) non è sempre credere: un sano scetticismo unito a flussi di lavoro di verifica può fermare molti stratagemmi di social engineering. La formazione e la consapevolezza, combinate con strumenti di verifica automatica come TruthScanformano una difesa formidabile. In un certo senso, dobbiamo alzare il livello di autenticazione e convalida delle informazioni. Le comunicazioni e i documenti digitali non possono più essere presi al valore nominale; la loro provenienza deve essere verificata, sia a livello di macchina che di processo.

Nel frattempo, ci aspettiamo che gli aggressori perfezionino ulteriormente le loro tattiche di IA, ma anche che continuino a innovare l'IA difensiva. La dinamica del gatto e del topo persisterà. Il successo dei difensori dipenderà da agilità e condivisione dell'intelligence. Coloro che incorporano rapidamente nuove informazioni sulle minacce (ad esempio, nuove tecniche di rilevamento di deepfake o firme aggiornate di modelli di IA) saranno in vantaggio rispetto agli aggressori che sfruttano i più recenti strumenti di IA. Anche la collaborazione tra industria, università e governo sarà fondamentale in questa lotta, come dimostrano gli avvisi e i quadri che emergono da agenzie come l'AI Risk Management Framework del NIST e le collaborazioni interbancarie sul rilevamento delle frodi da parte dell'IA.

Per concludere, il settore della sicurezza informatica si trova nel mezzo di un cambiamento di paradigma guidato dall'intelligenza artificiale. Le minacce sono diverse da quelle di un decennio fa, ma le stiamo affrontando con difese altrettanto inedite. Grazie a una combinazione di tecnologie di rilevamento avanzate e di una solida strategia di sicurezza, possiamo può mitigare i rischi dell'IA generativa e persino trasformarla a nostro vantaggio. Strumenti come la suite di rilevamento dell'IA di TruthScan ci permettono di ripristinare la fiducia in un mondo a fiducia zero - per garantire che la persona all'altro capo del filo sia reale, che il documento nella nostra casella di posta elettronica sia autentico e che il codice in esecuzione nella nostra rete non sia stato manomesso da un'IA maligna. Investendo in queste capacità ora, le organizzazioni non solo si proteggeranno dagli attacchi odierni basati sull'intelligenza artificiale, ma creeranno anche una capacità di resistenza contro le minacce in evoluzione di domani. Il risultato è chiaro: L'Intelligenza Artificiale può potenziare gli attacchi informatici, ma con il giusto approccio può anche potenziare le nostre difese.

Fonti: I dati e gli esempi pertinenti sono stati tratti da 2025 rapporti di intelligence sulle minacce e da esperti, tra cui Cyber Incident Trends di Mayer Brown.[1][67]La rassegna delle minacce di Fortinet per il 2025[2][19], ricerca Barracuda sugli attacchi email AI[6][7], Rapporto sulle minacce dell'intelligenza artificiale di Google GTIG[34], approfondimenti della Federal Reserve di Boston sulle frodi sintetiche[45][50]e i casi di studio e i comunicati stampa pubblicati da TruthScan.[30][26], tra gli altri. Queste illustrano la portata delle minacce guidate dall'intelligenza artificiale e l'efficacia delle contromisure incentrate sull'intelligenza artificiale in scenari reali. Imparando da questa intelligenza e impiegando strumenti all'avanguardia, possiamo navigare con fiducia nell'era del rischio informatico potenziato dall'intelligenza artificiale.

[1] [67] 2025 Tendenze degli incidenti informatici: cosa deve sapere la vostra azienda | Approfondimenti | Mayer Brown

[2] [3] [19] Statistiche sulla sicurezza informatica: Fatti, statistiche e violazioni per il 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Frodi guidate dall'intelligenza artificiale nei servizi finanziari: Tendenze e soluzioni recenti | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan rileva un attacco Deepfake della Corea del Nord contro funzionari della Difesa - Bryan County Magazine

[6] [7] [14] Metà dello spam nella vostra casella di posta è generato dall'intelligenza artificiale: il suo utilizzo negli attacchi avanzati è in fase iniziale | Blog di Barracuda Networks

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Indice di fiducia digitale Q2 2025: Dati e approfondimenti sulle frodi dell'intelligenza artificiale

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Minacce di sicurezza informatica AI 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Ultime informazioni sulle minacce | TruthScan

[18] [63] [64] TruthScan - Rilevamento dell'intelligenza artificiale e sicurezza dei contenuti per le imprese

[23] [46] [56] [57] Deepfakes e depositi: Come combattere le frodi dell'intelligenza artificiale generativa

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Attacchi deepfake e phishing generato dall'intelligenza artificiale: statistiche del 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] Rilevatore vocale AI per deepfakes e clonazione vocale | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identificare i video falsi e di intelligenza artificiale - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Progressi nell'utilizzo degli strumenti di intelligenza artificiale da parte degli attori delle minacce | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Gli hacker hanno offuscato il malware con un codice AI prolisso

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Rilevamento AI in tempo reale - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Gli operatori di EvilAI usano codici generati dall'intelligenza artificiale e applicazioni false per ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] La Gen AI sta aumentando la minaccia di frodi di identità sintetiche - Federal Reserve Bank of Boston

[53] Frode dell'identità sintetica 2025: Strategie di rilevamento e prevenzione dell'intelligenza artificiale